温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

任务书:基于Hadoop+Spark+Hive的招聘推荐系统与招聘大数据分析

一、项目背景与目标

1. 背景

随着互联网招聘行业快速发展,企业招聘需求与求职者供给呈现数据量大、维度多、实时性强的特点。传统招聘系统存在以下问题:

- 数据孤岛:用户行为数据、简历文本、企业招聘需求分散存储,缺乏统一分析框架;

- 推荐低效:基于关键词匹配的算法难以捕捉用户隐性需求(如技能关联、职业规划);

- 分析滞后:批处理模式无法支持实时招聘趋势预测(如突发技术热点引发的岗位需求激增)。

2. 目标

构建基于Hadoop分布式存储、Spark内存计算、Hive数据仓库的招聘推荐系统,实现以下目标:

- 技术目标:支持PB级招聘数据的实时存储、处理与分析,推荐响应时间≤1秒;

- 功能目标:提供个性化职位推荐、招聘趋势分析、人才供需预测等功能;

- 业务目标:提升企业招聘效率(缩短职位空缺周期30%以上)和求职者匹配精准度(推荐点击率提升50%)。

二、项目范围与任务分解

1. 项目范围

- 数据层:整合招聘平台结构化数据(MySQL)、用户行为日志(JSON)、简历文本(PDF/Word);

- 计算层:基于Hadoop+Spark构建分布式计算框架,支持批处理与流处理;

- 应用层:开发招聘推荐系统Web端,提供可视化分析看板。

2. 任务分解

任务1:数据采集与预处理

- 子任务1.1:多源数据采集

- 从招聘平台MySQL数据库抽取职位表、用户表;

- 通过Scrapy爬取职位描述文本、公司官网文化介绍;

- 解析Kafka接收的用户行为日志(如浏览、收藏、投递)。

- 子任务1.2:数据清洗与转换

- 处理缺失值(如简历中缺失工作年限)、异常值(如薪资超出行业均值3倍);

- 统一数据格式(如将日期字段转换为YYYY-MM-DD)。

任务2:分布式存储与计算框架搭建

- 子任务2.1:Hadoop集群部署

- 配置HDFS存储原始数据(如

/raw/jobs/202509/目录下按日期分区的CSV文件); - 部署YARN资源调度器,管理集群计算资源。

- 配置HDFS存储原始数据(如

- 子任务2.2:Hive数据仓库构建

- 设计分层数据模型(ODS→DWD→DWS→ADS);

- 创建Hive表(如

dwd_user_profile宽表整合用户基本信息与行为特征)。

- 子任务2.3:Spark计算环境配置

- 部署Spark on YARN模式,支持Scala/Python开发;

- 配置Spark Streaming接收Kafka流数据。

任务3:招聘推荐算法开发

- 子任务3.1:基于协同过滤的推荐

- 实现ALS算法(交替最小二乘法)挖掘用户-职位隐性关系;

- 引入时间衰减因子(

weight=1/(1+0.1*days))解决行为数据时效性。

- 子任务3.2:知识图谱嵌入

- 构建"求职者-技能-职位-公司"四元关系图(如

User(1001)-[has_skill]->Skill(Java)); - 采用TransE算法学习实体嵌入向量,通过GCN聚合邻居信息。

- 构建"求职者-技能-职位-公司"四元关系图(如

- 子任务3.3:多目标优化推荐

- 同时优化点击率(CTR)、预约面试率(IR)、入职率(HR);

- 采用帕累托前沿算法平衡指标冲突。

任务4:实时招聘趋势分析

- 子任务4.1:流处理管道开发

- Spark Streaming按城市/技能/公司维度聚合指标(如

count_by_city_skill); - 滑动窗口统计(窗口大小=1小时,滑动步长=5分钟)检测突发流量。

- Spark Streaming按城市/技能/公司维度聚合指标(如

- 子任务4.2:需求预测模型

- 基于LSTM网络预测未来7天各技能岗位需求量;

- 输入特征包括历史需求、季节因子(如校招季)、宏观经济指标(如GDP增长率)。

任务5:系统集成与测试

- 子任务5.1:前后端集成

- 使用Flask框架开发推荐系统API;

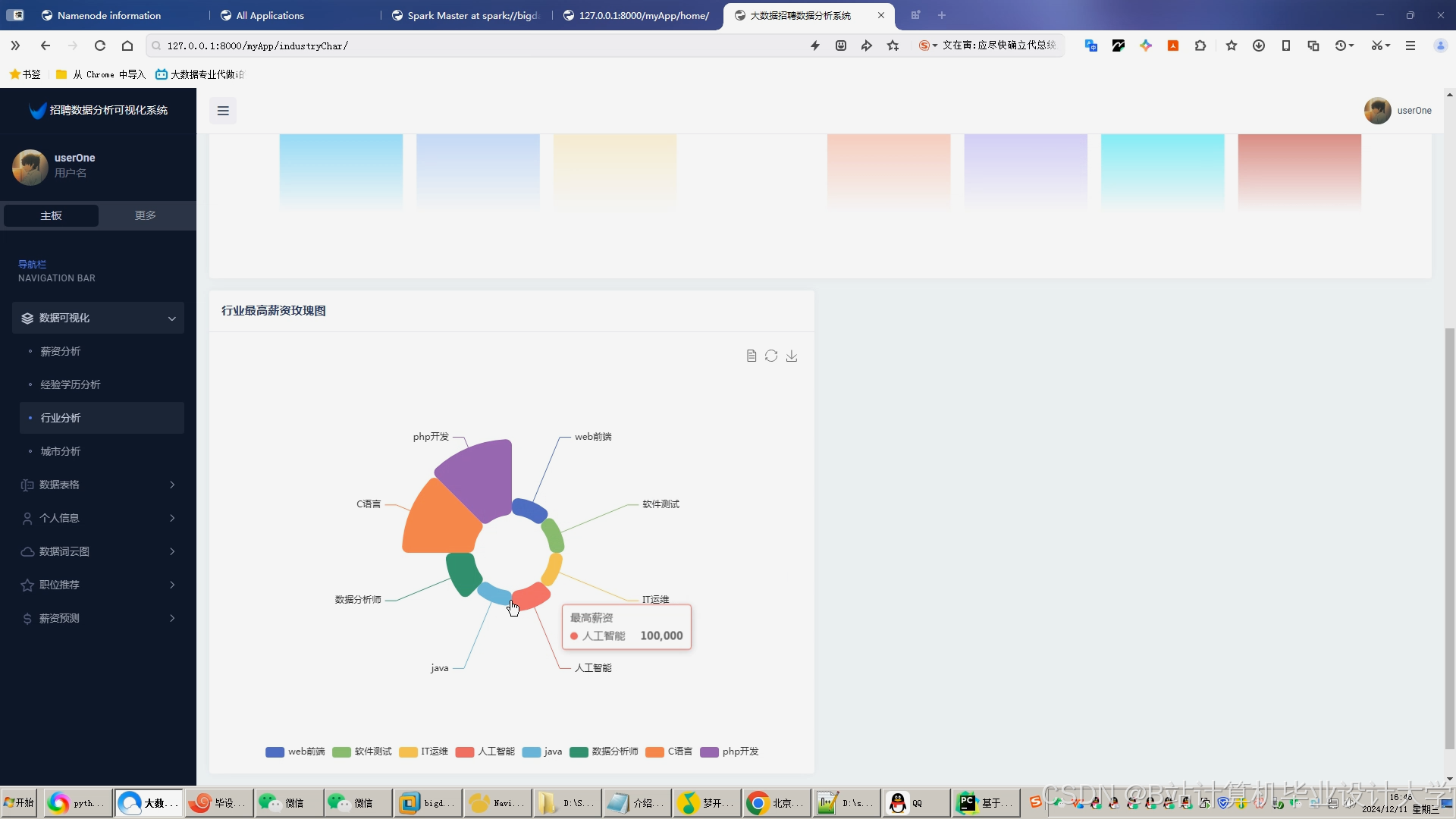

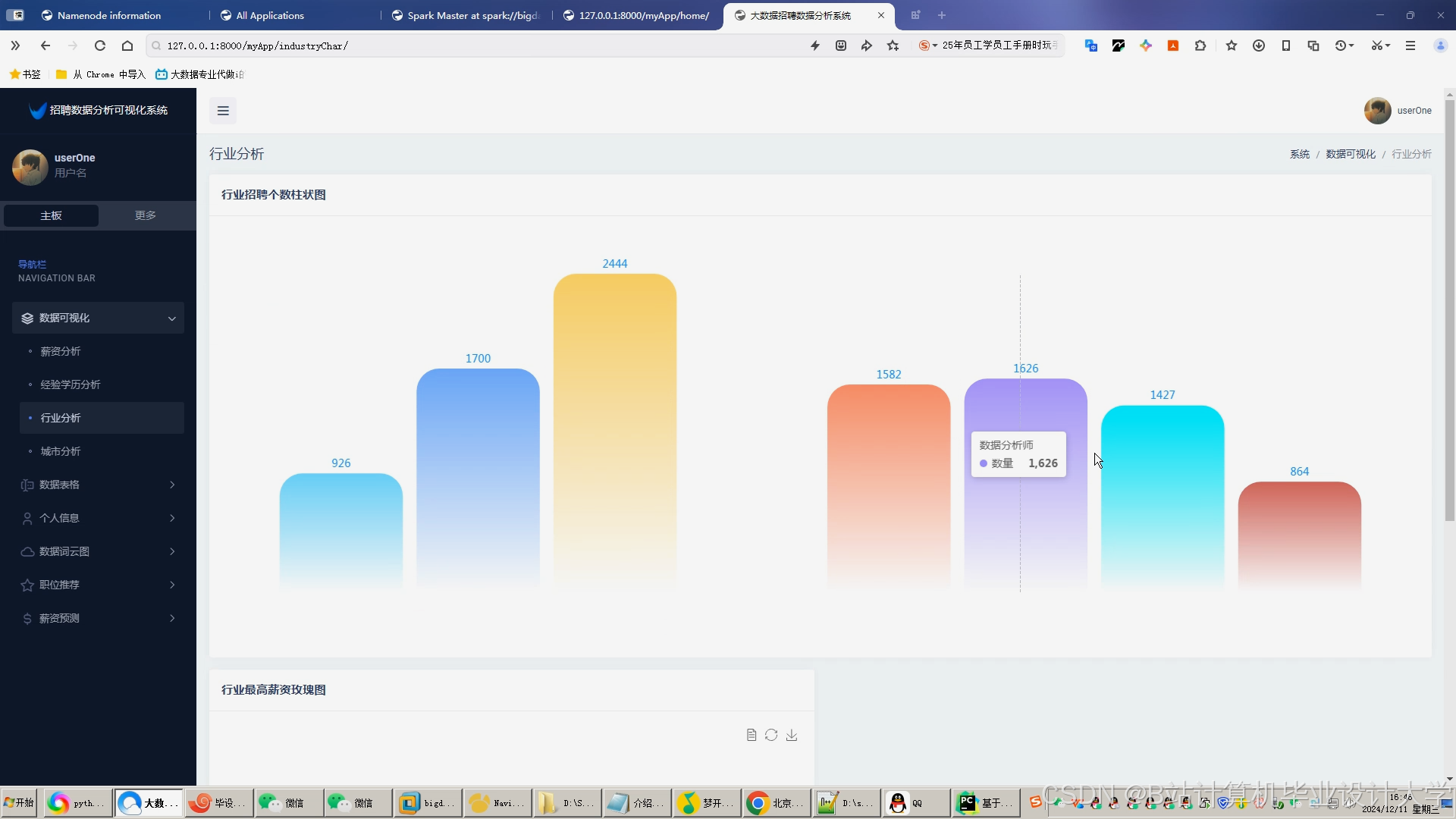

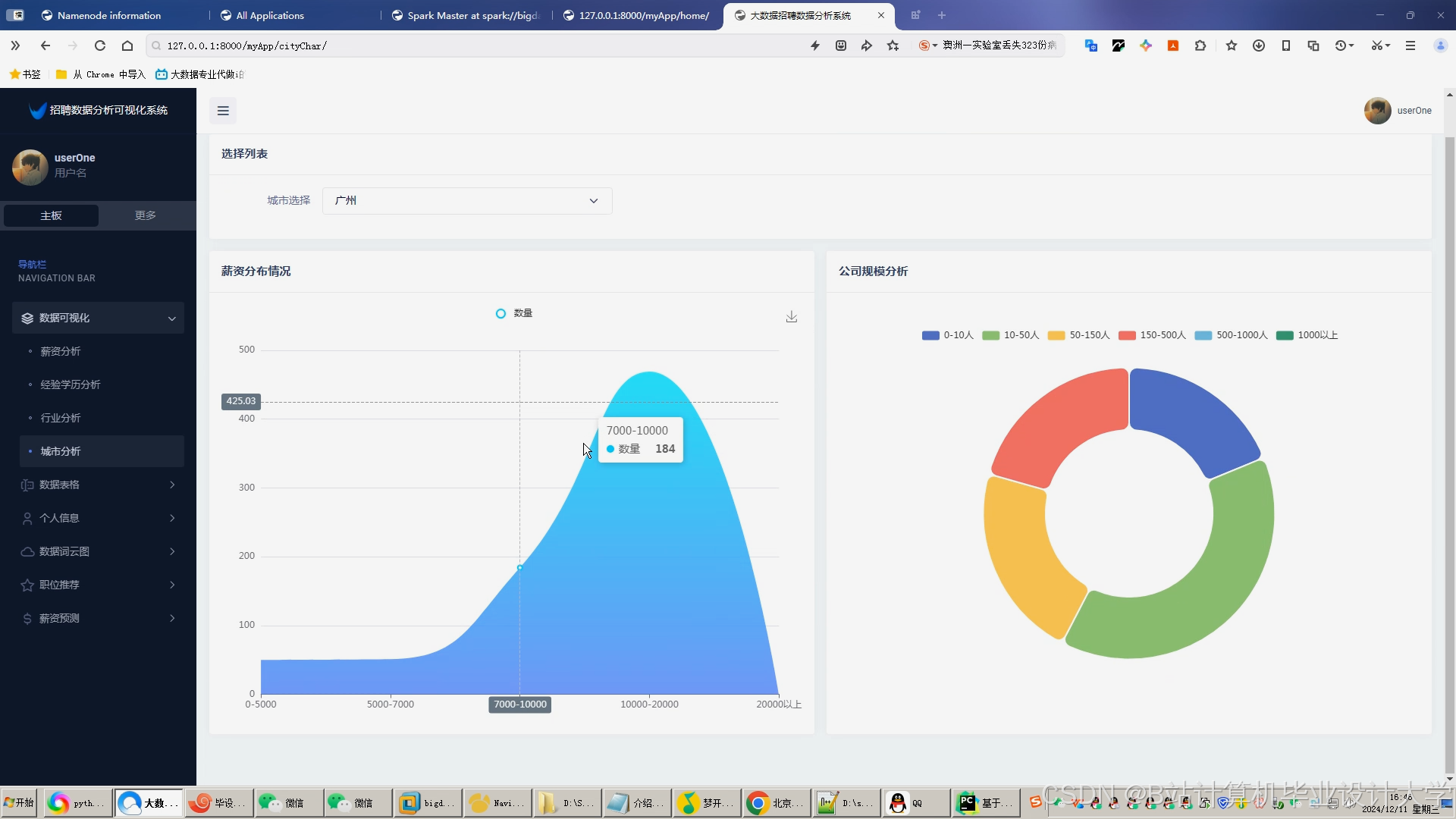

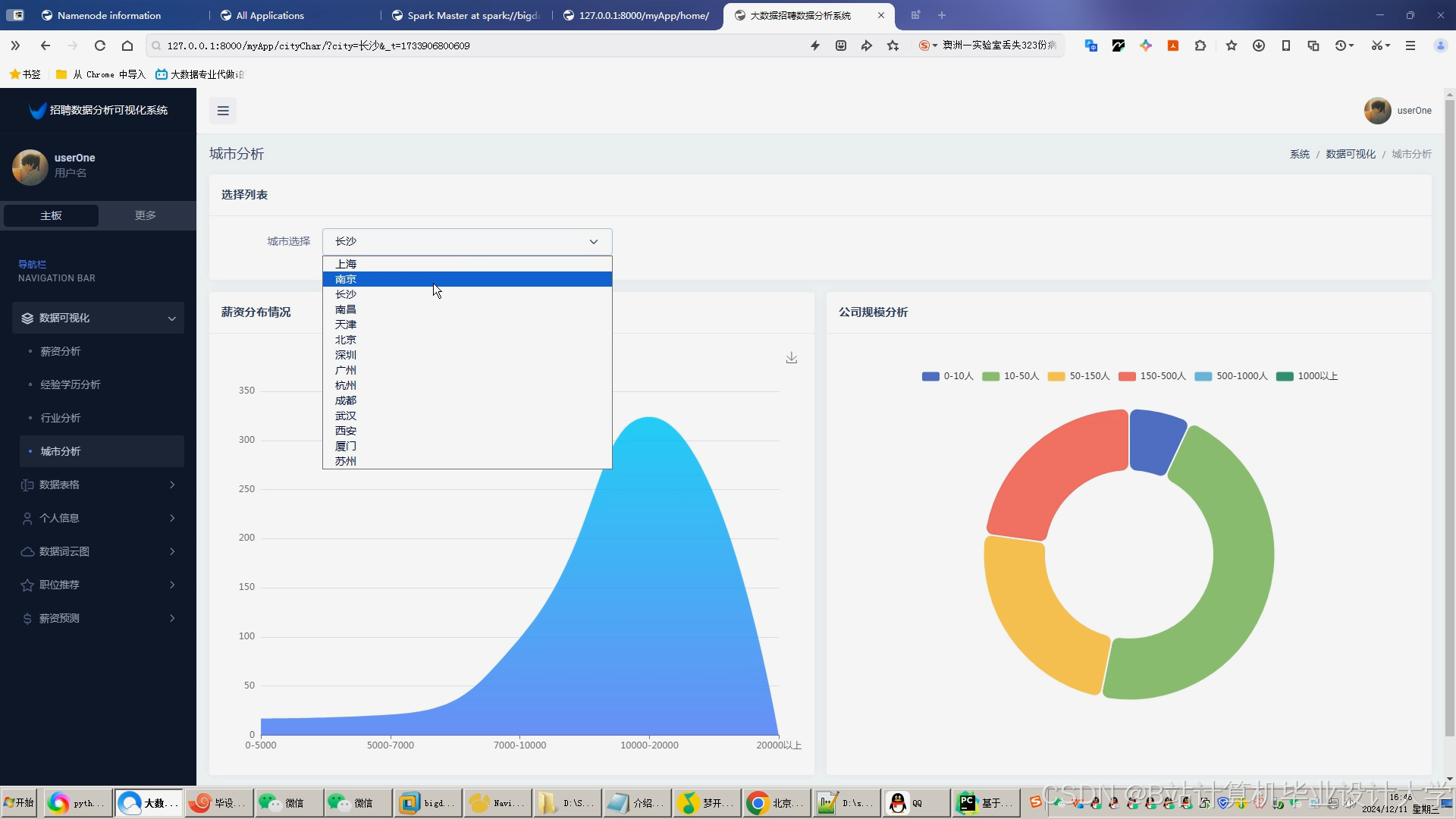

- 前端采用ECharts实现可视化看板(如技能热度排行榜、区域人才供需比)。

- 子任务5.2:性能测试

- 压测集群吞吐量(目标:每秒处理10万条行为日志);

- 对比基线模型(如ALS、BERT4Rec)的AUC、Recall指标。

三、资源需求与分工

1. 资源需求

- 硬件资源:

- 服务器:5台(配置:16核CPU、64GB内存、2TB硬盘);

- 网络:千兆以太网,支持集群节点间高速通信。

- 软件资源:

- 操作系统:CentOS 7.6;

- 大数据组件:Hadoop 3.3.6、Spark 3.5.0、Hive 3.1.3、Kafka 3.6.0;

- 开发工具:IntelliJ IDEA、PyCharm、Postman。

2. 分工与职责

| 角色 | 职责 |

|---|---|

| 项目经理 | 制定项目计划、协调资源、监控进度,定期向利益相关方汇报。 |

| 数据工程师 | 负责数据采集、清洗、存储,构建Hive数据仓库。 |

| 算法工程师 | 开发推荐算法(协同过滤、知识图谱嵌入、多目标优化),优化模型性能。 |

| 后端开发 | 基于Spark开发批处理与流处理任务,实现推荐系统API。 |

| 前端开发 | 设计可视化看板,集成ECharts实现动态图表展示。 |

| 测试工程师 | 制定测试用例,执行性能测试与功能测试,输出测试报告。 |

四、时间计划与里程碑

| 阶段 | 时间节点 | 交付物 |

|---|---|---|

| 需求分析 | 2025.10.01-2025.10.15 | 《需求规格说明书》《数据字典》 |

| 系统设计 | 2025.10.16-2025.10.31 | 《技术架构图》《数据库设计文档》《接口规范》 |

| 开发实施 | 2025.11.01-2026.04.30 | 完成Hadoop集群部署、推荐算法开发、前端可视化看板。 |

| 系统测试 | 2026.05.01-2026.05.15 | 《测试报告》《性能优化方案》 |

| 上线部署 | 2026.05.16-2026.05.31 | 系统上线,完成用户培训与文档交付。 |

五、风险管理

| 风险类型 | 风险描述 | 应对措施 |

|---|---|---|

| 技术风险 | Spark Streaming处理延迟超过1秒 | 优化任务并行度,增加Executor内存;采用Kafka分区策略平衡负载。 |

| 数据风险 | 爬取数据被目标网站封禁IP | 使用代理IP池,控制爬取频率(如每秒请求≤5次);遵守robots.txt协议。 |

| 进度风险 | 算法优化耗时超出预期 | 采用敏捷开发模式,分阶段交付可运行版本;优先实现基础推荐功能,再迭代优化。 |

六、验收标准

1. 功能验收

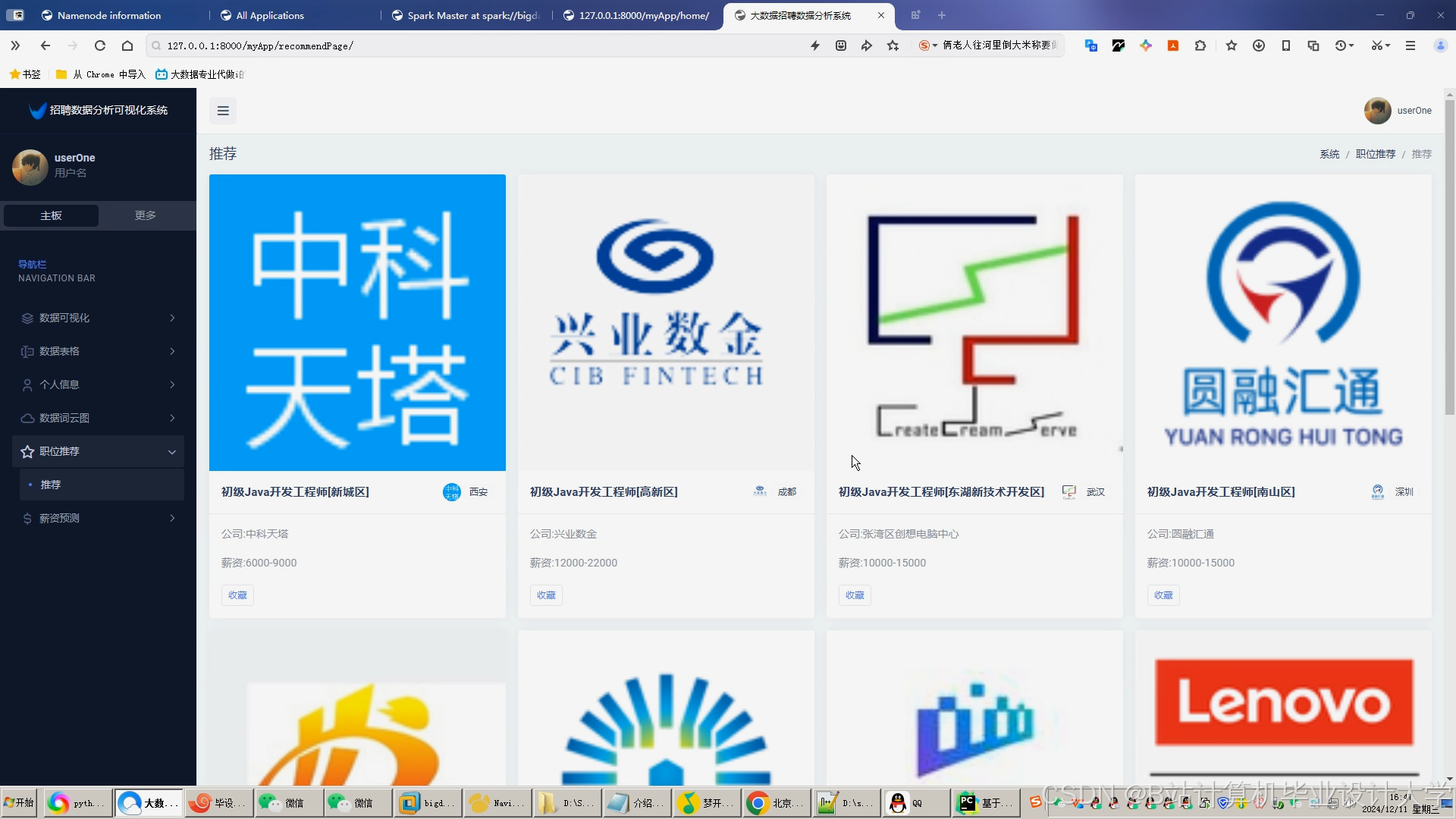

- 推荐系统支持个性化推荐(如根据用户浏览历史推荐相关职位);

- 分析看板展示实时招聘趋势(如技能热度排行榜、区域人才供需比)。

2. 性能验收

- 集群吞吐量≥10万条/秒(行为日志处理);

- 推荐响应时间≤1秒(95%请求)。

3. 文档验收

- 提交《系统设计文档》《用户操作手册》《维护指南》等完整文档。

项目负责人(签字):____________________

日期:____________________

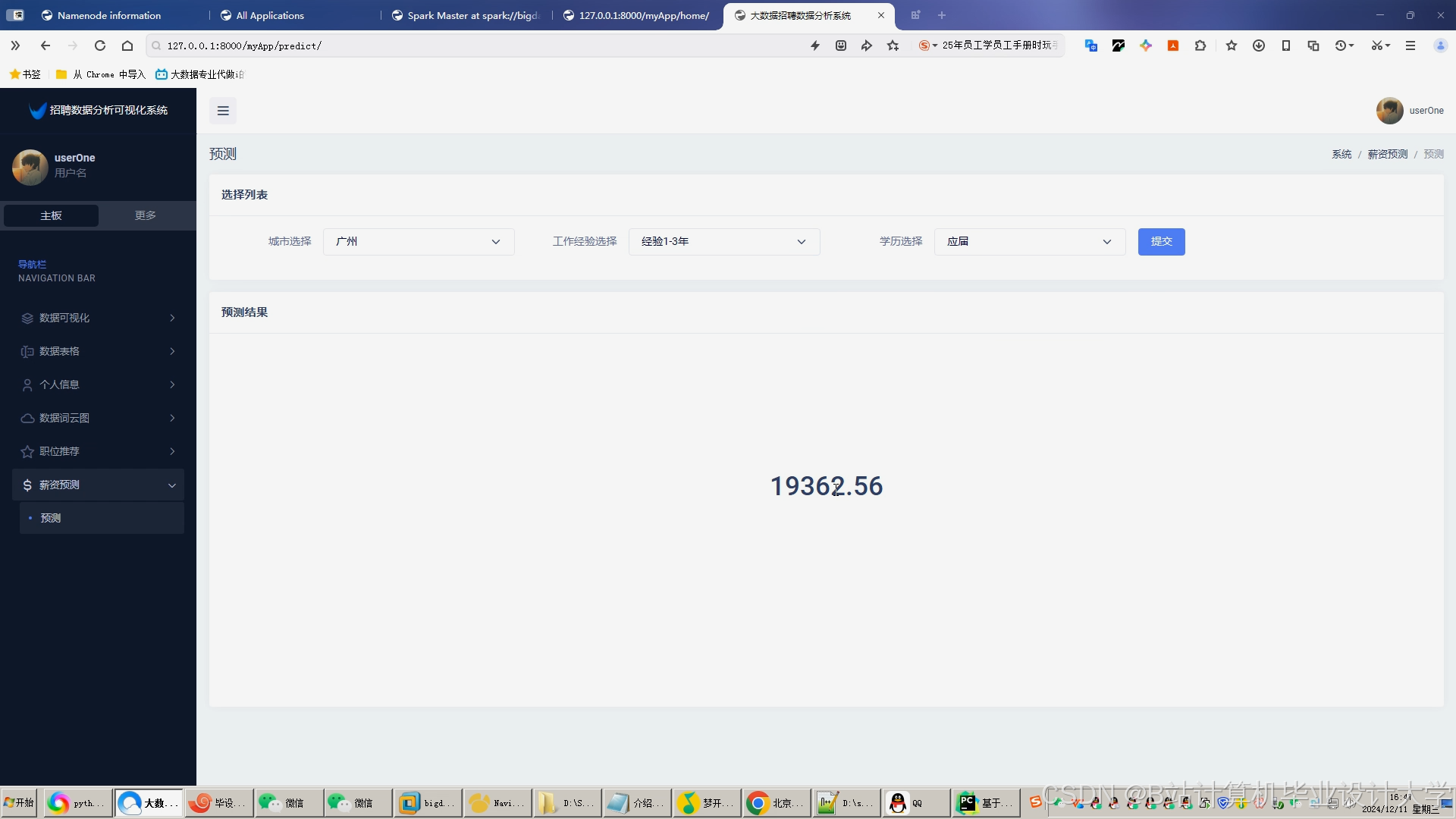

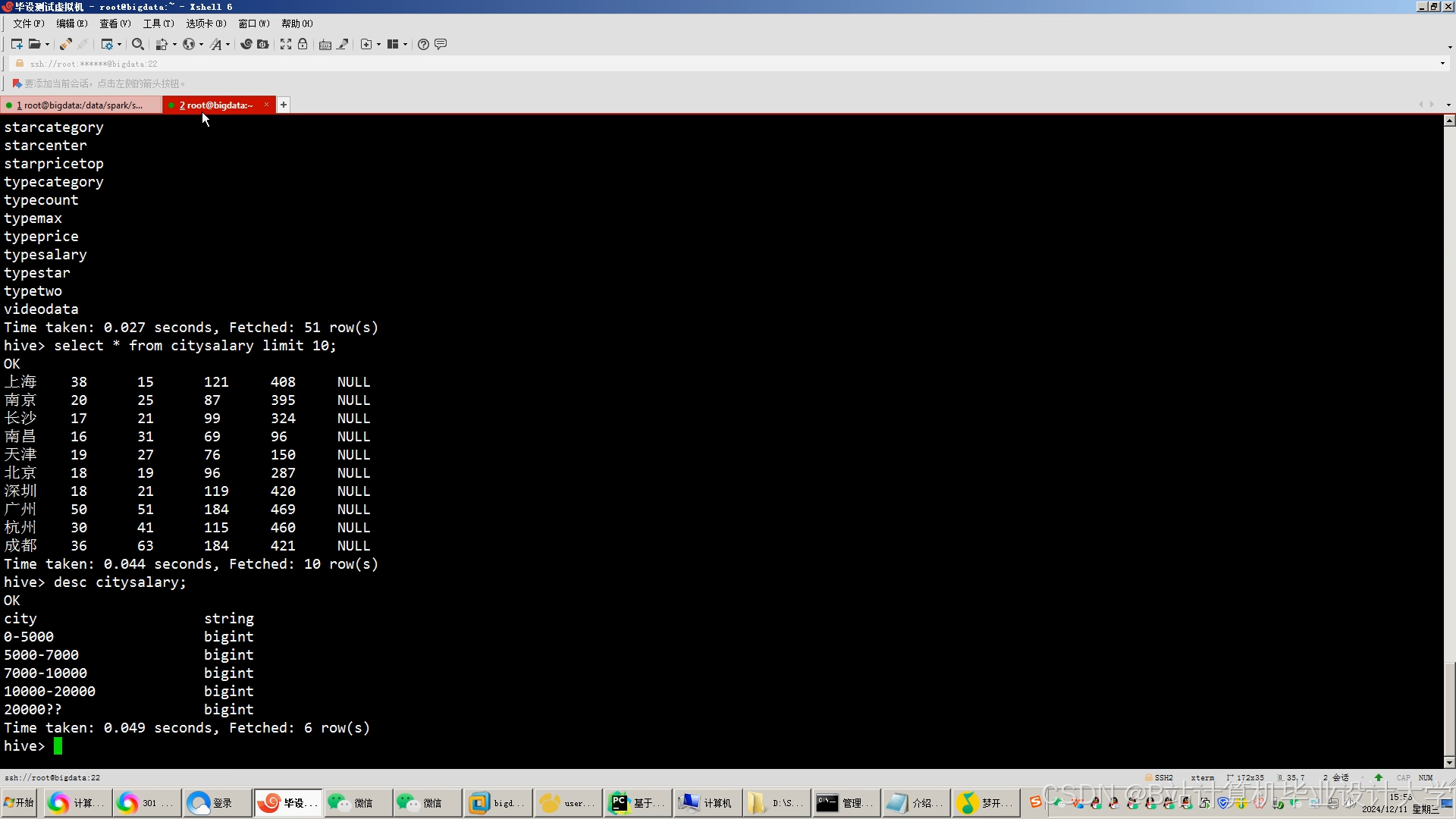

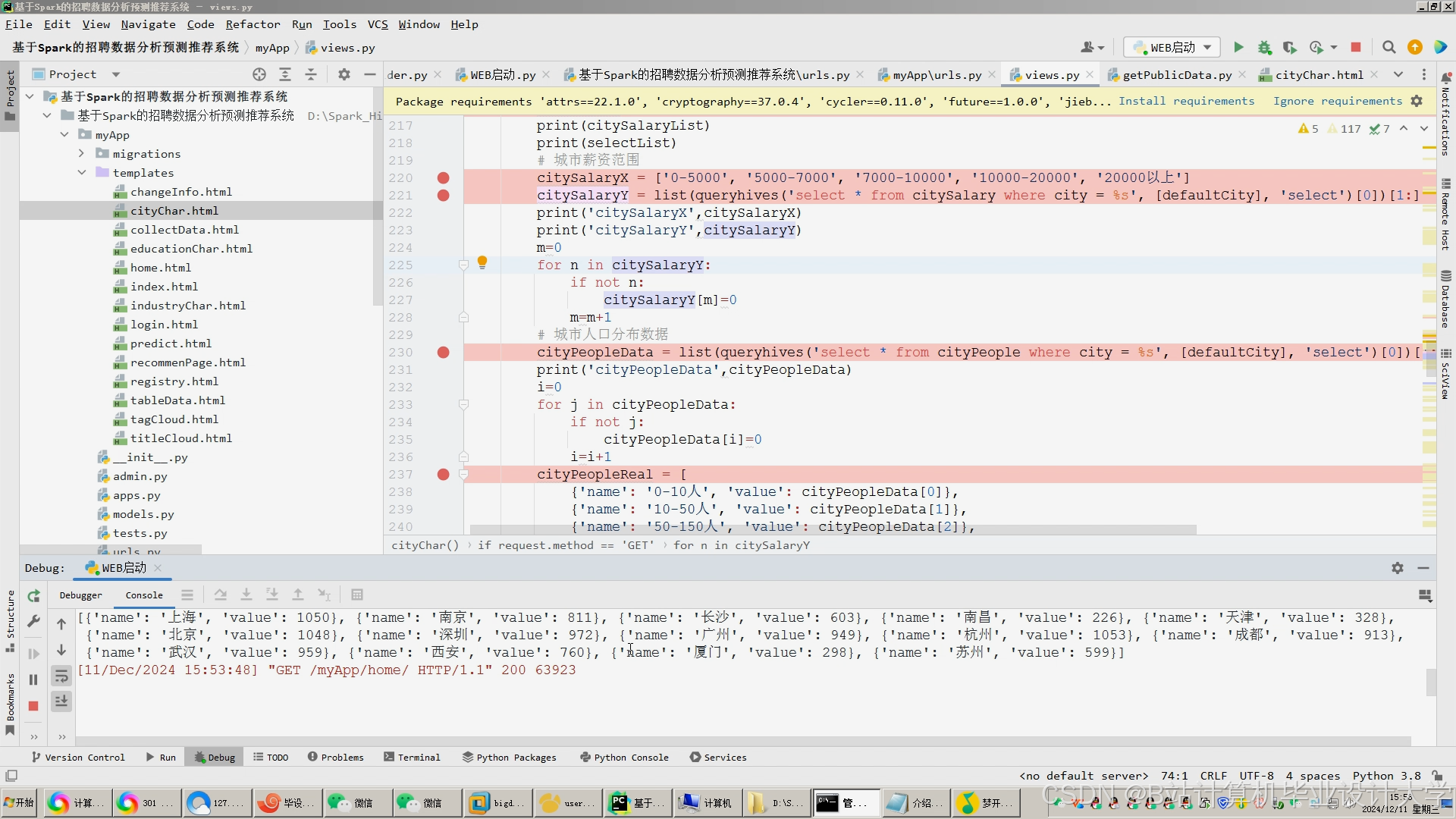

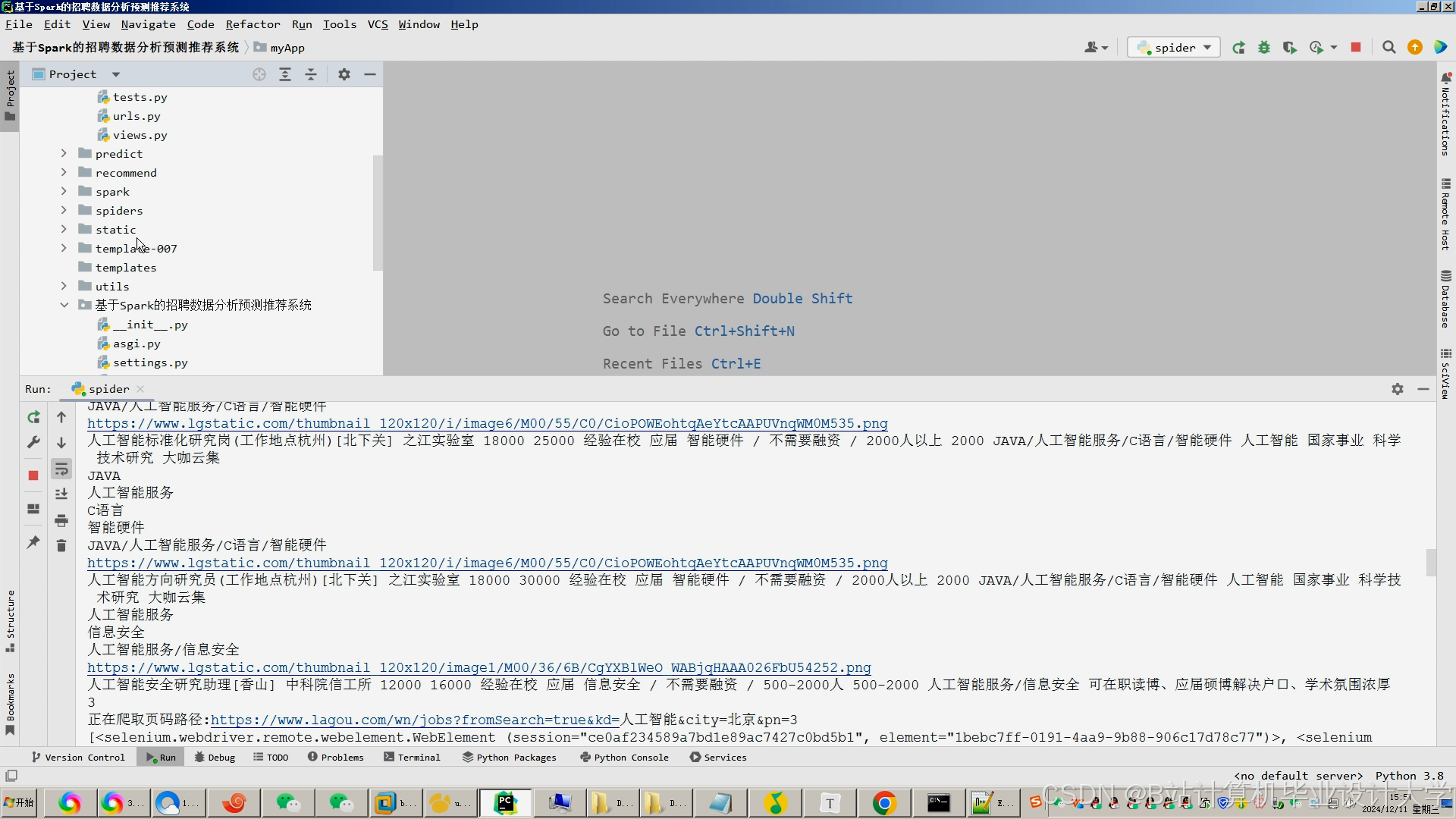

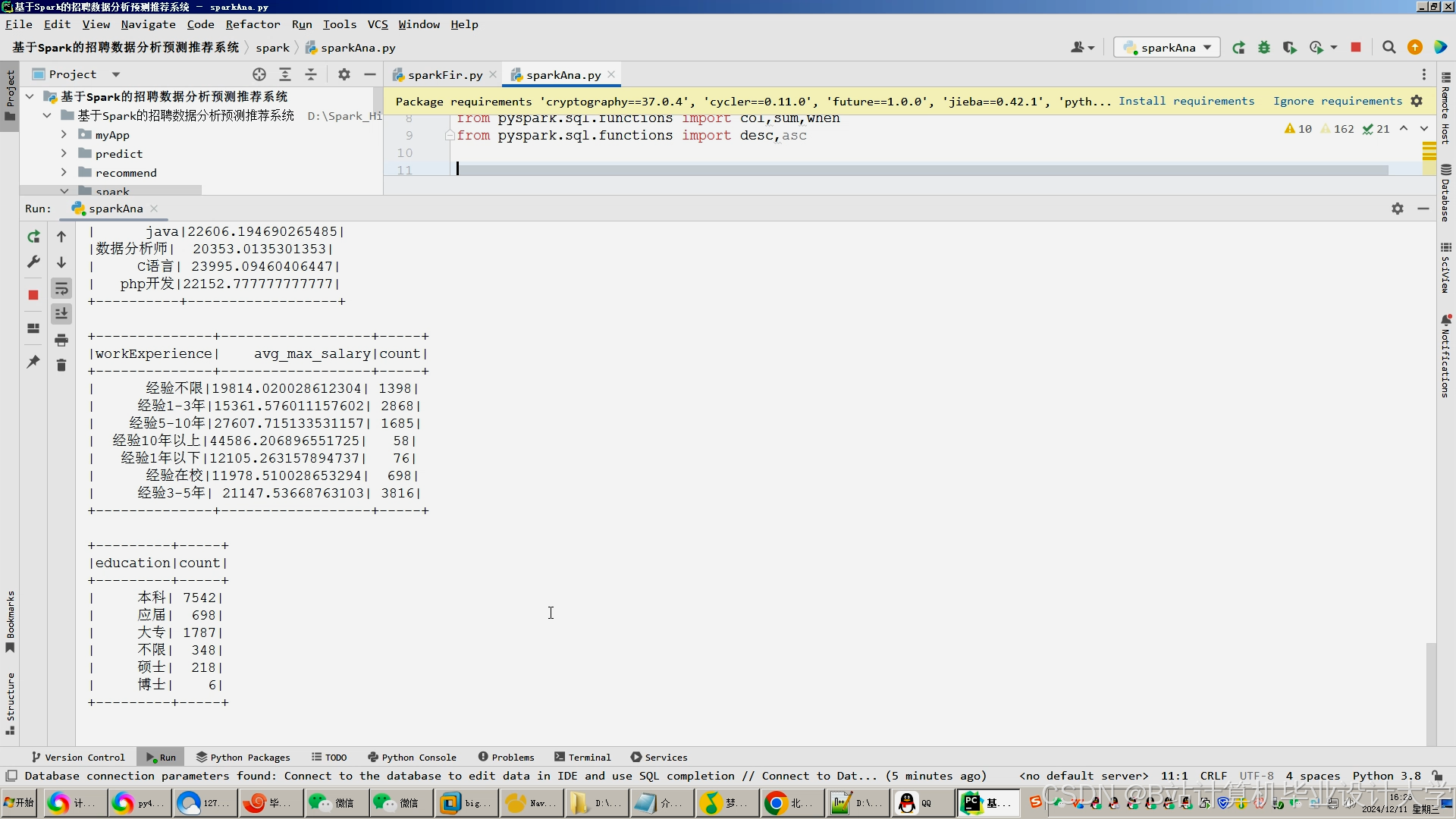

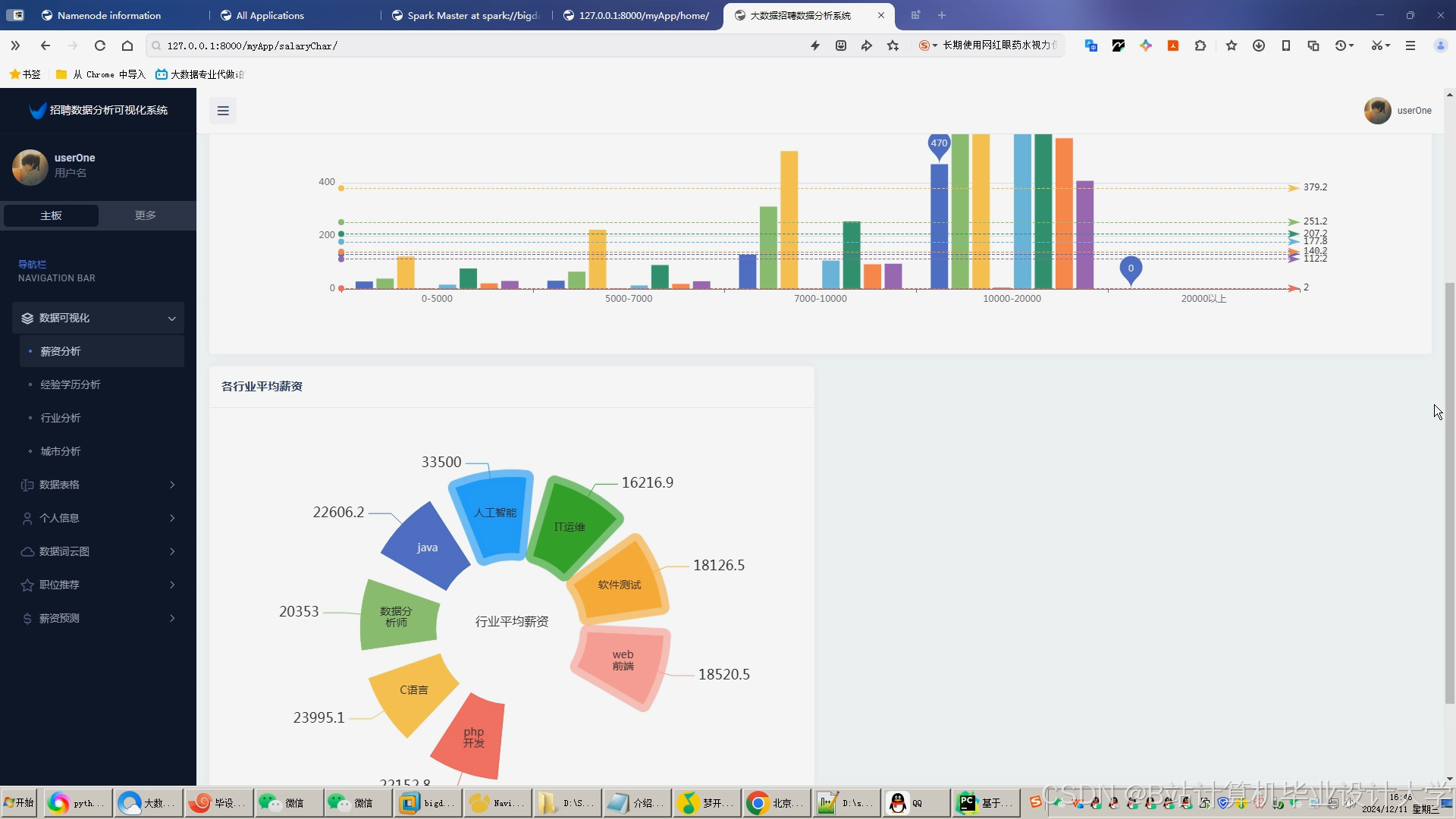

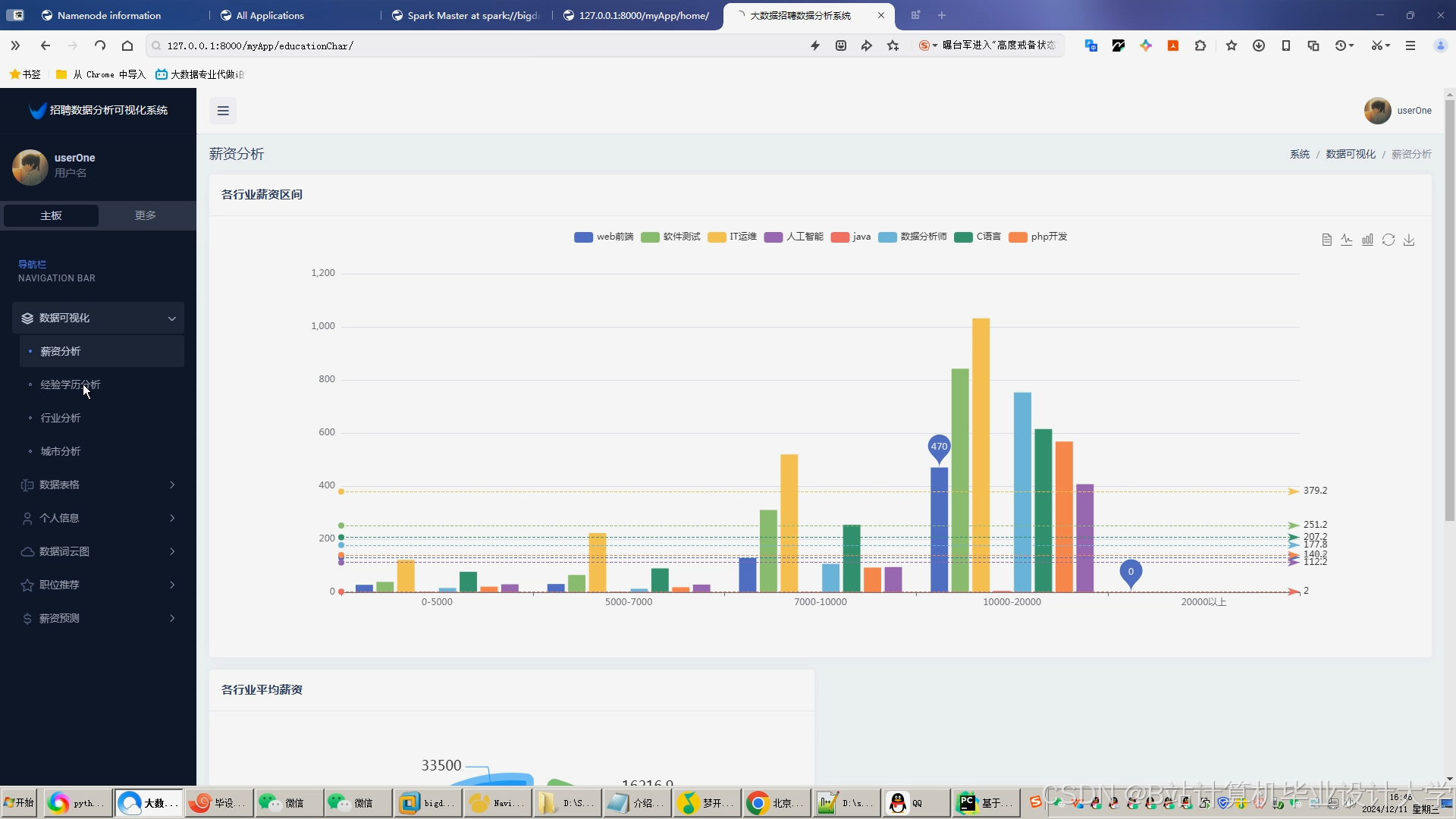

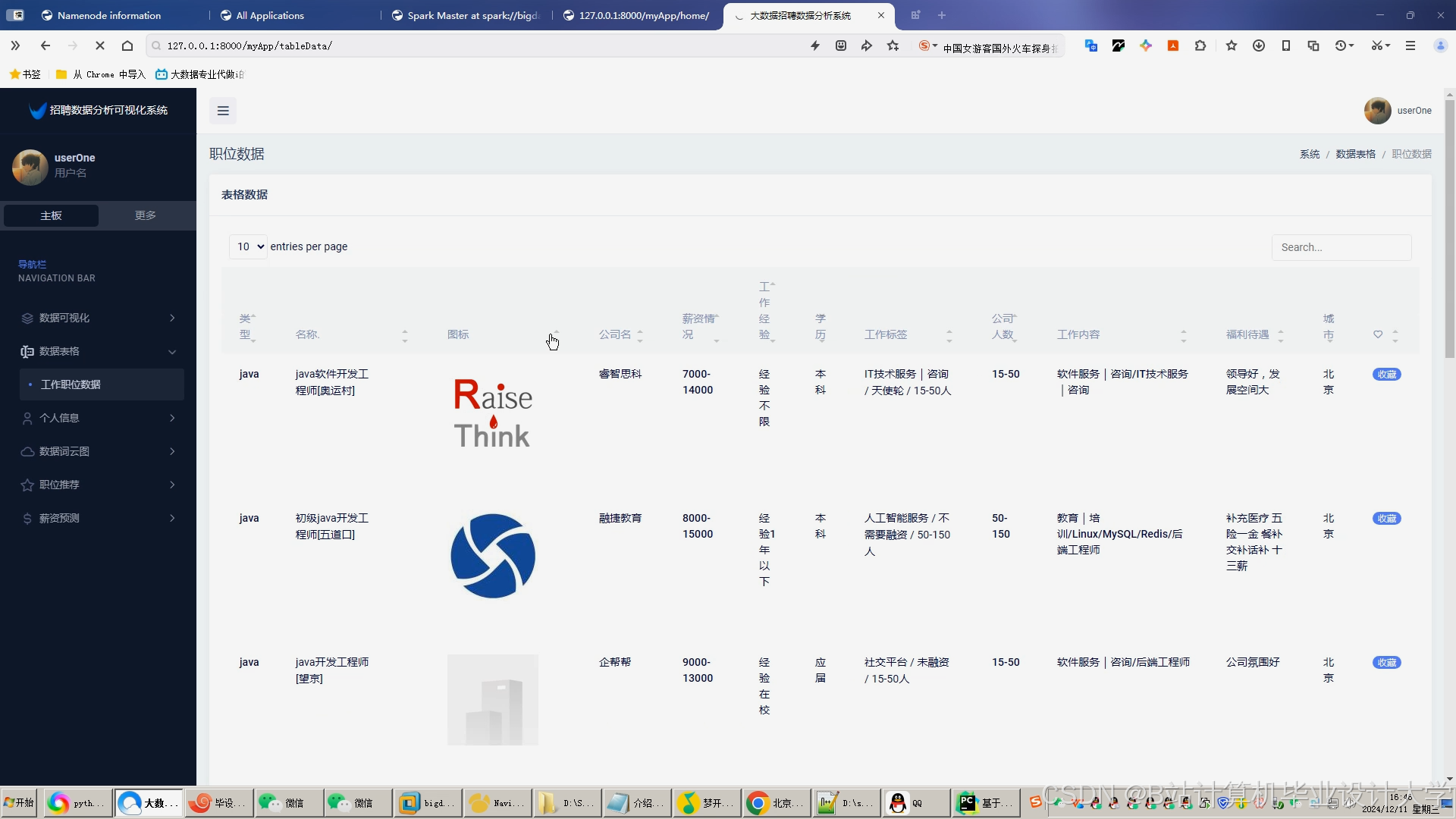

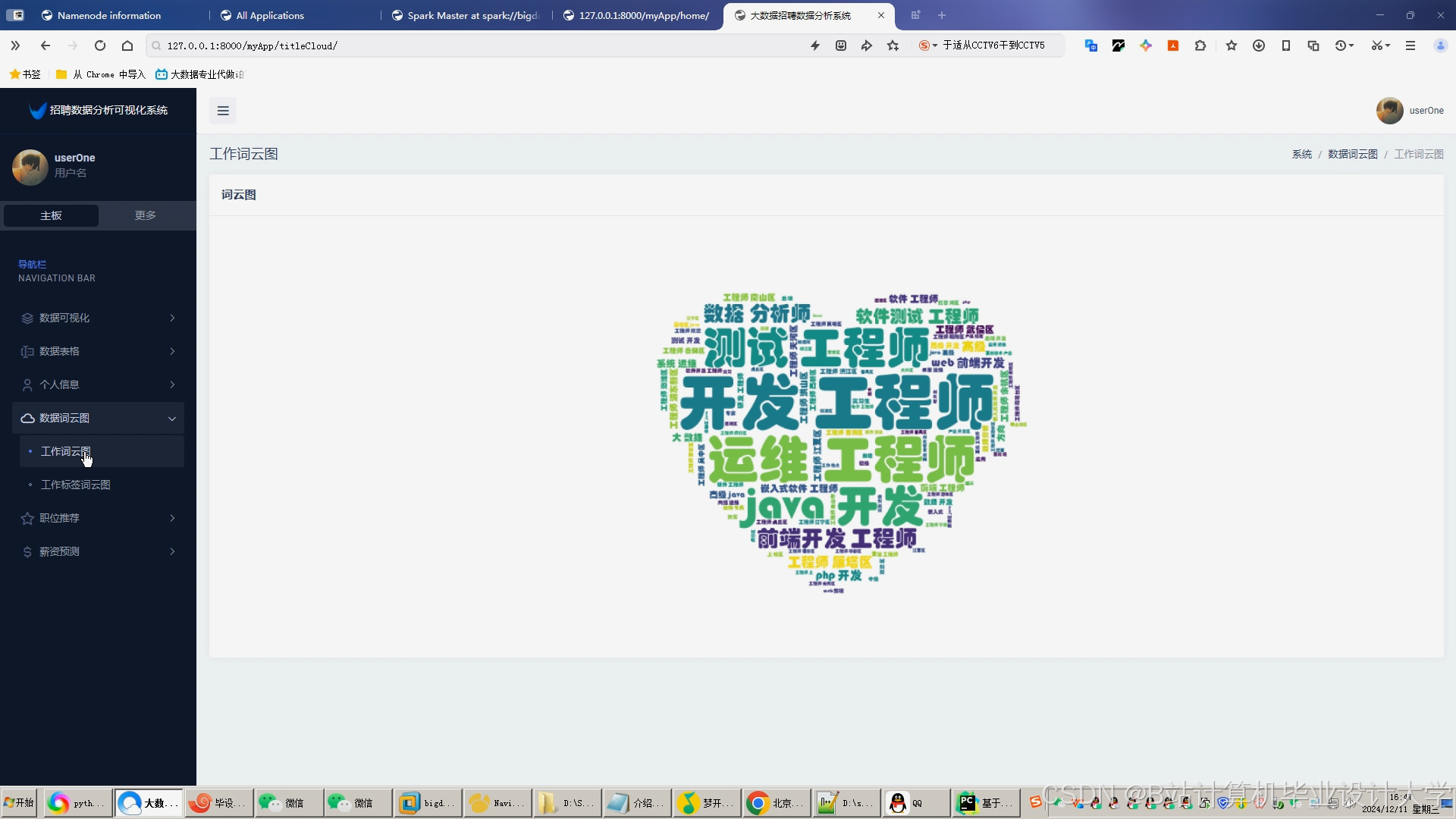

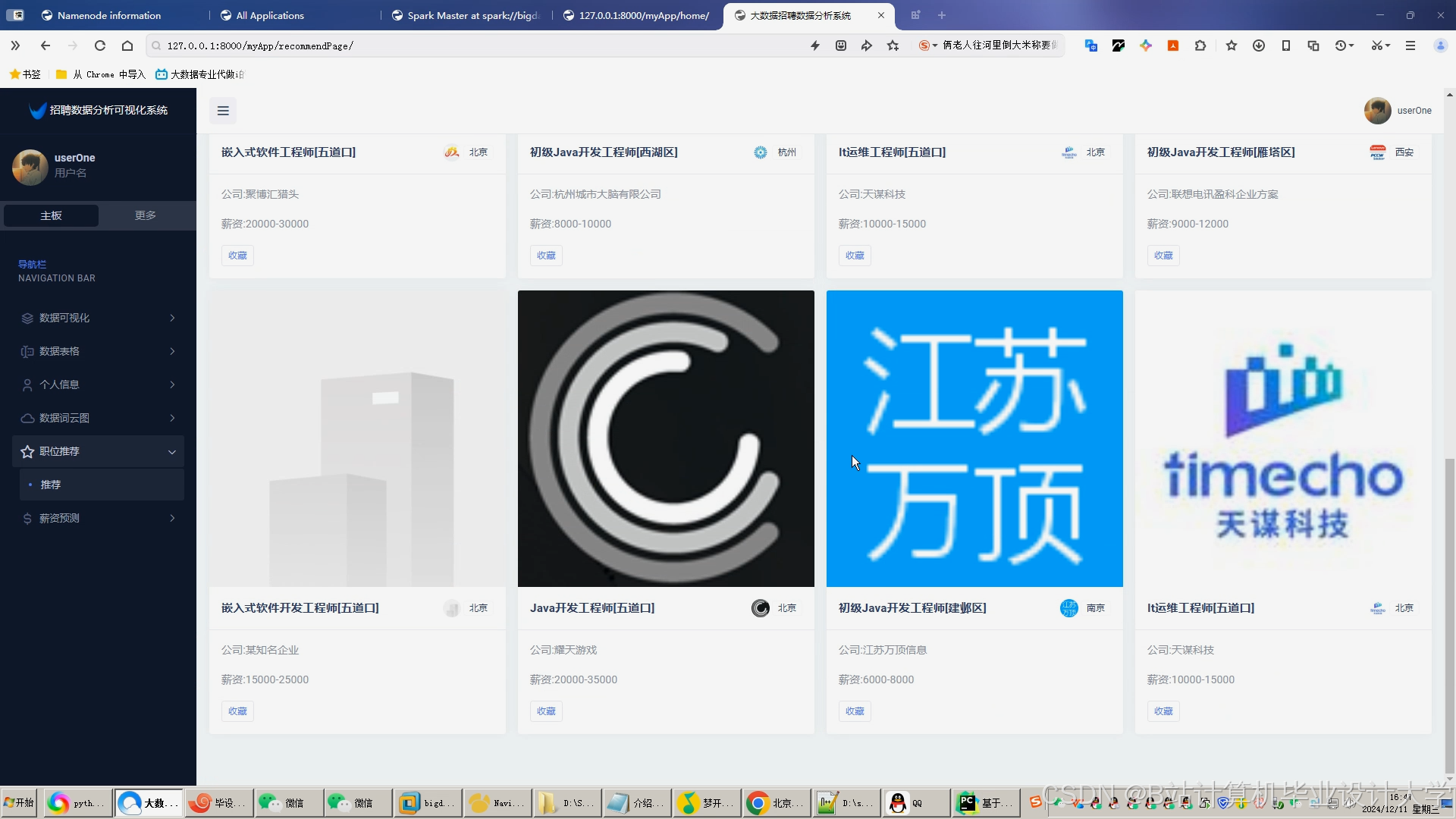

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

411

411

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?