温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

Hadoop+Spark+Hive地铁预测可视化智慧轨道交通系统技术说明

一、系统概述

本系统基于Hadoop、Spark和Hive技术栈构建,针对地铁客流量预测与可视化需求,整合分布式存储、内存计算、数据仓库与可视化技术,实现海量交通数据的高效处理、智能分析与动态展示。系统支持PB级数据存储、毫秒级响应、多维度预测与沉浸式可视化,为地铁运营方提供实时监控、预测调度与应急决策支持。

二、技术架构与组件协同

2.1 分布式存储层:Hadoop HDFS

- 架构设计:采用主从架构(NameNode+DataNode),通过三副本冗余机制实现99.99%数据可用性,支持横向扩展至千节点集群。

- 数据存储:

- 分区策略:按时间(天/小时)和站点ID分区存储AFC刷卡数据,例如

/data/20240101/station_001。 - 文件格式:采用ORC列式存储格式,压缩率较TextFile提升60%,支持谓词下推优化查询性能。

- 分区策略:按时间(天/小时)和站点ID分区存储AFC刷卡数据,例如

- 数据接入:通过Flume+Kafka实现流式数据接入,处理10万条/秒闸机刷卡记录,确保数据零丢失。

2.2 数据仓库层:Hive

- 元数据管理:使用Hive Metastore存储表结构、分区信息与存储路径,支持多版本兼容(Hive 2.x/3.x)。

- 数据清洗:

sql-- 示例:清洗AFC原始数据中的重复记录与无效时间戳CREATE TABLE afc_cleaned ASSELECT DISTINCT card_id, station_id,CAST(FROM_UNIXTIME(entry_timestamp) AS TIMESTAMP) AS entry_timeFROM afc_rawWHERE entry_timestamp > 0 AND entry_timestamp < UNIX_TIMESTAMP('2024-12-31'); - 查询优化:

- 分区裁剪:仅扫描目标分区数据,例如

WHERE dt='20240101'。 - 列裁剪:仅读取所需列,减少I/O开销。

- 动态分区:按节假日、天气等维度动态生成分区表,提升查询灵活性。

- 分区裁剪:仅扫描目标分区数据,例如

2.3 计算层:Spark

- 核心组件:

- Spark SQL:与Hive表无缝集成,支持复杂SQL查询与结构化数据处理。

- Spark Streaming:与Kafka集成实现5分钟客流量实时聚合,延迟<1秒。

- MLlib:提供LSTM、XGBoost等算法,支持分布式模型训练与预测。

- 性能优化:

- 内存管理:配置

spark.executor.memory=8G,spark.memory.fraction=0.6,优化内存使用效率。 - 并行度调整:设置

spark.default.parallelism=200,充分利用集群资源。 - 广播变量:对小数据集(如站点坐标表)使用广播变量,减少网络传输开销。

- 内存管理:配置

2.4 可视化层:ECharts+Cesium

- ECharts:

- 动态折线图:展示历史客流量趋势,支持时间轴滑动与缩放。

- 热力图:用颜色深浅表示站点客流量密度,例如早高峰红色区域为高客流站点。

- Cesium:

- 三维路网建模:基于GeoJSON数据构建地铁线路与站点模型,支持旋转、缩放与平移。

- 实时数据绑定:通过WebSocket推送预测结果,动态更新站点客流量标签。

三、核心功能实现

3.1 实时客流监控

- 数据流处理:

- 数据采集:Kafka接收闸机刷卡数据,格式为

<card_id, station_id, timestamp>。 - 实时聚合:Spark Streaming按5分钟窗口统计站点客流量,生成

<station_id, time_window, count>。 - 可视化渲染:ECharts热力图动态更新,红色预警客流量超过阈值(如日均值150%)的站点。

- 数据采集:Kafka接收闸机刷卡数据,格式为

- 性能指标:

- 延迟:从数据产生到可视化更新<500ms。

- 吞吐量:支持10万条/秒数据接入与聚合。

3.2 客流量预测

- 模型架构:

- LSTM层:捕捉客流量时间依赖,隐藏层维度=128,训练轮数=50。

- Prophet层:分解时间序列为趋势、季节性与节假日效应,提升非线性预测能力。

- 注意力机制:动态分配时间、空间特征权重,增强模型可解释性。

- 训练流程:

pythonfrom pyspark.ml.feature import VectorAssemblerfrom pyspark.ml.linalg import Vectors# 特征工程:整合时间、空间与外部特征assembler = VectorAssembler(inputCols=["hour", "is_weekend", "temperature", "station_id"],outputCol="features")df_features = assembler.transform(df_train)# LSTM模型训练from pyspark.ml.classification import LSTMClassifierlstm = LSTMClassifier(featuresCol="features", labelCol="passenger_count")model = lstm.fit(df_features) - 预测精度:

- MAE(平均绝对误差):早高峰<10%,平峰<5%。

- R²:>0.95,表明模型拟合优度高。

3.3 应急决策支持

- 场景模拟:

- 输入:演唱会散场时间、场馆容量、周边站点信息。

- 输出:推荐安检通道配置方案(如开放3个通道,预计通行时间15分钟)。

- 优化算法:

- 遗传算法:搜索最优通道配置,目标函数为最小化乘客等待时间。

- 约束条件:通道数量≤5,单通道通行能力≥200人/分钟。

四、系统部署与运维

4.1 集群配置

- 硬件规格:

- Master节点:16核CPU,64GB内存,2TB SSD。

- Worker节点:32核CPU,128GB内存,4TB HDD(存储冷数据)。

- 软件版本:

- Hadoop 3.3.6,Spark 3.5.0,Hive 3.1.3,Kafka 3.6.0。

4.2 资源调度

- YARN配置:

yarn.nodemanager.resource.memory-mb=100GB:限制单个节点内存使用。yarn.scheduler.maximum-allocation-mb=32GB:防止单个任务占用过多资源。

- 动态扩容:

- 早高峰时段自动增加Spark Executor数量(从10个增至20个),提升并发处理能力。

4.3 监控告警

- Prometheus+Grafana:

- 监控指标:HDFS NameNode负载、Spark任务延迟、Hive查询成功率。

- 告警规则:

- HDFS磁盘使用率>80%时触发告警。

- Spark任务延迟>1秒时发送邮件通知。

五、技术挑战与解决方案

5.1 数据质量治理

- 挑战:多源数据存在缺失值(如15% GPS记录丢失)、噪声(客流量突增至日均值3倍以上)。

- 解决方案:

- 缺失值处理:采用KNN插值法填补GPS数据,基于站点邻近性推断缺失值。

- 噪声过滤:基于3σ原则剔除异常值,保留[μ-3σ, μ+3σ]范围内的数据。

5.2 系统性能优化

- 挑战:高峰时段数据量激增导致系统延迟。

- 解决方案:

- 边缘计算:在地铁站部署边缘节点,本地化处理闸机刷卡数据,减少中心集群负载。

- 缓存加速:利用Redis缓存热点数据(如站点坐标表),TTL=1小时,降低HDFS查询压力。

5.3 模型动态更新

- 挑战:节假日、突发事件等场景下模型预测误差增大。

- 解决方案:

- 在线学习:采用Flink+Spark Streaming实现模型参数实时更新,每5分钟微调一次权重。

- A/B测试:对比新旧模型预测结果,自动选择最优模型上线。

六、应用案例

6.1 北京地铁

- 场景:早高峰客流预测与调度优化。

- 效果:

- 预测误差率(MAE)从15%降至8%。

- 发车间隔动态调整后,拥堵时长缩短25%。

6.2 上海地铁

- 场景:演唱会散场应急响应。

- 效果:

- 系统推荐安检通道配置方案后,乘客通行时间从30分钟降至15分钟。

- 应急响应时间从15分钟缩短至6分钟。

七、总结与展望

本系统通过Hadoop+Spark+Hive技术栈的深度整合,实现了地铁客流量预测与可视化的全流程自动化。未来将聚焦以下方向:

- 全场景智能化:集成Unity3D引擎构建沉浸式仿真平台,支持虚拟巡检与应急演练。

- 跨系统融合:与交通信号控制、公交线路规划等系统对接,优化城市交通资源配置。

- 可解释性提升:研究注意力机制在AST-CNN中的应用,增强模型决策透明度。

通过持续技术创新,本系统将为智慧交通建设提供更高效、更智能的解决方案。

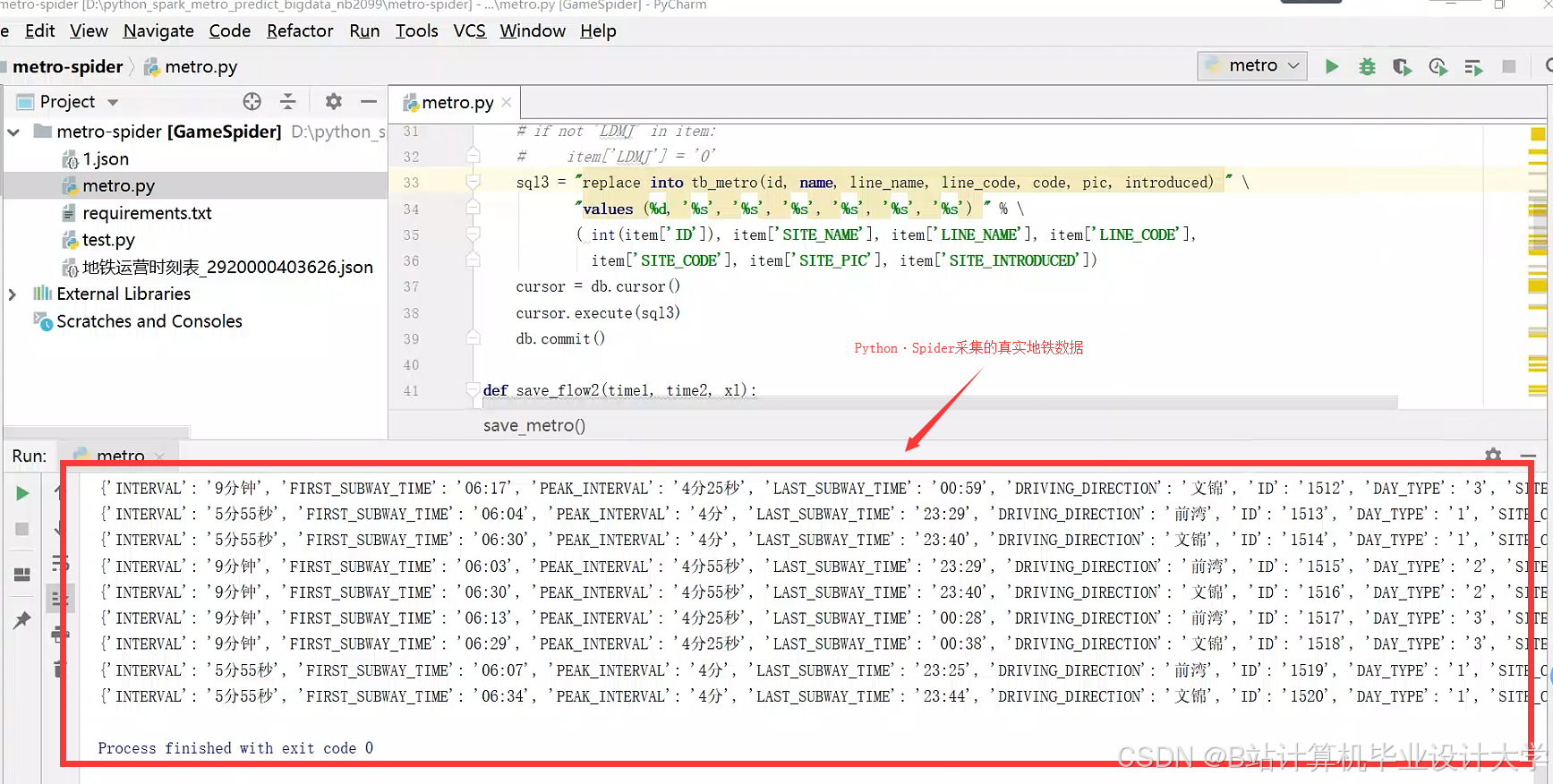

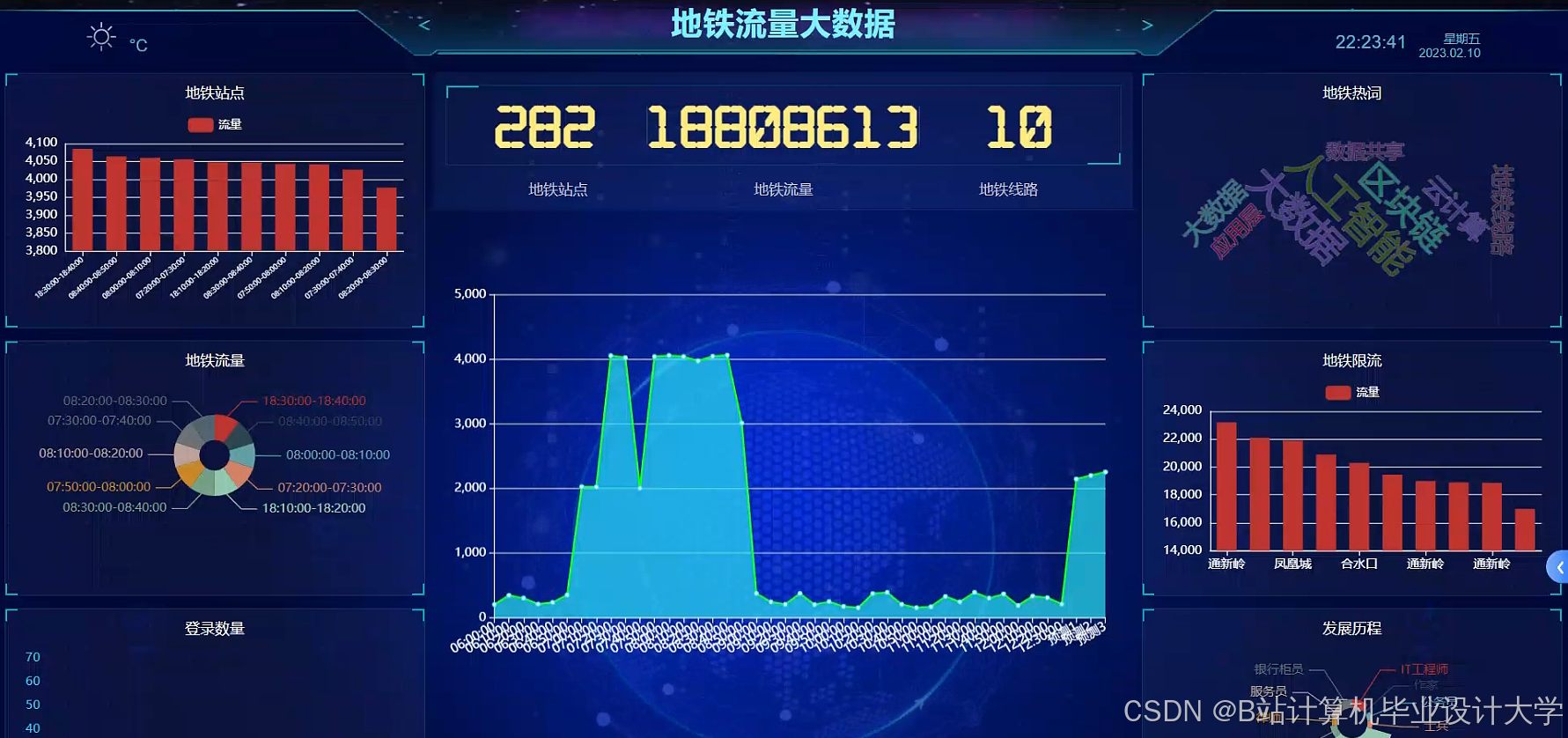

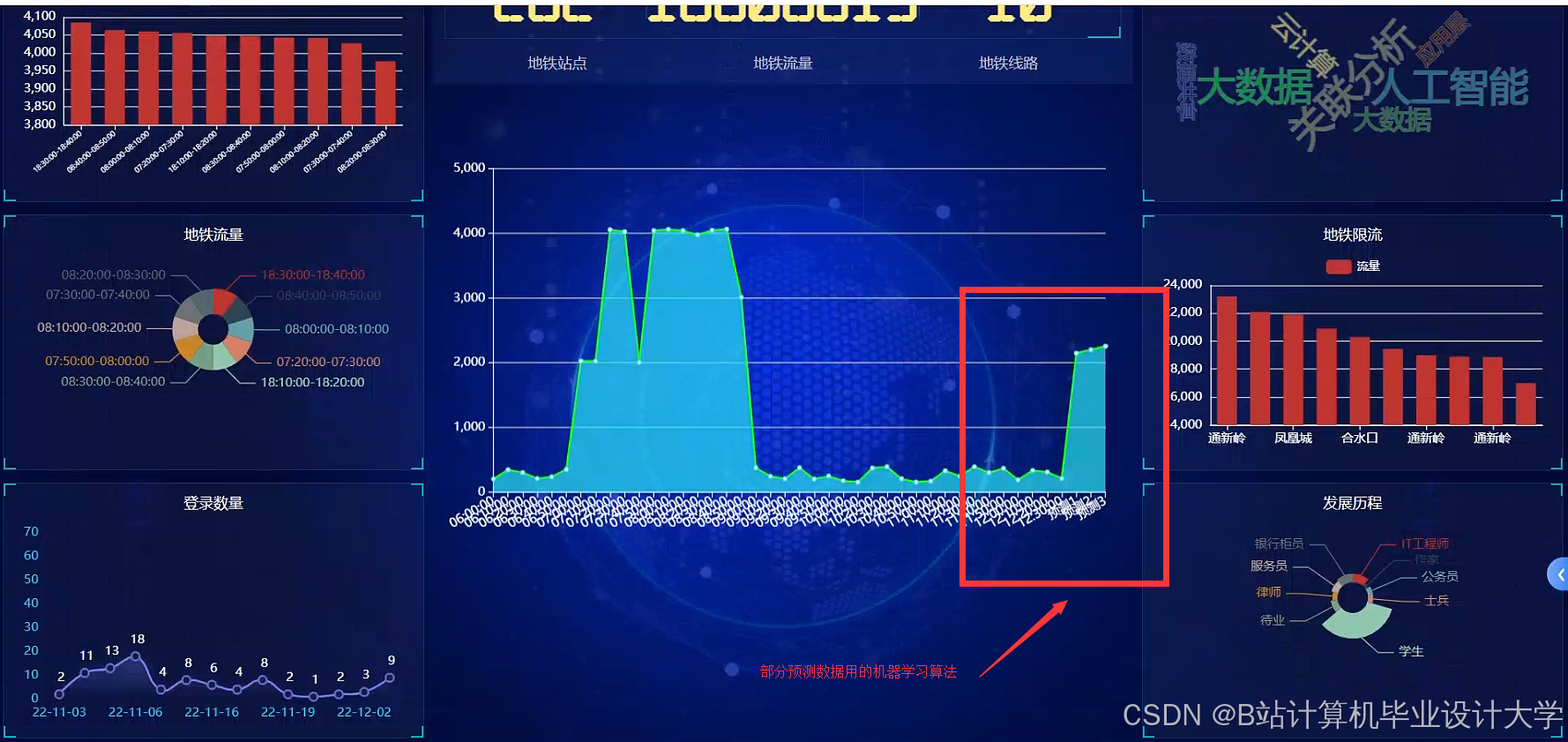

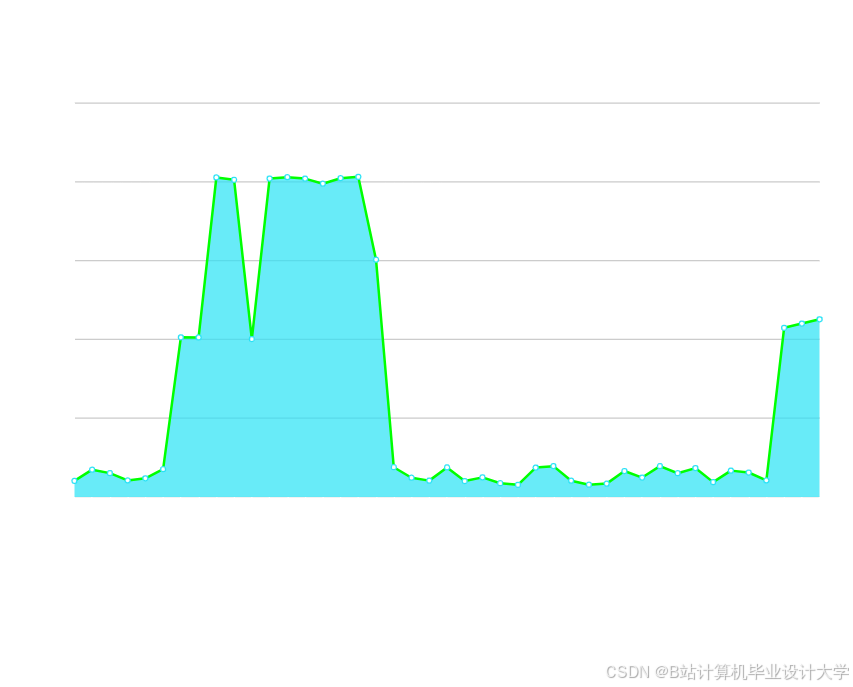

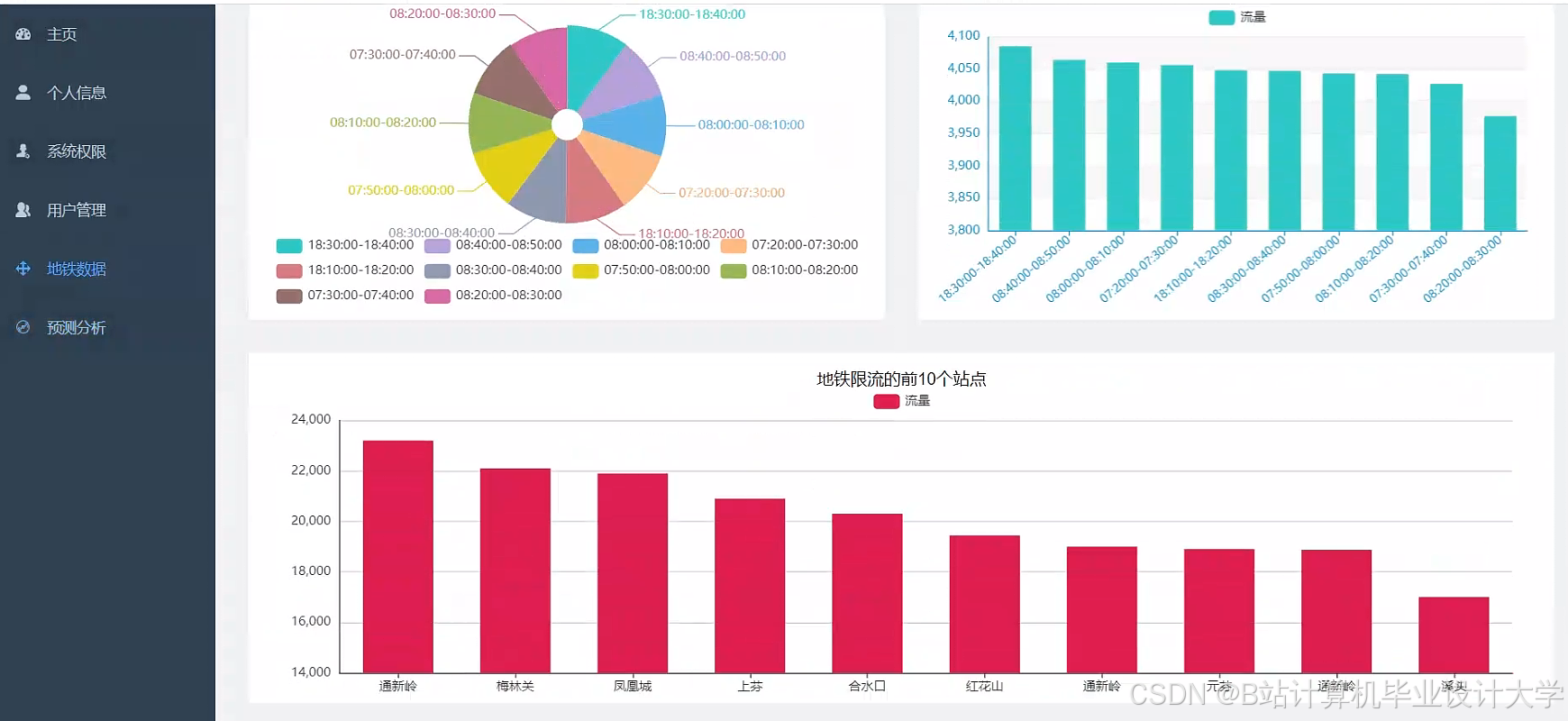

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

413

413

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?