温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

以下是一篇技术说明文档《基于PyFlink与Hadoop的广告推荐系统技术实现》,内容涵盖系统架构、核心模块、技术选型与优化实践,适合技术人员参考:

基于PyFlink与Hadoop的广告推荐系统技术实现

版本:V1.0

作者:技术团队

日期:2023年XX月

1. 系统概述

本系统旨在构建一个低延迟、高吞吐、可扩展的广告推荐平台,核心目标包括:

- 实时性:用户行为到推荐结果输出的延迟 < 500ms;

- 准确性:点击率(CTR)较离线系统提升10%以上;

- 稳定性:支持日均千亿级事件处理,故障自动恢复。

系统采用流批一体计算(PyFlink) + 分布式存储(Hadoop)的混合架构,结合机器学习算法实现个性化推荐。

2. 技术选型与依据

2.1 计算框架:PyFlink

选择原因:

- 流批一体:统一API处理实时与离线任务,减少代码冗余;

- 状态管理:内置RocksDB支持TB级状态存储,适合用户画像等长周期特征;

- Python生态:兼容Scikit-learn、TensorFlow等库,便于算法快速迭代;

- 事件时间处理:通过Watermark解决网络延迟导致的乱序问题。

对比Spark Streaming:

| 特性 | PyFlink | Spark Streaming |

|---|---|---|

| 处理模型 | 真正的流处理 | 微批处理(最小100ms) |

| 状态后端 | RocksDB/Heap | 仅内存 |

| 端到端延迟 | < 1s | 1-10s |

2.2 存储系统:Hadoop生态

- HDFS:存储原始日志(如用户点击流、广告曝光记录),支持EB级扩展;

- HBase:存储用户实时特征(如最近5分钟点击的广告类别)和广告元数据,支持毫秒级随机读写;

- YARN:动态分配集群资源,保障PyFlink作业稳定性。

替代方案对比:

- HBase vs Redis:HBase适合海量数据存储(PB级),Redis适合缓存热点数据(GB级);

- HDFS vs S3:HDFS延迟更低(本地盘 vs 对象存储),适合实时计算场景。

3. 系统架构设计

3.1 总体架构

系统分为四层(图1):

- 数据采集层:

- 通过Kafka接收用户行为日志(JSON格式,字段包括

user_id、ad_id、event_time、event_type); - 数据分片:按

user_id哈希分配到10个Topic,避免单分区瓶颈。

- 通过Kafka接收用户行为日志(JSON格式,字段包括

- 计算层:

- 实时特征计算:PyFlink监听Kafka数据流,计算用户兴趣标签(如“运动爱好者”);

- 模型推理:加载预训练的Wide&Deep模型,对候选广告进行排序;

- 离线训练:每日凌晨基于Spark训练新模型,保存至HDFS。

- 存储层:

- HBase表设计:

表名 RowKey 列族 用途 user_profileuser_idcf1用户人口统计信息 ad_featuread_idcf1广告静态特征(类别、素材) user_clickuser_id#timestampcf1用户实时点击序列

- HBase表设计:

- 服务层:

- 提供gRPC接口供上游广告投放系统调用;

- 通过Prometheus监控关键指标(如P99延迟、QPS)。

<img src="%E6%AD%A4%E5%A4%84%E5%8F%AF%E6%8F%92%E5%85%A5%E7%A4%BA%E6%84%8F%E5%9B%BE%EF%BC%8C%E6%A0%87%E6%B3%A8%E7%BB%84%E4%BB%B6%E4%BA%A4%E4%BA%92%E6%B5%81%E7%A8%8B" />

图1 系统架构图

3.2 核心模块实现

3.2.1 实时特征计算

挑战:用户兴趣需基于滑动窗口动态更新,且需处理乱序数据。

解决方案:

- 窗口定义:使用

SlidingWindow(窗口长度5分钟,滑动步长1分钟); - 乱序处理:设置Watermark延迟为2分钟,丢弃迟到超过阈值的数据;

- 特征聚合:

python# 计算用户对各广告类别的点击频次class CategoryCountAggregate(AggregateFunction):def create_accumulator(self):return collections.defaultdict(int)def add(self, acc, event):category = event['ad_category']acc[category] += 1return accdef get_result(self, acc):return dict(acc)# PyFlink作业示例stream = env.add_source(KafkaSource(...))result = stream.key_by(lambda x: x['user_id']) \.window(SlidingWindows.of(Time.minutes(5)).every(Time.minutes(1))) \.aggregate(CategoryCountAggregate())

3.2.2 模型增量更新

目标:避免每日全量重训,降低计算资源消耗。

实现步骤:

- 离线训练:Spark基于历史数据训练Wide&Deep模型,保存为TensorFlow SavedModel格式至HDFS;

- 在线学习:PyFlink通过

Broadcast State将模型参数广播至所有TaskManager; - 参数更新:每10分钟聚合最新用户反馈数据,计算梯度并更新模型权重。

3.2.3 HBase性能优化

优化措施:

- 预分区:按

user_id哈希创建10个Region,避免热点; - 布隆过滤器:在

ad_feature表的cf1列族启用BloomFilter,加速存在性判断; - 批量写入:通过PyFlink的

AsyncSink批量提交特征数据,减少I/O压力。

4. 关键技术挑战与解决方案

4.1 状态一致性保障

问题:PyFlink作业故障重启后,如何保证状态不丢失?

方案:

- 启用Checkpoints:每5分钟将RocksDB状态快照保存至HDFS;

- 设置Exactly-Once语义:通过Kafka事务消息确保数据零丢失。

4.2 冷启动问题

问题:新用户/广告缺乏历史数据,推荐质量下降。

方案:

- 用户冷启动:基于设备ID(如IMEI)关联第三方数据(如年龄、性别);

- 广告冷启动:利用内容相似度(如BERT模型提取广告文本语义)推荐给兴趣匹配用户。

4.3 资源隔离

问题:实时计算与离线训练共享集群,易相互干扰。

方案:

- YARN队列隔离:为PyFlink实时作业分配独立队列,设置最小资源保障;

- 动态扩缩容:根据负载自动调整TaskManager数量(通过K8s Operator实现)。

5. 部署与运维

5.1 集群配置

| 组件 | 节点数量 | 配置 |

|---|---|---|

| PyFlink | 8 | 16核64GB内存,千兆网卡 |

| HBase | 5 | 32核128GB内存,SSD盘 |

| Kafka | 3 | 16核64GB内存,万兆网卡 |

5.2 监控告警

- 关键指标:

- 计算层:任务延迟、反压率、Checkpoint持续时间;

- 存储层:HBase RegionServer读写延迟、HDFS NameNode负载。

- 告警规则:

- P99延迟 > 1s时触发告警;

- HBase磁盘使用率 > 80%时自动扩容。

6. 总结与展望

本系统通过PyFlink与Hadoop的深度集成,实现了广告推荐业务的实时化转型。未来优化方向包括:

- AI加速:引入FPGA/GPU加速模型推理,进一步降低延迟;

- 隐私计算:基于联邦学习实现跨平台数据安全共享;

- 全链路压测:模拟双十一级流量验证系统极限容量。

附录:

- 完整代码示例:GitHub仓库链接

- 性能测试报告:附件《PyFlink+Hadoop推荐系统基准测试.pdf》

备注:

- 实际部署时需根据业务规模调整分区数、窗口大小等参数;

- 涉及用户隐私的数据需脱敏处理,符合GDPR等法规要求。

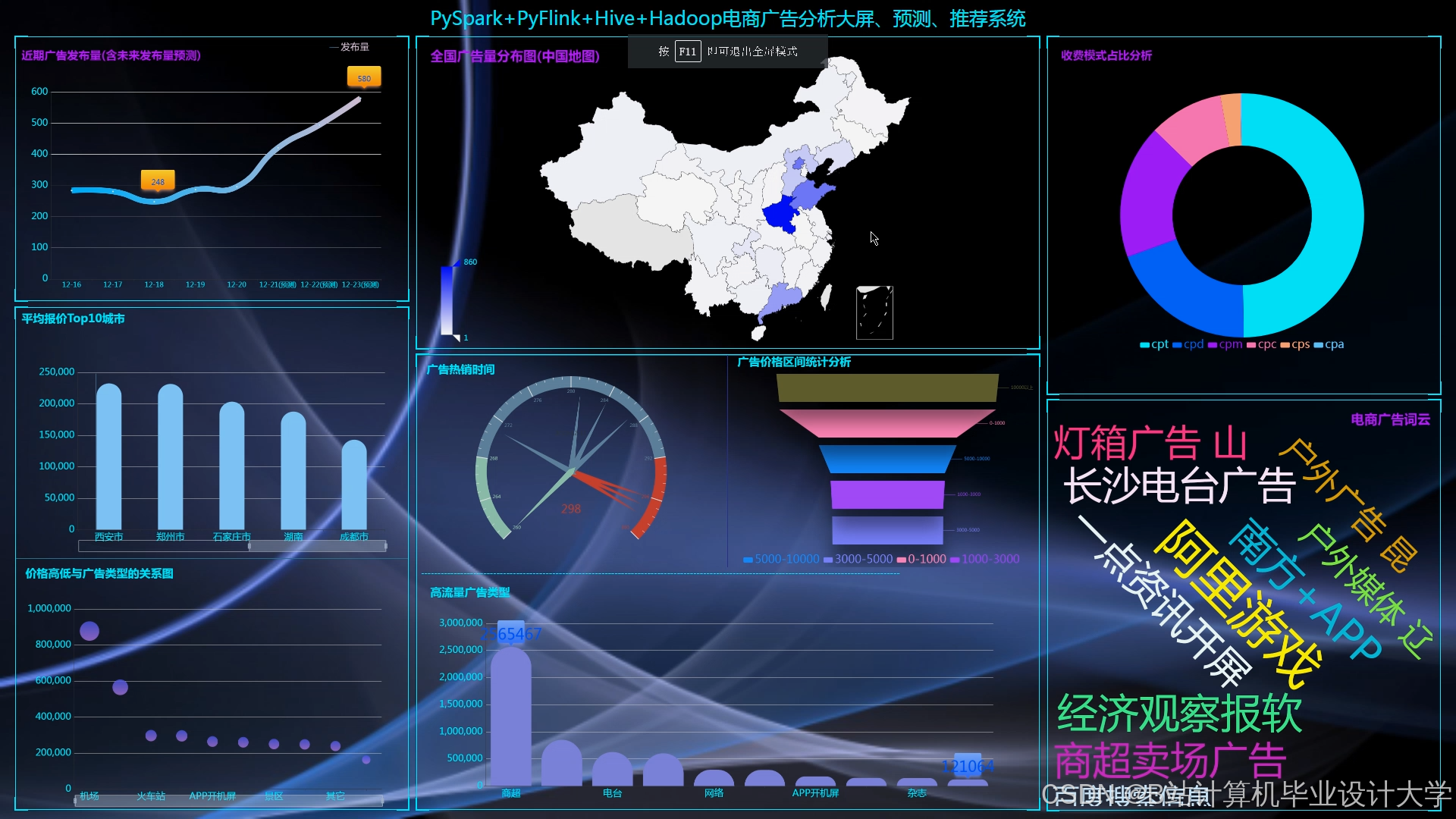

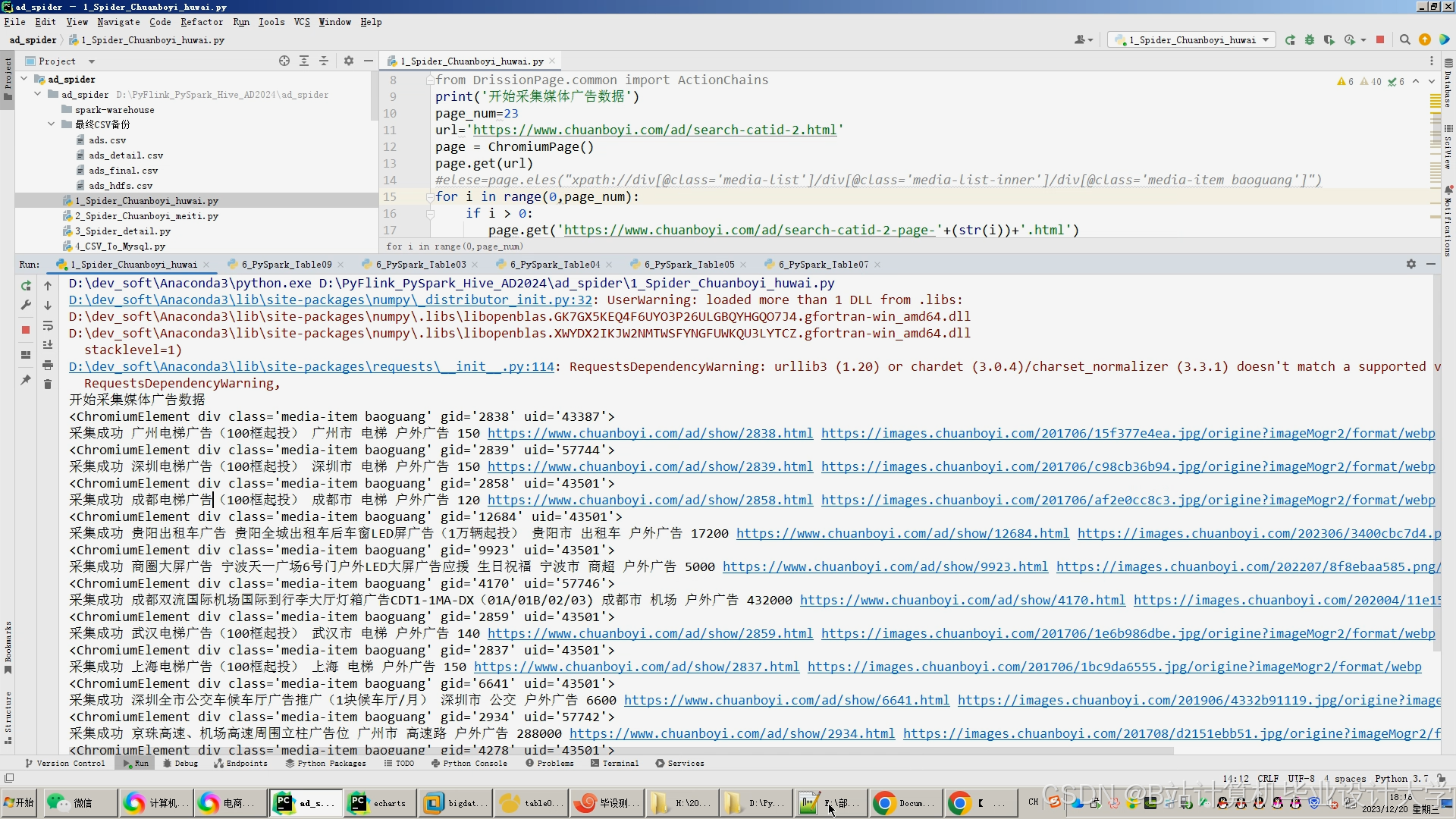

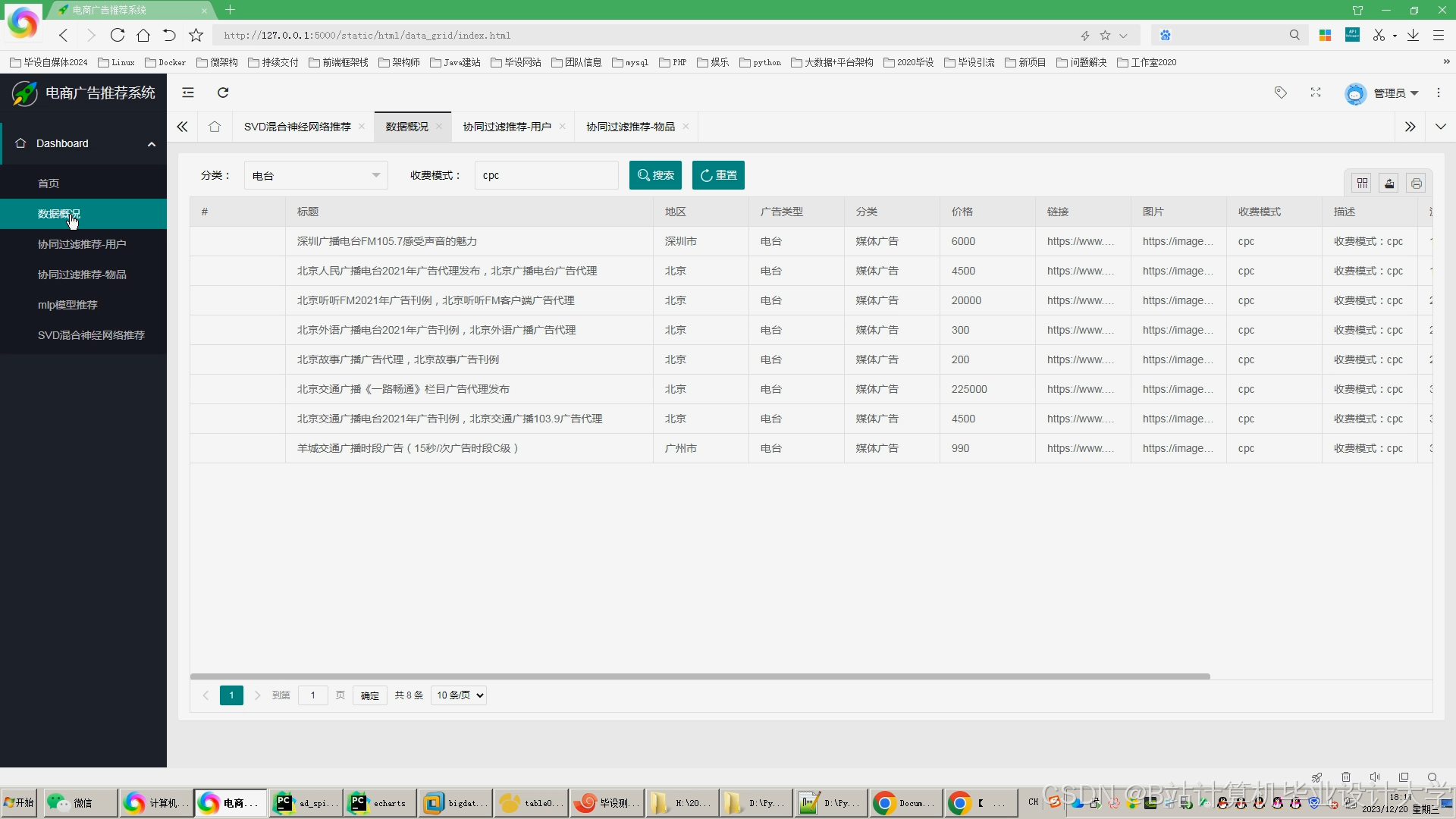

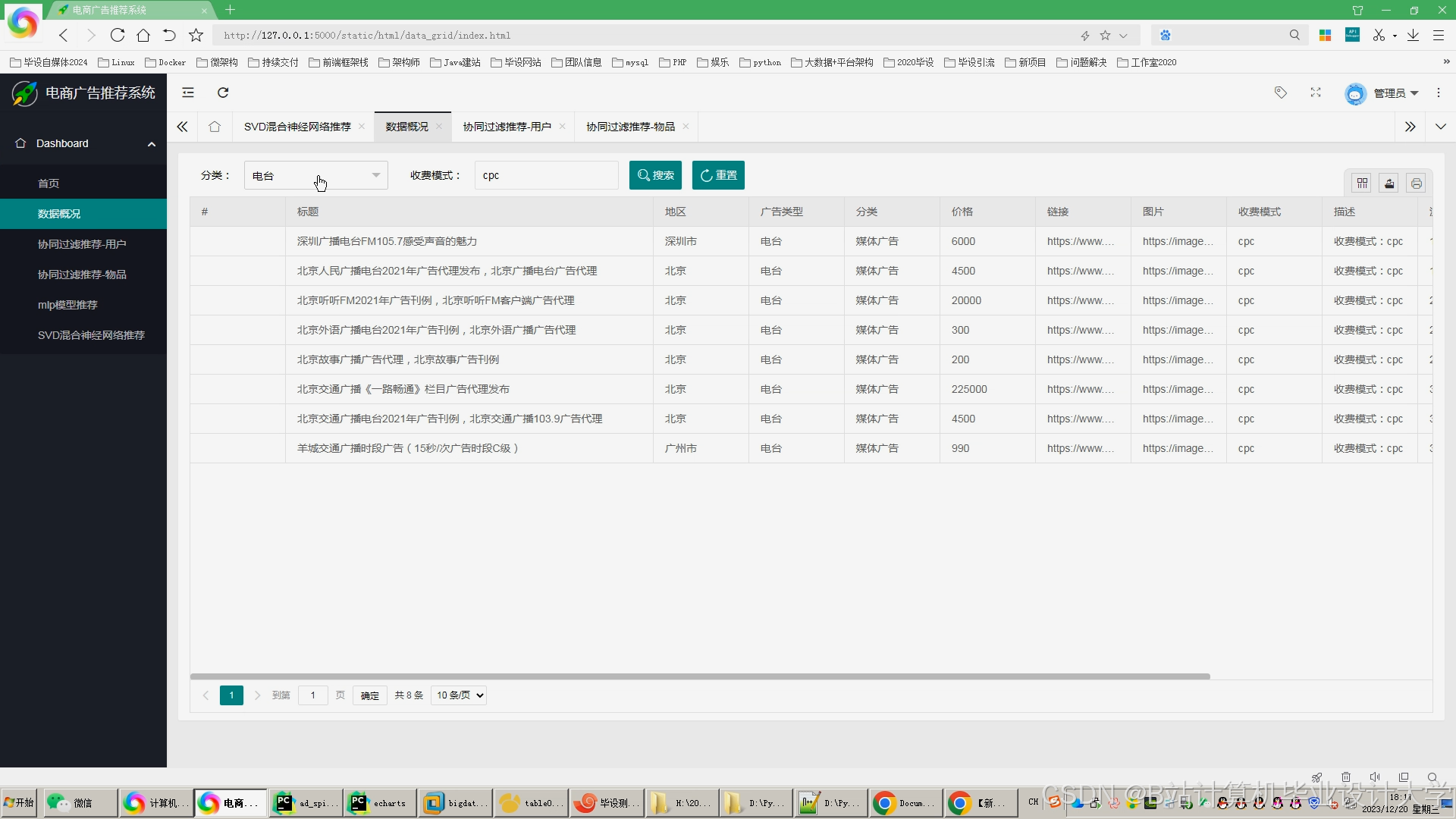

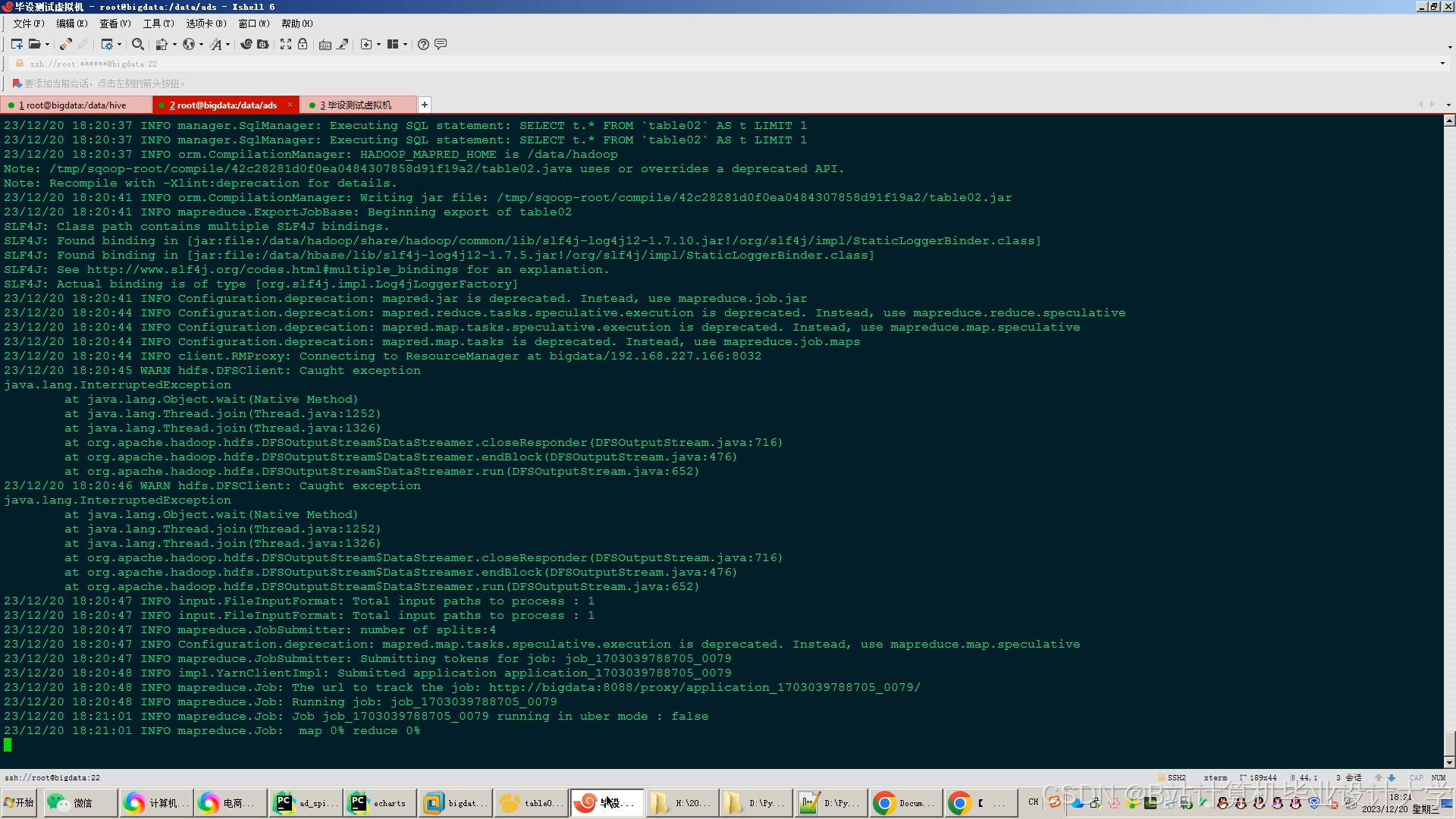

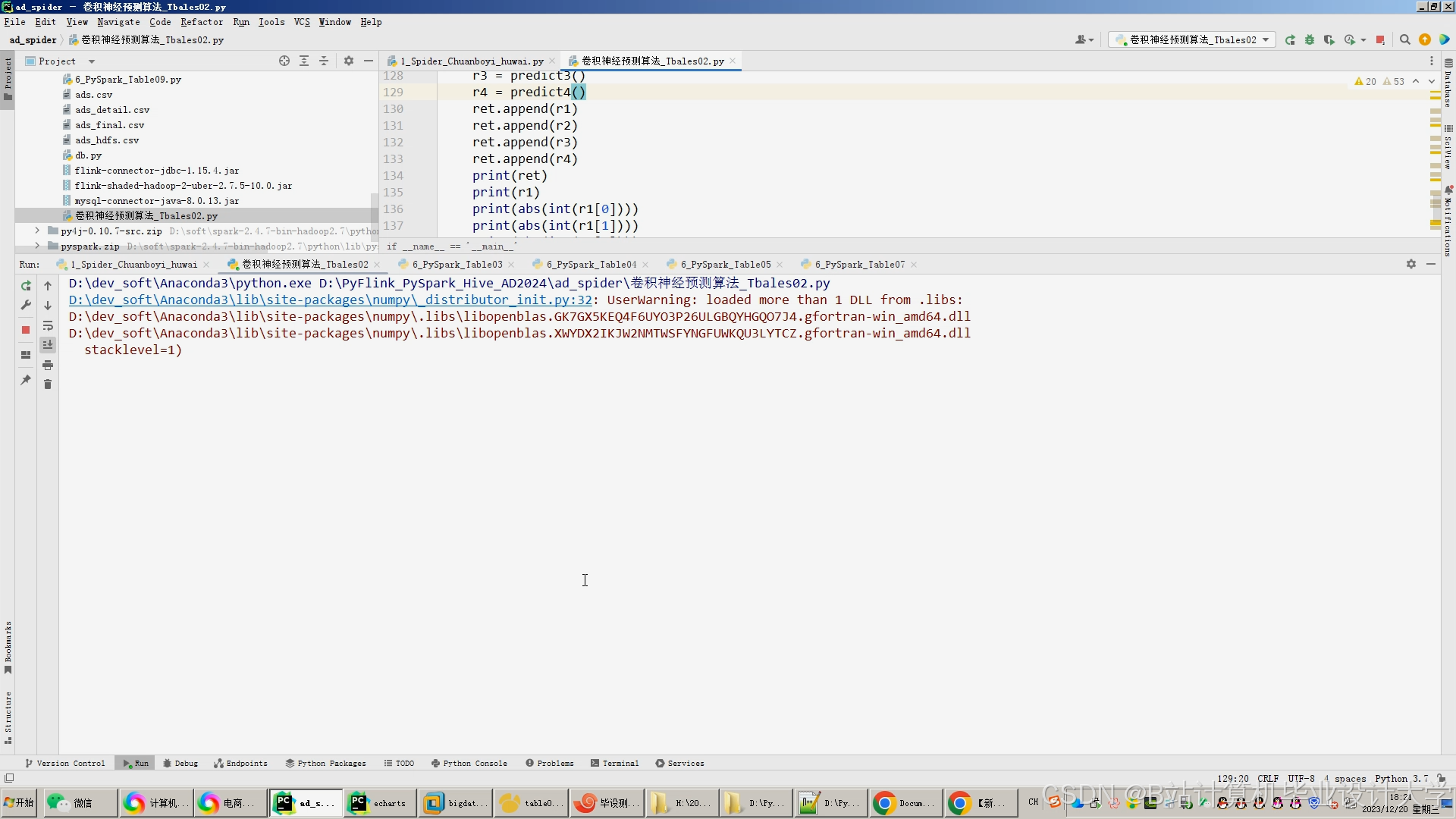

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

911

911

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?