温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

以下是一篇关于《Hadoop+Spark+Hive空气质量预测系统》的任务书模板,包含任务目标、技术要求、实施计划、验收标准等内容,适用于项目管理或课程作业的详细任务分配。

任务书:基于Hadoop+Spark+Hive的空气质量预测系统

项目名称:城市空气质量实时分析与预测系统

任务周期:2024年3月1日 - 2024年12月31日

负责人:XXX

参与人员:数据工程师(2人)、算法工程师(2人)、测试工程师(1人)

一、任务目标

构建一个基于Hadoop+Spark+Hive的分布式空气质量预测系统,实现以下功能:

- 数据存储与处理:支持PB级多源异构空气质量数据(传感器、气象站、卫星遥感)的存储与实时清洗;

- 预测模型开发:结合机器学习与深度学习算法,实现72小时AQI预测,误差率(MAPE)≤10%;

- 实时预警服务:对污染事件(如PM2.5突增)提供分钟级预警,召回率≥90%;

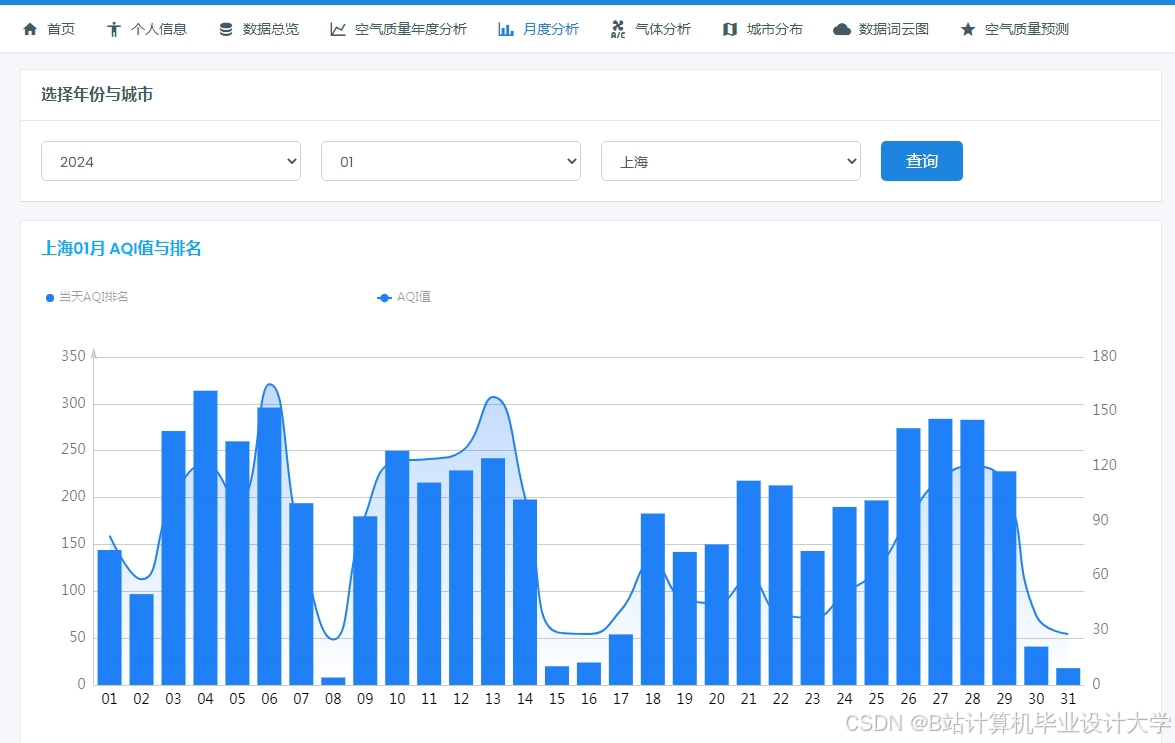

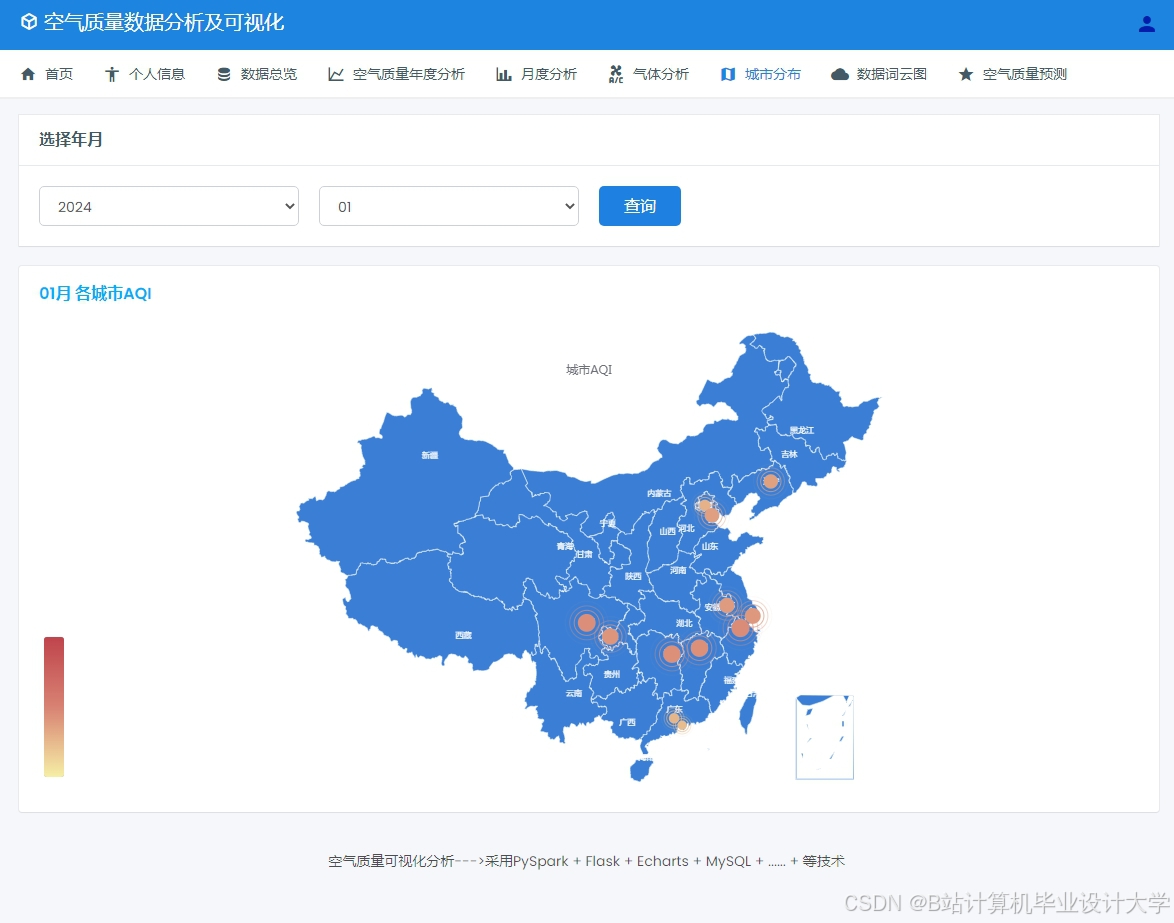

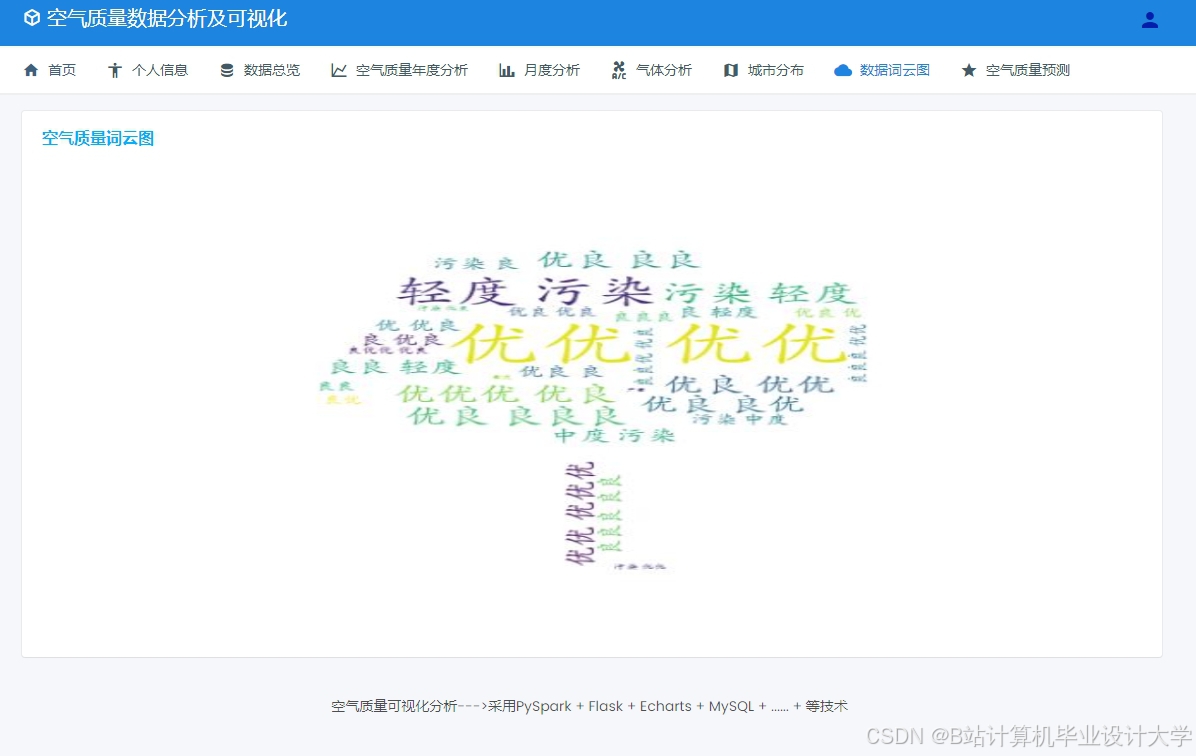

- 可视化交互:提供Web端数据查询与预测结果可视化界面。

二、任务分解与技术要求

模块1:数据采集与预处理

负责人:数据工程师A、B

时间:2024.03.01 - 2024.04.30

技术要求:

- 数据接入:

- 使用Flume采集传感器数据(JSON格式),Kafka缓冲气象API数据(RESTful接口);

- 支持数据源动态扩展(如新增工业排放监测点)。

- 数据清洗:

- 基于Hive构建ETL流程,定义清洗规则:

sql-- 示例:过滤无效PM2.5数据(阈值法)CREATE TABLE cleaned_pm25 ASSELECT city, timestamp,CASE WHEN pm25 BETWEEN 0 AND 500 THEN pm25 ELSE NULL END AS pm25FROM raw_sensor_data; - 处理缺失值:时空插值(邻近站点均值填充);

- 异常检测:基于3σ原则标记离群点。

- 基于Hive构建ETL流程,定义清洗规则:

- 数据存储:

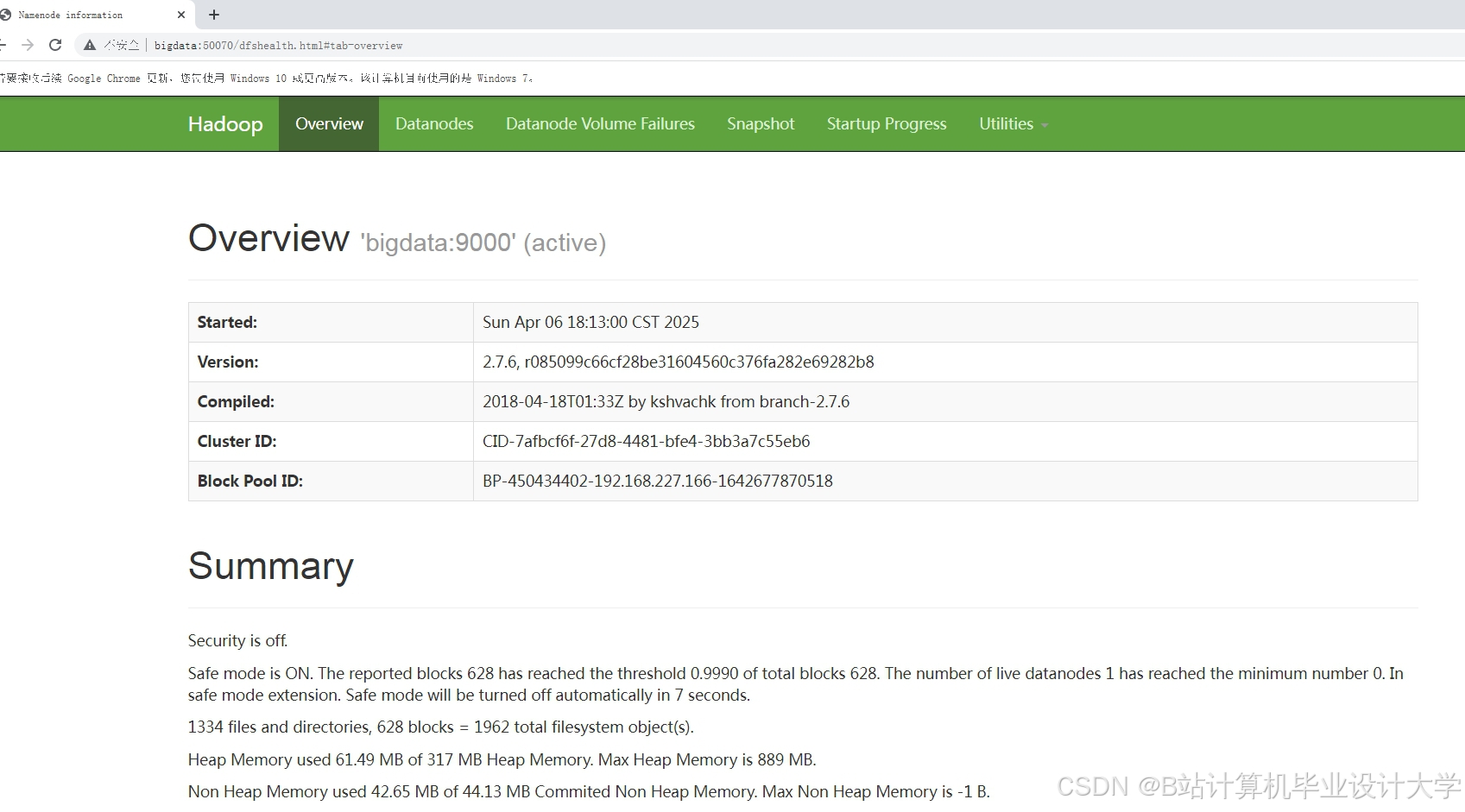

- 原始数据存入HDFS(3副本),清洗后数据按天分区存入Hive(ORC格式);

- 配置HDFS冷热数据策略:最近7天数据存SSD,历史数据存HDD。

模块2:特征工程与模型训练

负责人:算法工程师A、B

时间:2024.05.01 - 2024.08.31

技术要求:

- 特征提取:

- 时空特征:提取小时/日周期性、邻近站点相关性(计算Pearson系数);

- 气象特征:构建风速-污染扩散指数(公式:

扩散指数 = 风速 / (湿度 + 1)); - 滑动窗口统计:计算过去6小时PM2.5均值、最大值作为动态特征。

- 模型开发:

- 短期预测(0-6小时):使用XGBoost(参数:

max_depth=6, learning_rate=0.1); - 长期预测(6-72小时):使用LSTM(层数=2,隐藏单元=64);

- 模型融合:按验证集RMSE加权平均两模型输出(权重通过网格搜索优化)。

- 短期预测(0-6小时):使用XGBoost(参数:

- 训练优化:

- 使用Spark MLlib分布式训练XGBoost,设置

num_workers=4; - LSTM训练采用GPU加速(NVIDIA Tesla T4)。

- 使用Spark MLlib分布式训练XGBoost,设置

模块3:实时预测与预警服务

负责人:算法工程师A、数据工程师B

时间:2024.09.01 - 2024.10.31

技术要求:

- 实时计算:

- 使用Spark Streaming处理Kafka新数据,窗口大小=5分钟,滑动步长=1分钟;

- 触发预测条件:当某站点PM2.5小时均值突增≥20μg/m³时,启动预警流程。

- 预警规则:

- 阈值设定:AQI≥150(中度污染)时发送预警;

- 通知方式:通过企业微信API推送消息至环保部门。

- 服务接口:

- 提供RESTful API供Web端调用(示例):

GET /api/predict?city=Beijing×tamp=202409011200返回:{"aqi": 120, "pollutant": "PM2.5", "warning": false}

- 提供RESTful API供Web端调用(示例):

模块4:系统测试与优化

负责人:测试工程师、全体成员

时间:2024.11.01 - 2024.12.15

技术要求:

- 功能测试:

- 验证数据清洗规则是否覆盖95%异常场景;

- 检查预警服务在模拟污染事件中的触发延迟(目标≤3分钟)。

- 性能测试:

- 集群压力测试:10城市并行预测时,系统吞吐量≥10万条/秒;

- 单节点故障恢复时间≤5分钟。

- 优化措施:

- 调整Spark参数:

spark.sql.shuffle.partitions=200避免数据倾斜; - 压缩Hive中间表:启用Snappy压缩减少IO开销。

- 调整Spark参数:

模块5:项目验收与文档编写

负责人:负责人XXX

时间:2024.12.16 - 2024.12.31

交付物:

- 系统源代码(GitHub仓库);

- 测试报告(含性能指标对比表);

- 用户手册(Web端操作指南、API文档);

- 论文初稿(技术方案与实验结果)。

三、资源需求

| 资源类型 | 规格 | 数量 |

|---|---|---|

| 服务器 | 32核CPU, 256GB内存, 4TB SSD | 5台 |

| 存储设备 | 48TB HDD(分布式存储扩展) | 1套 |

| 开发环境 | Hadoop 3.3.6, Spark 3.5.0, Hive 3.1.3 | - |

| 许可证 | Cloudera Manager企业版(6个月) | 1套 |

四、验收标准

- 功能完整性:系统实现全部需求文档中的功能点;

- 性能达标:

- 预测误差率(MAPE)≤10%(测试集:2023年北京市数据);

- 预警召回率≥90%(模拟100次污染事件);

- 文档完备性:提供系统设计文档、测试报告、用户手册;

- 代码规范性:符合Google Java Style Guide,注释覆盖率≥30%。

五、风险管理

| 风险类型 | 描述 | 应对措施 |

|---|---|---|

| 数据延迟 | 传感器网络故障导致数据缺失 | 设置Kafka消息保留策略(7天) |

| 模型过拟合 | 训练数据分布与测试集差异大 | 增加交叉验证轮次(5折) |

| 硬件故障 | 服务器宕机导致服务中断 | 部署HDFS高可用(HA)模式 |

任务书签署:

项目负责人:_________________ 日期:__________

此任务书结构清晰,责任明确,可直接用于团队分工与进度跟踪。实际执行时需根据集群资源动态调整技术参数(如Spark executor内存分配),并定期召开周会同步进展。

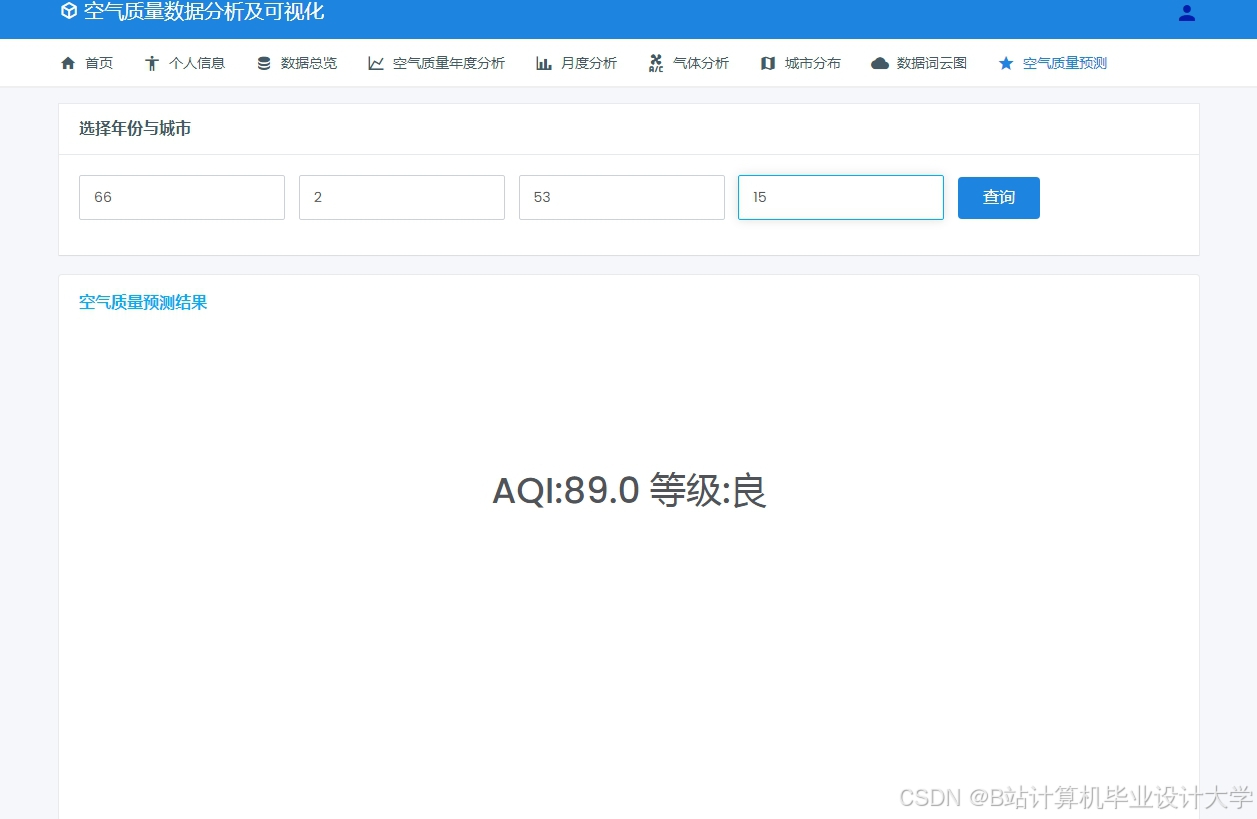

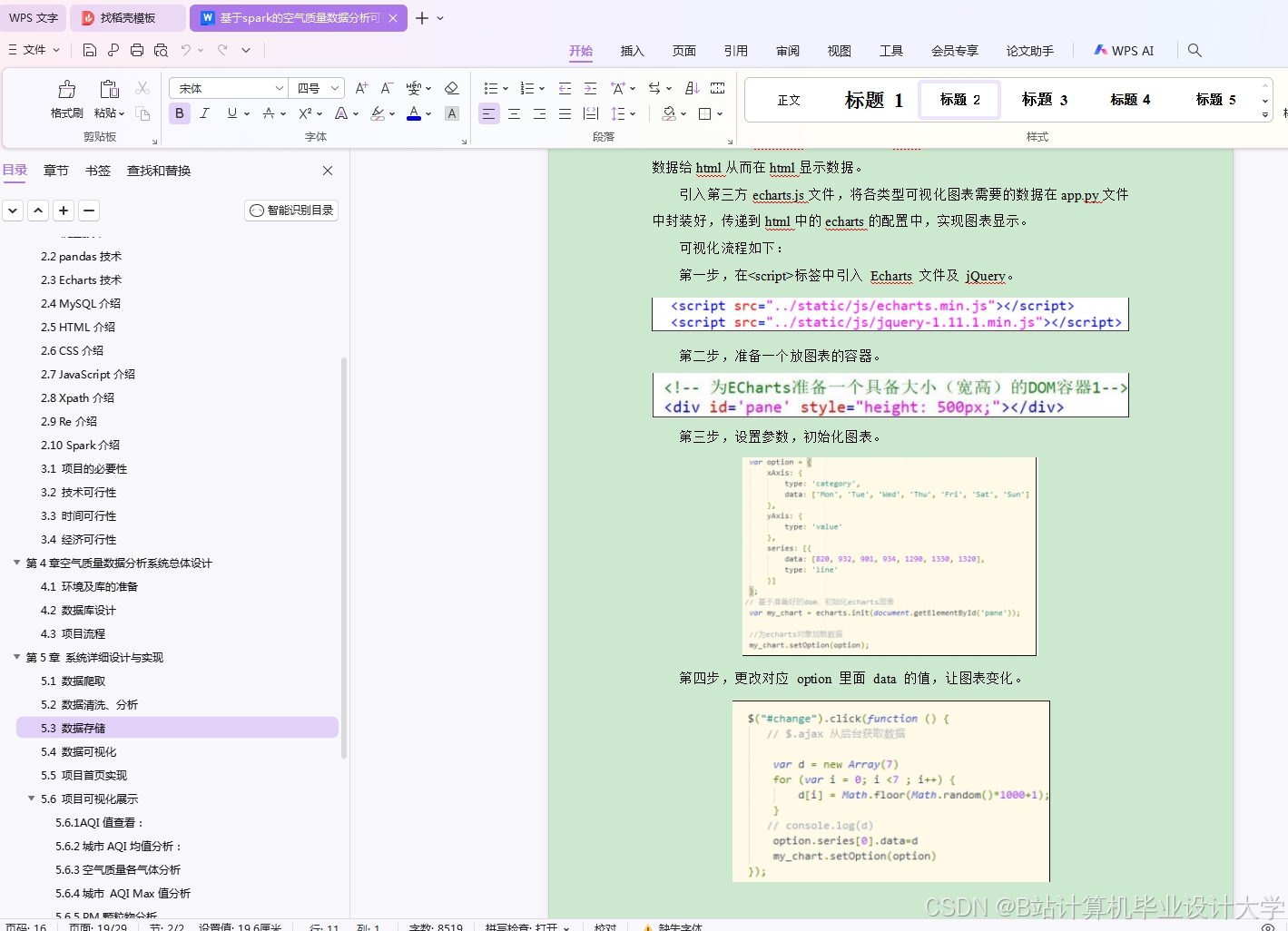

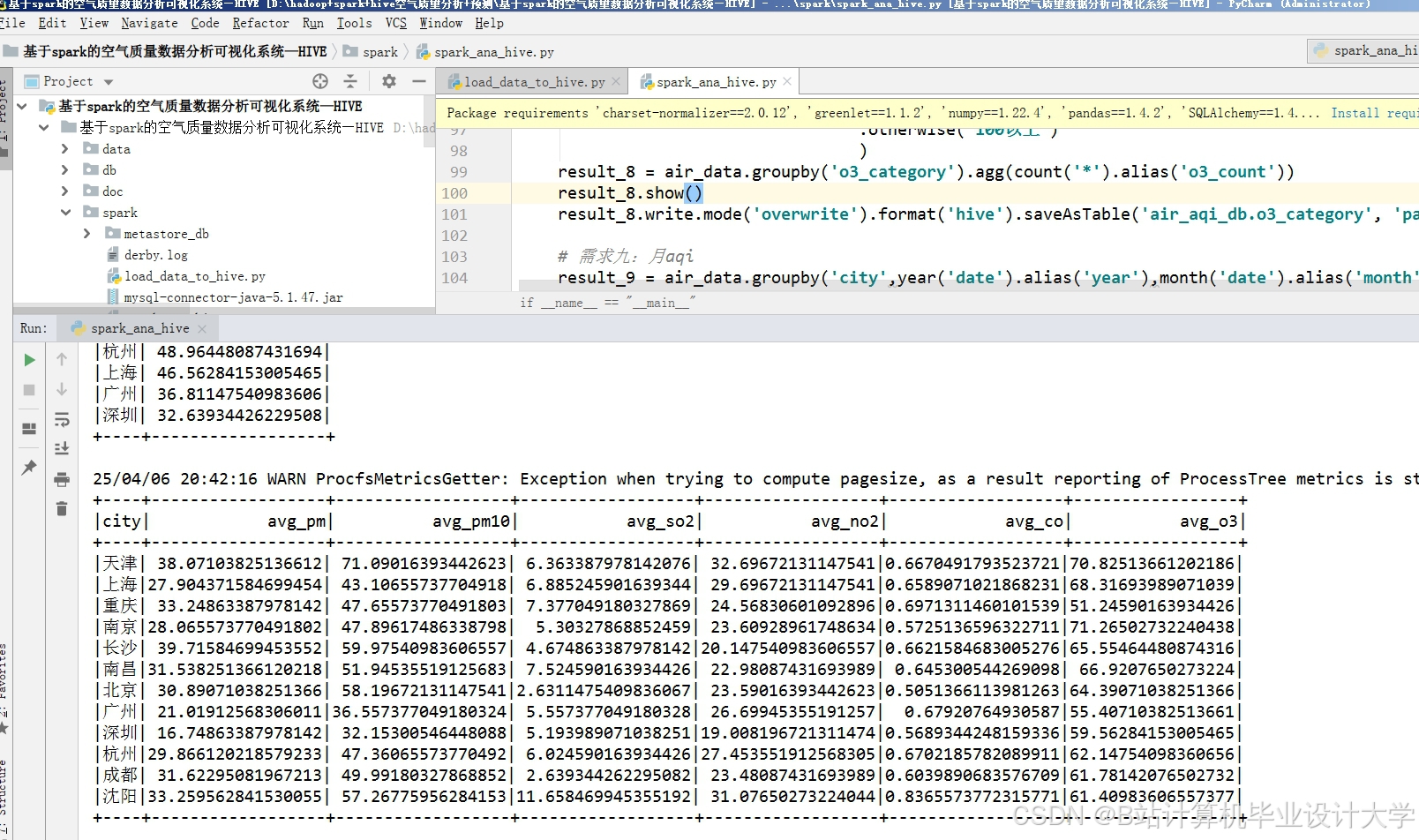

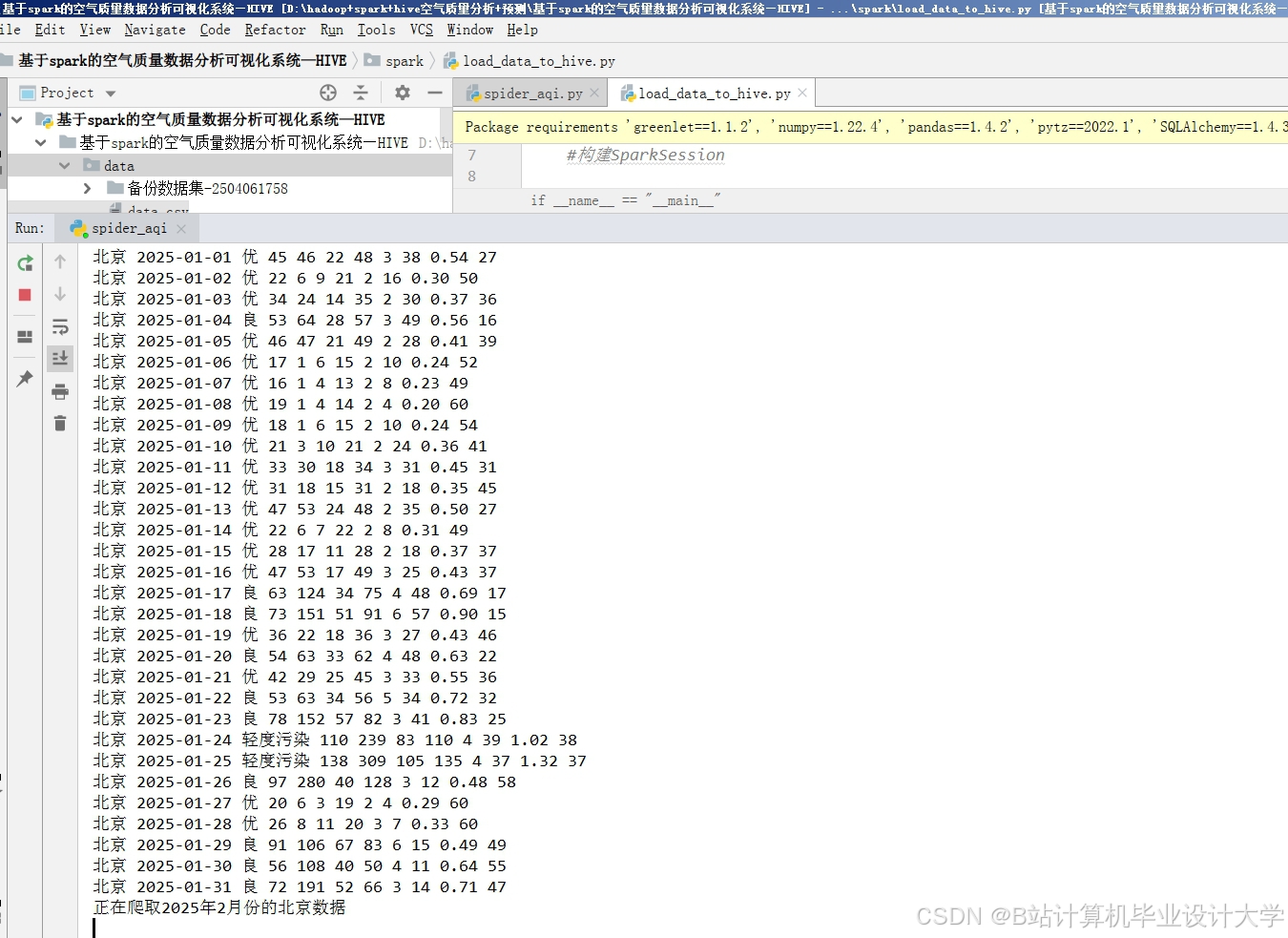

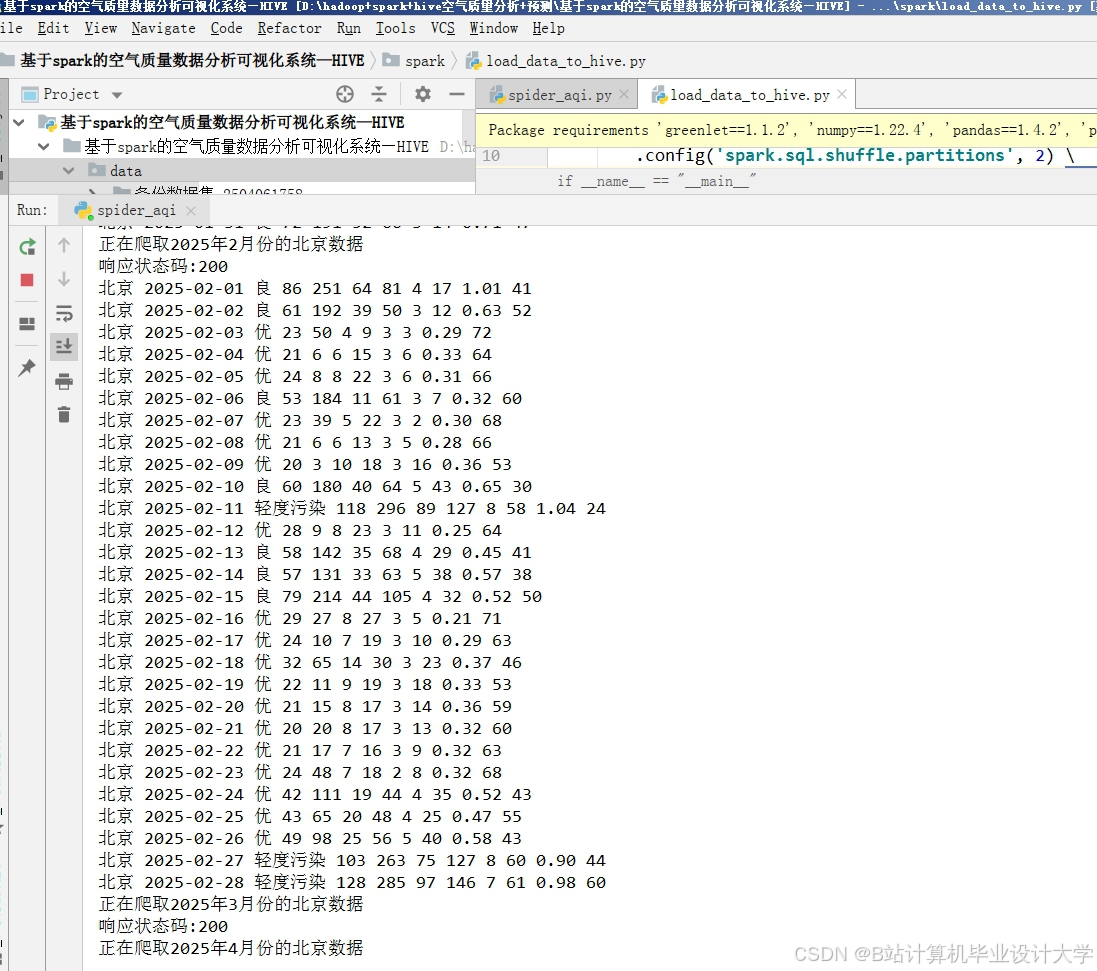

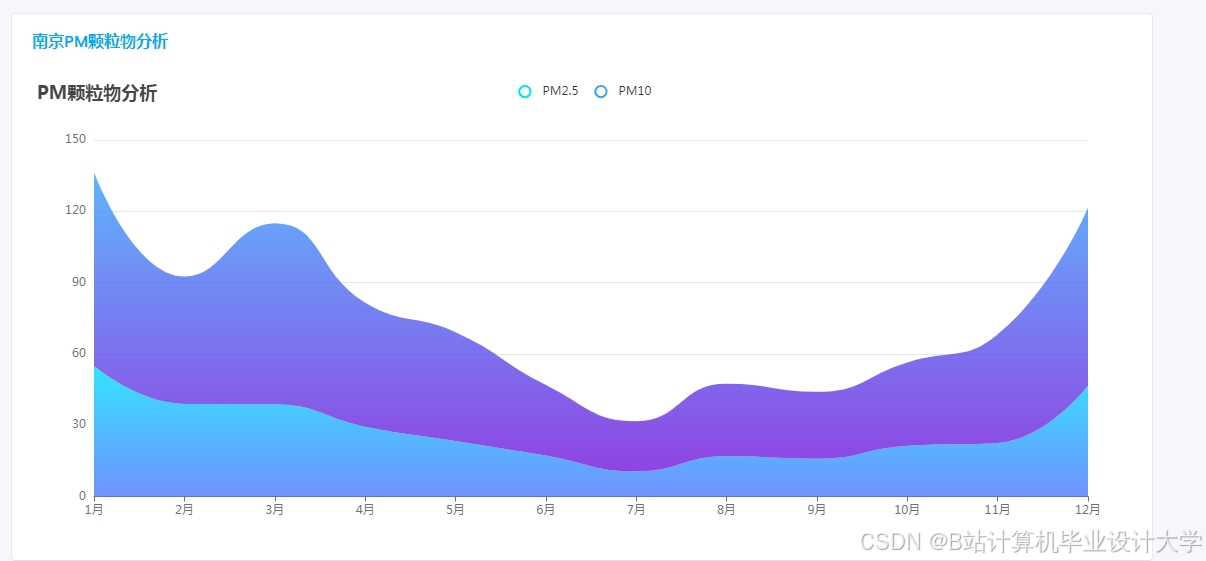

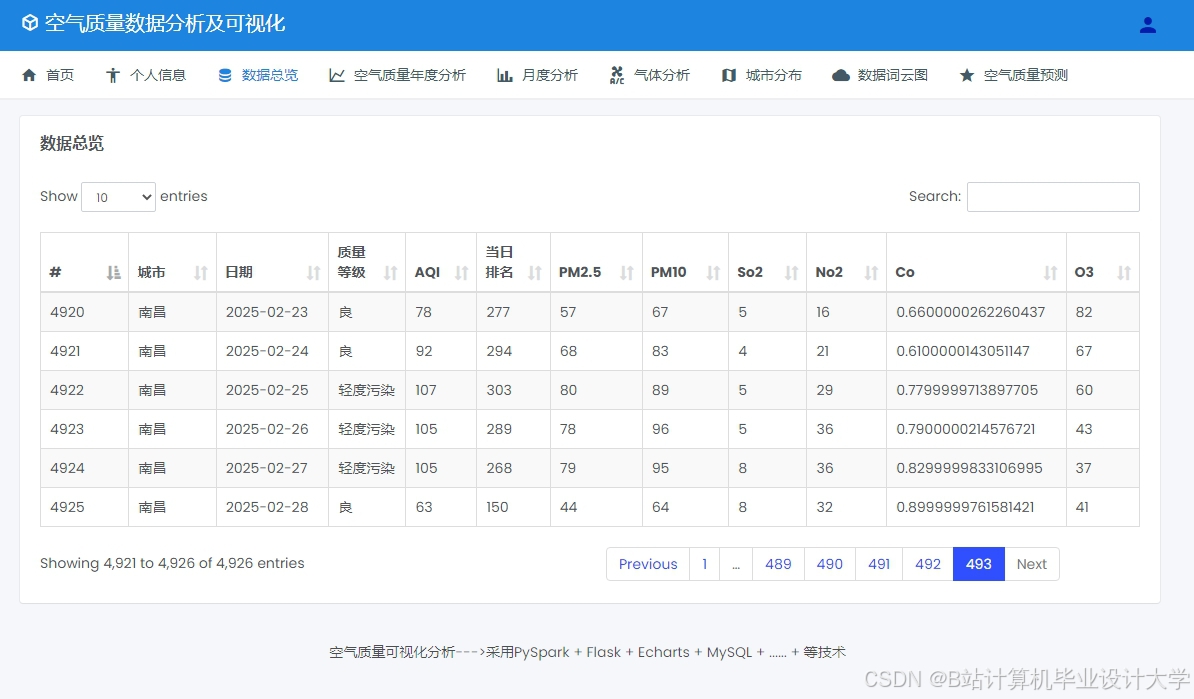

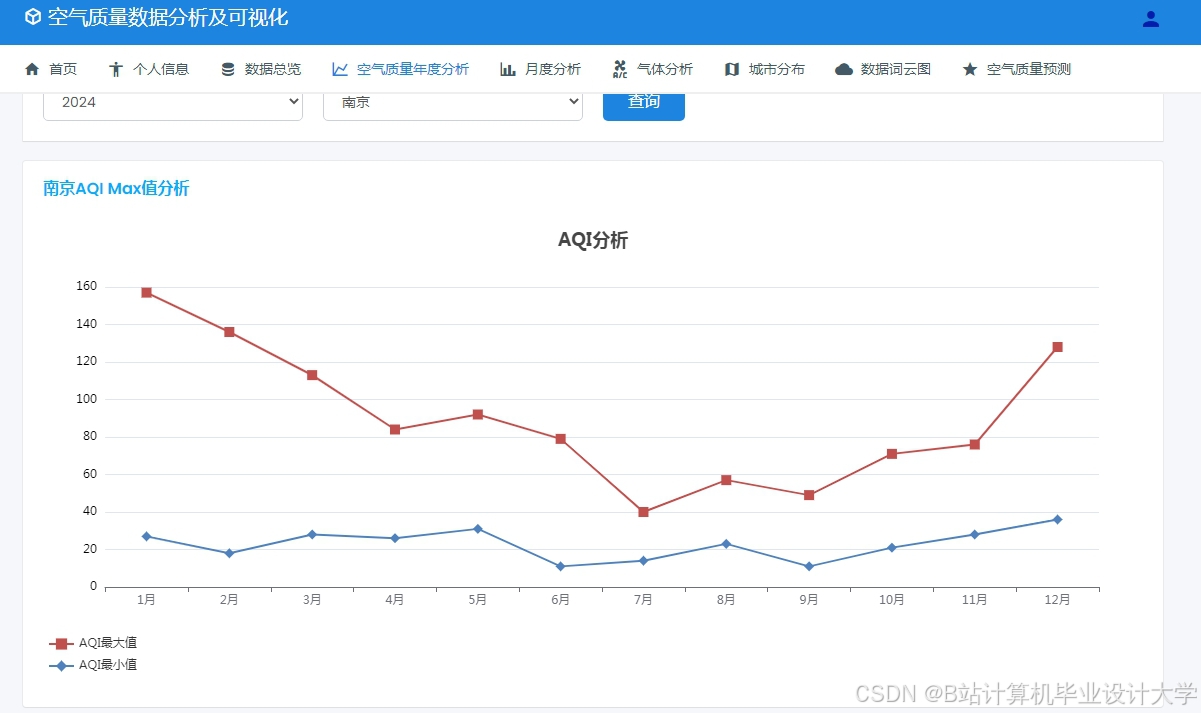

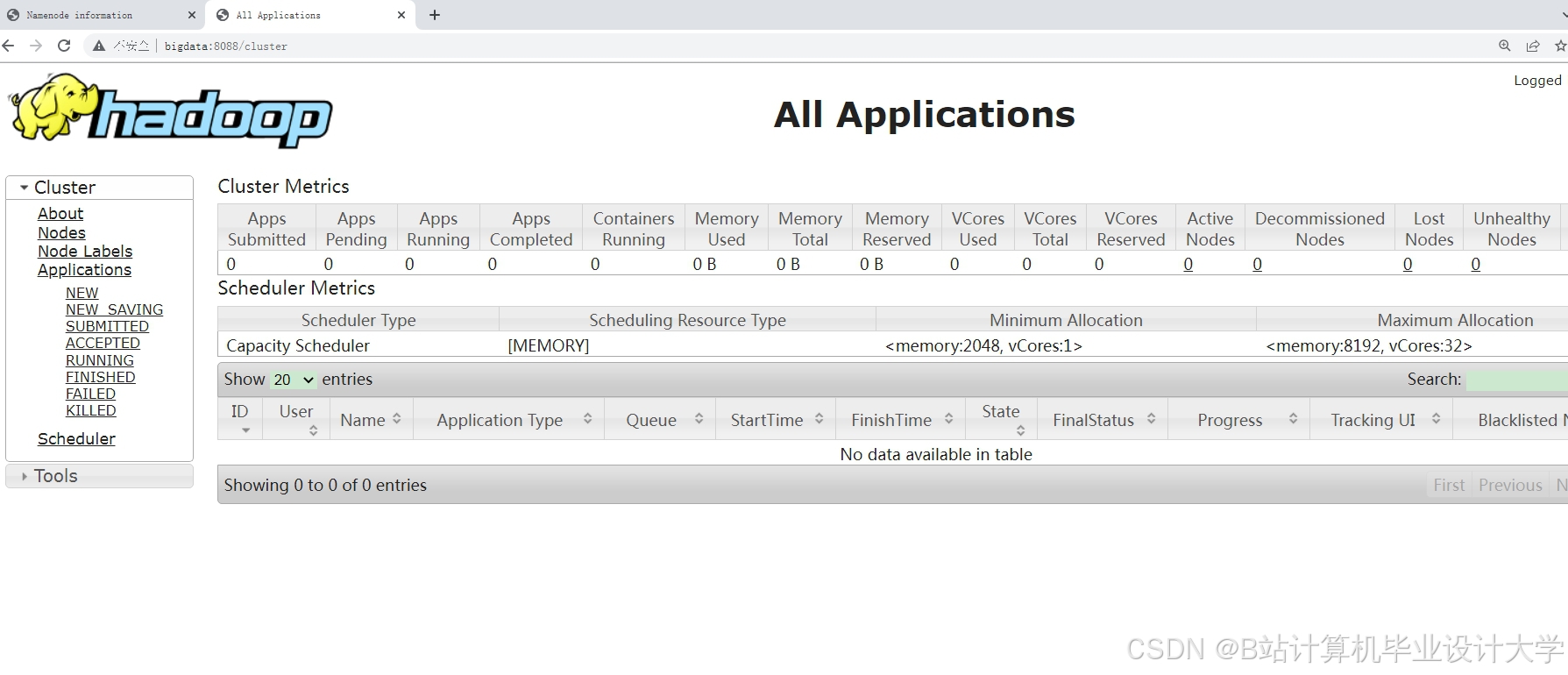

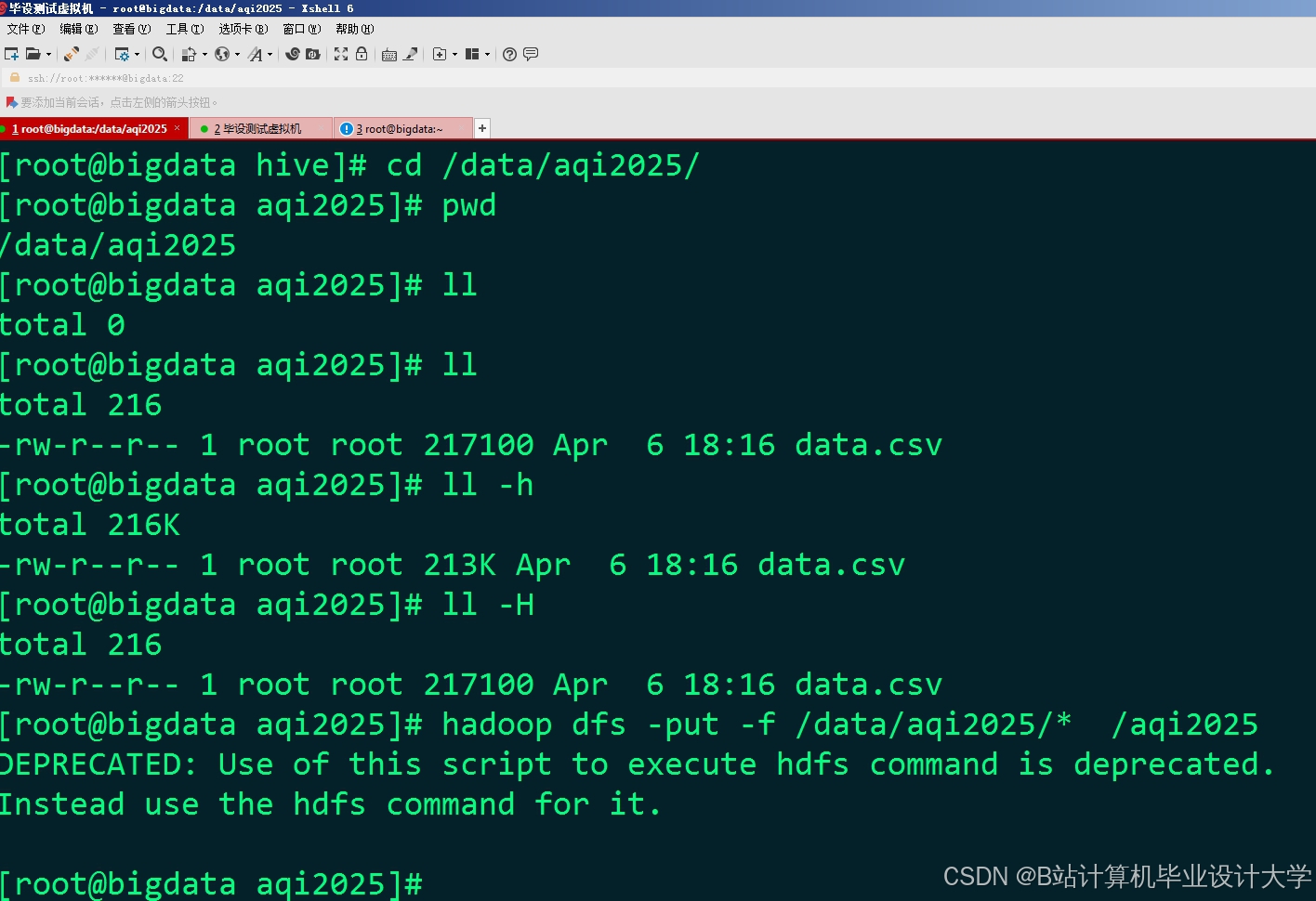

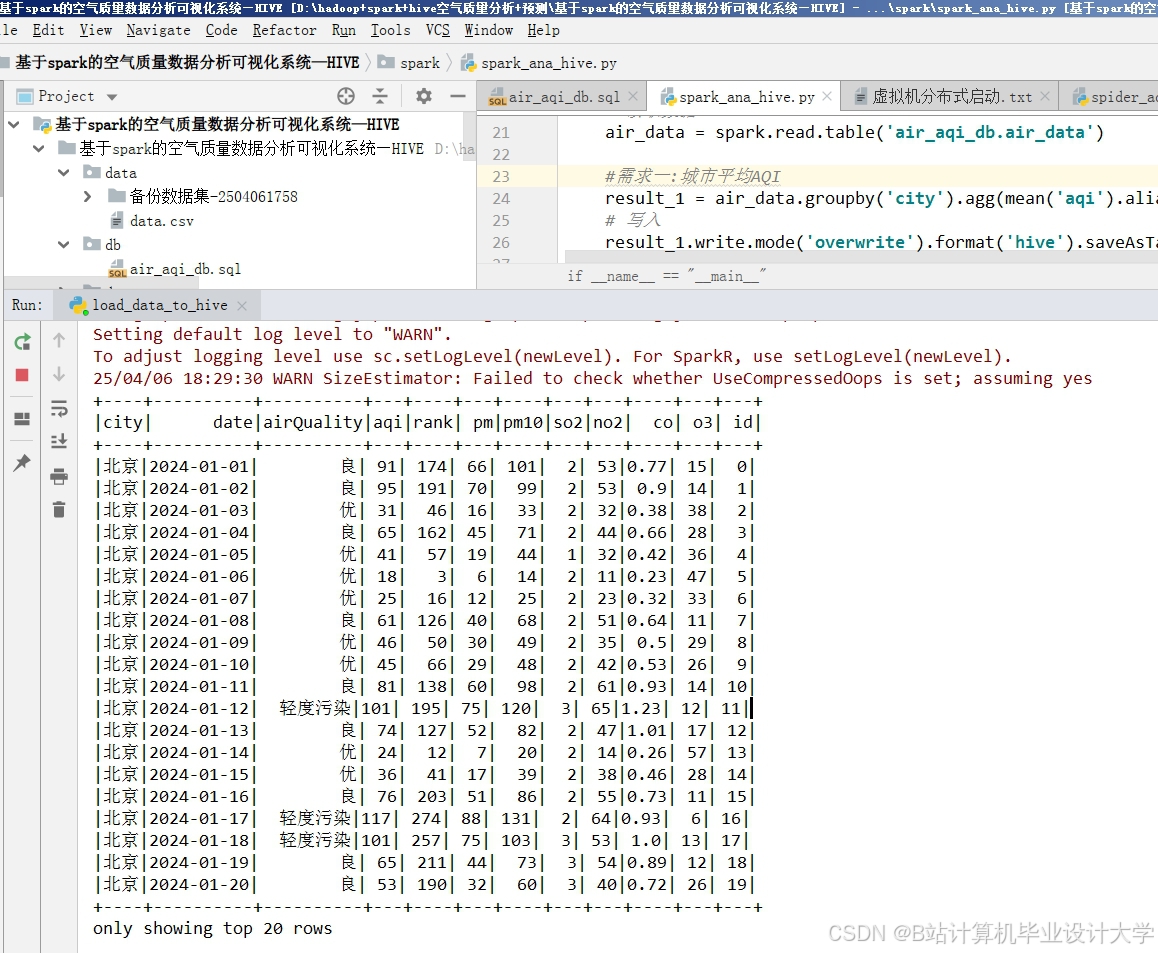

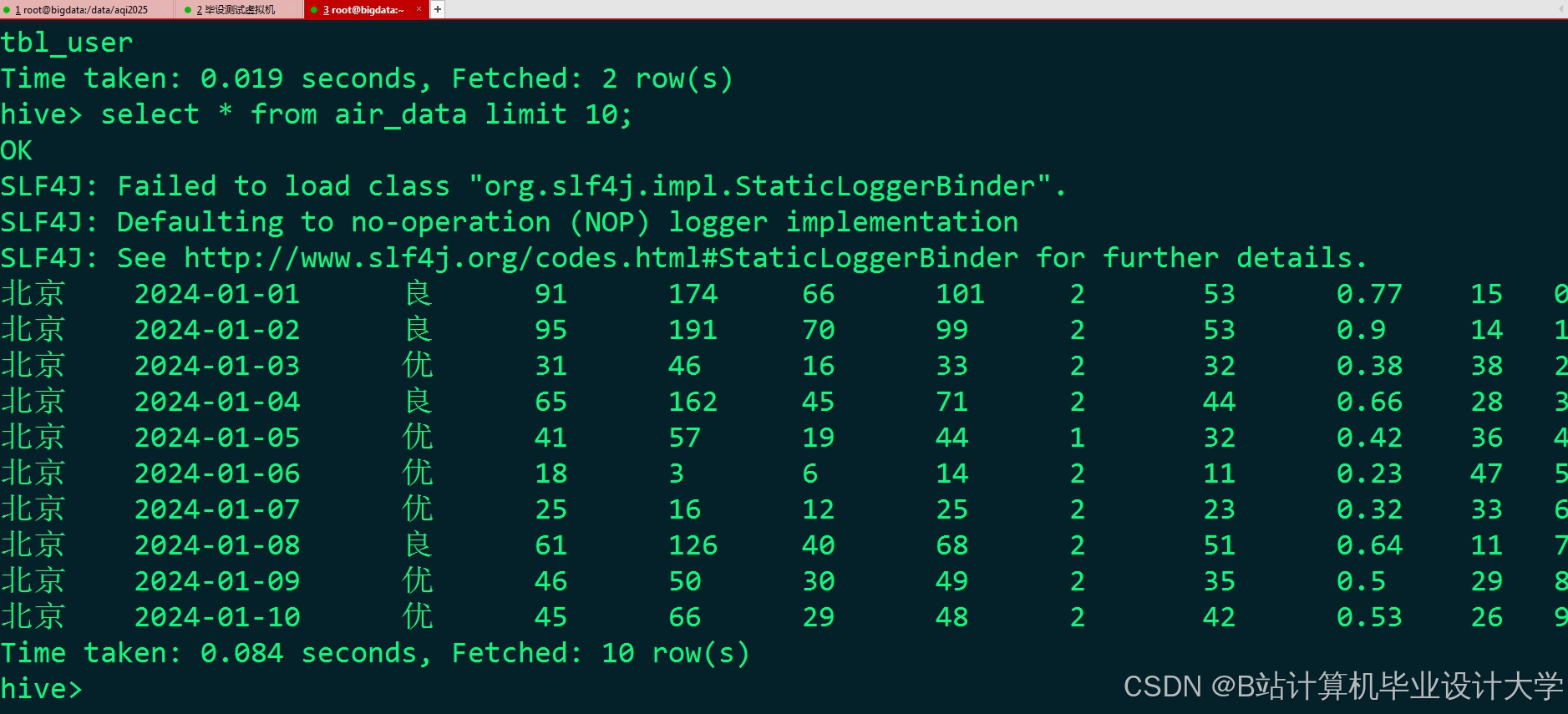

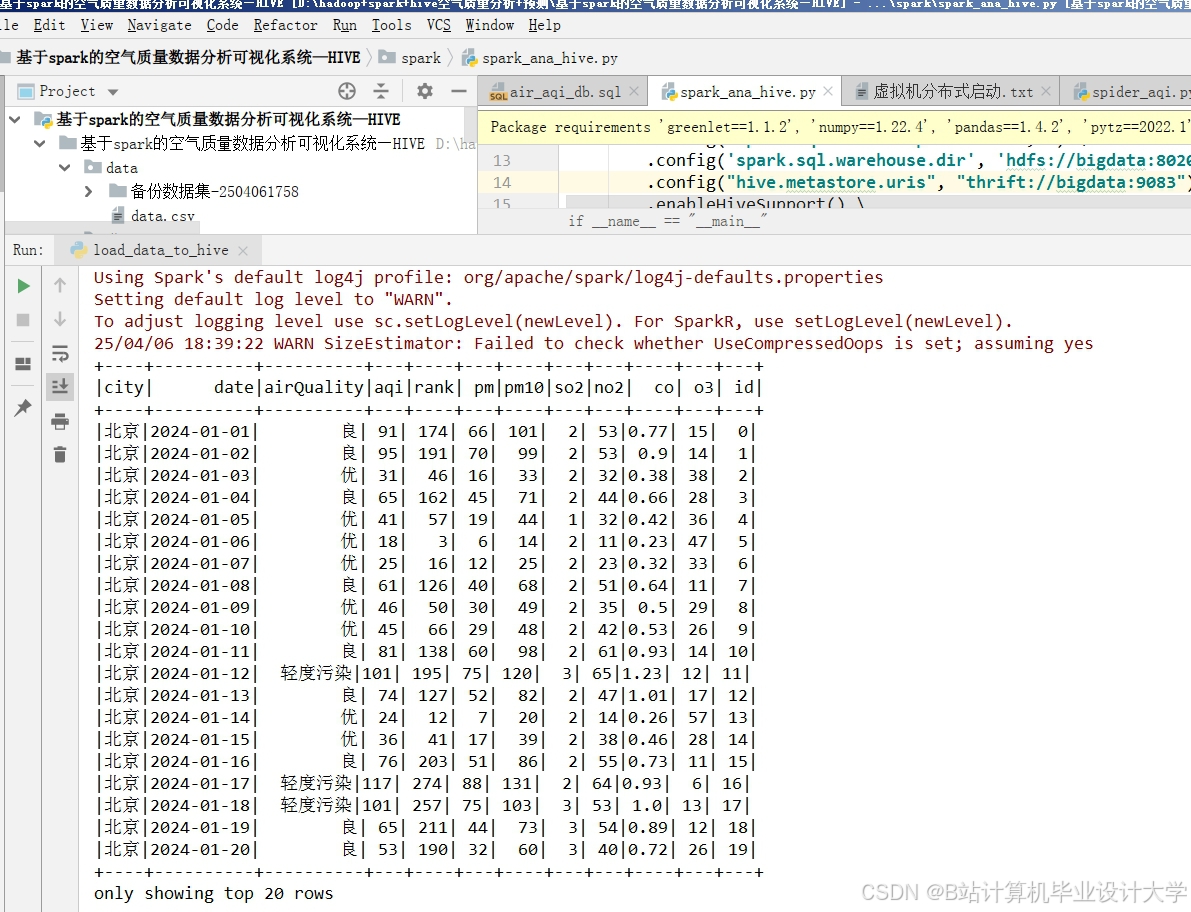

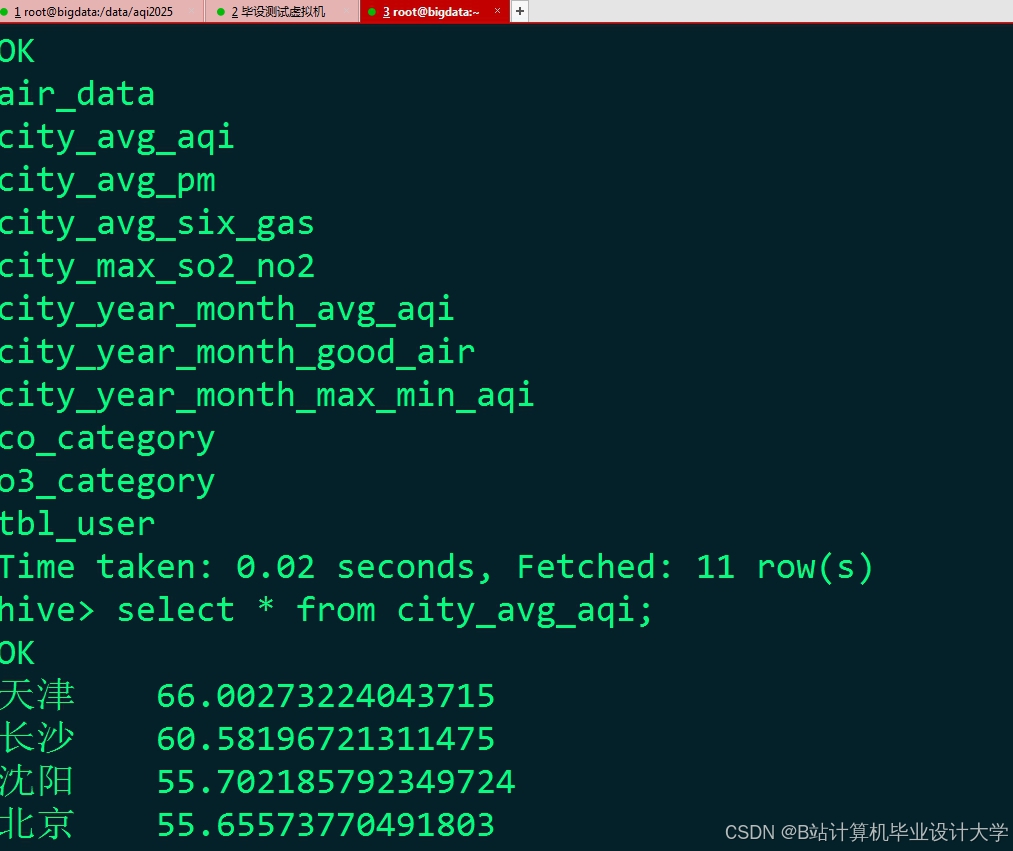

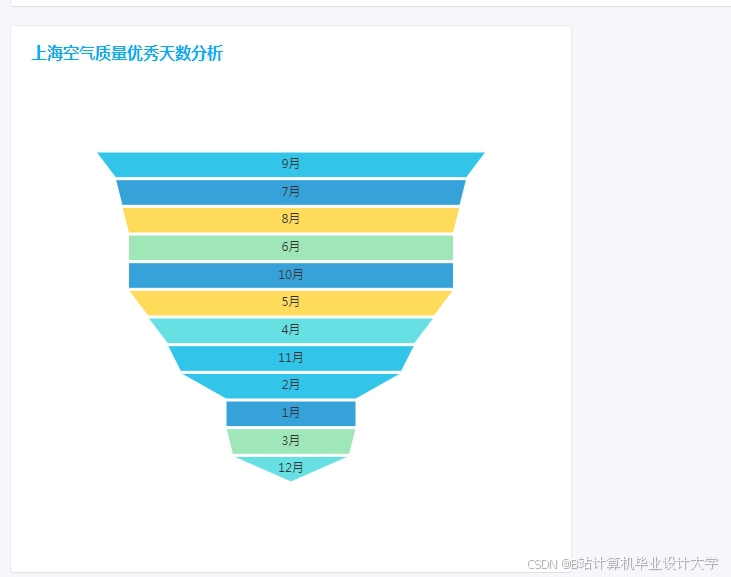

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

925

925

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?