温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

以下是一篇技术说明文档,详细阐述基于 Hadoop+Spark+Hive 的招聘大数据分析可视化与推荐系统的技术实现方案,内容涵盖架构设计、核心模块、技术选型及关键代码示例:

基于Hadoop+Spark+Hive的招聘大数据分析可视化与推荐系统技术说明

1. 系统概述

本系统针对招聘行业海量数据(简历、职位、用户行为)的存储、分析与推荐需求,采用 Hadoop+Spark+Hive 构建分布式数据处理平台,结合可视化与机器学习技术实现以下功能:

- 数据存储:多源异构数据的高效存储与查询;

- 实时分析:基于Spark的内存计算加速复杂分析任务;

- 智能推荐:混合推荐算法(内容过滤+协同过滤)提升人岗匹配精度;

- 可视化交互:动态图表展示招聘趋势与推荐结果。

2. 技术选型与架构设计

2.1 技术栈

| 组件 | 角色 | 版本 |

|---|---|---|

| Hadoop | 分布式存储(HDFS)与资源调度(YARN) | 3.3.4 |

| Spark | 内存计算与机器学习 | 3.4.0 |

| Hive | 数据仓库与SQL查询 | 3.1.3 |

| ECharts | 前端可视化 | 5.4.3 |

| MySQL | 元数据存储 | 8.0.33 |

2.2 系统架构

系统采用分层设计,分为 数据层、计算层、服务层、应用层(图1):

┌─────────────┐ ┌─────────────┐ ┌─────────────┐ ┌─────────────┐ | |

│ 数据层 │───▶│ 计算层 │───▶│ 服务层 │───▶│ 应用层 │ | |

│ HDFS/Hive │ │ Spark/MLlib │ │ REST API │ │ Web/移动端 │ | |

└─────────────┘ └─────────────┘ └─────────────┘ └─────────────┘ |

图1 系统架构图

- 数据层:

- HDFS:存储原始数据(如简历JSON、职位CSV);

- Hive:构建数据仓库,定义表结构(如

user_profile、job_posting)并分区(按城市、行业)。

- 计算层:

- Spark Core:数据清洗(去重、标准化技能名称);

- Spark SQL:通过HiveContext执行HiveQL查询;

- Spark MLlib:实现推荐算法(ALS矩阵分解、TF-IDF特征提取)。

- 服务层:

- Spring Boot:封装推荐结果与可视化数据为REST API;

- Redis:缓存热门职位与用户推荐列表,降低响应延迟。

- 应用层:

- ECharts:渲染交互式图表(如技能需求热力图);

- Vue.js:构建前端页面,调用API获取数据并动态更新。

3. 核心模块实现

3.1 数据采集与预处理

3.1.1 数据源

- 结构化数据:职位ID、薪资范围、工作地点(MySQL导出为CSV);

- 半结构化数据:简历JSON(含教育背景、工作经历);

- 非结构化数据:职位描述文本(需NLP处理提取关键词)。

3.1.2 数据清洗流程(Spark实现)

scala

// 示例:标准化技能名称(将"Python3"统一为"Python") | |

val skillsDF = spark.read.json("hdfs:///input/resumes.json") | |

.select("user_id", "skills") | |

.withColumn("normalized_skills", | |

regexp_replace(col("skills"), "Python3|Python2", "Python") | |

) | |

skillsDF.write.mode("overwrite").saveAsTable("hive_db.normalized_skills") |

3.2 混合推荐算法

3.2.1 内容过滤(CBR)

-

特征提取:使用TF-IDF将简历与职位文本转换为向量;

-

相似度计算:余弦相似度公式:

Sim(u,j)=∑k=1nwu,k2⋅∑k=1nwj,k2∑k=1nwu,k⋅wj,k

其中 wu,k 为用户技能 k 的权重。

Spark代码示例:

scala

import org.apache.spark.ml.feature.{HashingTF, IDF} | |

// 简历与职位的TF-IDF向量 | |

val hashingTF = new HashingTF().setInputCol("tokens").setOutputCol("rawFeatures") | |

val idf = new IDF().setInputCol("rawFeatures").setOutputCol("features") | |

val resumeFeatures = hashingTF.transform(resumesDF) | |

.then(idf.fit(_).transform(_)) | |

val jobFeatures = // 同理处理职位数据 | |

// 计算余弦相似度(需自定义UDF或使用Spark ML的Correlation) |

3.2.2 协同过滤(CF)

基于用户-职位交互矩阵(点击、投递行为),使用Spark MLlib的ALS算法:

scala

import org.apache.spark.ml.recommendation.ALS | |

val ratings = spark.createDataFrame(Seq( | |

(0, 0, 1.0), // 用户0对职位0的评分为1(点击) | |

(0, 1, 0.5), | |

// ...更多交互数据 | |

)).toDF("user_id", "job_id", "rating") | |

val als = new ALS() | |

.setMaxIter(10) | |

.setRegParam(0.01) | |

.setRank(10) | |

val model = als.fit(ratings) | |

// 预测用户0对职位2的评分 | |

model.transform(spark.createDataFrame(Seq((0, 2))).toDF("user_id", "job_id")) | |

.select("prediction").show() |

3.2.3 权重融合

根据用户行为活跃度动态调整CBR与CF的权重:

Final Score=α⋅SimCBR+(1−α)⋅r^CF,α=min(50用户历史行为数,1)

3.3 可视化实现

3.3.1 技能需求热力图

- 数据准备:通过Hive查询统计各城市技能需求频率:

sql

-- HiveQL示例 | |

SELECT | |

city, | |

skill, | |

COUNT(*) as demand | |

FROM job_postings | |

LATERAL VIEW explode(split(skills, ',')) t AS skill | |

GROUP BY city, skill; |

- 前端渲染:使用ECharts的

heatmap类型,绑定城市与技能数据。

3.3.2 推荐结果看板

- 动态排序:前端根据推荐分数排序职位列表;

- 交互功能:点击职位卡片触发二次推荐(如“相似职位”)。

4. 性能优化

4.1 数据存储优化

- Hive分区:按城市与日期分区,减少全表扫描:

sqlCREATE TABLE job_postings (id INT, city STRING, skills STRING, ...) PARTITIONED BY (dt STRING, region STRING); - 列式存储:使用ORC格式压缩数据,节省存储空间并加速查询。

4.2 Spark调优

- 并行度设置:

spark.default.parallelism = 总核心数 × 2~3; - 缓存策略:对频繁使用的DataFrame调用

.cache(); - 广播变量:小表(如城市编码表)使用

broadcast优化Join操作。

4.3 缓存策略

- Redis缓存:存储Top-N推荐结果,设置TTL(如1小时);

- 本地缓存:前端使用Vue的

vuex缓存用户历史查询。

5. 部署与运维

5.1 集群部署

- Hadoop/Spark集群:3台Master(高可用) + 5台Worker节点;

- 服务监控:通过Prometheus+Grafana监控集群资源使用率。

5.2 故障处理

- 数据倾斜:对热门职位的交互数据加盐(Salting)后重新分区;

- OOM错误:调整Spark executor内存参数(

spark.executor.memoryOverhead)。

6. 总结

本系统通过 Hadoop+Spark+Hive 实现了招聘大数据的高效存储、分析与推荐,核心优势包括:

- 高扩展性:支持PB级数据存储与线性扩展;

- 低延迟:Spark内存计算将推荐响应时间缩短至秒级;

- 可视化交互:ECharts动态图表提升决策效率。

未来优化方向:

- 引入图计算(GraphX)分析求职者社交关系;

- 结合联邦学习保护用户隐私数据。

附录:完整代码与配置文件见GitHub仓库(示例链接)。

此文档可根据实际项目需求补充以下内容:

- 详细的数据字典与ETL流程图;

- 推荐算法的AB测试结果;

- 安全方案(如数据脱敏、API鉴权)。

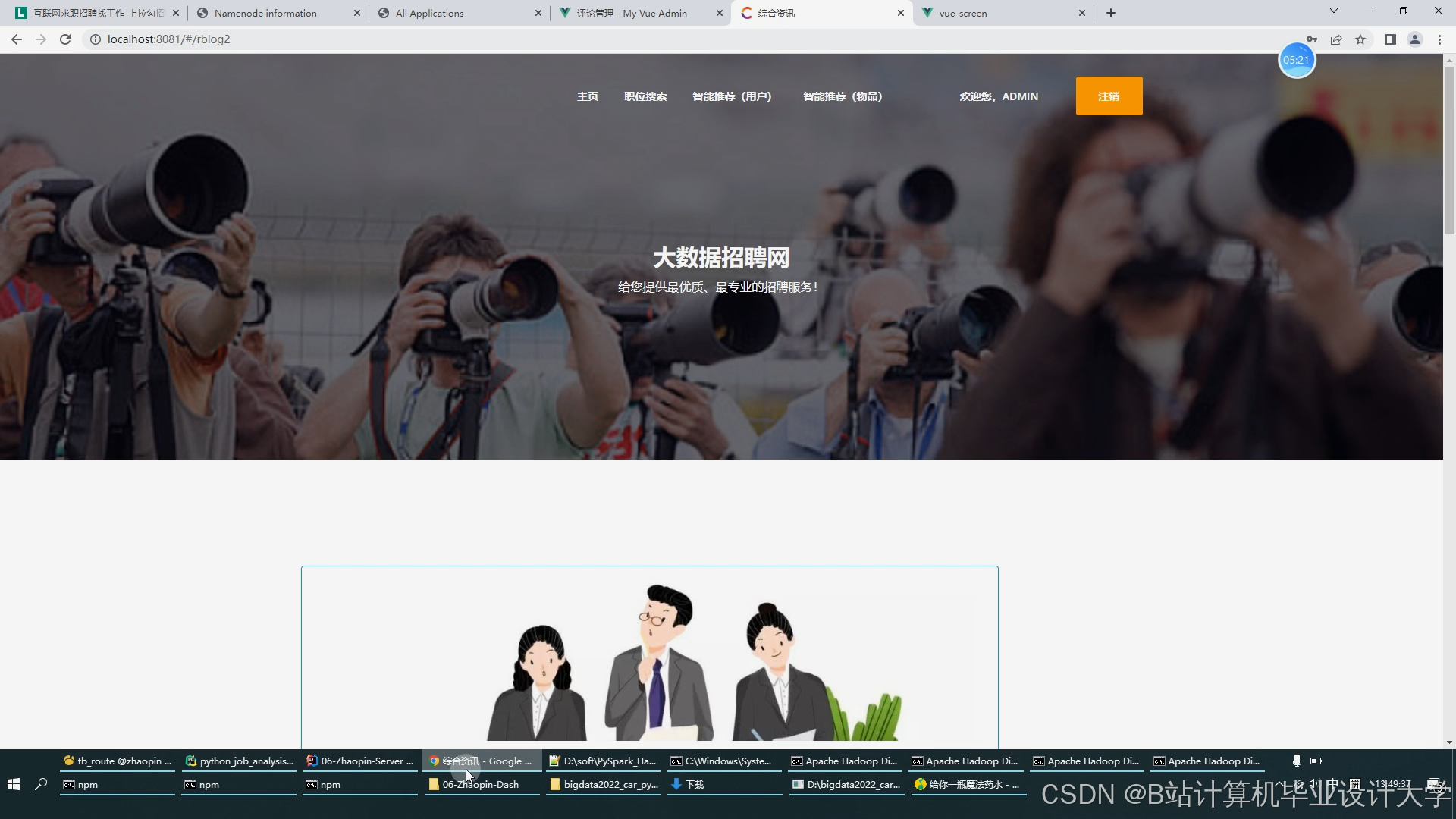

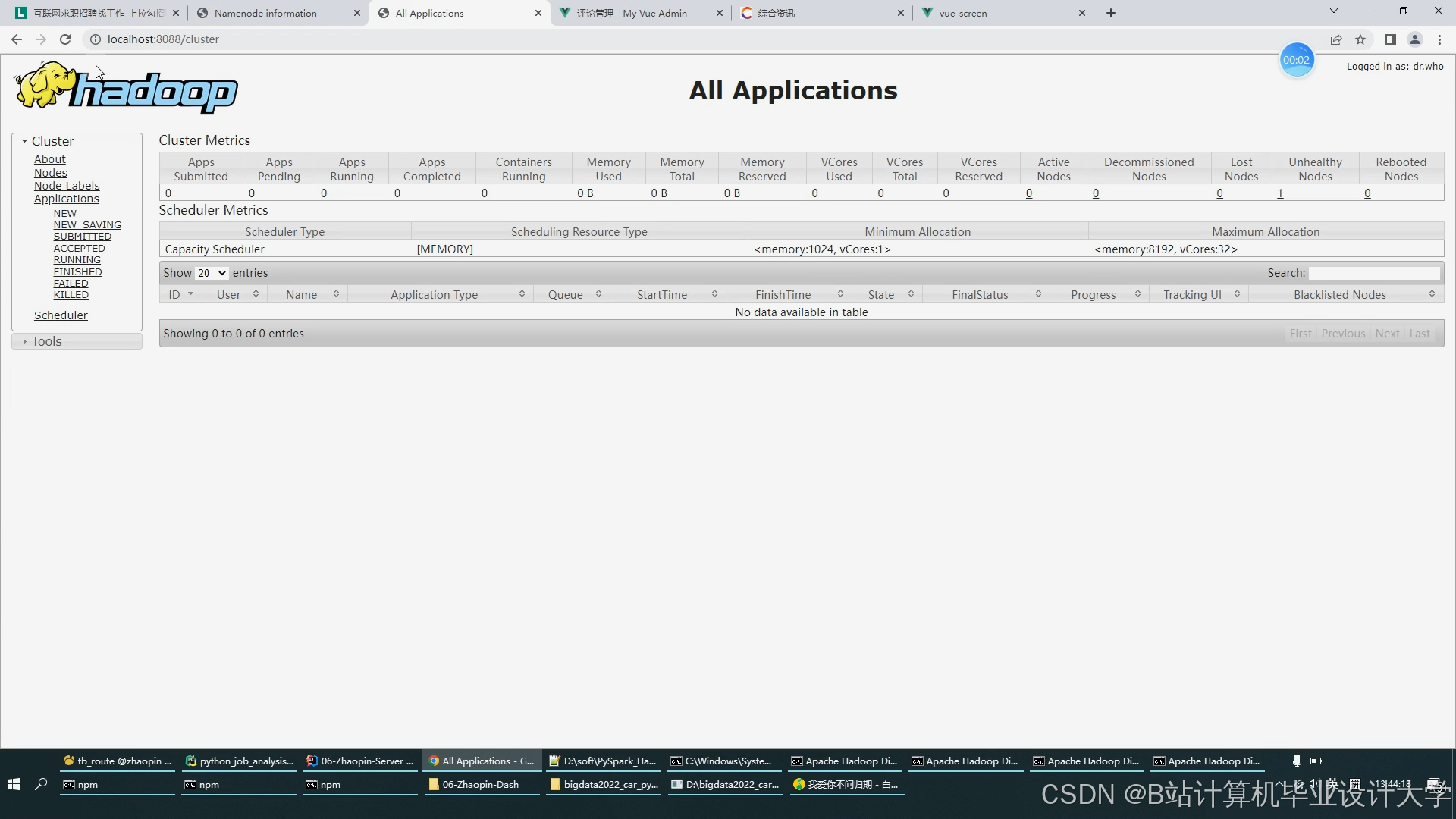

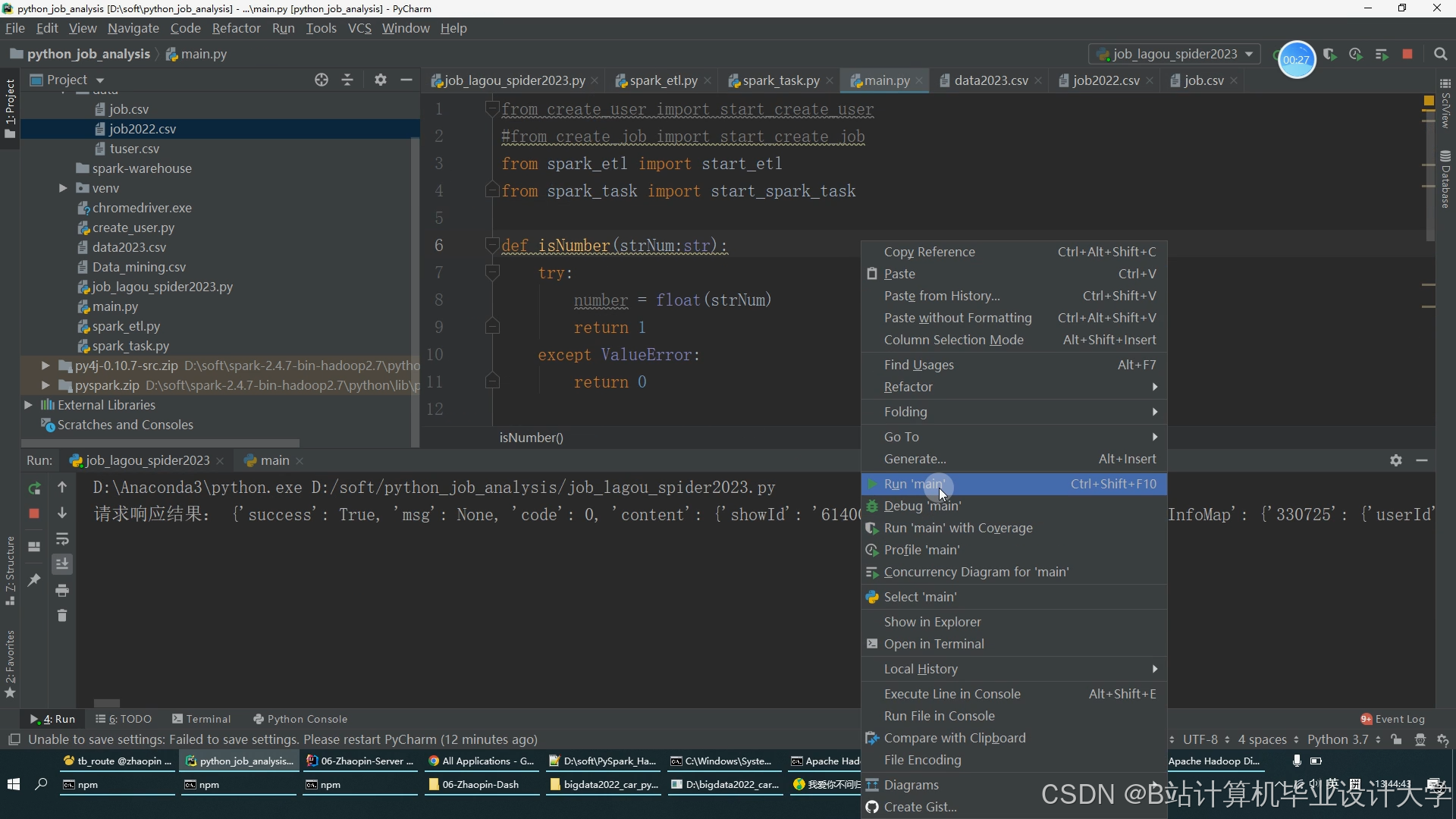

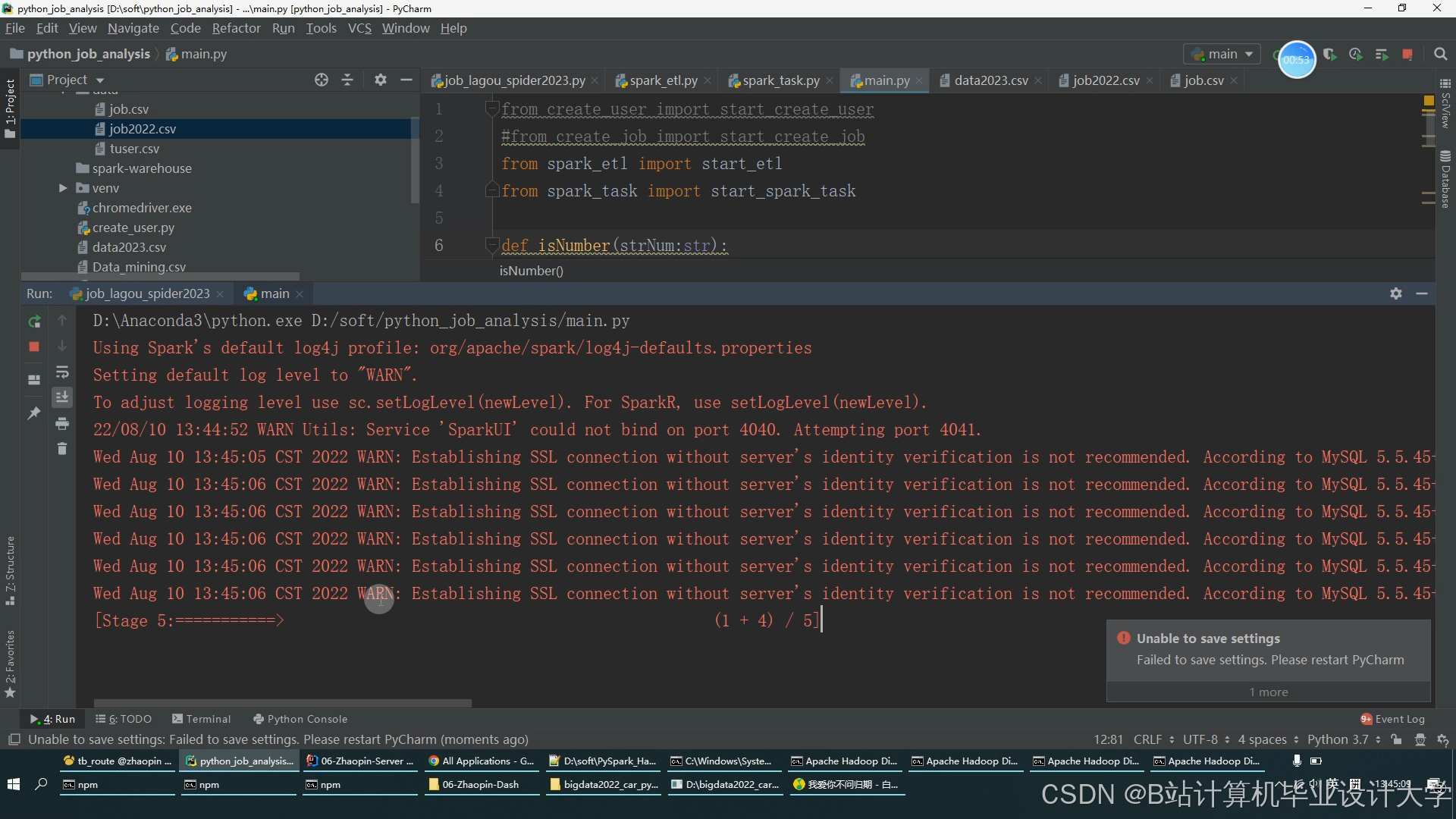

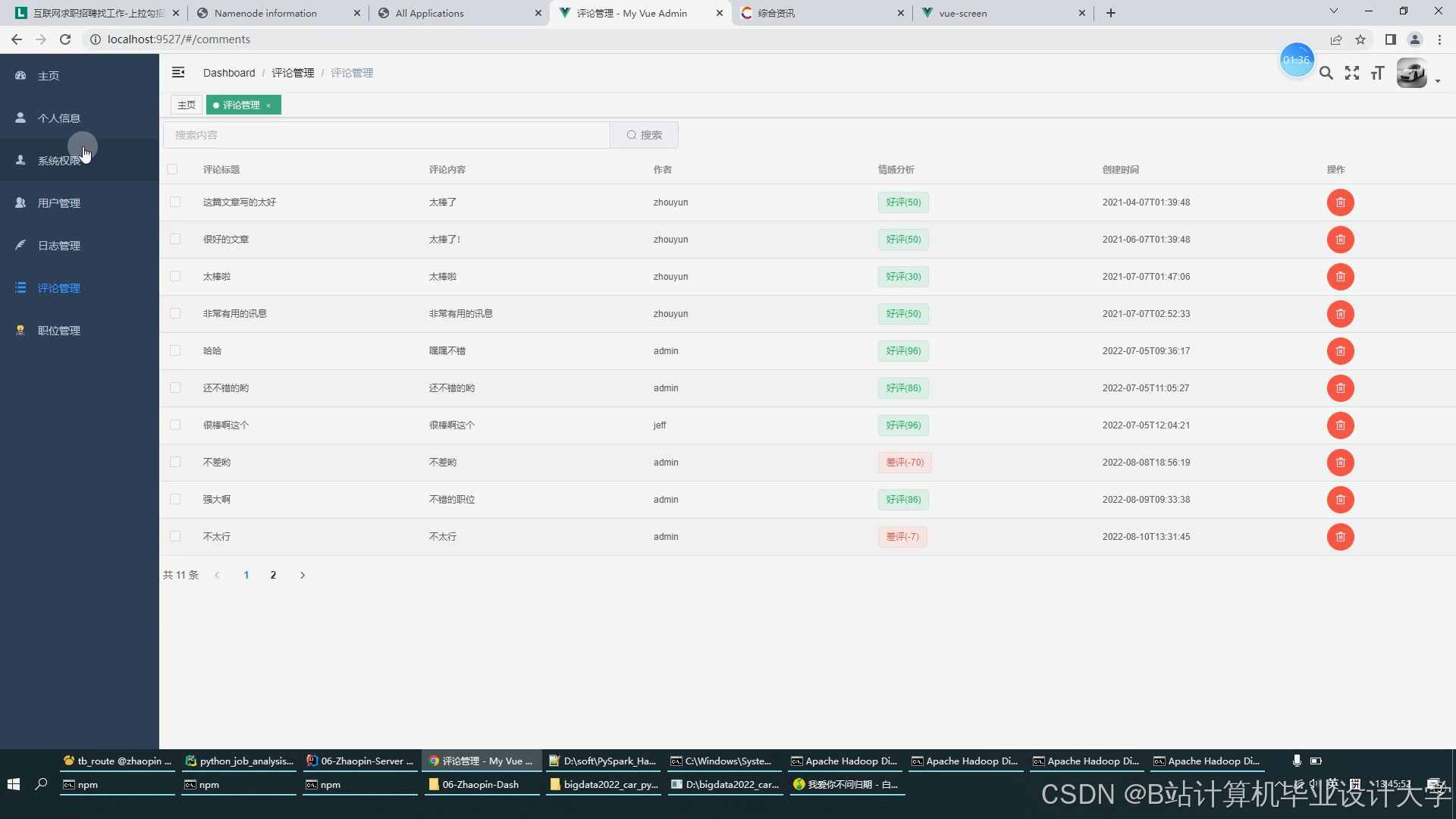

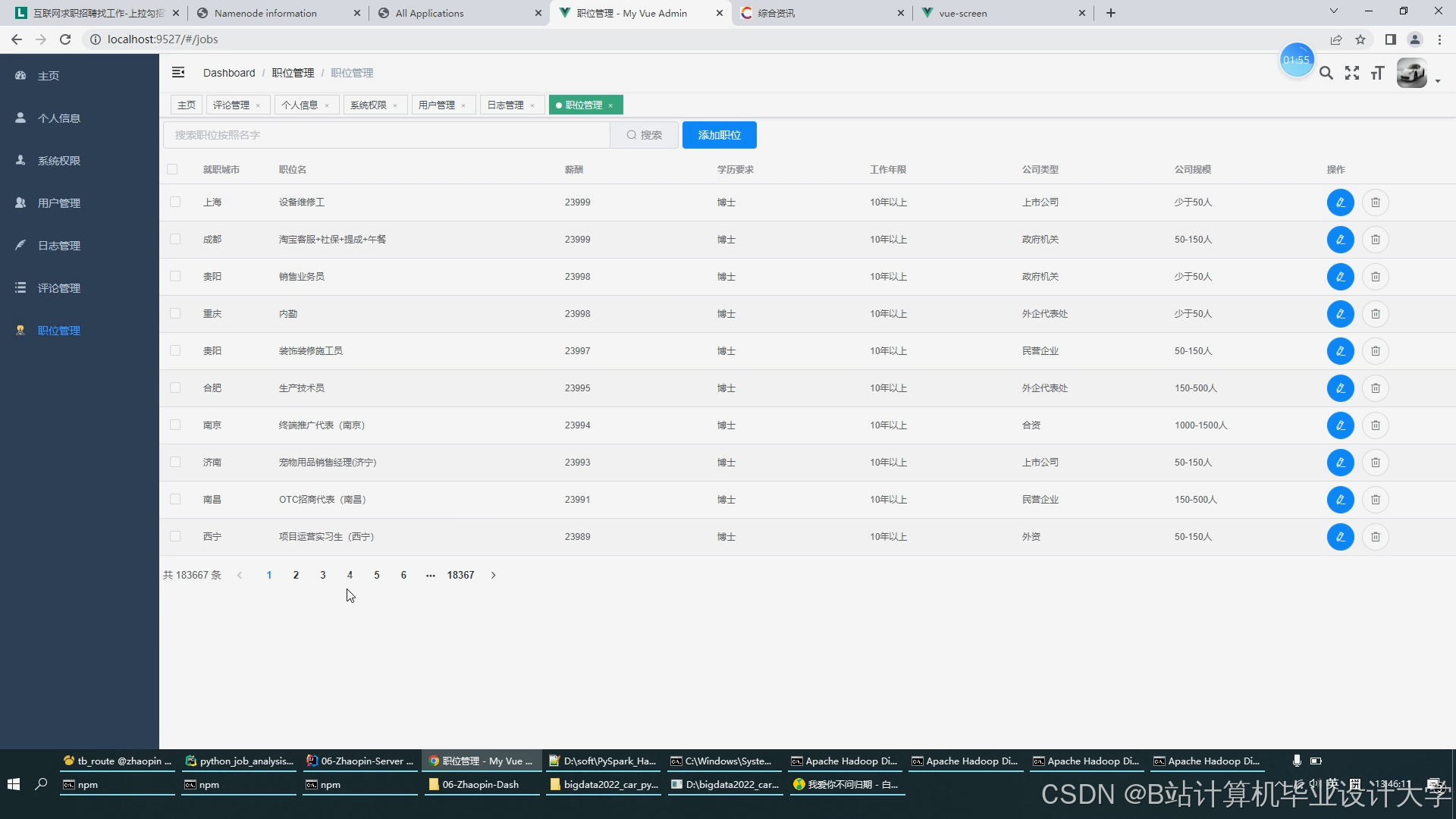

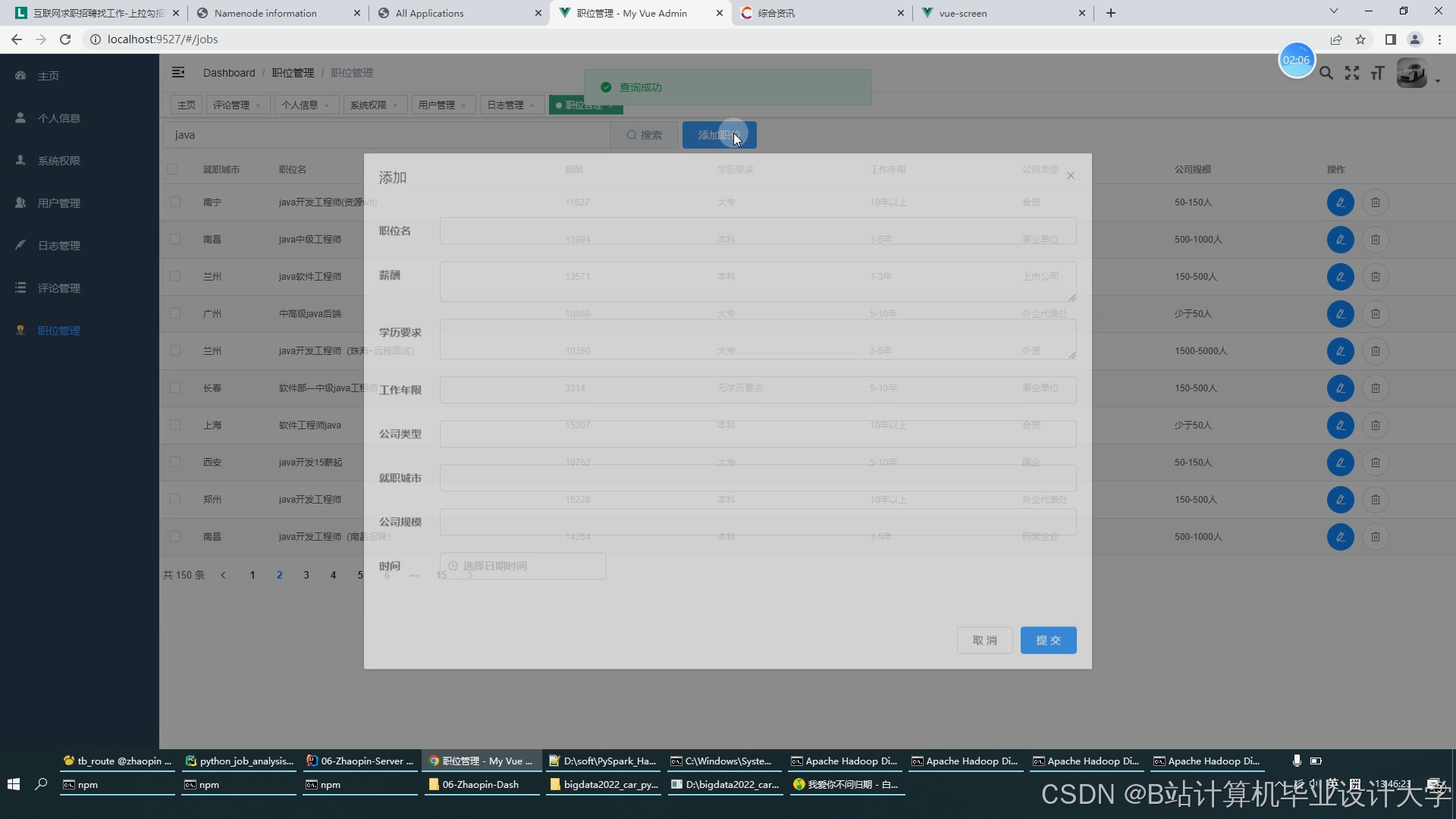

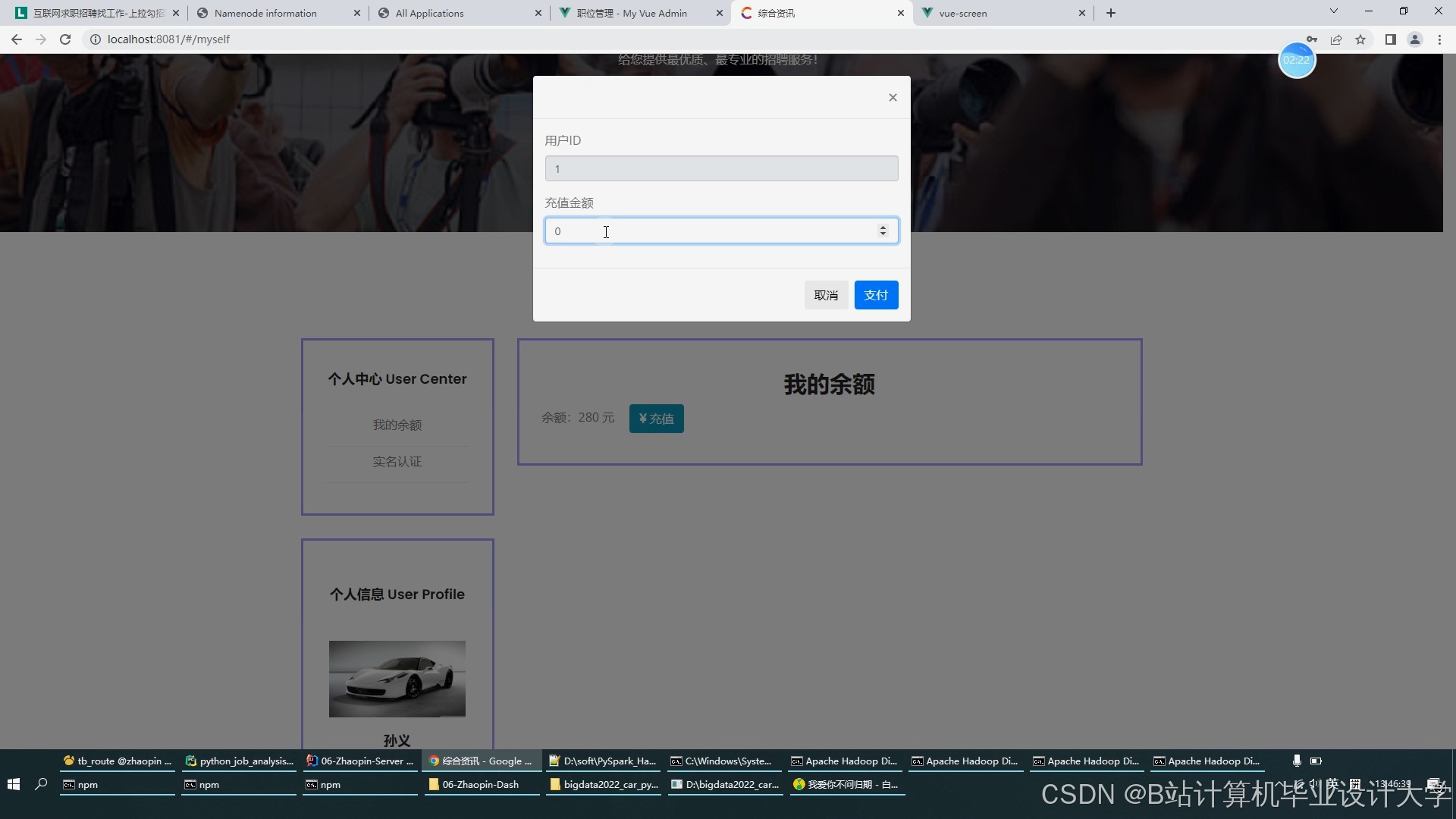

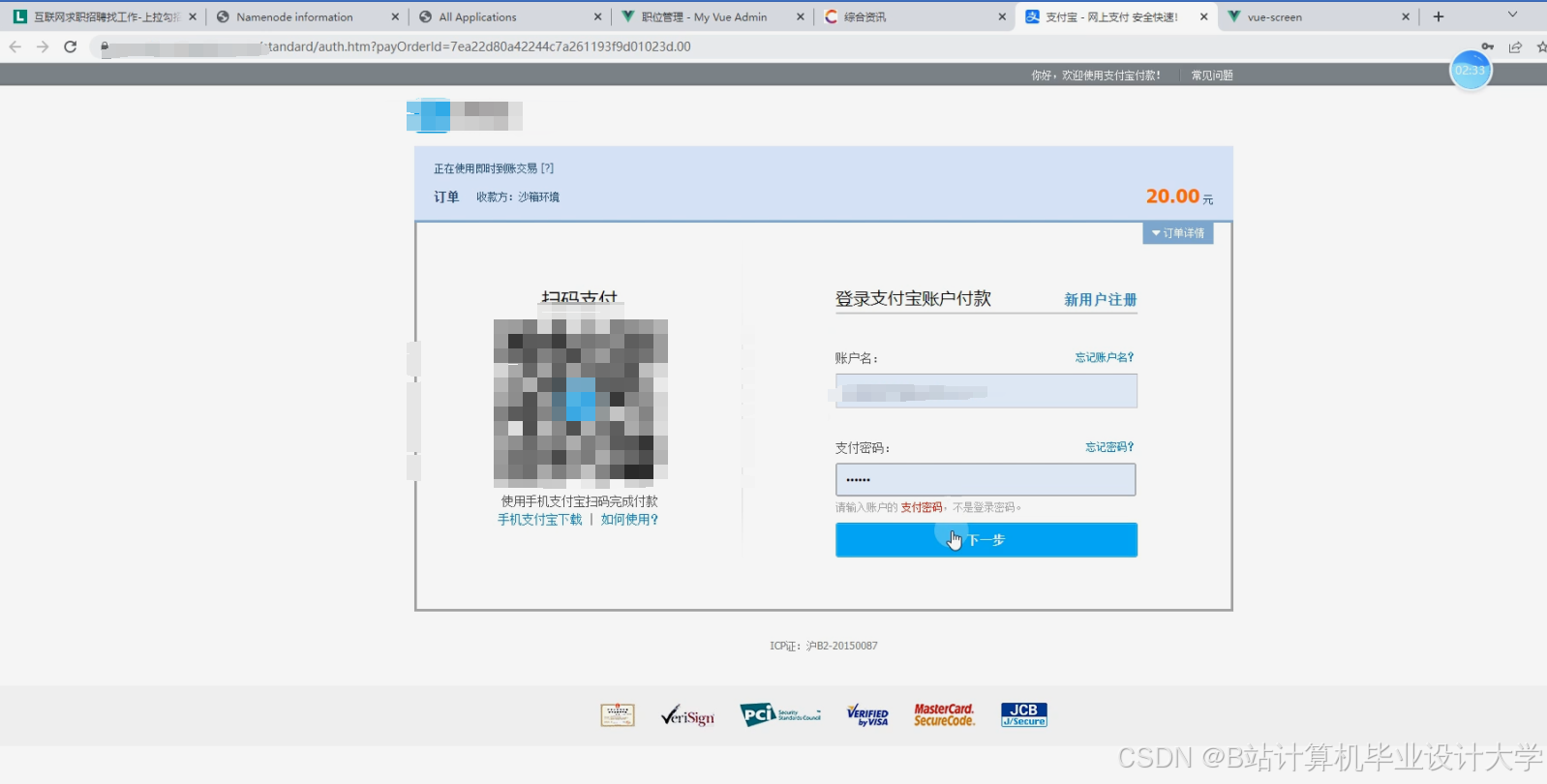

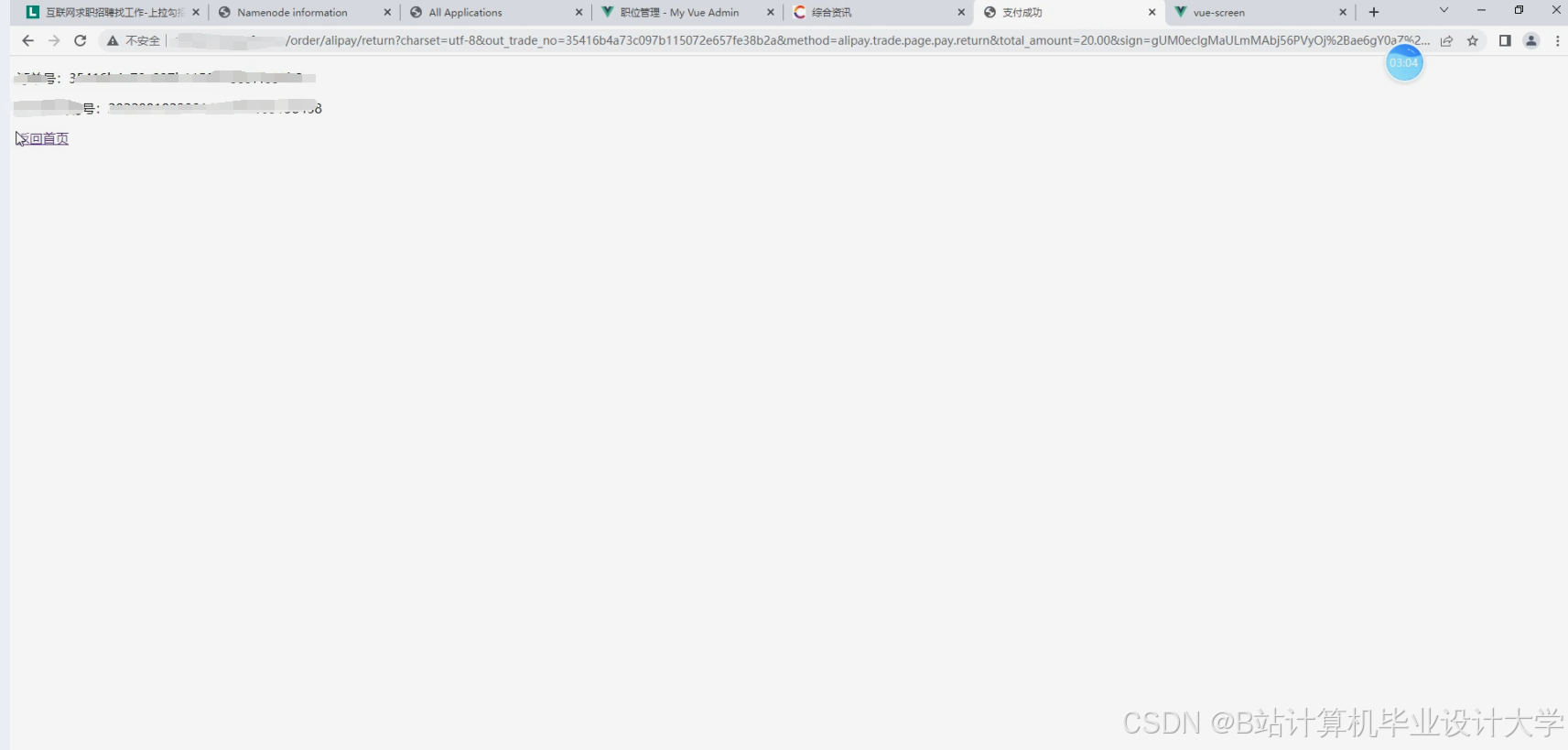

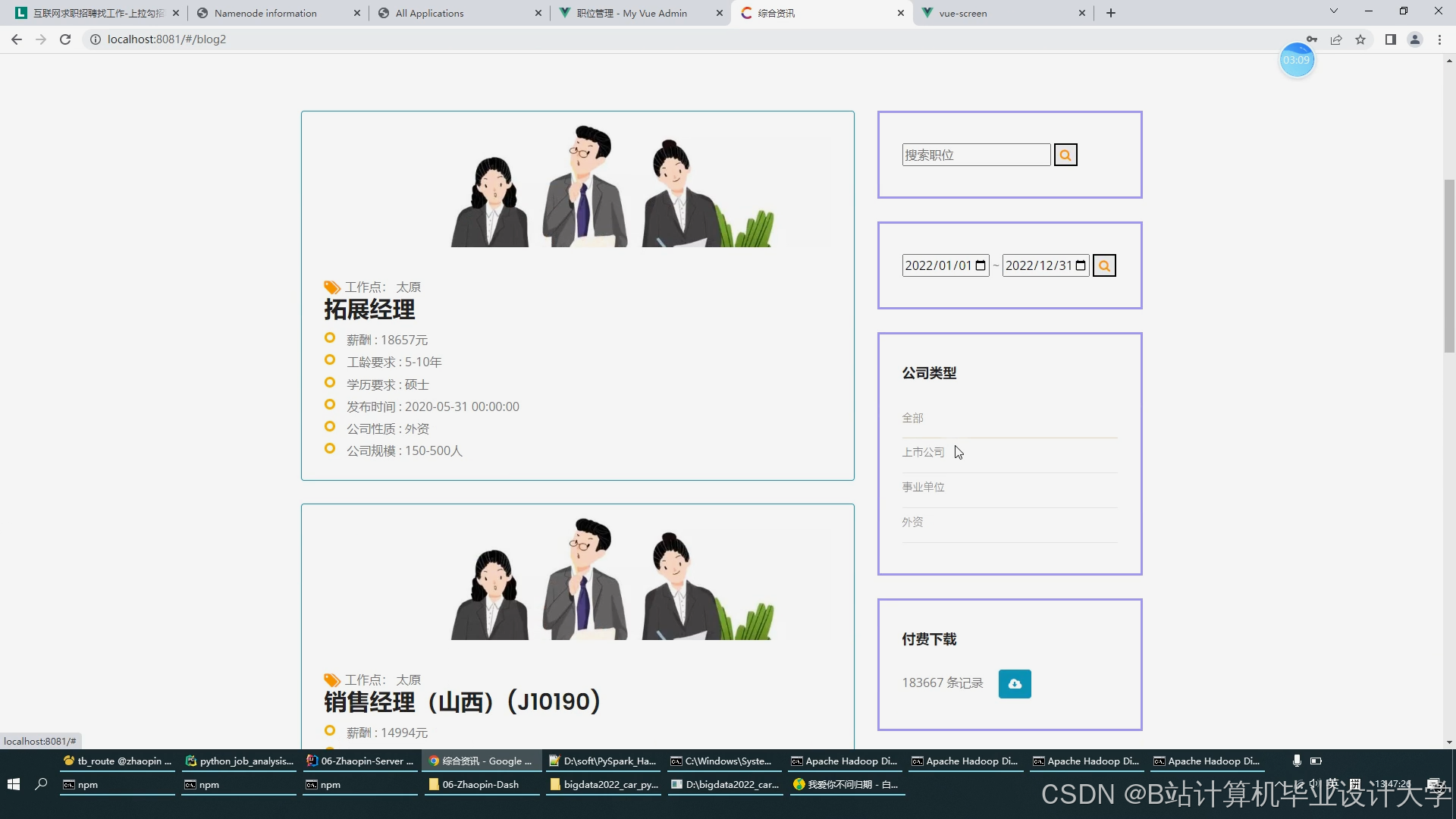

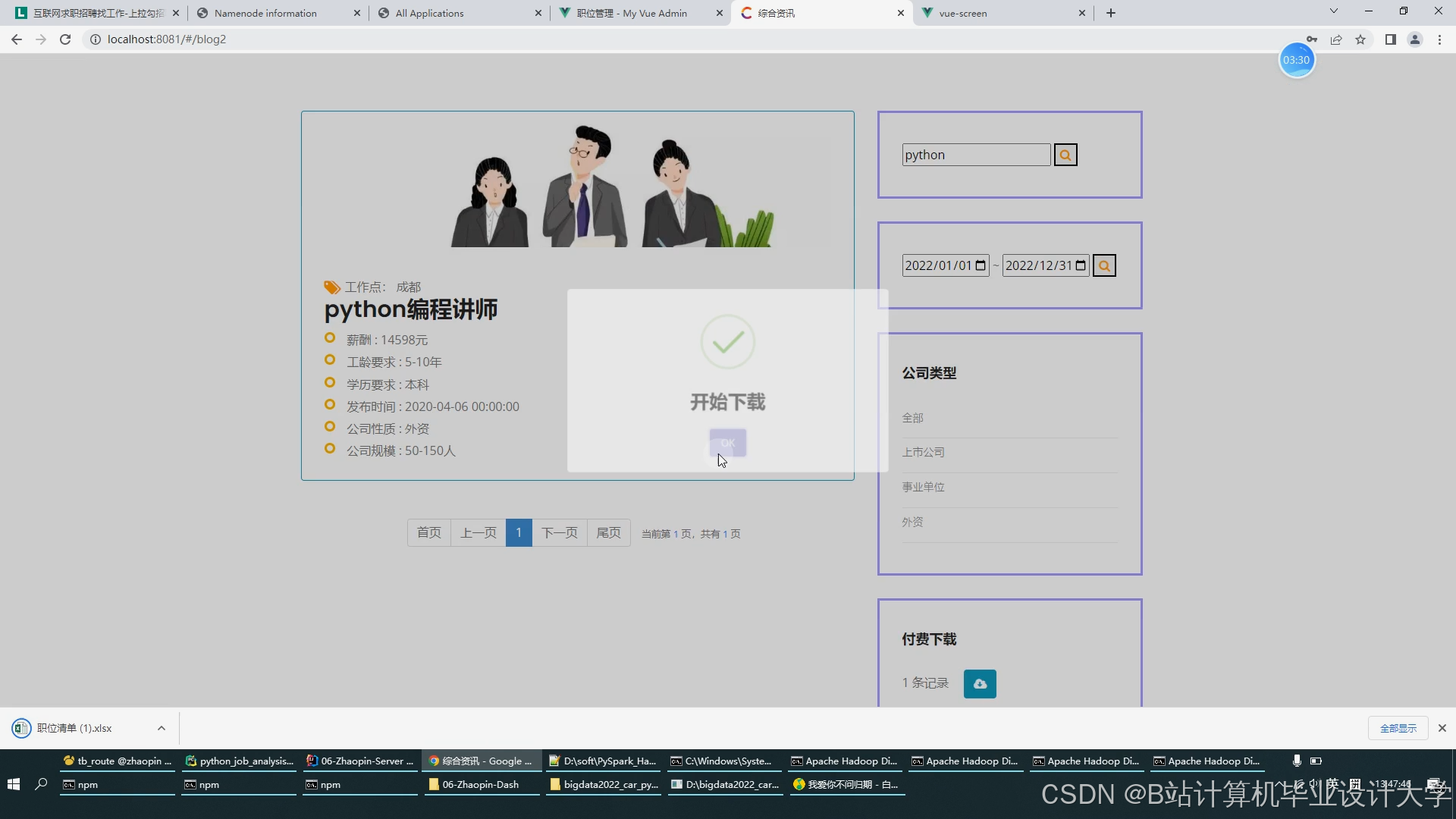

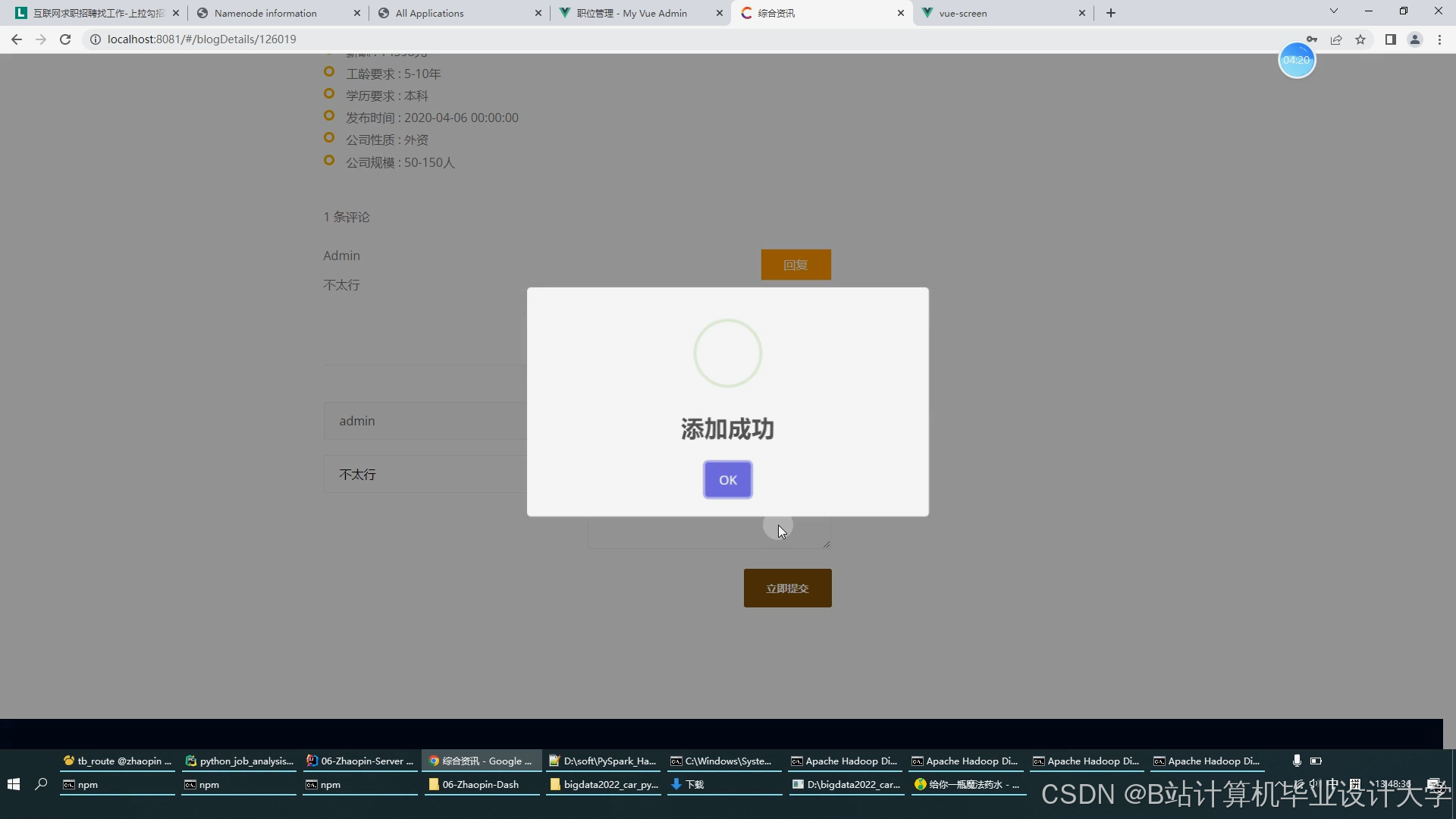

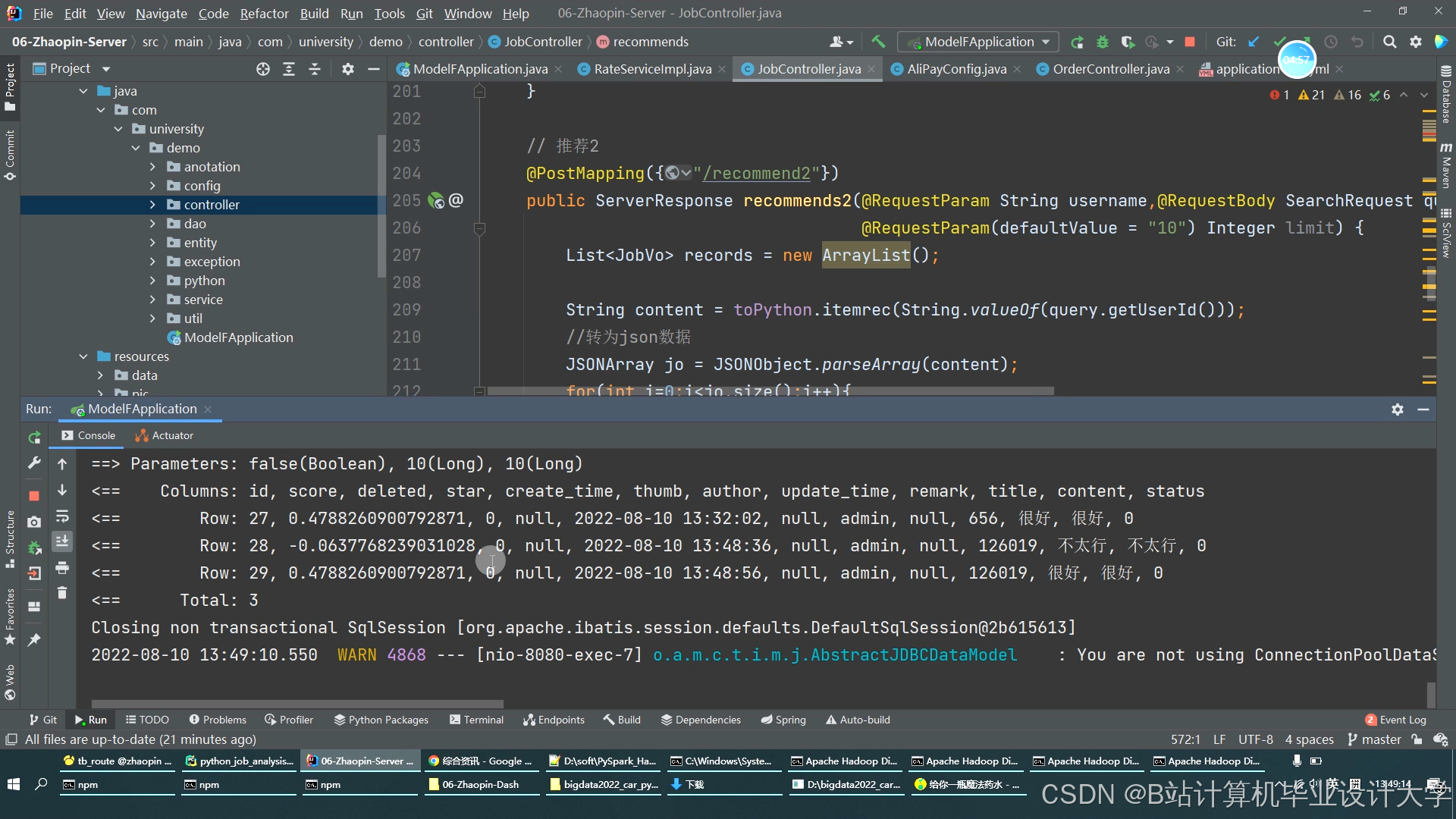

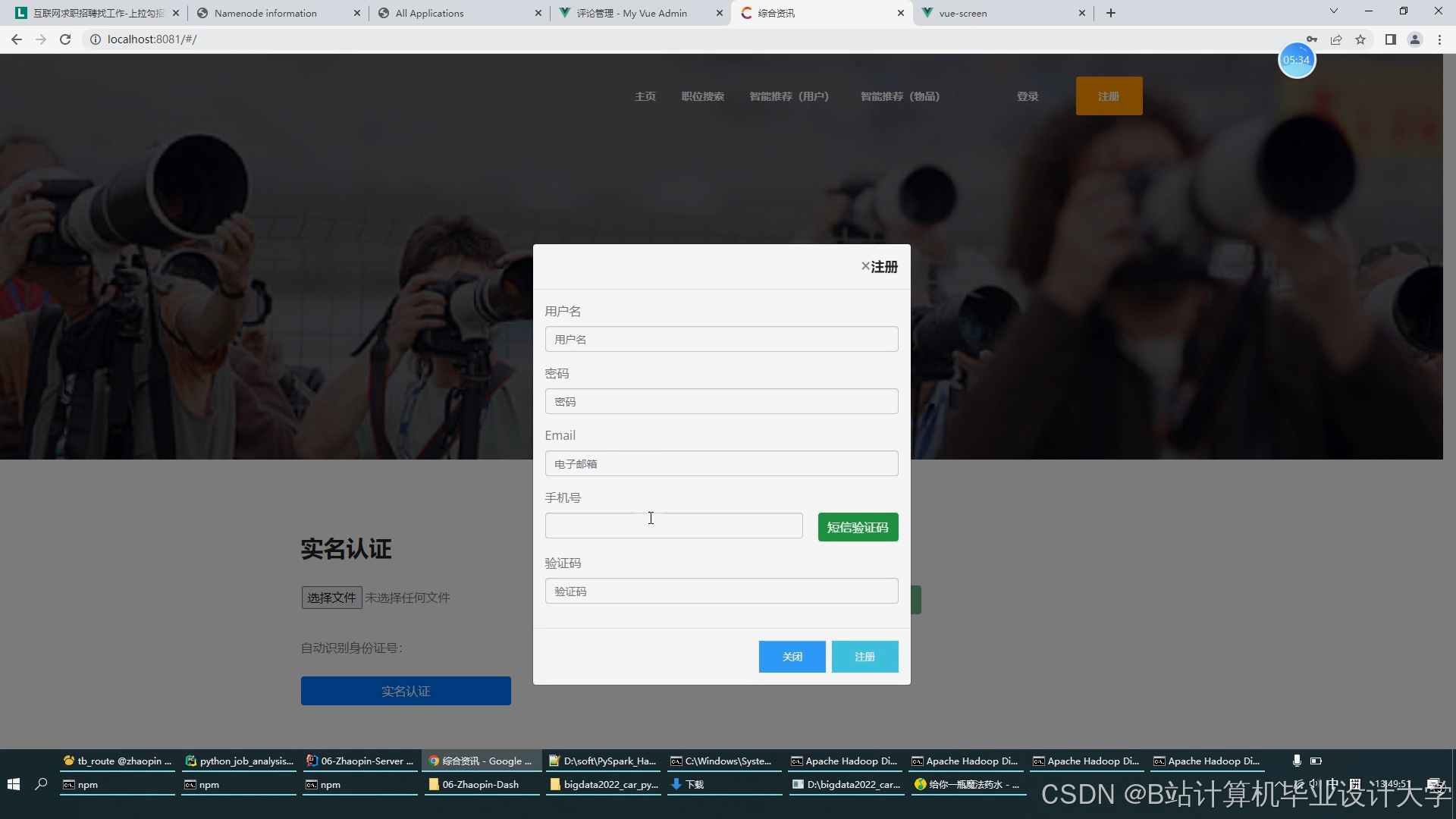

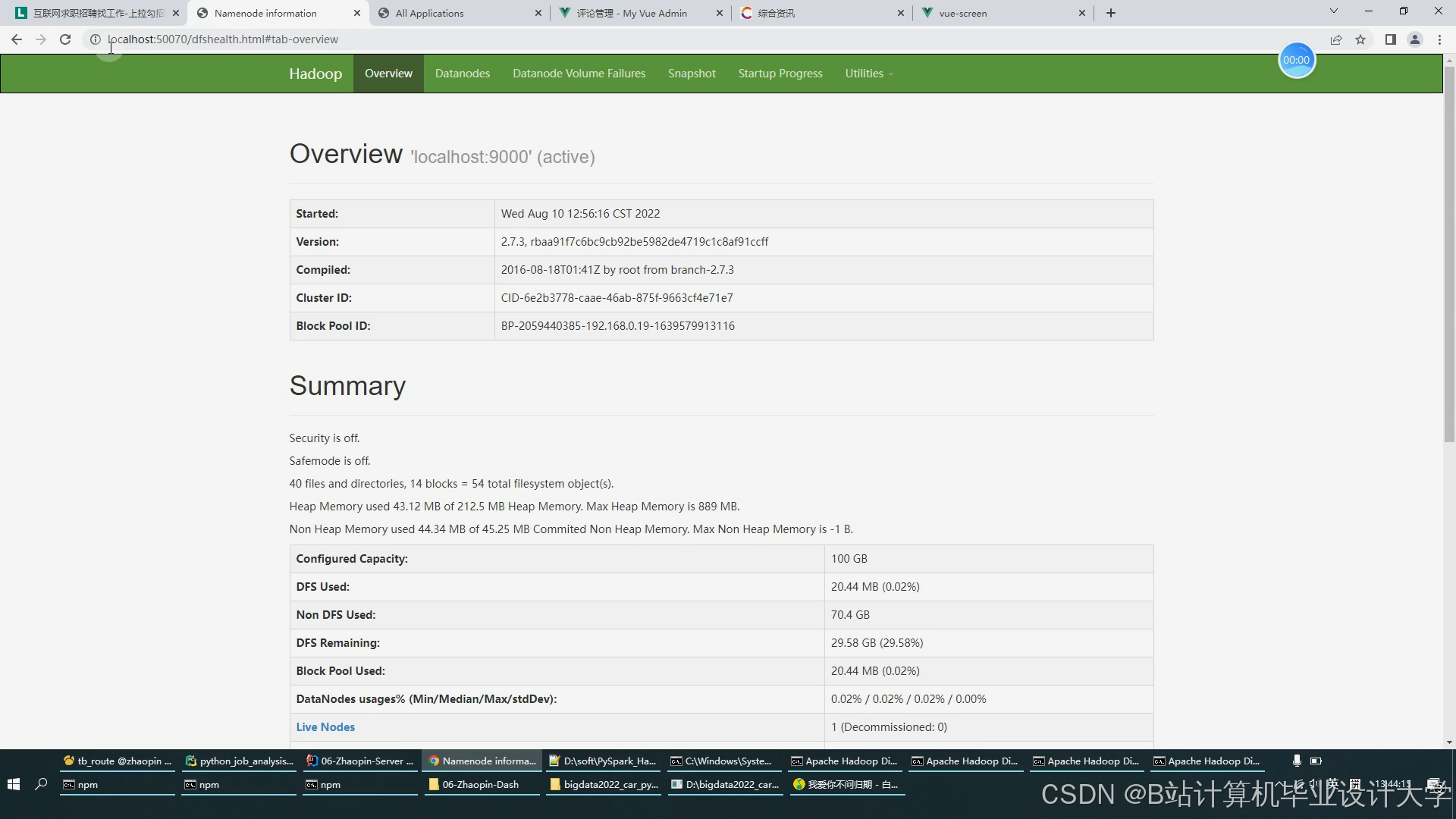

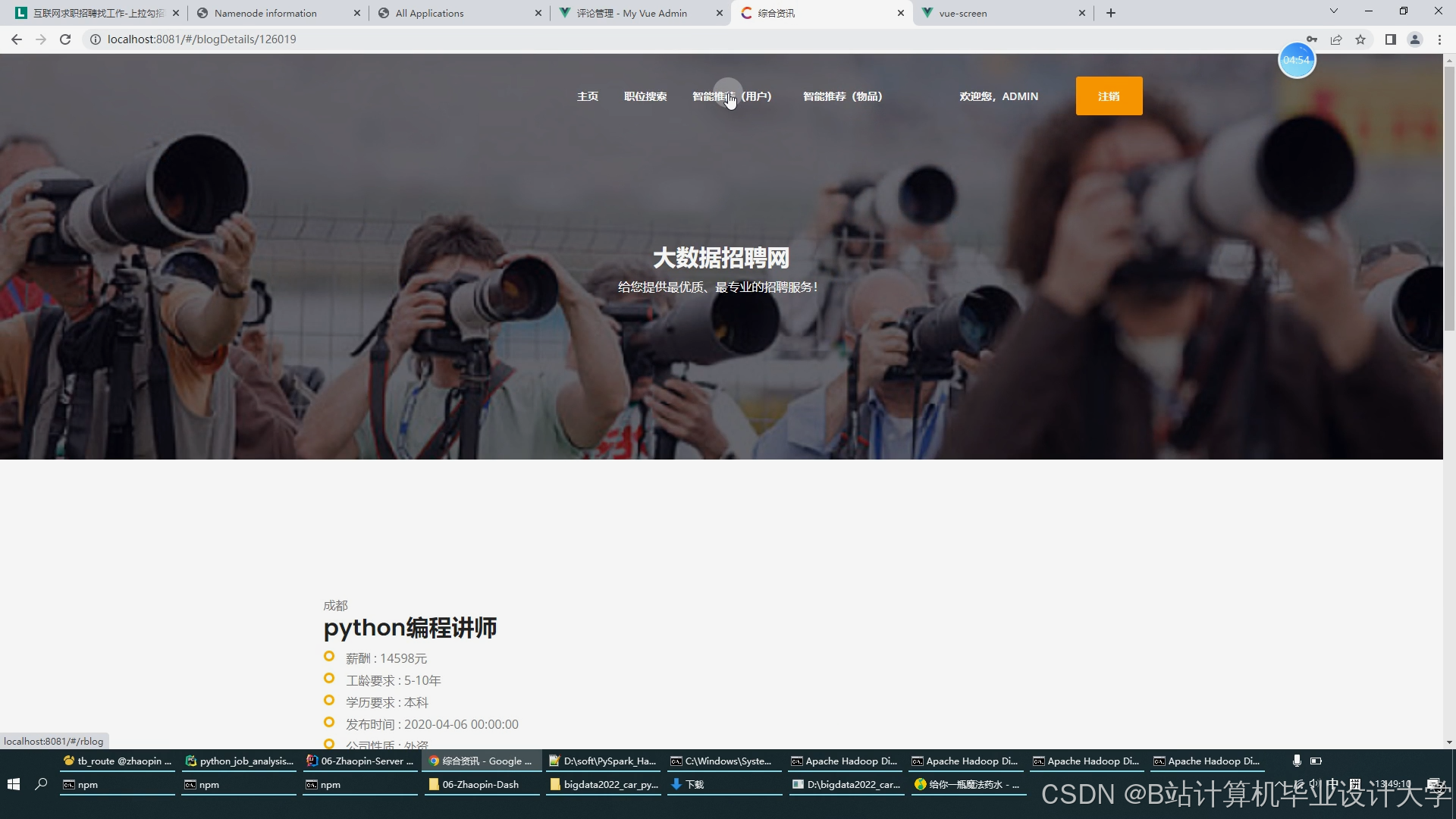

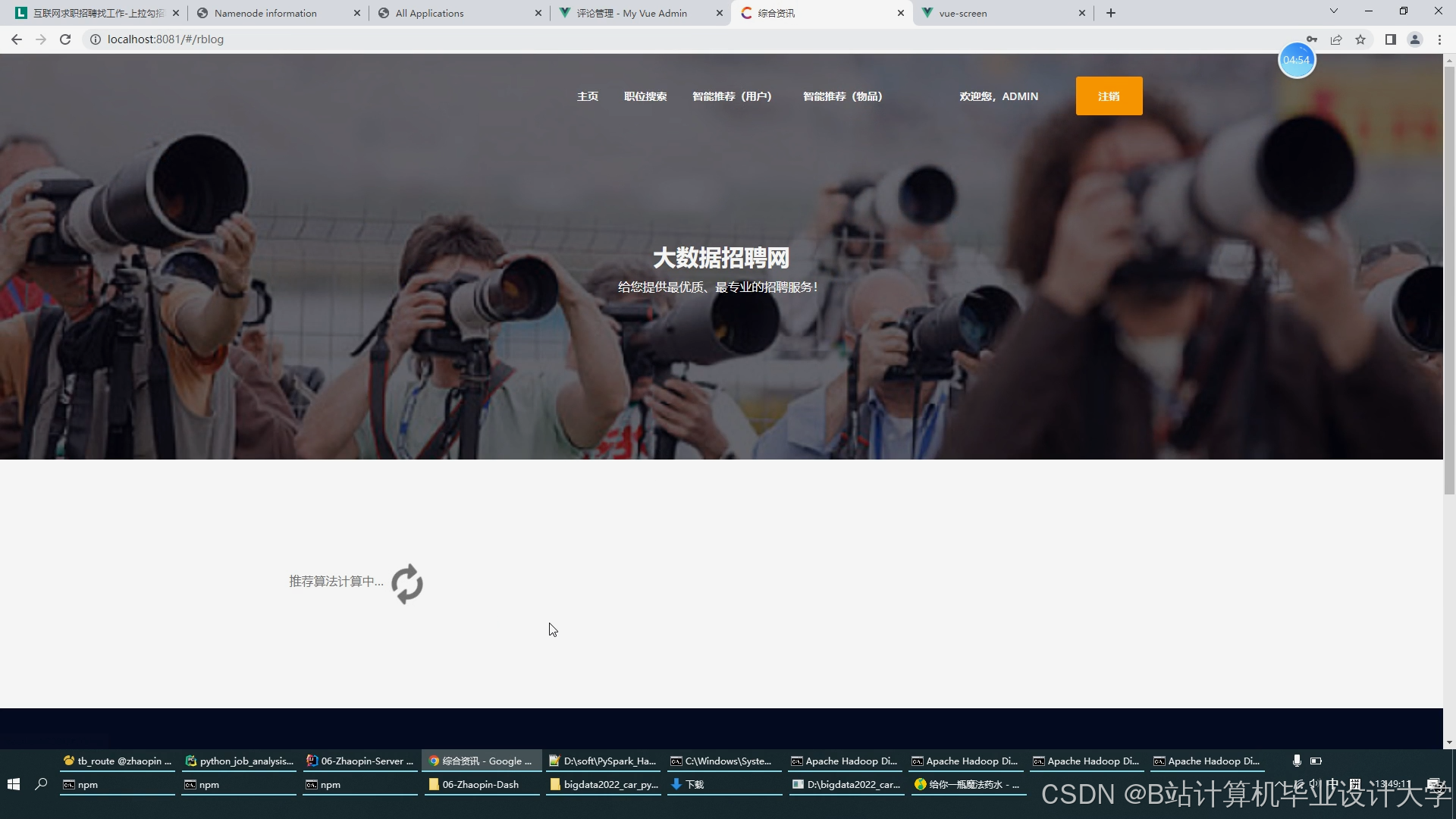

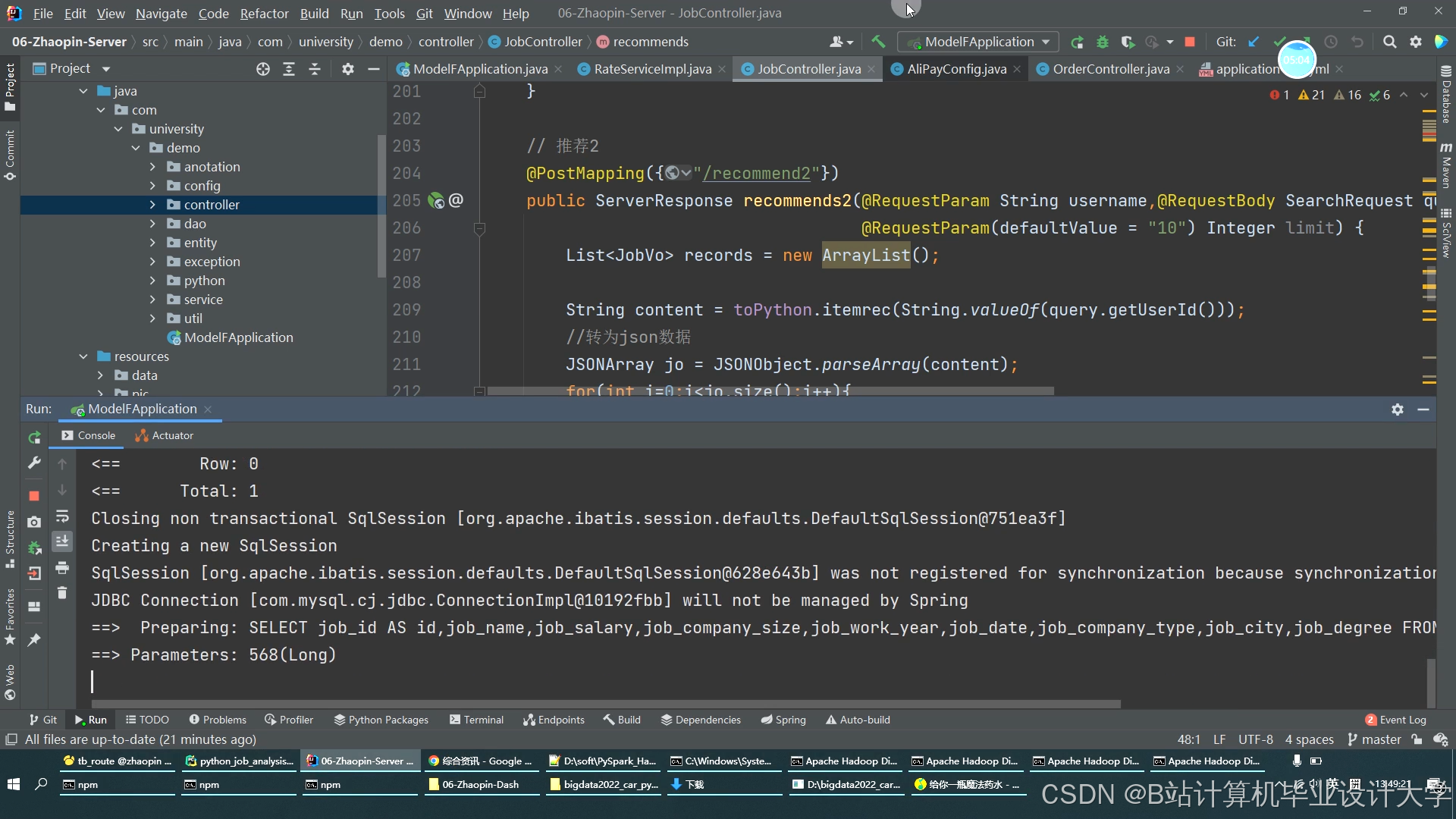

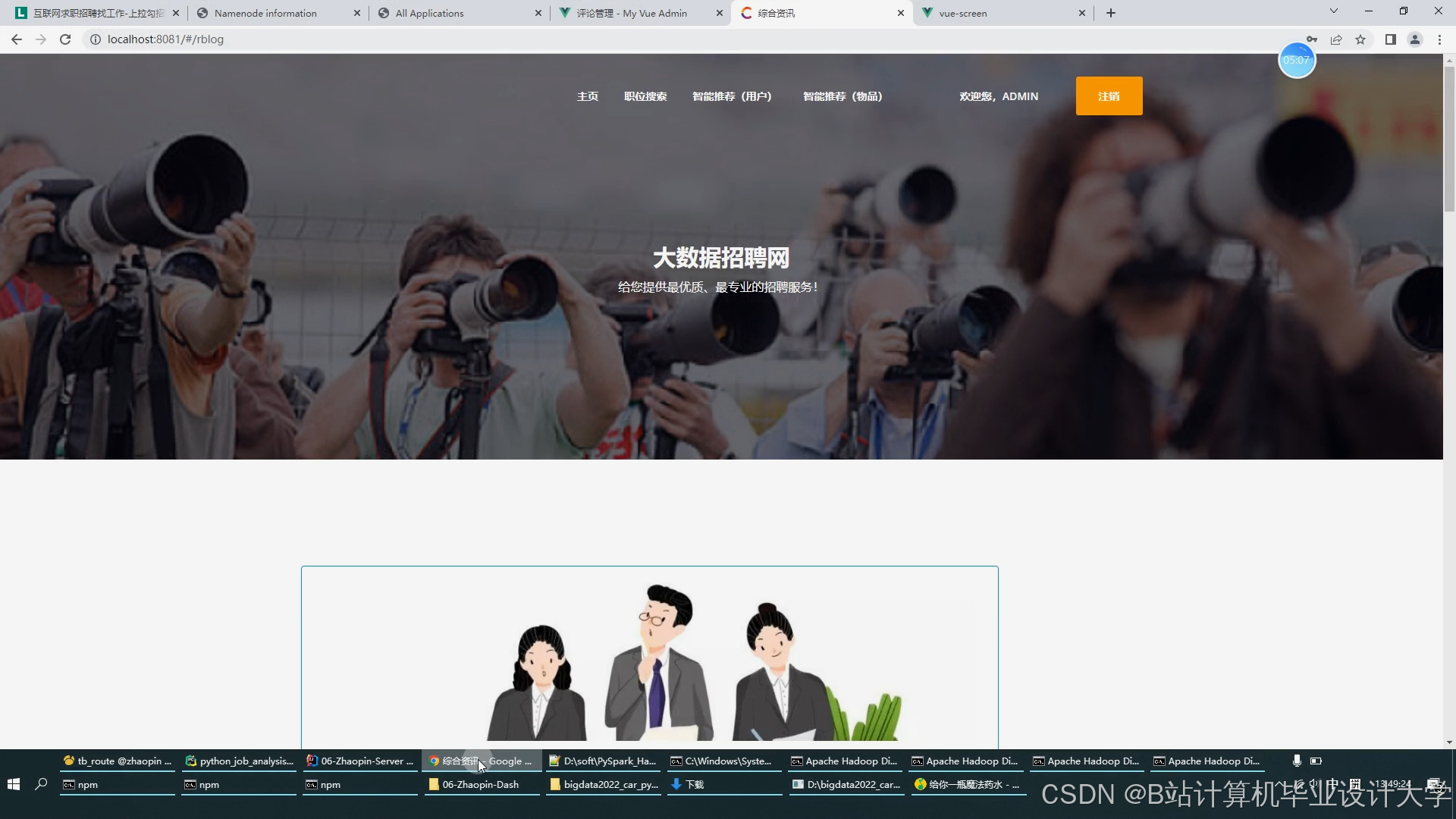

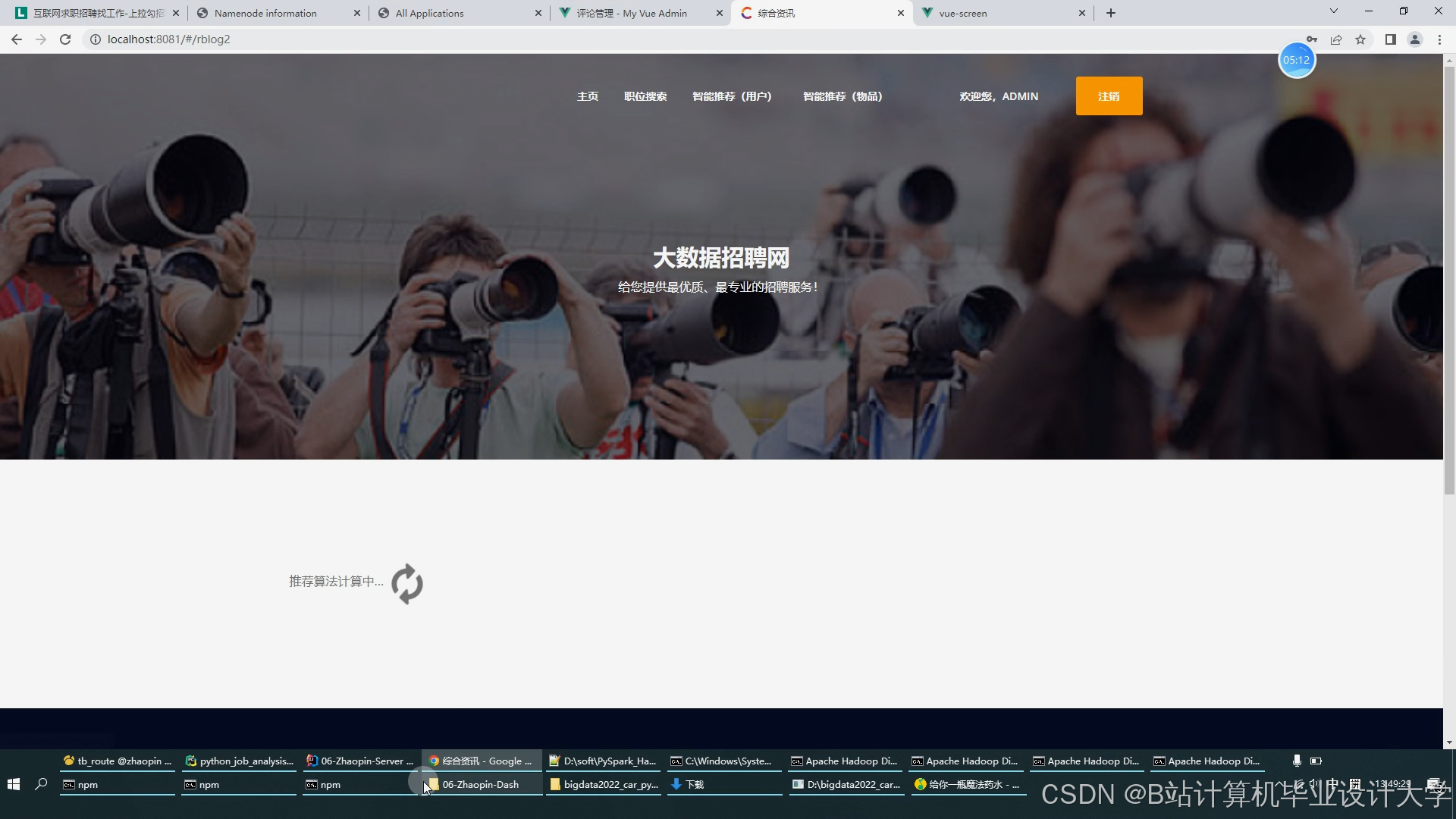

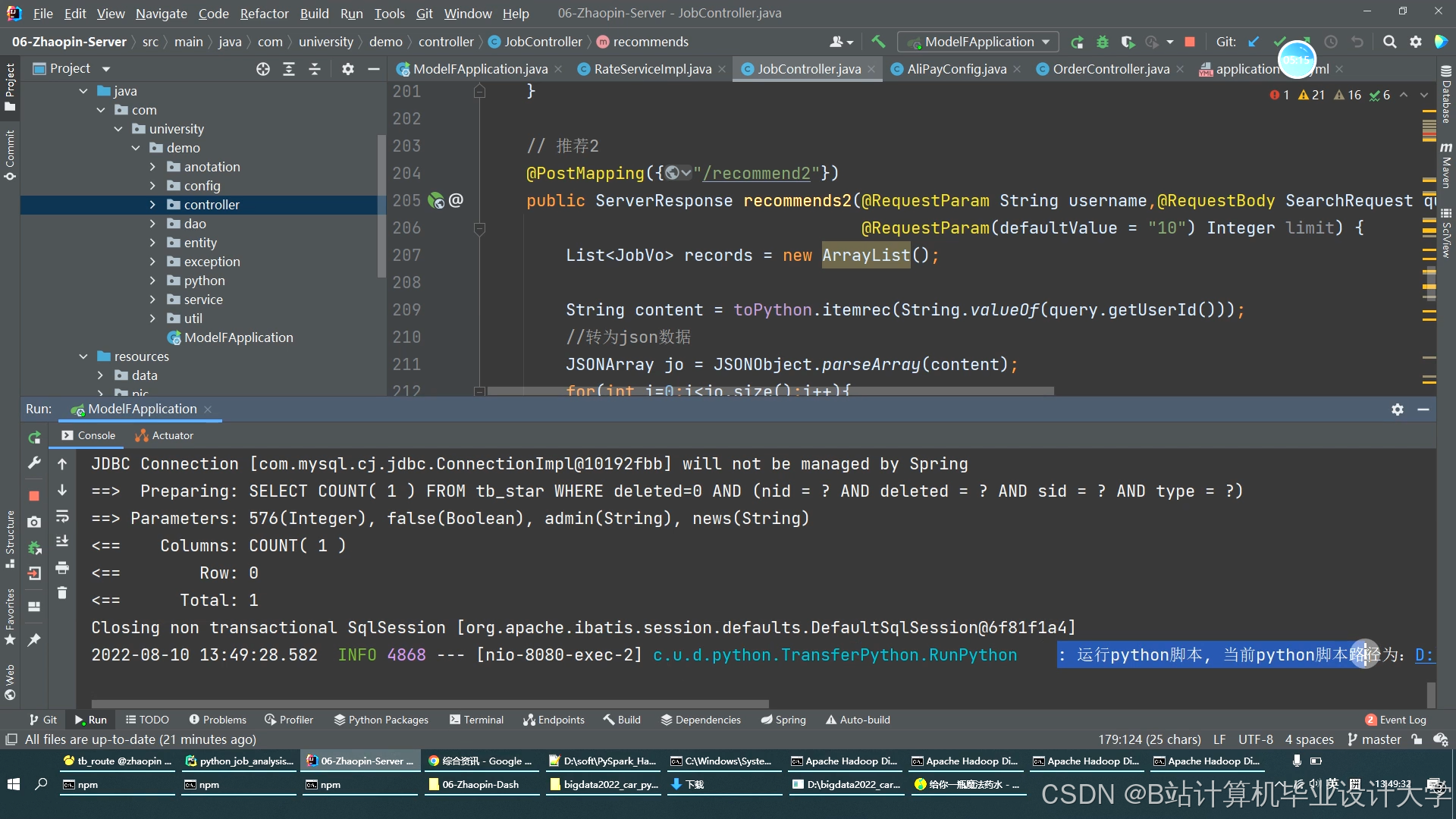

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?