温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

以下是一篇关于《Hadoop+Spark+Hive美食推荐系统与美食可视化》的任务书模板,内容涵盖任务目标、技术分解、分工安排、进度计划及交付成果等核心要素:

任务书

项目名称:基于Hadoop+Spark+Hive的美食推荐系统与美食可视化平台开发

项目周期:2025年7月—2026年4月

项目负责人:[填写姓名]

参与人员:[填写团队成员及分工]

一、任务目标

- 核心目标

- 构建一个分布式美食推荐系统,整合用户行为、美食特征、时空上下文数据,实现个性化推荐(推荐准确率NDCG@10≥0.65)。

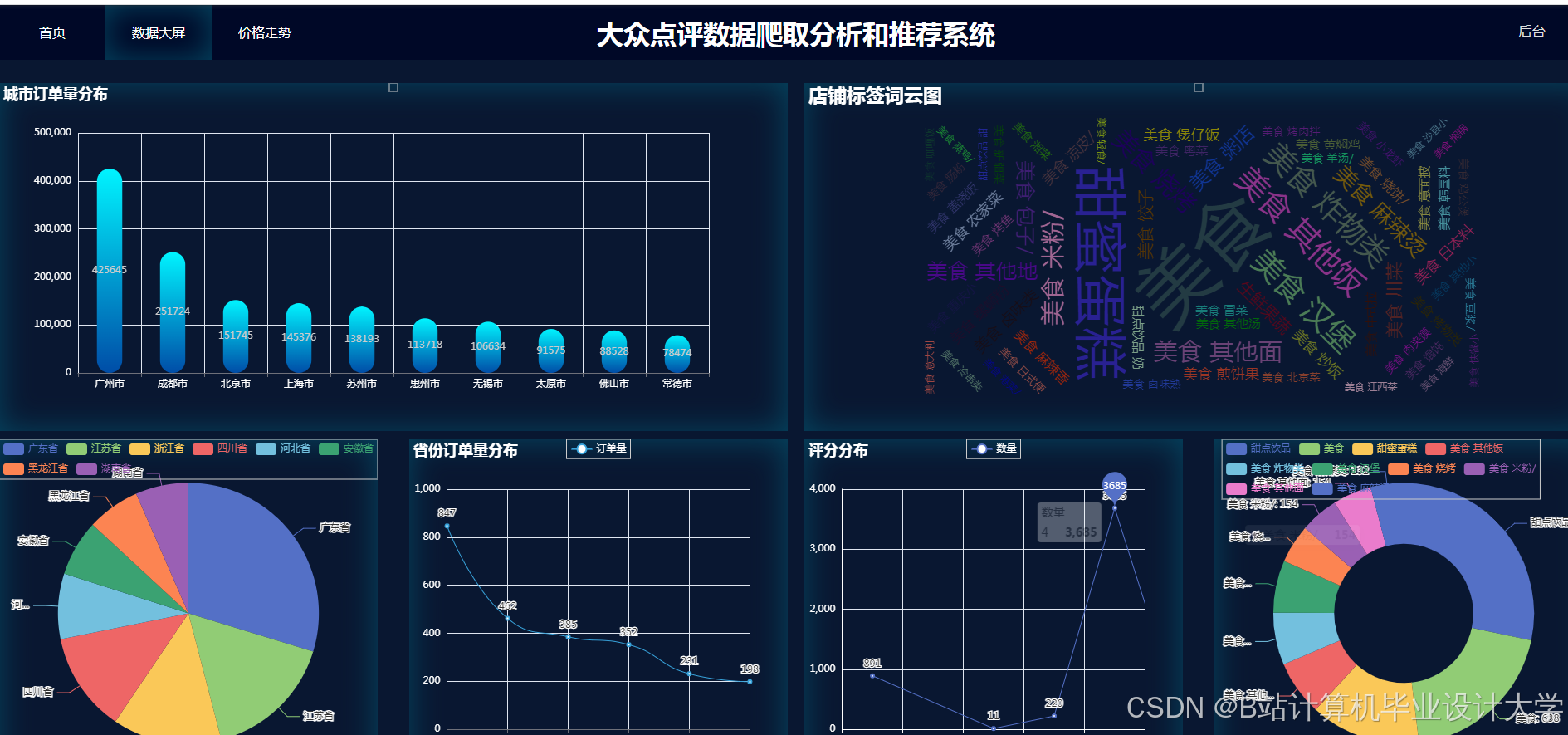

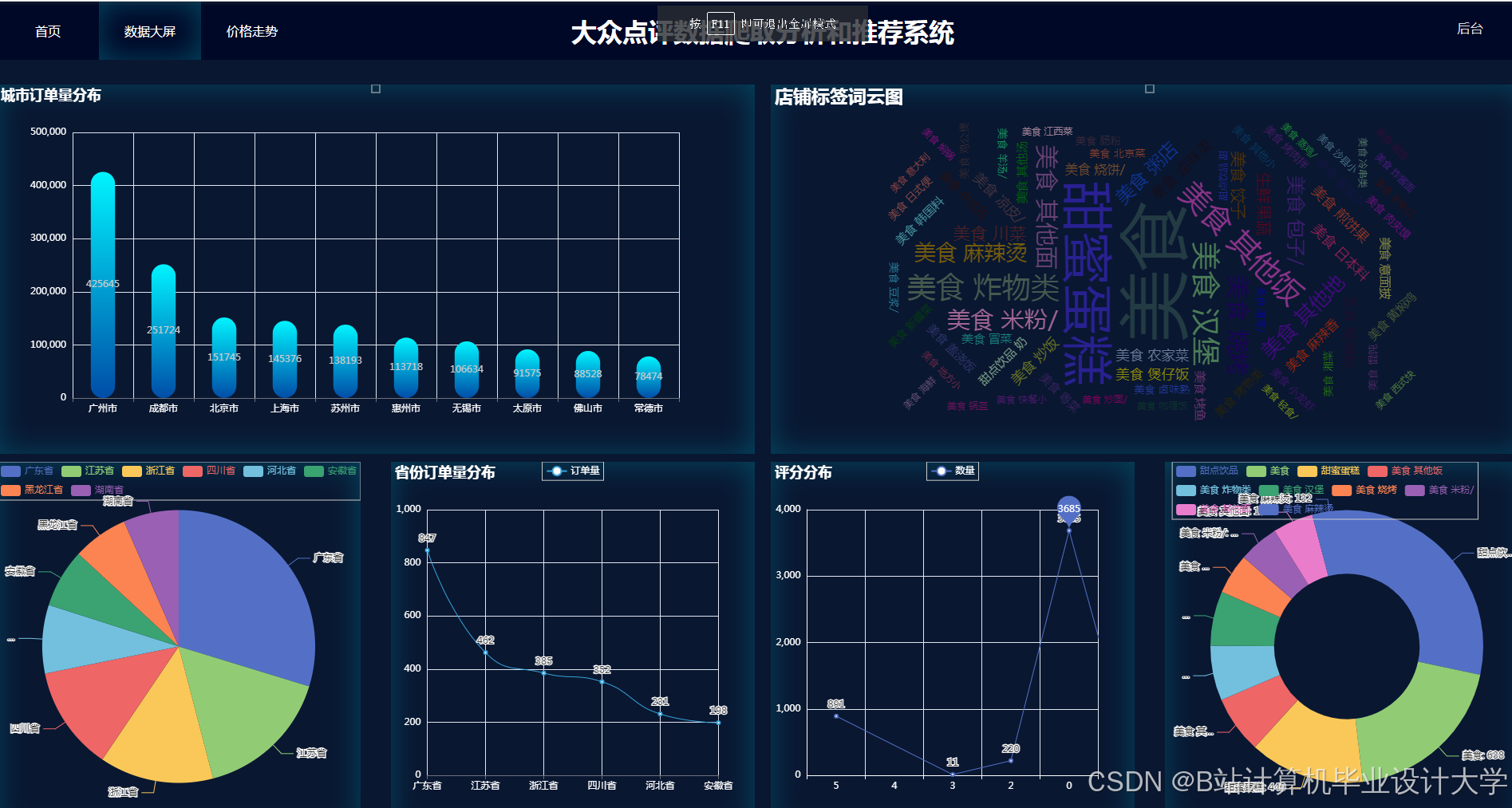

- 开发可视化分析平台,支持美食热度地图、销量趋势图等交互式可视化功能,辅助商家运营决策。

- 技术指标

- 数据规模:支持每日10TB级美食数据(用户行为日志、评论、图片元数据等)的实时处理。

- 响应时间:推荐接口平均响应时间≤500ms,可视化图表渲染时间≤2s。

- 集群规模:基于Hadoop/Spark的5节点集群(1 Master + 4 Worker),单节点配置:16核CPU、64GB内存、4TB存储。

二、任务分解与技术方案

任务1:分布式数据存储与处理架构搭建

- 负责人:[姓名]

- 技术方案:

- 数据存储层:

- 使用Hadoop HDFS实现美食数据的冷热分层存储(热数据:SSD存储;冷数据:HDD存储)。

- 通过Hive构建数据仓库,定义美食评论、用户行为、商家信息等表结构,采用ORC格式+Snappy压缩优化存储效率。

- 数据计算层:

- 部署Spark on YARN集群,配置动态资源分配(

spark.dynamicAllocation.enabled=true)。 - 使用Spark SQL进行批处理分析(如每日用户偏好统计),Spark Streaming处理实时行为流(如用户点击事件)。

- 部署Spark on YARN集群,配置动态资源分配(

- 数据存储层:

任务2:混合推荐模型开发与优化

- 负责人:[姓名]

- 技术方案:

- 特征工程:

- 用户特征:融合显式反馈(评分)与隐式反馈(浏览时长、收藏次数),使用Word2Vec生成用户兴趣向量。

- 美食特征:提取评论文本的TF-IDF关键词,结合美食图片的ResNet-50视觉特征(通过PyTorch预训练模型提取)。

- 时空特征:基于GeoHash编码用户位置,结合LSTM模型预测用户时段偏好(如工作日午餐/周末晚餐)。

- 推荐算法:

- 基础模型:基于ALS(交替最小二乘法)的协同过滤,处理用户-美食评分矩阵。

- 深度模型:构建Wide & Deep模型,Wide部分为逻辑回归(处理记忆性特征),Deep部分为DNN(处理泛化性特征)。

- 混合策略:加权融合协同过滤与深度学习模型的推荐结果(权重通过网格搜索优化)。

- 特征工程:

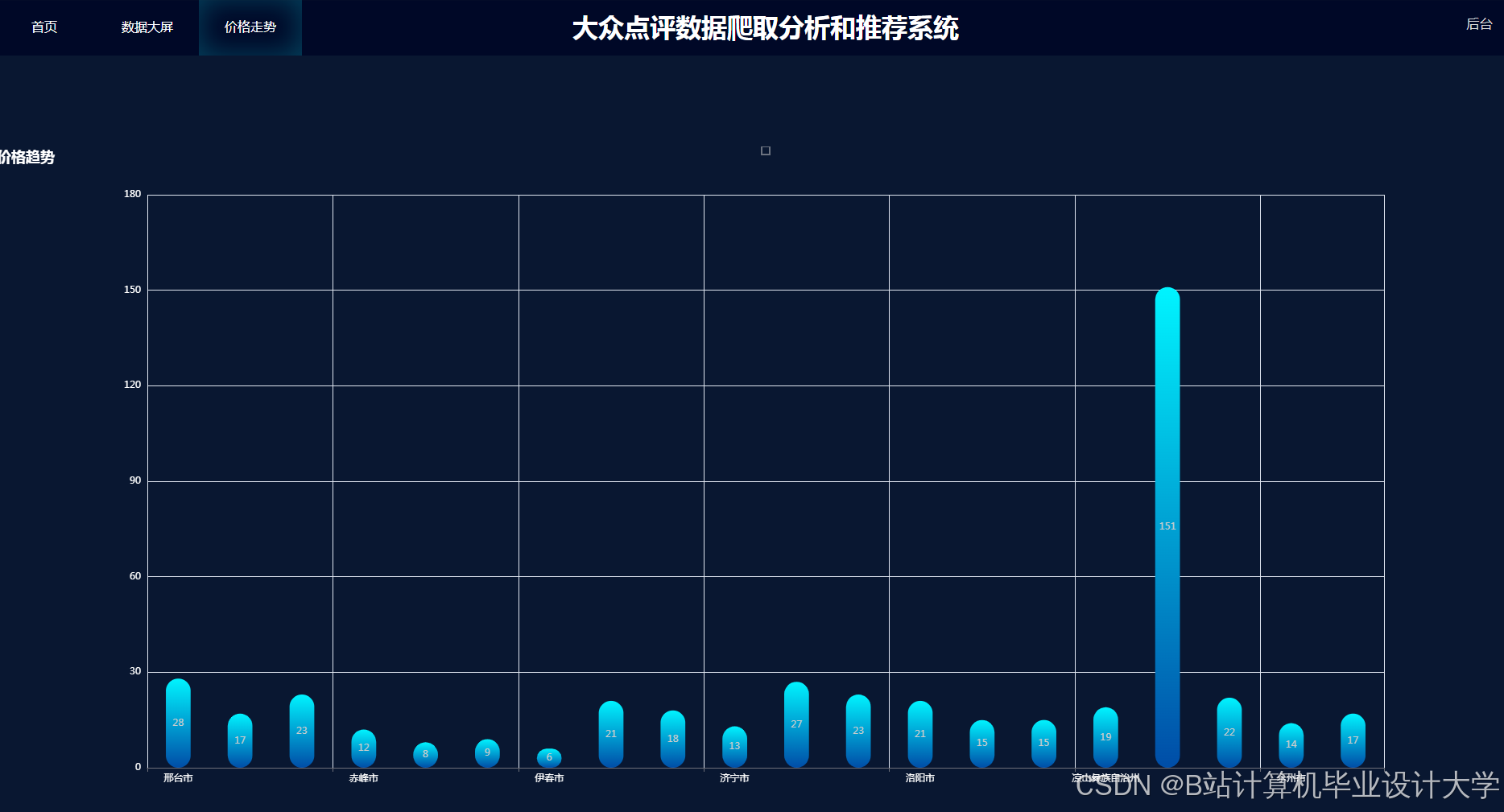

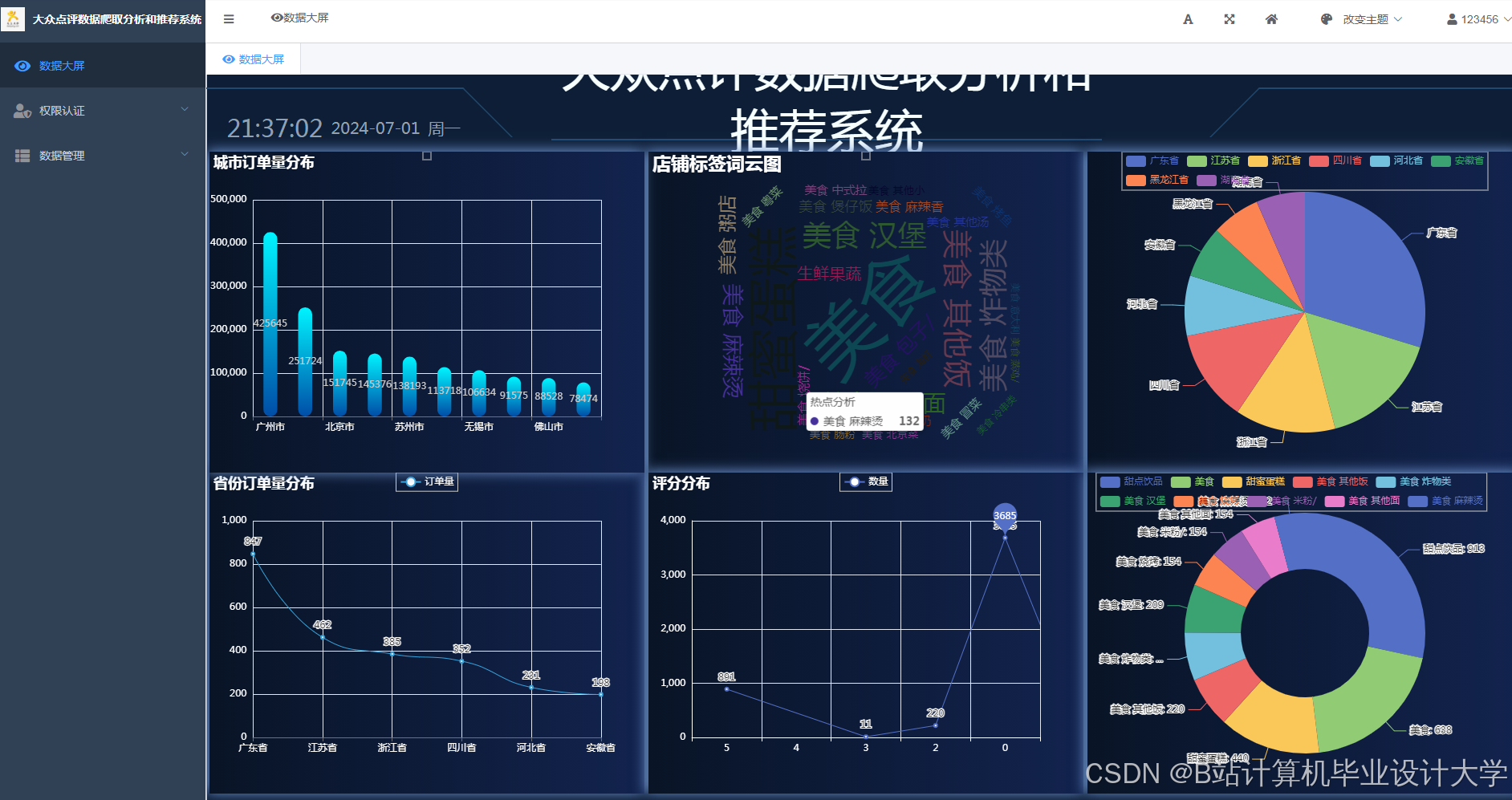

任务3:美食可视化平台开发

- 负责人:[姓名]

- 技术方案:

- 前端展示:

- 使用ECharts 5.0实现交互式可视化组件,包括:

- 热力图:展示区域美食热度(基于高德地图API)。

- 折线图:分析菜品销量周趋势(支持动态时间范围筛选)。

- 雷达图:对比不同用户群体的口味偏好(如“年轻人 vs 中老年人”)。

- 使用ECharts 5.0实现交互式可视化组件,包括:

- 后端服务:

- 基于Spring Boot开发RESTful API,提供推荐结果与可视化数据的接口(如

/api/recommend/{userId})。 - 使用Redis缓存高频访问数据(如热门商家列表),降低Hive查询压力。

- 基于Spring Boot开发RESTful API,提供推荐结果与可视化数据的接口(如

- 前端展示:

任务4:系统集成与性能测试

- 负责人:[姓名]

- 技术方案:

- 集成测试:

- 验证Hadoop→Hive→Spark→可视化平台的数据流完整性(如检查Hive表数据是否正确流入Spark任务)。

- 测试推荐接口与可视化API的兼容性(如返回数据格式是否符合前端要求)。

- 性能测试:

- 使用JMeter模拟1000并发用户,测试推荐接口的吞吐量(TPS≥200)。

- 通过Spark UI监控任务执行时间,优化Shuffle阶段数据倾斜问题(如使用

salting技术)。

- 集成测试:

三、分工与职责

| 成员姓名 | 角色 | 具体职责 |

|---|---|---|

| 张三 | 项目经理 | 协调资源、把控进度、对接需求方 |

| 李四 | 大数据工程师 | 搭建Hadoop/Spark集群、开发ETL流程 |

| 王五 | 算法工程师 | 实现推荐模型、优化特征工程 |

| 赵六 | 前端开发 | 设计可视化界面、实现交互逻辑 |

| 钱七 | 测试工程师 | 编写测试用例、执行性能测试 |

四、进度计划

| 阶段 | 时间范围 | 关键里程碑 |

|---|---|---|

| 1 | 2025.07-2025.08 | 完成Hadoop/Spark集群部署,验证基础读写功能 |

| 2 | 2025.09-2025.10 | 实现Hive数据仓库设计,完成历史数据迁移 |

| 3 | 2025.11-2025.12 | 开发Wide & Deep推荐模型,在Yelp数据集上验证准确率 |

| 4 | 2026.01-2026.02 | 完成可视化平台前端开发,集成推荐API |

| 5 | 2026.03-2026.04 | 执行全链路压力测试,撰写项目总结报告 |

五、交付成果

- 系统文档:

- 《Hadoop+Spark+Hive集群部署指南》

- 《美食推荐系统API文档》

- 《可视化平台用户手册》

- 代码与模型:

- Spark推荐任务代码(Scala/Python)

- ECharts可视化配置文件(JSON格式)

- 训练好的Wide & Deep模型权重文件(HDF5格式)

- 测试报告:

- 《推荐准确率测试报告》(包含NDCG@10、Precision@K等指标)

- 《系统性能测试报告》(包含响应时间、吞吐量、资源利用率数据)

六、风险评估与应对措施

| 风险类型 | 风险描述 | 应对策略 |

|---|---|---|

| 技术风险 | Spark任务因数据倾斜导致OOM | 优化Shuffle分区策略,增加spark.sql.shuffle.partitions参数 |

| 数据风险 | 用户行为日志存在缺失值 | 设计数据清洗规则(如填充中位数、删除异常样本) |

| 进度风险 | 算法调优耗时超出预期 | 提前预留2周缓冲期,优先保证基础功能上线 |

项目负责人签字:____________________

日期:2025年6月XX日

备注:本任务书需根据实际资源情况(如集群节点数量、数据规模)进一步细化技术参数,并定期召开周会同步进度风险。

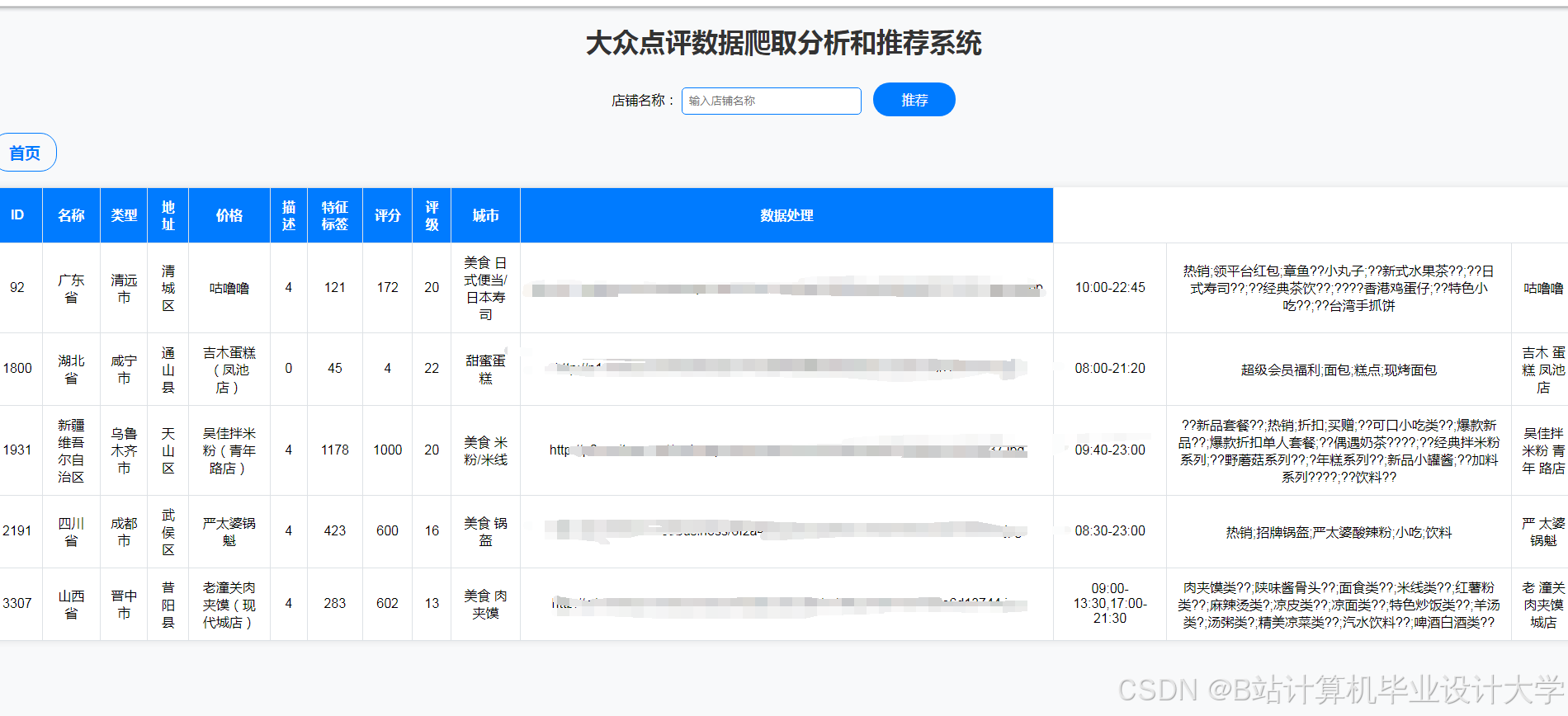

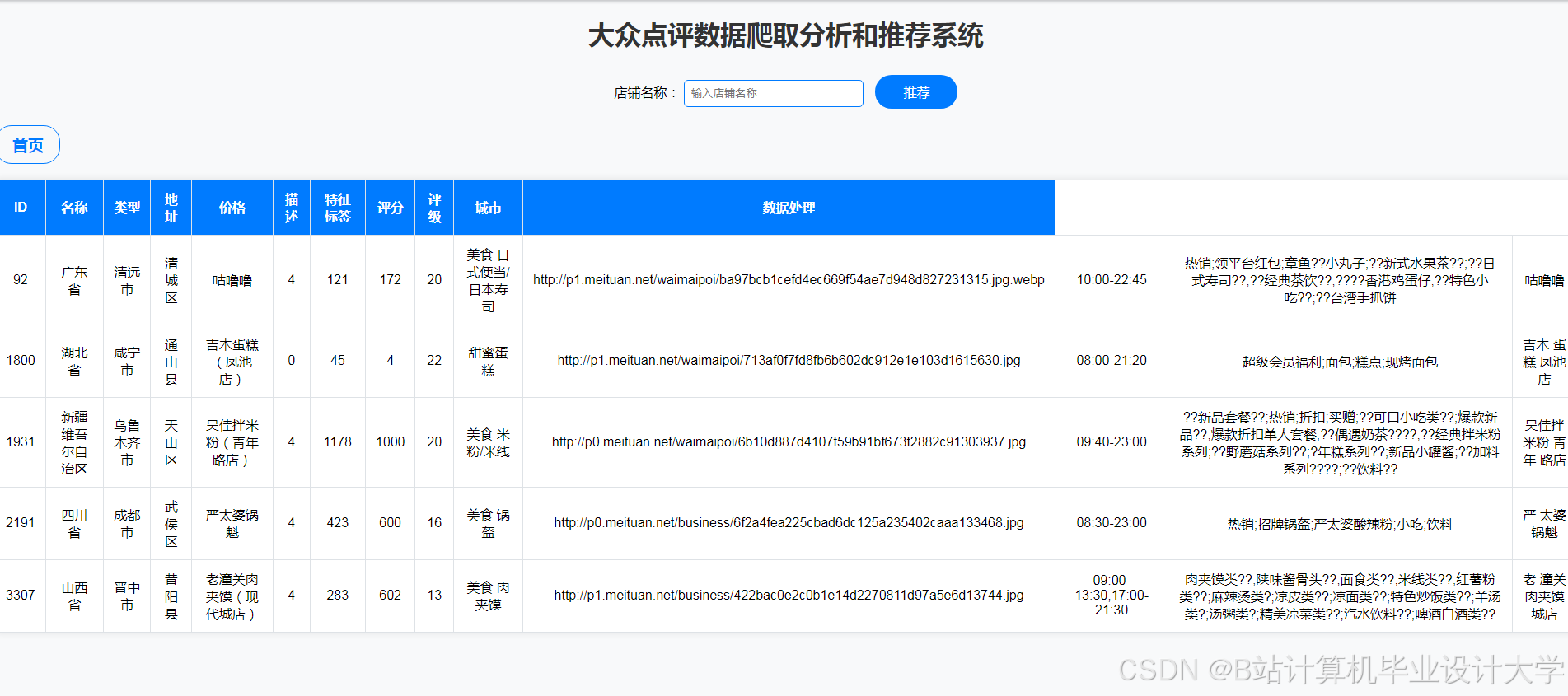

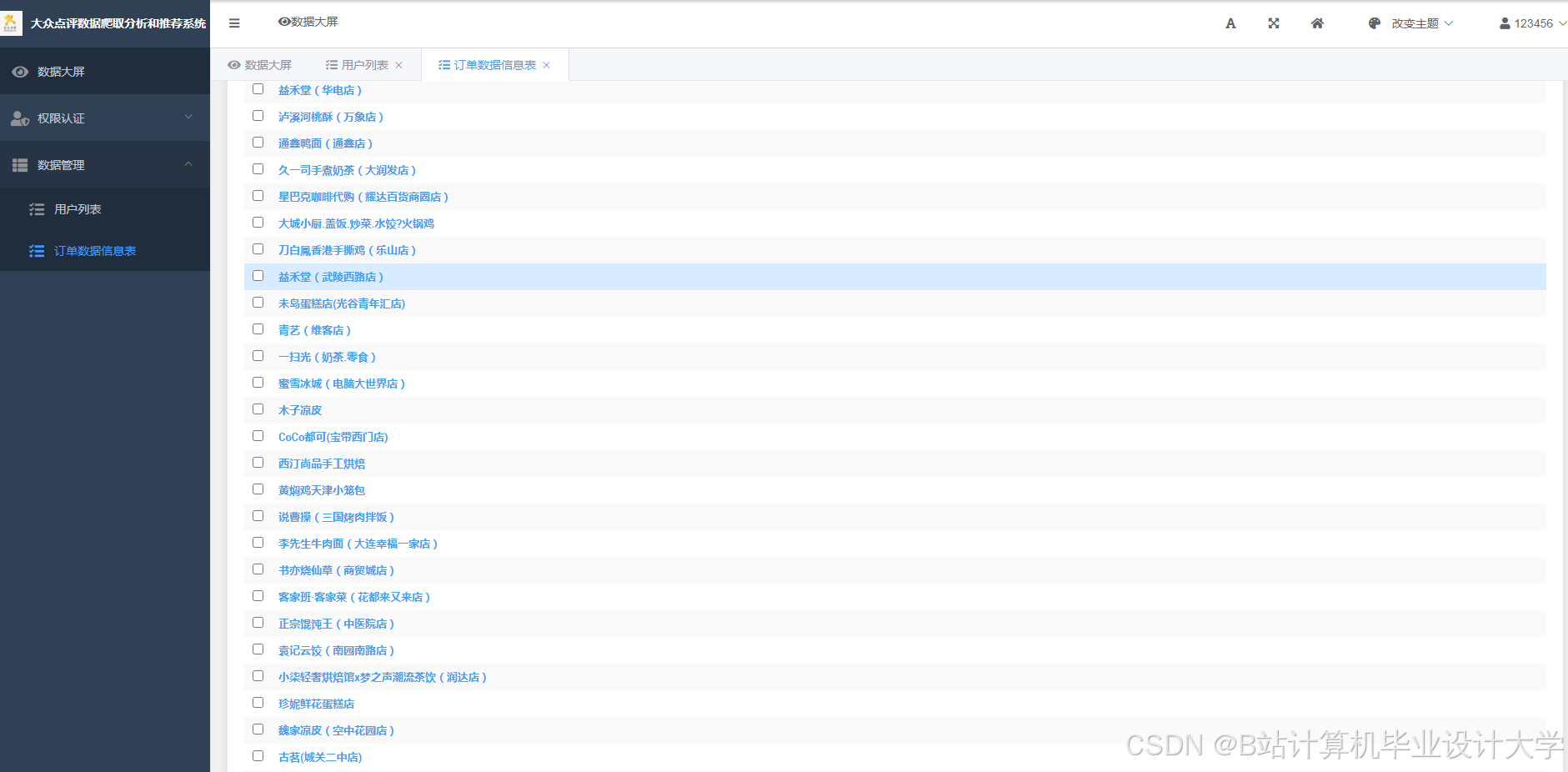

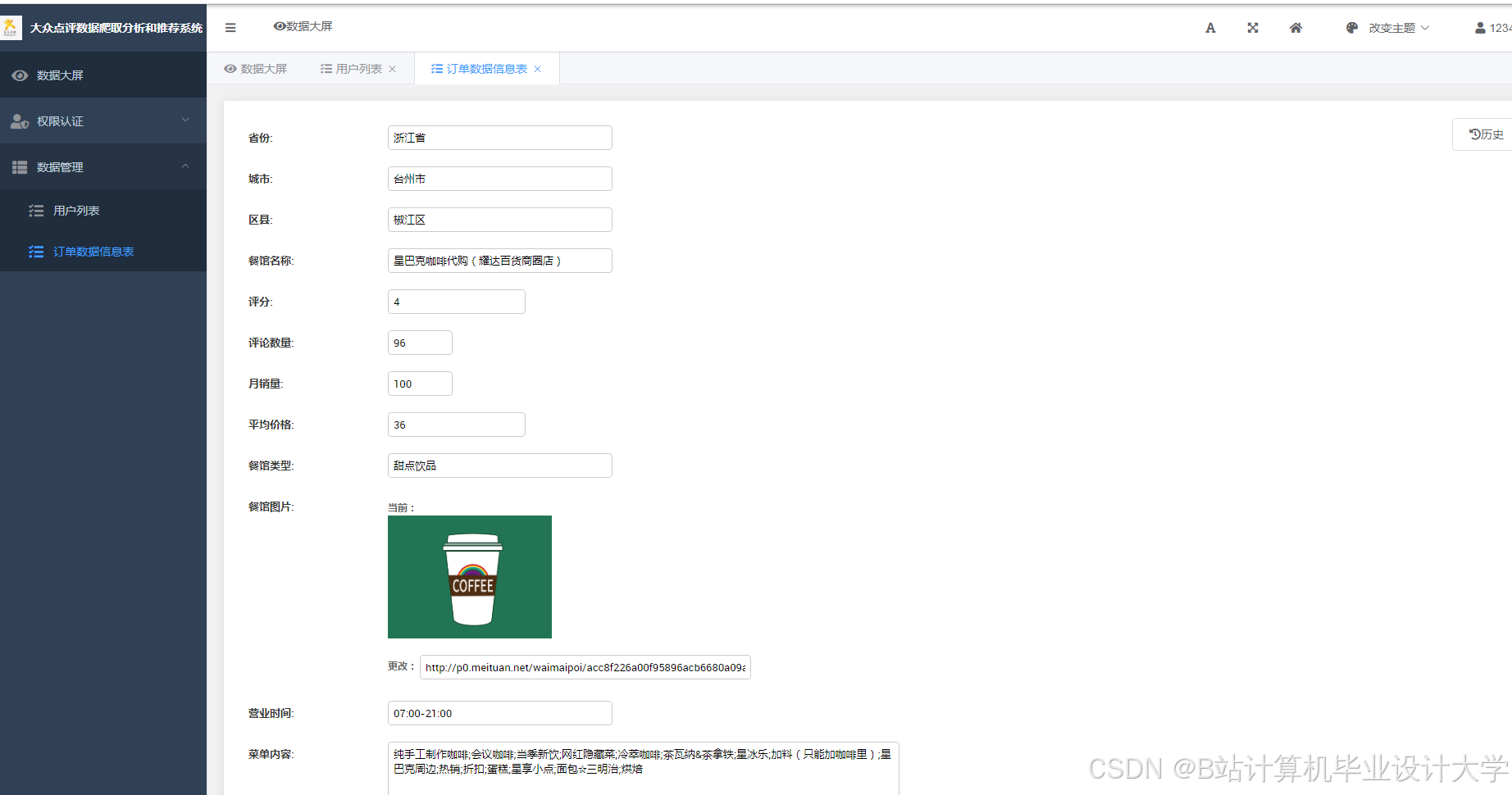

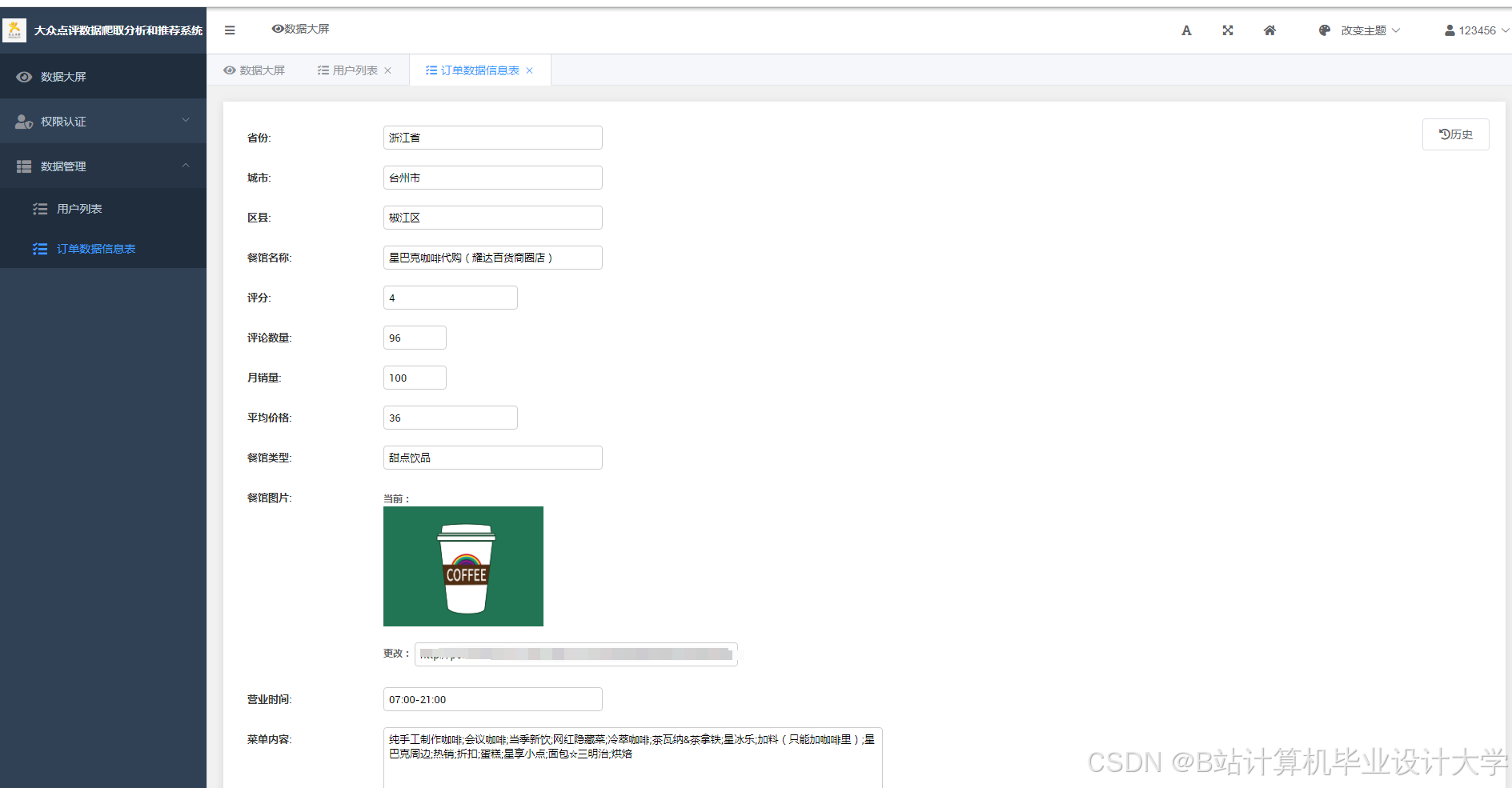

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

928

928

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?