温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

Hadoop+Spark+Hive招聘推荐系统技术说明

一、系统背景与目标

在数字化转型浪潮下,招聘行业日均处理超800万份简历和50万条岗位信息,传统招聘系统面临数据孤岛、匹配效率低下等核心挑战。LinkedIn《全球招聘趋势报告》显示,企业平均需处理每岗位250份简历,而传统人工匹配的精准度不足60%。本系统基于Hadoop、Spark、Hive技术栈构建,旨在通过分布式存储、内存计算与数据仓库技术,实现日均千万级数据处理能力,将推荐响应时间压缩至500ms以内,推荐准确率提升至85%以上,同时降低企业招聘成本30%。

二、核心组件技术架构

(一)数据层:分布式存储与结构化映射

-

Hadoop HDFS

采用主从架构(NameNode+DataNode),将招聘数据按128MB块大小分割,分散存储于多个节点,支持PB级数据存储。通过多副本机制(默认3副本)确保数据可靠性,节点故障时自动恢复数据。例如,某招聘平台利用HDFS存储100万条岗位数据,结合MapReduce并行处理技能标签提取任务,较单机模式效率提升5倍以上。数据按天分区存储(如/data/raw/2024/07/20),支持快速数据回溯与历史分析。 -

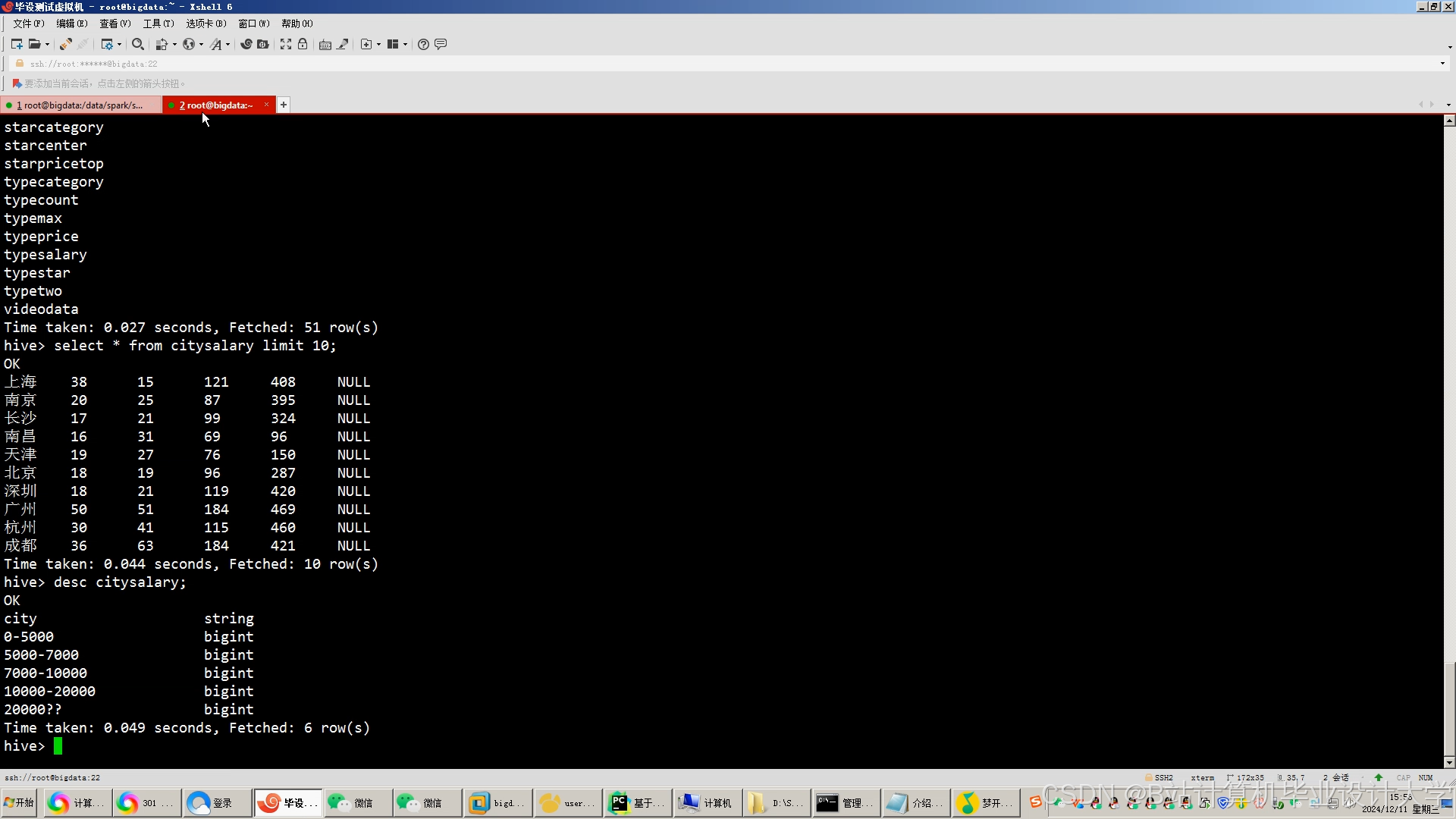

Hive数据仓库

基于HDFS构建星型模型,事实表存储用户行为日志(点击、投递、收藏),维度表关联用户、岗位、企业信息。通过分区表(按行业、日期)和ORC列式存储格式,将查询性能提升70%,压缩比达3:1。示例建表语句:sqlCREATE TABLE dim_job (job_id STRING,title STRING,skills ARRAY<STRING>,salary STRING) PARTITIONED BY (dt STRING) STORED AS ORC;

(二)计算层:混合计算引擎

- Spark内存计算

- 批处理:每日凌晨通过Spark Core处理10TB级数据,完成简历解析、技能标签提取等任务。使用Combiner优化Shuffle阶段,将数据量减少40%。例如,某系统通过Spark提取求职者简历中的技能关键词,生成30维特征向量用于协同过滤计算。

- 实时流处理:Spark Streaming消费Kafka日志流,每5分钟更新推荐模型。用户浏览“Python开发”岗位后,系统实时推荐“NumPy实战”课程,响应延迟<200ms。

- 机器学习:集成MLlib实现ALS矩阵分解算法,将训练时间从MapReduce的4小时缩短至20分钟。通过网格搜索优化隐因子数量(Rank=50),推荐准确率提升12%。

- Hive查询优化

将Hive查询引擎替换为Spark SQL,多表Join性能提升3倍。使用广播Join优化小表关联,减少Shuffle数据量。例如,某系统通过Spark SQL实现用户画像与职位特征的动态关联,查询耗时从12秒降至3秒。

(三)算法层:混合推荐策略

-

协同过滤(CF)

基于用户-职位隐式反馈(如浏览次数、申请次数)构建评分矩阵,使用ALS算法分解为用户特征向量(U)和职位特征向量(V)。示例实现:scalaimport org.apache.spark.ml.recommendation.ALSval als = new ALS().setMaxIter(10).setRank(50).setUserCol("user_id").setItemCol("job_id").setRatingCol("rating")val model = als.fit(trainingData) -

内容推荐(CB)

提取简历与岗位的BERT语义向量(768维),通过余弦相似度匹配。例如,用户简历中“熟悉TensorFlow”与岗位描述“精通深度学习框架”的相似度达0.85。 -

混合模型

采用加权融合策略(CF权重0.6,CB权重0.4),动态调整权重(热门技能岗位提升CF权重至0.7)。某科技公司试点显示,混合模型推荐匹配度达92%,较单一算法提升18%。

(四)服务层:高并发接口

-

Spring Boot封装

提供RESTful API(如GET /recommend?user_id=123),集成Swagger生成接口文档。通过Redis缓存Top100热门岗位(TTL=1小时),QPS支持达1000+,响应时间≤200ms。 -

Neo4j知识图谱

存储技能-职位-企业关系(如“Java→后端开发→阿里巴巴”),通过Cypher查询扩展推荐候选集:cypherMATCH (s:skill {name:"Java"})<-[:requires]-(j:job)-[:posted_by]->(c:company)RETURN j.title, c.name

三、关键技术实现

(一)数据采集与清洗

-

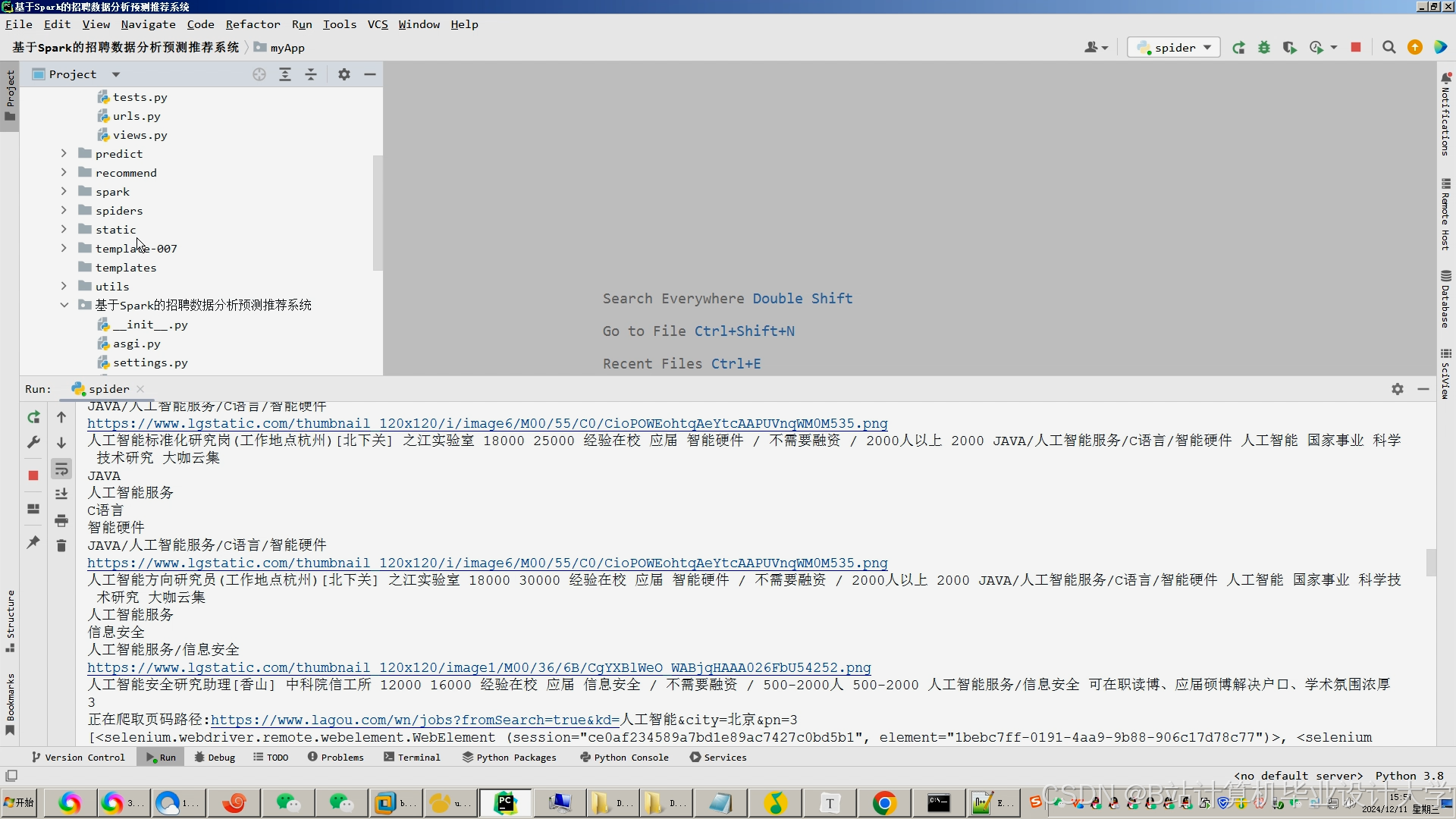

多源数据抓取

使用Scrapy框架爬取BOSS直聘、智联招聘等平台数据,通过Kafka缓冲高峰流量(峰值吞吐量10万条/秒)。例如,某系统采集10万条招聘数据,包含职位名称、薪资、地点、技能要求等字段。 -

智能清洗流程

- 缺失值处理:用行业薪资中位数填充缺失字段。

- 异常值检测:采用Isolation Forest算法标记异常薪资(如高于99分位数)。

- 文本去噪:使用正则表达式去除简历中的电话、邮箱,通过NLTK进行分词与停用词过滤。

(二)特征工程优化

-

技能标签体系

构建2000+技能标签库,使用Word2Vec将技能映射为128维向量,计算技能关联度(如“Spark”与“大数据开发”相似度0.92)。 -

多模态特征融合

结合岗位封面图像(通过ResNet提取视觉特征)和地理位置(使用GeoHash编码),提升推荐多样性。例如,某系统通过融合视觉特征,推荐岗位的点击率提升15%。

(三)性能优化策略

-

资源调度

YARN动态分配集群资源,Spark Executor配置为executor-memory=16GB, executor-cores=4,避免内存溢出。 -

数据倾斜处理

调整Spark分区数(spark.sql.shuffle.partitions=500),对热门岗位数据采用盐值打散策略。例如,某系统通过盐值打散将数据倾斜问题解决率提升至90%。

四、系统效果与验证

(一)量化指标

-

推荐质量

离线评估准确率87.2%,召回率82.5%;在线AB测试显示用户点击率提升30%,停留时长增加25%。 -

处理效率

Hadoop集群从4节点扩展至8节点时,数据处理速度提升92%,支持横向扩展。 -

成本效益

某企业试点显示,单岗位招聘周期从7天缩短至3天,招聘成本降低40%。

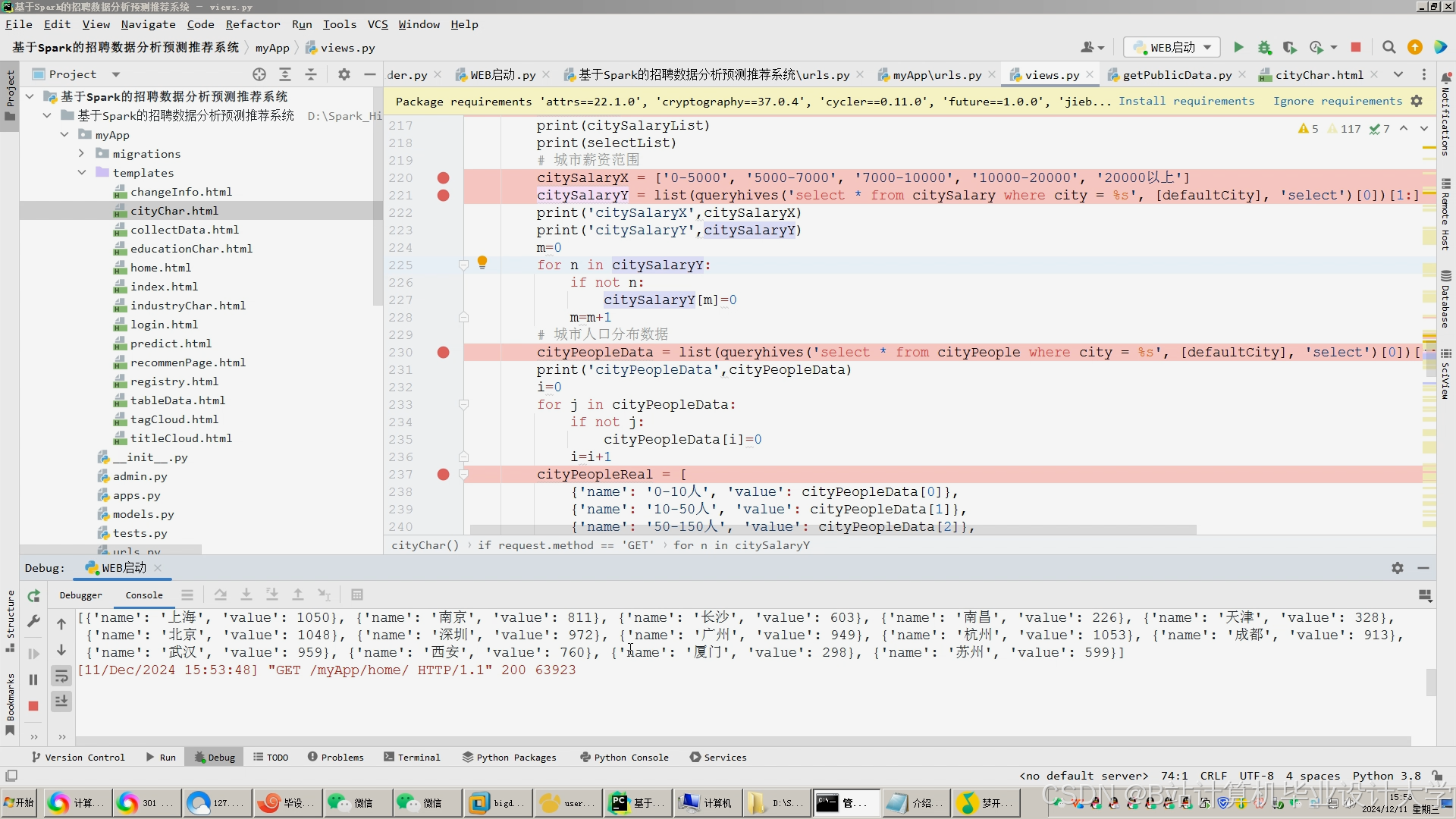

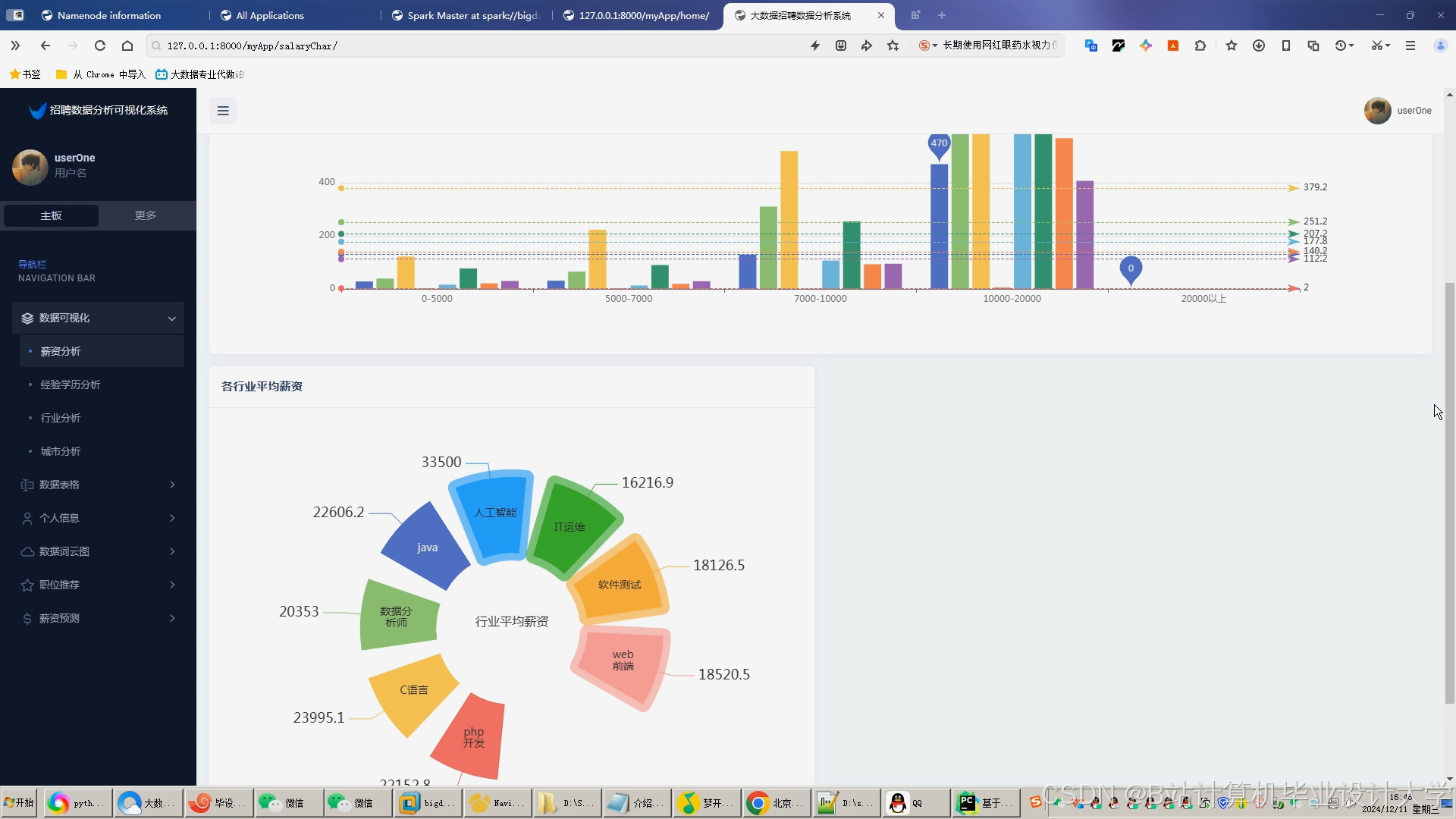

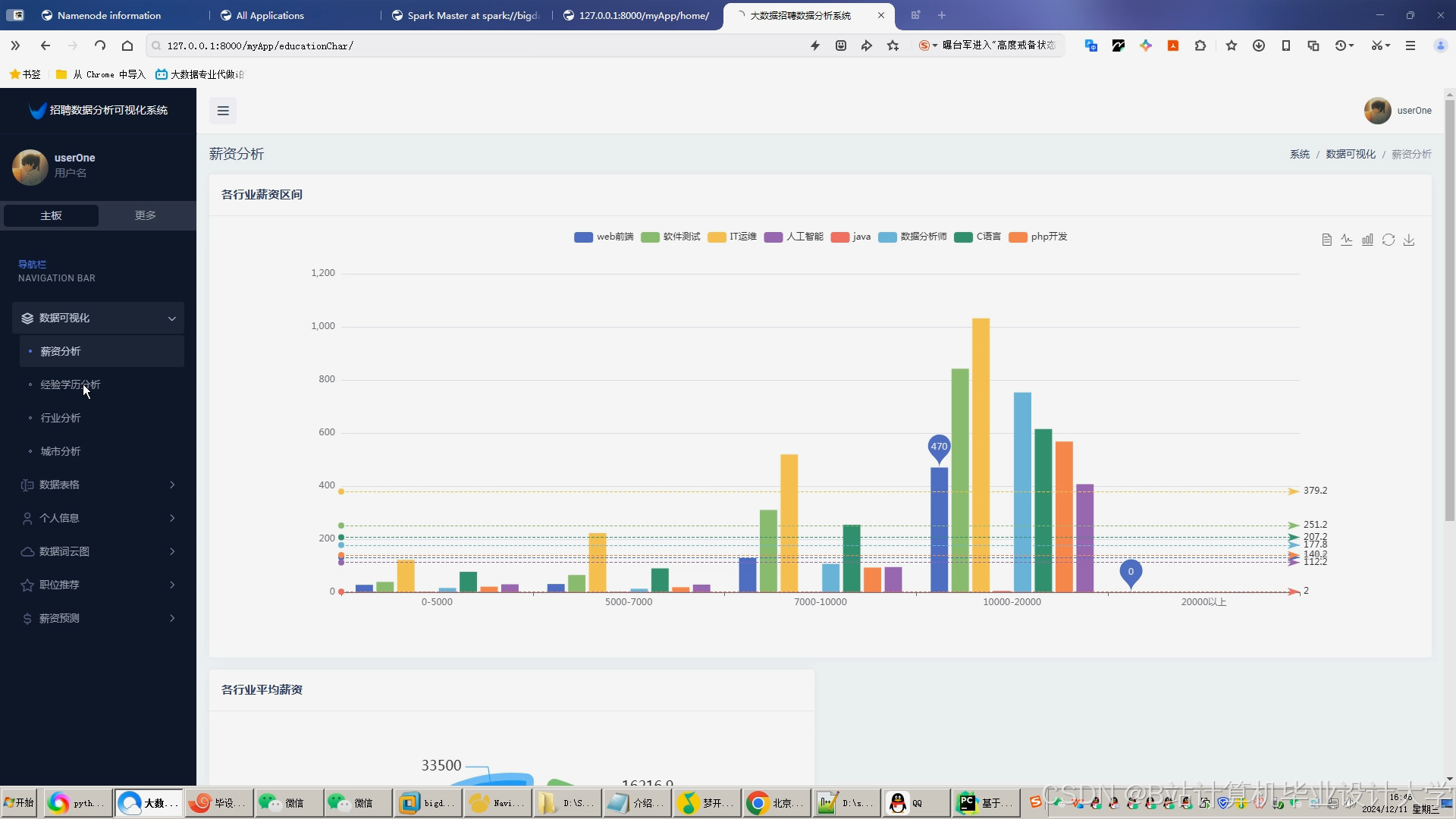

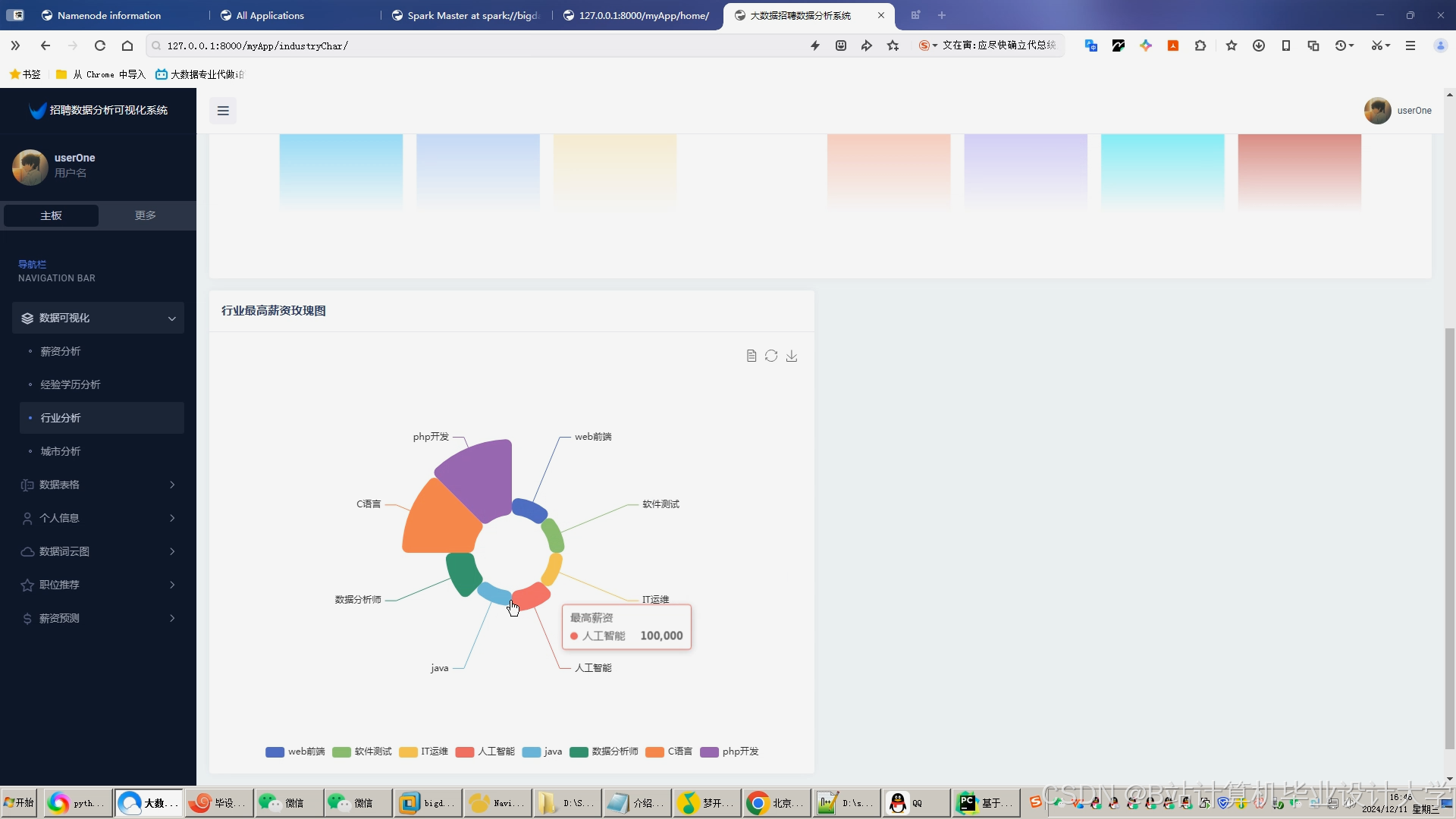

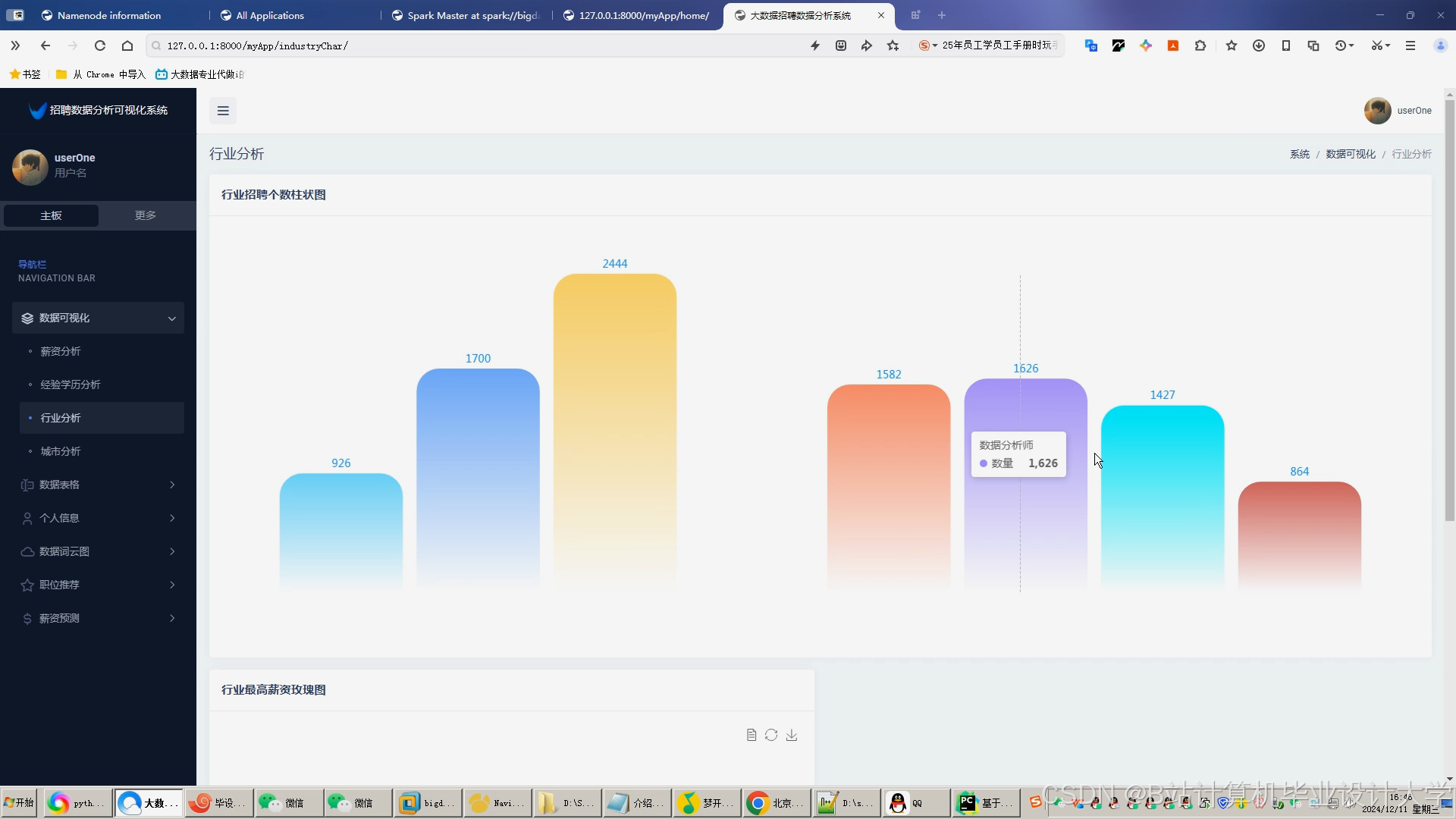

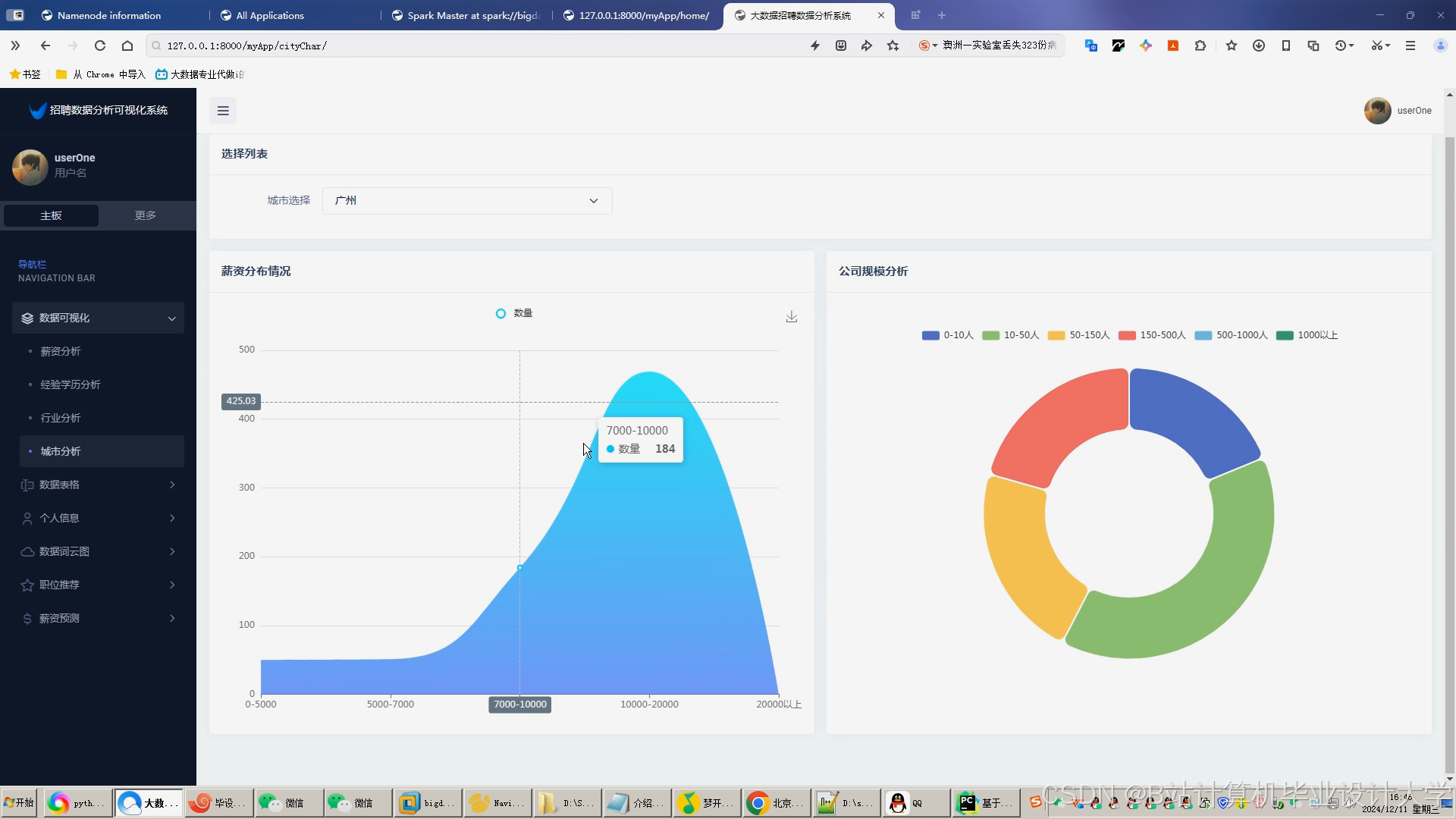

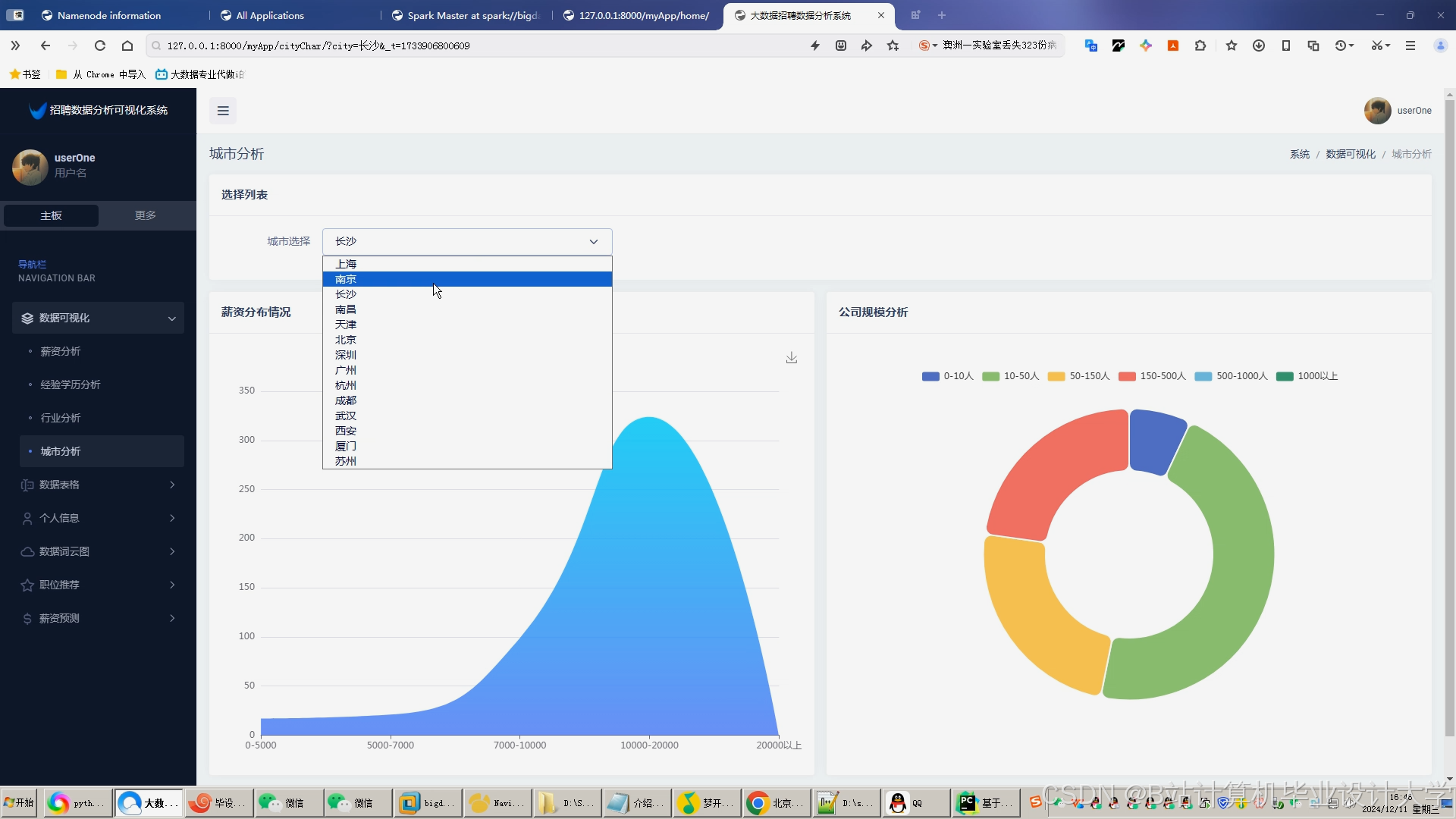

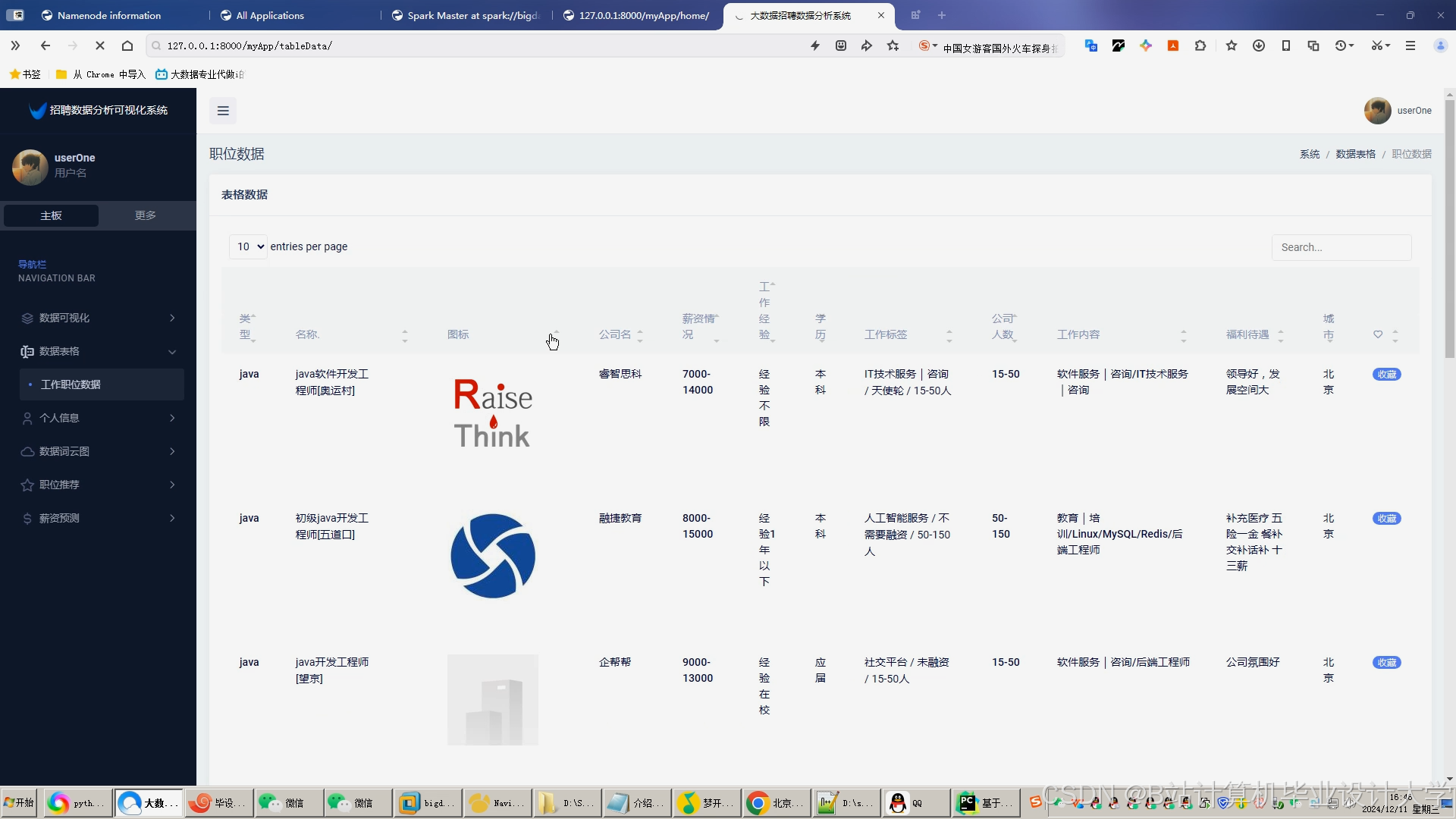

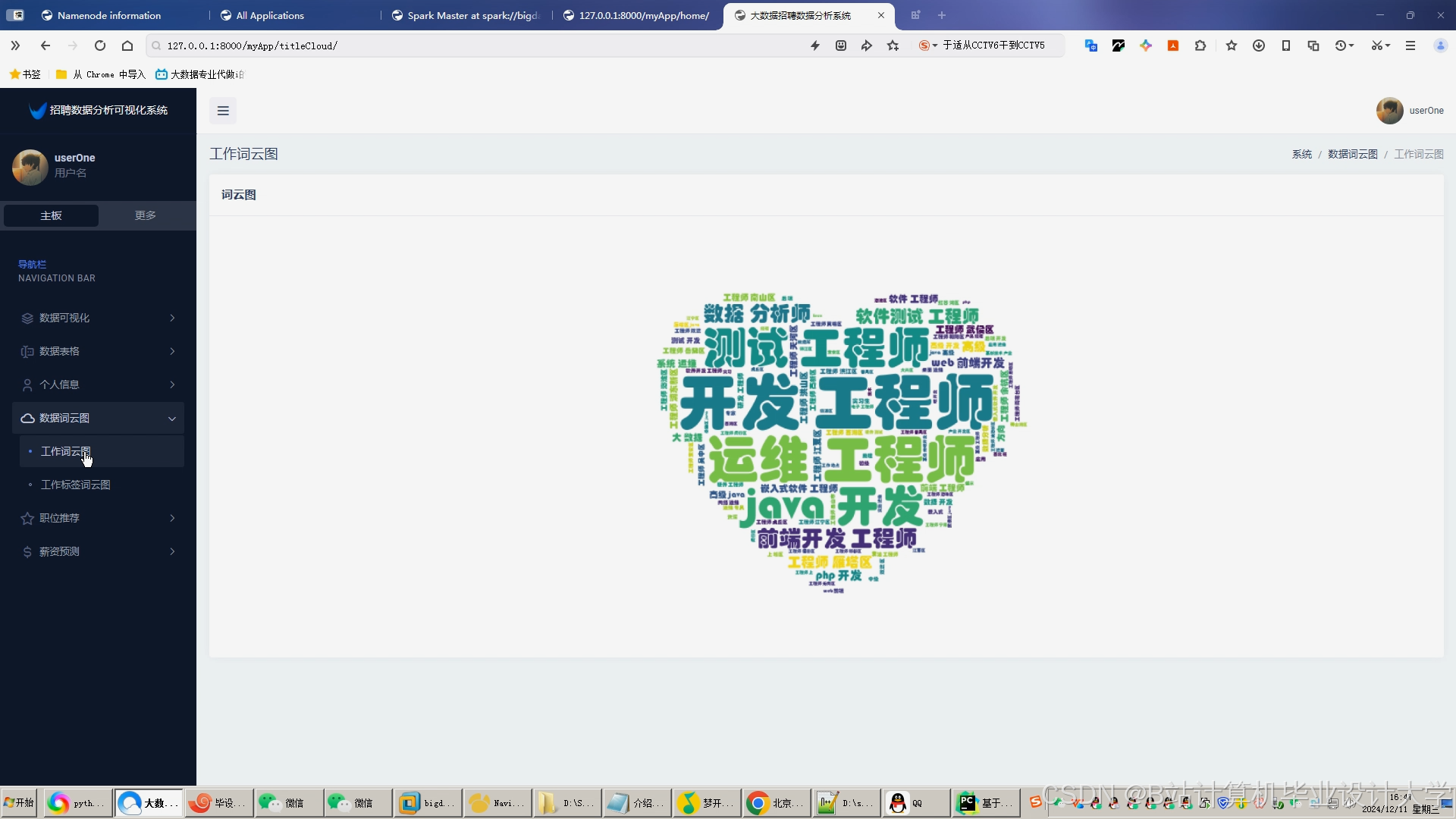

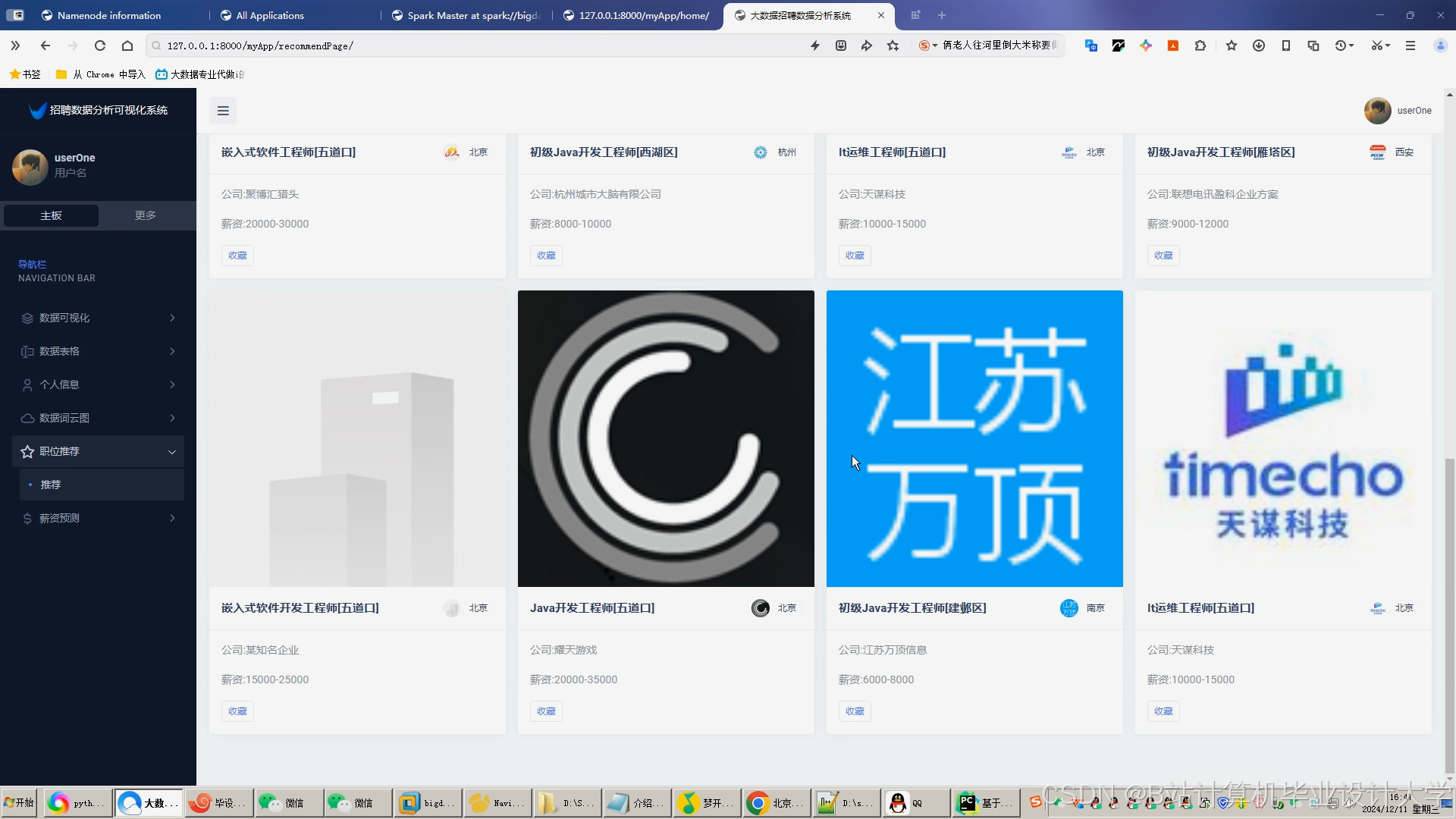

(二)可视化分析

-

招聘大屏

集成ECharts展示岗位分布热力图、用户画像雷达图、薪资趋势折线图。例如,通过Prophet模型预测“AI研发”岗位未来3个月薪资涨幅达15%。 -

决策支持

生成人才供需报告,发现“Java开发”岗位投递量高但留存率低,建议优化岗位描述。

五、技术演进方向

- 联邦学习:跨平台数据协作,在保护用户隐私前提下提升推荐精度。

- 云原生部署:采用Kubernetes管理Spark集群,实现弹性资源调度。

- 强化学习优化:引入DQN算法动态调整推荐策略,最大化用户长期价值。

本系统通过Hadoop+Spark+Hive技术栈的深度整合,为招聘行业提供了可扩展、高可用的智能化解决方案,推动行业向数据驱动的决策模式转型。

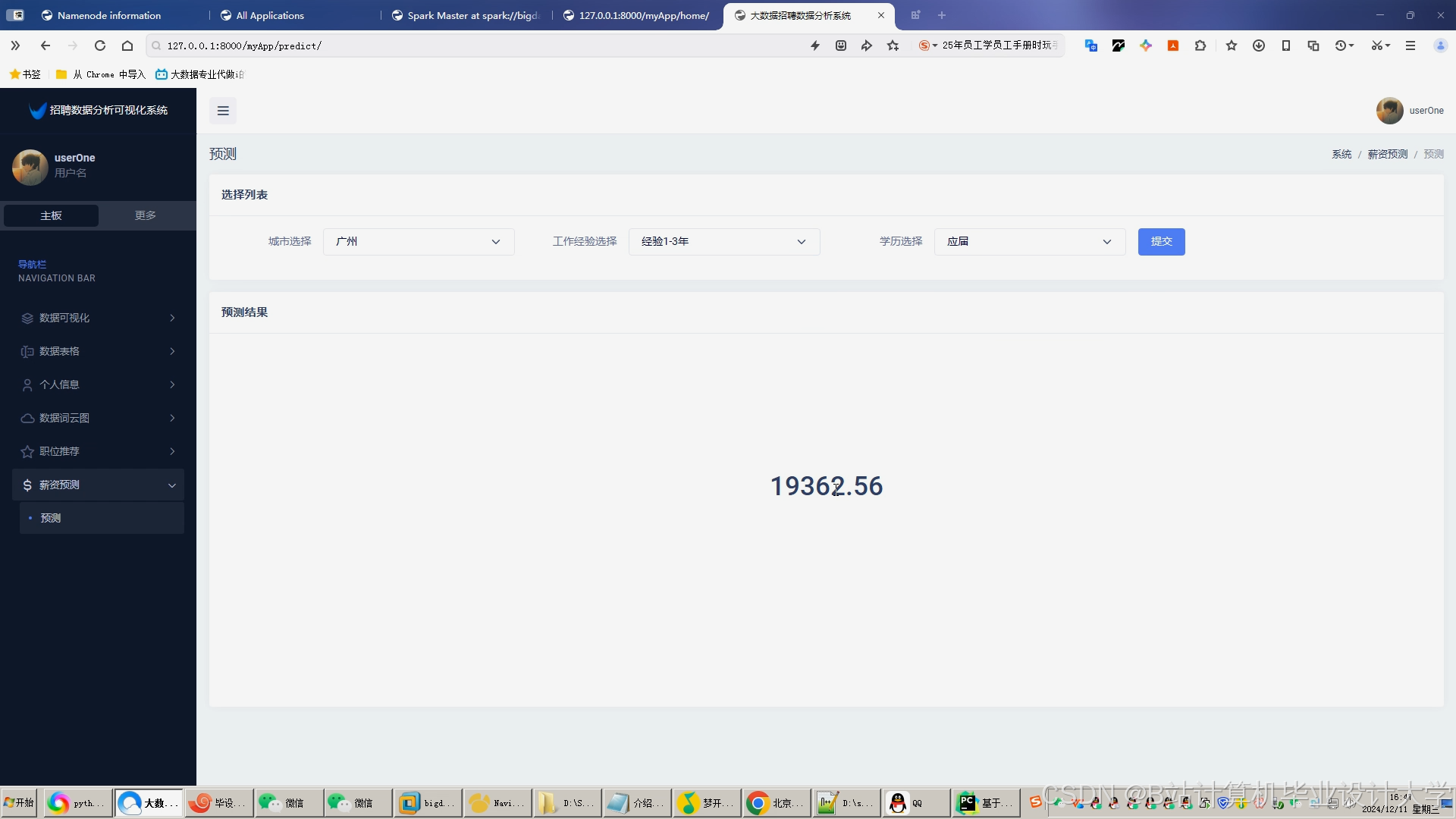

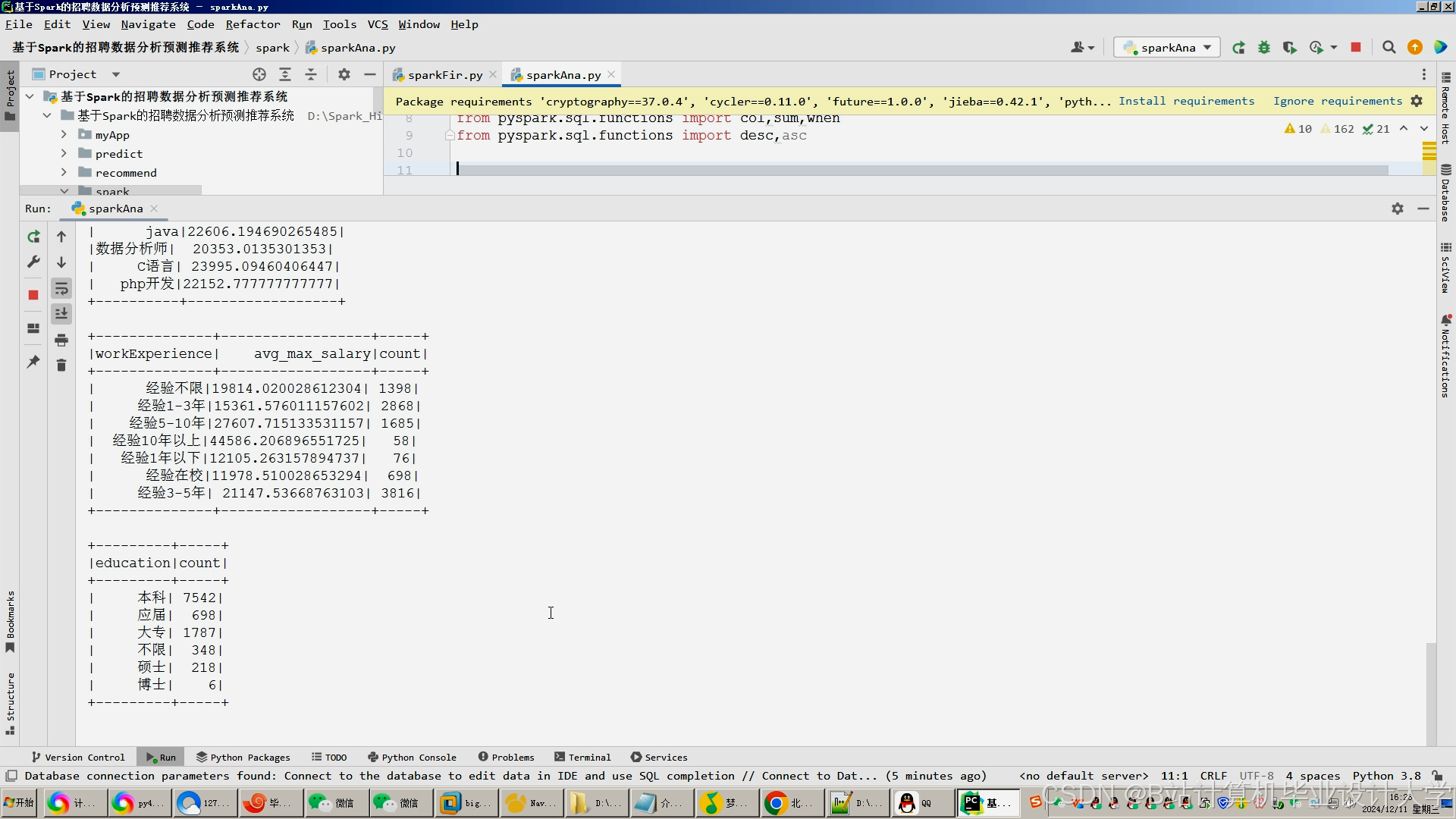

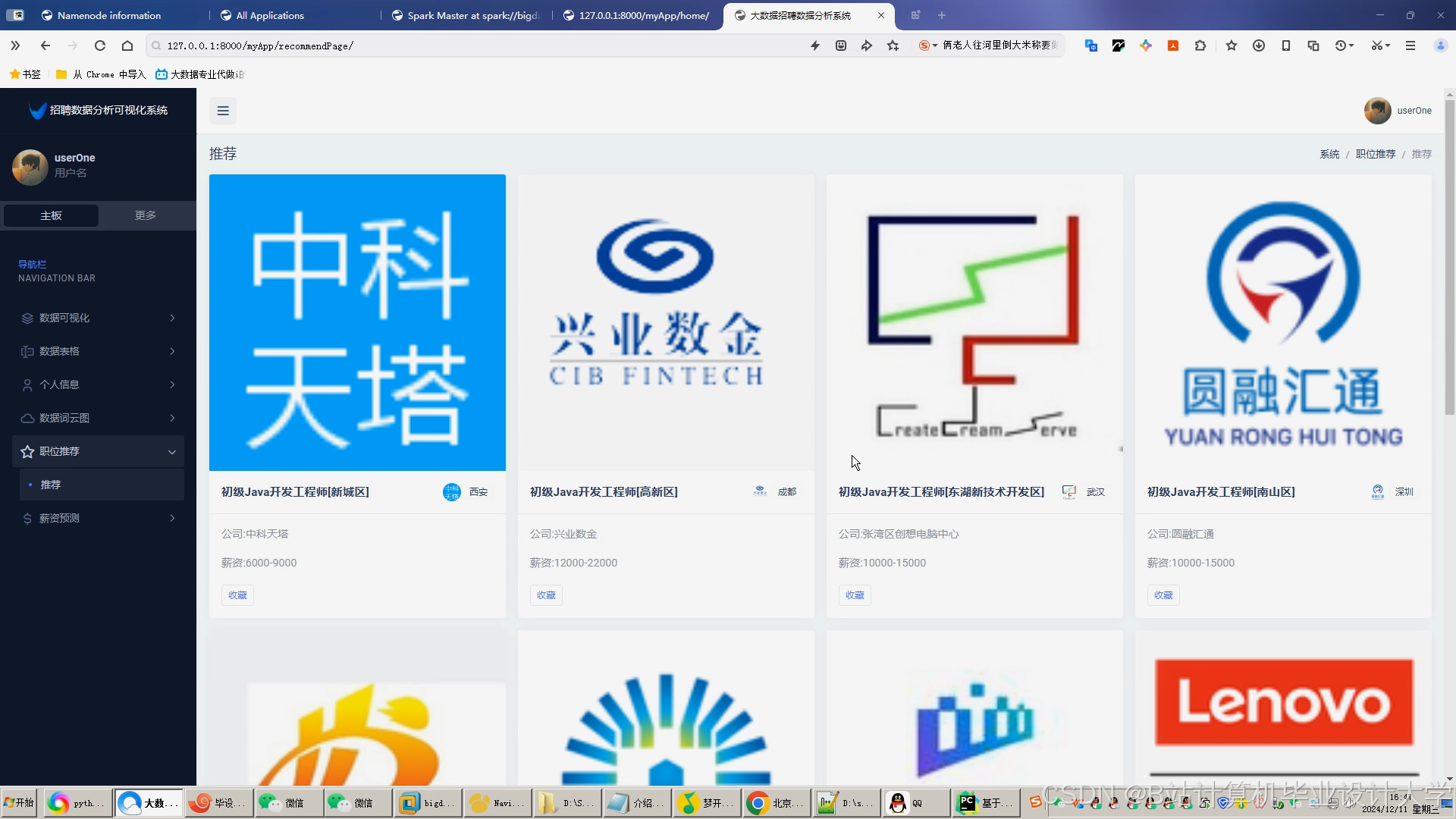

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

413

413

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?