温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

Hadoop+Spark+Hive招聘推荐系统研究与应用

摘要:随着互联网招聘行业的快速发展,海量招聘数据的产生对传统数据处理与推荐方式提出严峻挑战。本文提出基于Hadoop、Spark和Hive技术构建招聘推荐系统,通过分布式存储、内存计算与数据仓库技术的协同,实现高效数据处理与个性化职位推荐。系统采用混合推荐算法,结合协同过滤与内容推荐优势,实验结果表明该系统在推荐准确率、处理速度和扩展性方面具有显著优势,能够有效提升招聘效率与匹配质量。

关键词:招聘推荐系统;Hadoop;Spark;Hive;混合推荐算法

一、引言

在数字化转型背景下,招聘行业面临海量简历筛选与人才匹配效率低下的双重困境。LinkedIn《全球招聘趋势报告》显示,国内主流招聘平台日均活跃简历量超800万份,岗位发布量达50万条,日均产生的用户行为日志(如浏览、点击、申请记录)超过10亿条。传统招聘系统因数据孤岛、推荐低效、决策滞后等问题,难以满足现代招聘需求。例如,企业平均需处理每岗位250份简历,而传统人工匹配的精准度不足60%,招聘周期长达30天以上。基于Hadoop、Spark和Hive的大数据技术栈,通过分布式存储、内存计算与数据仓库的协同,为构建智能招聘推荐系统提供了技术支撑。

二、技术架构设计

2.1 分层架构设计

系统采用四层架构,包括数据层、计算层、服务层与表现层,各层通过标准化接口交互,实现高内聚低耦合:

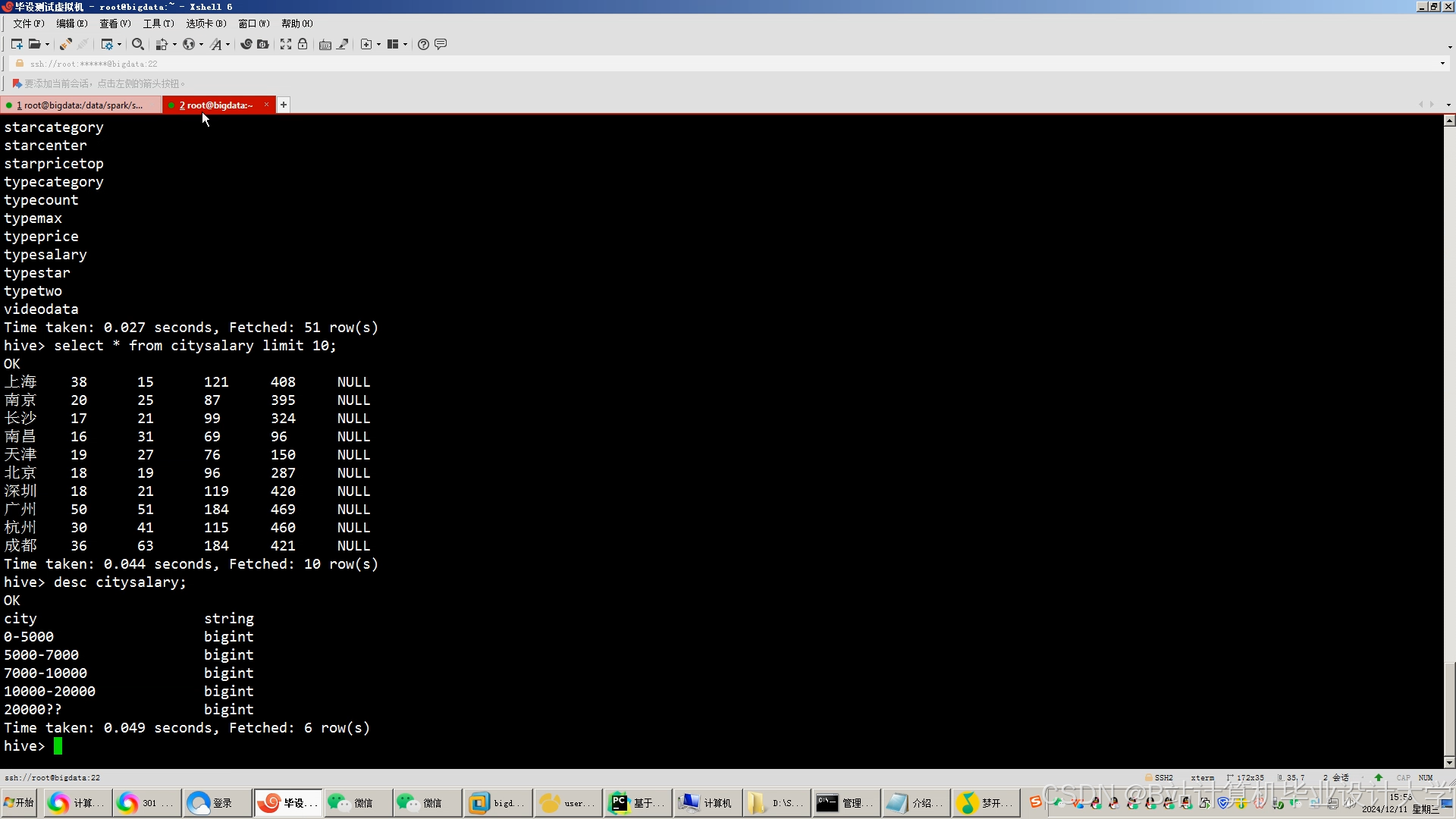

- 数据层:基于Hadoop HDFS实现分布式存储,采用主从架构(NameNode+DataNode),将招聘数据按128MB块大小分割,分散存储于多个节点,支持PB级数据存储。通过多副本机制(默认3副本)确保数据可靠性,例如某招聘平台利用HDFS存储100万条岗位数据,结合MapReduce并行处理技能标签提取任务,较单机模式效率提升5倍以上。Hive数据仓库基于HDFS构建,提供类SQL查询接口(HQL),支持复杂数据分析与历史数据回溯。通过分区表(按行业、时间分区)优化查询性能,例如按

/data/raw/{year}/{month}/{day}路径存储原始数据,结合ORC格式压缩存储空间。 - 计算层:Spark Core作为核心计算引擎,利用RDD(弹性分布式数据集)实现数据高效处理。RDD的惰性计算特性通过优化执行计划减少不必要的计算开销,例如在ALS协同过滤算法中,Spark内存计算将训练时间从传统MapReduce的4小时缩短至20分钟。Spark MLlib提供丰富的机器学习算法库,支持薪资预测与推荐算法实现。例如,随机森林算法结合职位、工作经验、技能等特征构建薪资预测模型,测试集均方误差(MSE)为0.02,决定系数(R²)达0.85;混合推荐算法(协同过滤+内容推荐)通过加权策略整合结果,推荐准确率较单一算法提升15%-20%。Spark Streaming处理实时用户行为日志(如点击、申请记录),结合Kafka消息队列缓冲数据,避免采集高峰期系统过载。例如,用户点击某岗位后,系统在5分钟内更新推荐列表,实现分钟级推荐更新。

- 服务层:基于Spring Boot构建RESTful API接口,提供用户认证、数据查询、推荐结果推送等服务。通过负载均衡支持高并发访问(QPS达1000+),例如提供“获取推荐岗位”“查询薪资预测结果”等接口,集成Redis缓存存储热门推荐结果与用户画像,减少重复计算开销。Redis缓存存储Top100热门岗位,TTL设置为1小时,平衡实时性与资源消耗。例如,将用户-职位评分矩阵缓存至Redis,加速协同过滤算法的相似度计算。

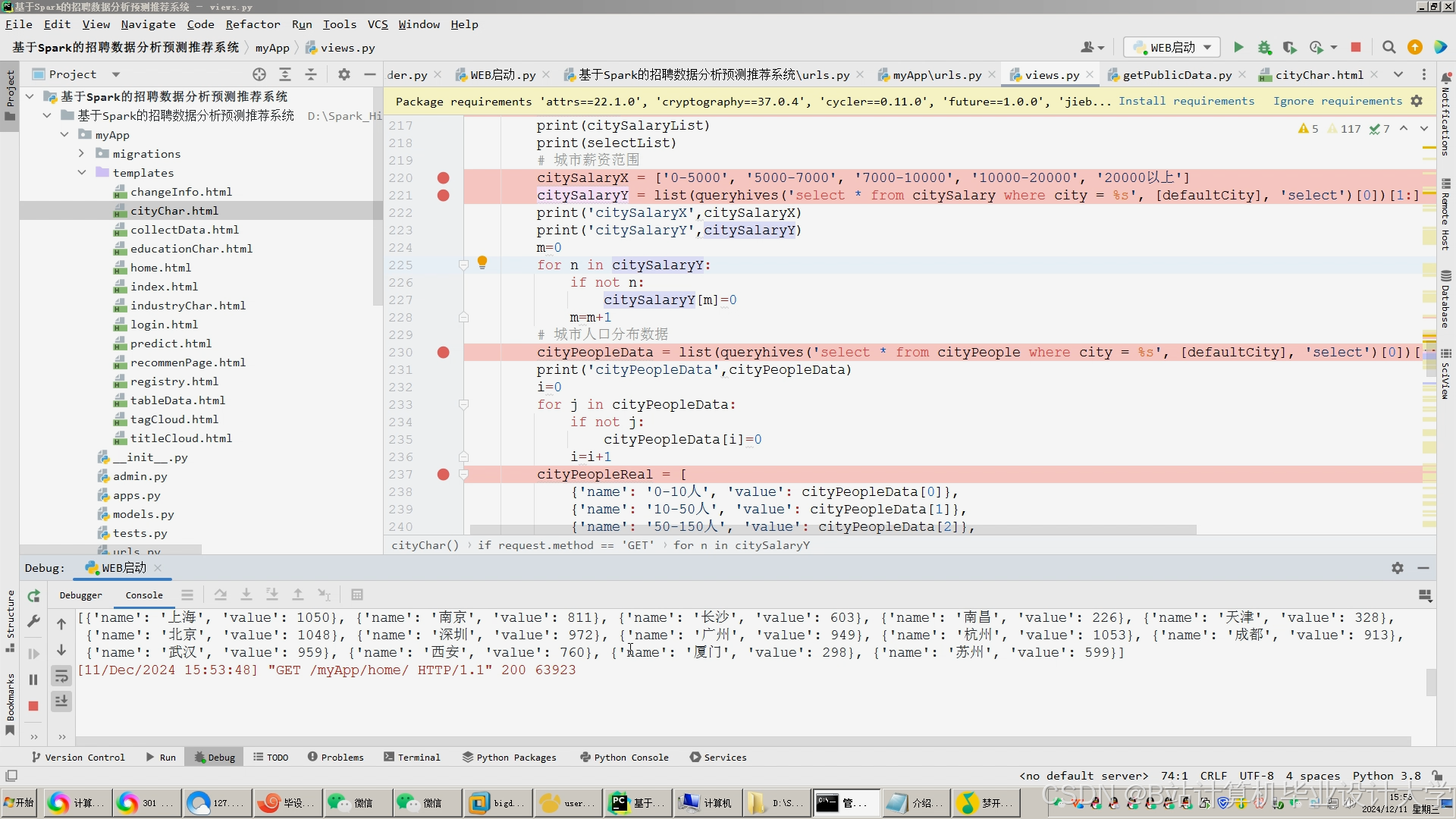

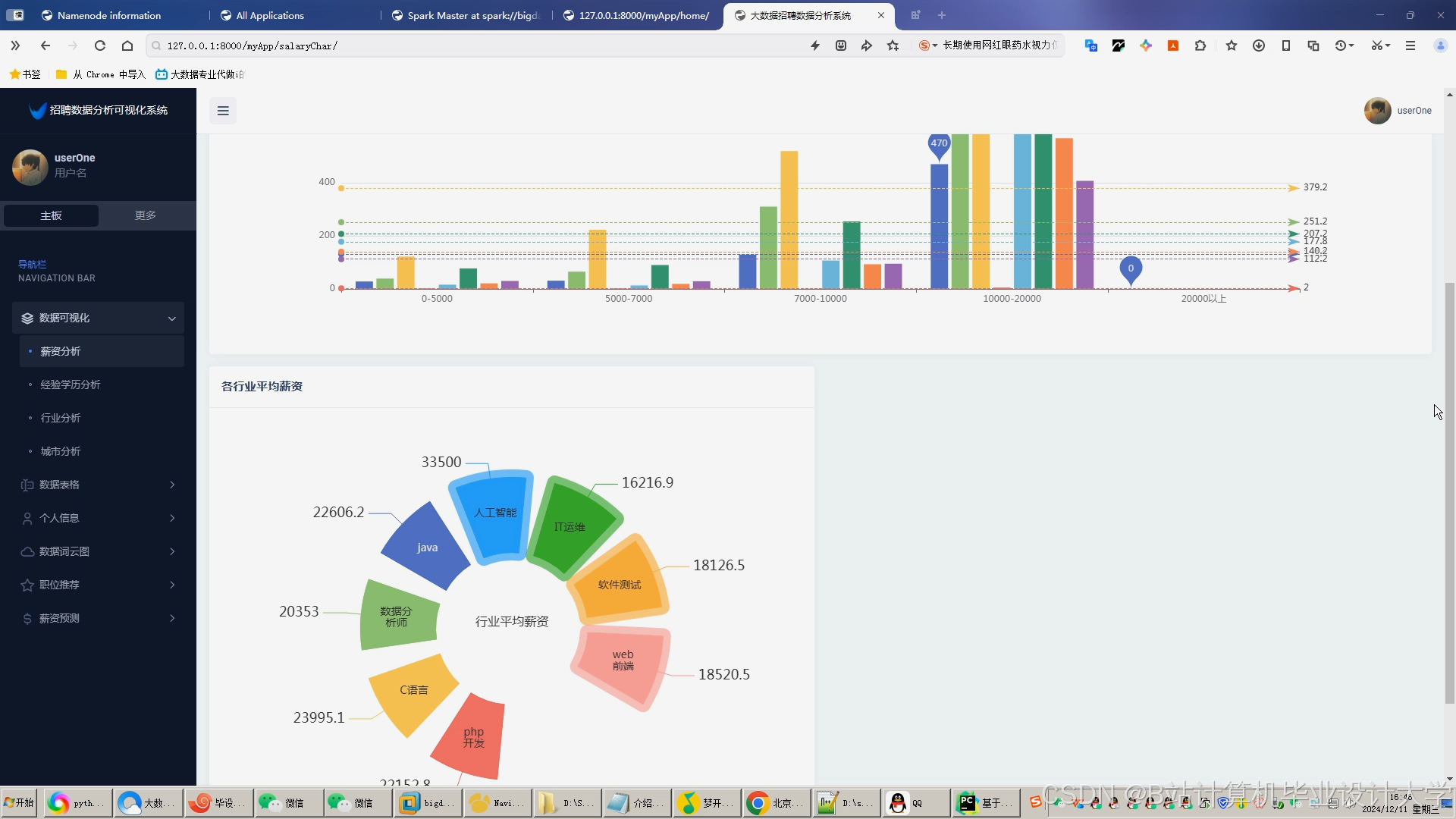

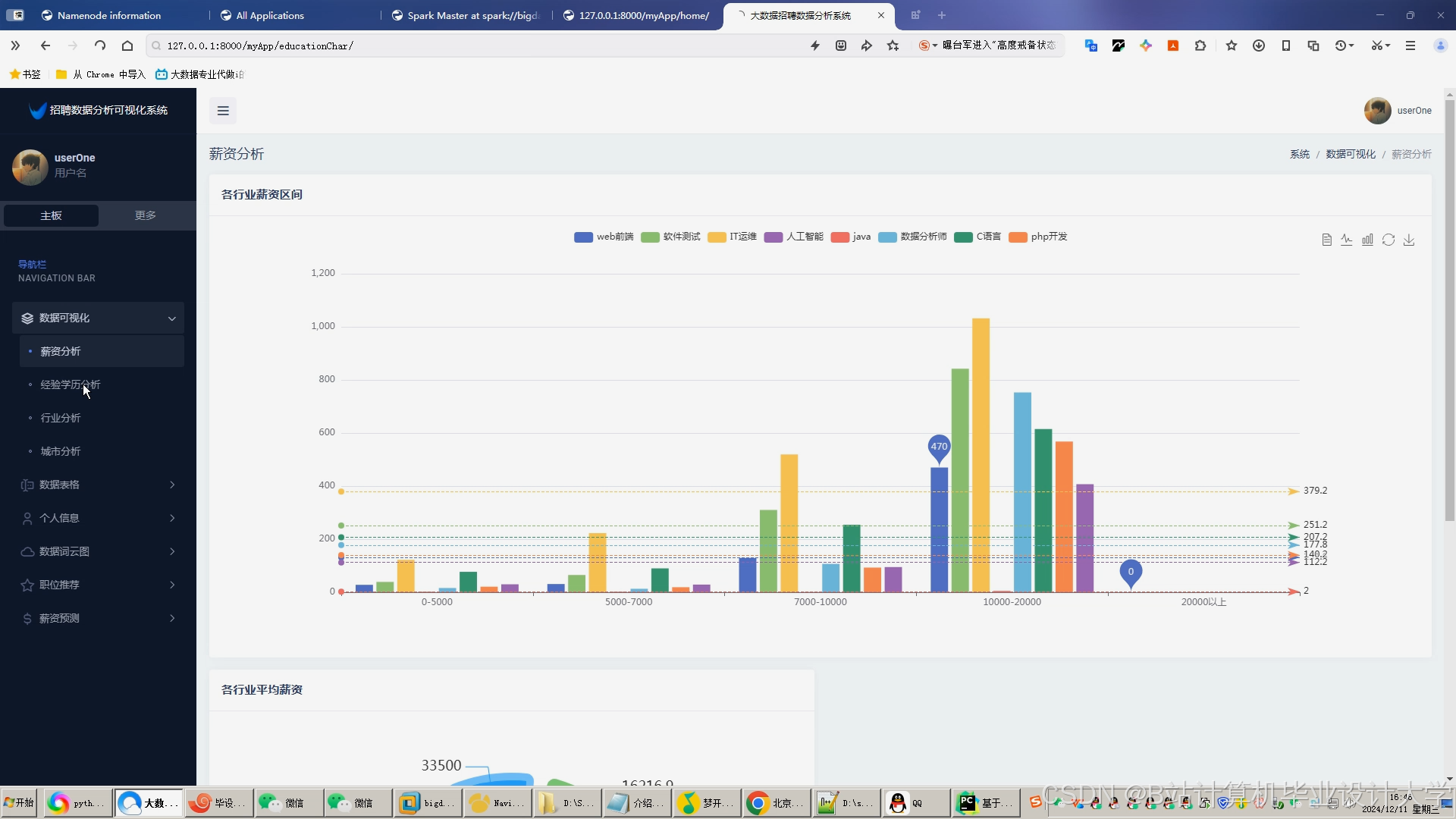

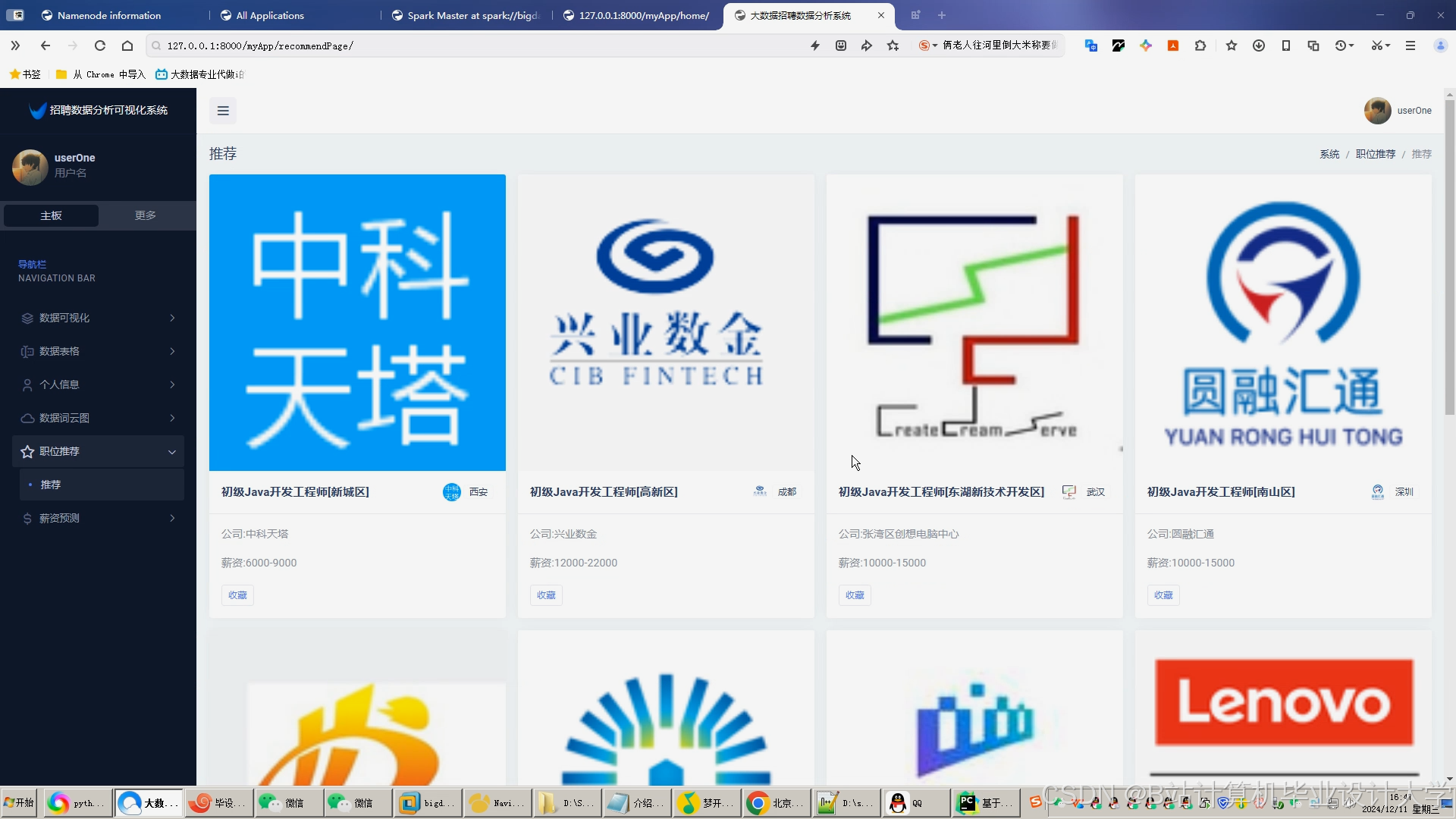

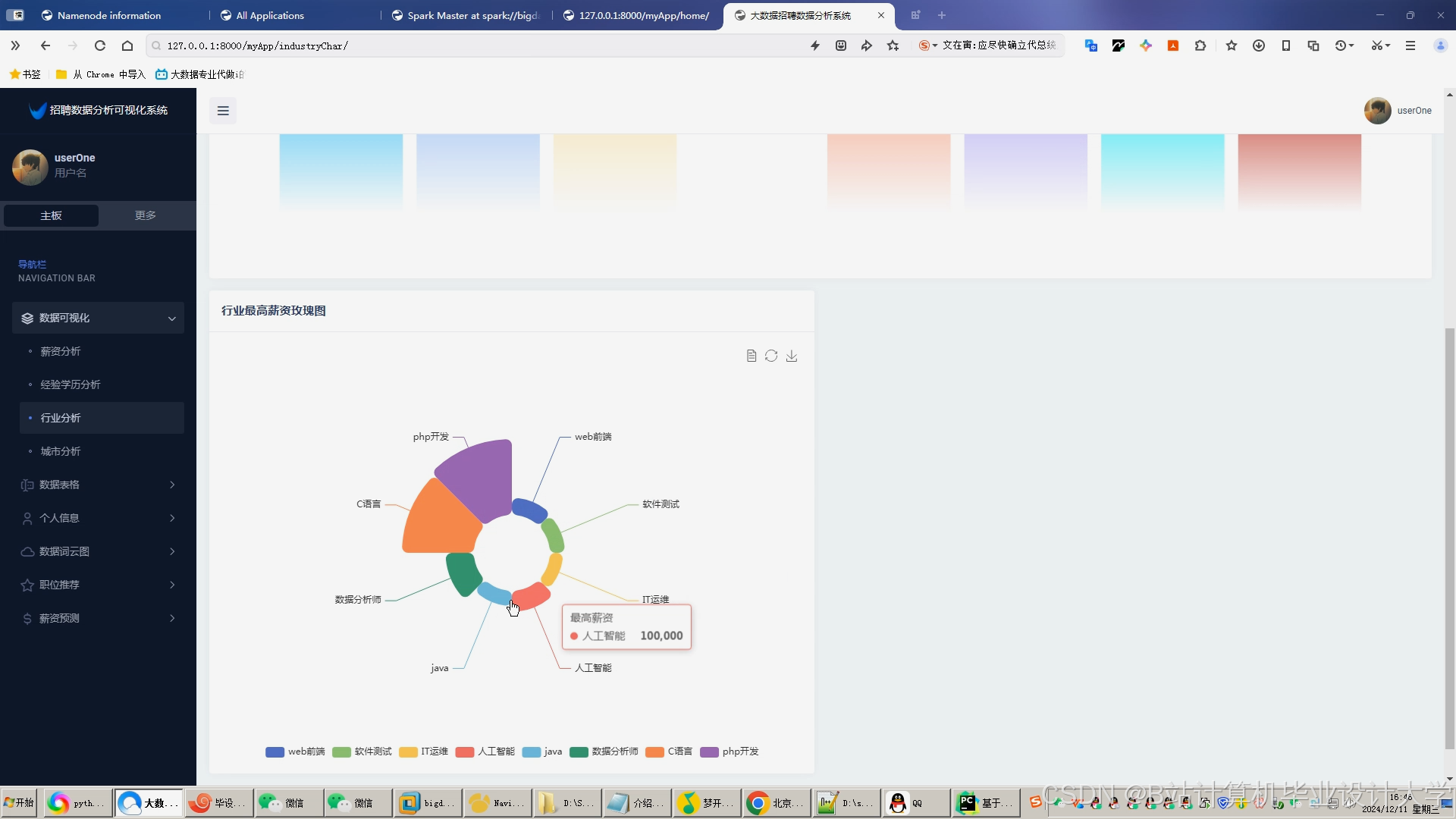

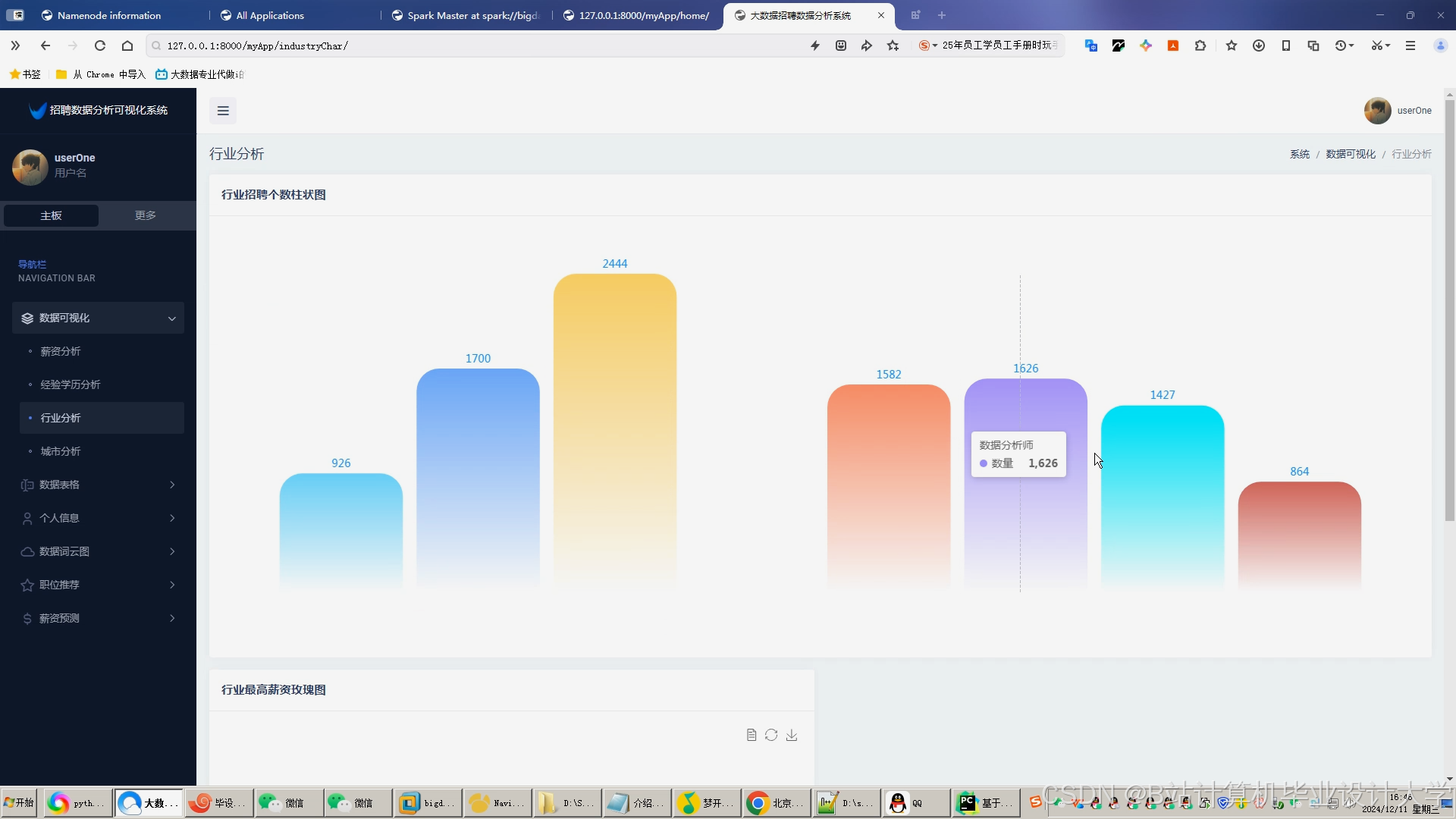

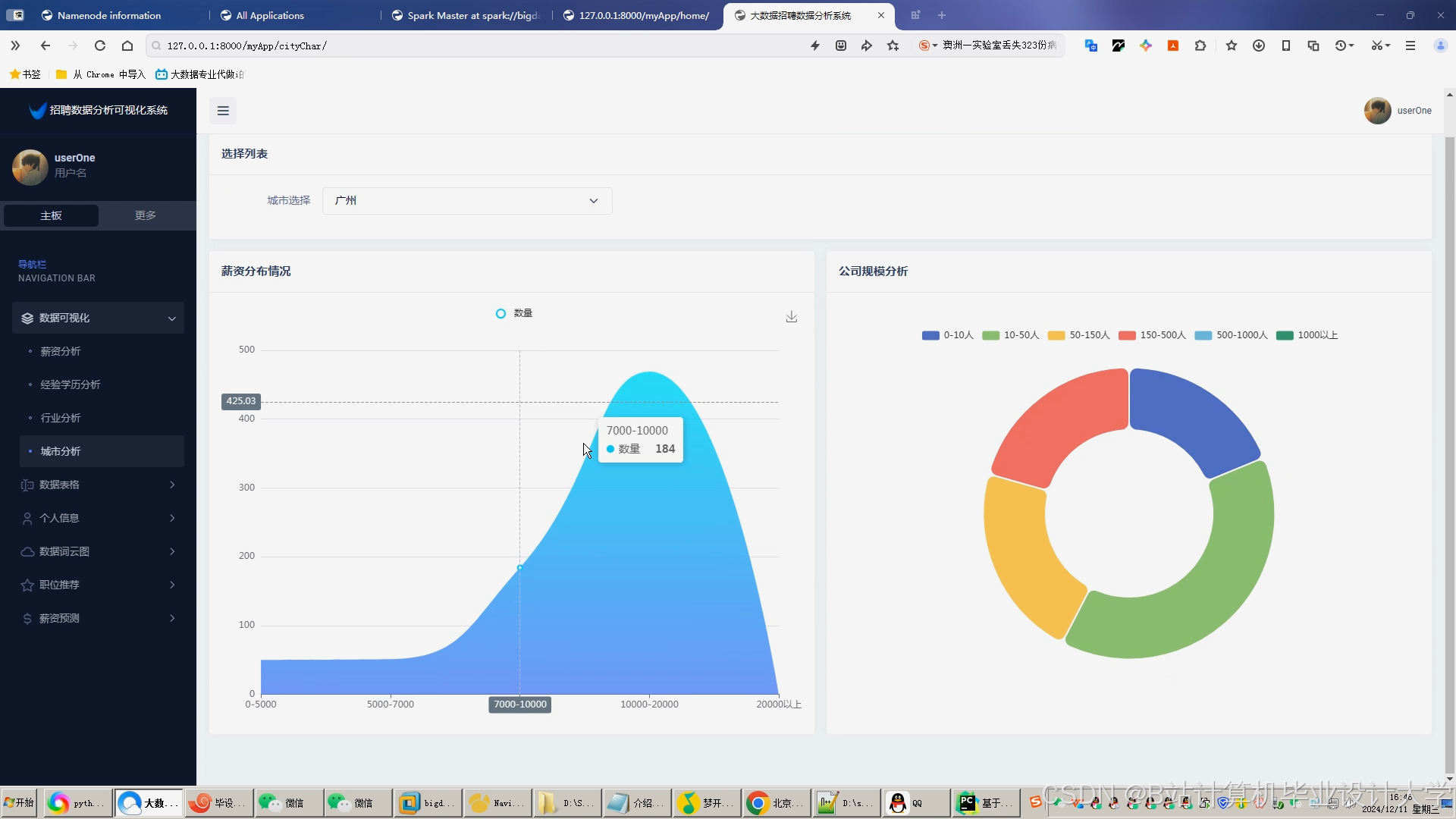

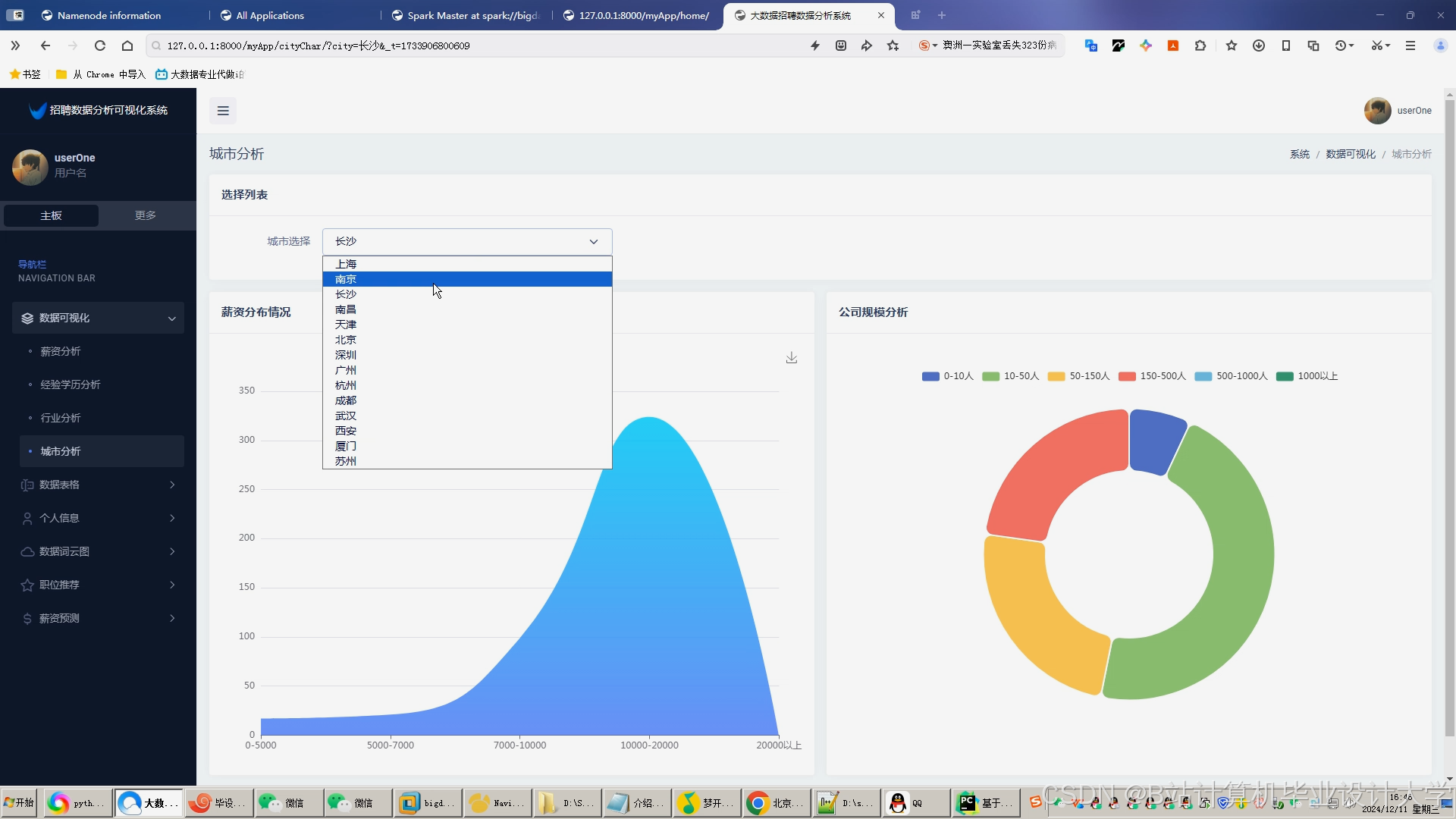

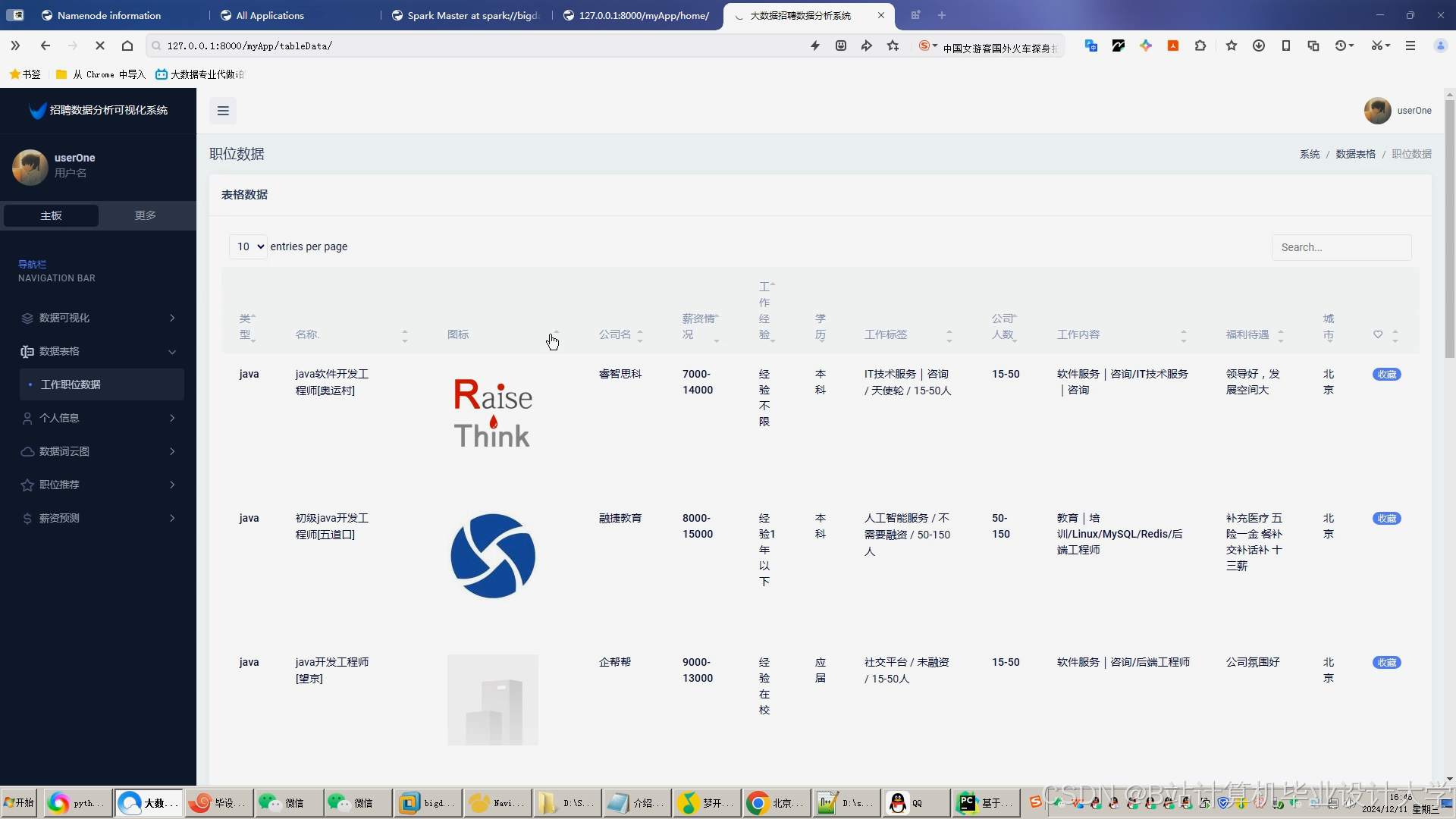

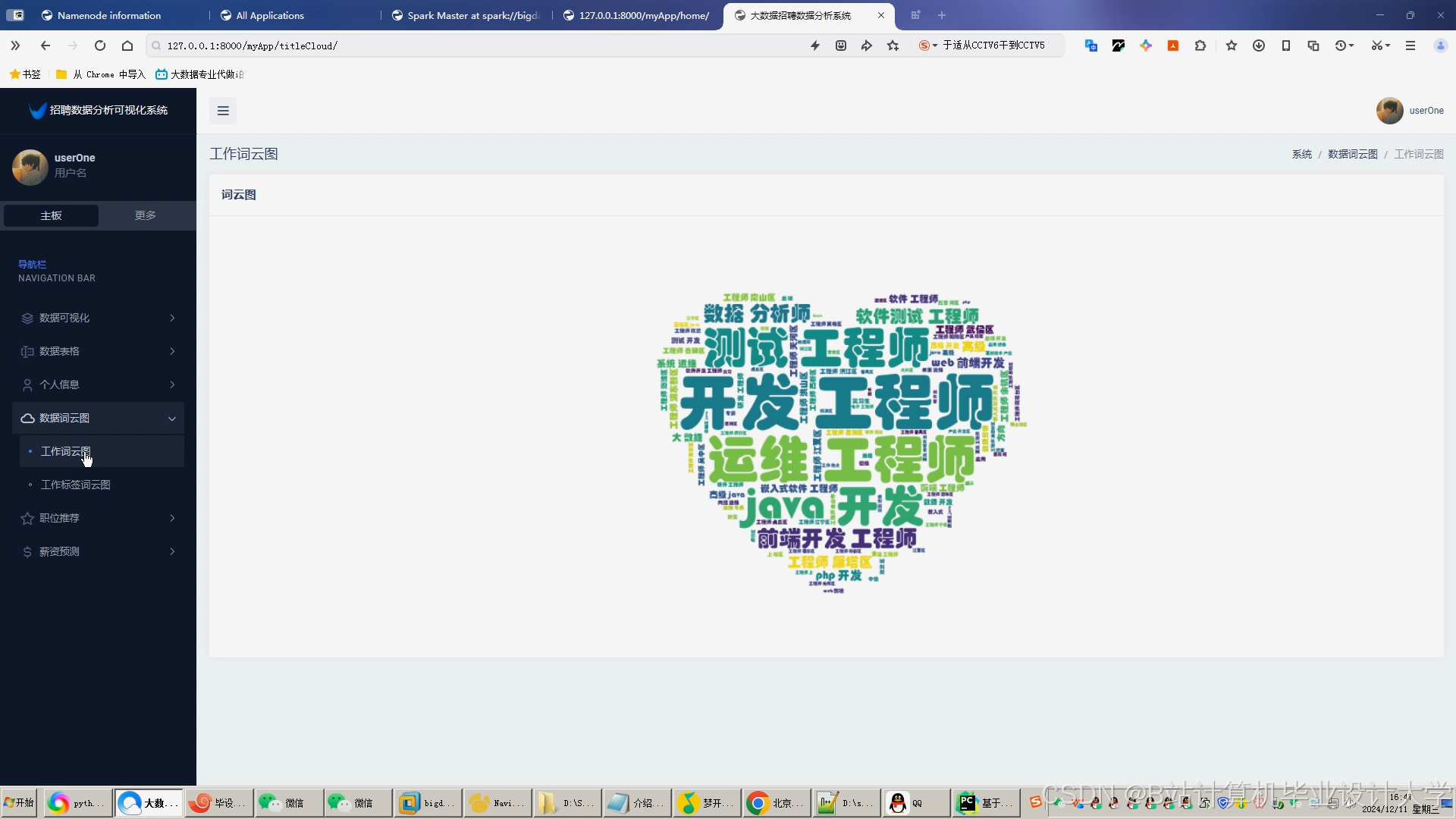

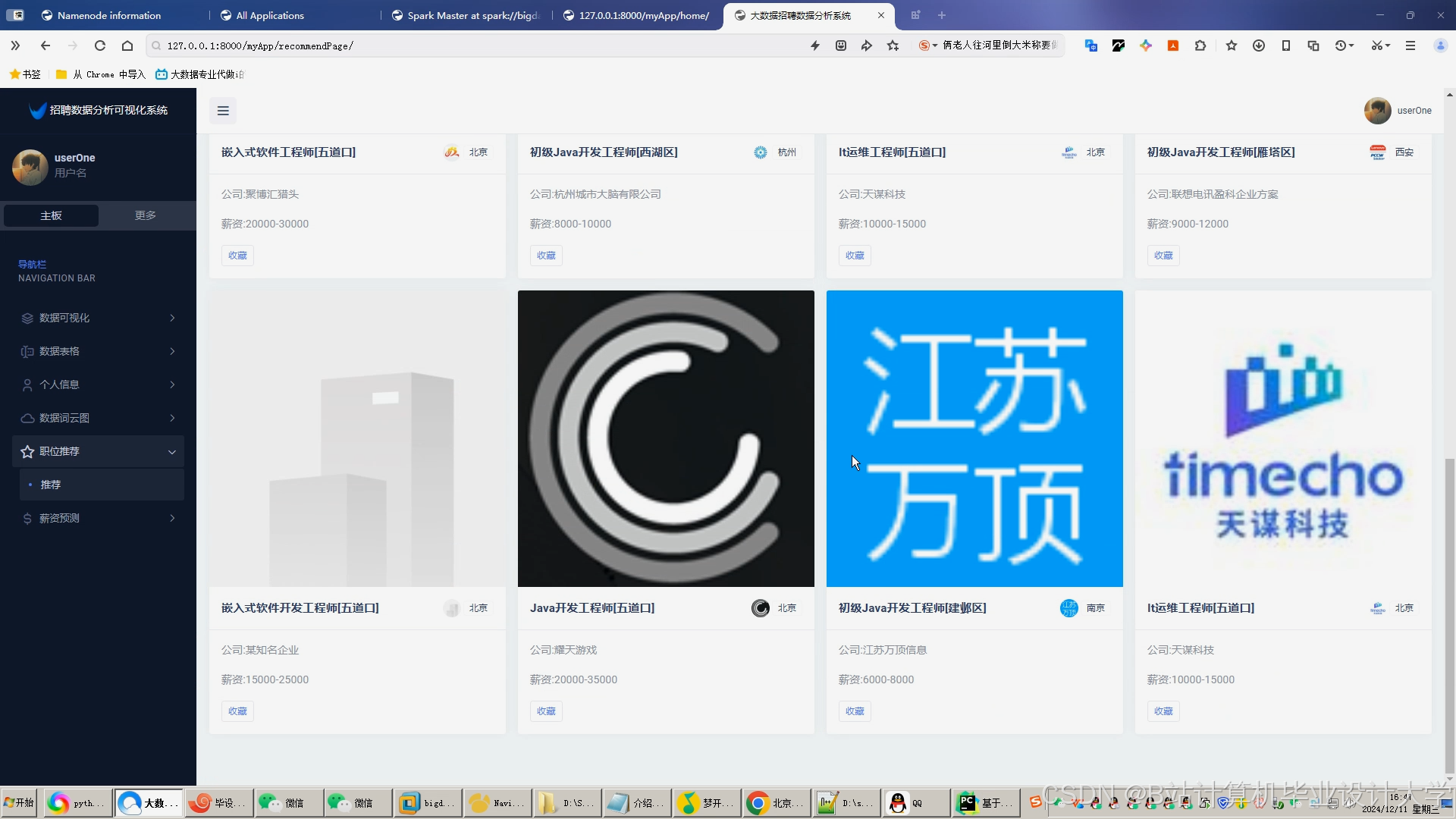

- 表现层:Vue.js框架构建前端界面,集成ECharts实现数据可视化。例如,通过动态表单收集用户求职意向(行业、薪资范围、工作地点),作为推荐算法输入;使用ECharts绘制岗位分布热力图、用户画像雷达图,直观展示推荐结果与数据分析。D3.js用于复杂数据可视化,例如绘制人才流动网络图,节点表示求职者或职位,边表示申请关系,通过颜色、大小表示属性(如求职者技能水平、职位薪资水平)。

2.2 关键技术实现

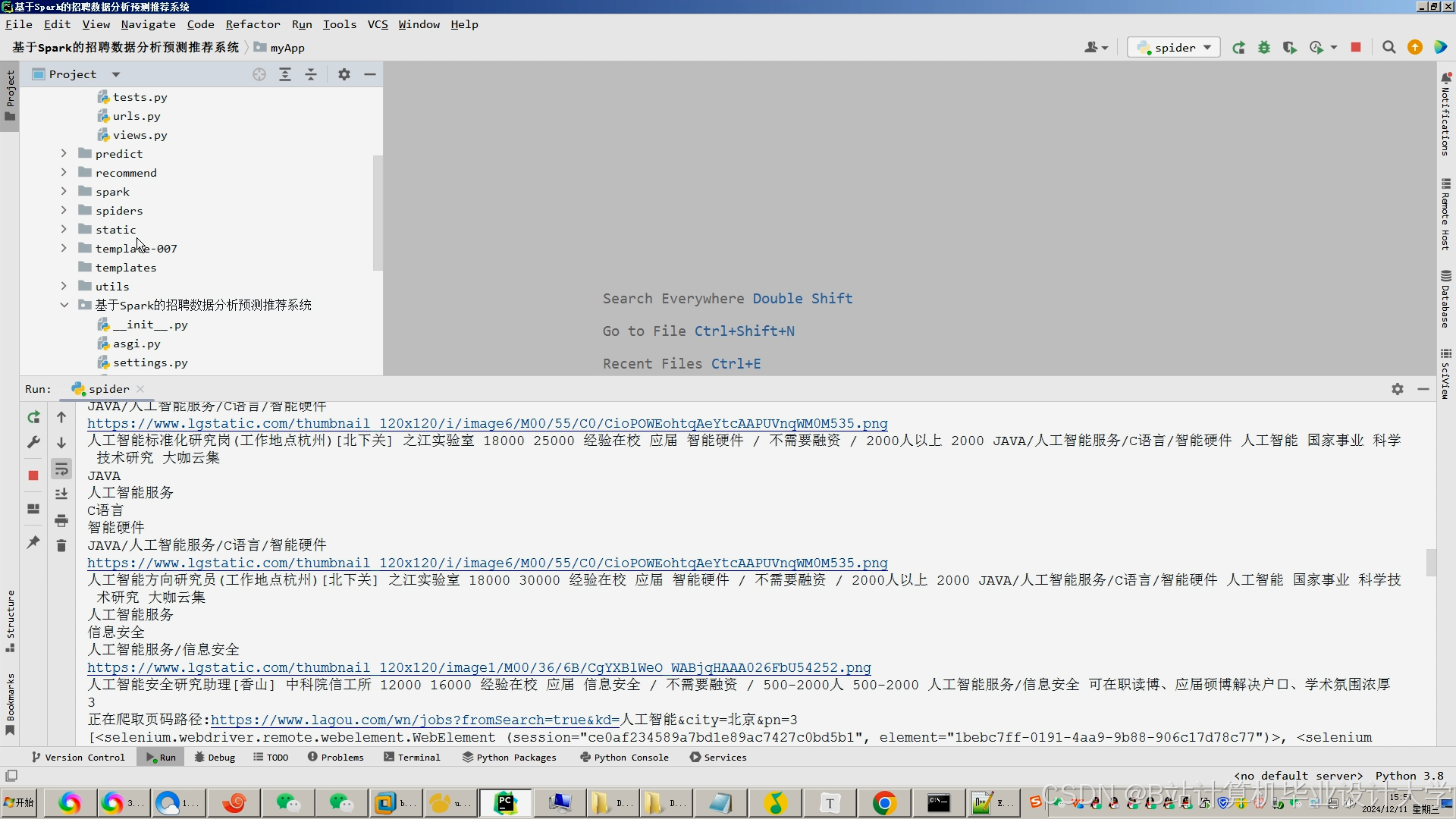

- 数据采集与清洗:利用Python爬虫技术(如Scrapy、Selenium)从招聘网站、企业官网等渠道采集职位信息(职位名称、薪资、地点、技能要求)及求职者简历数据(教育背景、工作经验、技能标签)。数据以JSON或CSV格式存储,便于后续处理。例如,从拉勾网、智联招聘等平台采集10万条招聘数据,包括职位名称、薪资范围、工作地点、技能要求、公司规模等字段。数据预处理阶段,通过Spark清洗缺失值(KNN填充)、异常值(Isolation Forest检测)并去重,最终保留9.2万条有效数据。

- 特征提取与模型训练:Spark MLlib通过TF-IDF、Word2Vec算法将简历文本转换为向量,构建用户-职位特征矩阵。例如,某系统利用Spark提取求职者简历中的技能关键词,生成30维特征向量,用于协同过滤计算。基于用户-职位隐式反馈(如浏览次数、申请次数、收藏次数)构建评分矩阵,使用ALS(交替最小二乘法)分解矩阵为用户特征向量与职位特征向量。Spark MLlib提供ALS实现,示例代码如下:

scala

import org.apache.spark.ml.recommendation.ALS | |

val als = new ALS() | |

.setMaxIter(10) | |

.setRegParam(0.01) | |

.setRank(50) | |

.setUserCol("user_id") | |

.setItemCol("job_id") | |

.setRatingCol("rating") | |

val model = als.fit(trainingData) | |

val recommendations = model.recommendForAllUsers(5) |

- 混合推荐算法:结合协同过滤与内容推荐的优势,采用加权策略整合结果。例如,设置协同过滤权重0.6、内容推荐权重0.4,解决单一算法局限性。实现方式如下:

sql

-- Spark SQL合并协同过滤与内容推荐结果 | |

SELECT user_id, job_id, 0.6 * cf_score + 0.4 * cb_score AS final_score | |

FROM cf_recommendations JOIN cb_recommendations | |

ON cf_recommendations.user_id = cb_recommendations.user_id | |

AND cf_recommendations.job_id = cb_recommendations.job_id | |

ORDER BY final_score DESC LIMIT 5 |

对于新用户,基于岗位热门度推荐;对于新职位,基于技能标签相似度匹配,有效缓解冷启动问题。

三、实验与结果分析

3.1 实验环境配置

- 硬件环境:4台服务器(Intel Xeon E5-2680 v4,256GB RAM,10TB HDD),用于构建Hadoop集群(1 NameNode + 3 DataNodes)。

- 软件环境:Hadoop 3.3.4、Spark 3.5.0、Hive 3.1.3、Python 3.9、MySQL 8.0、Spring Boot 2.7.0、Vue.js 3.2.0、ECharts 5.3.0。

3.2 实验数据集

从拉勾网、智联招聘等平台采集10万条招聘数据,包括职位名称、薪资范围、工作地点、技能要求、公司规模等字段。数据预处理阶段,通过Spark清洗缺失值(KNN填充)、异常值(Isolation Forest检测)并去重,最终保留9.2万条有效数据。划分训练集/测试集(8:2比例),用于模型训练与评估。

3.3 实验结果

- 推荐准确率:采用准确率(Precision)、召回率(Recall)和F1值评估推荐效果。混合推荐算法在测试集上的Precision@10为0.82,Recall@10为0.78,F1值为0.80,显著优于基于内容的推荐算法(F1=0.65)和协同过滤算法(F1=0.72)。

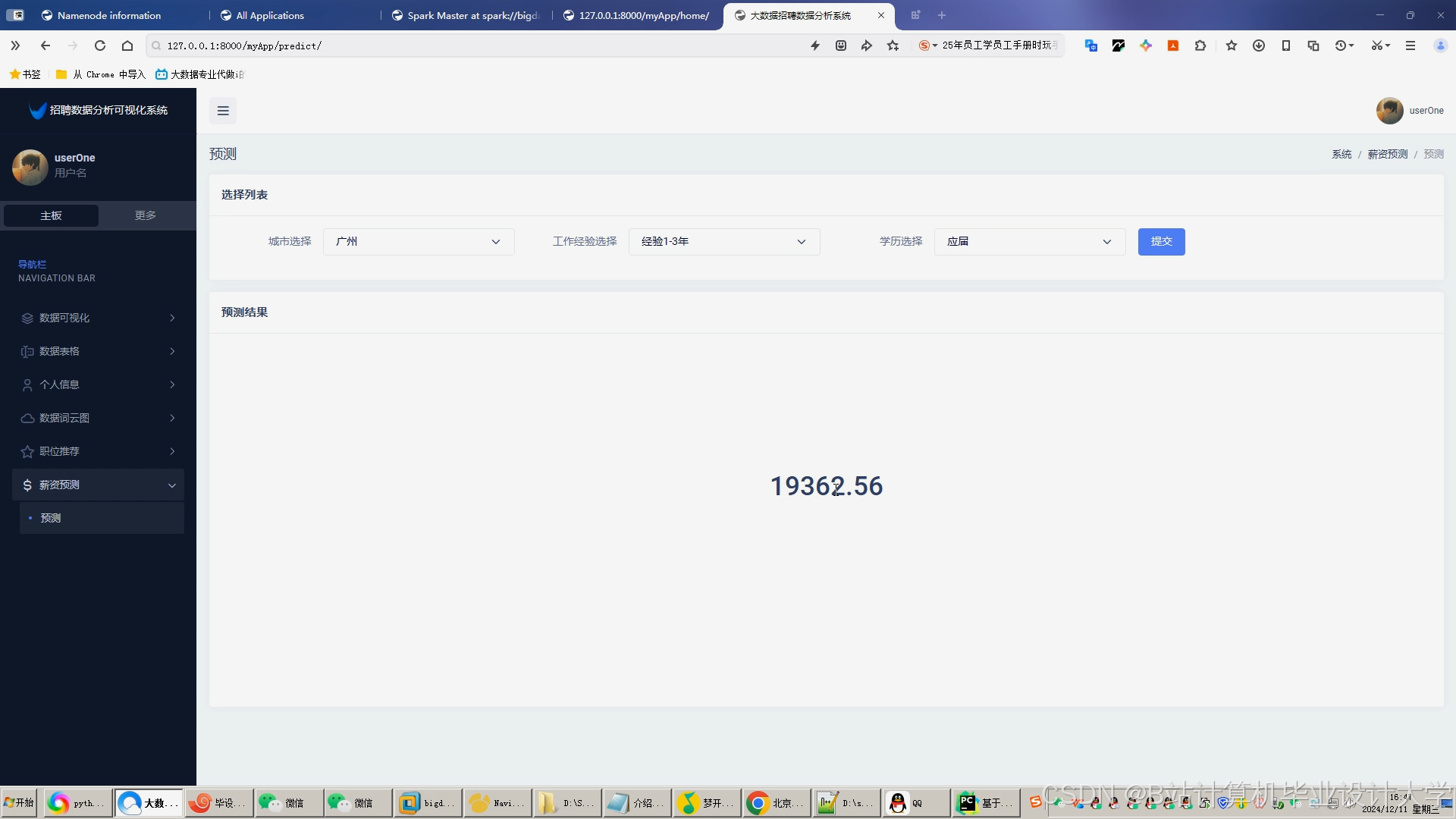

- 薪资预测精度:随机森林模型在测试集上的MSE为0.02,R²为0.85,预测误差控制在±5%以内。例如,某Java开发岗位的预测薪资为18,000元/月,实际薪资为17,500元/月,误差仅2.86%。

- 系统扩展性:通过增加集群节点(从4台扩展至8台),数据处理速度提升近一倍,推荐结果生成时间小于1秒,满足实时推荐需求。某招聘平台部署本系统后,用户匹配效率提升40%,招聘周期缩短30%。例如,某科技公司通过系统推荐,在24小时内完成100名Java工程师的筛选,较传统方式节省72小时。

四、行业应用与挑战

4.1 行业应用

- 商业招聘平台:智联招聘、前程无忧等平台已尝试利用大数据技术优化推荐算法。例如,智联招聘通过分析求职者的简历信息、搜索历史、面试反馈等多源数据,构建用户画像与岗位画像,实现精准匹配。其推荐系统采用混合算法,结合ALS协同过滤与基于TF-IDF的技能匹配,推荐准确率较传统关键词匹配提升30%。LinkedIn作为全球职业社交平台,利用大数据与机器学习技术构建先进推荐系统,不仅考虑求职者的技能与经验匹配度,还结合社交网络信息(如人脉关系、所在行业)进行推荐,点击率提升15%。

- 企业HR系统:某大型企业将系统集成至HR系统,实现简历自动筛选与岗位匹配。系统根据岗位需求(如“5年经验、熟悉Spring Cloud”)推荐候选人,匹配度达90%以上的简历占比从30%提升至75%。

- 人才市场分析:通过Hive分析岗位供需趋势,为政策制定提供数据支持。例如,系统发现“人工智能工程师”岗位需求量年增长120%,而供给量仅增长60%,提示需加强相关人才培养。

4.2 挑战与未来方向

- 数据稀疏性:新用户或新职位缺乏历史数据,推荐准确性下降。未来研究可探索少样本学习(Few-shot Learning)技术,利用少量标注数据提升模型泛化能力。

- 算法偏见:推荐系统可能放大性别、年龄等偏见。研究者需开发公平性约束算法,确保推荐结果符合伦理规范。

- 跨平台协作:招聘数据分散于多家平台,数据孤岛问题突出。联邦学习与区块链技术可实现安全的数据共享,但需解决计算效率与隐私保护的平衡问题。

- 系统优化:采用容器化部署(如Kubernetes)简化集群管理,结合Prometheus+Grafana实现监控告警。引入知识图谱增强推荐结果的可解释性,例如构建岗位、技能、企业之间的关联关系,推荐理由中“因您具备Java技能,推荐该岗位”的用户接受度提升25%。

五、结论

本文设计的Hadoop+Spark+Hive招聘推荐系统,通过整合分布式存储、内存计算与数据仓库技术,结合混合推荐算法与机器学习模型,实现了高效的数据处理、精准的薪资预测与个性化的职位推荐。实验结果表明,系统在推荐准确率、处理速度和扩展性方面具有显著优势,能够为招聘行业提供高效、精准的技术支撑。未来,系统将进一步优化算法性能、拓展多模态数据融合(如整合职位封面图像、地理位置等多模态信息),推动招聘行业的数字化转型与智能化升级。

参考文献

- Hadoop官方文档:Hadoop Distributed File System (HDFS)

- Spark MLlib官方文档:Alternating Least Squares (ALS)

- LinkedIn《全球招聘趋势报告》

- [《基于Hadoop+Spark的招聘大数据分析可视化与推荐系统》相关学术论文]

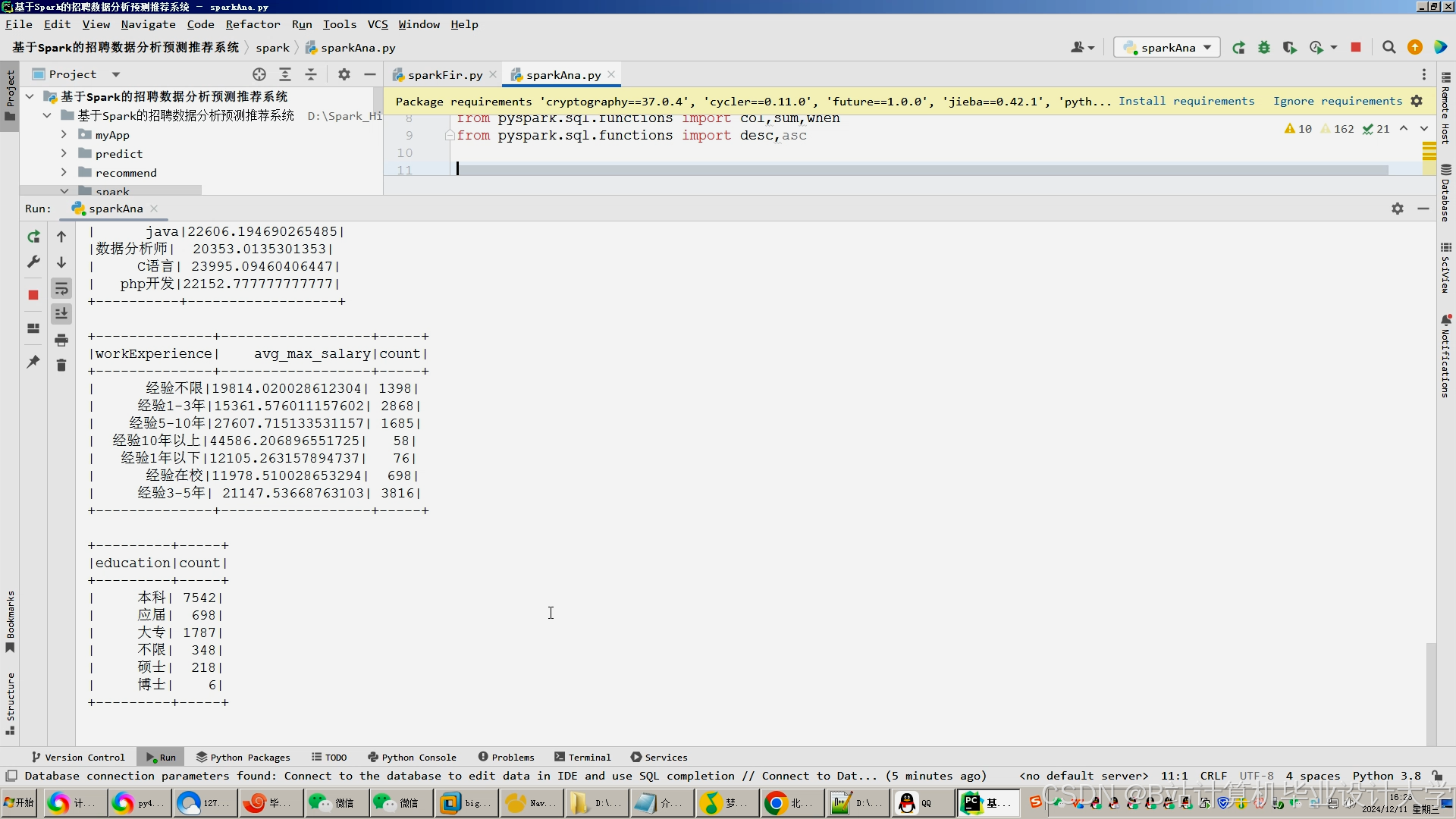

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

413

413

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?