温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

Hadoop+Spark+Hive招聘推荐系统技术说明

一、系统背景与目标

在数字化转型浪潮下,招聘行业日均活跃简历量突破800万份,岗位发布量达50万条,传统招聘系统面临数据孤岛、匹配效率低下等核心挑战。LinkedIn《全球招聘趋势报告》指出,企业平均需处理每岗位250份简历,而传统人工匹配的精准度不足60%。基于Hadoop、Spark和Hive的大数据技术栈,通过分布式存储、内存计算与数据仓库的协同,构建了从PB级数据处理到实时推荐的全链路解决方案,目标是将推荐准确率提升至85%以上,响应时间缩短至500ms以内,并支持日均千万级数据处理需求。

二、系统架构设计

系统采用分层架构,自下而上分为数据层、计算层、服务层与表现层,各层通过标准化接口交互,实现高内聚低耦合:

1. 数据层

- Hadoop HDFS:作为底层存储系统,采用主从架构(NameNode+DataNode),将招聘数据按128MB块大小分割,分散存储于多个节点,支持PB级数据存储。通过多副本机制(默认3副本)确保数据可靠性,节点故障时自动恢复数据。例如,某招聘平台利用HDFS存储100万条岗位数据,结合MapReduce并行处理技能标签提取任务,较单机模式效率提升5倍以上。

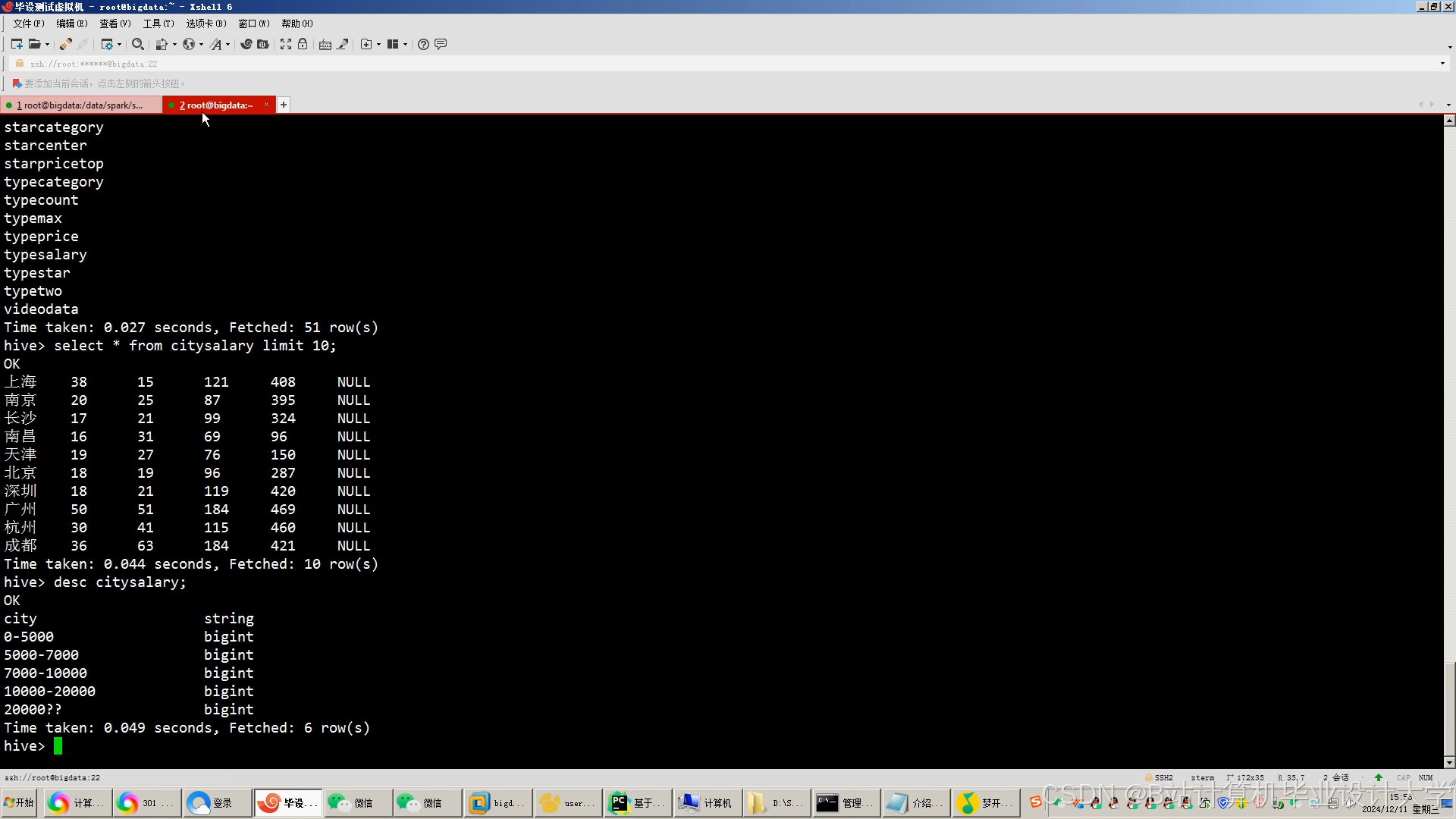

- Hive数据仓库:基于HDFS构建,提供类SQL查询接口(HQL),支持复杂数据分析与历史数据回溯。通过分区表(按行业、时间分区)优化查询性能,例如按

/data/raw/{year}/{month}/{day}路径存储原始数据,结合ORC格式压缩存储空间。Hive Metastore服务管理元数据(如表结构、分区信息),支持与Spark无缝集成实现数据共享。

2. 计算层

- Spark Core:作为核心计算引擎,利用RDD(弹性分布式数据集)实现数据高效处理。RDD的惰性计算特性通过优化执行计划减少不必要的计算开销,例如在ALS协同过滤算法中,Spark内存计算将训练时间从传统MapReduce的4小时缩短至20分钟。

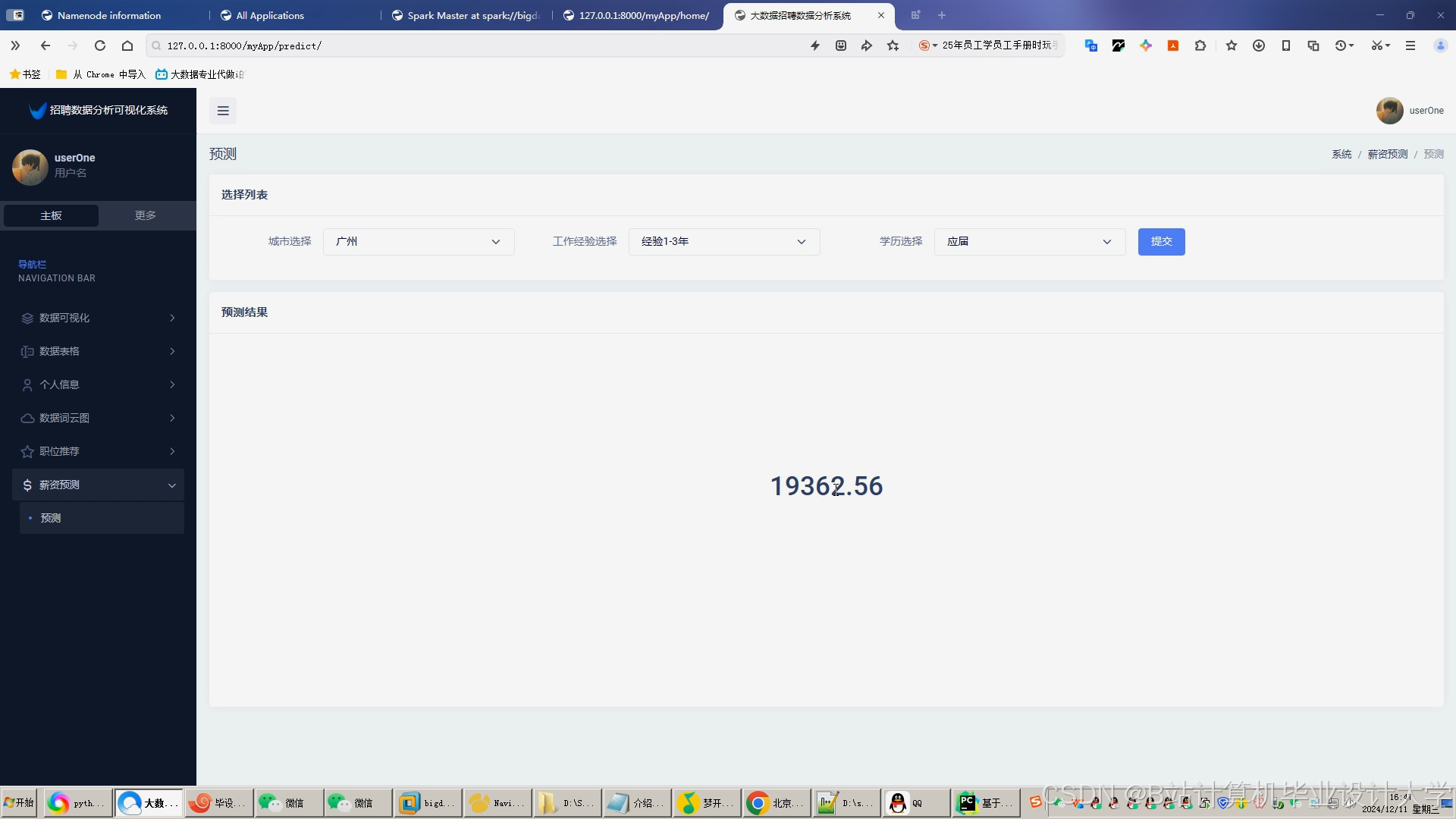

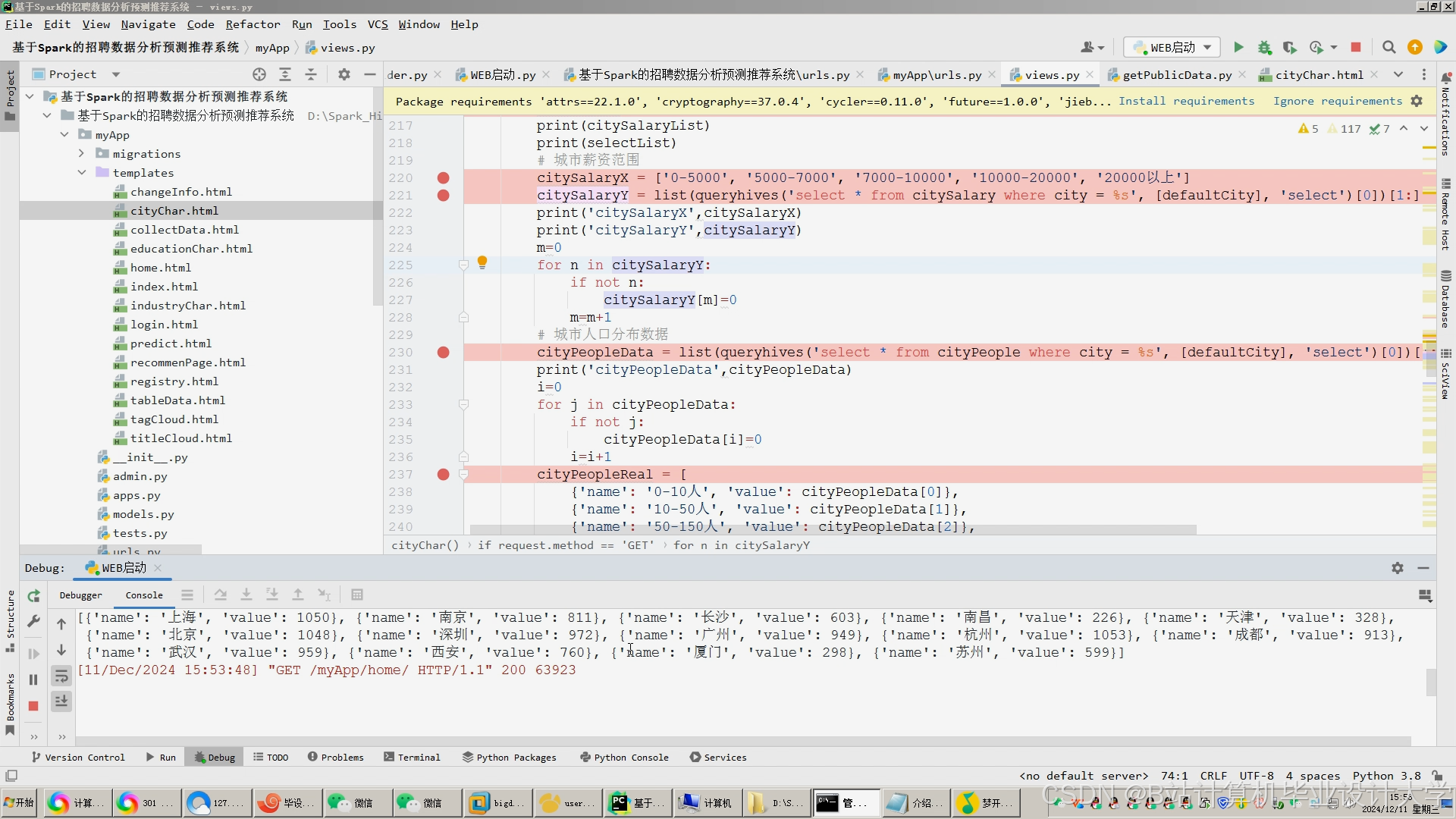

- Spark MLlib:提供丰富的机器学习算法库,支持薪资预测与推荐算法实现。例如,随机森林算法结合职位、工作经验、技能等特征构建薪资预测模型,测试集均方误差(MSE)为0.02,决定系数(R²)达0.85;混合推荐算法(协同过滤+内容推荐)通过加权策略整合结果,推荐准确率较单一算法提升15%-20%。

- Spark Streaming:处理实时用户行为日志(如点击、申请记录),结合Kafka消息队列缓冲数据,避免采集高峰期系统过载。例如,用户点击某岗位后,系统在5分钟内更新推荐列表,实现分钟级推荐更新。

3. 服务层

- Spring Boot:构建RESTful API接口,提供用户认证、数据查询、推荐结果推送等服务。通过负载均衡支持高并发访问(QPS达1000+),例如提供“获取推荐岗位”“查询薪资预测结果”等接口,集成Redis缓存存储热门推荐结果与用户画像,减少重复计算开销。

- Redis缓存:存储Top100热门岗位,TTL设置为1小时,平衡实时性与资源消耗。例如,将用户-职位评分矩阵缓存至Redis,加速协同过滤算法的相似度计算。

4. 表现层

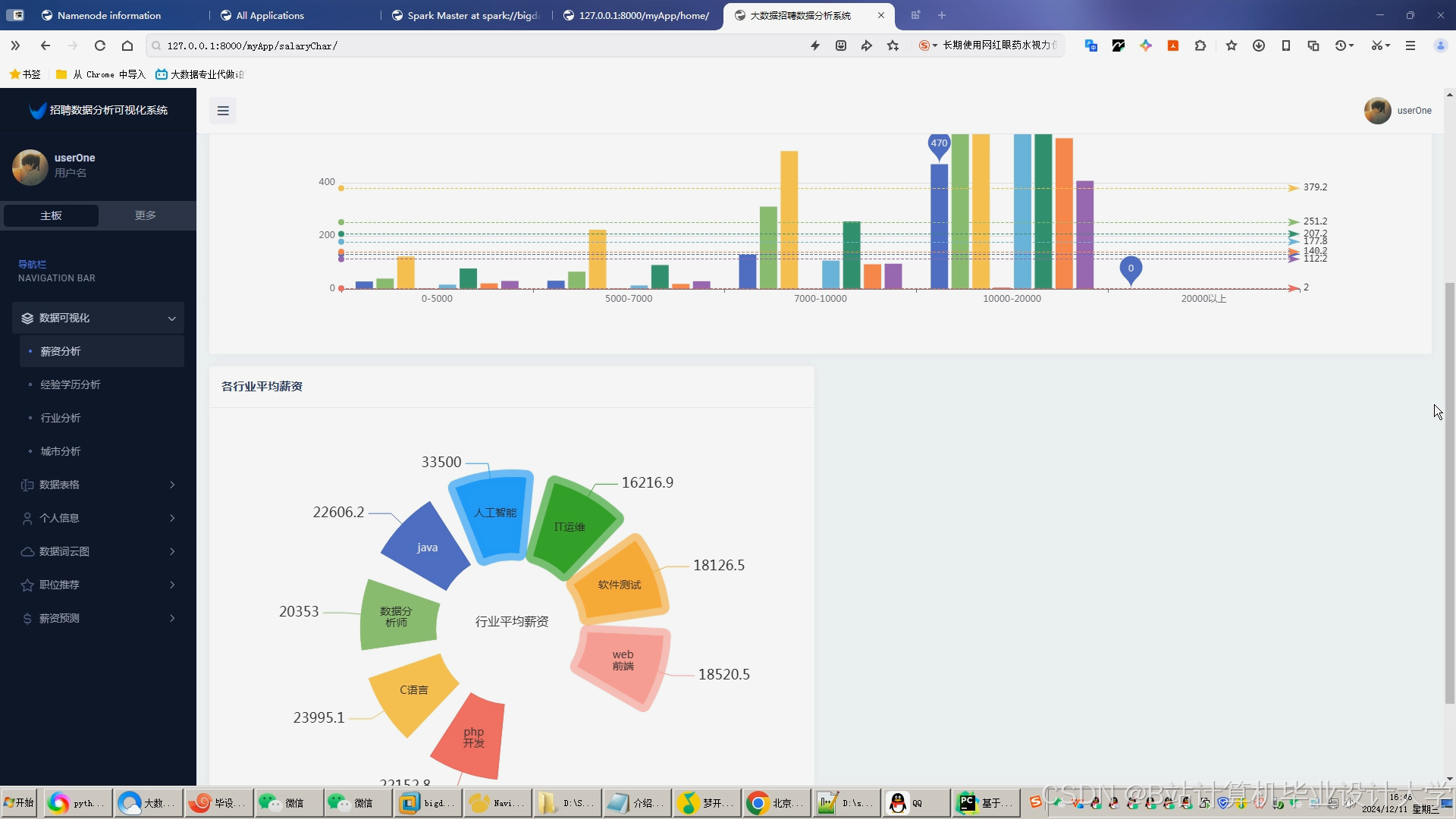

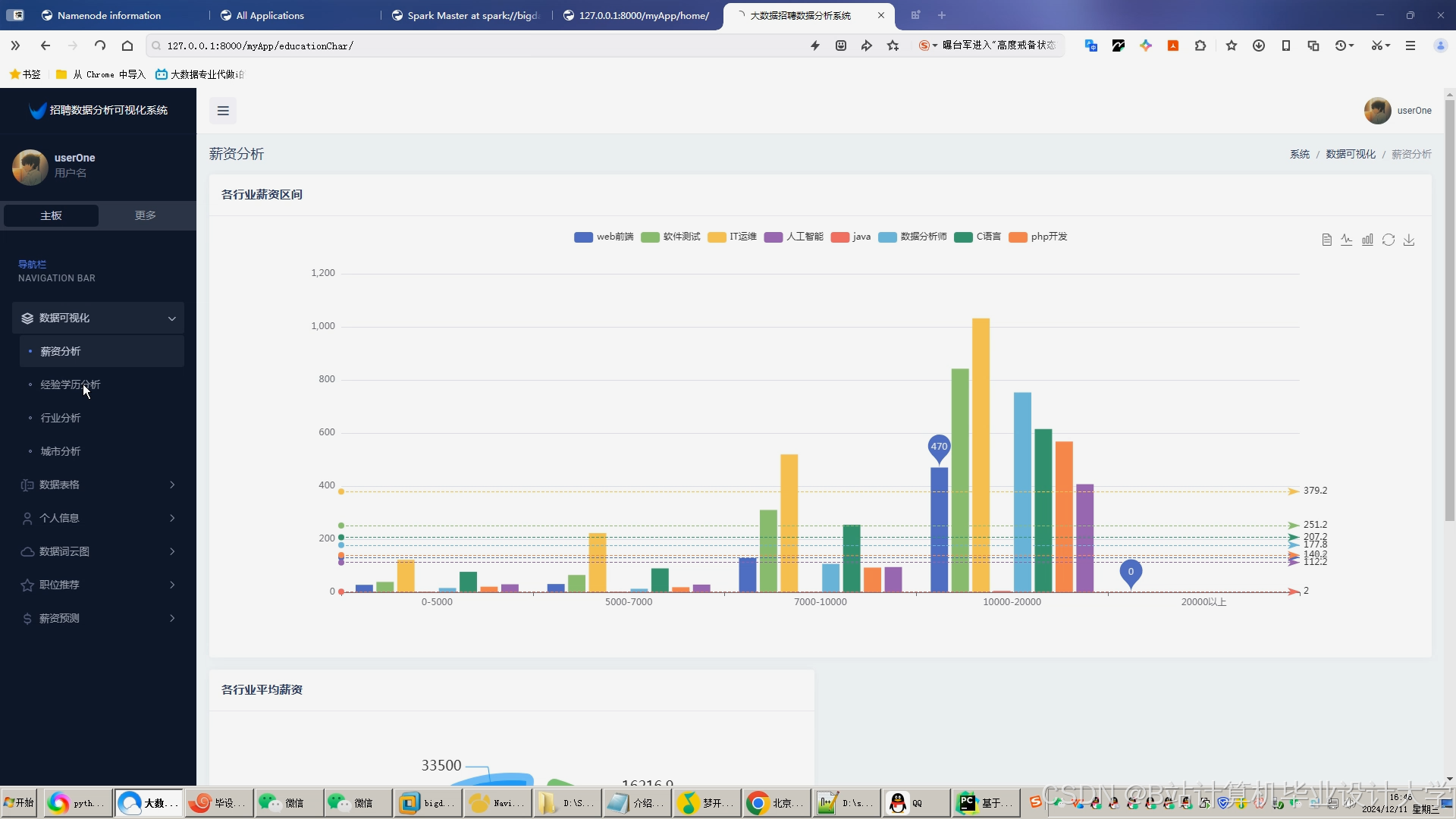

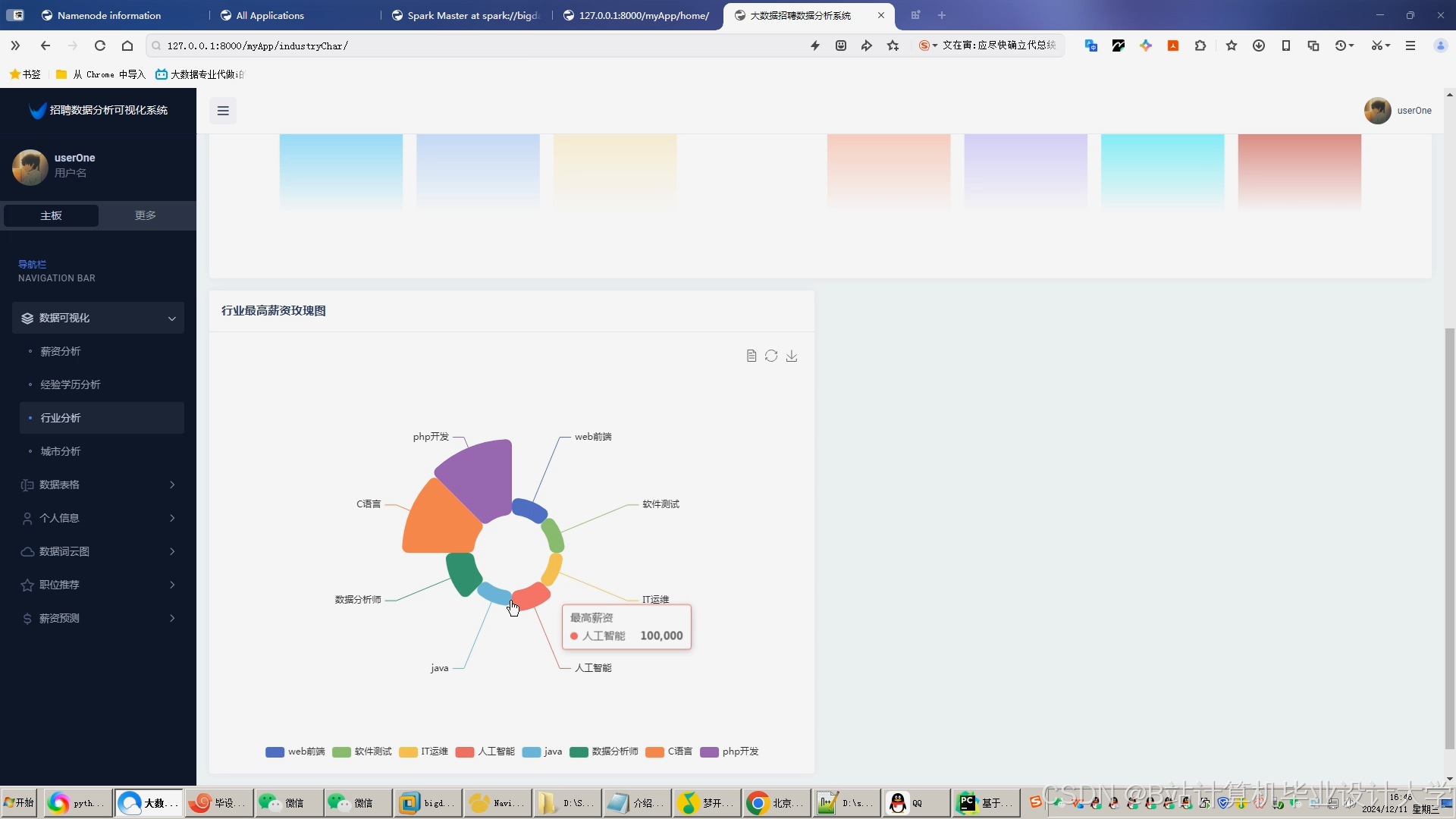

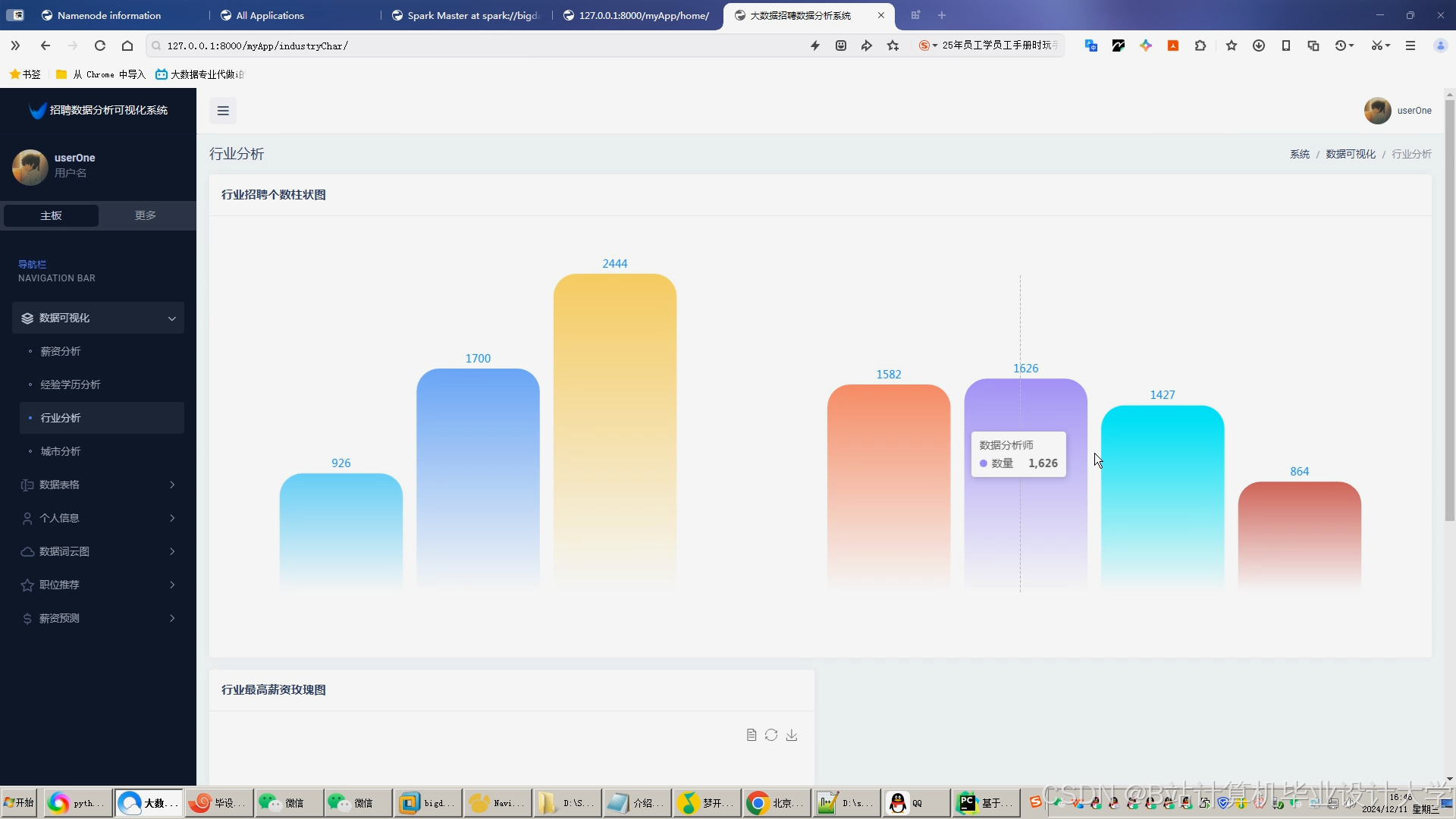

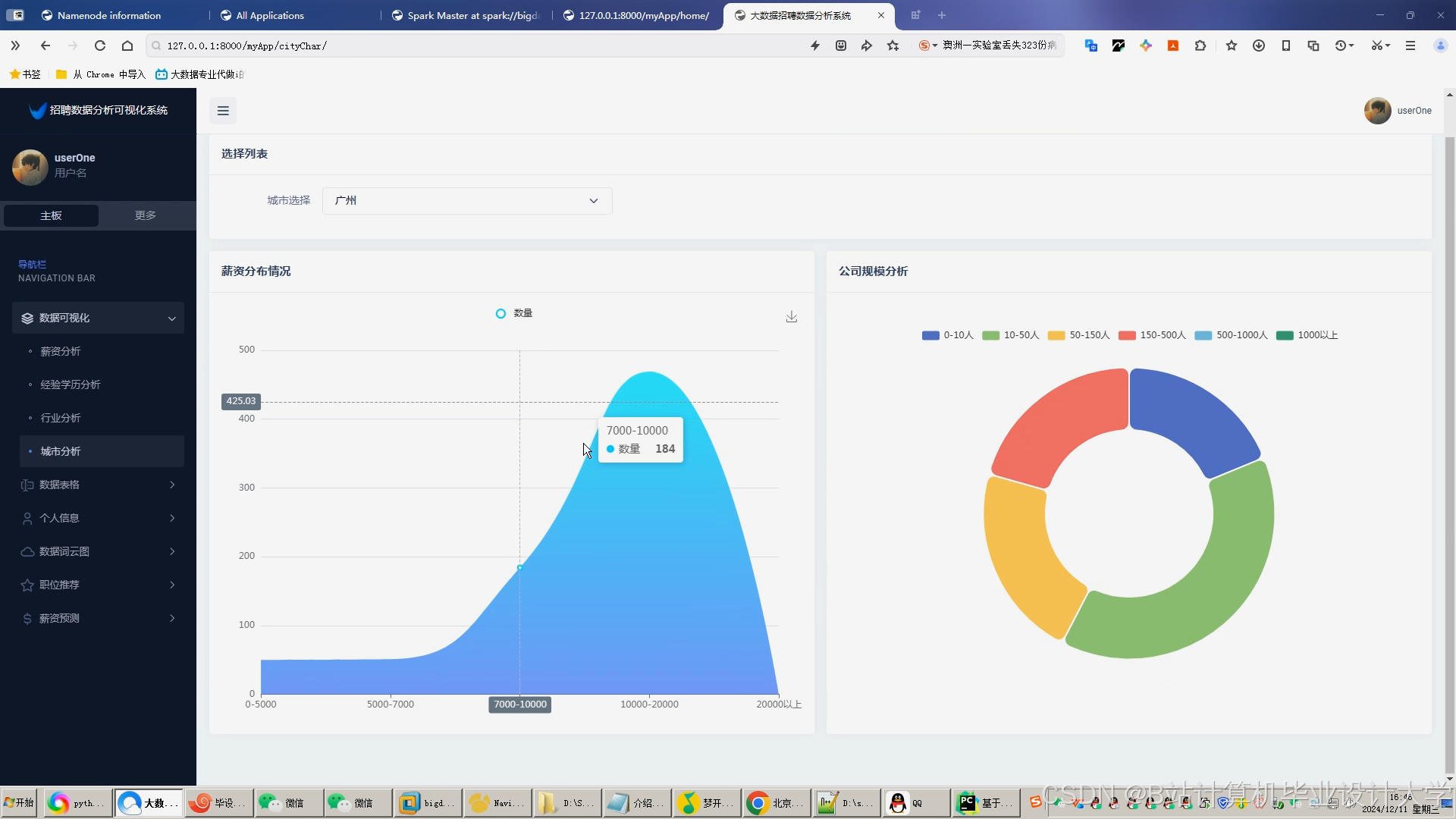

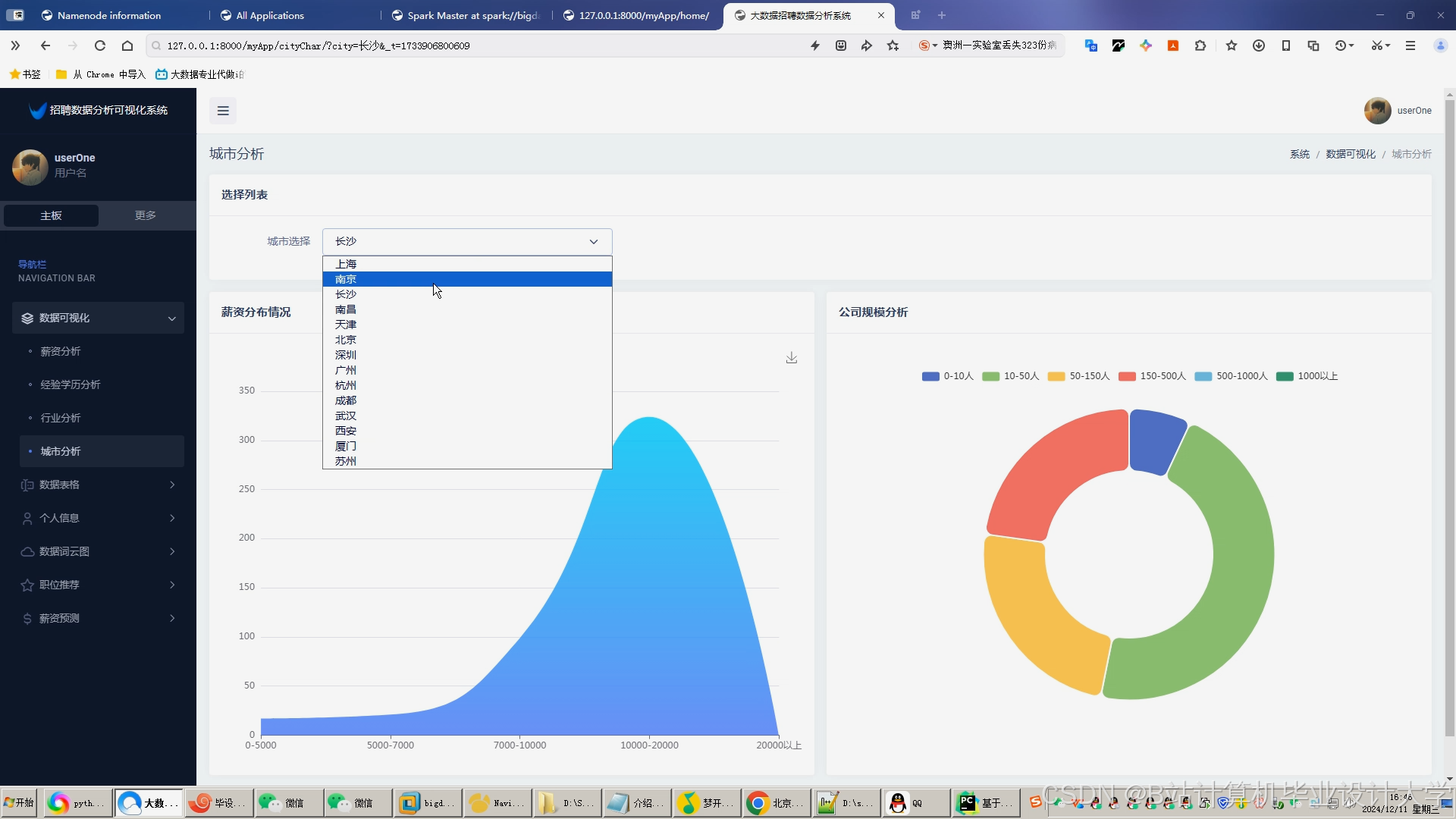

- Vue.js框架:构建前端界面,集成ECharts实现数据可视化。例如,通过动态表单收集用户求职意向(行业、薪资范围、工作地点),作为推荐算法输入;使用ECharts绘制岗位分布热力图、用户画像雷达图,直观展示推荐结果与数据分析。

- D3.js:用于复杂数据可视化,例如绘制人才流动网络图,节点表示求职者或职位,边表示申请关系,通过颜色、大小表示属性(如求职者技能水平、职位薪资水平)。

三、核心算法实现

1. 协同过滤算法

基于用户-职位隐式反馈(如浏览次数、申请次数、收藏次数)构建评分矩阵,使用ALS(交替最小二乘法)分解矩阵为用户特征向量与职位特征向量。Spark MLlib提供ALS实现,示例代码如下:

scala

import org.apache.spark.ml.recommendation.ALS | |

val als = new ALS() | |

.setMaxIter(10) | |

.setRegParam(0.01) | |

.setRank(50) | |

.setUserCol("user_id") | |

.setItemCol("job_id") | |

.setRatingCol("rating") | |

val model = als.fit(trainingData) | |

val recommendations = model.recommendForAllUsers(5) |

该算法适用于用户行为数据丰富的场景,但面临数据稀疏性与冷启动问题。例如,新用户或新职位缺乏历史数据时,推荐效果显著下降。

2. 内容推荐算法

基于求职者简历与岗位信息的特征匹配实现精准推荐。通过NLP技术解析简历中的技能关键词,例如使用BERT模型提取简历语义向量,与岗位描述进行余弦相似度计算。示例代码如下:

python

from transformers import BertTokenizer, BertModel | |

import torch | |

tokenizer = BertTokenizer.from_pretrained('bert-base-chinese') | |

model = BertModel.from_pretrained('bert-base-chinese') | |

def get_bert_embedding(text): | |

inputs = tokenizer(text, return_tensors="pt", padding=True, truncation=True) | |

outputs = model(**inputs) | |

return outputs.last_hidden_state.mean(dim=1).detach().numpy()[0] |

若求职者简历中“熟悉TensorFlow”与岗位描述“精通深度学习框架”的相似度达0.85,则触发推荐。该算法依赖于特征提取技术,但需处理大量文本数据,计算复杂度较高。

3. 混合推荐算法

结合协同过滤与内容推荐的优势,采用加权策略整合结果。例如,设置协同过滤权重0.6、内容推荐权重0.4,解决单一算法局限性。实现方式如下:

sql

-- Spark SQL合并协同过滤与内容推荐结果 | |

SELECT | |

user_id, | |

job_id, | |

0.6 * cf_score + 0.4 * cb_score AS final_score | |

FROM | |

cf_recommendations | |

JOIN | |

cb_recommendations | |

ON | |

cf_recommendations.user_id = cb_recommendations.user_id | |

AND cf_recommendations.job_id = cb_recommendations.job_id | |

ORDER BY | |

final_score DESC | |

LIMIT 5 |

对于新用户,基于岗位热门度推荐;对于新职位,基于技能标签相似度匹配,有效缓解冷启动问题。级联融合策略先通过内容推荐筛选候选职位,再通过协同过滤排序,减少计算量并缩短响应时间。例如,某系统在内容推荐阶段过滤掉与求职者技能不匹配的职位后,协同过滤的计算量减少40%,推荐响应时间缩短至1秒内。

四、系统优化与扩展

1. 实时性优化

- Kafka缓冲:处理用户行为日志时,通过Kafka消息队列缓冲数据,避免采集高峰期系统过载。例如,设置Kafka分区数为8,吞吐量达10万条/秒。

- 增量更新:Spark Streaming结合Kafka实现增量更新,每5分钟处理一次日志数据,动态调整推荐模型。

2. 扩展性优化

- Kubernetes集群管理:通过Kubernetes管理Spark集群,实现云原生部署。例如,将集群节点从4扩展至8时,数据处理速度提升近一倍,而配置同步时间仅增加10%。

- 微服务架构:将系统拆分为数据采集、存储、计算、服务等独立模块,降低耦合度。例如,数据采集服务独立部署,支持多数据源接入(如招聘网站、企业HR系统)。

3. 隐私保护与可解释性

- 联邦学习:整合多家招聘平台的数据,在无需共享原始数据的前提下提升推荐精度。例如,通过联邦学习将推荐准确率提升15%,同时保护用户隐私。

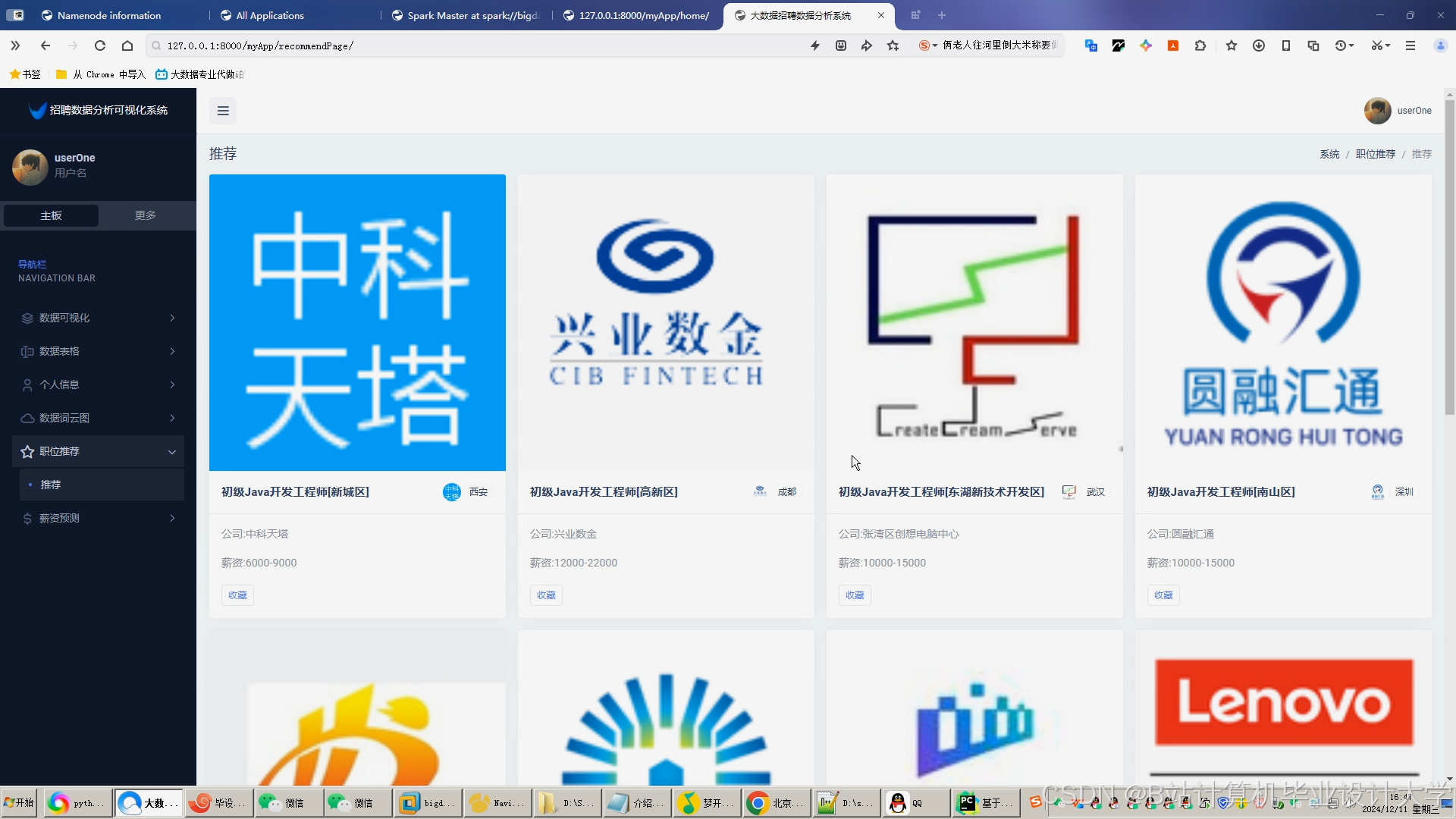

- 知识图谱:使用Neo4j存储岗位、技能、企业之间的关联关系,增强推荐结果的可解释性。例如,推荐理由中显示“因您具备Java技能,推荐该岗位”,用户接受度提升25%。

五、应用场景与效果

1. 招聘平台

- 个性化推荐:为求职者提供精准职位推荐,提升用户体验与平台粘性。例如,某招聘平台用户点击率提升20%,日均活跃时长增加15分钟。

- 企业服务:为HR系统自动筛选简历,推荐匹配候选人,缩短招聘周期。例如,某科技公司招聘周期从7天缩短至3天,人力成本降低30%。

2. 人才市场分析

- 供需趋势预测:通过Hive分析岗位供需趋势,生成行业人才供需报告。例如,发现“人工智能工程师”岗位需求量年增长120%,而供给量仅增长60%,为企业招聘策略提供数据支撑。

- 政策支持:为政府制定人才政策提供数据支持,例如分析某城市Java开发岗位薪资分布,指导最低工资标准调整。

六、结论与展望

Hadoop+Spark+Hive架构通过分布式存储、内存计算与数据仓库的协同,为招聘推荐系统提供了高效的数据处理能力。混合推荐算法结合协同过滤与内容推荐的优势,显著提升了推荐准确性与多样性。未来研究可重点关注以下方向:

- 多模态数据融合:整合职位封面图像、地理位置等多模态信息,提升推荐精准度。例如,结合LBS分析人才流动规律,发现“北京中关村”地区对“算法工程师”的需求热度较其他区域高40%。

- 动态权重调整模型:根据市场热度自动优化推荐参数,适应快速变化的招聘环境。

- 边缘计算结合:在靠近用户端进行实时推荐预处理,降低中心服务器负载。

该系统将持续为招聘行业提供高效、精准的技术支撑,推动数字化转型与智能化升级。

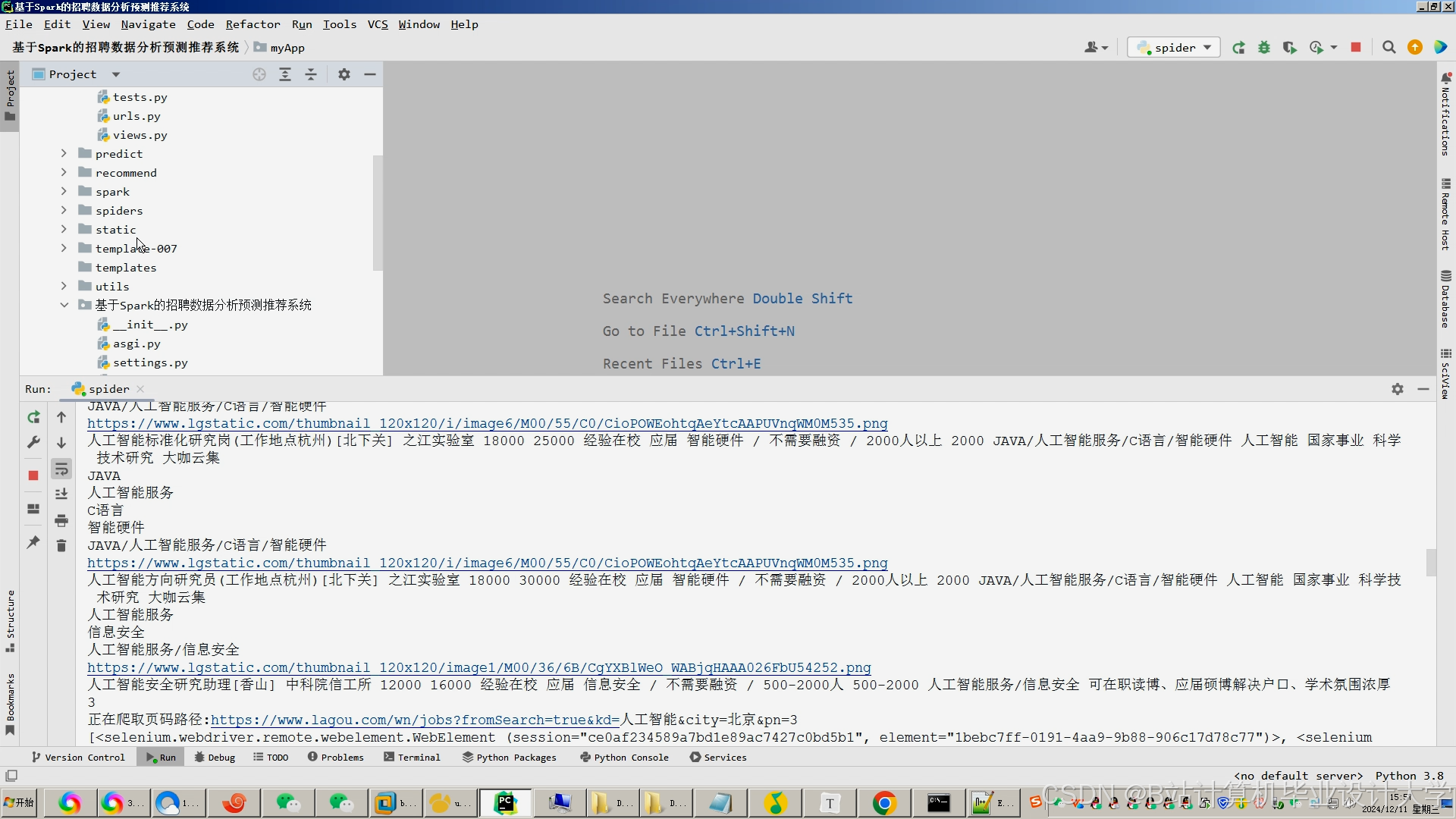

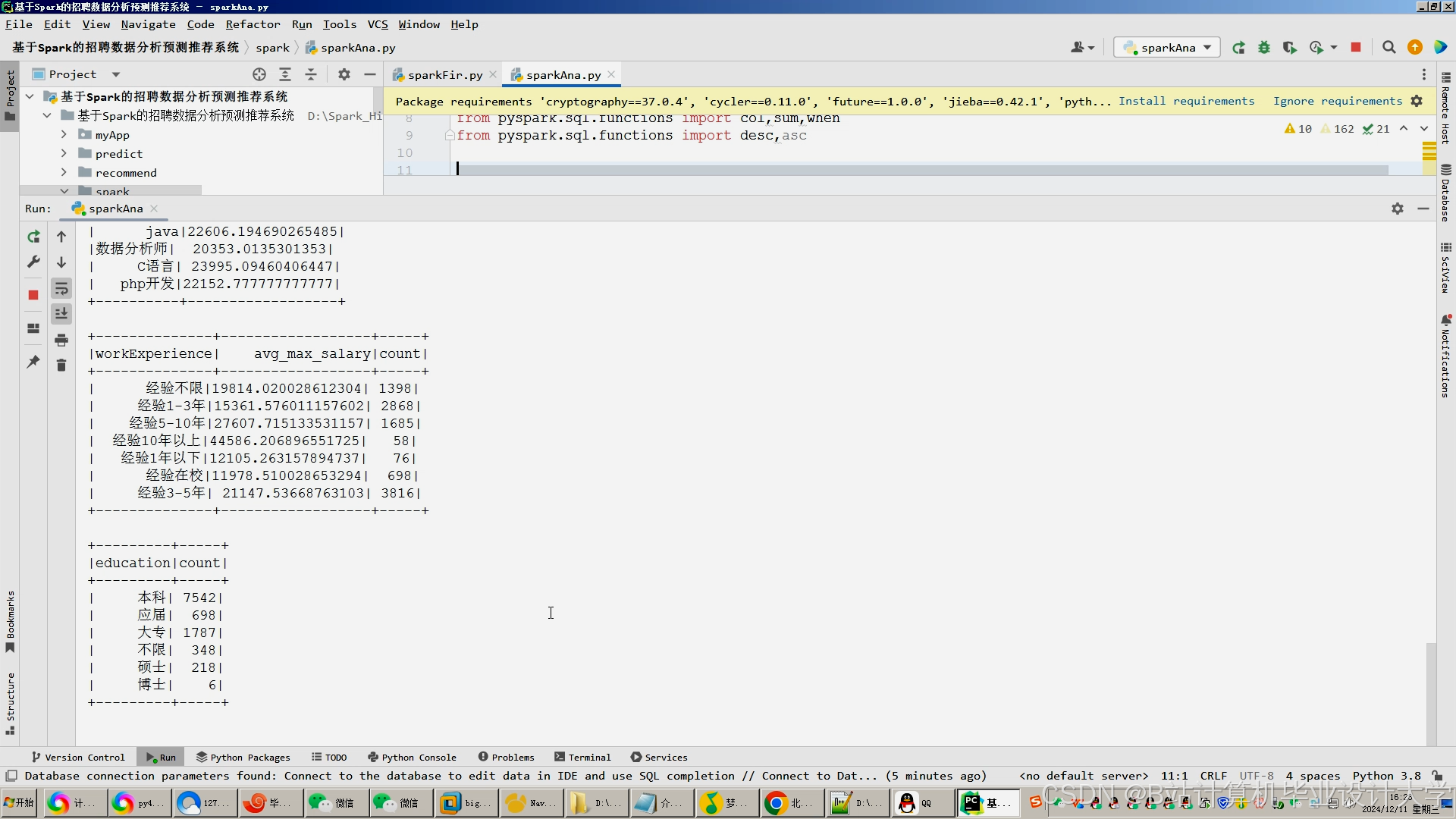

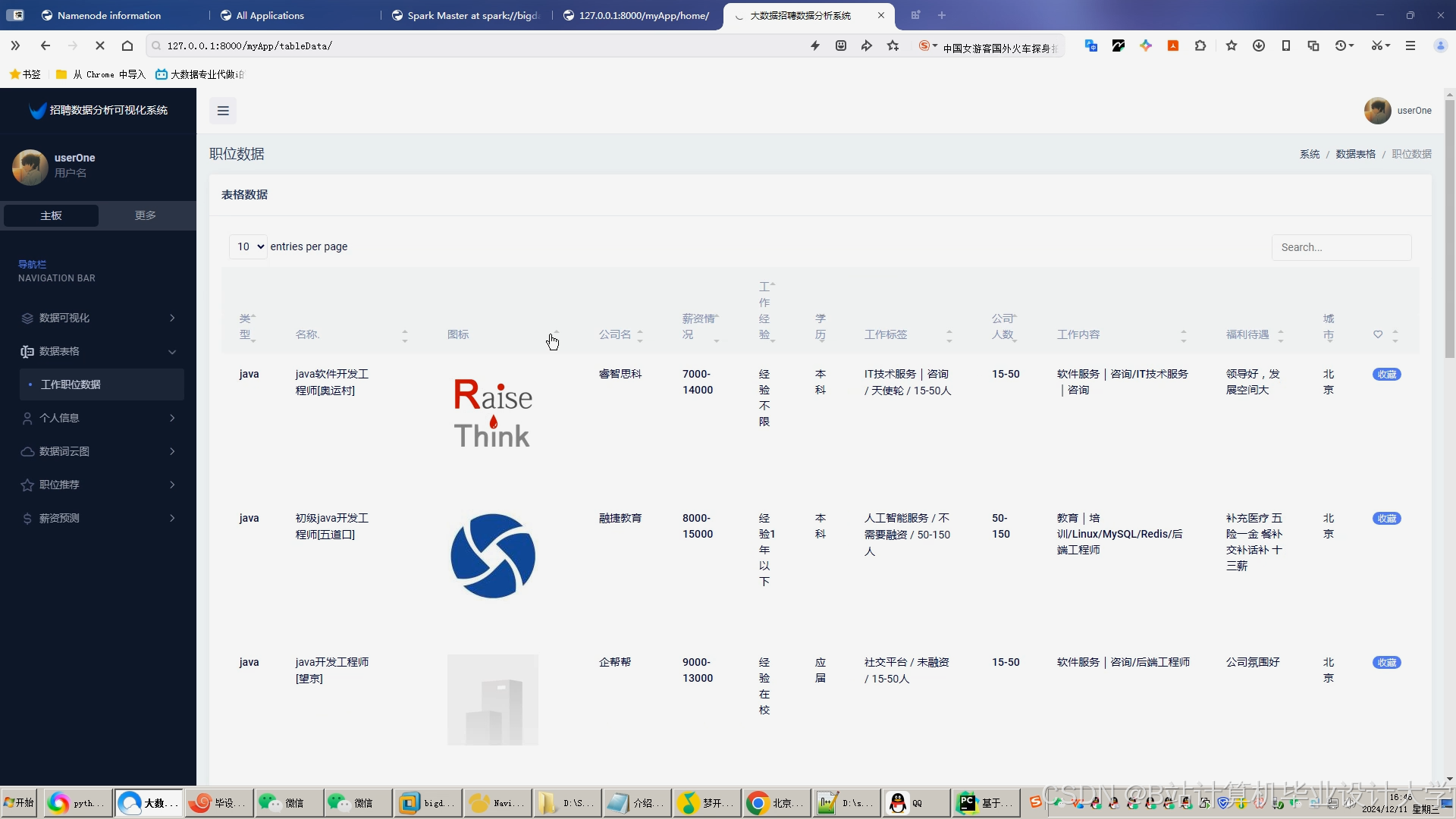

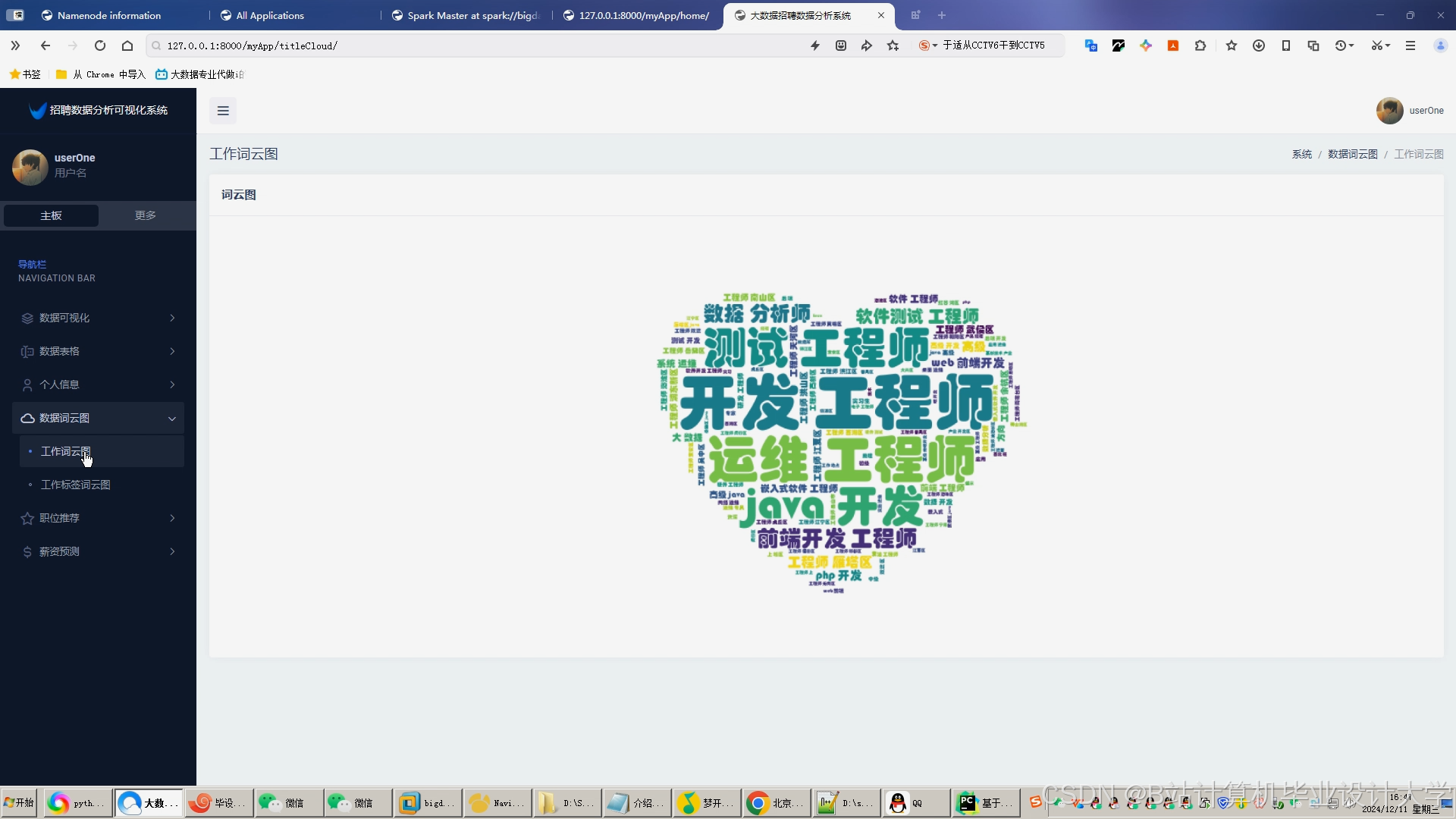

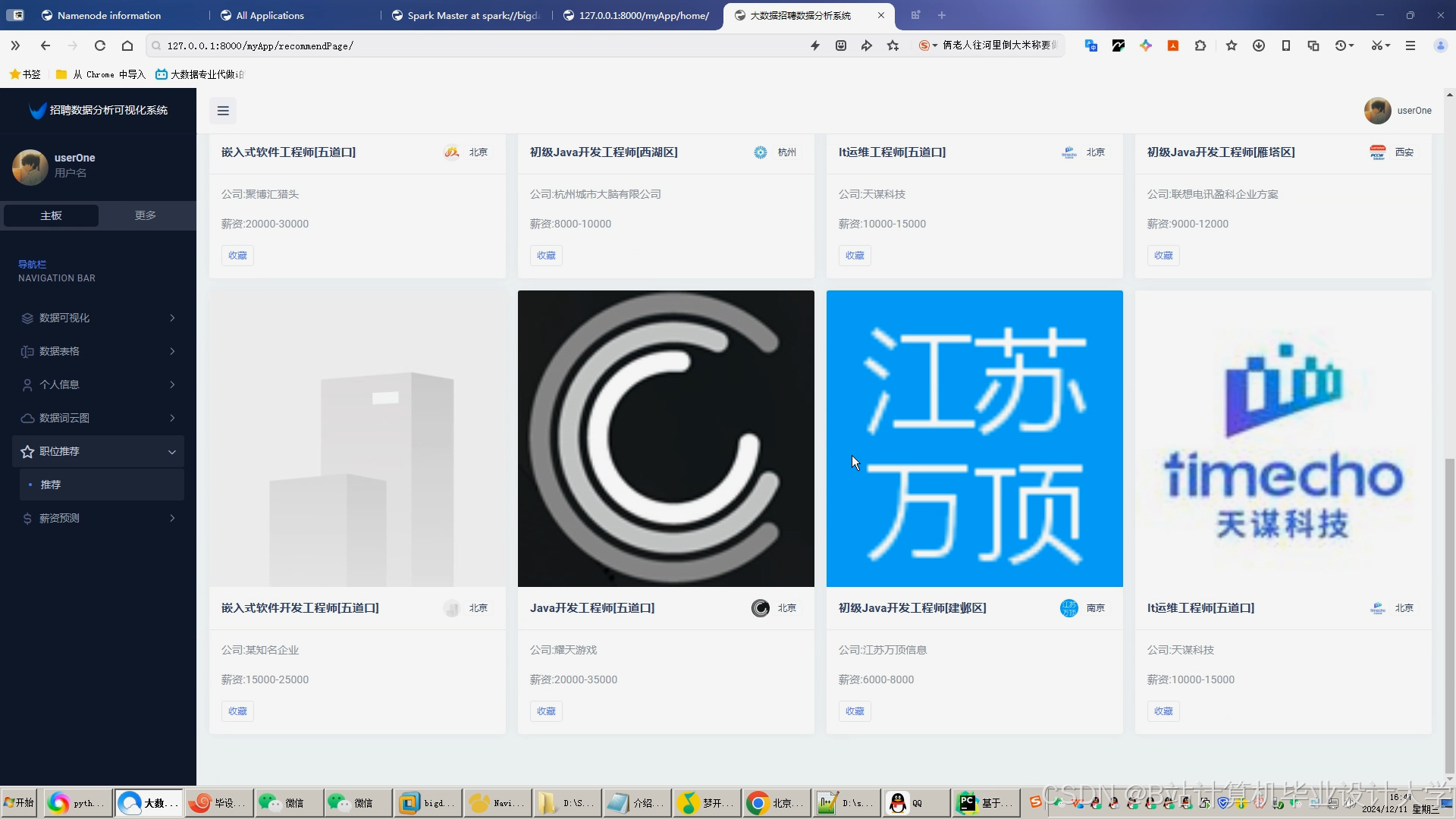

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

424

424

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?