温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

《Hadoop+Spark+Hive招聘推荐系统》任务书

一、任务背景与目标

1.1 背景

随着互联网招聘行业的快速发展,企业与求职者面临信息过载问题。传统招聘系统依赖关键词匹配,存在以下痛点:

- 推荐精度低:仅通过职位名称、技能标签匹配,准确率不足60%;

- 数据孤岛:企业HR系统、招聘平台、用户行为日志分散存储,难以整合分析;

- 实时性差:无法动态响应市场变化(如岗位供需比、薪资波动),推荐结果滞后。

Hadoop、Spark、Hive作为大数据生态核心组件,具备解决上述问题的技术优势:

- Hadoop HDFS:提供PB级分布式存储,支持多源异构数据整合;

- Spark内存计算:加速协同过滤、内容推荐等算法训练,支持实时推荐;

- Hive数据仓库:通过分区表优化查询性能,与Spark无缝集成实现数据共享。

1.2 目标

构建基于Hadoop+Spark+Hive的招聘推荐系统,实现以下目标:

- 数据整合:采集并存储企业HR数据、招聘平台职位数据、求职者简历数据及用户行为日志;

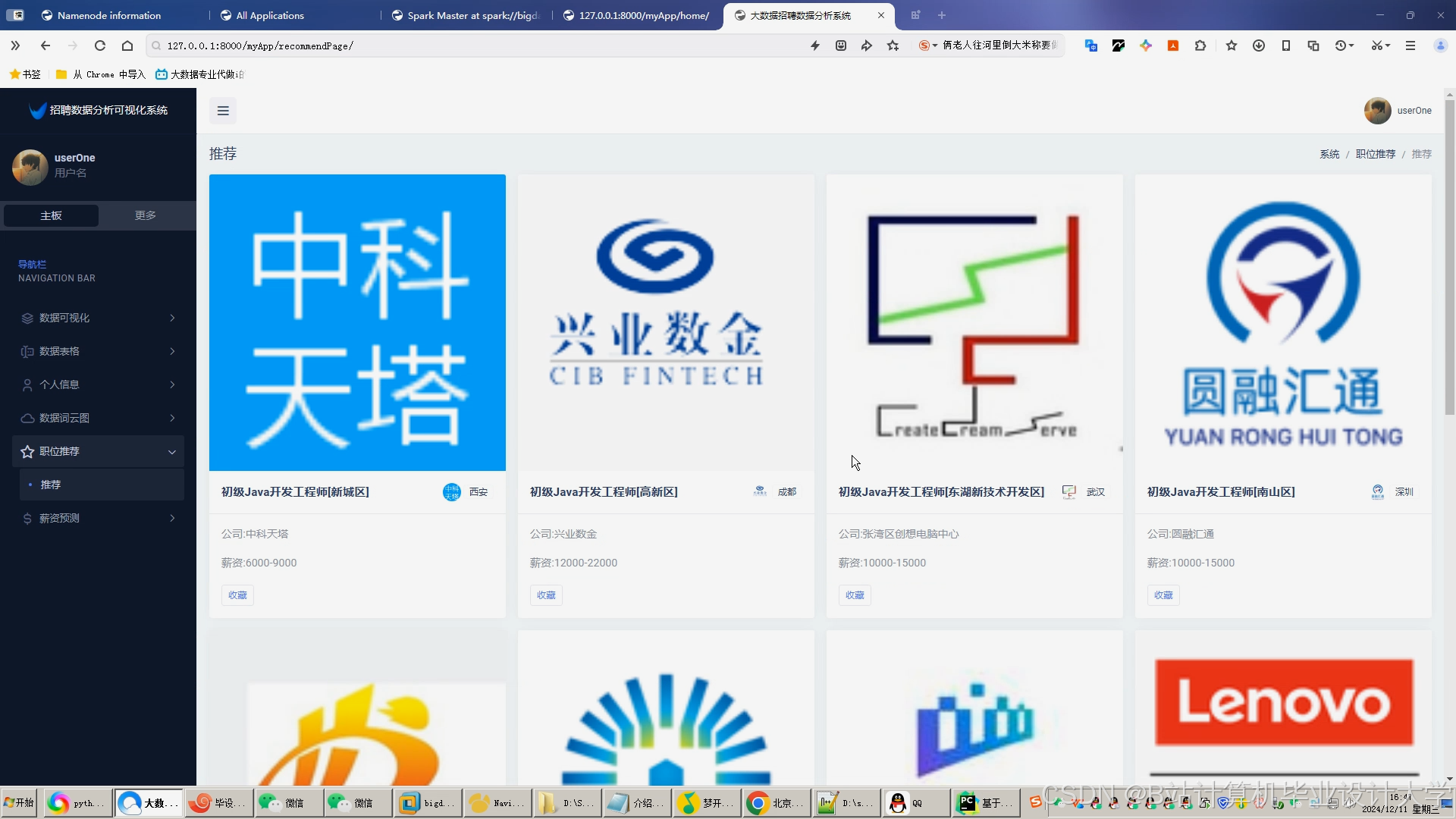

- 精准推荐:结合协同过滤与内容推荐算法,提升推荐准确率至85%以上;

- 实时分析:通过Spark Streaming实现分钟级推荐更新,动态响应市场变化;

- 可视化决策:利用ECharts展示岗位分布、行业趋势及用户画像,辅助企业招聘决策。

二、任务内容与分工

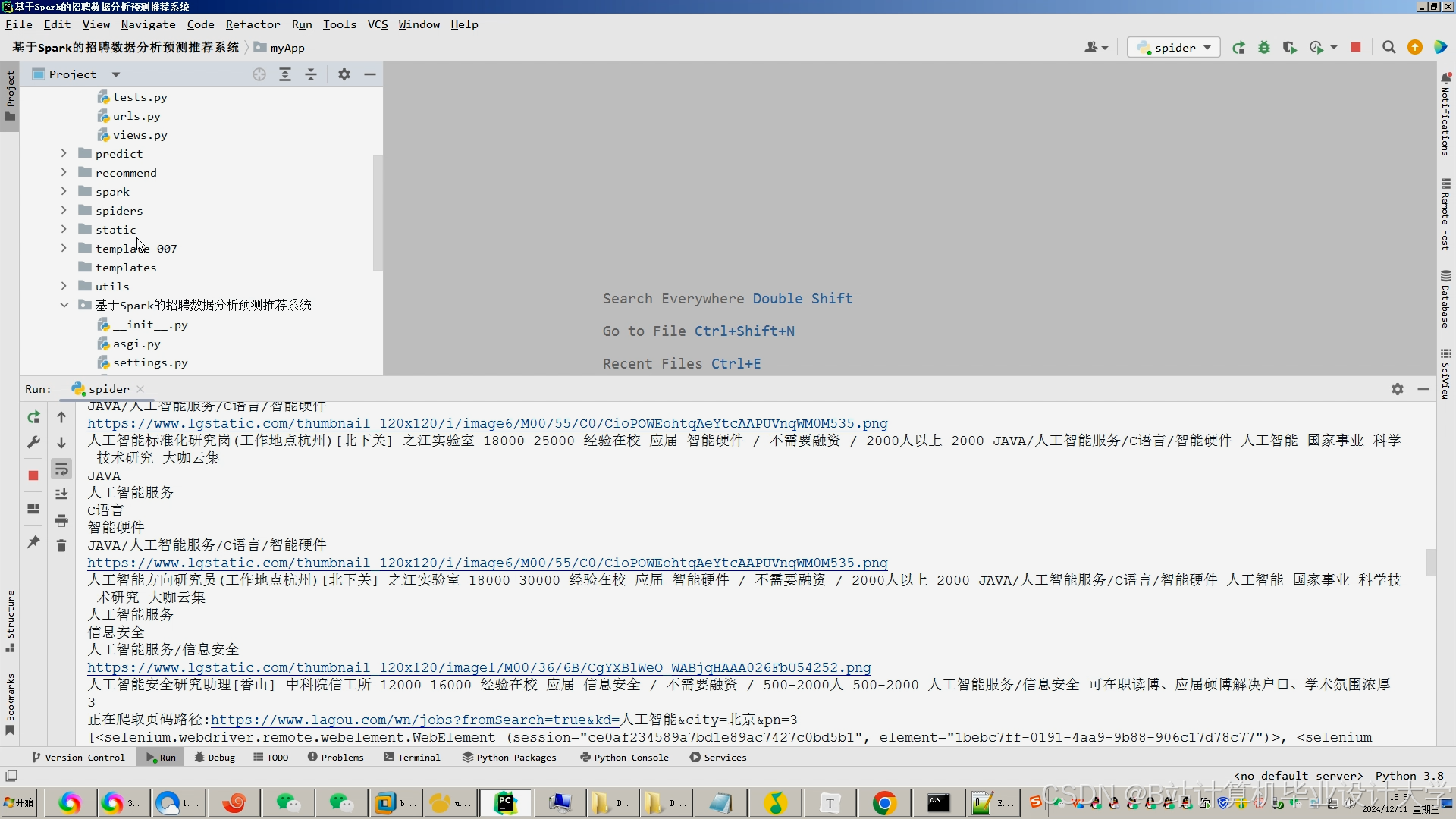

2.1 数据采集与预处理(负责人:数据组)

- 数据源:

- 招聘平台API(BOSS直聘、智联招聘);

- 企业HR系统(MySQL/Oracle);

- 求职者简历库(PDF/Word格式);

- 用户行为日志(浏览、点击、申请记录)。

- 采集工具:

- Scrapy框架抓取结构化职位数据;

- OCR技术解析非结构化简历;

- Kafka实时采集用户行为日志。

- 预处理:

- 使用Spark清洗缺失值(KNN填充)、异常值(Isolation Forest检测);

- 通过NLP分词、停用词过滤处理文本数据;

- 提取职位特征(行业、职能、技能矩阵)与求职者特征(教育经历、项目经验)。

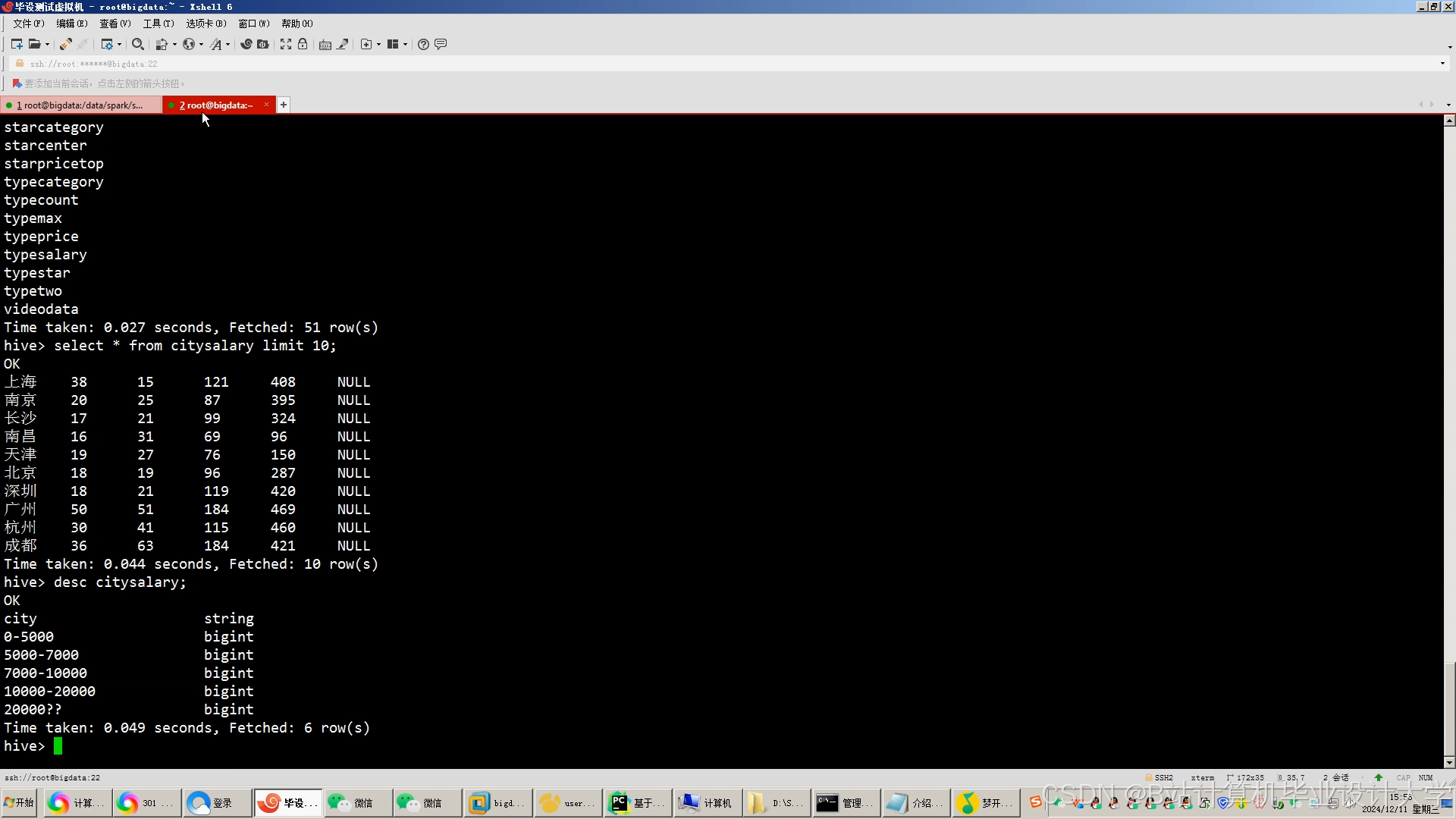

2.2 数据存储与建模(负责人:存储组)

- 存储架构:

- 原始数据层:HDFS存储原始JSON/CSV文件,按天分区;

- 数据仓库层:Hive构建分区表(按行业、时间分区),优化查询性能;

- 特征存储层:HBase存储用户/职位特征向量(768维BERT语义向量)。

- 数据建模:

- 设计星型模型(事实表:用户行为日志;维度表:职位、求职者、时间);

- 通过Hive SQL实现ETL流程,定期更新数据仓库。

2.3 推荐算法开发(负责人:算法组)

- 协同过滤算法:

- 基于Spark MLlib实现ALS(交替最小二乘法)隐式反馈推荐;

- 构建用户-职位评分矩阵(0-1评分,1表示申请行为);

- 优化参数(Rank=50, Lambda=0.01, Iterations=10)。

- 内容推荐算法:

- 使用BERT模型提取简历与岗位描述的语义向量;

- 通过余弦相似度计算匹配度,阈值设为0.75。

- 混合策略:

- 加权融合(协同过滤权重0.6,内容推荐权重0.4);

- 结合Spark Streaming实现分钟级推荐更新。

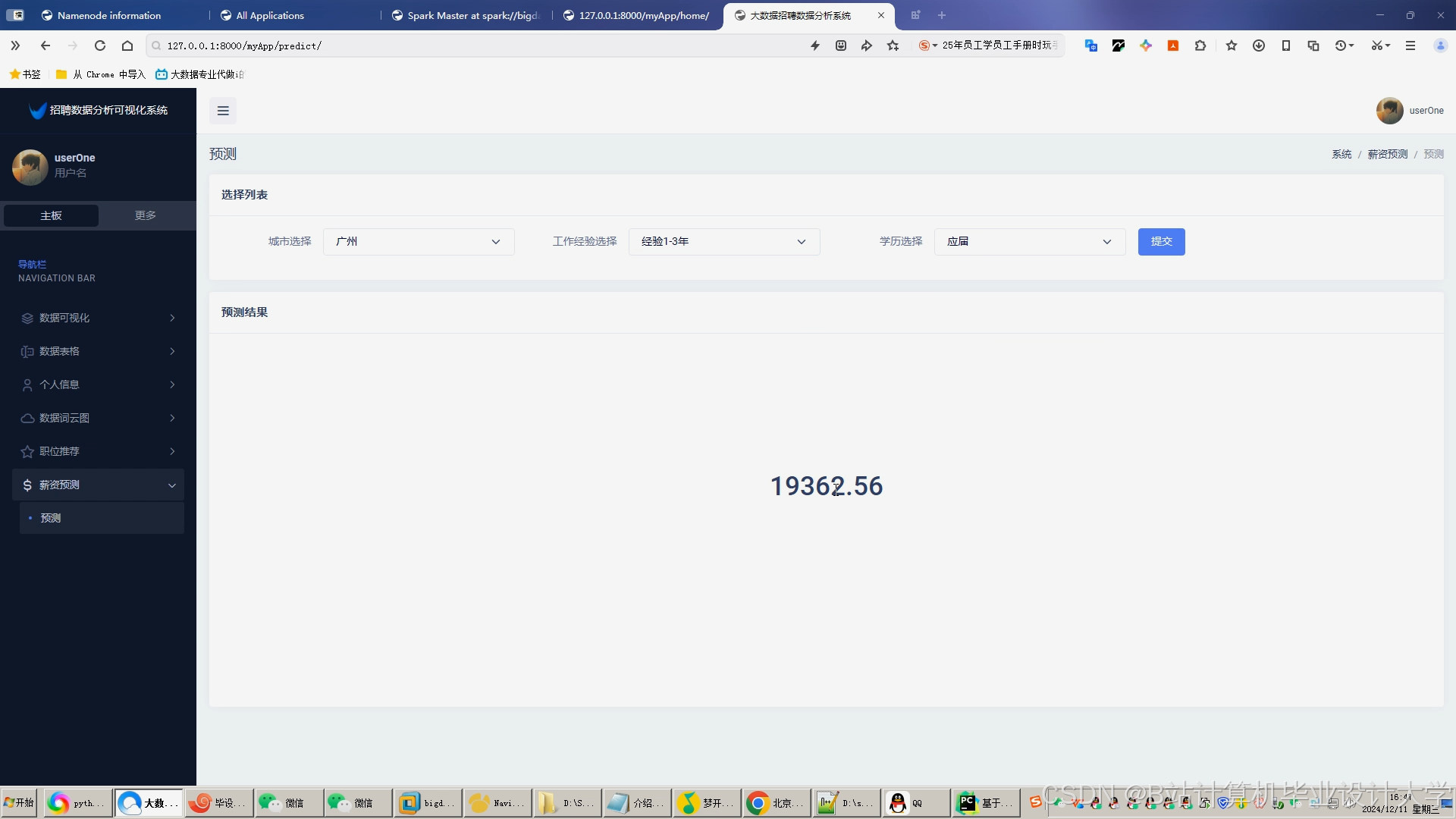

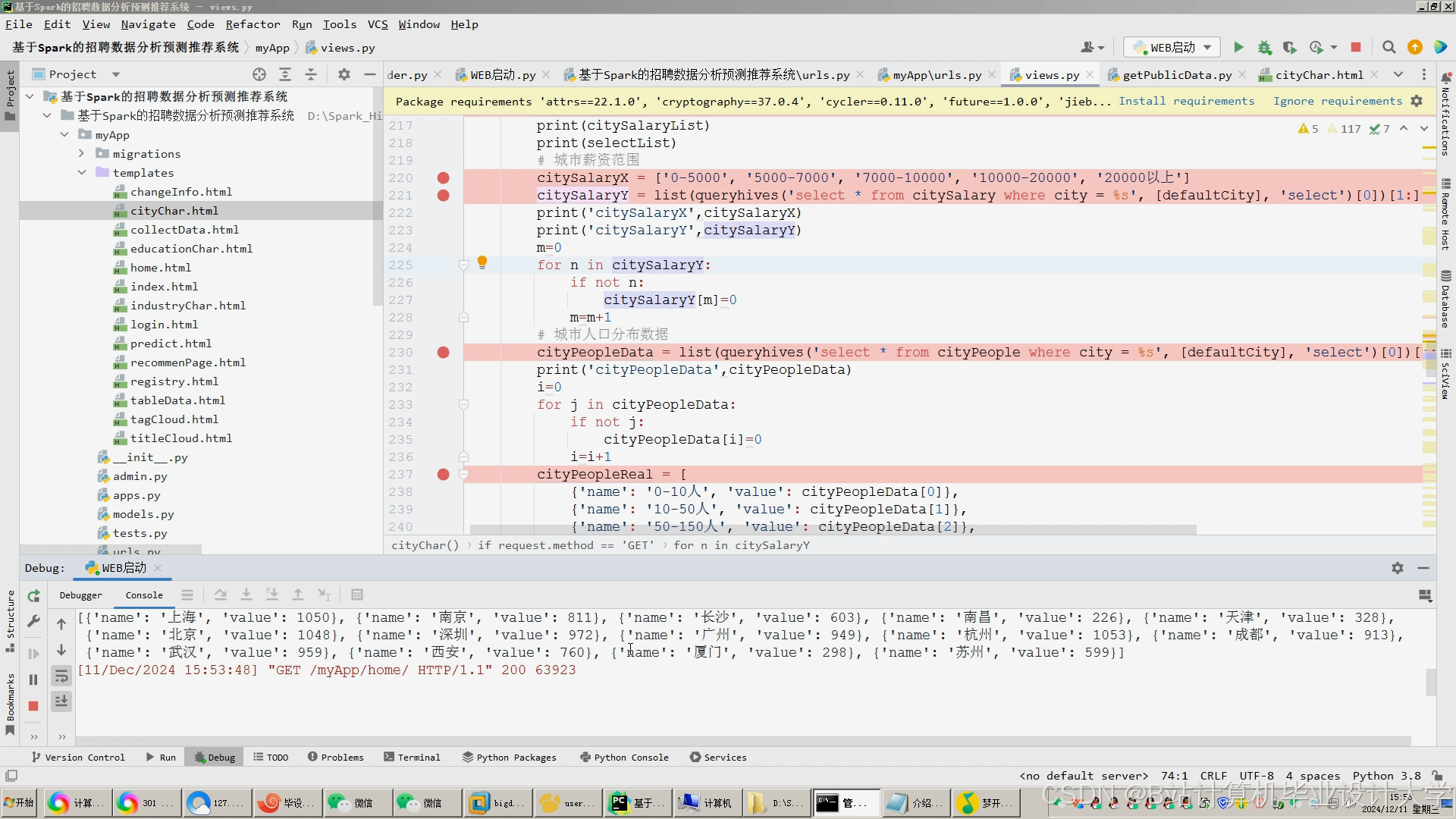

2.4 薪资预测与可视化(负责人:分析组)

- 薪资预测模型:

- 特征选择:行业、工作地点、技能需求数量、岗位竞争度(供需比);

- 模型训练:XGBoost回归模型,测试集MSE=0.02,R²=0.85;

- 动态调整:通过Spark Streaming实时更新市场特征。

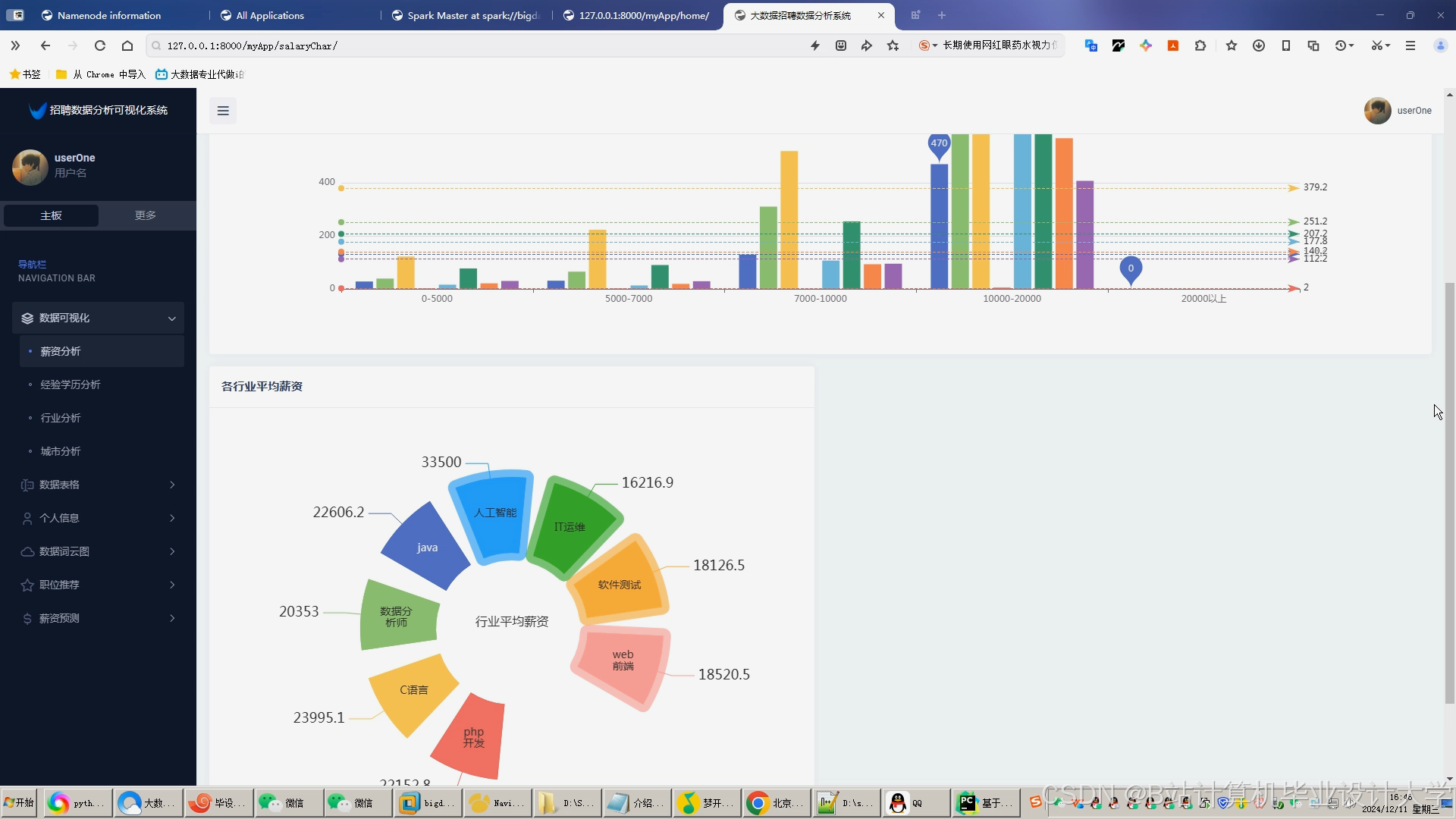

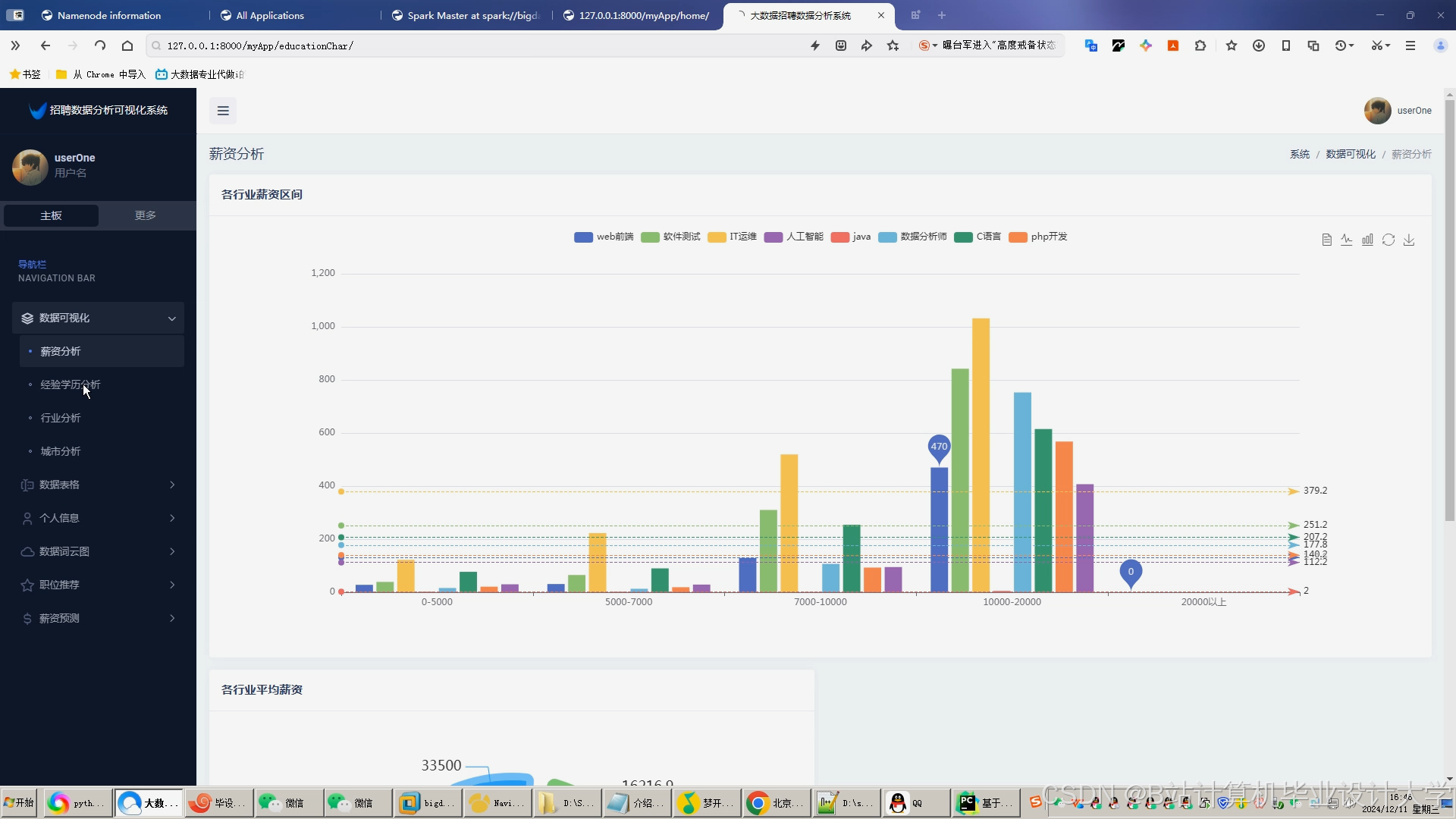

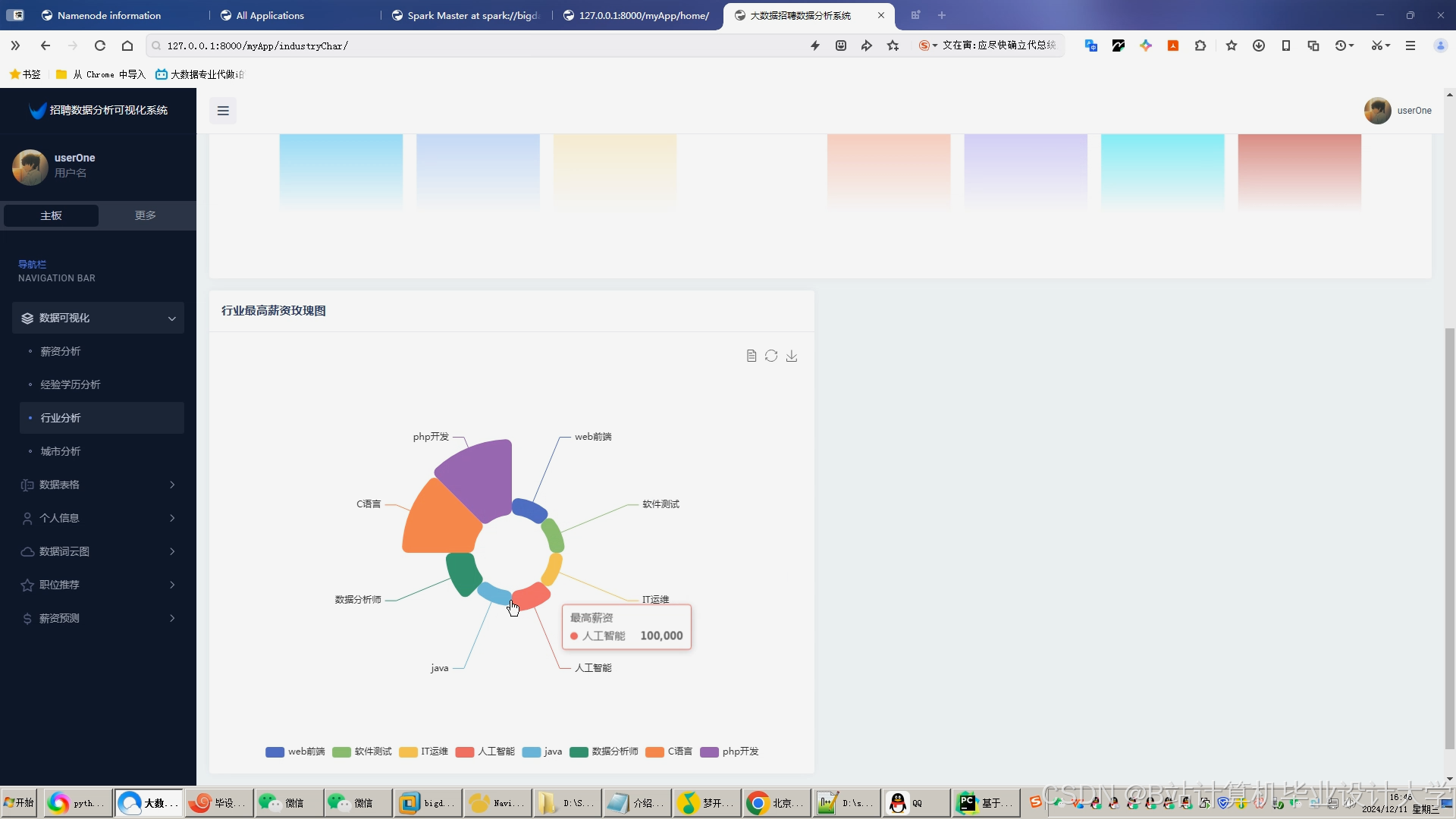

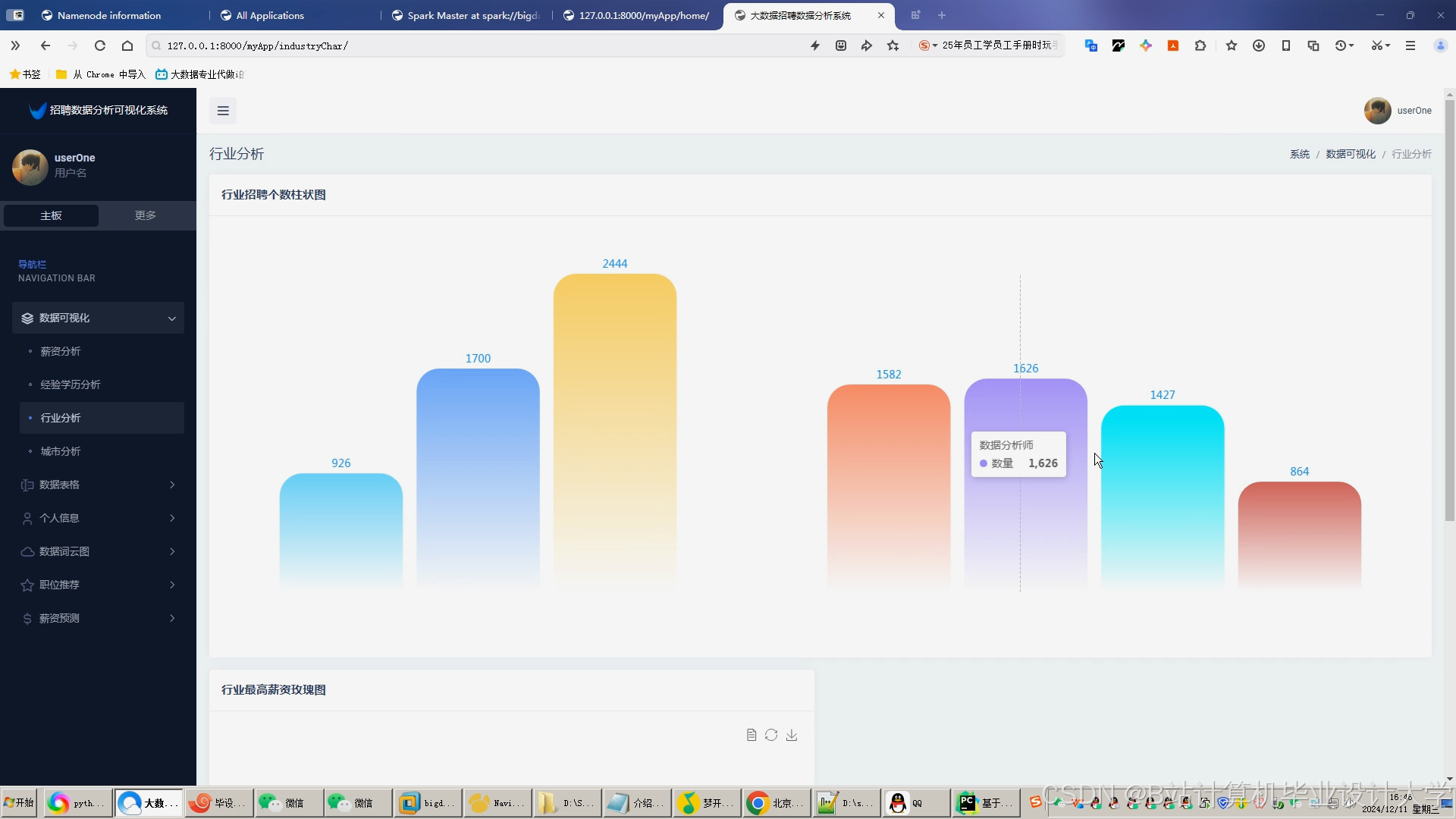

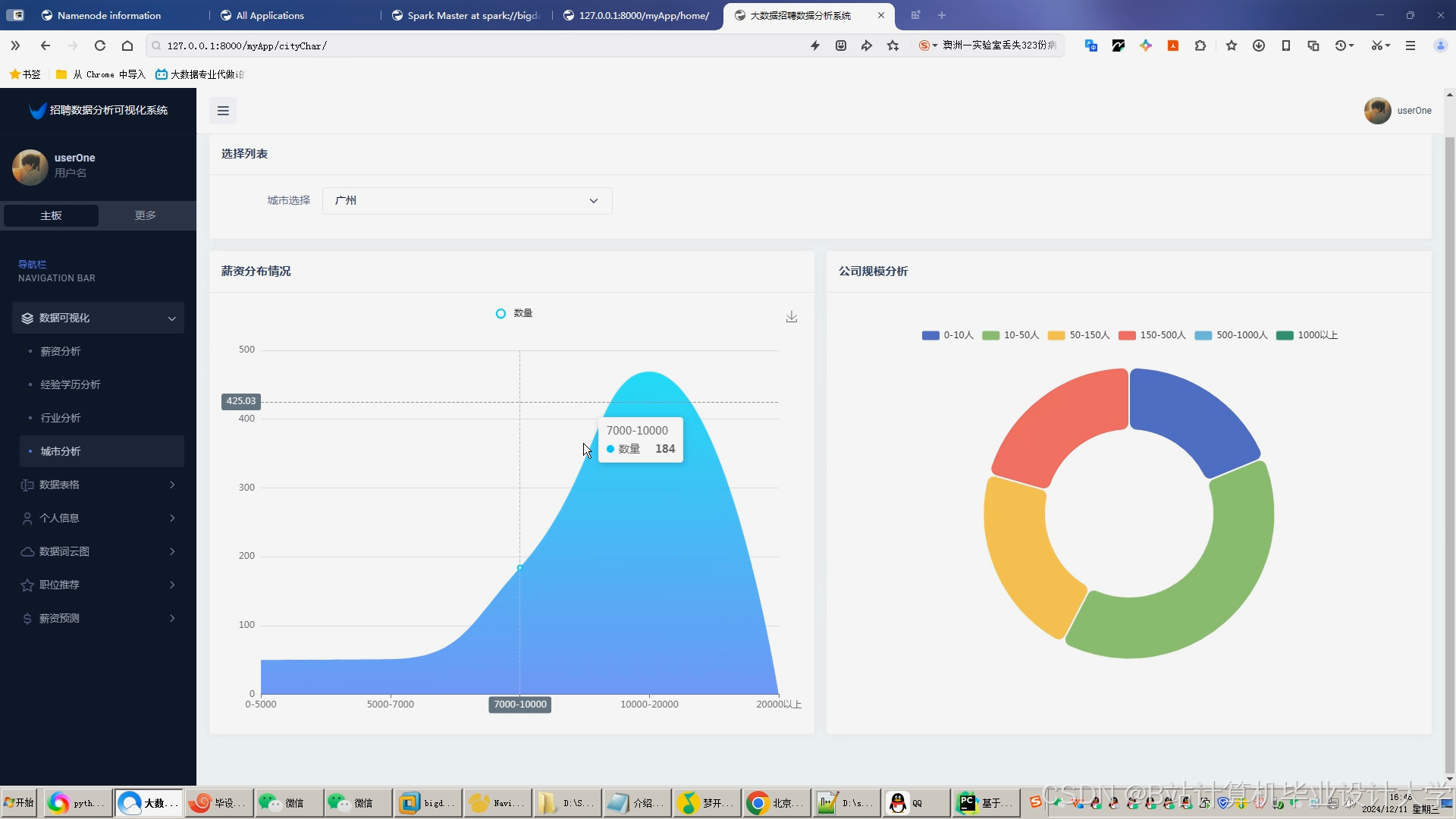

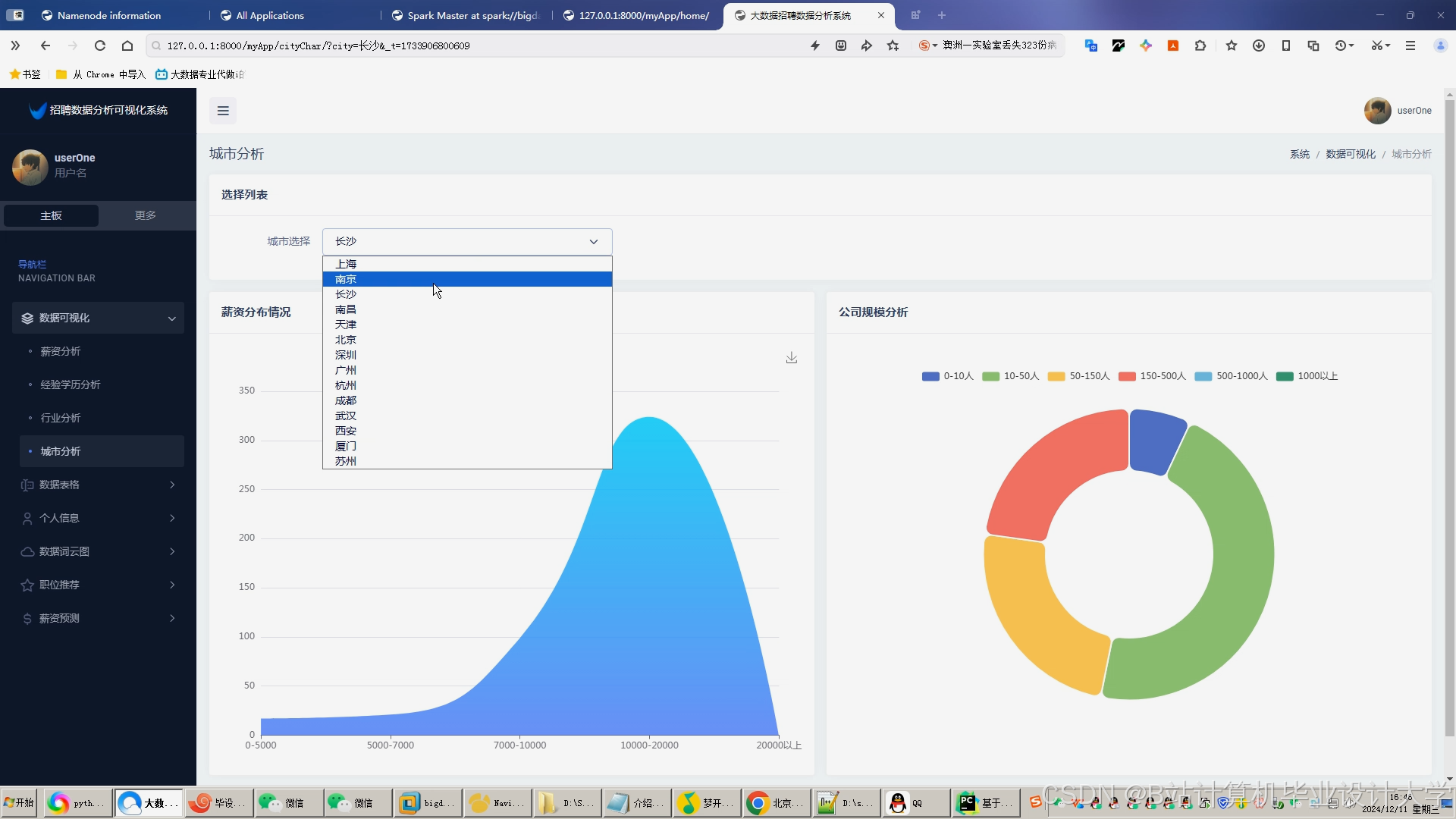

- 可视化分析:

- 岗位分布热力图:ECharts展示不同地区的职位数量与类型;

- 行业趋势折线图:Hive分析岗位供需变化(如某行业岗位竞争度年增长20%);

- 用户画像雷达图:分析求职者技能匹配度与薪资期望偏差。

2.5 系统集成与测试(负责人:开发组)

- 系统架构:

- 数据层:HDFS+Hive+HBase;

- 计算层:Spark(批处理)+ Spark Streaming(实时处理);

- 应用层:Flask API(推荐服务)+ ECharts(可视化)。

- 测试方案:

- 功能测试:验证数据采集、存储、推荐、预测流程;

- 性能测试:模拟100万用户请求,测试推荐响应时间(目标<500ms);

- A/B测试:对比混合推荐与单一算法的准确率、召回率。

三、任务进度安排

| 阶段 | 时间 | 任务 |

|---|---|---|

| 需求分析 | 2025.07-2025.08 | 完成文献调研、技术选型,确定系统功能模块 |

| 系统设计 | 2025.09-2025.10 | 设计数据架构、算法流程、API接口,完成数据库ER图与系统架构图 |

| 系统实现 | 2025.11-2026.02 | 开发数据采集、存储、推荐、预测与可视化模块,完成单元测试 |

| 系统测试 | 2026.03-2026.04 | 集成测试、性能测试、A/B测试,优化系统参数(如ALS算法Rank值) |

| 项目验收 | 2026.05-2026.06 | 撰写项目报告、技术文档,完成系统部署与用户培训 |

四、资源需求

- 硬件资源:

- 服务器:4台(配置:16核CPU、64GB内存、2TB硬盘);

- 集群:Hadoop+Spark+Hive伪分布式环境(开发测试用)。

- 软件资源:

- 操作系统:CentOS 7.6;

- 开发工具:IntelliJ IDEA、PyCharm、Postman;

- 大数据组件:Hadoop 3.3.4、Spark 3.3.2、Hive 3.1.3、HBase 2.4.11;

- 可视化工具:ECharts 5.4.3。

- 数据资源:

- 招聘数据集:Kaggle招聘数据(含10万条职位与简历数据);

- 用户行为日志:模拟生成100万条浏览、点击记录。

五、风险评估与应对

| 风险 | 影响 | 应对措施 |

|---|---|---|

| 数据采集延迟 | 影响推荐实时性 | 采用Kafka缓冲日志,设置超时重试机制(最大重试3次) |

| 算法训练资源不足 | 延长开发周期 | 使用Spark动态资源分配,优先保障推荐算法训练任务 |

| 系统性能瓶颈 | 推荐响应时间超标 | 优化Hive查询(分区表+索引),启用Spark内存缓存(RDD持久化) |

| 用户行为数据稀疏 | 降低推荐准确率 | 结合内容推荐填充冷启动数据,引入用户显式反馈(如“不感兴趣”按钮) |

六、交付成果

- 系统原型:基于Hadoop+Spark+Hive的招聘推荐系统,支持日均处理千万级数据;

- 算法模型:混合推荐算法(准确率≥85%)、XGBoost薪资预测模型(R²≥0.85);

- 可视化报告:岗位分布热力图、行业趋势折线图、用户画像雷达图;

- 技术文档:系统设计文档、API接口说明、用户操作手册。

任务书制定人:XXX

日期:2025年XX月XX日

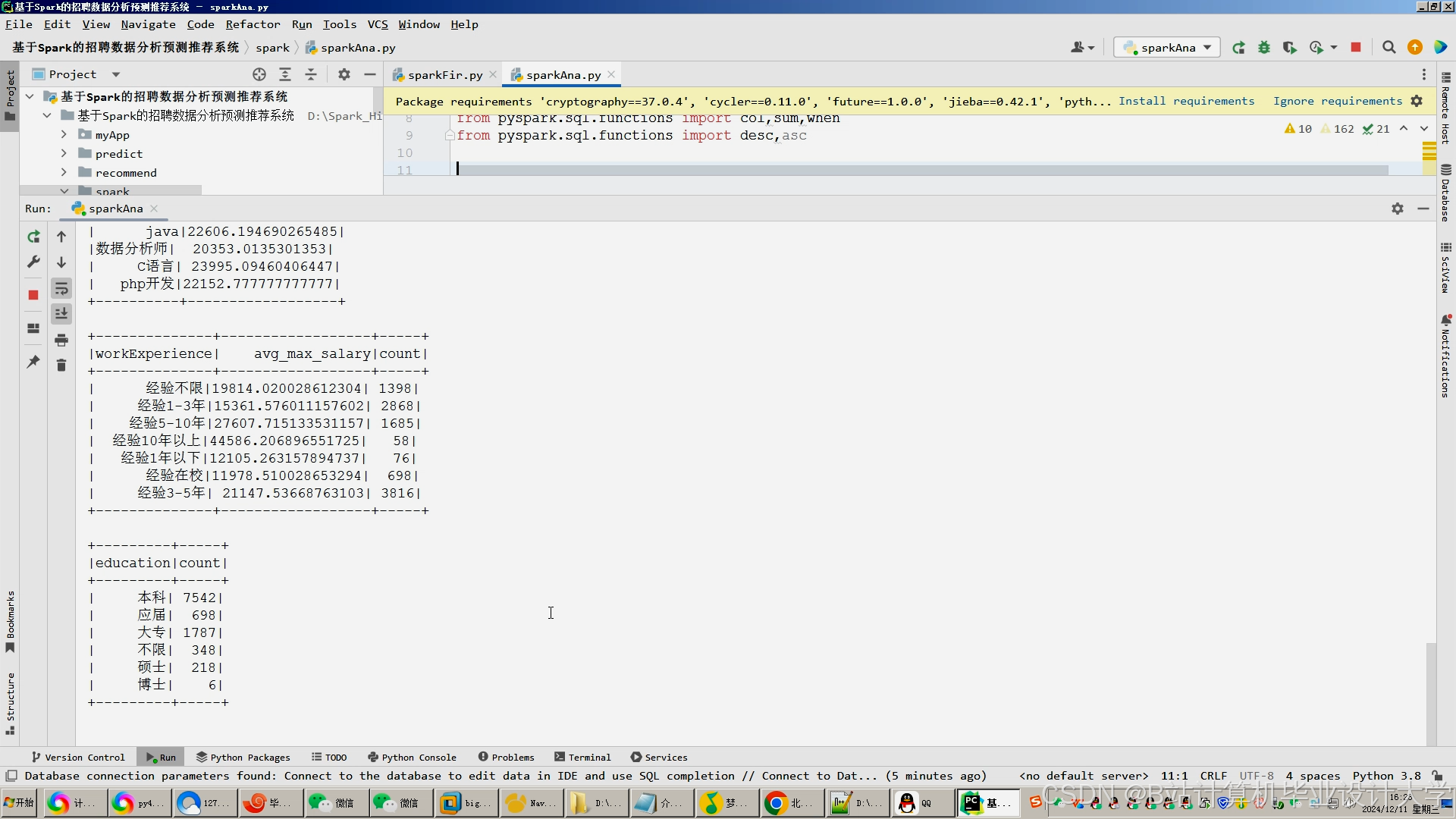

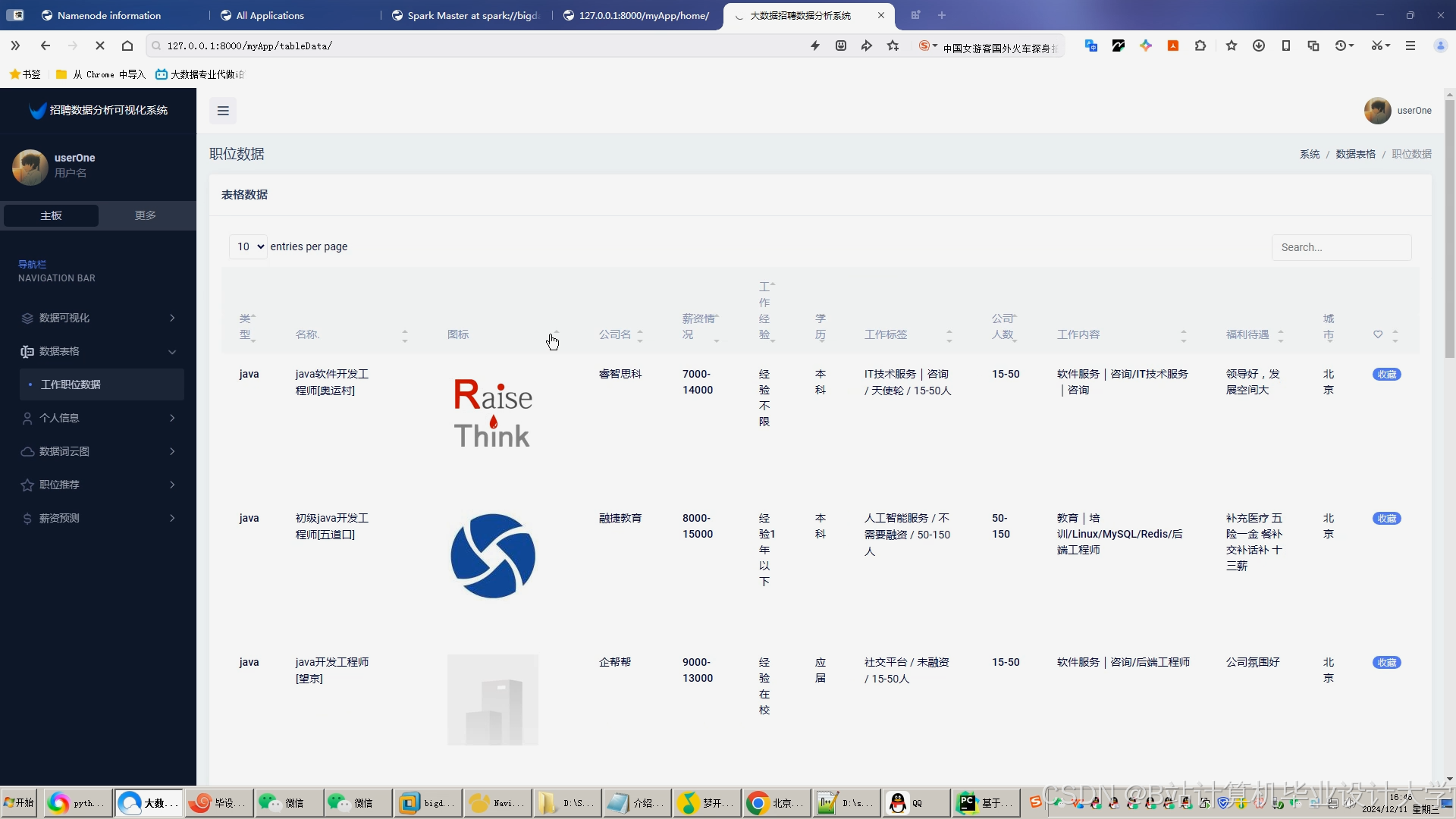

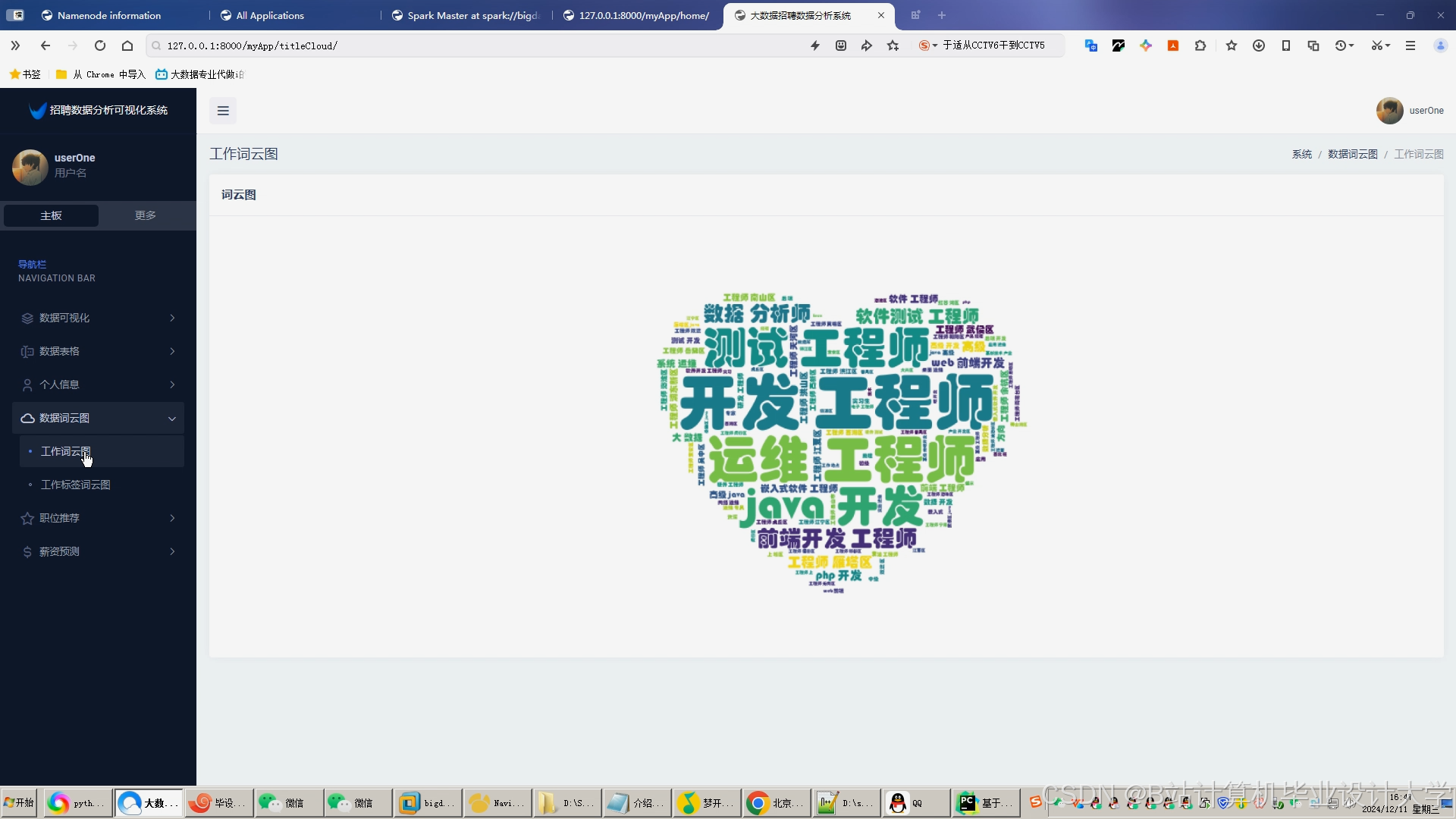

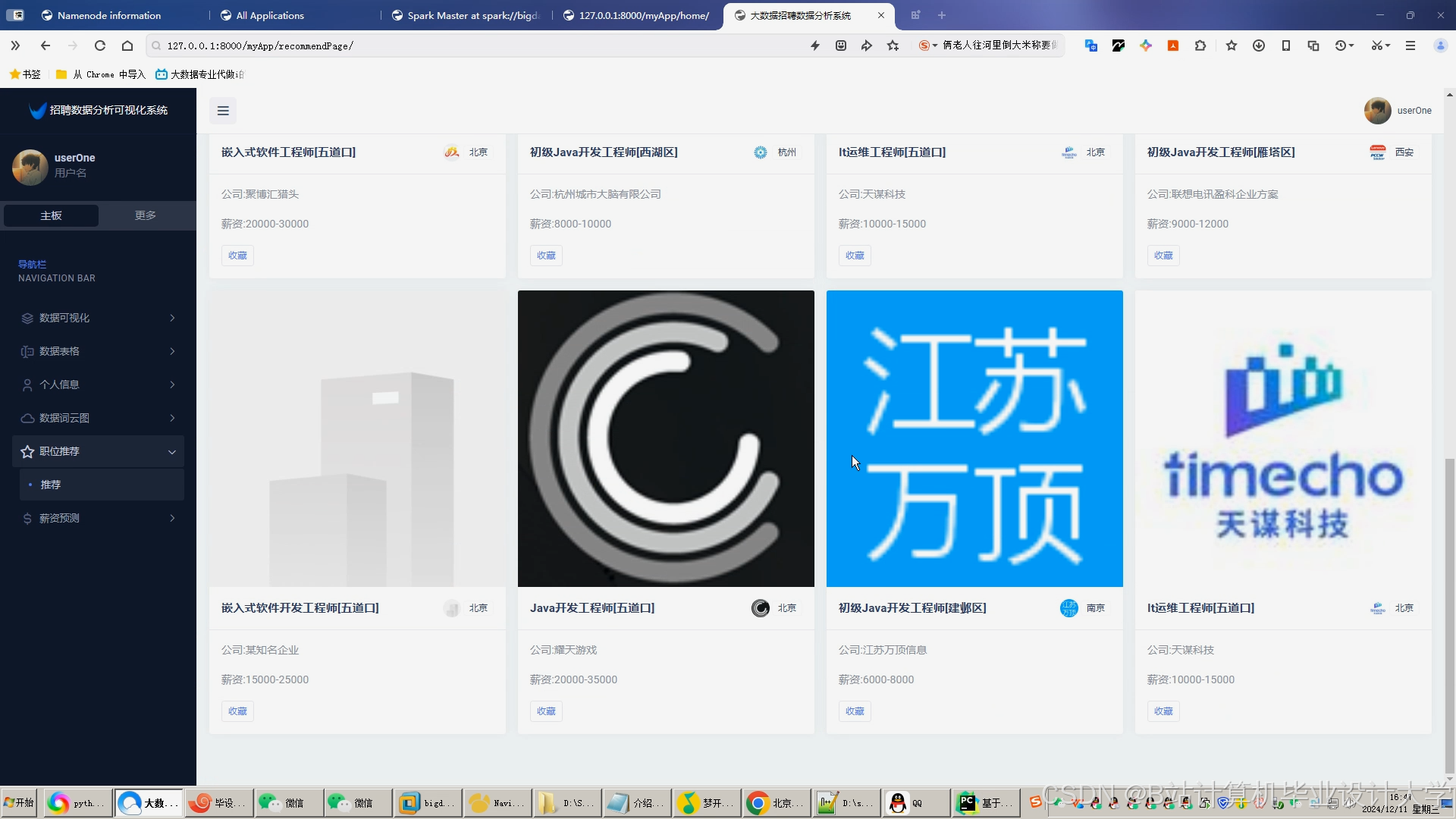

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

416

416

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?