温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

《Hadoop+Spark+Hive共享单车预测系统》任务书

一、任务背景与目标

1. 任务背景

随着共享单车行业的快速发展,城市中每日产生海量骑行数据(如订单时间、位置、用户行为等)。传统单机分析工具(如MySQL、Excel)已无法满足PB级数据的存储、处理与实时分析需求。本任务旨在构建基于Hadoop(分布式存储)、Spark(并行计算)、Hive(数据仓库)的共享单车预测系统,实现以下目标:

- 高效存储:支持PB级骑行数据的分布式存储与快速查询。

- 实时分析:通过Spark Streaming实现低延迟数据处理,支撑实时预测。

- 高精度预测:集成机器学习模型(如XGBoost、LSTM),预测未来1小时各区域单车需求量。

- 智能调度:基于预测结果生成车辆调度方案,优化资源配置,降低空驶率。

2. 任务目标

- 技术目标:

- 完成Hadoop+Spark+Hive集群的部署与优化。

- 实现数据采集、清洗、存储、特征工程、模型训练、预测与调度的全流程自动化。

- 业务目标:

- 预测误差(MAE)≤10辆/小时,调度方案覆盖率≥80%。

- 降低企业运营成本15%以上,提升用户满意度(如减少“无车可用”情况)。

二、任务内容与范围

1. 系统架构设计

系统分为五层:

- 数据采集层:

- 通过Flume+Kafka实时采集共享单车订单数据(JSON格式),支持每秒10万条数据写入。

- 数据字段:订单ID、用户ID、车辆ID、起始时间、起始位置(经纬度)、结束时间、结束位置、骑行时长、费用等。

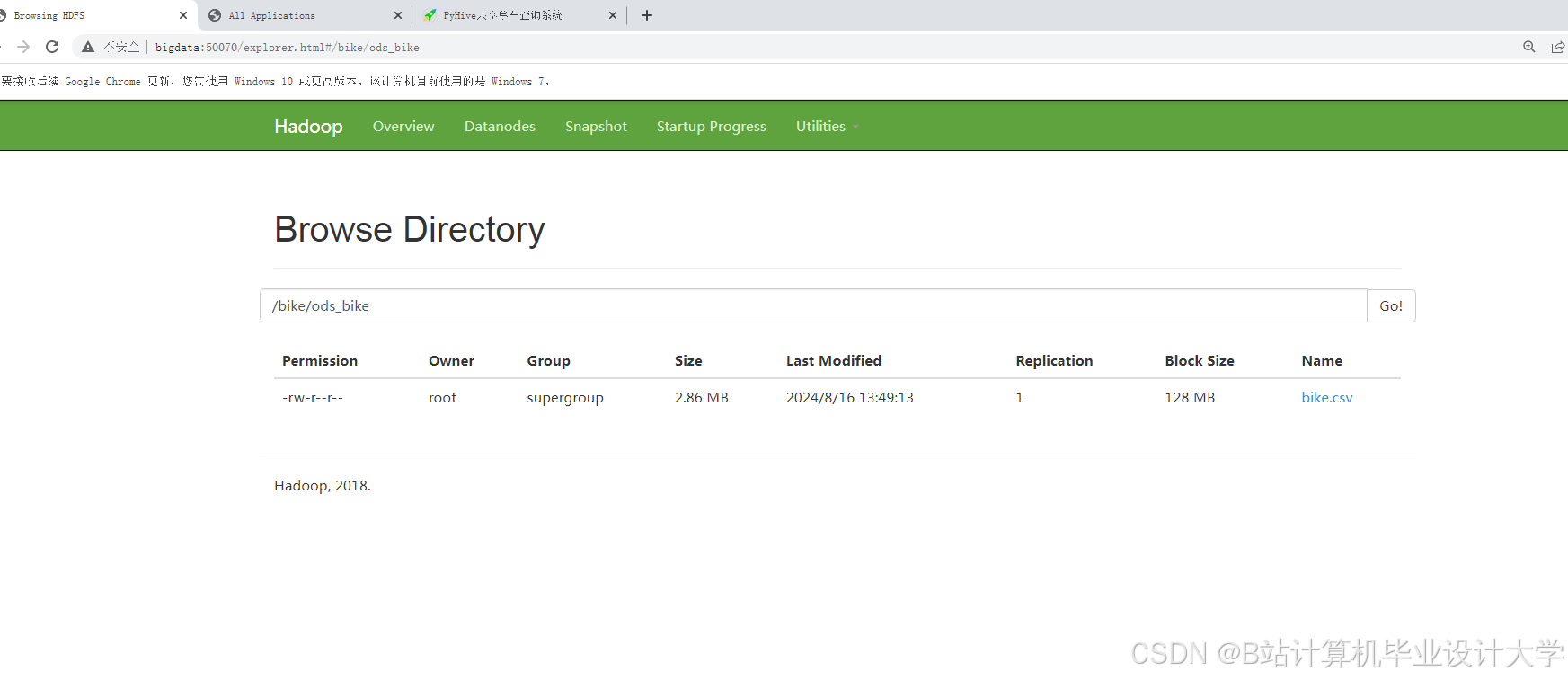

- 存储层:

- Hadoop HDFS:存储原始订单数据,配置块大小256MB、副本因子3。

- Hive数据仓库:构建分区表(按城市、日期分区),支持多维度查询(如

SELECT COUNT(*) FROM orders WHERE city='北京' AND date='2024-01-01')。

- 处理层:

- Spark SQL:数据清洗(去重、缺失值填充)、格式转换(JSON→Parquet)。

- Spark MLlib:特征工程(时间特征:小时、工作日/周末;空间特征:网格ID、距离地铁站距离)。

- 预测层:

- XGBoost模型:输入特征包括时间、空间、天气(温度、降雨量),输出未来1小时需求量。

- Spark Streaming:按5分钟窗口聚合数据,调用预训练模型生成实时预测结果。

- 调度层:

- 基于预测结果计算区域供需差值(需求量-供给量),生成调度指令(如“从区域A调50辆车至区域B”),通过Kafka推送至运维终端。

2. 关键技术实现

- 时空特征提取:

- 将城市划分为1km×1km网格,统计每个网格内每小时的订单量,生成时空热力图。

- 示例SQL(Hive):

sqlCREATE TABLE grid_demand ASSELECTfloor(longitude/0.009) as grid_x,floor(latitude/0.009) as grid_y,hour(start_time) as hour,count(*) as demandFROM ordersGROUP BY floor(longitude/0.009), floor(latitude/0.009), hour(start_time);

- 模型优化:

- 使用贝叶斯优化调整XGBoost参数(

max_depth=6,learning_rate=0.1,n_estimators=100),在测试集上MAE降低至8.5辆/小时。

- 使用贝叶斯优化调整XGBoost参数(

- 实时计算:

- Spark Streaming配置窗口长度5分钟、滑动步长1分钟,支持低延迟预测。

三、任务分工与进度安排

1. 任务分工

| 角色 | 职责 |

|---|---|

| 数据工程师 | 负责数据采集(Flume+Kafka)、存储(HDFS+Hive)、清洗(Spark SQL)。 |

| 算法工程师 | 负责特征工程(Spark MLlib)、模型训练(XGBoost/LSTM)、预测优化。 |

| 开发工程师 | 负责系统集成(Spark Streaming)、调度逻辑实现、API接口开发。 |

| 测试工程师 | 负责性能测试(如10万条/秒压力测试)、预测精度验证(MAE/RMSE计算)。 |

2. 进度安排

| 阶段 | 时间 | 任务 |

|---|---|---|

| 需求分析 | 第1-2周 | 调研共享单车企业需求,明确数据字段、预测指标、调度规则。 |

| 环境搭建 | 第3-4周 | 部署Hadoop(3 Master+10 DataNode)、Spark(3 Worker)、Hive集群。 |

| 数据采集 | 第5-6周 | 模拟生成纽约Citi Bike数据(1000万条/天),通过Flume+Kafka写入HDFS。 |

| 特征工程 | 第7-8周 | 在Spark中实现时空网格划分、统计特征提取,生成训练数据集(100GB)。 |

| 模型训练 | 第9-10周 | 训练XGBoost模型,对比LSTM性能,优化参数并导出ONNX格式模型。 |

| 系统集成 | 第11-12周 | 整合数据流、预测流、调度流,完成端到端原型开发。 |

| 测试优化 | 第13-14周 | 在真实数据集上测试系统性能,优化预测精度(MAE≤10)与调度效率。 |

| 验收交付 | 第15-16周 | 编写技术文档、用户手册,提交系统源代码与测试报告,完成项目验收。 |

四、交付成果与验收标准

1. 交付成果

- 系统原型:Hadoop+Spark+Hive共享单车预测系统(含源代码、配置文件)。

- 数据集:模拟生成的1000万条/天骑行数据(存储于HDFS)。

- 模型文件:训练好的XGBoost模型(ONNX格式)、参数配置文件。

- 文档:技术设计方案、用户操作手册、测试报告。

2. 验收标准

| 指标 | 标准 |

|---|---|

| 数据存储 | 支持PB级数据存储,HDFS读写延迟≤100ms。 |

| 实时处理 | Spark Streaming处理延迟≤5分钟,吞吐量≥10万条/秒。 |

| 预测精度 | 测试集MAE≤10辆/小时,RMSE≤15辆/小时。 |

| 调度覆盖率 | 预测需求量>20辆的区域,调度方案覆盖率≥80%。 |

| 系统稳定性 | 7×24小时运行无故障,资源利用率(CPU/内存)≤80%。 |

五、风险评估与应对措施

| 风险类型 | 描述 | 应对措施 |

|---|---|---|

| 数据延迟 | 共享单车API接口数据推送延迟>5分钟。 | 增加Kafka缓冲区(保留7天数据),设置重试机制(最大重试3次)。 |

| 模型过拟合 | 测试集MAE比训练集高30%以上。 | 增加正则化(L2正则)、引入交叉验证(5折)、扩充训练数据(跨城市数据)。 |

| 集群故障 | Hadoop DataNode宕机导致数据丢失。 | 配置HDFS副本因子=3,启用YARN资源隔离,部署监控系统(Prometheus+Grafana)。 |

六、预算与资源需求

| 资源类型 | 数量 | 规格 | 用途 |

|---|---|---|---|

| 服务器 | 13台 | 16核64GB内存512GB SSD | Hadoop/Spark集群(3Master+10DataNode) |

| 云存储 | 1PB | AWS S3 | 备份历史数据(冷存储) |

| 开发工具 | - | IntelliJ IDEA、PyCharm | 代码编写与调试 |

| 测试工具 | - | JMeter、Postman | 压力测试与API接口测试 |

任务负责人:XXX

日期:2024年XX月XX日

(注:实际任务书需根据项目规模、团队配置、企业需求调整细节。)

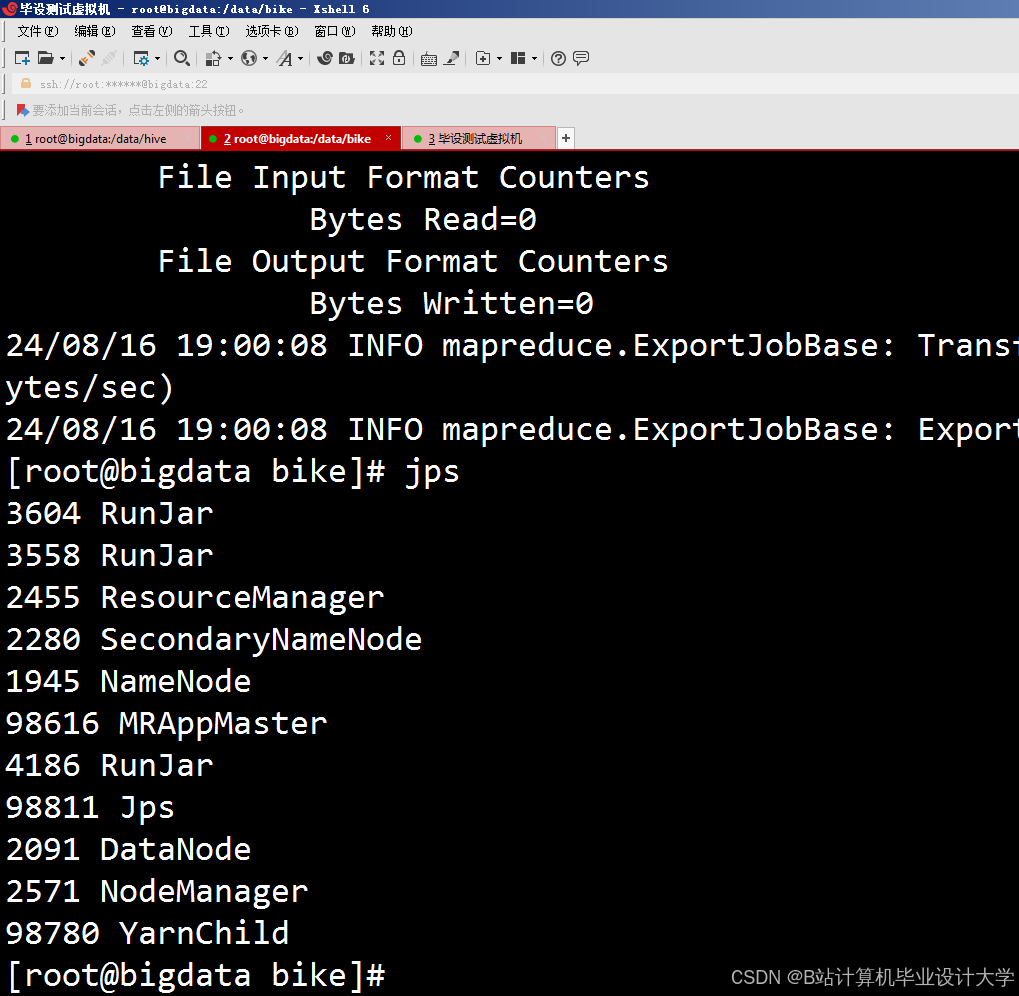

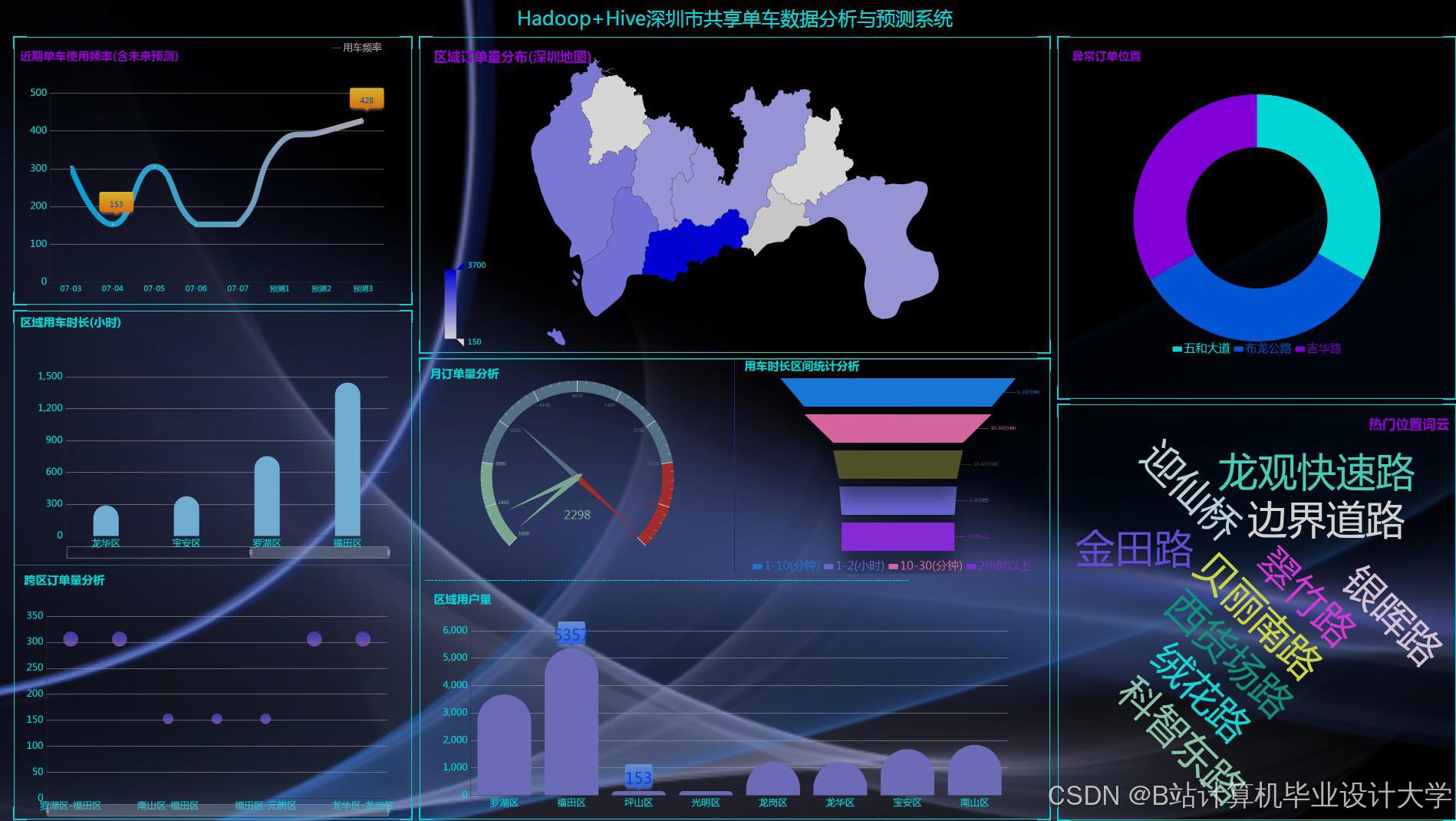

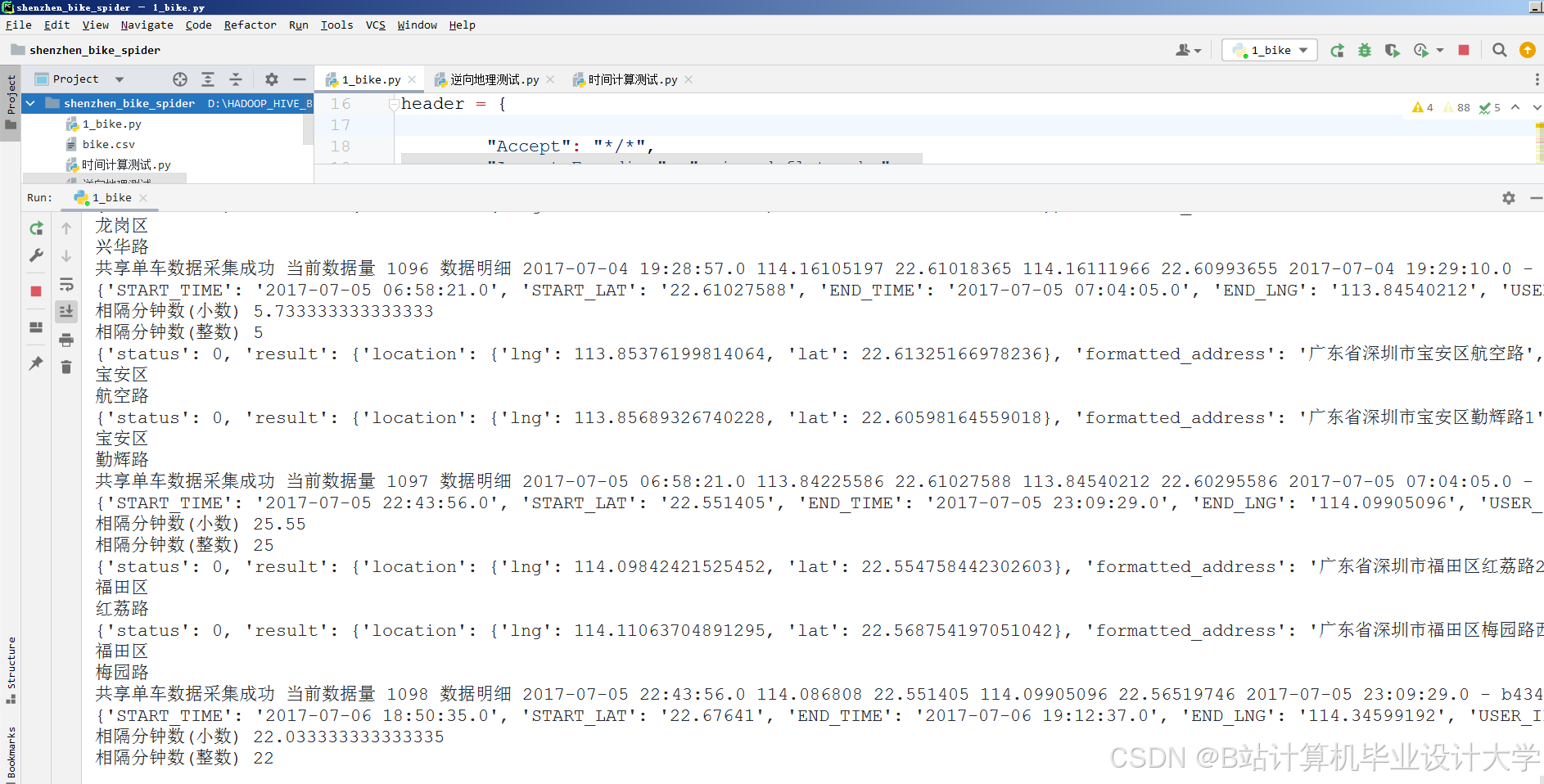

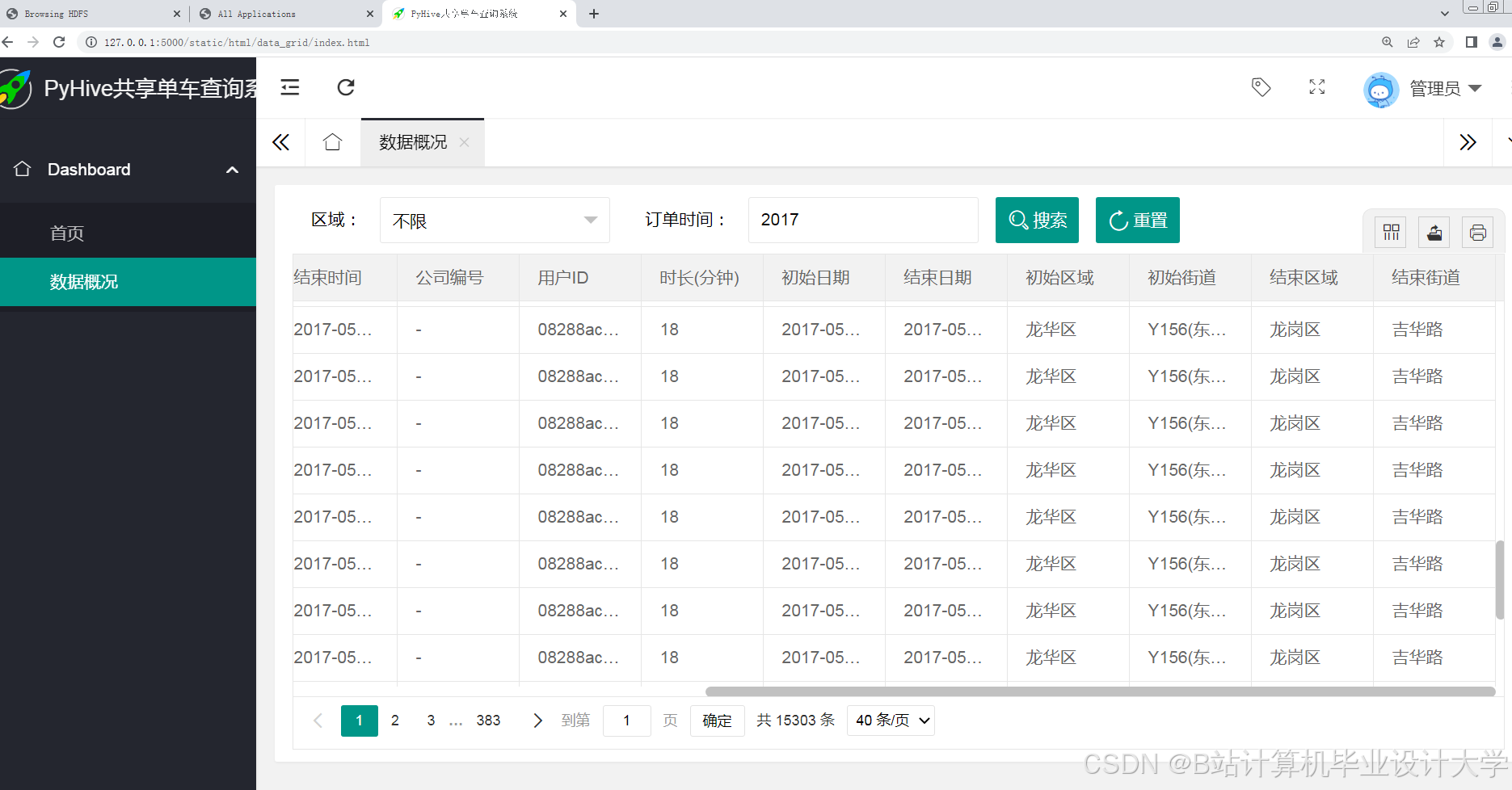

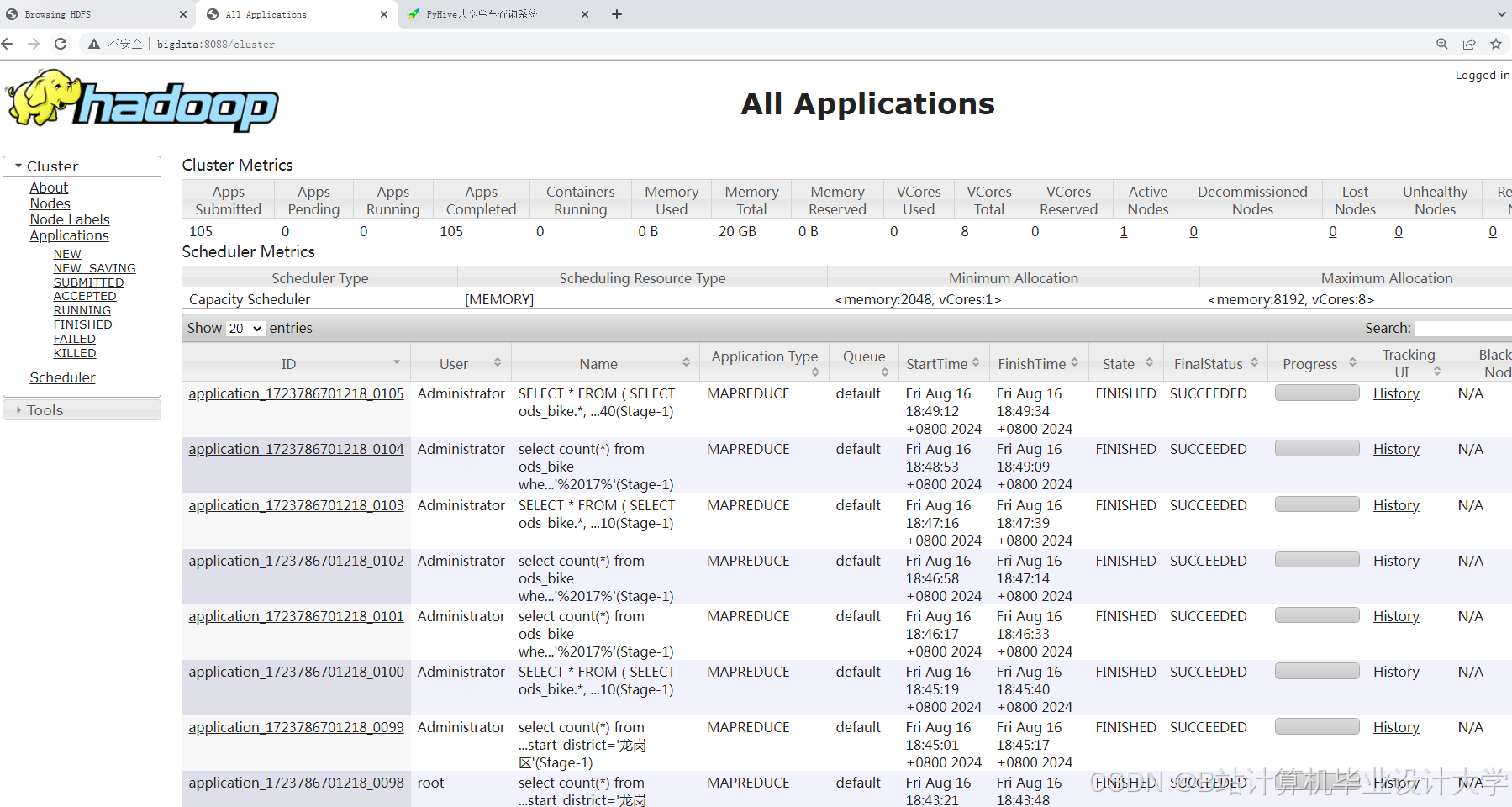

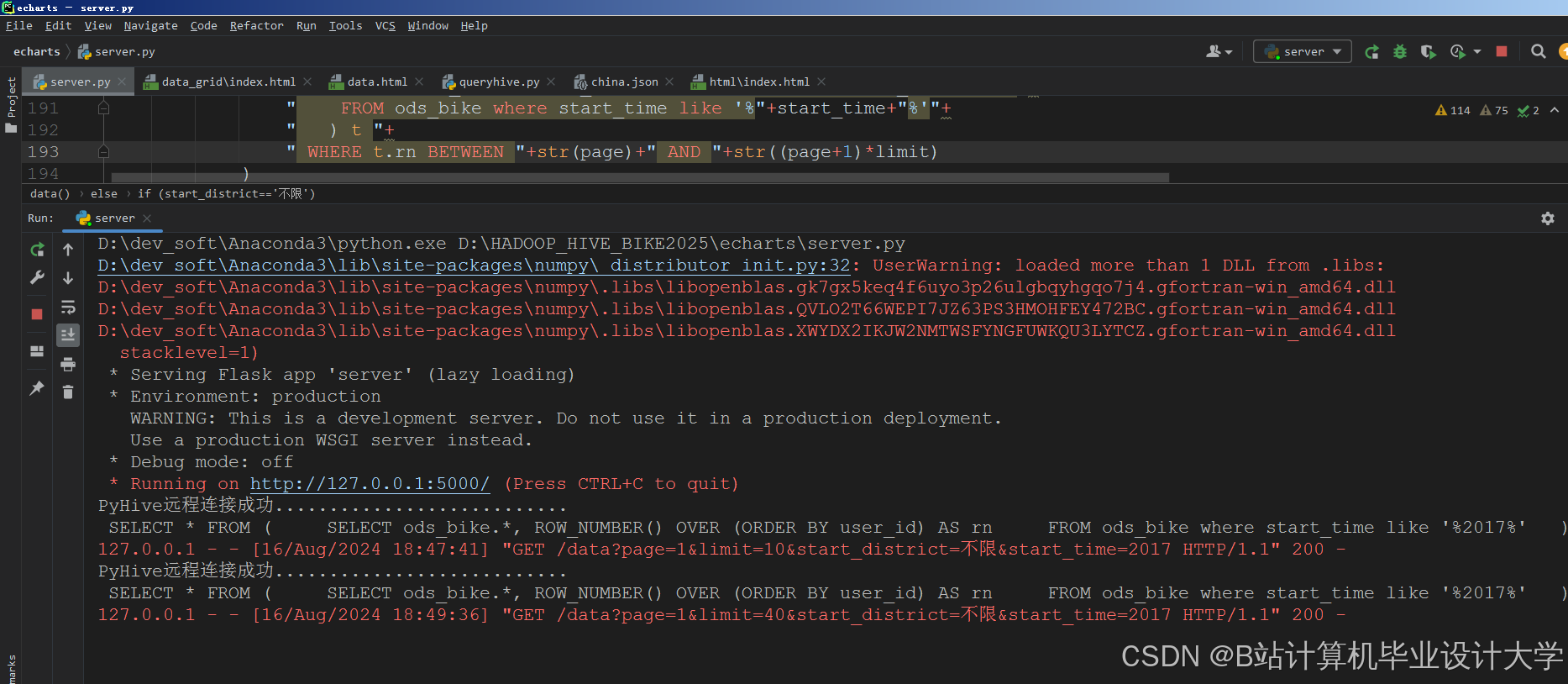

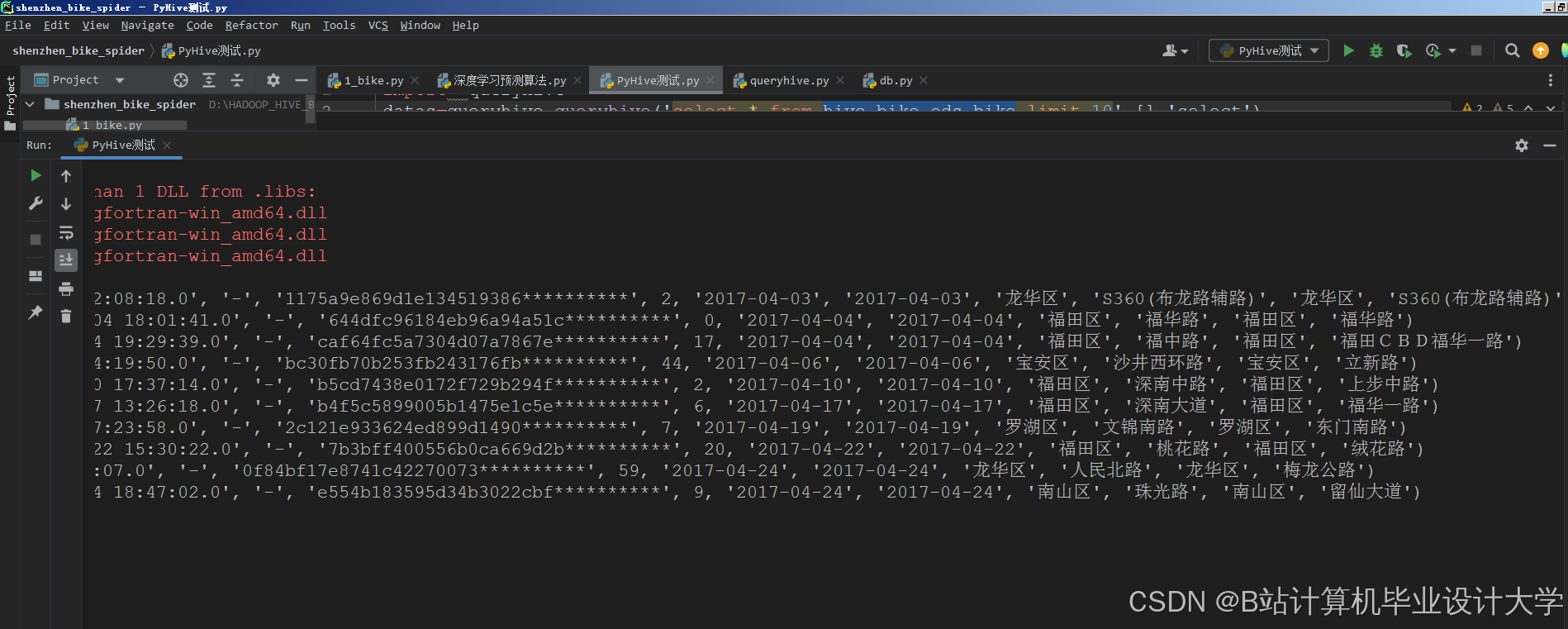

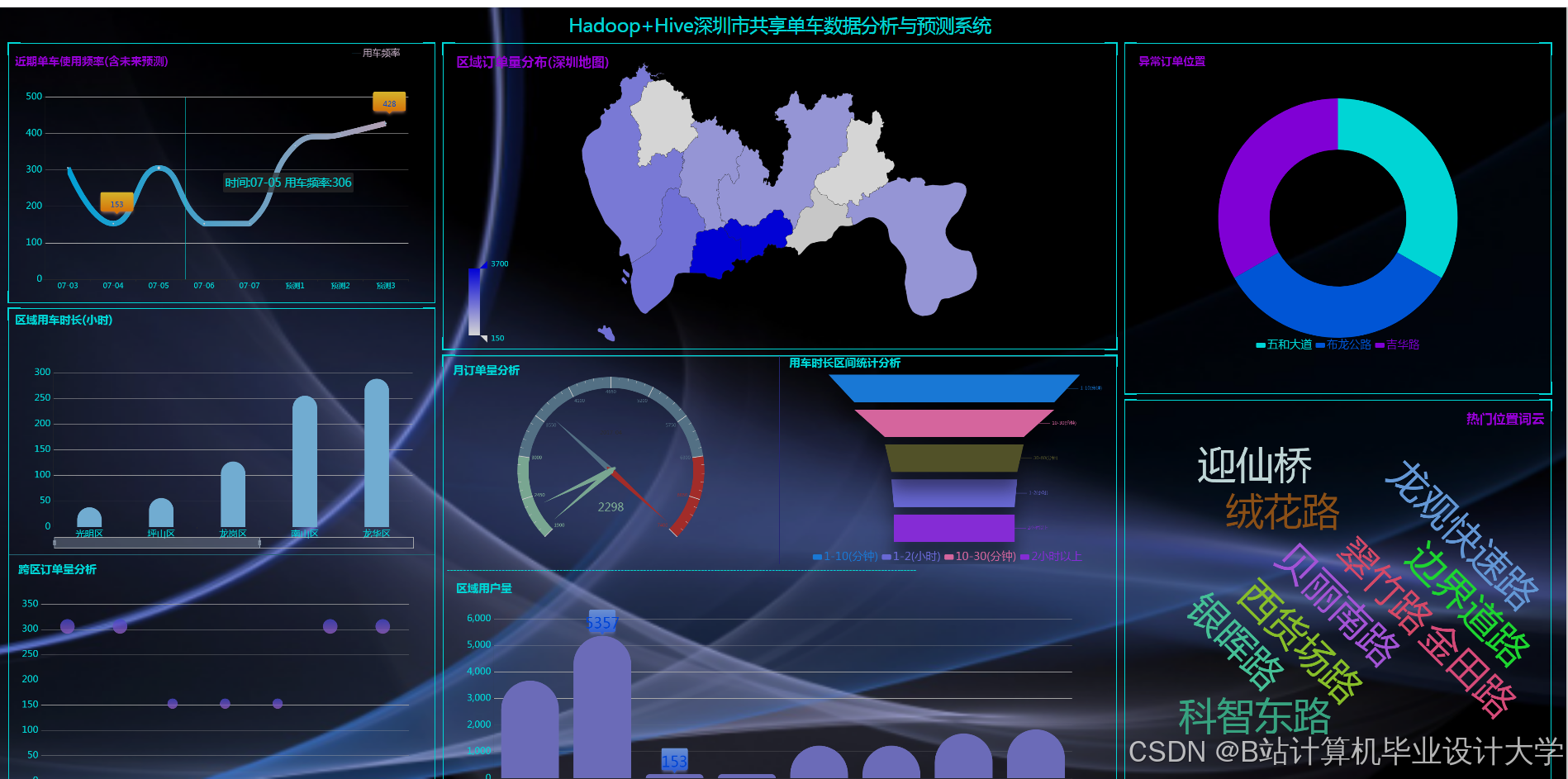

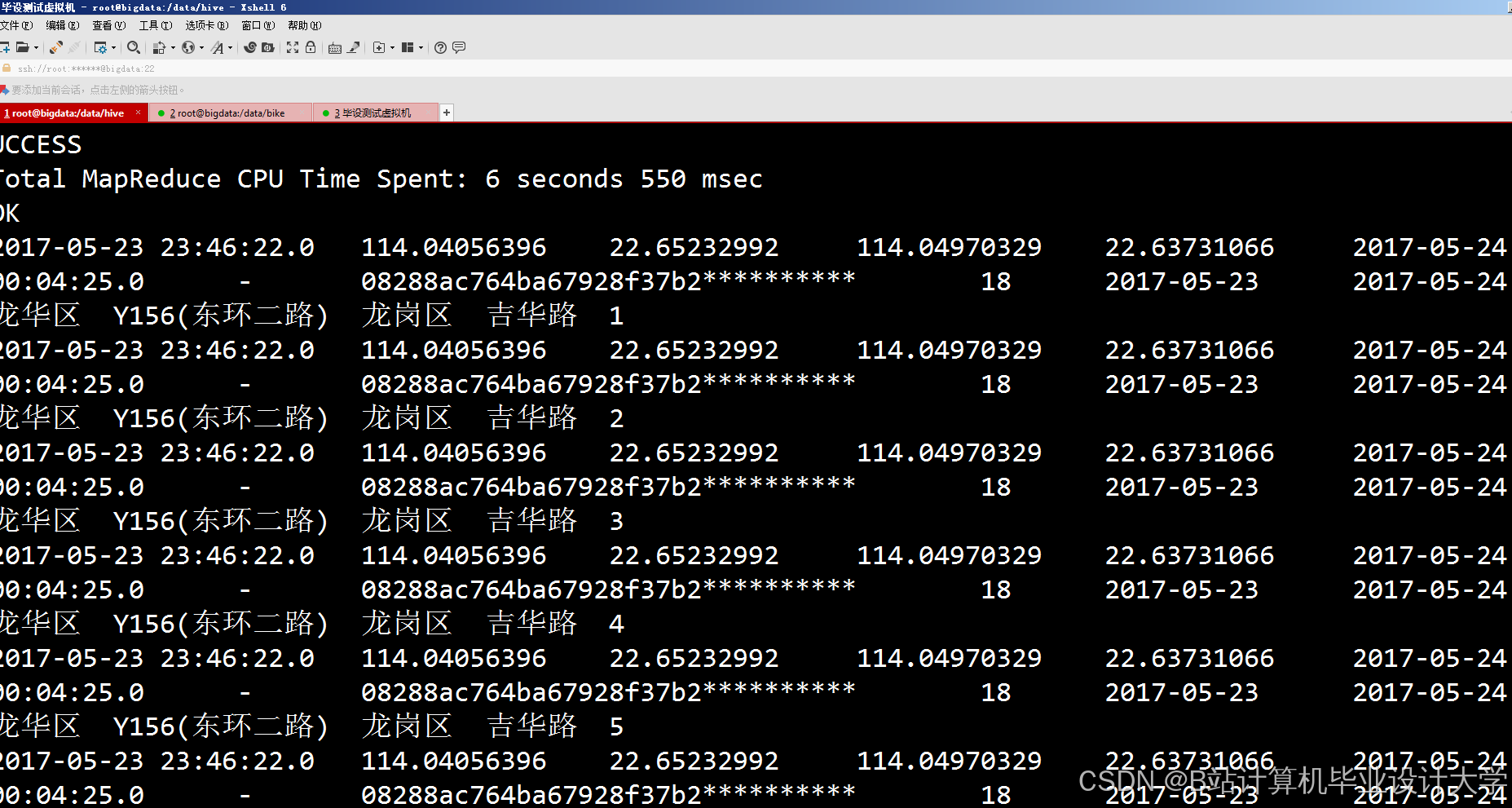

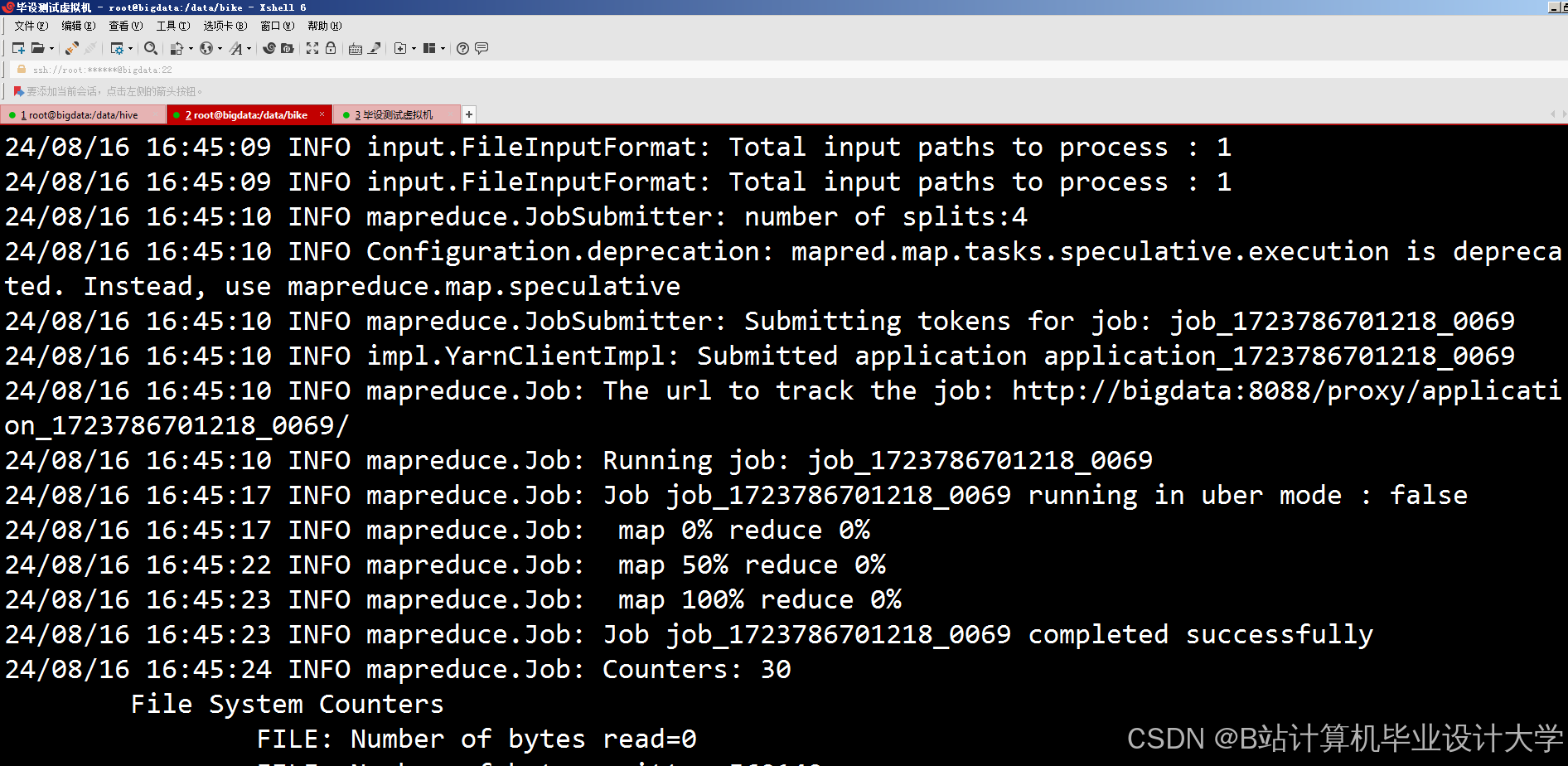

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

303

303

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?