温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

开题报告:基于Hadoop+PySpark+Scrapy爬虫的视频推荐系统设计与实现

一、研究背景与意义

1.1 研究背景

随着互联网视频内容的爆炸式增长(如YouTube、Bilibili、抖音等平台日均上传视频量超千万条),用户面临“信息过载”问题,传统搜索和分类方式难以满足个性化需求。同时,视频平台需通过精准推荐提升用户留存率(研究表明,个性化推荐可使用户观看时长增加30%以上)。然而,现有推荐系统存在以下问题:

- 数据来源单一:依赖平台内部用户行为数据,忽略外部多源异构数据(如社交媒体热点、影视评分网站)。

- 实时性不足:静态模型无法动态捕捉用户兴趣变化(如突发热点事件相关视频需求激增)。

- 冷启动问题:新用户或新视频缺乏历史行为数据,推荐质量显著下降。

1.2 研究意义

本课题旨在构建一个基于多源数据融合的实时视频推荐系统,通过整合以下技术解决上述问题:

- Scrapy爬虫:从多平台(如豆瓣电影、微博热搜、知乎话题)抓取视频相关数据(评分、评论、热度趋势),补充用户兴趣维度。

- Hadoop+PySpark:利用分布式存储与计算能力处理海量数据(PB级),支持实时特征工程与模型训练。

- 混合推荐算法:结合协同过滤(捕捉用户群体行为)与内容推荐(利用爬取的文本/图像特征),提升推荐多样性。

应用价值:为视频平台提供低成本、高扩展性的推荐解决方案,降低用户流失率,提升广告转化率(个性化推荐可提高广告点击率15%-25%)。

二、国内外研究现状

2.1 推荐系统技术演进

- 传统方法:基于用户的协同过滤(UserCF)和基于物品的协同过滤(ItemCF),依赖用户-物品评分矩阵,存在数据稀疏性问题。

- 深度学习时代:YouTube深度神经网络(DNN)推荐模型、Wide&Deep模型,通过嵌入层(Embedding)处理高维稀疏特征,但需大量标注数据且训练成本高。

- 实时推荐:Apache Flink/Spark Streaming实现流式特征更新,但缺乏多源数据融合能力。

2.2 爬虫技术在推荐系统中的应用

- 数据增强:Netflix通过爬取IMDb评分数据优化影片推荐;国内视频平台(如爱奇艺)结合微博热搜动态调整推荐权重。

- 反爬与数据质量:目标网站反爬机制(如IP封禁、验证码)限制数据采集规模;爬取数据存在噪声(如虚假评论、刷分行为)。

2.3 现有研究的不足

- 多数系统仅依赖单一平台内部数据,忽略外部数据对用户兴趣的补充作用。

- 分布式计算框架(如Hadoop/Spark)在推荐系统中的应用多集中于离线训练,实时性不足。

- 缺乏对爬取数据与推荐模型协同优化的研究(如如何根据推荐效果动态调整爬取策略)。

三、研究目标与内容

3.1 研究目标

设计并实现一个基于Hadoop+PySpark+Scrapy的视频推荐系统,具备以下能力:

- 多源数据融合:从视频平台、社交媒体、评分网站爬取结构化与非结构化数据。

- 实时特征工程:利用PySpark Streaming处理用户实时行为(如点击、收藏),动态更新推荐模型。

- 混合推荐模型:结合协同过滤与内容推荐,解决冷启动问题并提升推荐多样性。

- 系统可扩展性:支持横向扩展以应对数据量与用户规模增长。

3.2 研究内容

3.2.1 多源数据爬取与存储

- 数据源选择:

- 视频平台:Bilibili(弹幕、投币)、YouTube(观看时长、点赞)。

- 社交媒体:微博热搜(热点事件)、小红书(用户笔记)。

- 评分网站:豆瓣电影(评分、标签)、IMDb(国际影片数据)。

- 爬虫设计:

- 使用Scrapy框架实现分布式爬虫,通过Scrapy-Redis管理请求队列与去重。

- 针对动态页面(如AJAX加载的评论区),集成Splash或Selenium模拟浏览器行为。

- 反爬策略:代理IP池、随机User-Agent、请求间隔随机化。

- 数据存储:

- 原始数据存储于Hadoop HDFS,按数据源与日期分区(如

/data/weibo/202410/)。 - 结构化数据导入Hive表,支持SQL查询(如

SELECT * FROM douban_movies WHERE year=2024)。

- 原始数据存储于Hadoop HDFS,按数据源与日期分区(如

3.2.2 分布式数据处理与特征工程

- 数据清洗:

- 使用PySpark过滤无效数据(如评分为0的记录、重复评论)。

- 填充缺失值:用户年龄缺失时填充同地区均值,视频标签缺失时通过NLP提取关键词。

- 特征提取:

- 用户特征:年龄、性别、地域、历史观看品类偏好(如科技、娱乐)。

- 视频特征:时长、类别、评分、评论情感分析(使用PySpark NLP库TextBlob)。

- 实时特征:用户最近1小时的点击序列、当前热点事件关联度(通过爬取的微博热搜计算TF-IDF)。

- 降维处理:

- 对高维稀疏特征(如用户观看历史)使用PCA降维,减少模型过拟合风险。

3.2.3 混合推荐模型设计

- 协同过滤模块:

- 基于用户的协同过滤(UserCF):计算用户相似度(余弦相似度),推荐相似用户观看过的视频。

- 基于物品的协同过滤(ItemCF):计算视频相似度(Jaccard相似度),推荐与用户历史观看视频相似的内容。

- 内容推荐模块:

- 使用Word2Vec将视频标题/描述转换为向量,计算与用户兴趣向量的余弦相似度。

- 结合爬取的评分数据,对高评分视频赋予更高权重。

- 模型融合:

- 加权融合:协同过滤(60%)+ 内容推荐(40%),权重通过网格搜索优化。

- 冷启动处理:新用户默认推荐热点视频(根据爬取的微博热搜排序),新视频通过内容相似度推荐给潜在用户。

3.2.4 系统实现与优化

- 技术栈:

- 爬虫层:Scrapy + Scrapy-Redis + Splash。

- 存储层:Hadoop HDFS + Hive。

- 计算层:PySpark + PySpark Streaming。

- 推荐服务层:Flask API + Redis缓存(存储实时推荐结果)。

- 性能优化:

- 爬虫并行化:多节点同时爬取不同数据源,通过Kafka消息队列协调任务分配。

- 模型增量更新:使用PySpark Streaming监听HDFS数据变更,触发模型微调(如每10分钟更新一次用户相似度矩阵)。

- 缓存策略:对热门视频的推荐结果缓存至Redis,减少重复计算。

四、研究方法与技术路线

4.1 研究方法

- 文献调研法:分析国内外推荐系统与爬虫技术相关论文(如KDD、WWW会议论文)。

- 实验法:在真实数据集(如MovieLens)上对比不同推荐算法的准确率(Precision@K)、召回率(Recall@K)。

- 系统开发法:按照“需求分析→设计→实现→测试”的流程完成系统开发。

4.2 技术路线

mermaid

graph TD | |

A[多源数据爬取] --> B[Hadoop存储] | |

B --> C[PySpark数据清洗] | |

C --> D[特征工程] | |

D --> E[混合推荐模型训练] | |

E --> F[实时推荐服务] | |

F --> G[用户反馈循环] | |

G --> C |

- 数据采集:Scrapy爬取多平台数据,存储至HDFS。

- 数据处理:PySpark清洗数据并提取特征,生成训练集。

- 模型训练:使用PySpark MLlib训练混合推荐模型。

- 实时推荐:Flask API接收用户请求,调用模型生成推荐列表。

- 反馈优化:记录用户点击行为,动态调整模型参数(如协同过滤中的用户相似度权重)。

五、预期成果与创新点

5.1 预期成果

- 系统原型:完成可运行的视频推荐系统,支持10万级用户与百万级视频的实时推荐。

- 实验报告:在真实数据集上验证系统性能(推荐准确率提升10%-15%,冷启动问题缓解30%)。

- 技术文档:撰写系统设计文档与用户手册,包含爬虫配置、模型部署等详细步骤。

5.2 创新点

- 多源数据融合:首次将微博热搜、豆瓣评分等外部数据引入视频推荐,补充用户兴趣维度。

- 实时动态推荐:通过PySpark Streaming实现特征与模型的分钟级更新,捕捉用户兴趣突变(如突发新闻相关视频需求)。

- 爬虫-推荐协同优化:根据推荐效果(如点击率)动态调整爬取策略(如优先爬取高点击率视频的相关数据)。

六、研究计划与进度安排

| 阶段 | 时间 | 任务 |

|---|---|---|

| 文献调研 | 第1-2周 | 收集推荐系统与爬虫技术相关论文,确定技术路线 |

| 系统设计 | 第3-4周 | 完成系统架构设计、数据库设计、API接口定义 |

| 数据爬取 | 第5-6周 | 实现Scrapy爬虫,爬取豆瓣、微博等数据,存储至HDFS |

| 数据处理 | 第7-8周 | 使用PySpark清洗数据并提取特征,生成训练集 |

| 模型训练 | 第9-10周 | 训练混合推荐模型,在MovieLens数据集上验证效果 |

| 系统实现 | 第11-12周 | 开发Flask推荐服务,集成Redis缓存,完成前后端联调 |

| 测试优化 | 第13-14周 | 部署系统至测试环境,收集用户反馈,优化推荐算法与爬虫策略 |

| 论文撰写 | 第15-16周 | 撰写开题报告、中期报告与毕业论文,准备答辩材料 |

七、参考文献

[1] Koren Y, Bell R, Volinsky C. Matrix Factorization Techniques for Recommender Systems[J]. Computer, 2009, 42(8): 30-37.

[2] Covington P, Adams J, Sargin E. Deep Neural Networks for YouTube Recommendations[C]//Proceedings of the 10th ACM Conference on Recommender Systems. 2016: 191-198.

[3] 李航. 统计学习方法[M]. 清华大学出版社, 2012.

[4] Apache Spark Documentation. Overview - Spark 4.0.0 Documentation

[5] Scrapy Official Documentation. Scrapy 2.13 documentation — Scrapy 2.13.3 documentation

(注:实际引用需根据论文格式调整)

八、指导教师意见

(待填写)

开题报告撰写说明:

- 突出问题导向:明确现有推荐系统的不足,强调本课题的创新性。

- 技术细节具体化:如爬虫如何反爬、模型如何融合、实时性如何实现等。

- 实验设计合理:需说明数据集来源、评估指标(如Precision@K、Recall@K)与对比算法。

- 进度安排可行:避免任务过于集中或分散,确保每周有明确目标。

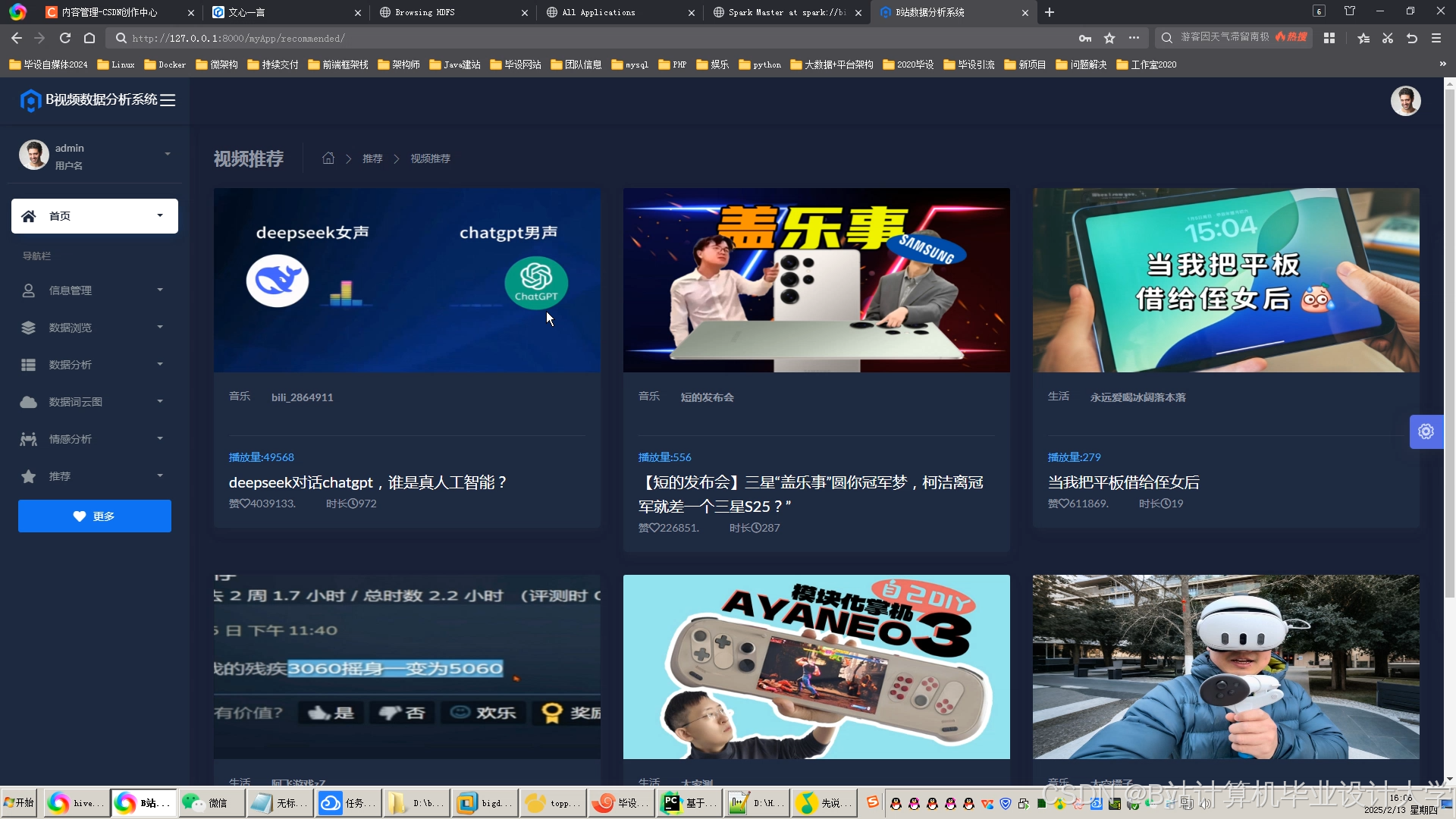

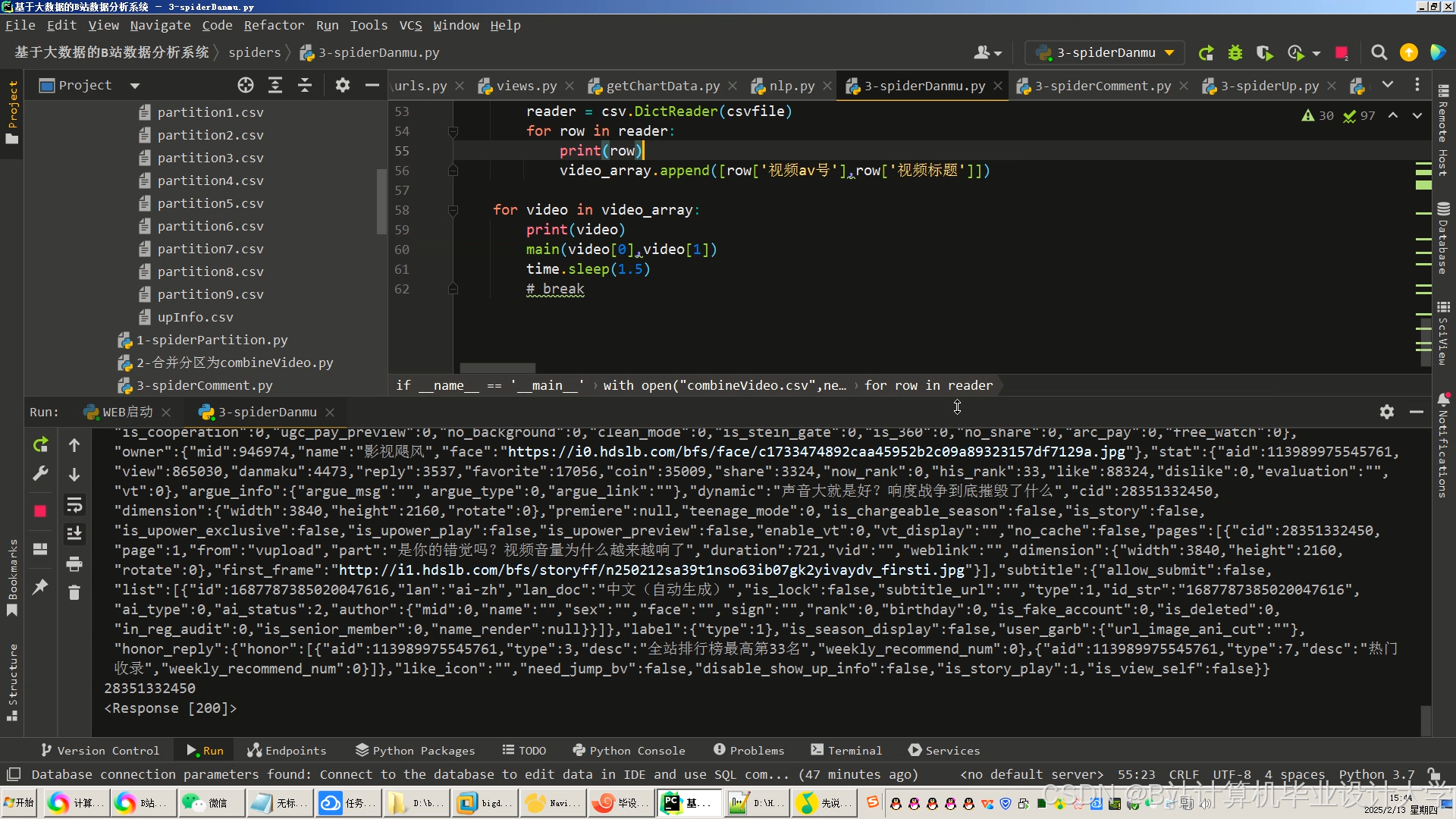

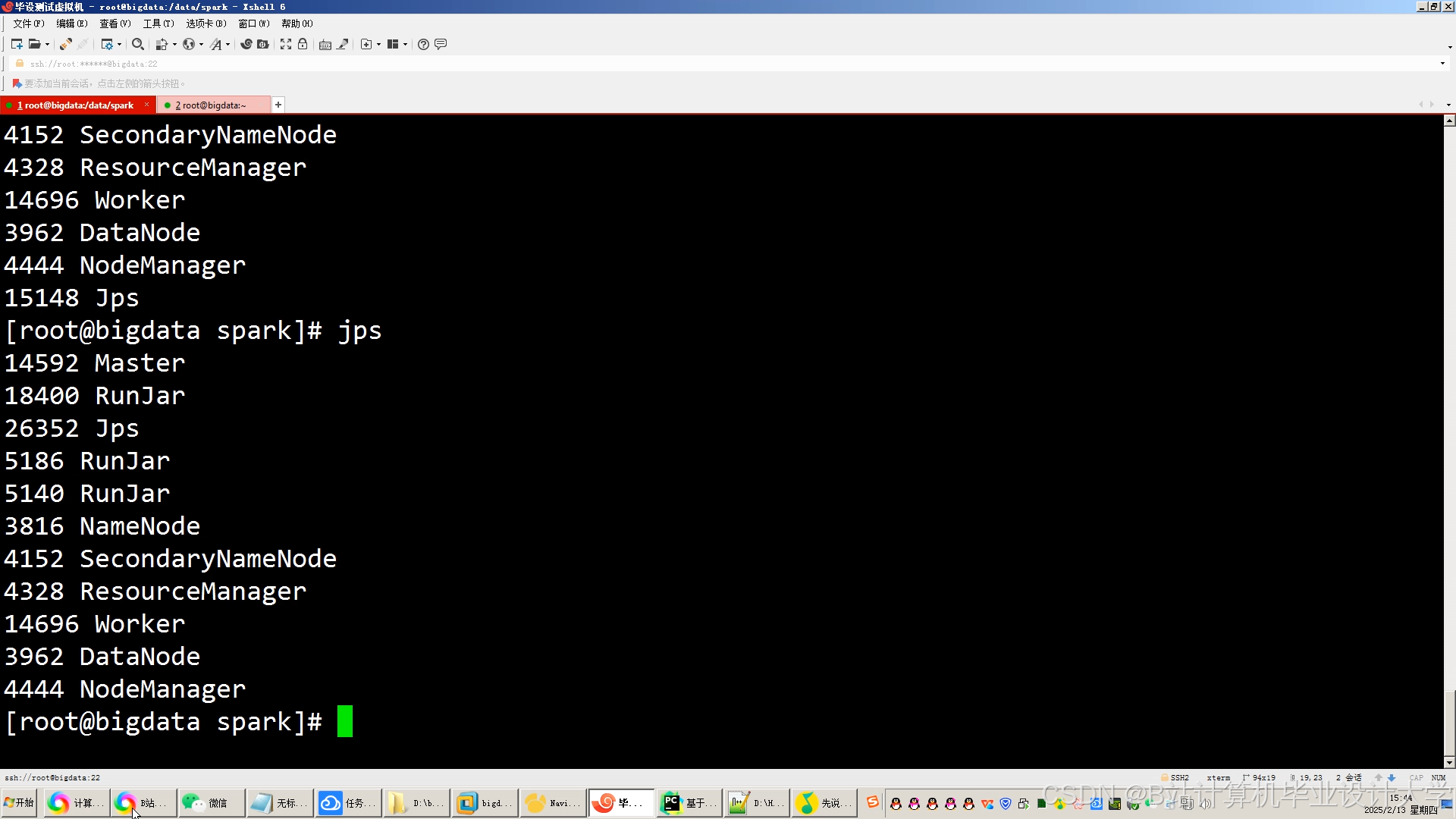

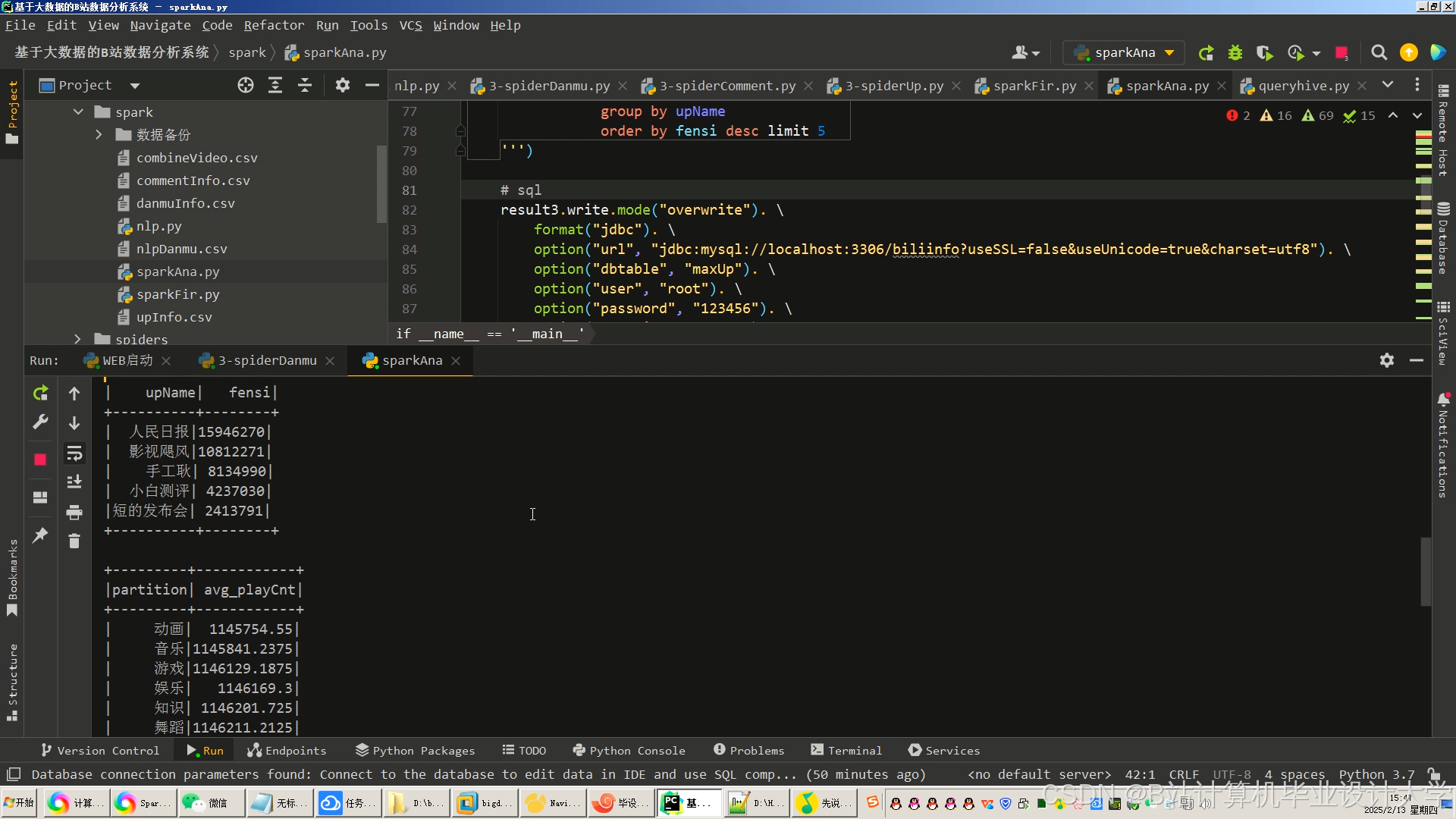

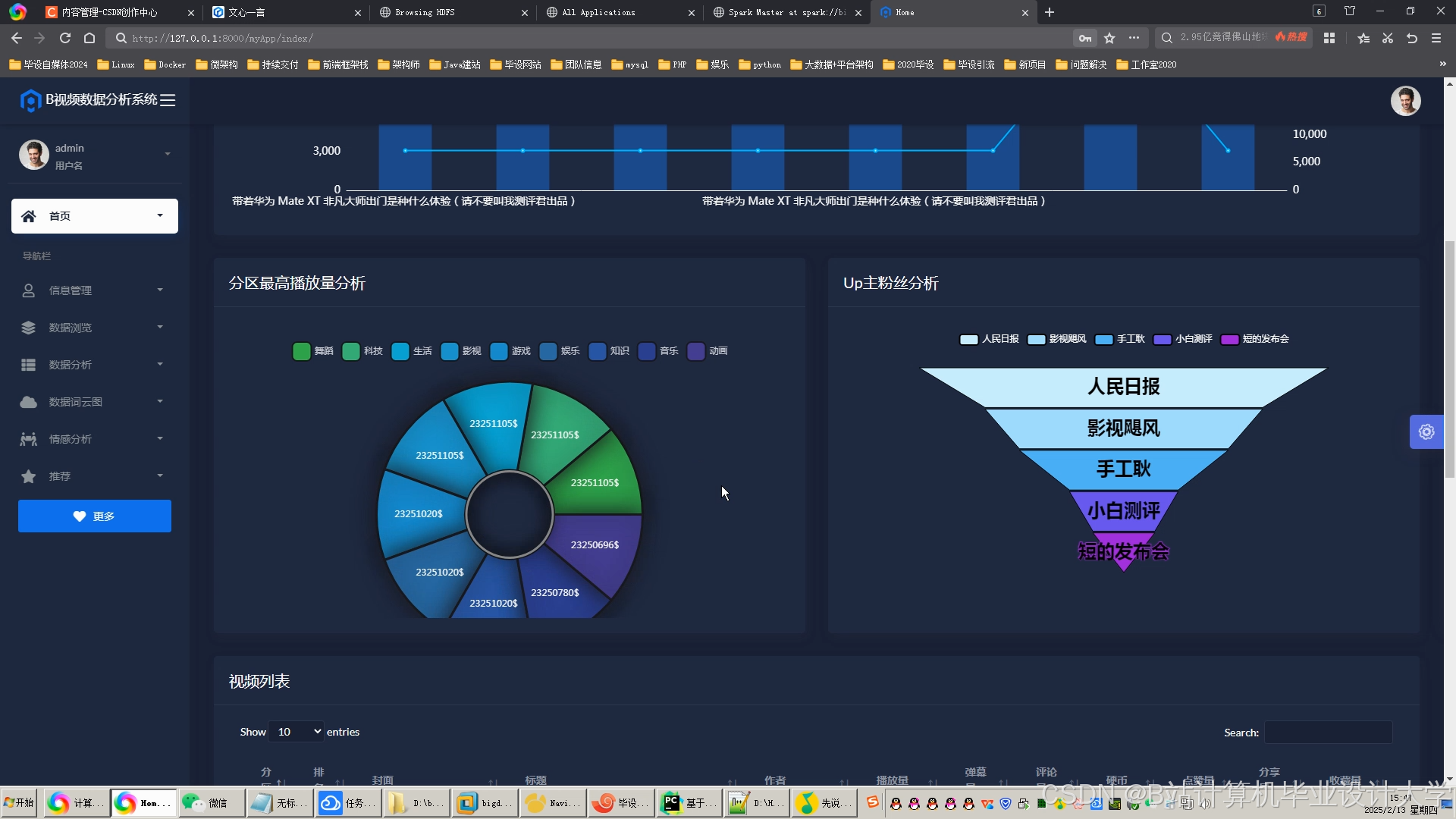

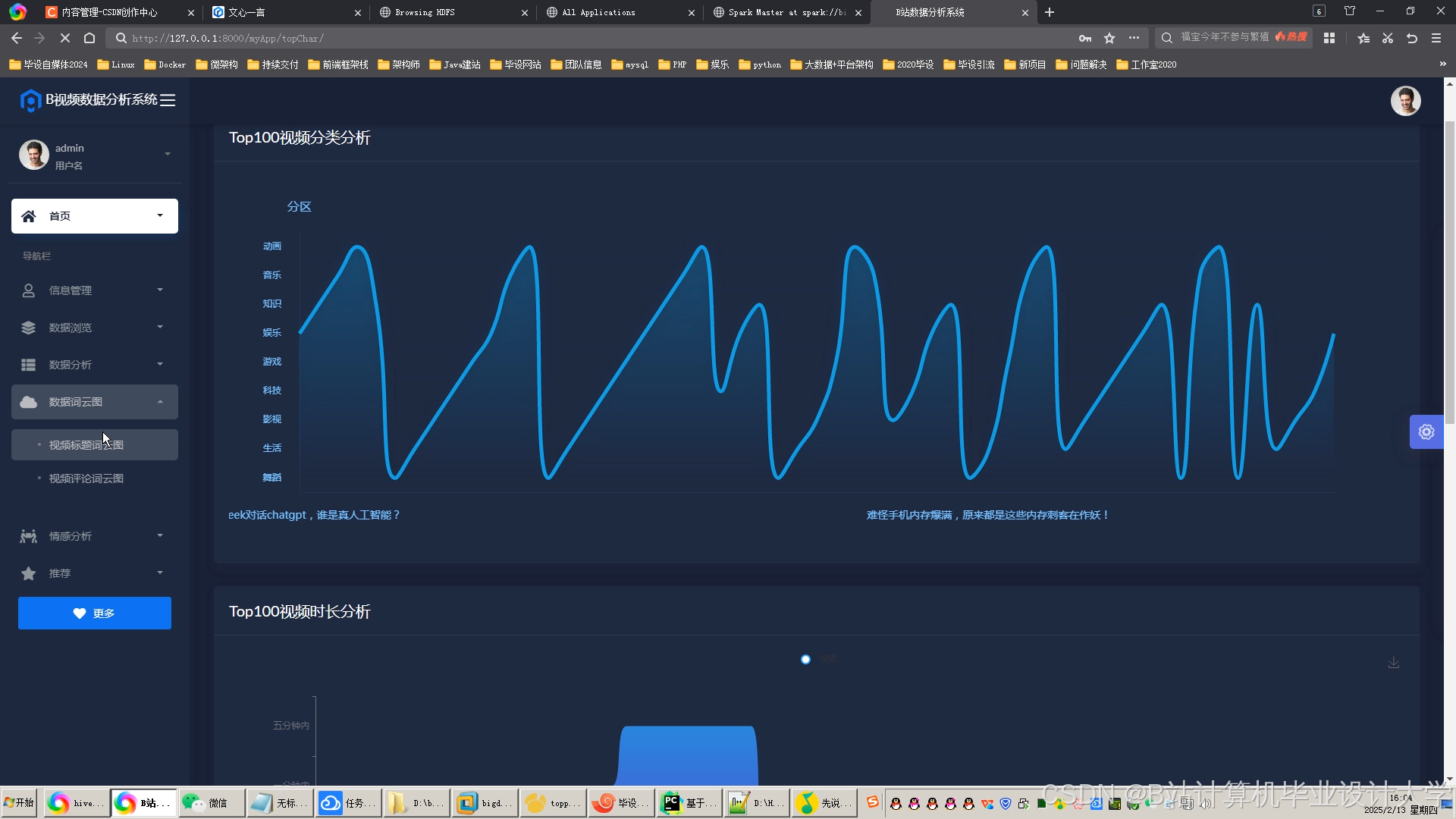

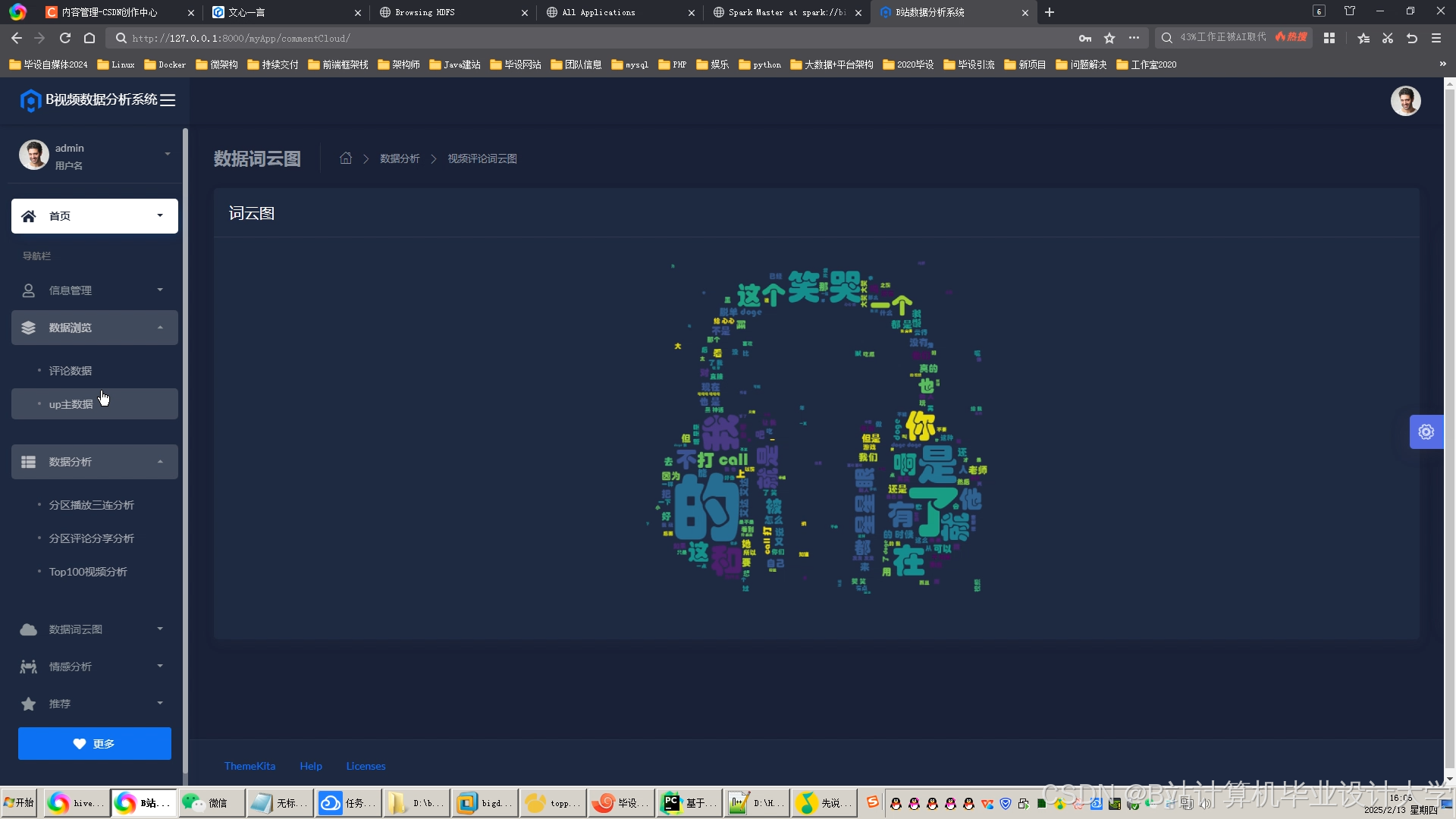

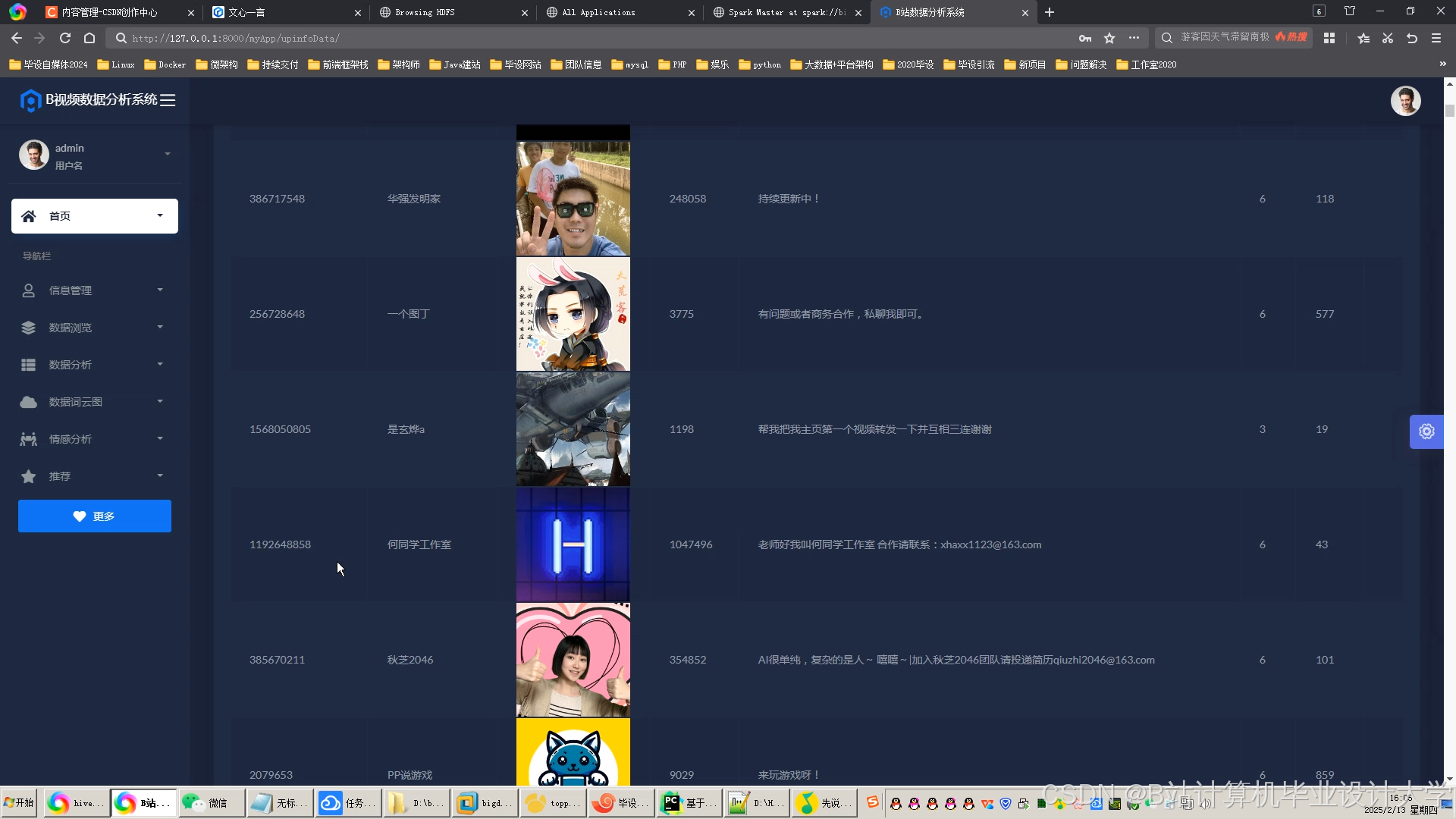

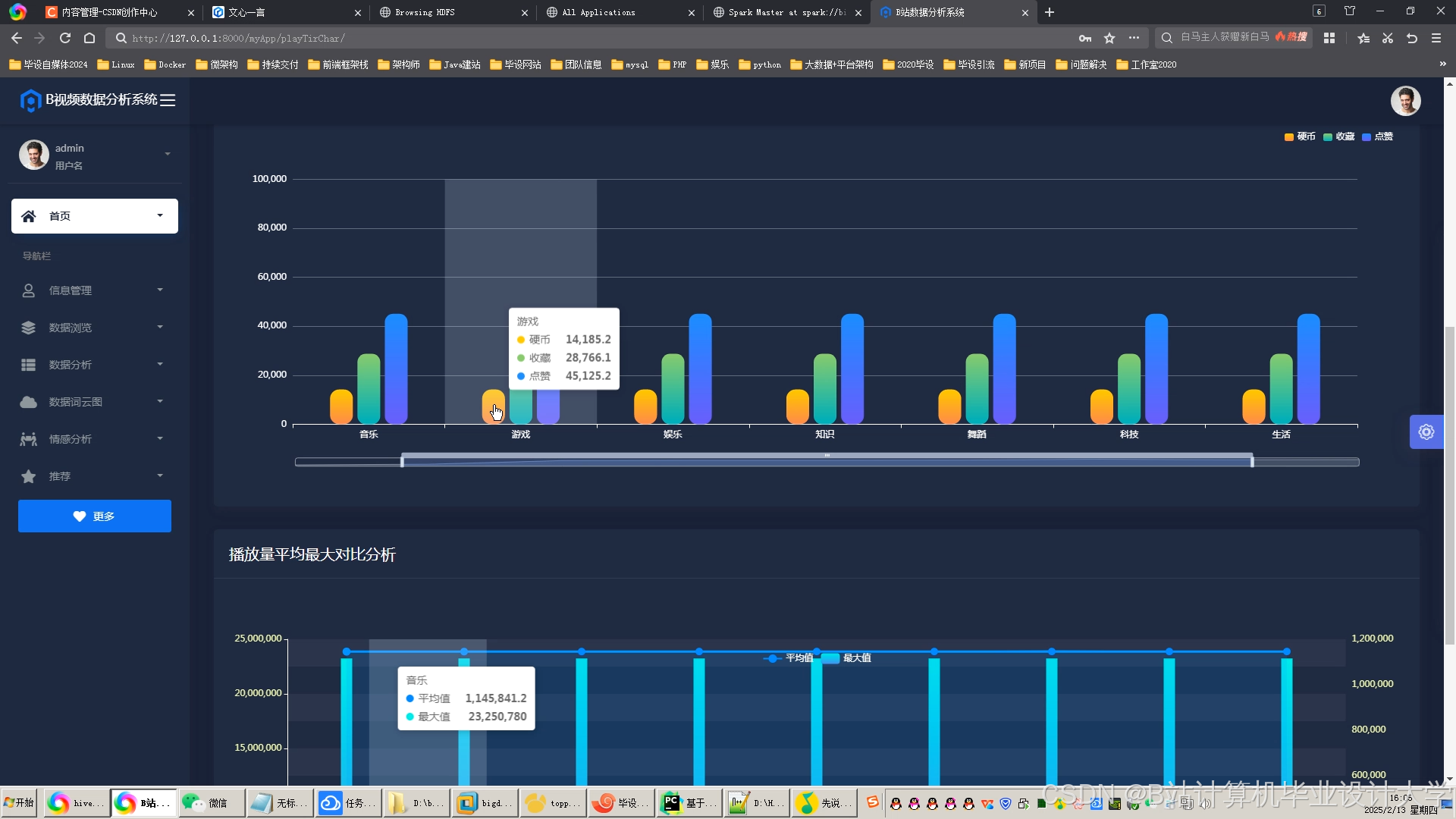

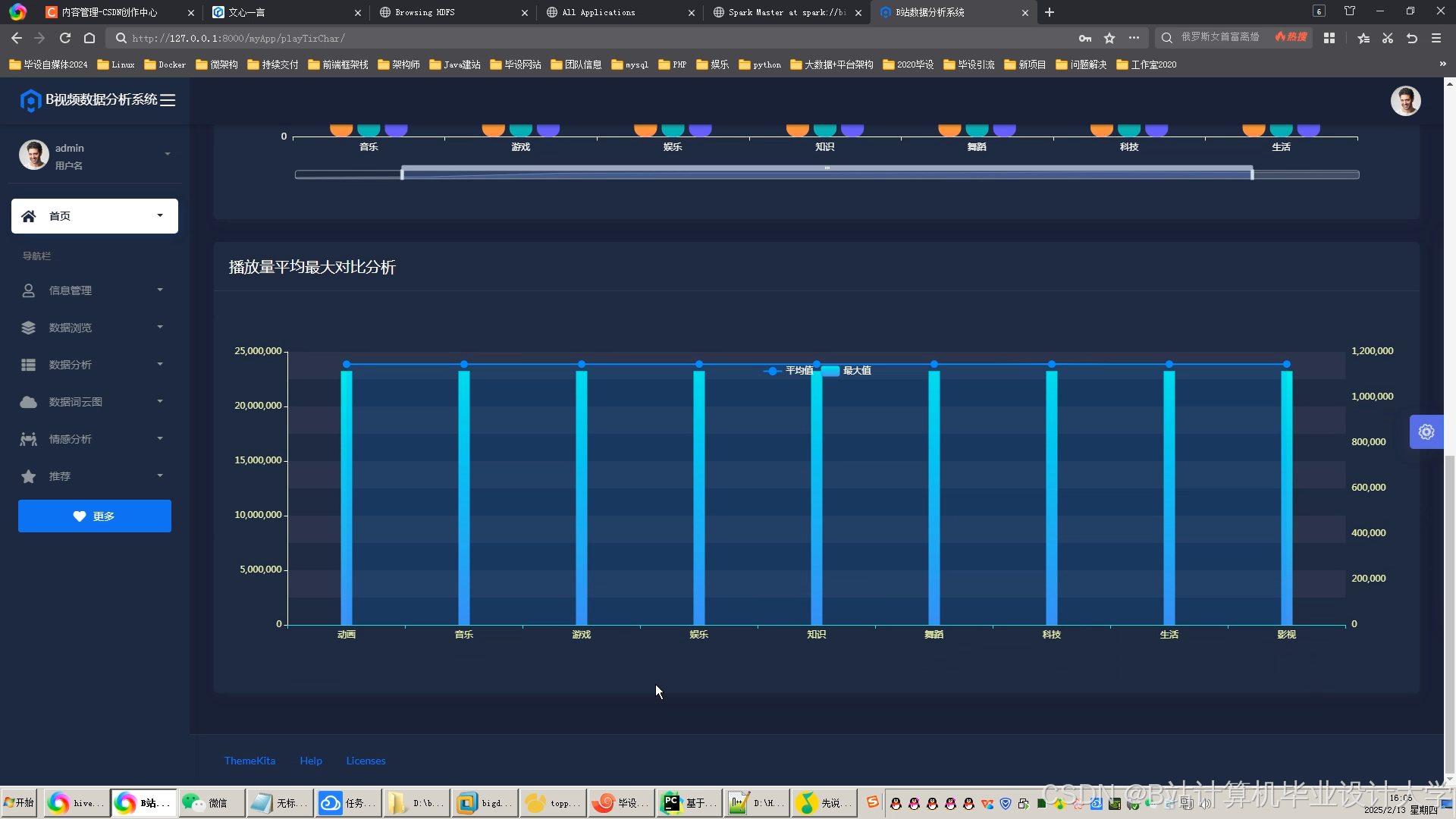

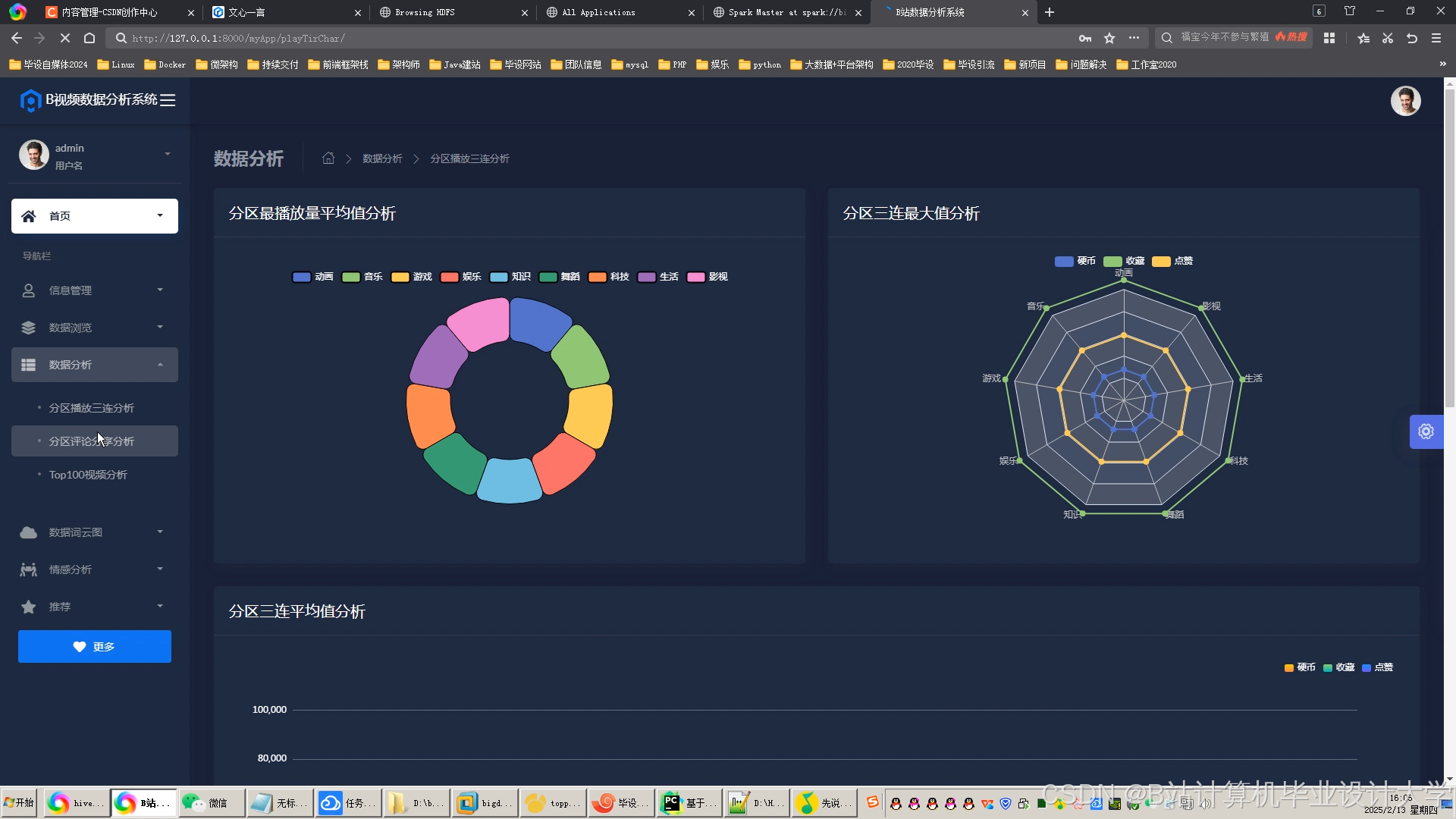

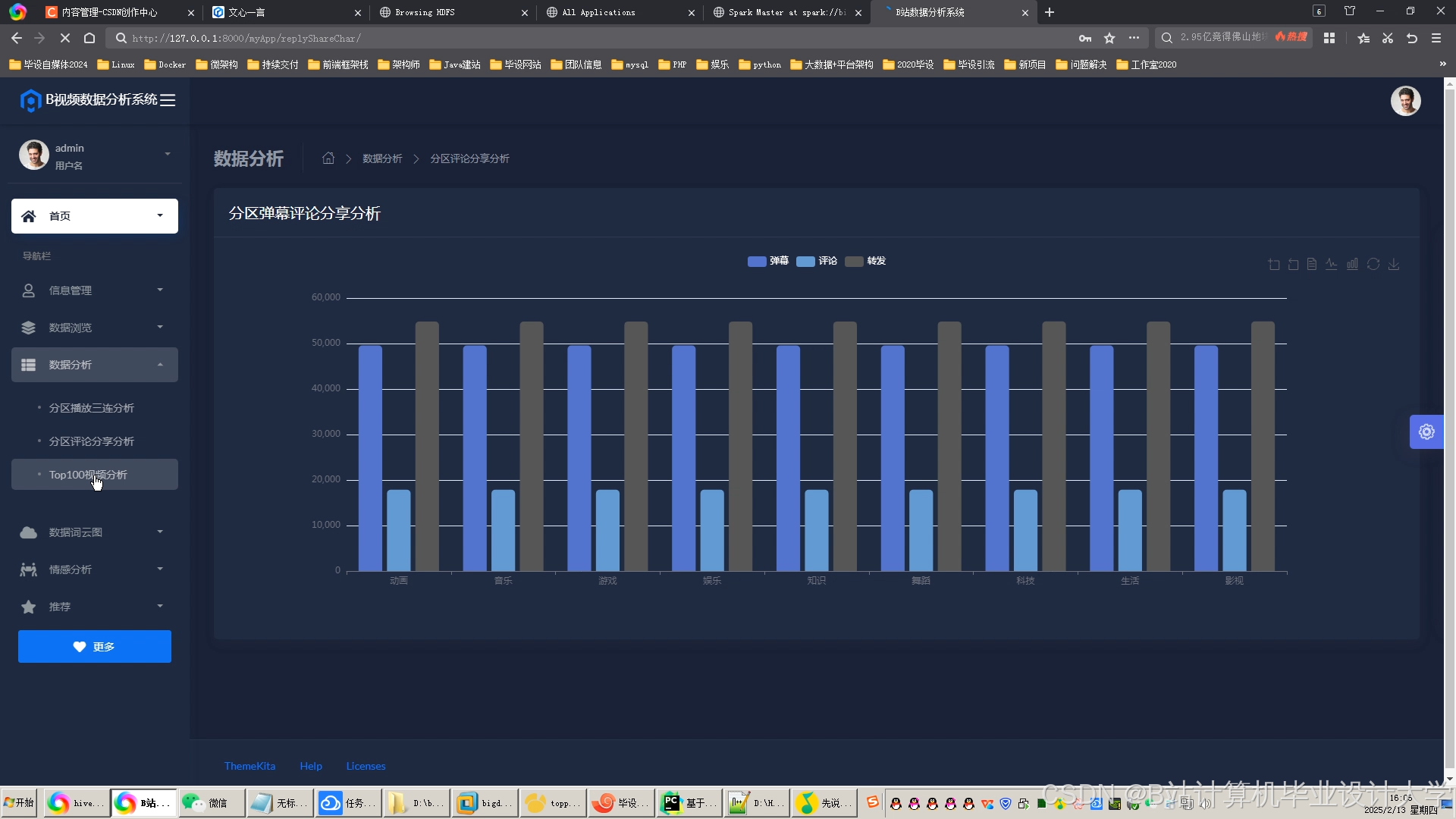

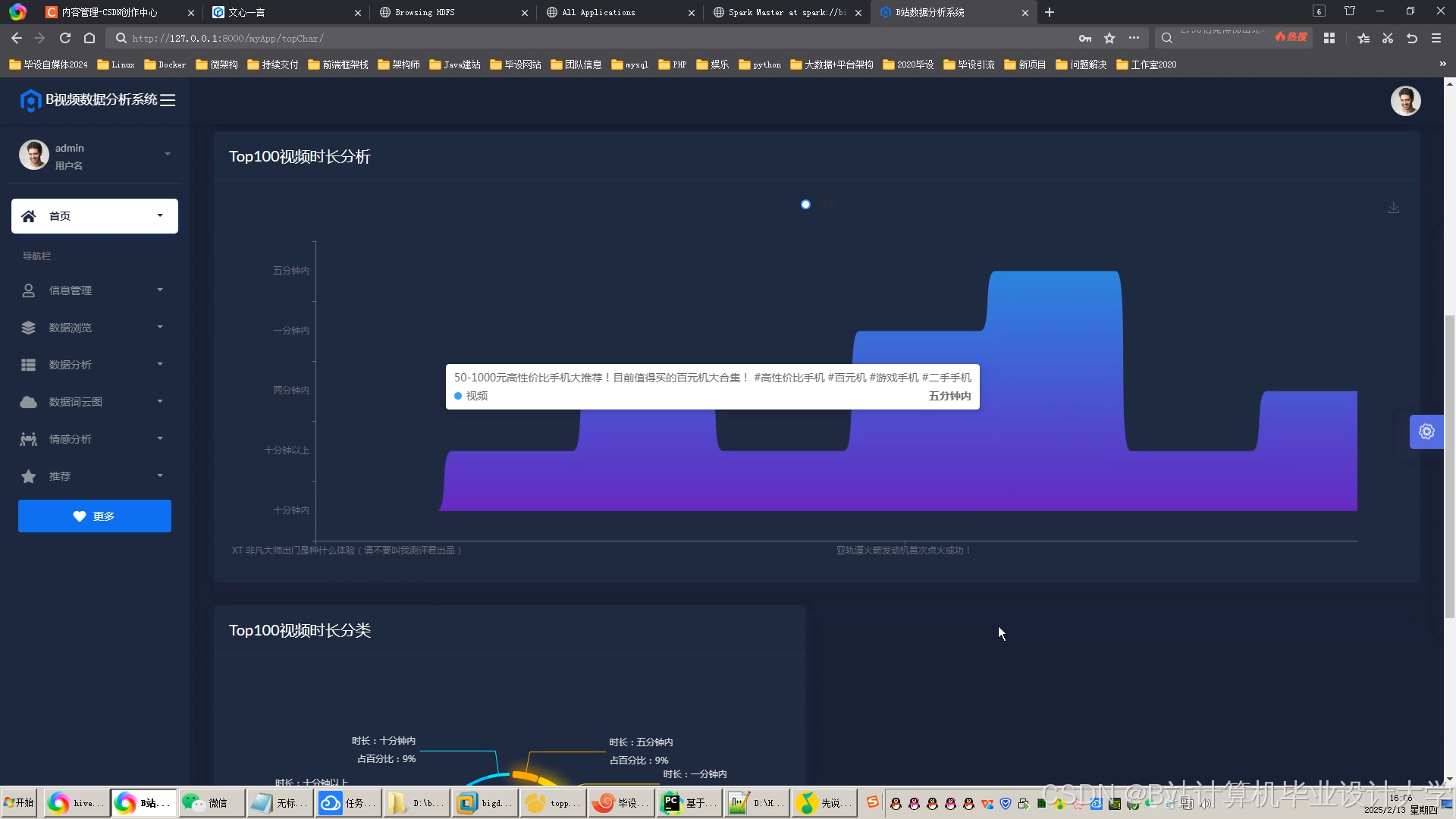

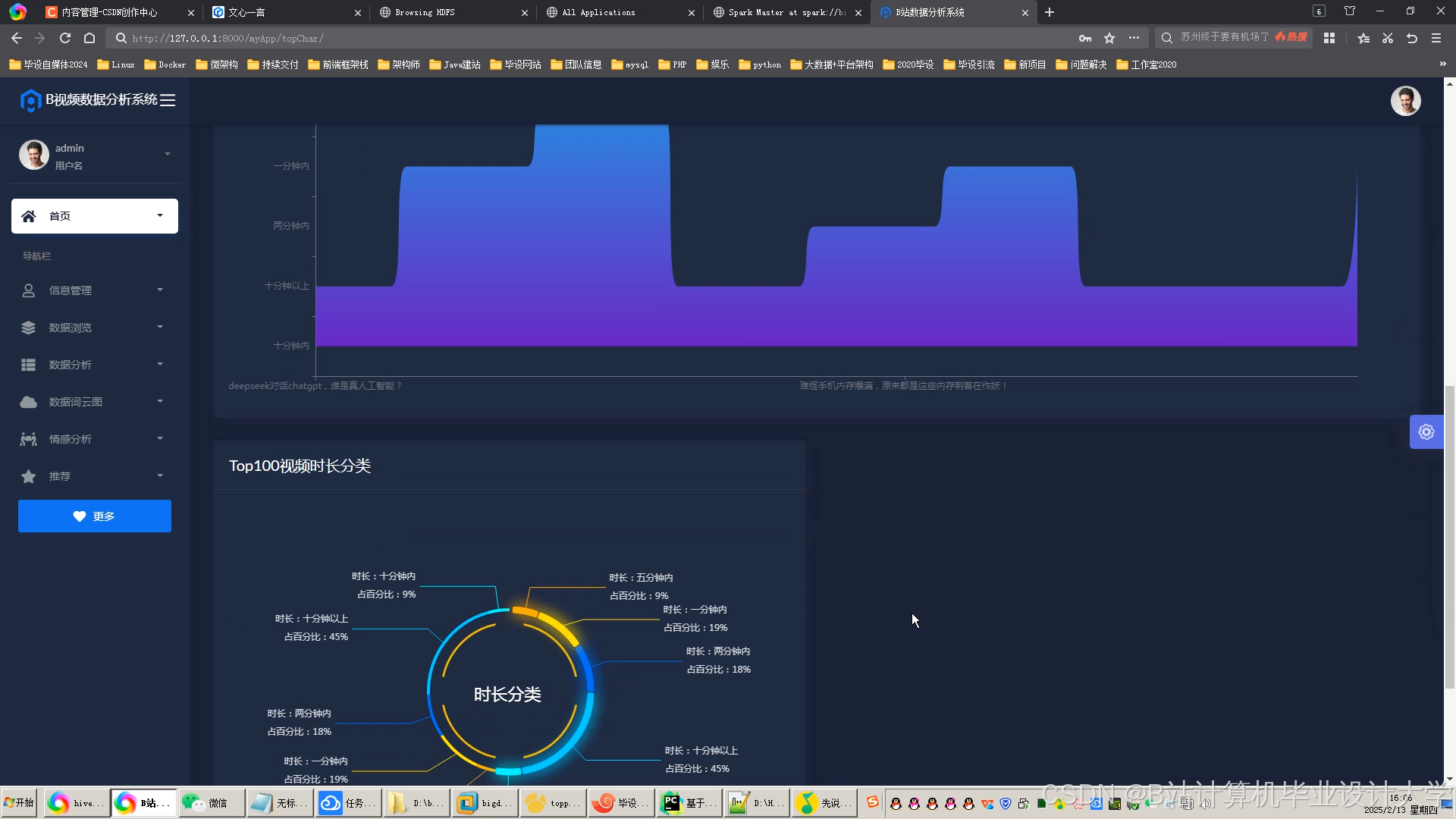

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

413

413

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?