温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

《Hadoop+Spark+Hive 招聘推荐系统》任务书

一、任务基本信息

- 任务名称:Hadoop+Spark+Hive 招聘推荐系统

- 任务来源:[具体来源,如科研项目、企业合作项目、毕业设计等]

- 任务起止时间:[开始日期]-[结束日期]

- 任务负责人:[姓名]

- 参与人员:[列出其他参与人员姓名]

二、任务背景与目标

(一)背景

随着互联网的快速发展,招聘行业积累了海量的职位信息和求职者简历数据。传统招聘推荐方式效率低下,难以从海量数据中精准匹配职位与人才。Hadoop、Spark 和 Hive 作为大数据处理的关键技术,Hadoop 提供分布式存储与计算框架,Spark 以内存计算加速数据处理,Hive 提供类似 SQL 的查询接口方便数据分析。将三者结合应用于招聘推荐系统,可有效解决数据处理和推荐效率问题,推动招聘行业数字化转型。

(二)目标

- 构建基于 Hadoop+Spark+Hive 的高效招聘推荐系统架构,实现对海量招聘数据的存储、管理和快速处理。

- 提出并实现一种结合多种特征的招聘推荐算法,提高职位与求职者的匹配精准度。

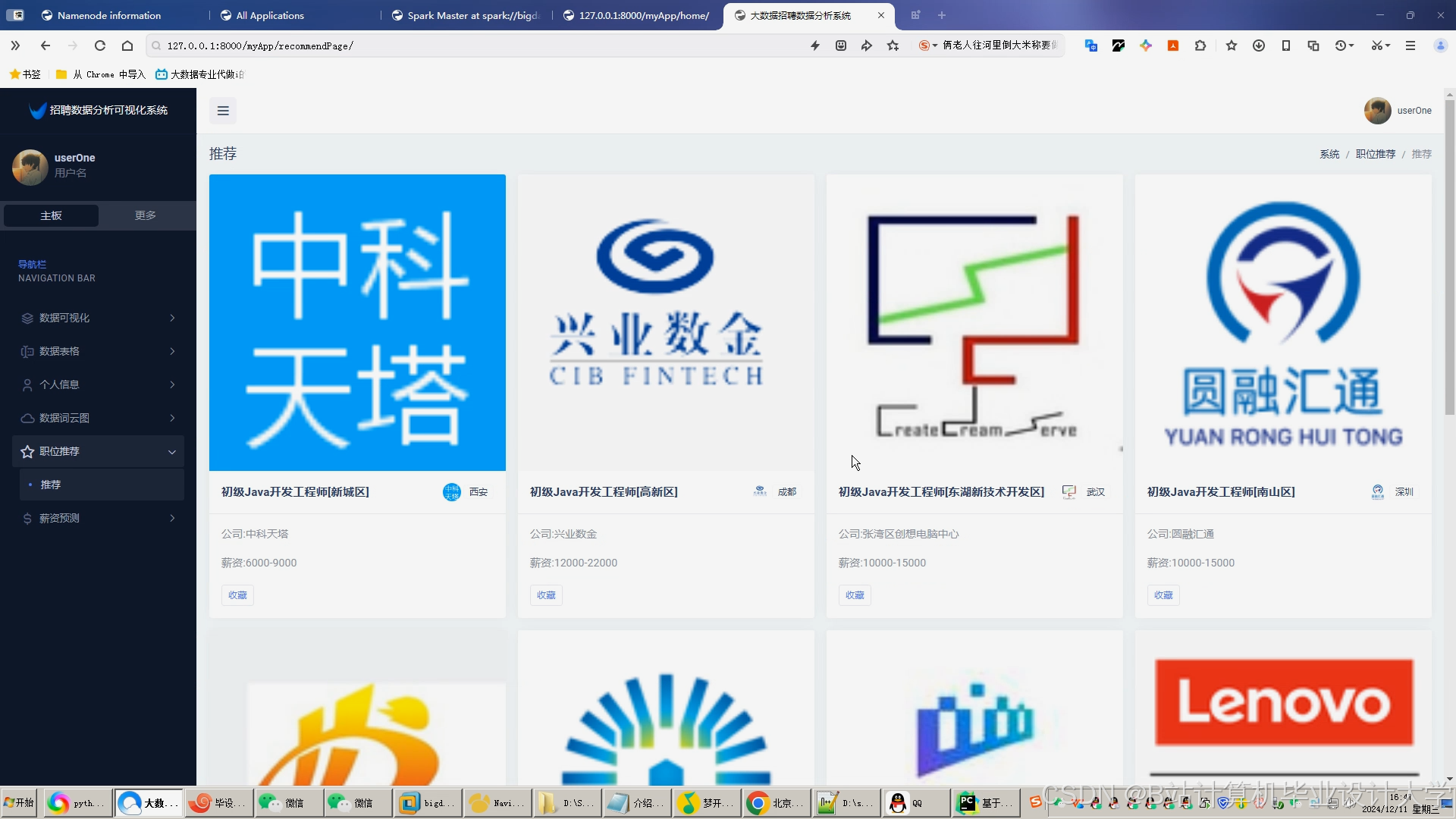

- 开发招聘推荐系统原型,具备用户注册登录、职位发布、简历上传、精准推荐展示等功能。

- 对系统进行全面测试和性能评估,确保系统稳定性和推荐准确性。

三、任务内容与要求

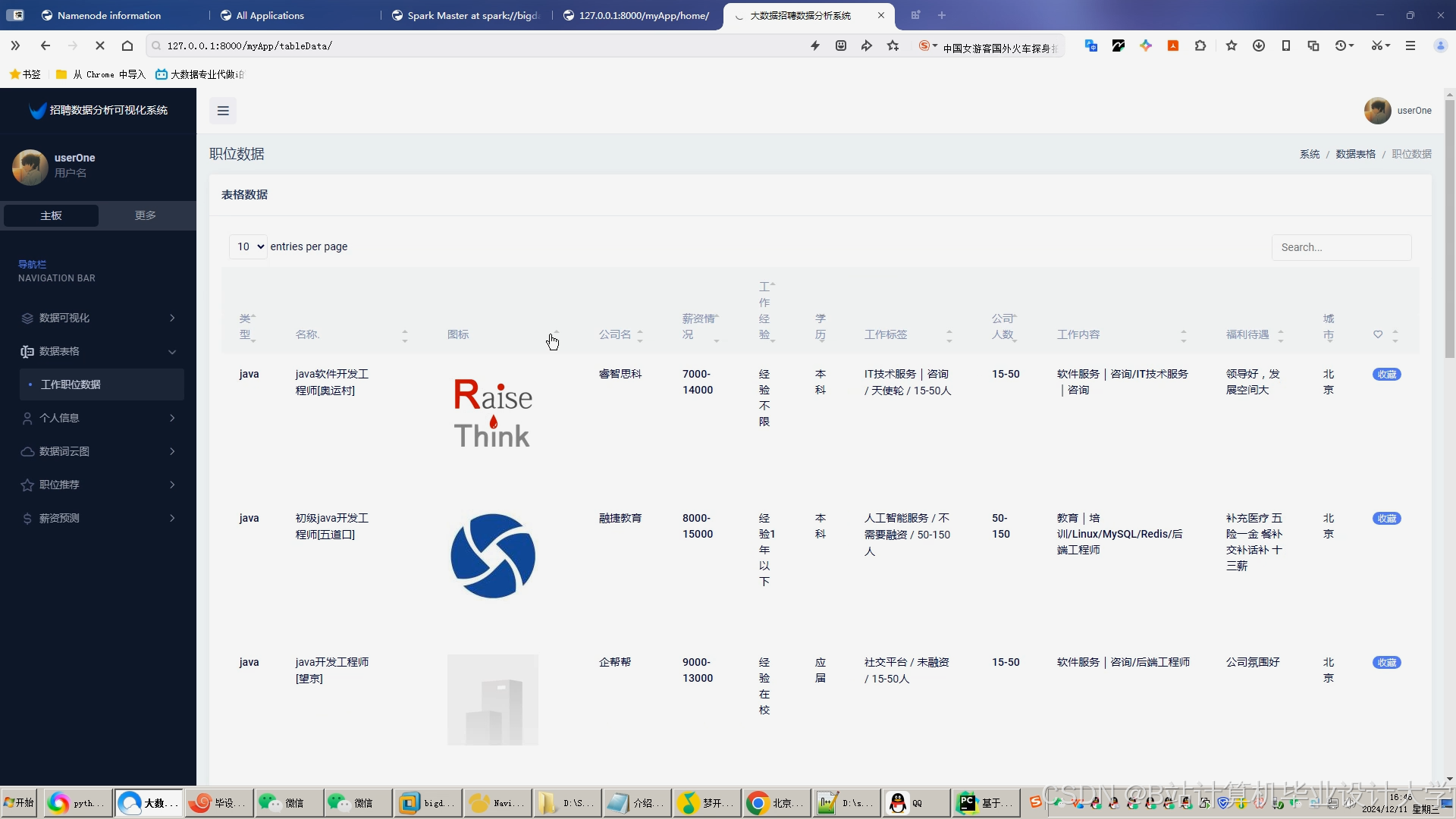

(一)招聘数据采集与预处理

- 内容

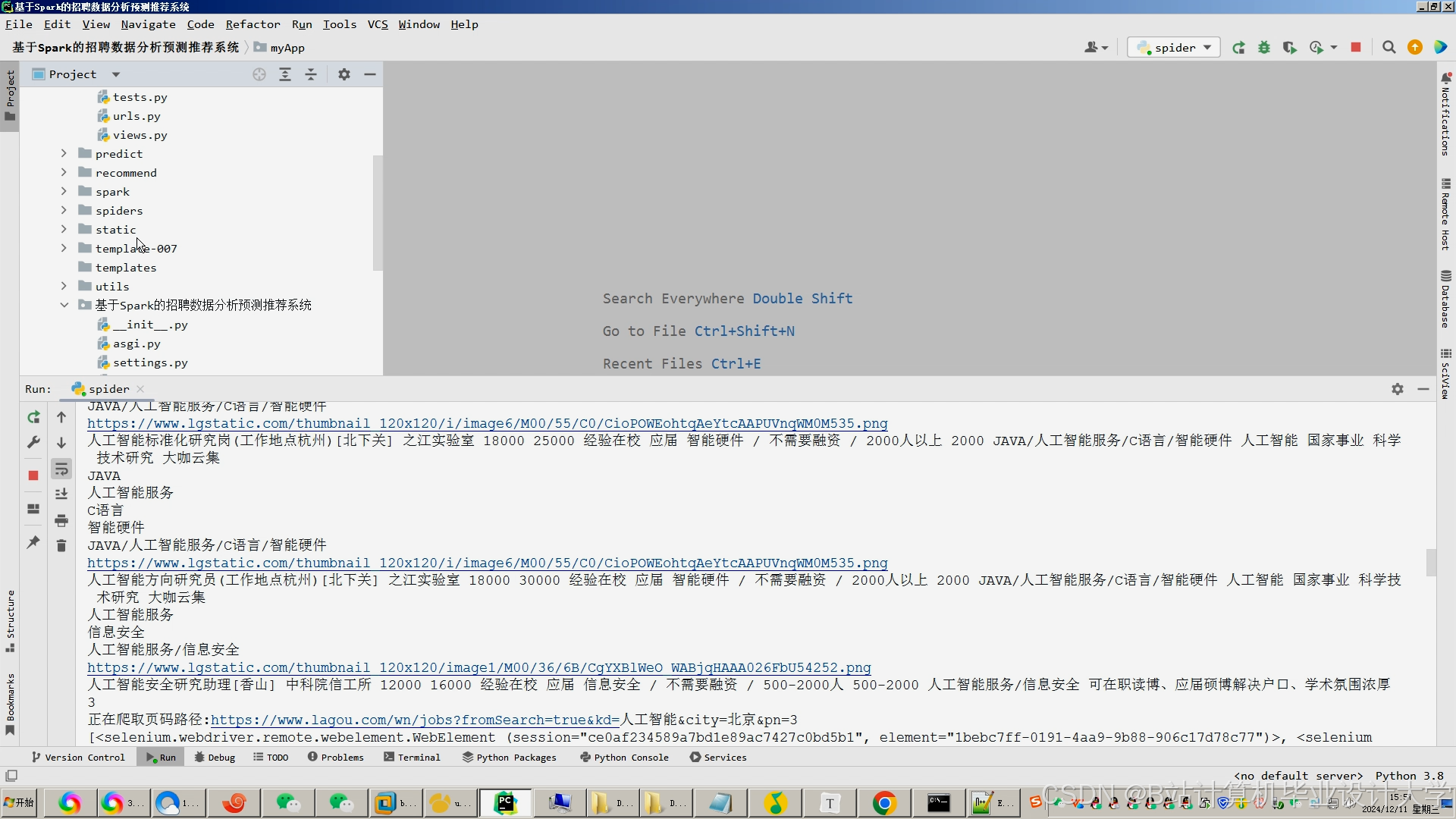

- 使用网络爬虫技术从多个招聘平台采集职位信息(如职位名称、描述、薪资、地点等)和求职者简历数据(如技能、工作经验、教育背景等)。

- 对采集到的数据进行清洗,去除重复、错误和不完整的数据;进行数据转换,将不同格式的数据统一为标准格式;进行数据标准化,消除不同量纲对后续分析的影响。

- 要求

- 确保采集数据的全面性和准确性,覆盖多个行业和职位类型。

- 数据清洗和预处理过程要详细记录,保证数据的可追溯性。

(二)基于 Hadoop+Hive 的数据存储与管理

- 内容

- 搭建 Hadoop 集群,合理配置节点参数,确保集群的高可用性和性能。

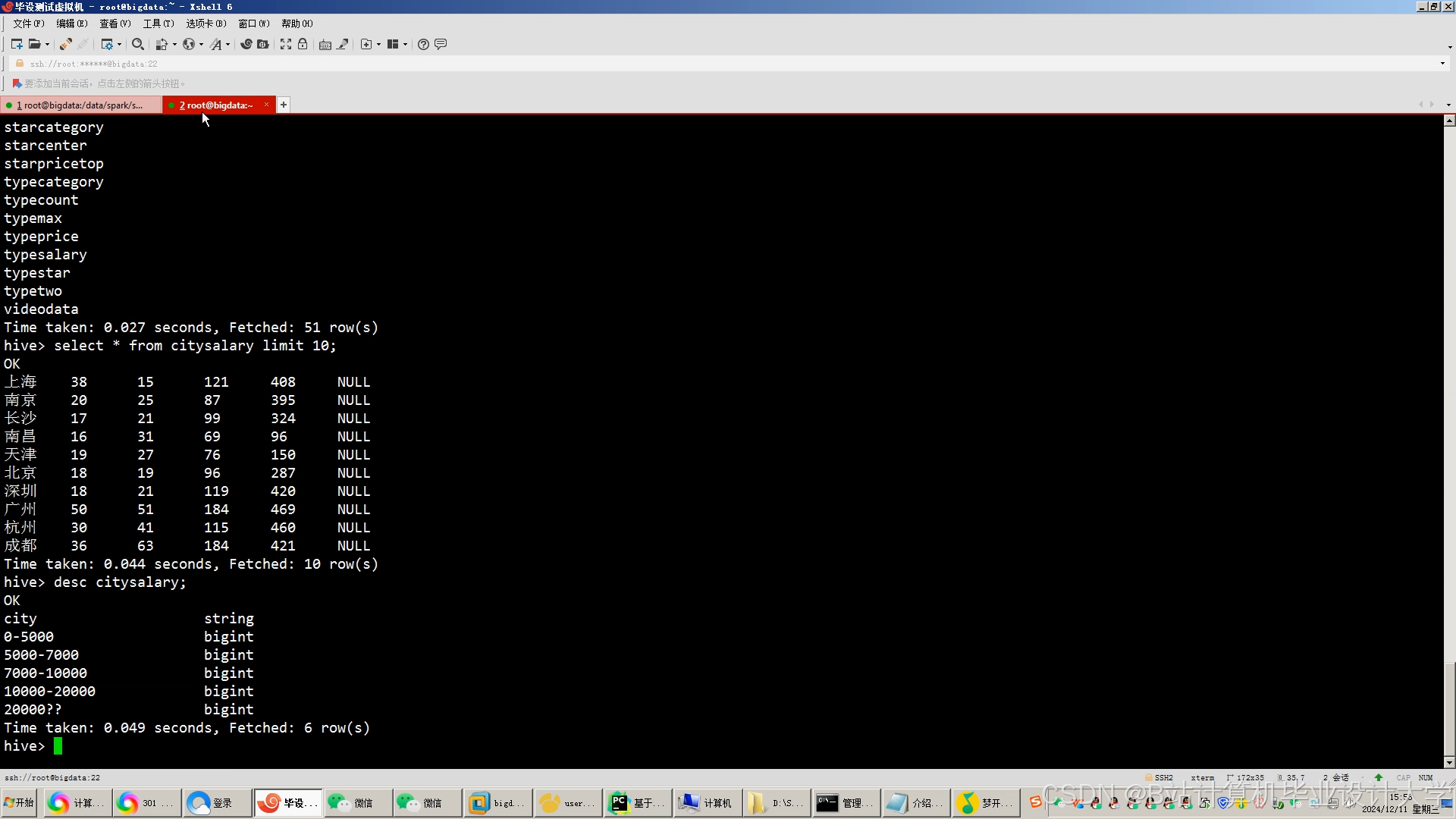

- 利用 Hive 创建数据表,根据数据特征设计合适的表结构,将预处理后的数据存储到 Hive 中。

- 编写 HiveQL 查询语句,实现对招聘数据的常规查询和统计分析。

- 要求

- Hadoop 集群搭建要符合企业级应用标准,具备数据备份和恢复机制。

- Hive 数据表设计要合理,能够高效存储和查询数据。

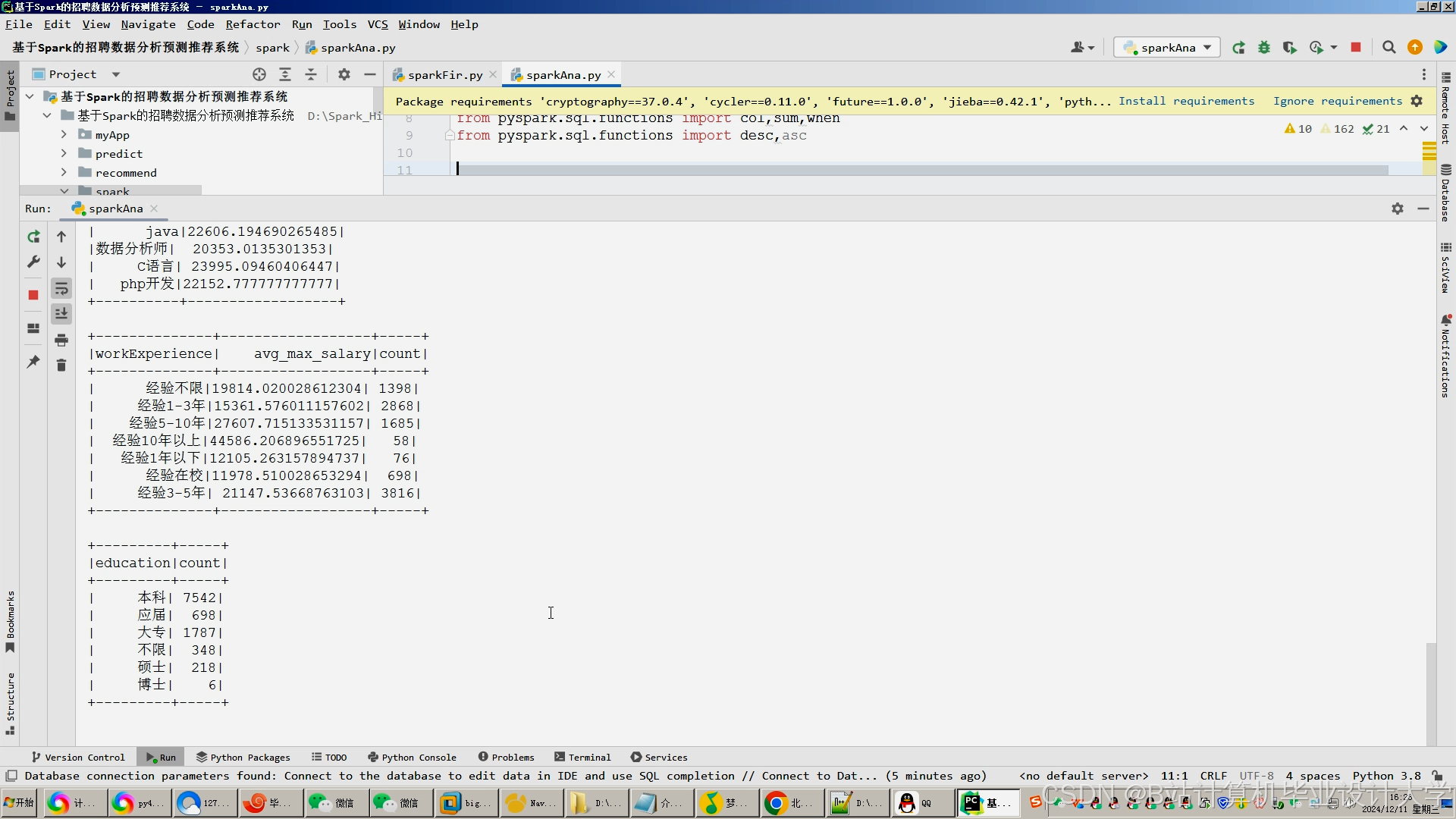

(三)基于 Spark 的数据分析与挖掘

- 内容

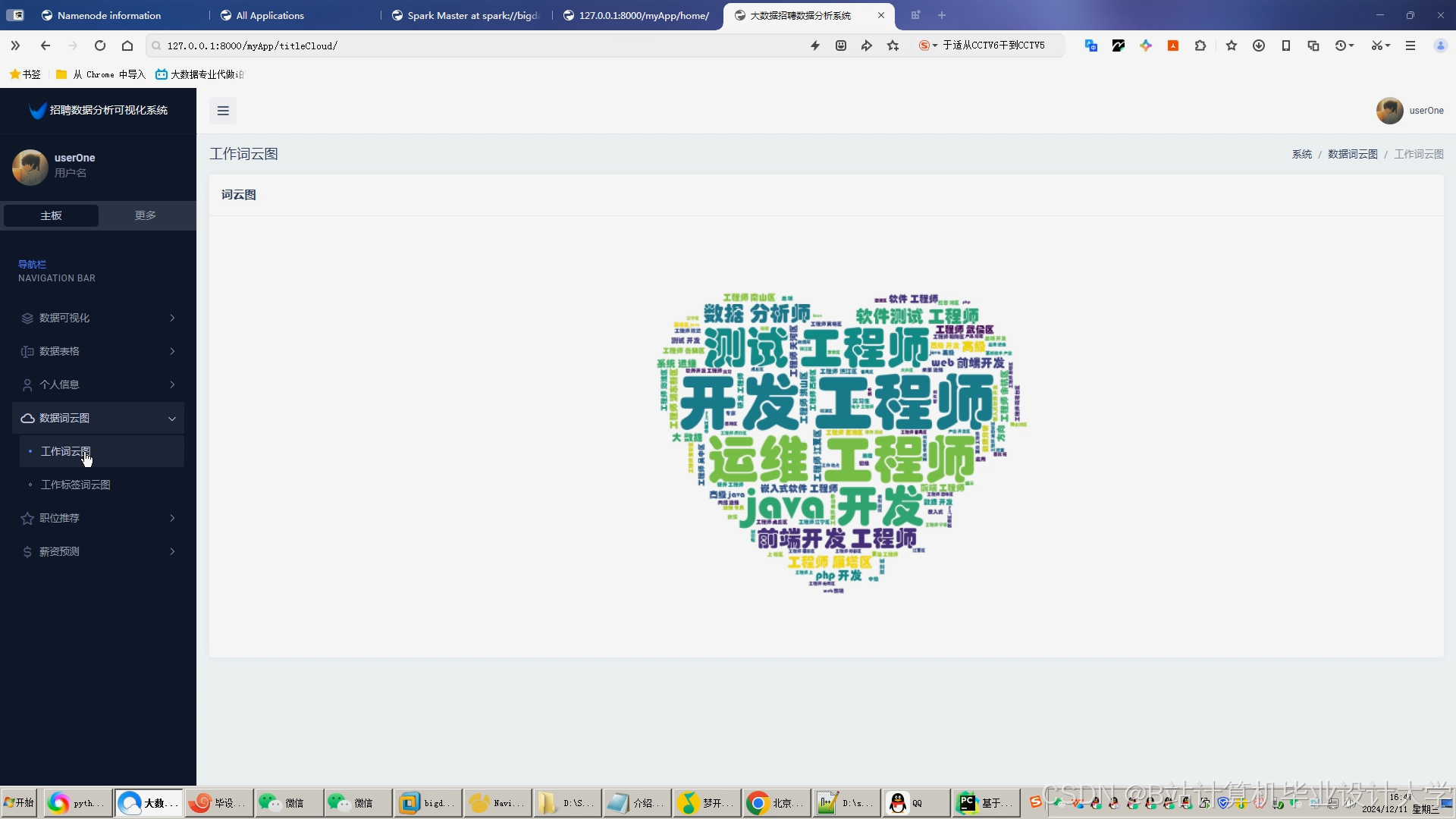

- 使用 Spark 的 RDD 和 DataFrame 编程模型,对招聘数据进行特征提取,如提取职位关键词、求职者技能关键词等。

- 进行统计分析,如计算职位与求职者技能匹配度、工作经验匹配度等。

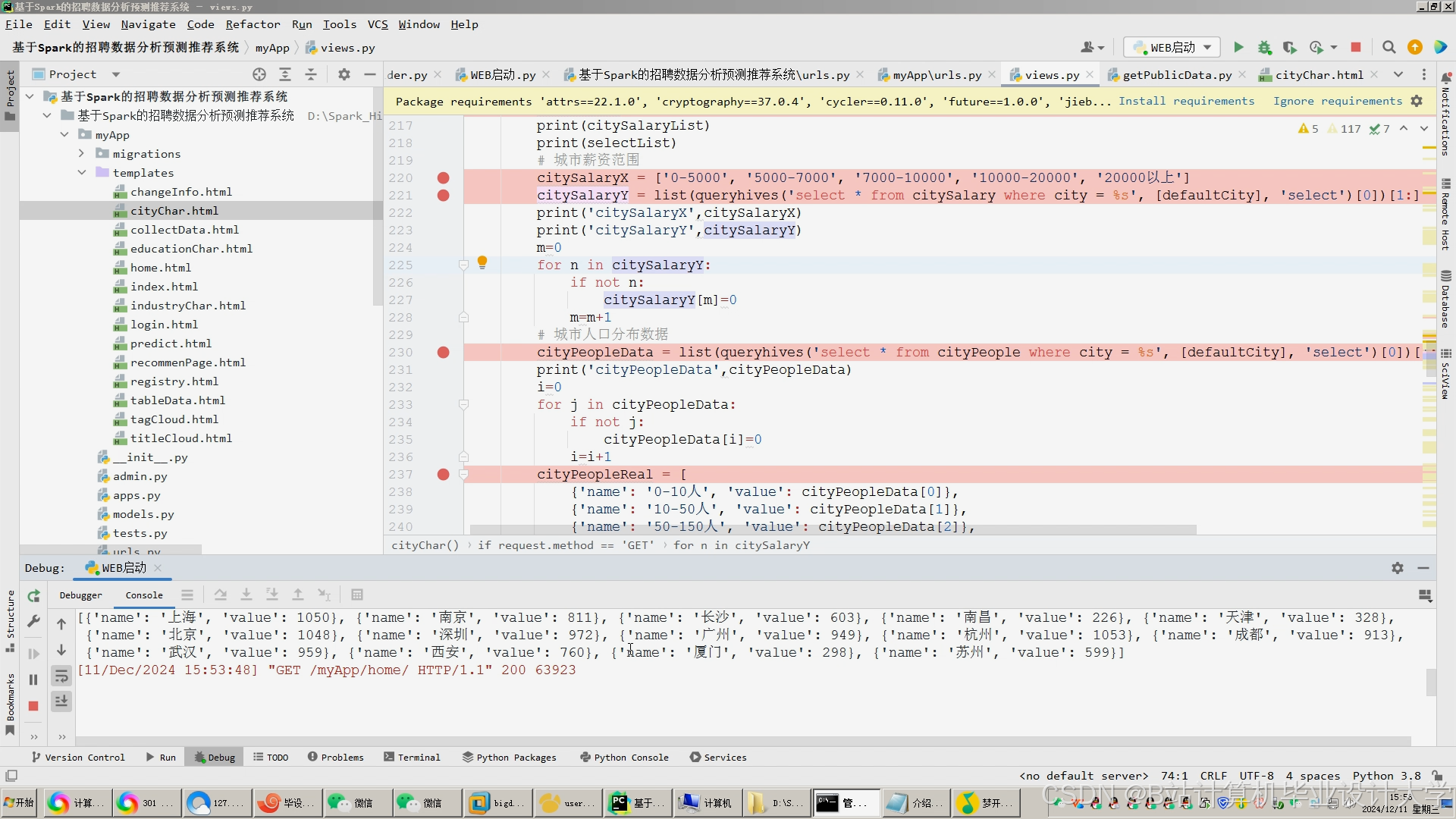

- 结合机器学习算法(如决策树、逻辑回归、协同过滤等),构建招聘推荐模型,并使用 Spark MLlib 进行模型训练和优化。

- 要求

- 特征提取要准确,能够反映职位和求职者的关键信息。

- 模型训练要选择合适的算法和参数,提高推荐准确性。

(四)招聘推荐算法设计与实现

- 内容

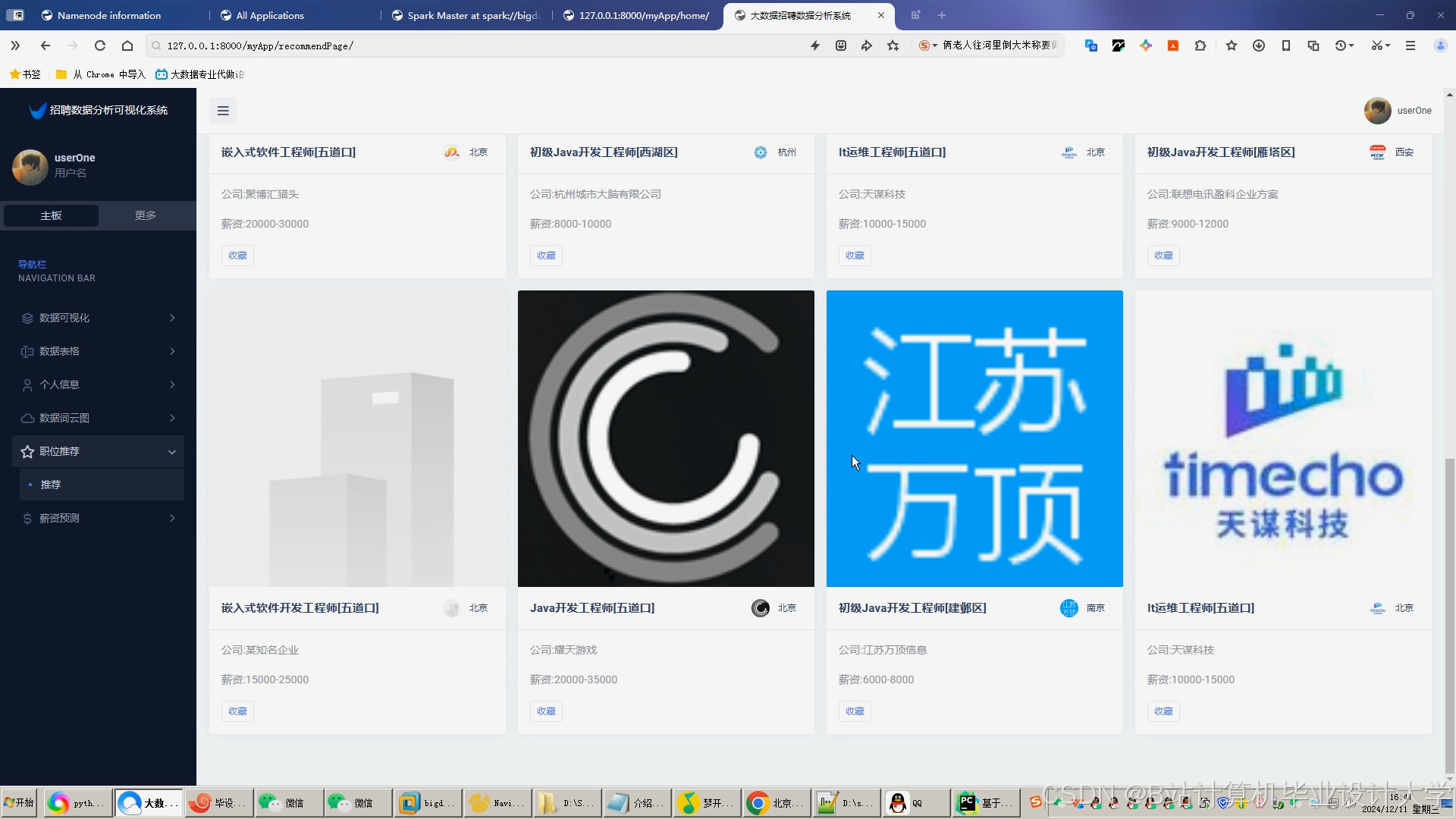

- 提出一种综合考虑多种特征的招聘推荐算法,如结合技能匹配度、工作经验、地理位置、薪资期望等因素。

- 利用 Spark 分布式计算能力,对推荐算法进行并行化实现,提高推荐效率。

- 要求

- 推荐算法要具有创新性和实用性,能够提高职位与求职者的匹配度。

- 并行化实现要充分利用 Spark 的优势,确保算法在大规模数据下的高效运行。

(五)招聘推荐系统原型开发与测试

- 内容

- 使用前端技术(如 HTML、CSS、JavaScript)和后端技术(如 Python、Flask)开发招聘推荐系统原型。

- 实现用户注册登录、职位发布、简历上传、推荐展示等功能模块。

- 对系统进行功能测试、性能测试和安全测试,评估系统的准确性、效率和稳定性。

- 要求

- 系统界面要简洁美观,操作方便。

- 功能模块要完整,能够满足用户的基本需求。

- 测试过程要详细记录,对发现的问题及时进行修复和优化。

四、任务成果形式

- 系统原型:基于 Hadoop+Spark+Hive 的招聘推荐系统原型,具备完整的功能模块。

- 技术文档:包括系统设计文档、算法设计文档、数据库设计文档、测试报告等。

- 研究报告:详细阐述系统的研究背景、目标、方法、实现过程和实验结果。

- 代码:系统的源代码,包括数据采集、预处理、存储、分析、推荐算法和系统开发等部分的代码。

五、任务进度安排

| 阶段 | 时间区间 | 主要任务 | 交付成果 |

|---|---|---|---|

| 需求分析与设计阶段 | [开始日期]-[具体日期 1] |

|

|

| 数据采集与预处理阶段 | [具体日期 1]-[具体日期 2] |

|

|

| 数据存储与管理阶段 | [具体日期 2]-[具体日期 3] |

|

|

| 数据分析与挖掘阶段 | [具体日期 3]-[具体日期 4] |

|

|

| 系统开发与实现阶段 | [具体日期 4]-[具体日期 5] |

|

|

| 系统测试与优化阶段 | [具体日期 5]-[具体日期 6] |

|

|

| 总结与验收阶段 | [具体日期 6]-[结束日期] |

|

|

六、任务资源需求

- 硬件资源:服务器若干台,用于搭建 Hadoop 集群和部署系统;开发工作站若干台,用于系统开发和测试。

- 软件资源:Hadoop、Spark、Hive 等大数据处理软件;Python、Flask 等开发工具;数据库管理系统(如 MySQL);前端开发工具(如 Visual Studio Code)。

- 数据资源:招聘平台的数据接口或网络爬虫获取的招聘数据。

七、任务风险与应对措施

(一)技术风险

- 风险描述:Hadoop、Spark 和 Hive 等大数据技术学习曲线较陡,可能出现技术难题无法及时解决的情况;推荐算法可能无法达到预期的准确性和效率。

- 应对措施:组织团队成员参加相关技术培训和学习交流活动;查阅大量的技术文档和案例,寻求专家帮助;对推荐算法进行多次实验和优化,不断调整参数和特征。

(二)数据风险

- 风险描述:招聘数据可能存在数据质量不高、数据缺失等问题;数据采集过程中可能面临反爬虫机制的限制。

- 应对措施:加强数据预处理环节,提高数据质量;采用多种数据采集方法,如模拟浏览器行为、使用代理 IP 等,避免被反爬虫机制识别。

(三)时间风险

- 风险描述:任务进度可能受到各种因素的影响,如技术难题、人员变动等,导致任务无法按时完成。

- 应对措施:制定详细的任务进度计划,并定期进行进度检查和评估;合理安排人员分工,确保各项工作有序进行;预留一定的时间缓冲,以应对突发情况。

八、任务验收标准

- 系统功能:系统具备用户注册登录、职位发布、简历上传、精准推荐展示等完整功能,操作流程顺畅,无明显功能缺陷。

- 推荐准确性:通过实际数据测试,推荐算法的准确率、召回率等指标达到预期目标,能够有效提高职位与求职者的匹配度。

- 系统性能:系统在高并发情况下能够稳定运行,响应时间满足用户需求;Hadoop 集群和 Spark 计算任务能够高效完成。

- 文档质量:技术文档、研究报告等资料齐全、规范,内容详实、准确,能够清晰阐述系统的设计思路、实现方法和实验结果。

任务负责人(签字):__________________

日期:__________________

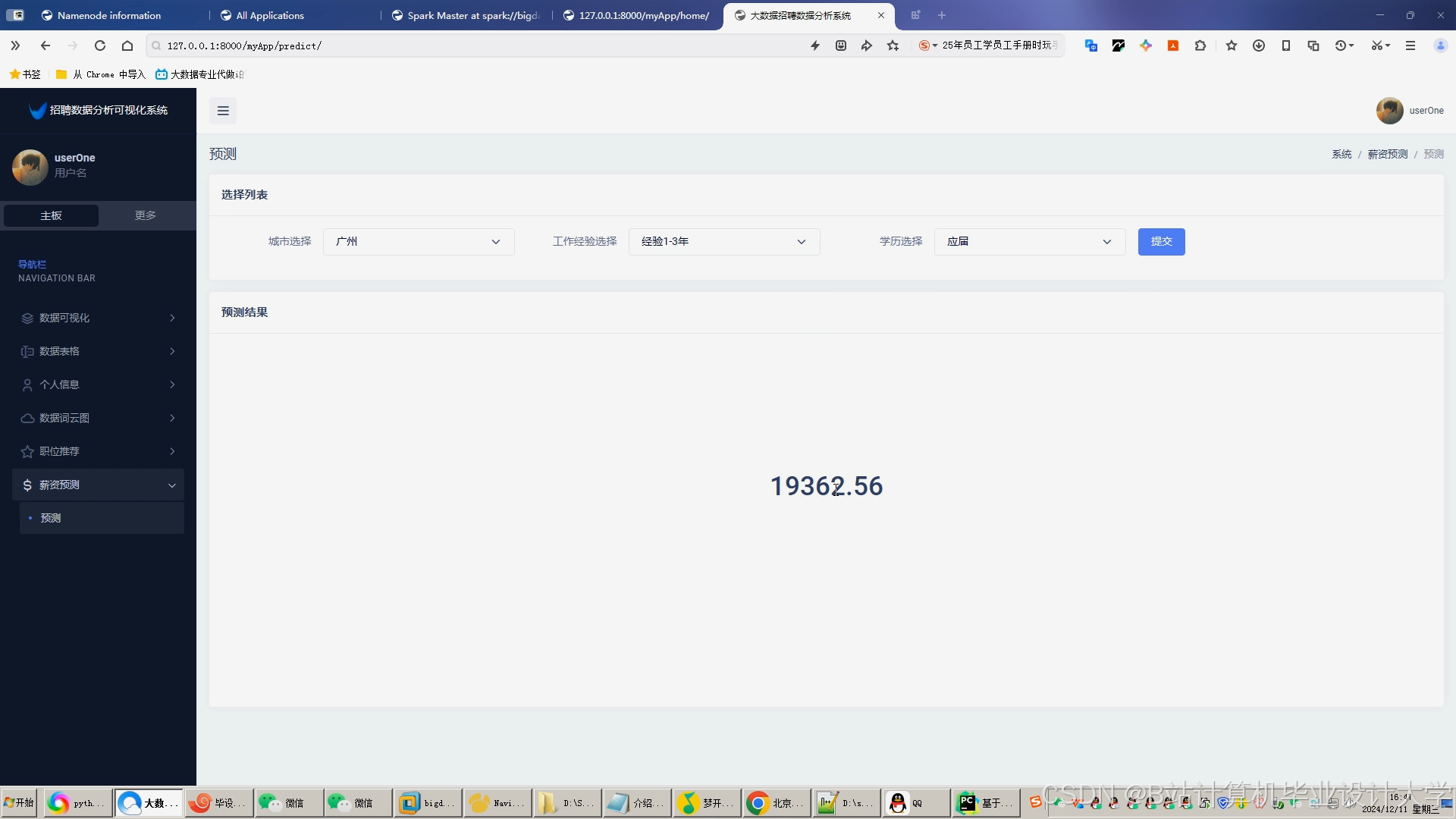

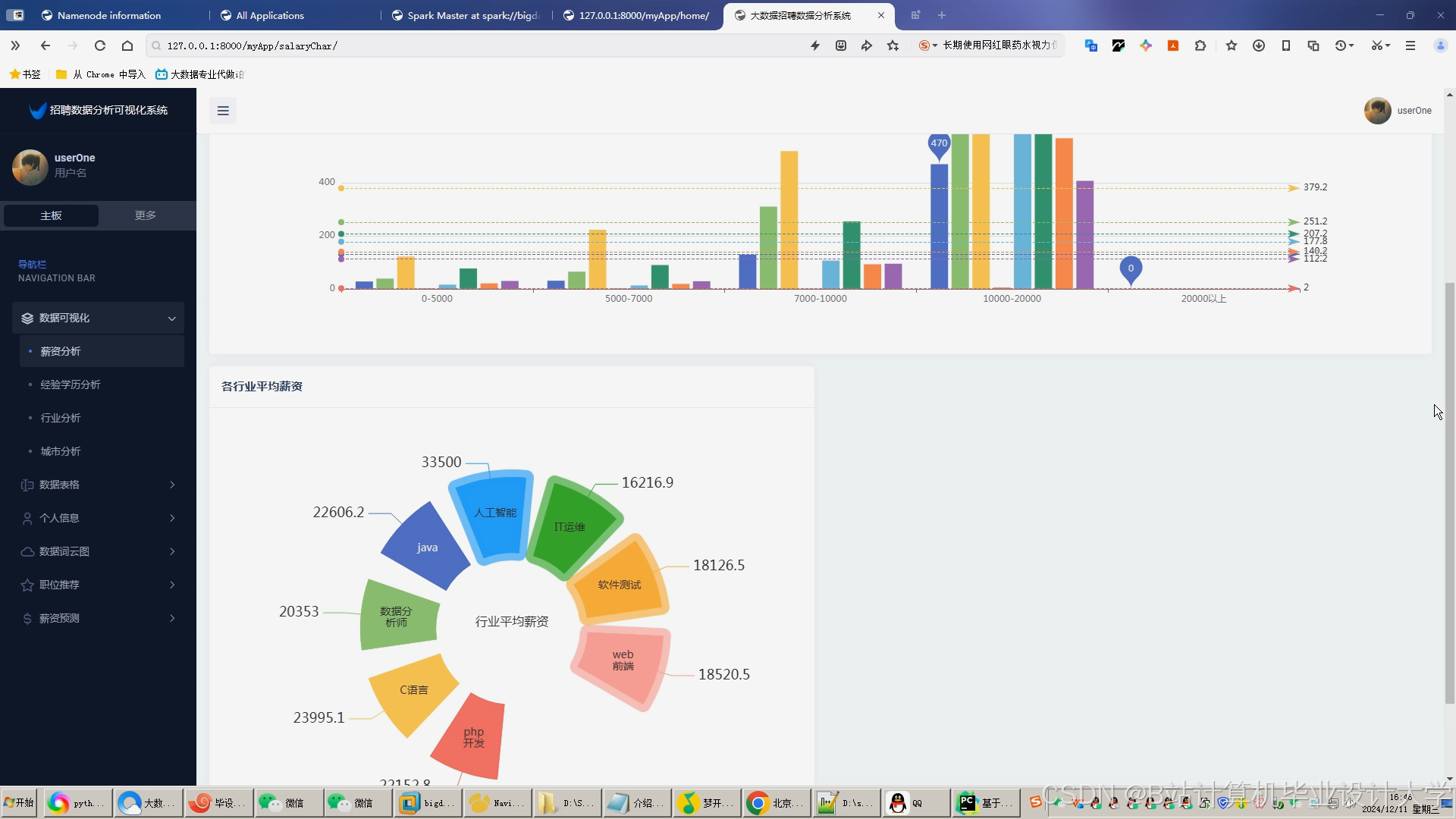

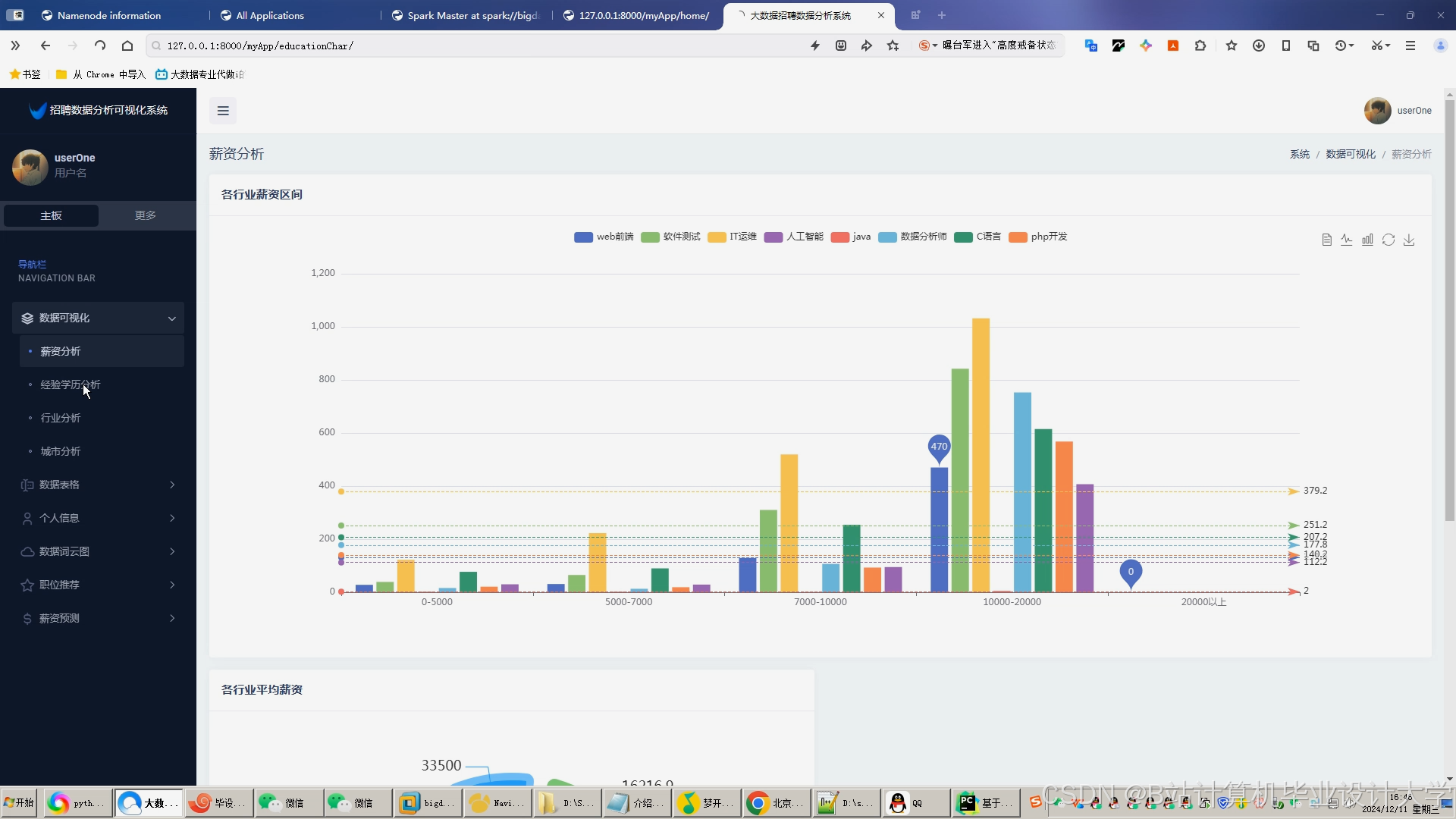

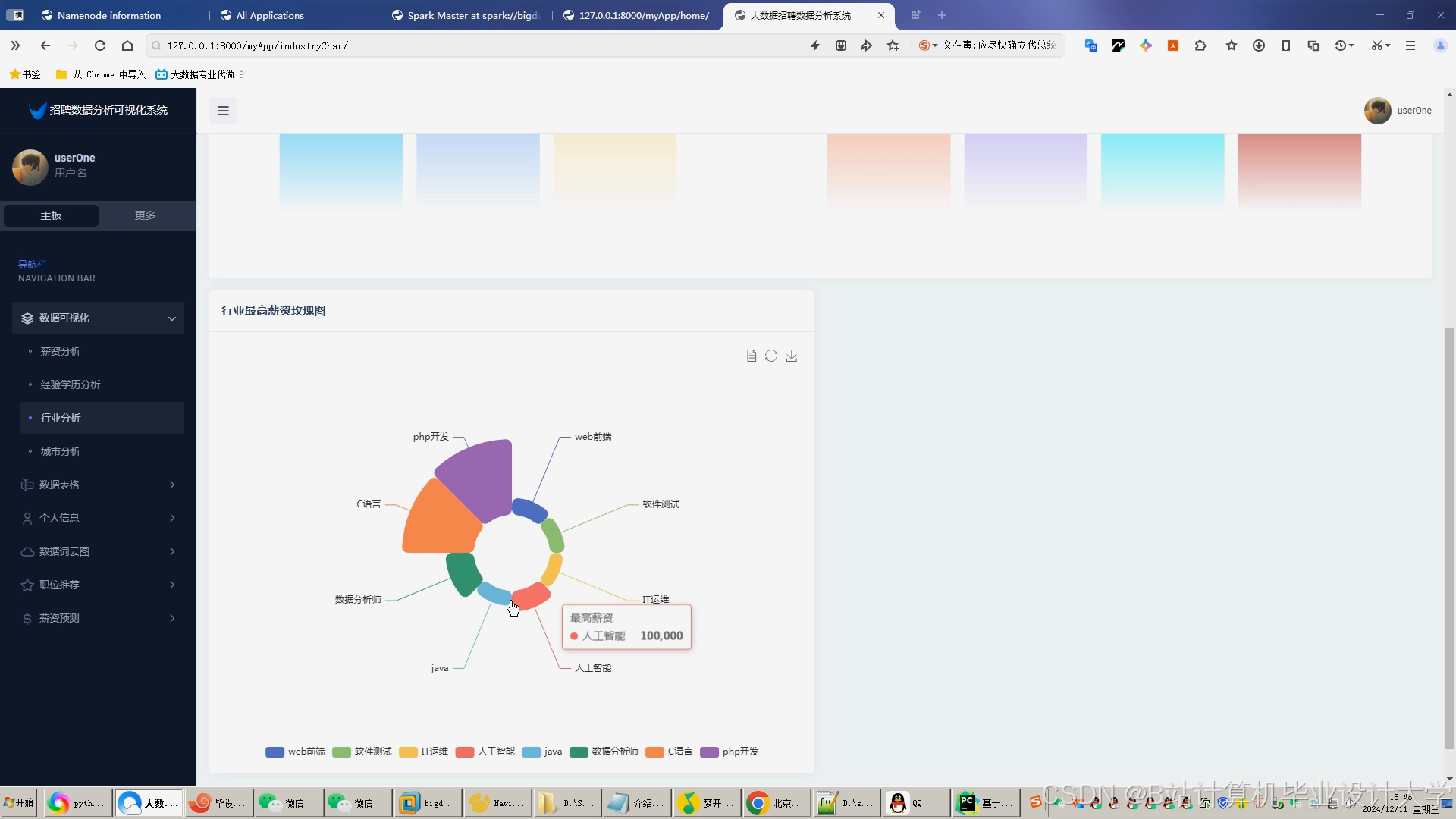

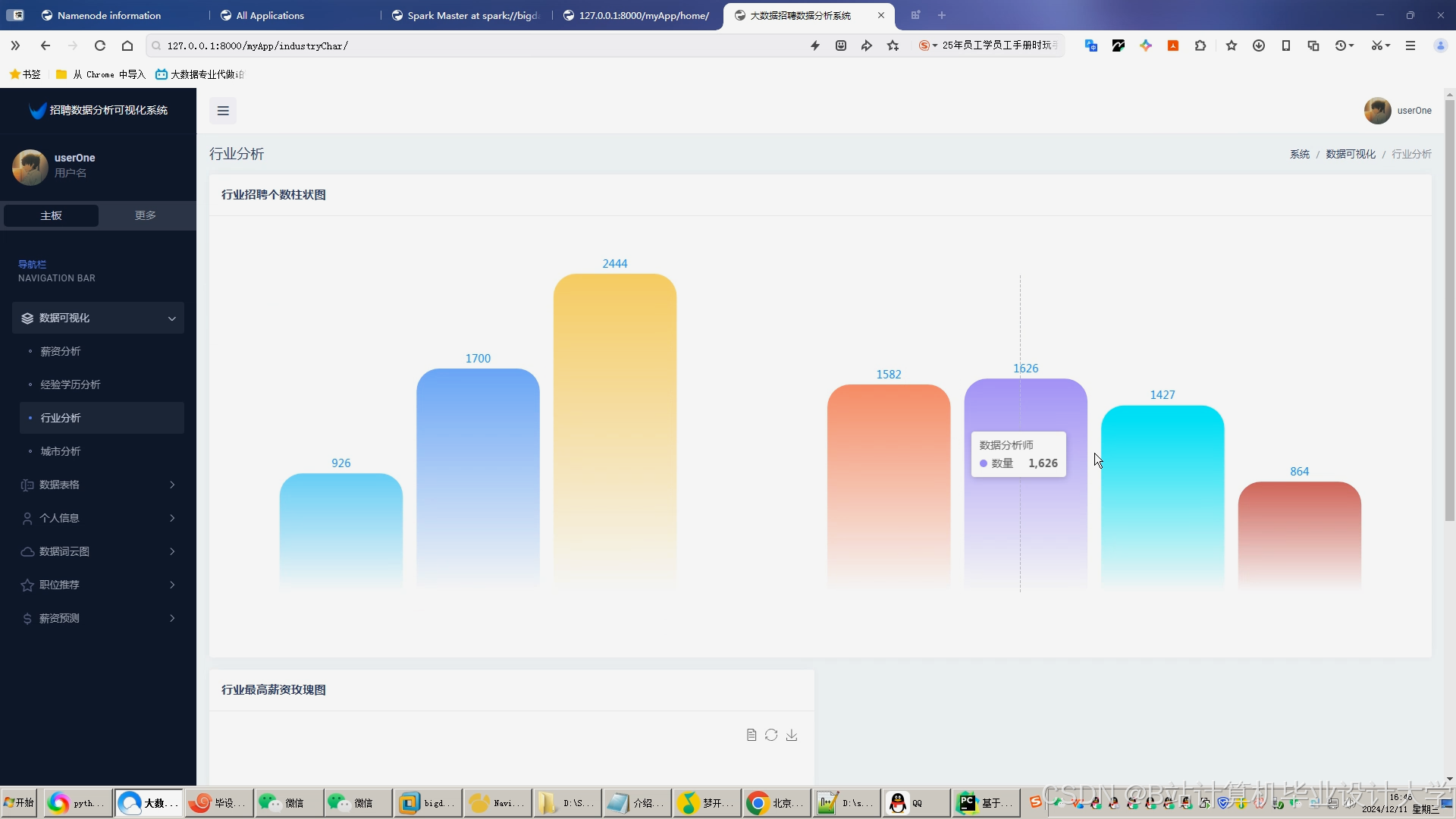

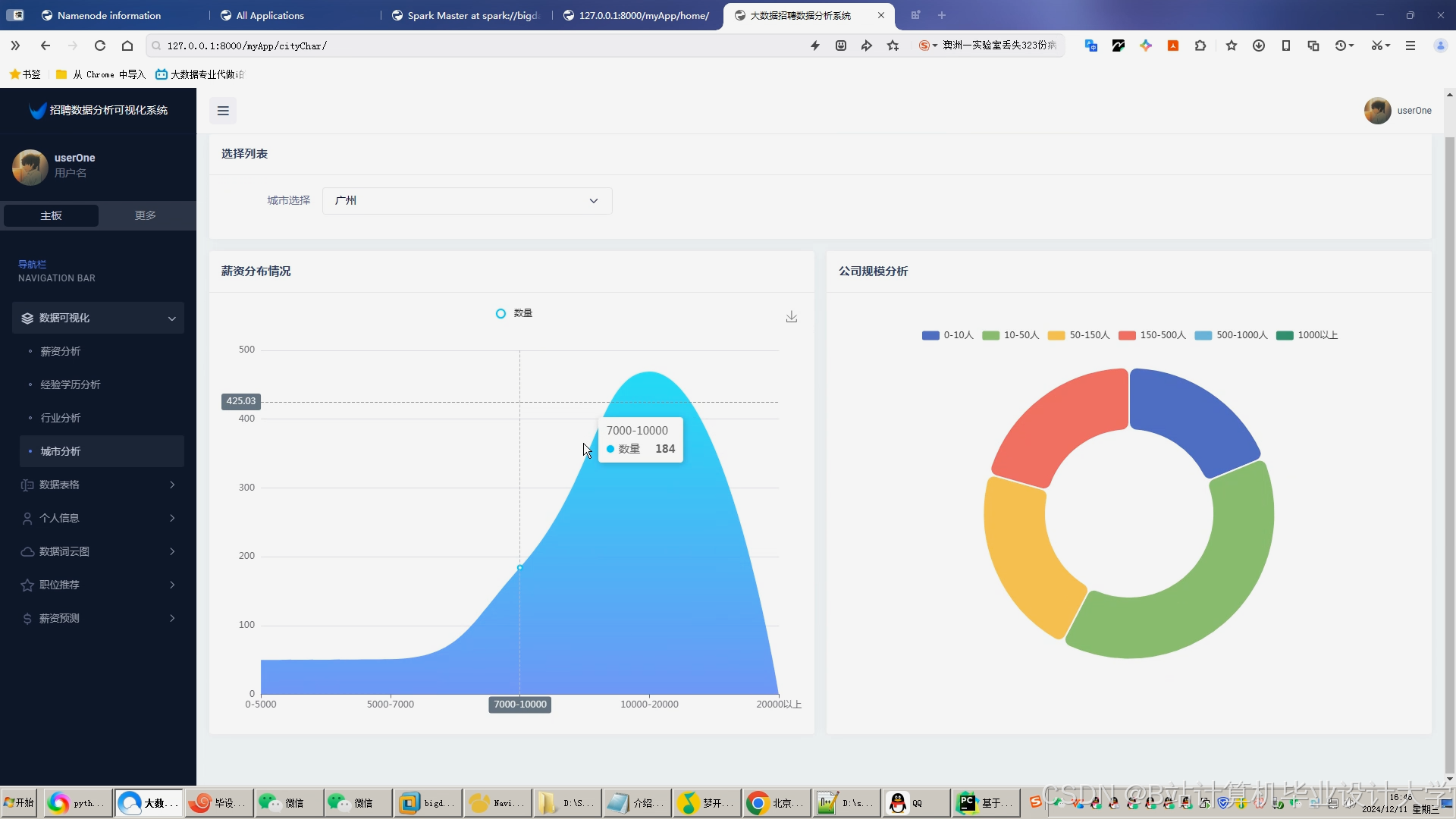

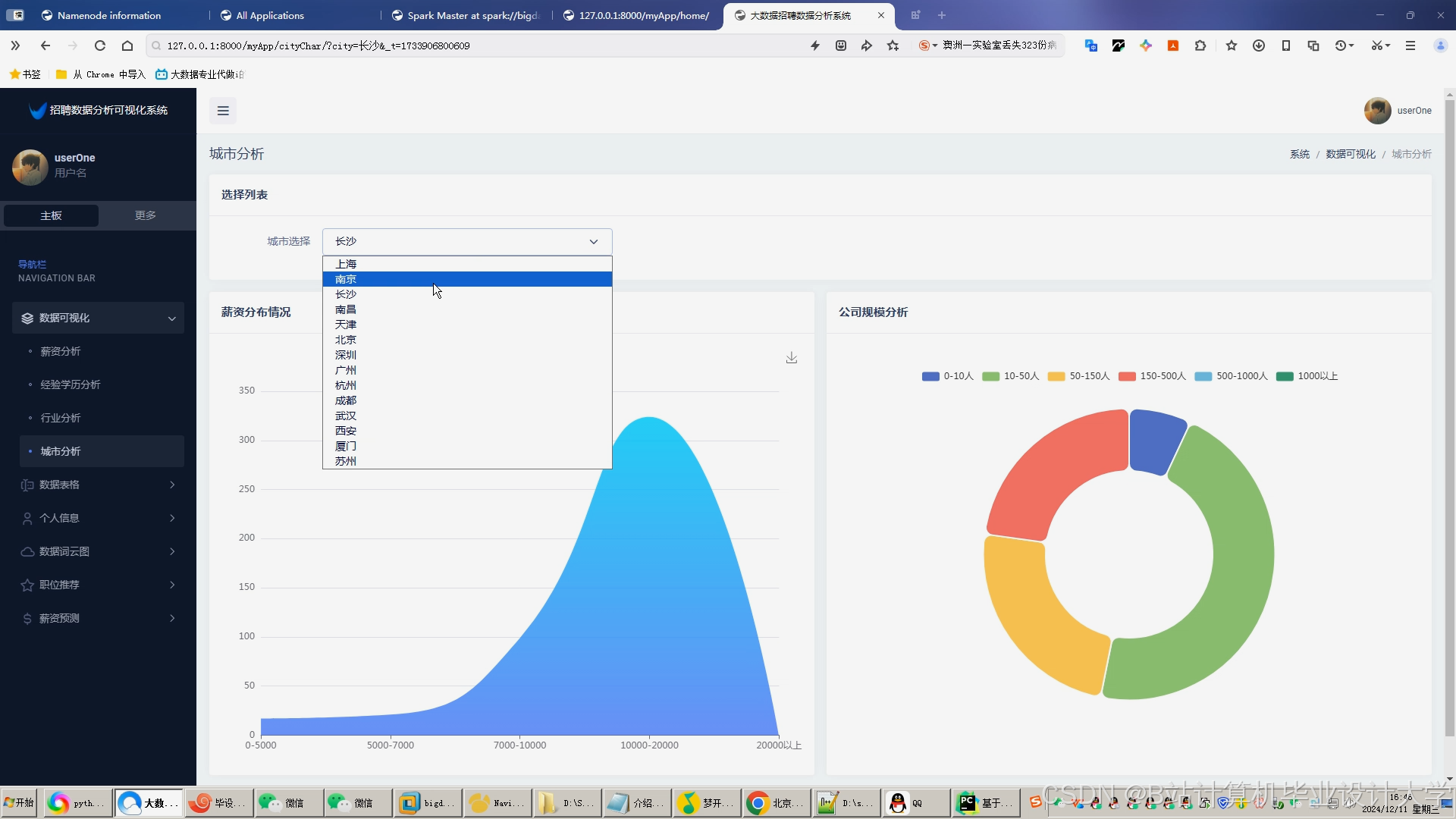

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

413

413

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?