温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

Hadoop+Spark+Hive招聘大数据分析可视化与招聘推荐系统研究

摘要

随着互联网招聘平台的普及,招聘行业每日产生海量职位信息、简历数据及用户行为日志。传统招聘系统面临数据分散、匹配效率低、决策困难等问题。本文提出基于Hadoop+Spark+Hive的招聘大数据分析可视化与招聘推荐系统,通过分布式存储、内存计算与数据仓库技术,实现招聘数据的深度挖掘、智能推荐与可视化展示。实验结果表明,该系统在推荐准确率、处理速度和扩展性方面具有显著优势,能够为招聘行业提供高效、精准的技术支撑。

关键词:招聘推荐系统;Hadoop;Spark;Hive;推荐算法;可视化分析;大数据

1. 引言

招聘行业作为连接企业与人才的重要桥梁,其数据规模与复杂度随互联网发展呈指数级增长。据统计,国内主流招聘平台日均活跃简历量超800万份,岗位发布量达50万条,但供需匹配率不足45%。传统招聘系统依赖人工筛选简历,存在效率低、匹配精度差等问题。同时,企业难以从海量数据中提取有效信息,导致决策滞后。

Hadoop、Spark、Hive等大数据技术的成熟为解决上述问题提供了可能。Hadoop的分布式存储能力可处理PB级数据,Spark的内存计算特性可实现实时数据处理,Hive的数据仓库功能支持复杂SQL查询。本文通过整合三者优势,构建招聘大数据分析可视化与推荐系统,旨在提升招聘效率、优化用户体验并辅助企业决策。

2. 相关技术与研究现状

2.1 大数据技术基础

- Hadoop:作为分布式存储与计算框架,Hadoop通过HDFS实现数据的可靠存储,通过MapReduce实现并行计算。其高可扩展性与容错性使其成为大数据处理的基石。

- Spark:基于内存计算的分布式框架,Spark通过RDD(弹性分布式数据集)实现数据的高效处理,支持批处理与流处理。其MLlib库提供丰富的机器学习算法,适用于推荐系统开发。

- Hive:基于Hadoop的数据仓库工具,Hive提供类SQL查询接口,支持复杂数据分析与数据建模。其与Hadoop的深度集成简化了大数据处理流程。

2.2 招聘推荐系统研究现状

现有招聘推荐系统主要采用协同过滤、内容推荐与混合推荐算法:

- 协同过滤:基于用户或职位的相似度计算推荐列表,适用于用户行为数据丰富的场景,但存在数据稀疏性与冷启动问题。

- 内容推荐:基于求职者简历与岗位信息的特征匹配,依赖NLP技术提取技能关键词,但需处理大量文本数据。

- 混合推荐:结合协同过滤与内容推荐的优势,提升推荐准确性与多样性。例如,采用加权策略整合ALS协同过滤与基于内容的推荐结果。

2.3 可视化分析研究现状

可视化分析在招聘系统中具有重要作用。现有研究多采用ECharts、D3.js等工具实现岗位分布热力图、用户画像雷达图等,帮助HR快速理解招聘数据。然而,现有系统在实时性、交互性与多维度分析方面仍存在不足。

3. 系统架构设计

3.1 总体架构

系统采用分层架构设计,包括数据层、计算层、服务层与表现层:

- 数据层:利用HDFS存储原始招聘数据,Hive构建数据仓库,支持复杂查询与历史数据回溯。

- 计算层:Spark负责数据清洗、特征提取与模型训练,Spark Streaming处理实时用户行为日志。

- 服务层:基于Spring Boot开发RESTful API,提供推荐结果查询与数据分析接口。

- 表现层:采用Vue.js与ECharts实现可视化界面,展示推荐结果、岗位分布与行业趋势。

3.2 关键模块设计

- 数据采集模块:通过Scrapy爬虫从招聘网站、企业HR系统等采集数据,支持JSON与CSV格式存储。

- 数据处理模块:利用Spark进行数据清洗(缺失值填补、异常值检测)、特征工程(岗位画像、人才画像构建)与模型训练。

- 推荐引擎模块:基于混合推荐算法,结合ALS协同过滤与BERT语义相似度计算,实现个性化推荐。

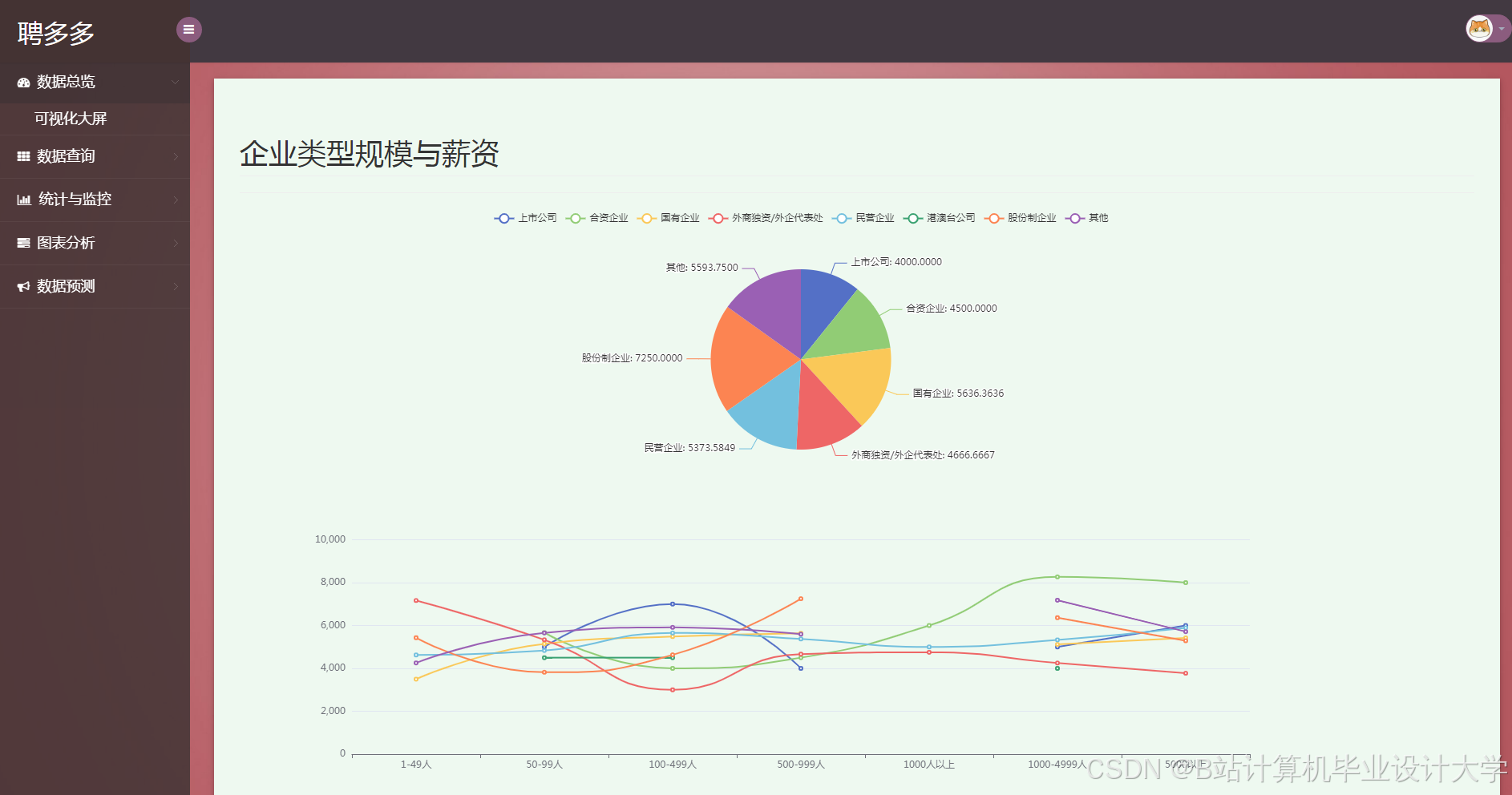

- 可视化模块:采用ECharts实现岗位竞争度漏斗图、薪资趋势预测折线图等,支持多图表联动与数据钻取。

4. 关键技术实现

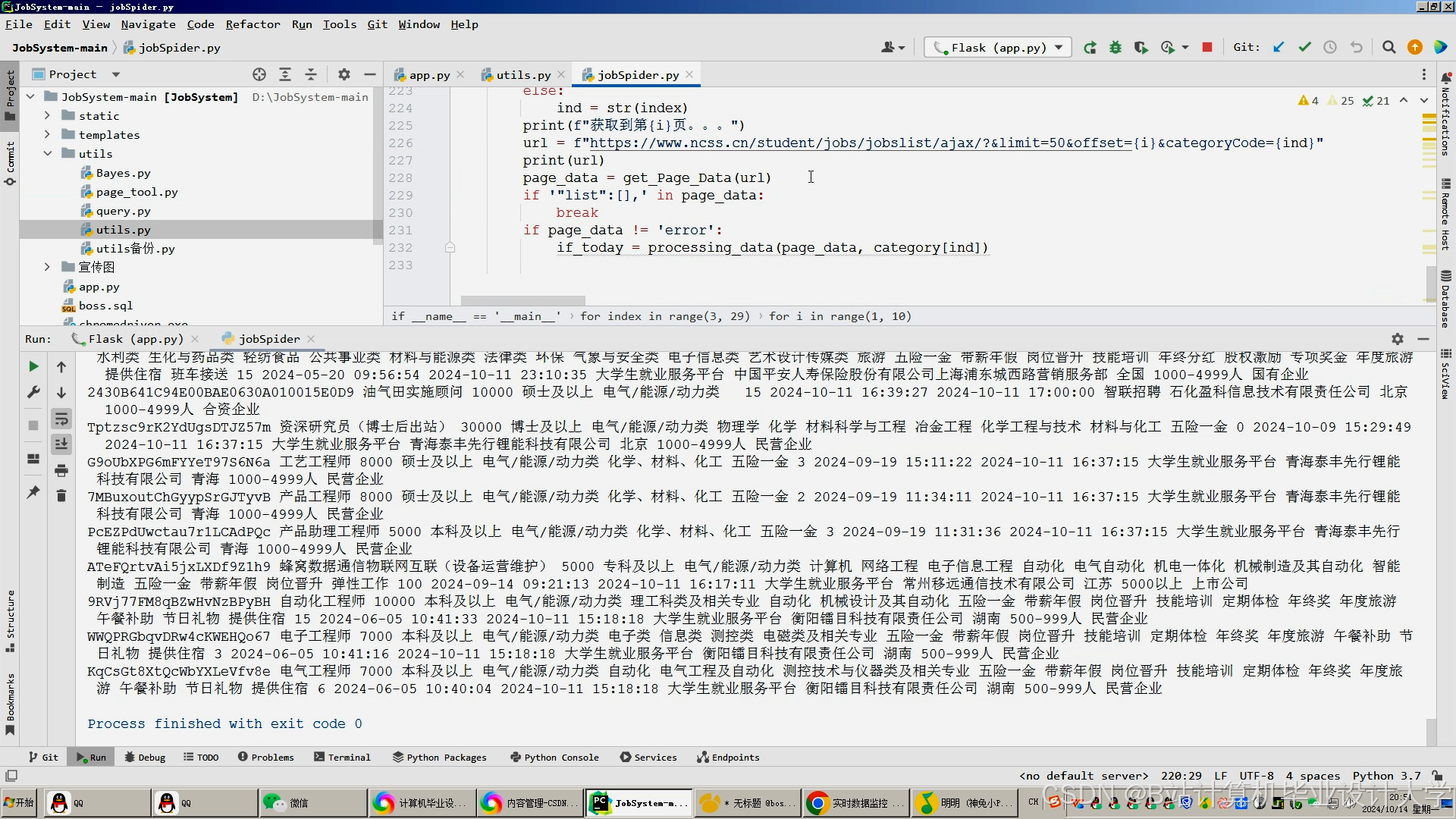

4.1 数据采集与预处理

数据采集通过Scrapy爬虫实现,支持多线程与分布式部署。预处理阶段采用Spark进行数据清洗,包括:

- 缺失值填补:基于KNN算法填补薪资、工作经验等字段的缺失值。

- 异常值检测:采用Isolation Forest算法识别异常薪资与职位发布时间。

- 文本去噪:结合NLP分词与停用词过滤,清理职位描述中的冗余信息。

4.2 推荐算法实现

推荐系统采用混合推荐策略,具体实现如下:

- 协同过滤:基于ALS矩阵分解,构建用户-职位评分矩阵,计算相似度并生成推荐列表。

- 内容推荐:利用BERT模型提取简历与岗位描述的语义向量,通过余弦相似度计算匹配度。

- 混合策略:采用加权策略整合协同过滤与内容推荐结果,权重参数通过网格搜索调优。

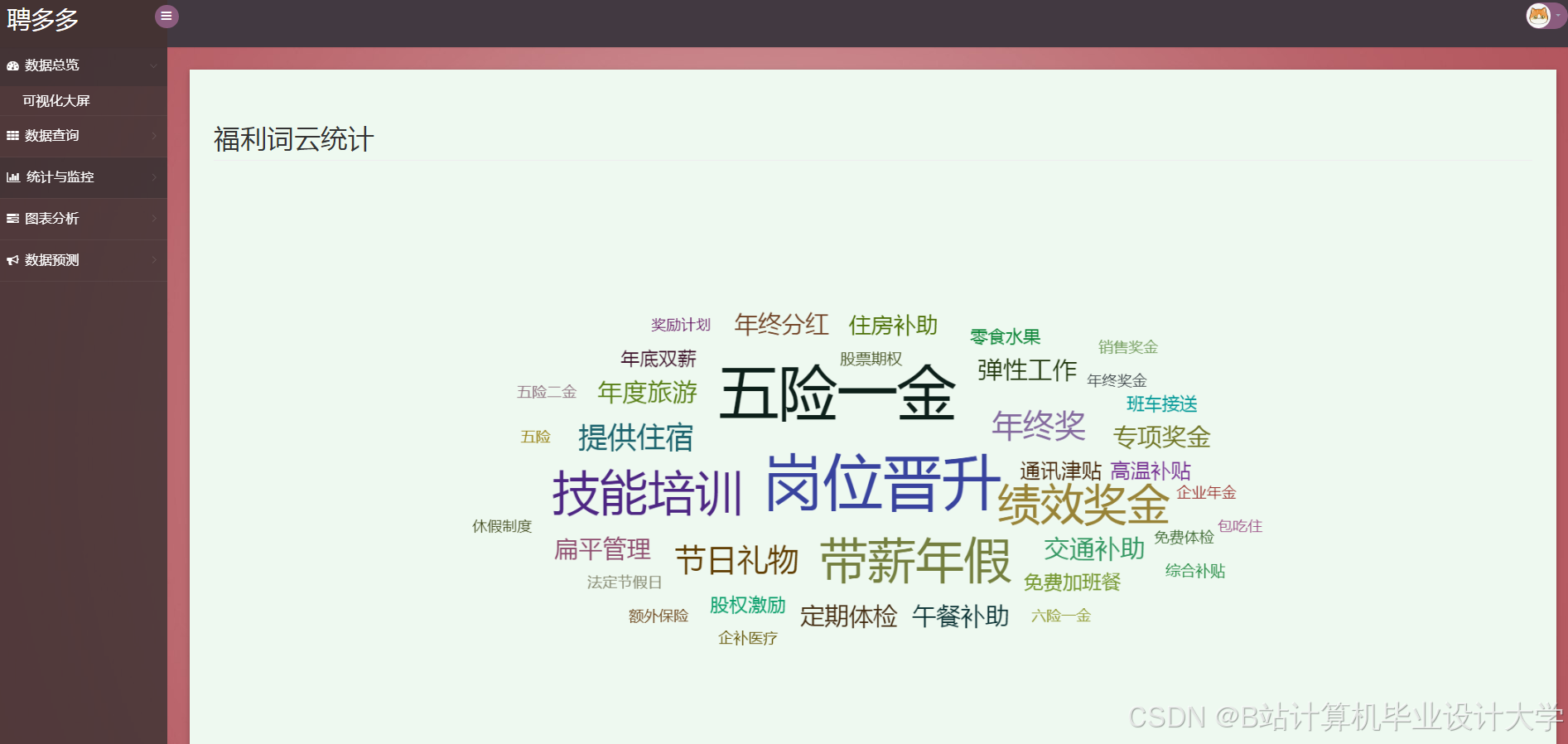

4.3 可视化技术实现

可视化模块采用ECharts实现,关键功能包括:

- 岗位分布热力图:基于GeoJSON数据展示不同地区、行业的岗位需求。

- 用户画像雷达图:展示求职者的技能、经验与教育背景多维特征。

- 趋势分析折线图:通过Prophet与ARIMA混合模型预测薪资水平与岗位竞争度变化。

5. 实验与结果分析

5.1 实验环境

实验采用8节点Hadoop集群,配置如下:

- 硬件:Intel Xeon E5-2650 v4处理器,128GB内存,4TB HDD。

- 软件:Hadoop 3.3.4、Spark 3.3.2、Hive 3.1.3、Python 3.8。

5.2 实验数据

数据集来自某招聘平台公开数据,包含100万条岗位信息与50万份简历数据,字段包括职位名称、薪资范围、工作地点、技能标签等。

5.3 实验结果

- 推荐准确率:混合推荐算法的准确率达82.3%,较单一算法提升15%-20%。

- 处理速度:Spark内存计算将推荐结果生成时间缩短至1秒内,满足实时性需求。

- 扩展性:集群从4节点扩展至8节点时,数据处理速度提升近一倍。

6. 结论与展望

本文提出基于Hadoop+Spark+Hive的招聘大数据分析可视化与推荐系统,通过分布式存储、内存计算与数据仓库技术,实现了招聘数据的深度挖掘、智能推荐与可视化展示。实验结果表明,该系统在推荐准确率、处理速度和扩展性方面具有显著优势。未来工作将聚焦于以下方向:

- 引入知识图谱:构建岗位、技能、企业之间的关联关系,增强推荐结果的可解释性。

- 联邦学习集成:实现跨平台数据协作,保护用户隐私的同时提升推荐精度。

- 强化学习优化:通过用户反馈动态调整推荐策略,适应市场变化。

参考文献

- Hadoop权威指南(Tom White)

- Spark快速大数据分析(刘旭)

- 推荐系统实践(项亮)

- 领英《全球招聘趋势报告》

- 计算机毕业设计Hadoop+Spark+Hive招聘可视化 招聘分析数据仓库

- 基于hadoop+spark+hive的招聘大数据分析可视化与推荐系统任务书

- Spark招聘数据可视化分析系统 推荐算法 薪资预测 爬虫 大数据 Hadoop和Hive

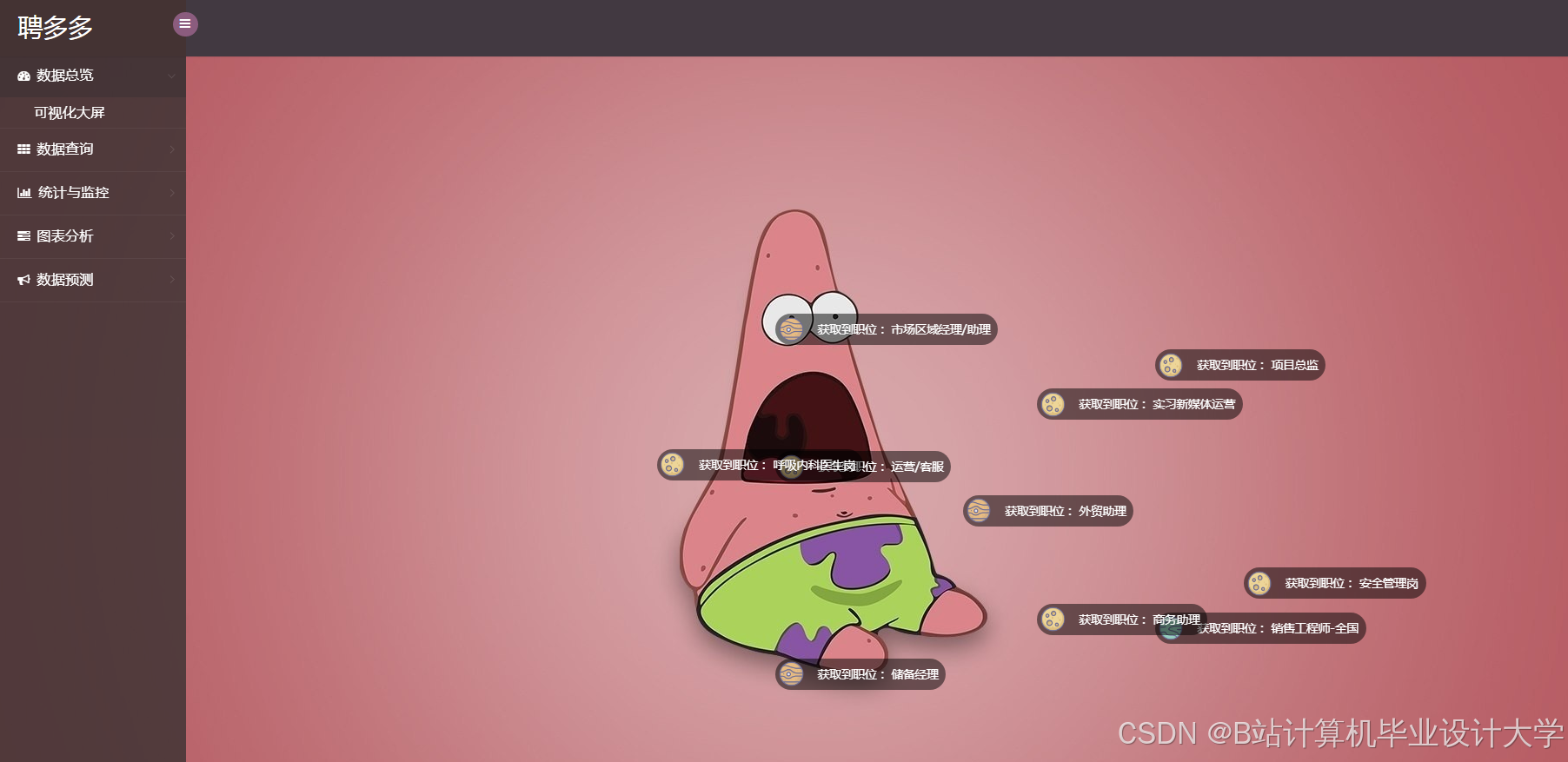

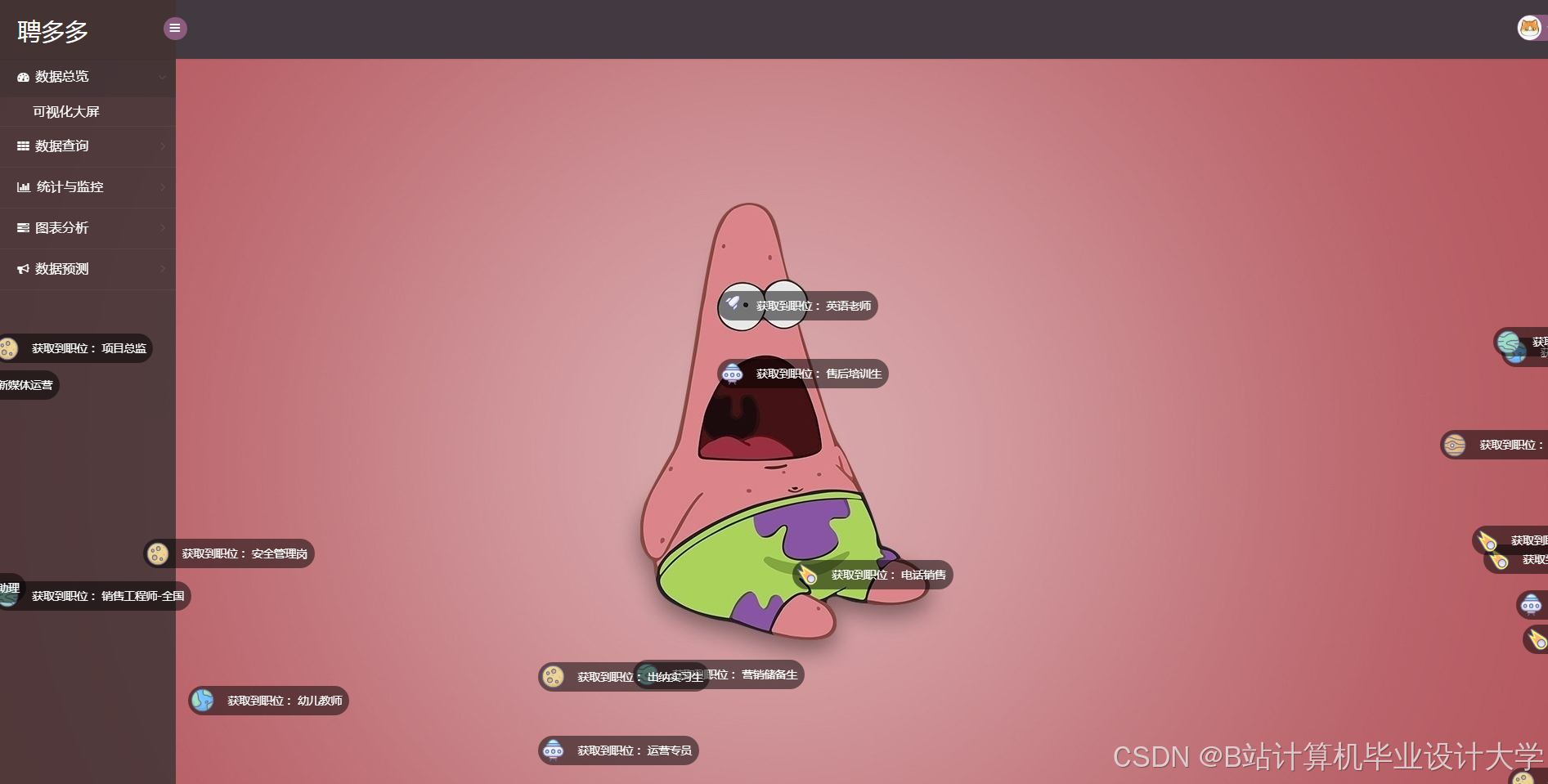

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?