温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

作者简介:Java领域优质创作者、优快云博客专家 、优快云内容合伙人、掘金特邀作者、阿里云博客专家、51CTO特邀作者、多年架构师设计经验、多年校企合作经验,被多个学校常年聘为校外企业导师,指导学生毕业设计并参与学生毕业答辩指导,有较为丰富的相关经验。期待与各位高校教师、企业讲师以及同行交流合作

主要内容:Java项目、Python项目、前端项目、PHP、ASP.NET、人工智能与大数据、单片机开发、物联网设计与开发设计、简历模板、学习资料、面试题库、技术互助、就业指导等

业务范围:免费功能设计、开题报告、任务书、中期检查PPT、系统功能实现、代码编写、论文编写和辅导、论文降重、长期答辩答疑辅导、腾讯会议一对一专业讲解辅导答辩、模拟答辩演练、和理解代码逻辑思路等。

收藏点赞不迷路 关注作者有好处

文末获取源码

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

《Hadoop+Spark+Hive招聘大数据分析可视化与招聘推荐系统》任务书

一、研究背景与意义

(一)研究背景

随着互联网技术的快速发展,招聘行业面临着海量数据的挑战。招聘网站每天都会产生大量的职位信息、简历投递、面试反馈等数据,这些数据不仅数量庞大,而且种类繁多。如何高效地处理和分析这些数据,提取有价值的信息,成为招聘行业亟待解决的问题。同时,企业和求职者对精准匹配、高效招聘的需求日益增长。

传统的招聘方式往往依赖于人工筛选简历和发布职位信息,效率低下且难以精准匹配。随着大数据技术的兴起,利用Hadoop、Spark、Hive等大数据处理框架,可以实现对招聘数据的快速处理、深度挖掘与智能分析,为招聘企业和求职者提供更加精准、高效的服务。

(二)研究意义

本研究旨在设计并实现一个基于Hadoop、Spark和Hive的招聘大数据分析可视化与招聘推荐系统,具有以下重要意义:

- 提高招聘效率:通过对招聘数据的深度挖掘和分析,可以自动化处理简历筛选、职位匹配等环节,显著提高招聘效率。

- 提升招聘质量:利用个性化推荐算法,根据求职者的简历信息、求职意向以及企业的招聘需求,实现精准的职位推荐,提升招聘质量。

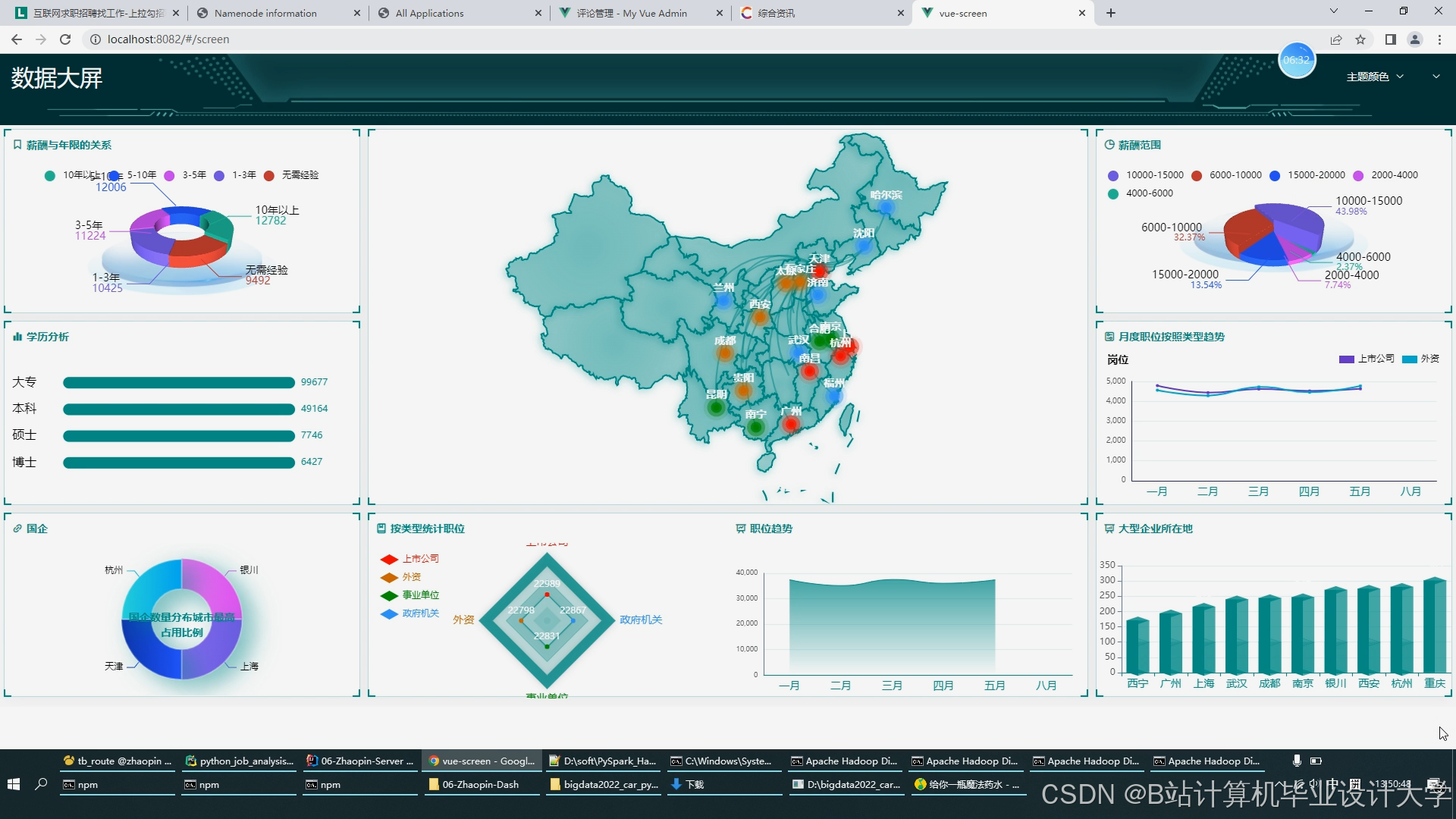

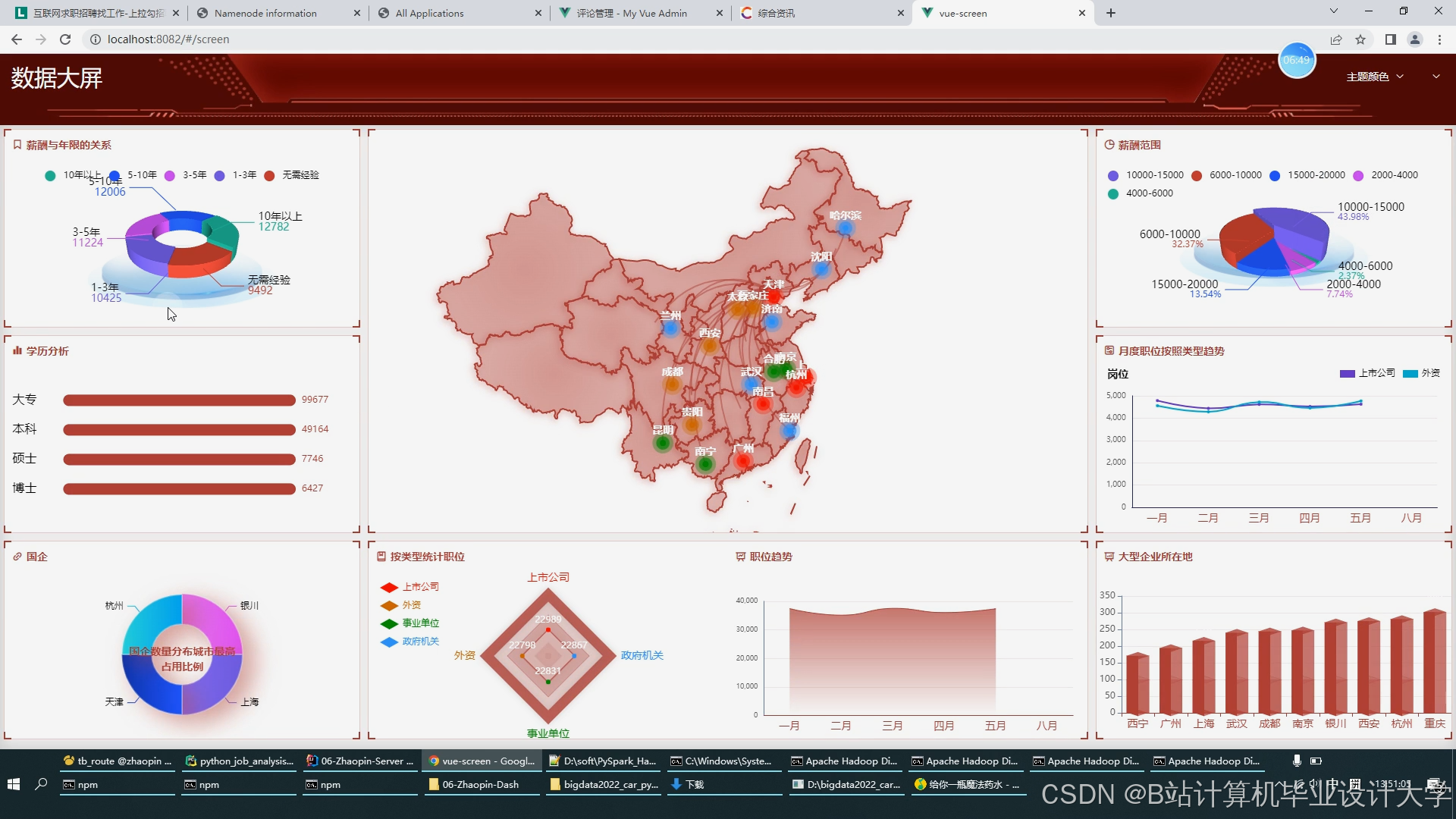

- 优化招聘决策:通过可视化展示招聘数据分析结果,帮助招聘企业快速理解市场趋势和招聘效果,优化招聘决策。

二、研究目的与内容

(一)研究目的

本研究旨在设计并实现一个基于Hadoop、Spark和Hive的招聘大数据分析可视化与招聘推荐系统,提高招聘企业和求职者的效率,实现精准的职位推荐和招聘决策优化。

(二)研究内容

- 构建大数据处理平台

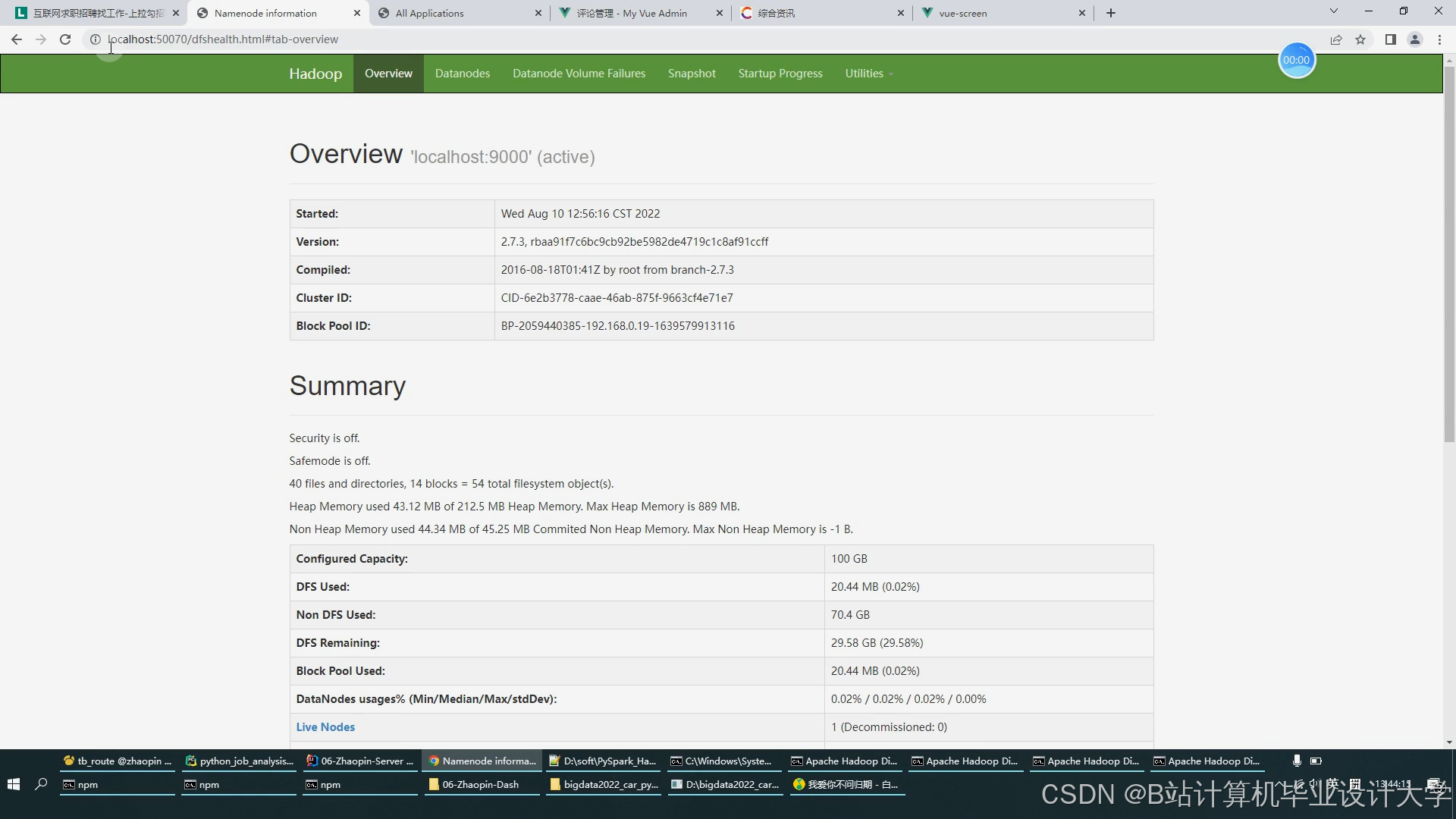

- 利用Hadoop、Spark和Hive等大数据处理框架,搭建一个稳定、高效的大数据处理平台,实现对招聘数据的分布式存储、快速处理与智能分析。

- 实现招聘推荐功能

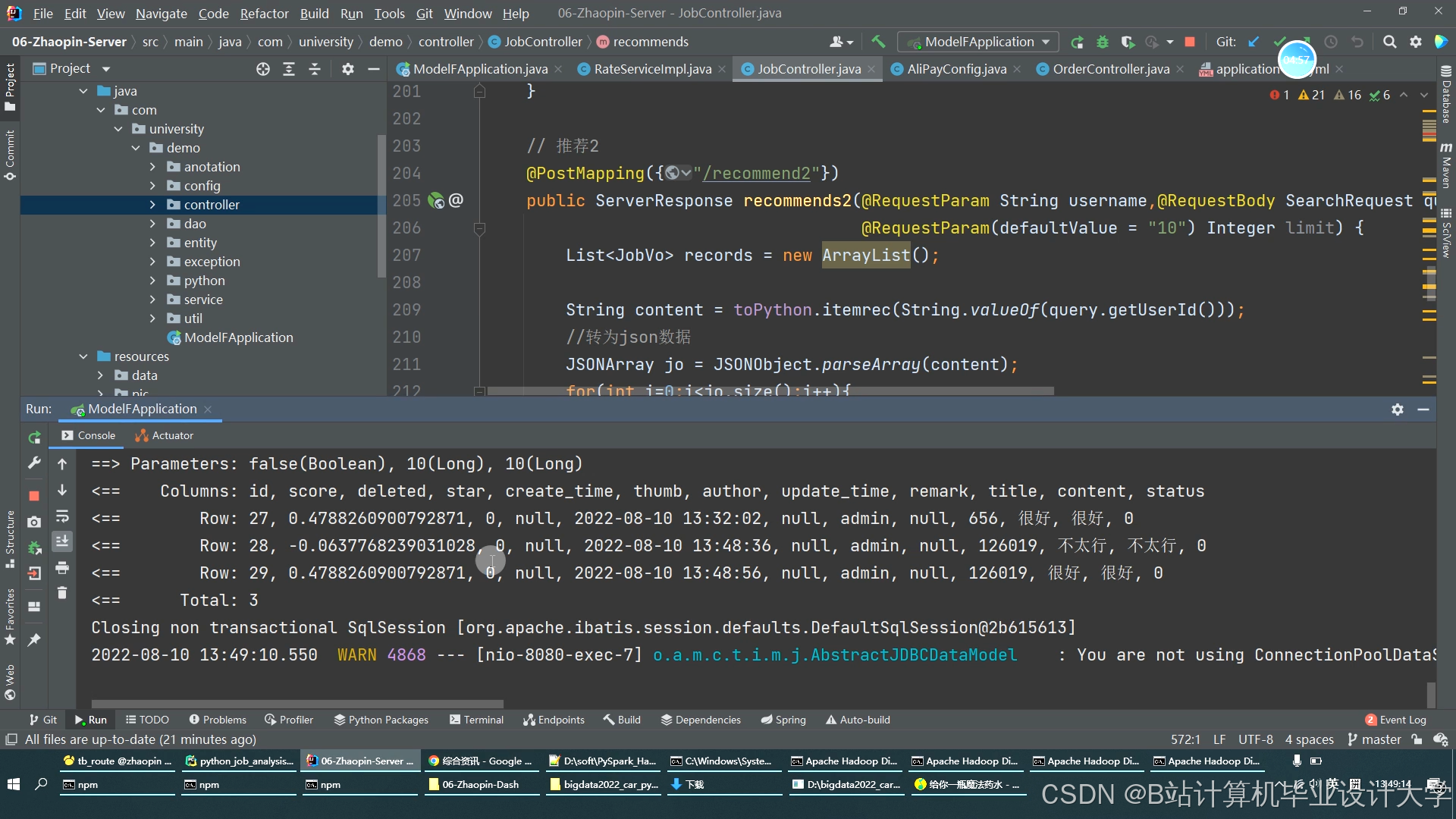

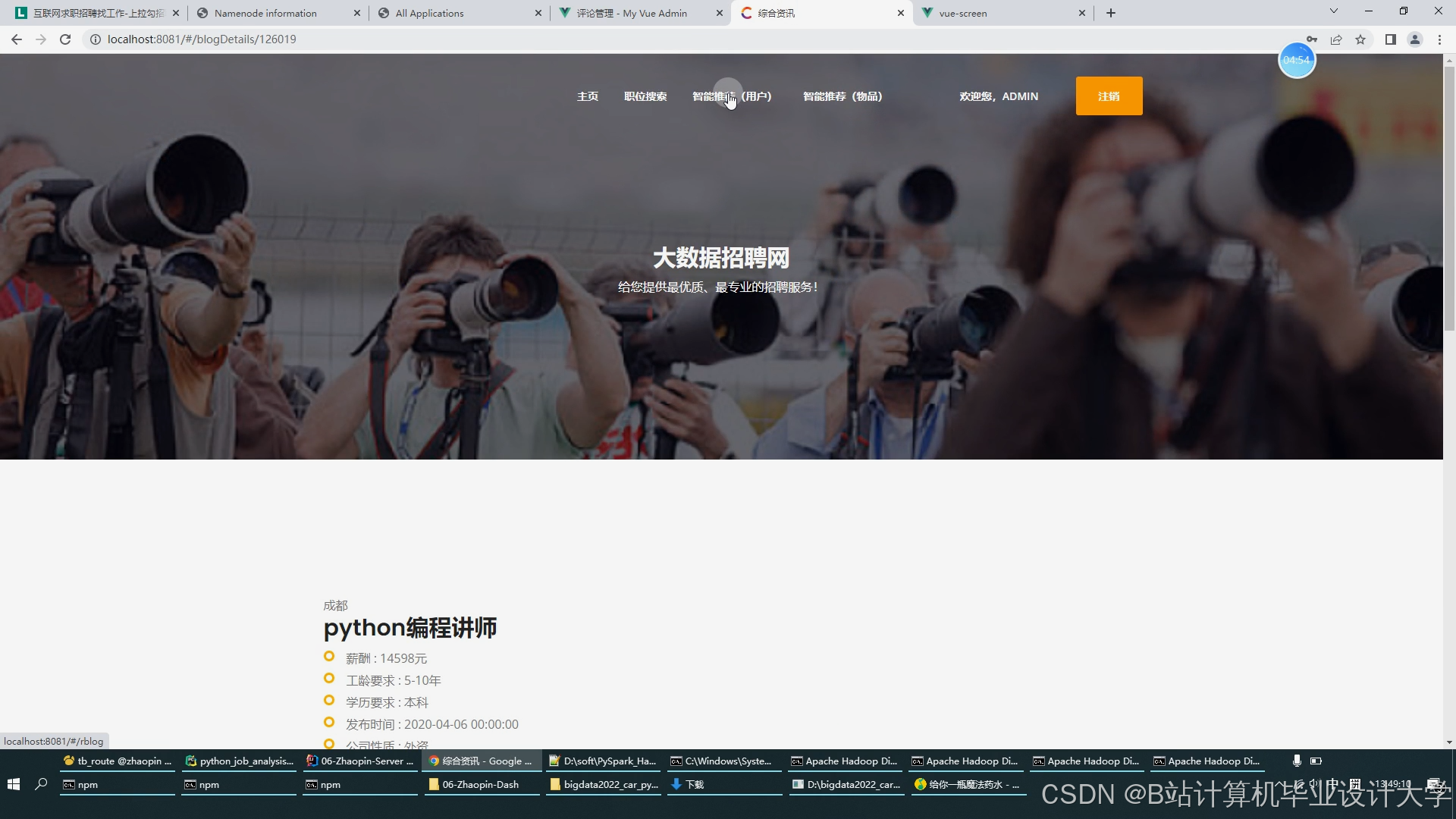

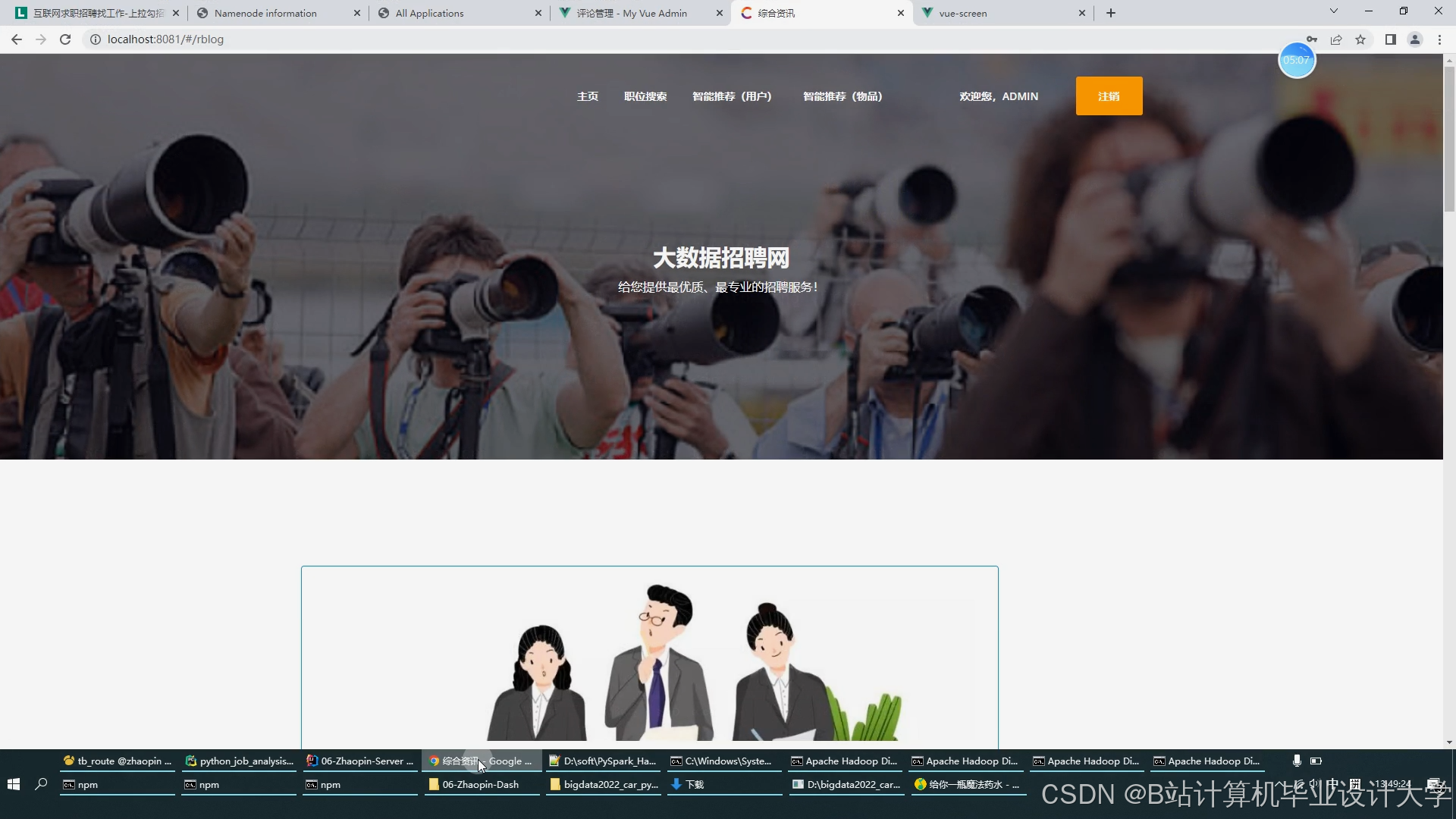

- 研究并应用先进的推荐算法,如协同过滤、基于内容的推荐等,结合求职者的简历信息、求职意向以及企业的招聘需求,实现个性化的职位推荐。

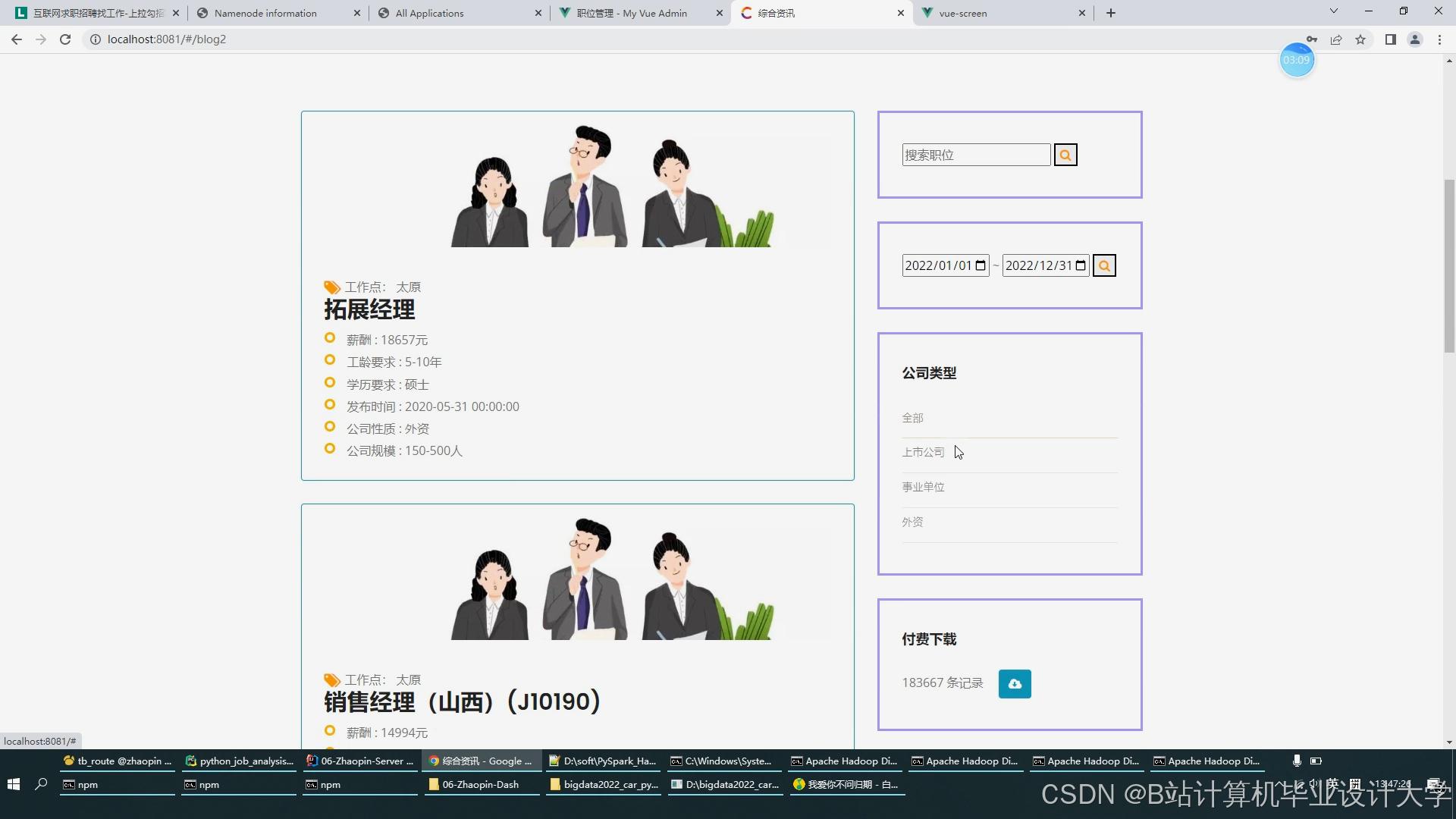

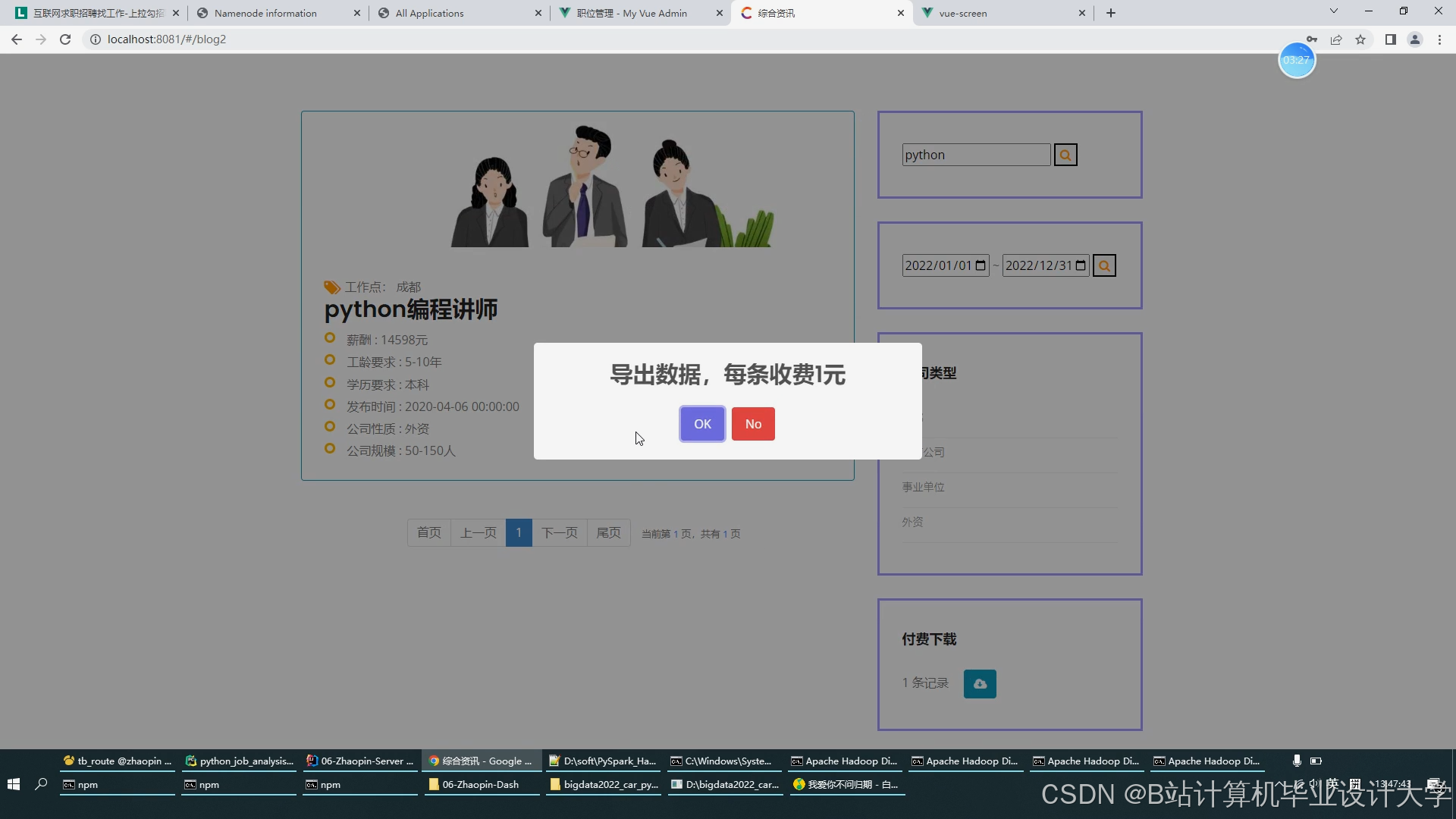

- 设计并实现可视化界面

- 采用前端技术,设计并实现一个直观、易用的可视化界面,展示招聘数据分析结果和推荐结果,帮助用户快速理解数据,优化招聘决策。

三、技术路线与方法

(一)技术路线

- 数据采集与预处理

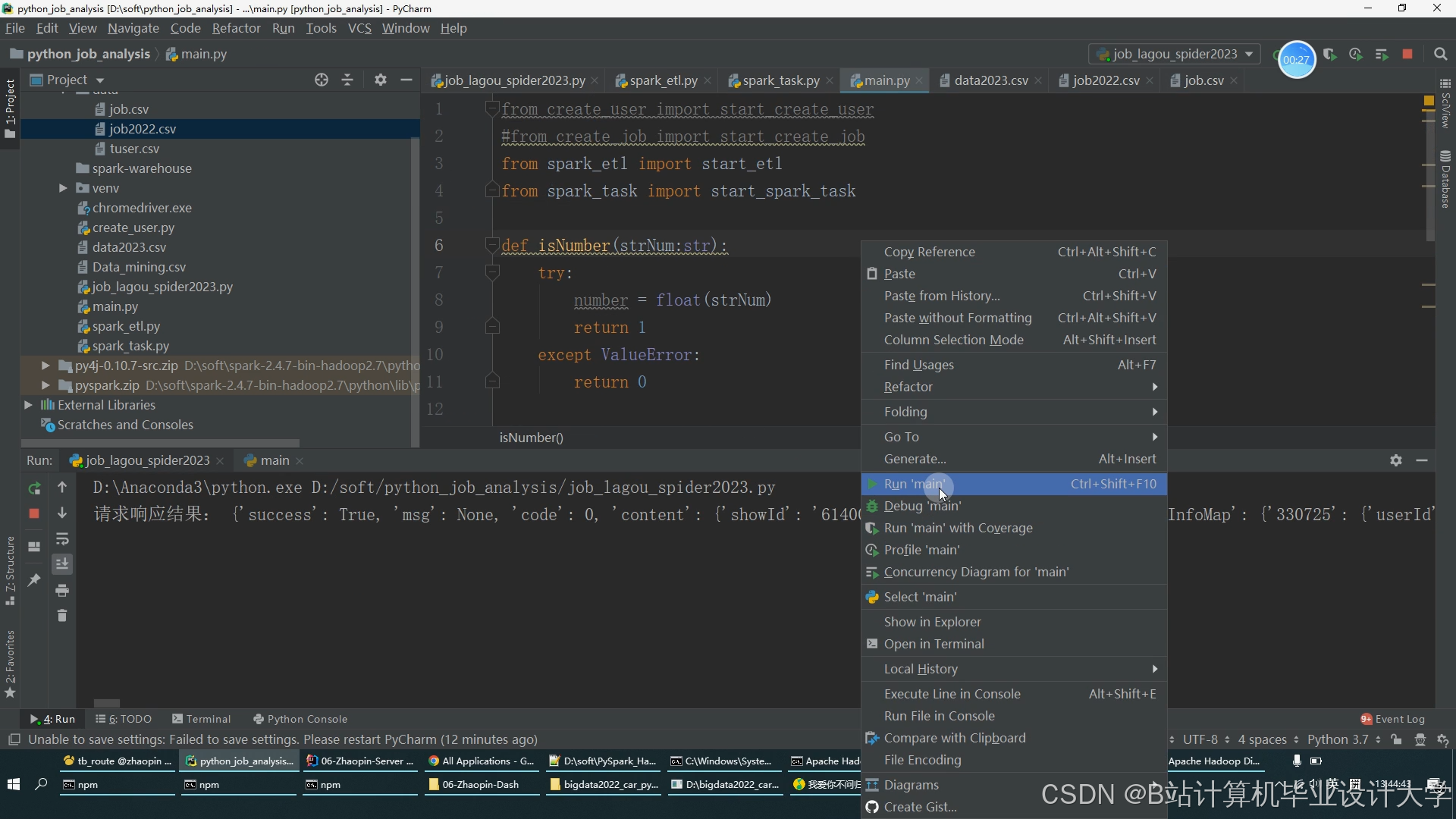

- 使用Python爬虫从各大招聘网站采集数据,包括职位信息、求职者简历、面试反馈等。

- 对采集到的数据进行清洗、去重、格式化等预处理操作,为后续分析提供高质量的数据基础。

- 数据存储与管理

- 利用Hadoop HDFS实现数据的分布式存储,确保数据的可靠性和可扩展性。

- 利用Hive进行数据仓库的建设和管理,通过SQL查询进行数据分析和提取用户特征和职位信息。

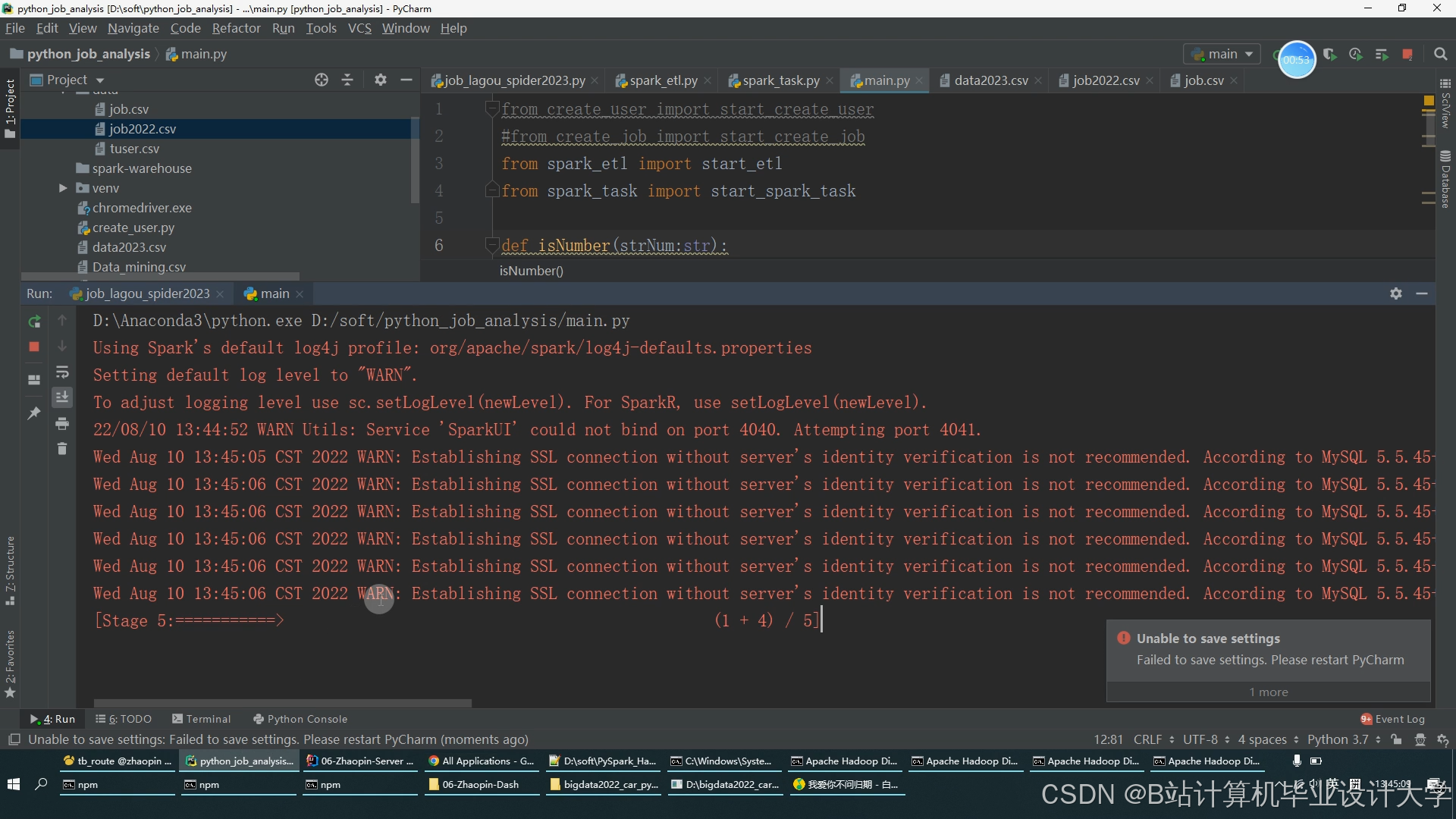

- 数据处理与分析

- 基于Spark的分布式计算能力,对招聘数据进行快速处理与分析,包括数据挖掘、关联分析、聚类分析等,提取有价值的信息和特征。

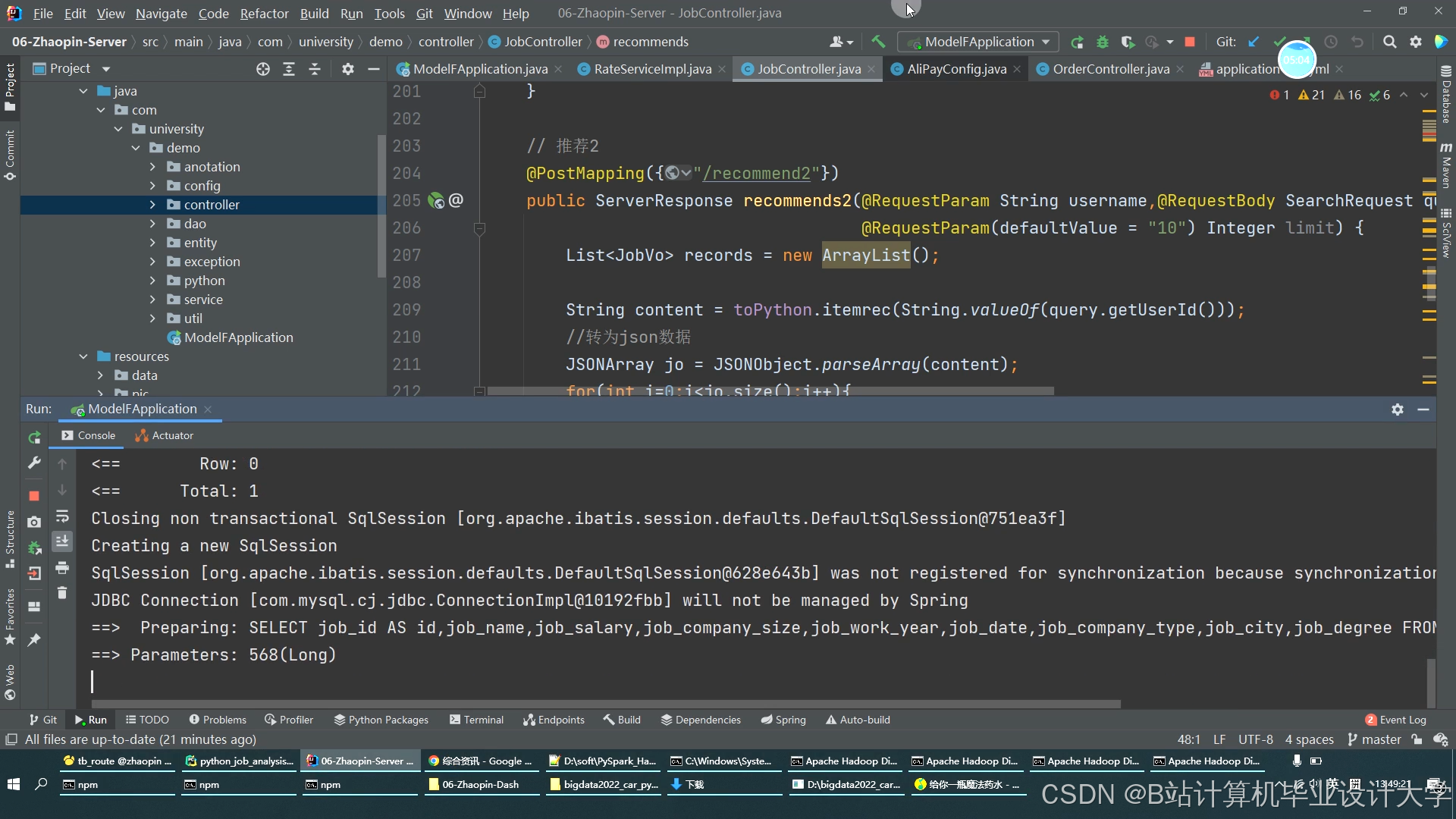

- 推荐算法实现

- 研究并应用先进的推荐算法,如协同过滤、基于内容的推荐等,结合用户行为和职位信息,实现个性化的职位推荐。

- 可视化展示

- 采用前端技术(如HTML、CSS、JavaScript等),设计并实现一个直观、易用的可视化界面,展示招聘数据分析结果和推荐结果。

(二)研究方法

- 文献分析法

- 查阅国内外相关文献,了解Hadoop、Spark、Hive以及招聘数据分析与可视化等领域的最新研究成果和技术进展,为本研究提供理论支持。

- 系统开发法

- 采用软件工程的方法,按照需求分析、系统设计、系统实现、系统测试等阶段进行系统开发,确保系统能够满足用户需求,并具备良好的稳定性和可扩展性。

- 实证研究法

- 通过实际招聘数据对系统进行测试和验证,评估系统的性能和效果,并进行必要的优化,确保系统能够在实际应用中发挥良好作用。

四、预期成果与创新点

(一)预期成果

- 开发招聘大数据分析可视化与招聘推荐系统

- 完成基于Hadoop、Spark和Hive的招聘大数据分析可视化与招聘推荐系统的设计与实现,提高招聘企业和求职者的效率。

- 实现个性化职位推荐

- 利用先进的推荐算法,结合求职者的简历信息、求职意向以及企业的招聘需求,实现个性化的职位推荐,提升招聘匹配度和效率。

- 设计并实现可视化界面

- 采用前端技术,设计并实现一个直观、易用的可视化界面,展示招聘数据分析结果和推荐结果,帮助用户快速理解数据,优化招聘决策。

(二)创新点

- 技术融合创新

- 首次将Hadoop、Spark和Hive等技术应用于招聘领域,实现招聘数据的深度挖掘和可视化展示,为招聘企业和求职者提供更加精准、高效的服务。

- 算法优化创新

- 研究并应用先进的推荐算法,如协同过滤、基于内容的推荐等,结合用户行为和职位信息,提高招聘匹配度和效率。

- 用户体验创新

- 设计并实现直观、易用的可视化界面,提升用户体验,满足用户多元化的招聘需求。

五、研究计划与进度安排

(一)研究计划

本研究计划分为以下几个阶段:

- 文献调研与需求分析阶段(第1-2周)

- 查阅国内外相关文献,了解Hadoop、Spark、Hive以及招聘数据分析与可视化等领域的最新研究成果和技术进展。

- 分析用户需求,明确系统功能和技术指标。

- 系统设计与实现阶段(第3-8周)

- 设计系统架构,划分功能模块。

- 实现数据采集与预处理、数据存储与管理、数据处理与分析、推荐算法实现以及可视化展示等功能模块。

- 实验验证与结果分析阶段(第9-10周)

- 通过实际招聘数据对系统进行测试和验证,评估系统的性能和效果。

- 根据测试结果进行系统优化和调试。

- 论文撰写与总结阶段(第11-12周)

- 撰写开题报告和毕业论文,总结本研究的主要成果和创新点。

- 对后续研究工作进行展望。

(二)进度安排

根据研究计划,合理安排各阶段的时间节点和预期成果,确保研究工作的顺利进行。具体进度安排如下:

- 第1-2周:完成文献调研与需求分析,明确研究目标和内容。

- 第3-4周:完成系统设计与实现,包括数据采集与预处理、数据存储与管理等功能模块的开发。

- 第5-6周:完成数据处理与分析、推荐算法实现等功能模块的开发。

- 第7-8周:完成可视化展示功能模块的开发。

- 第9-10周:对系统进行全面的测试和验证,评估系统性能和效果。根据测试结果进行系统优化和调试。

- 第11-12周:撰写论文,准备答辩。

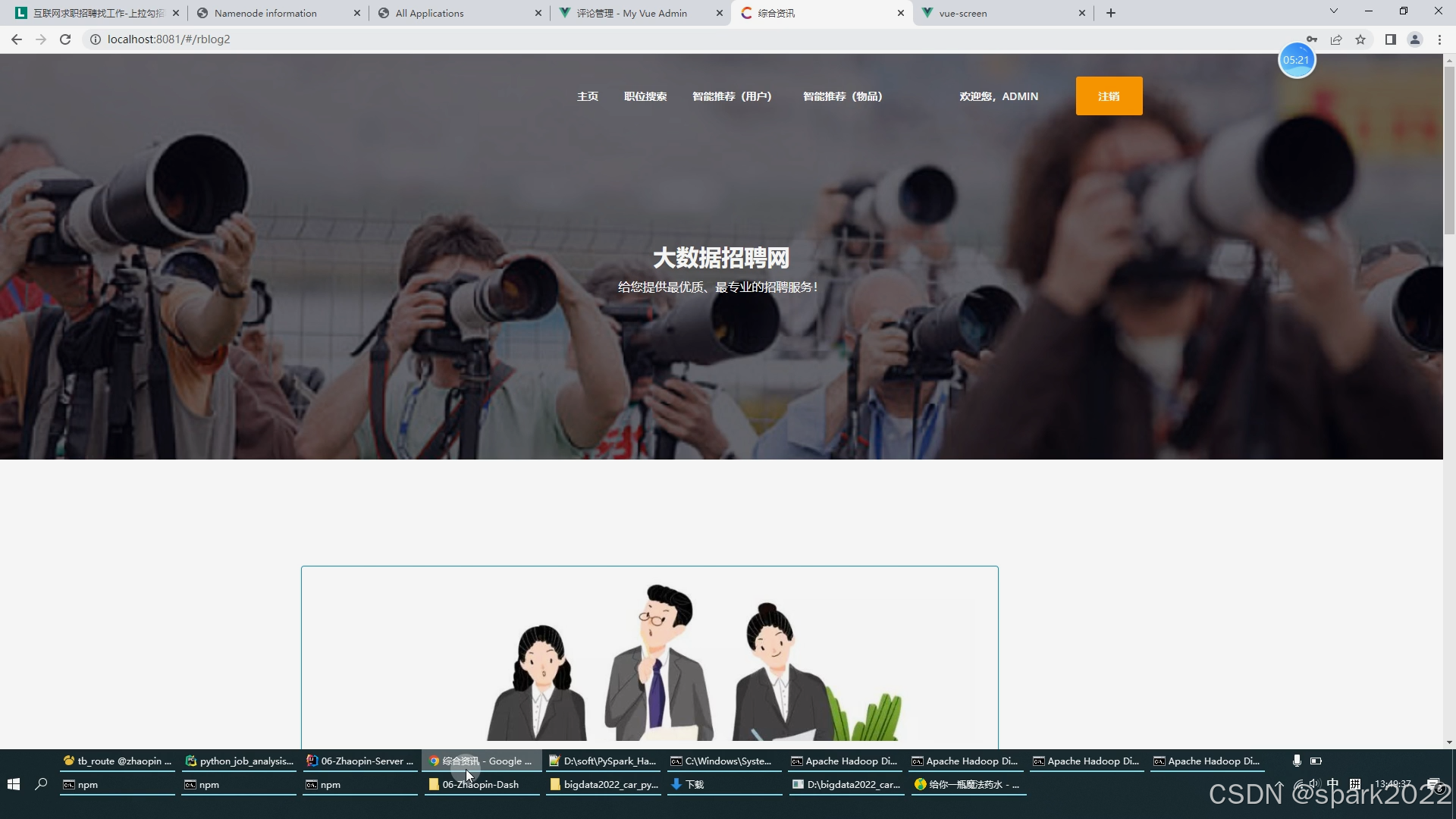

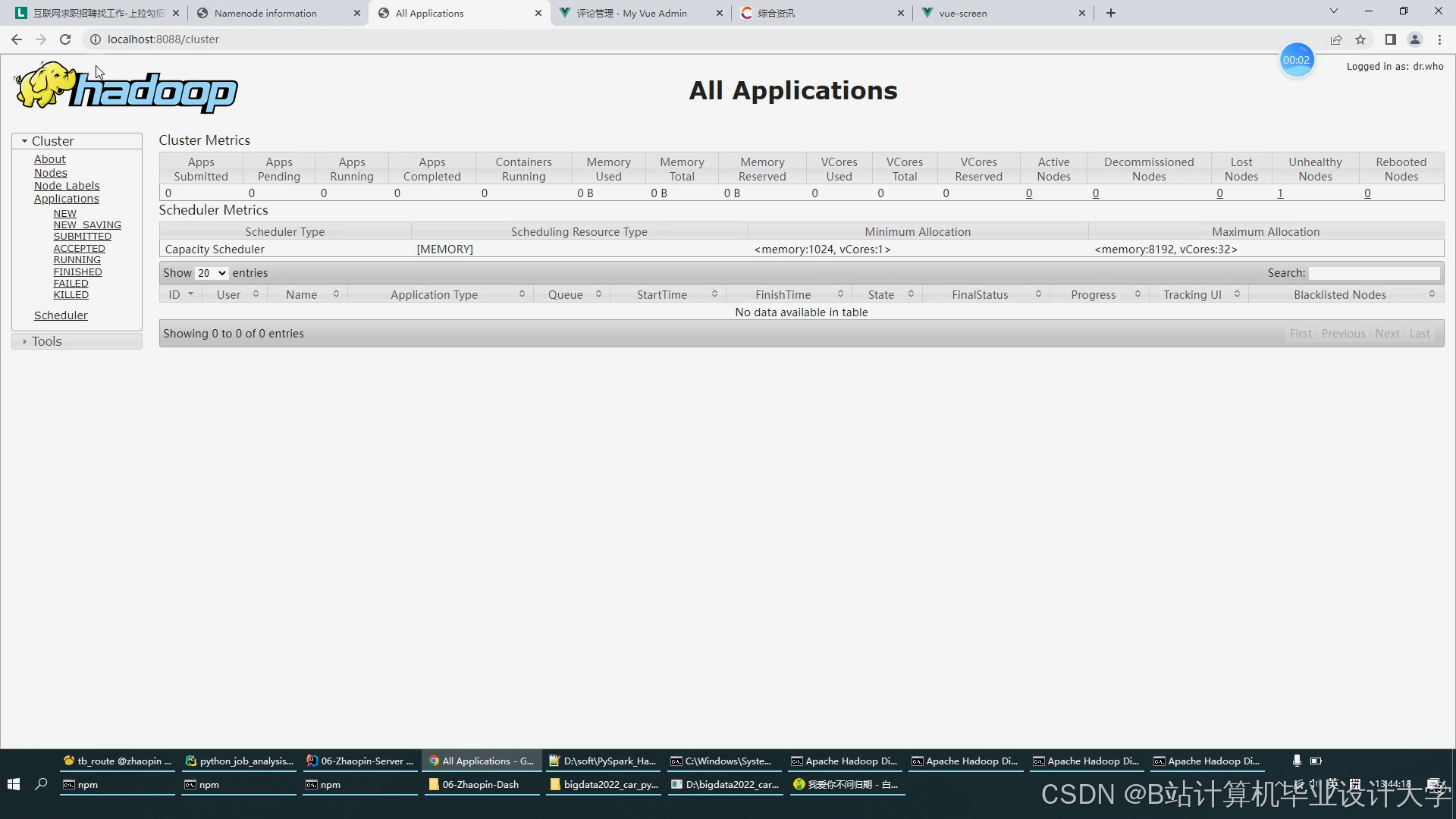

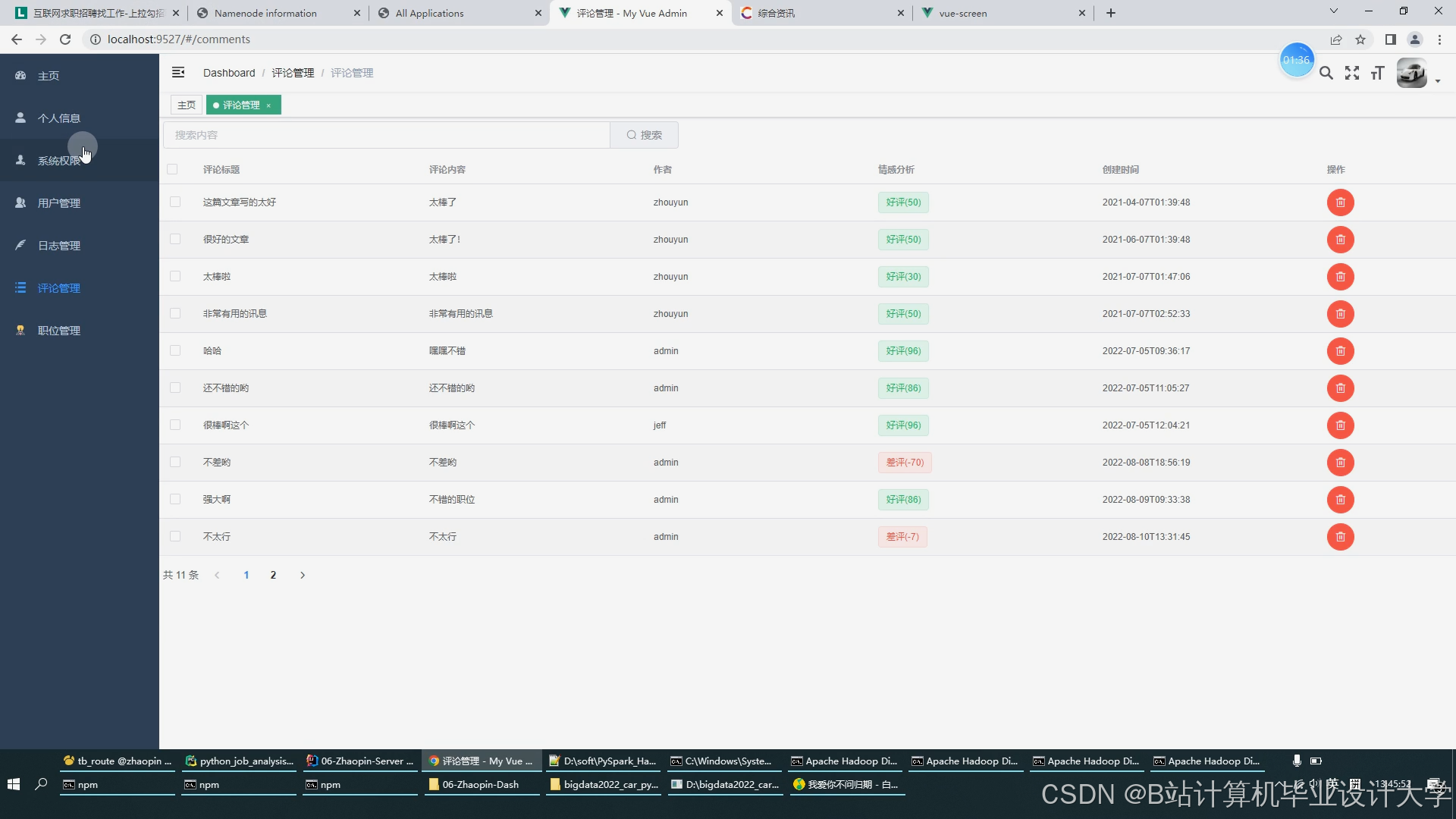

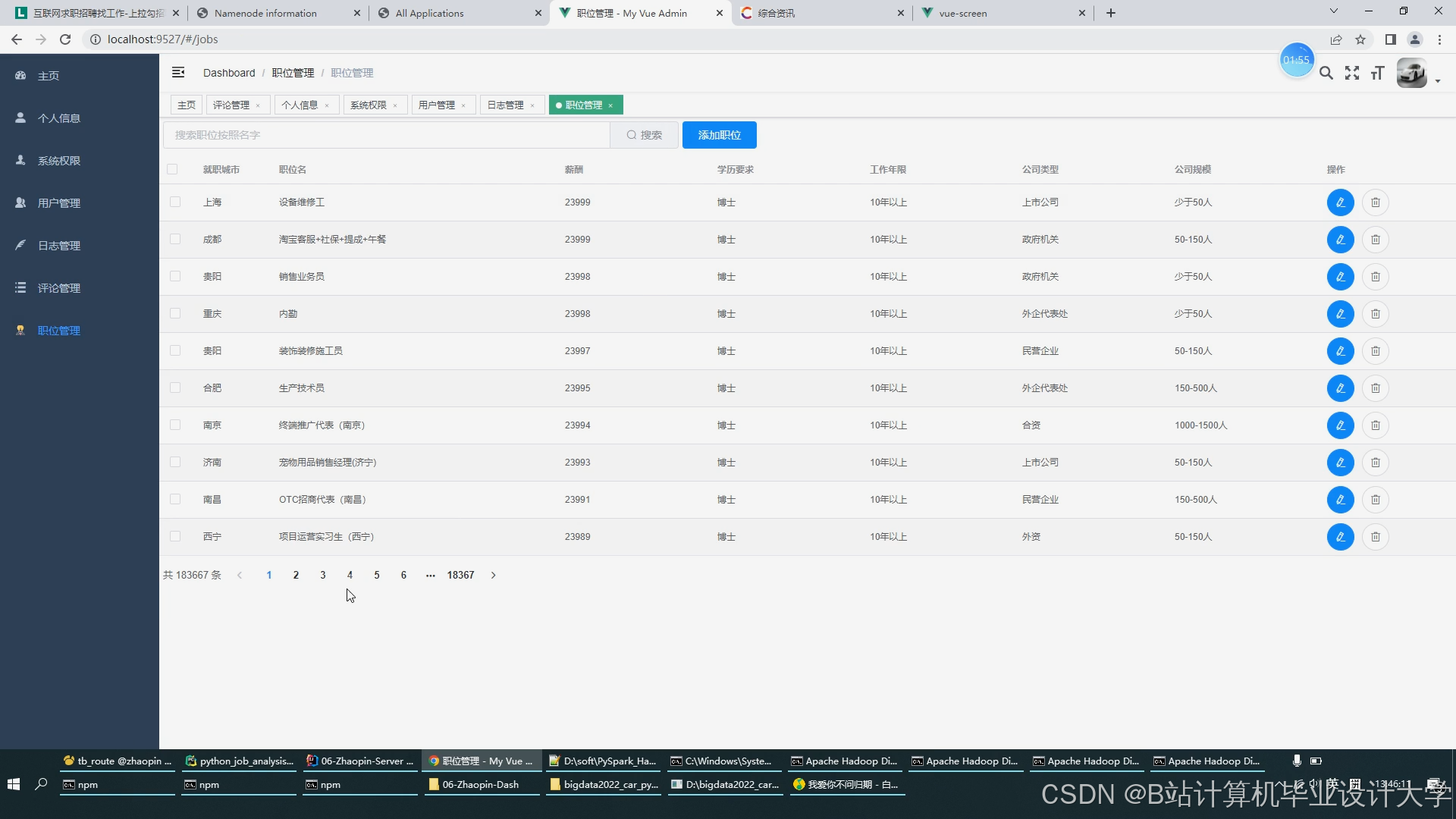

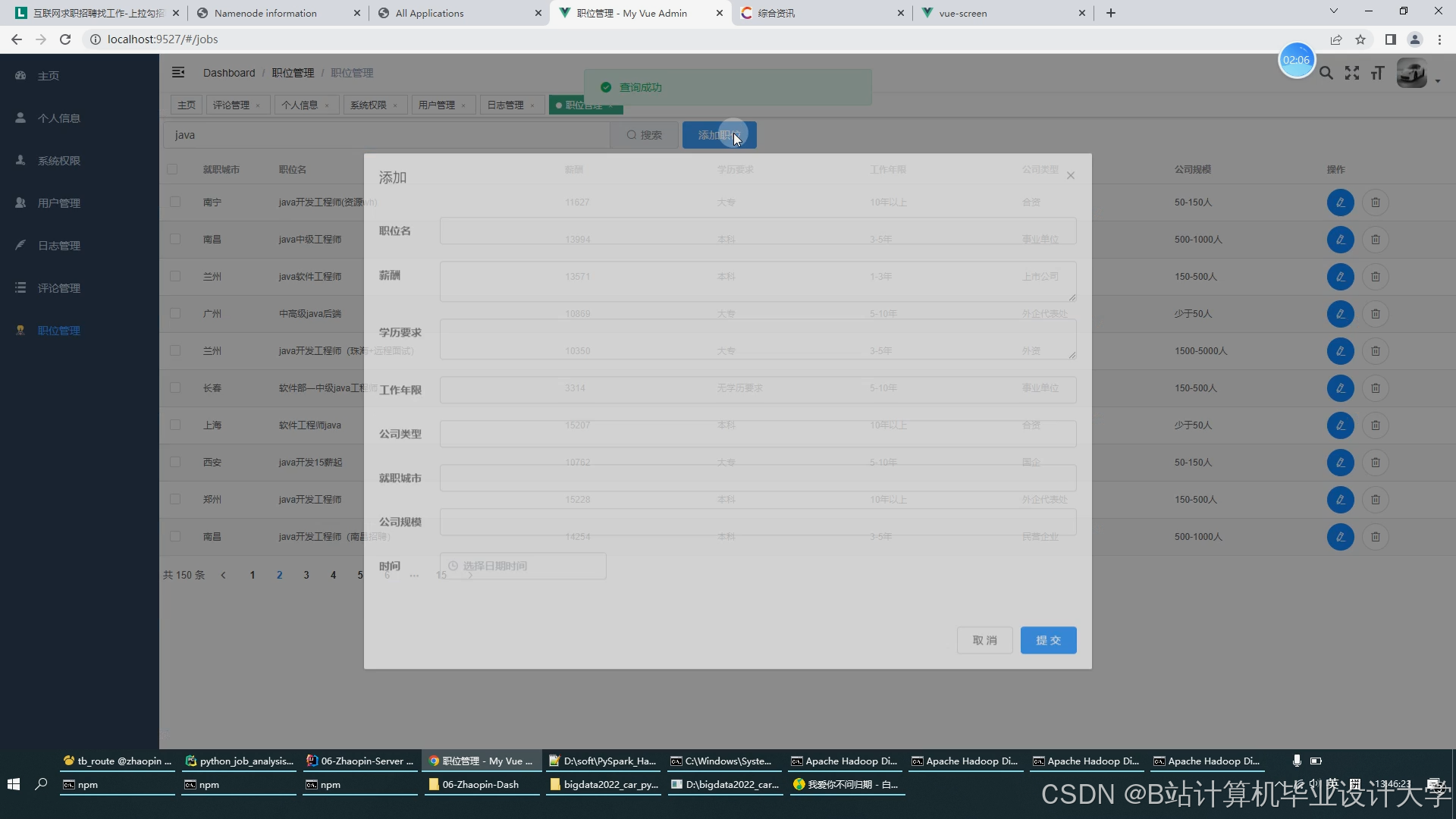

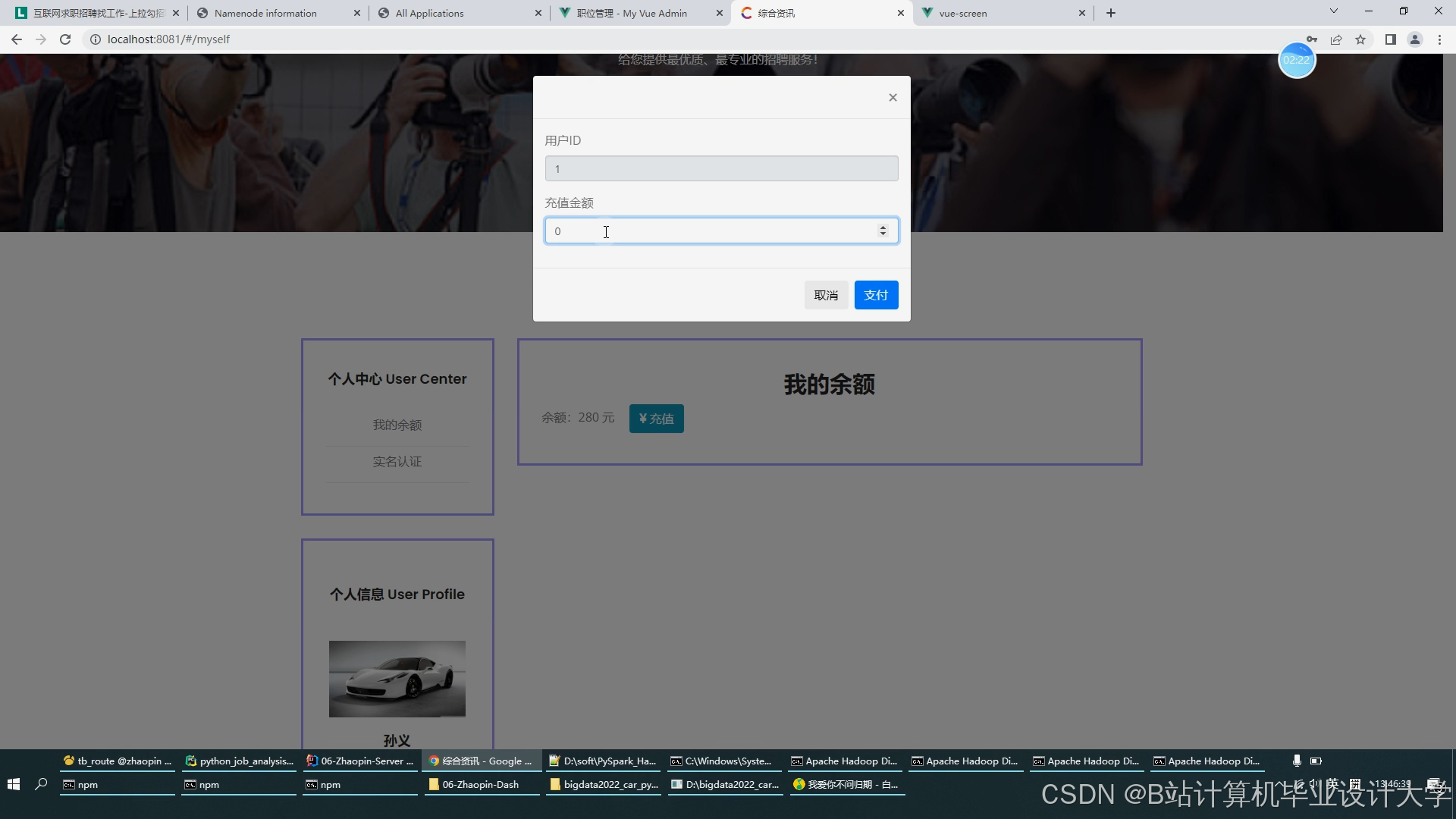

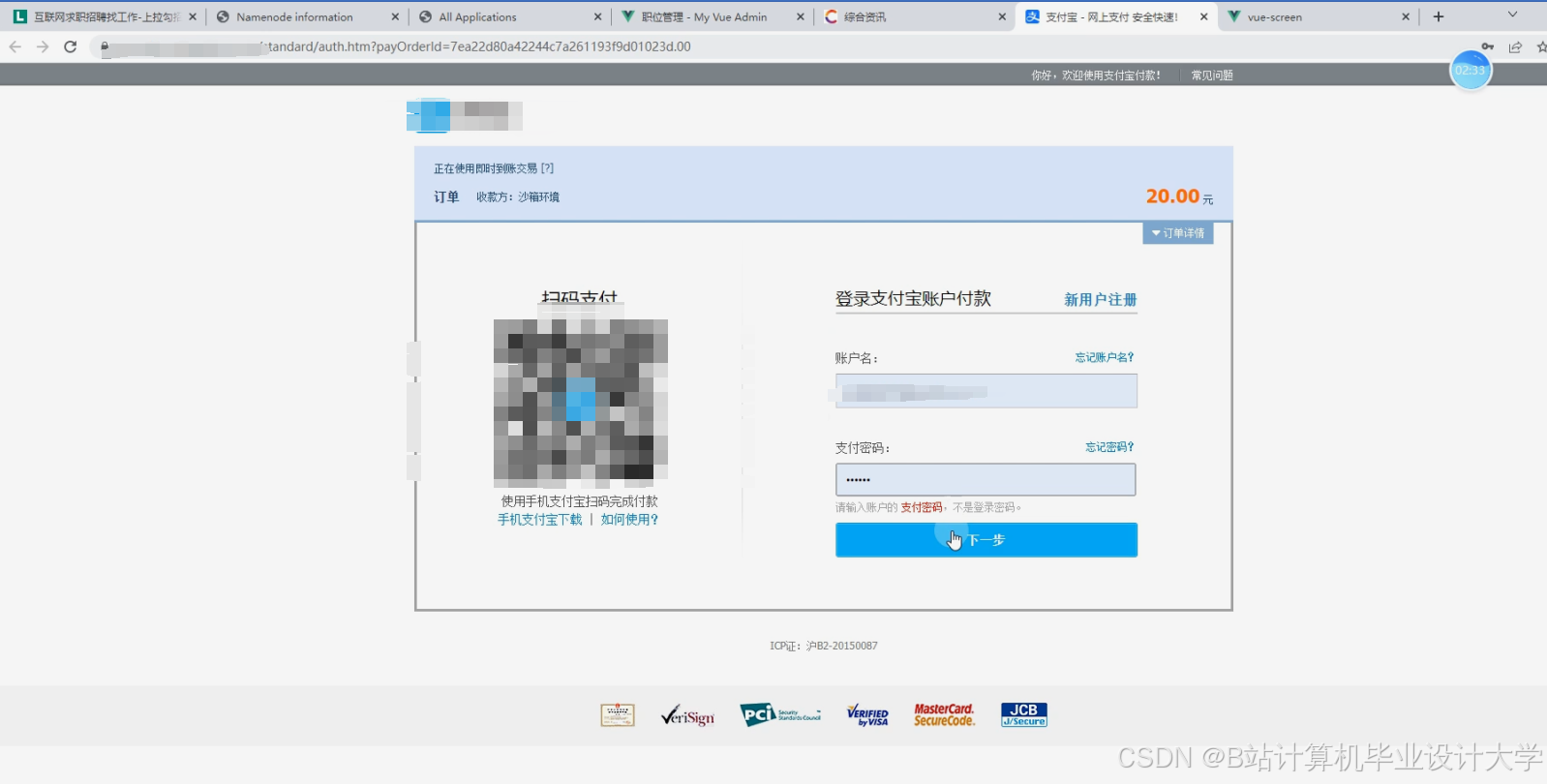

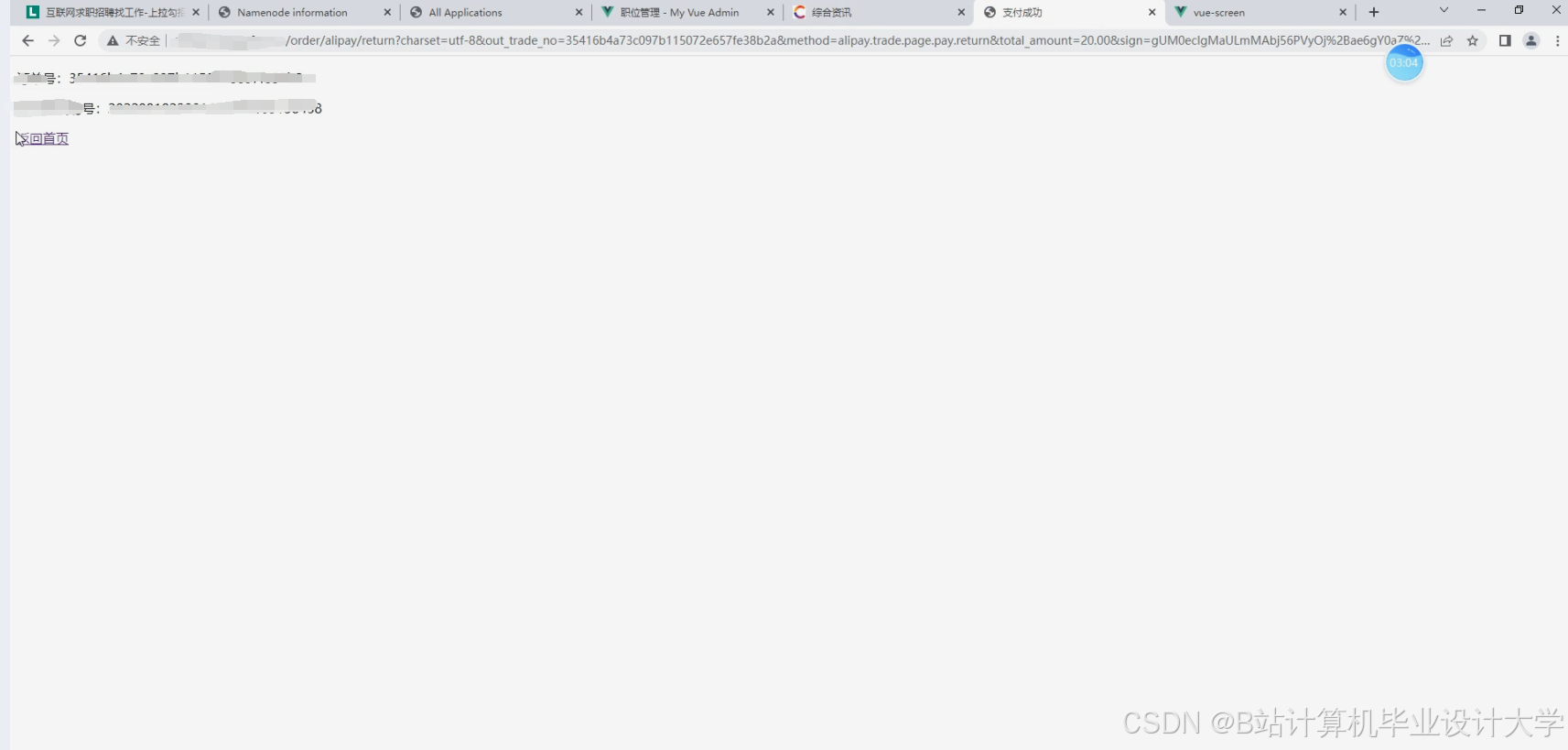

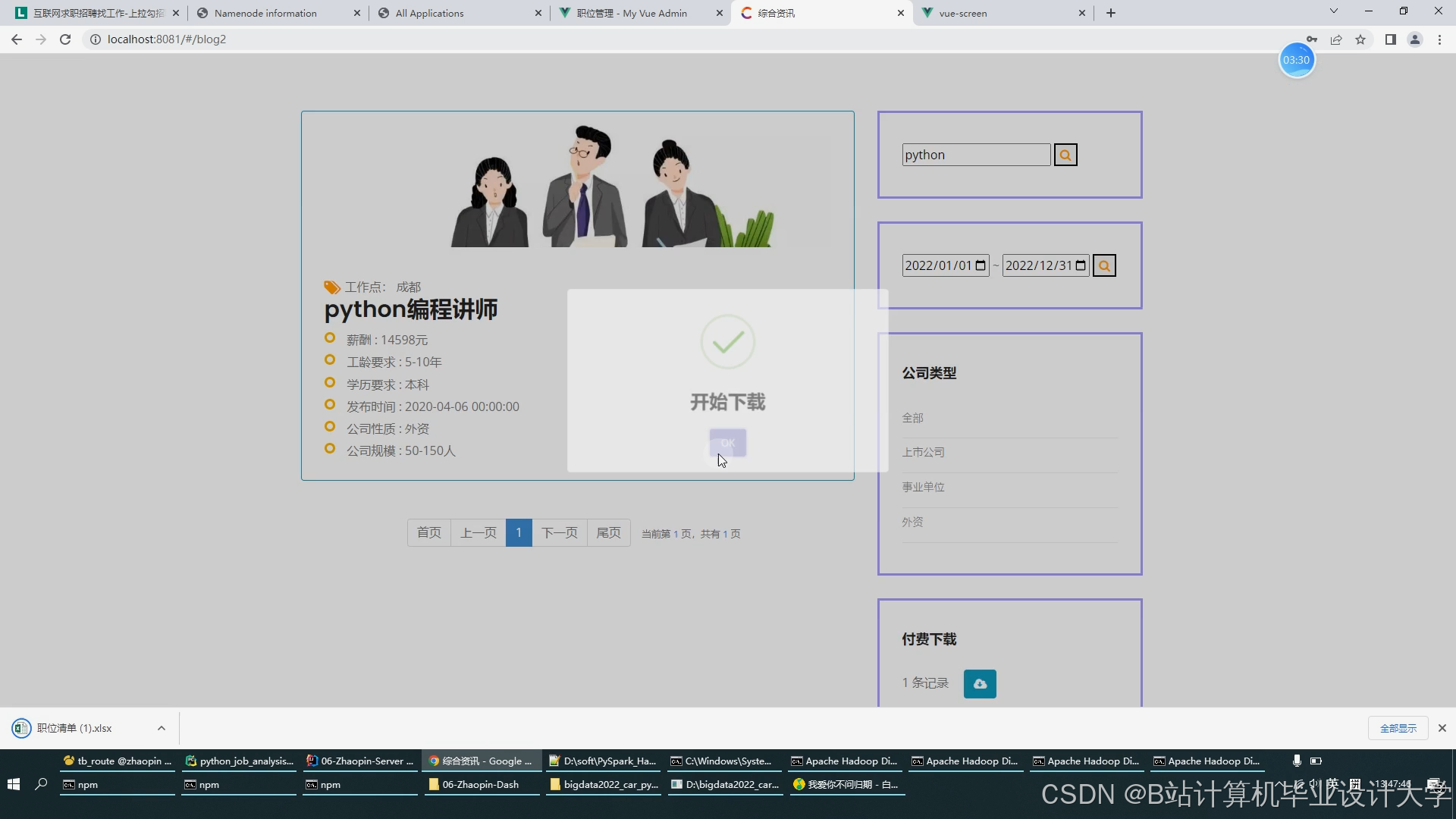

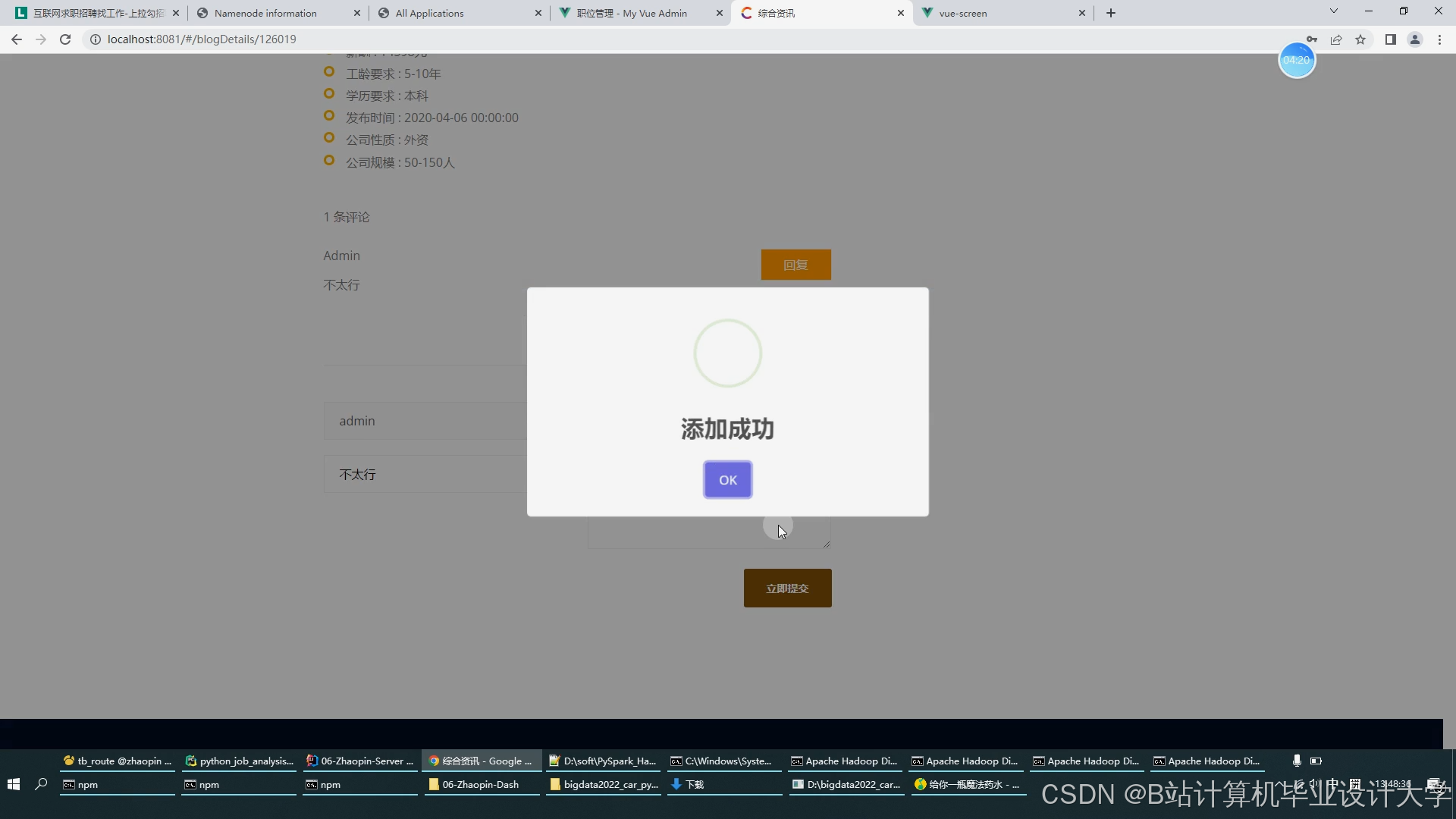

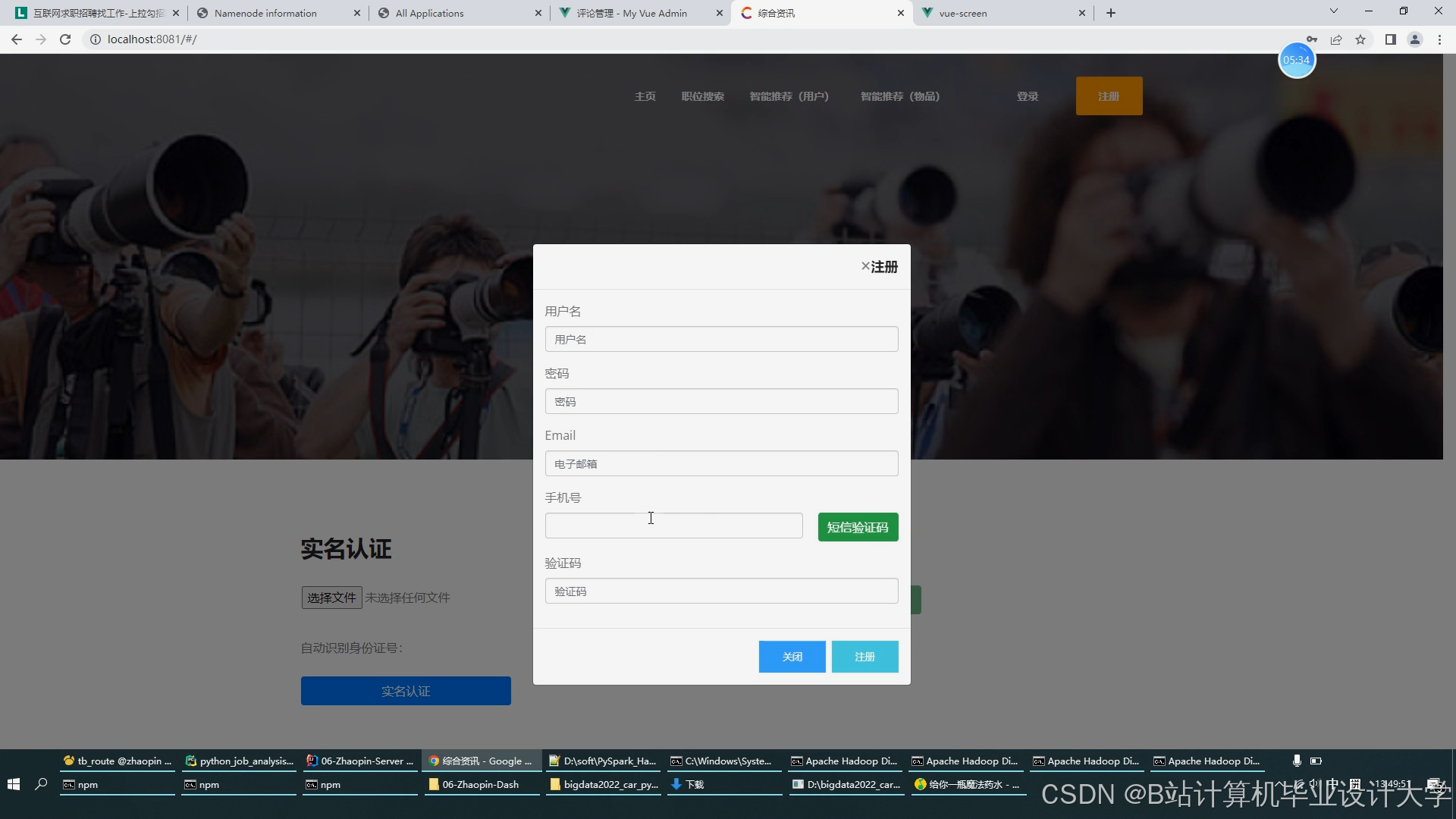

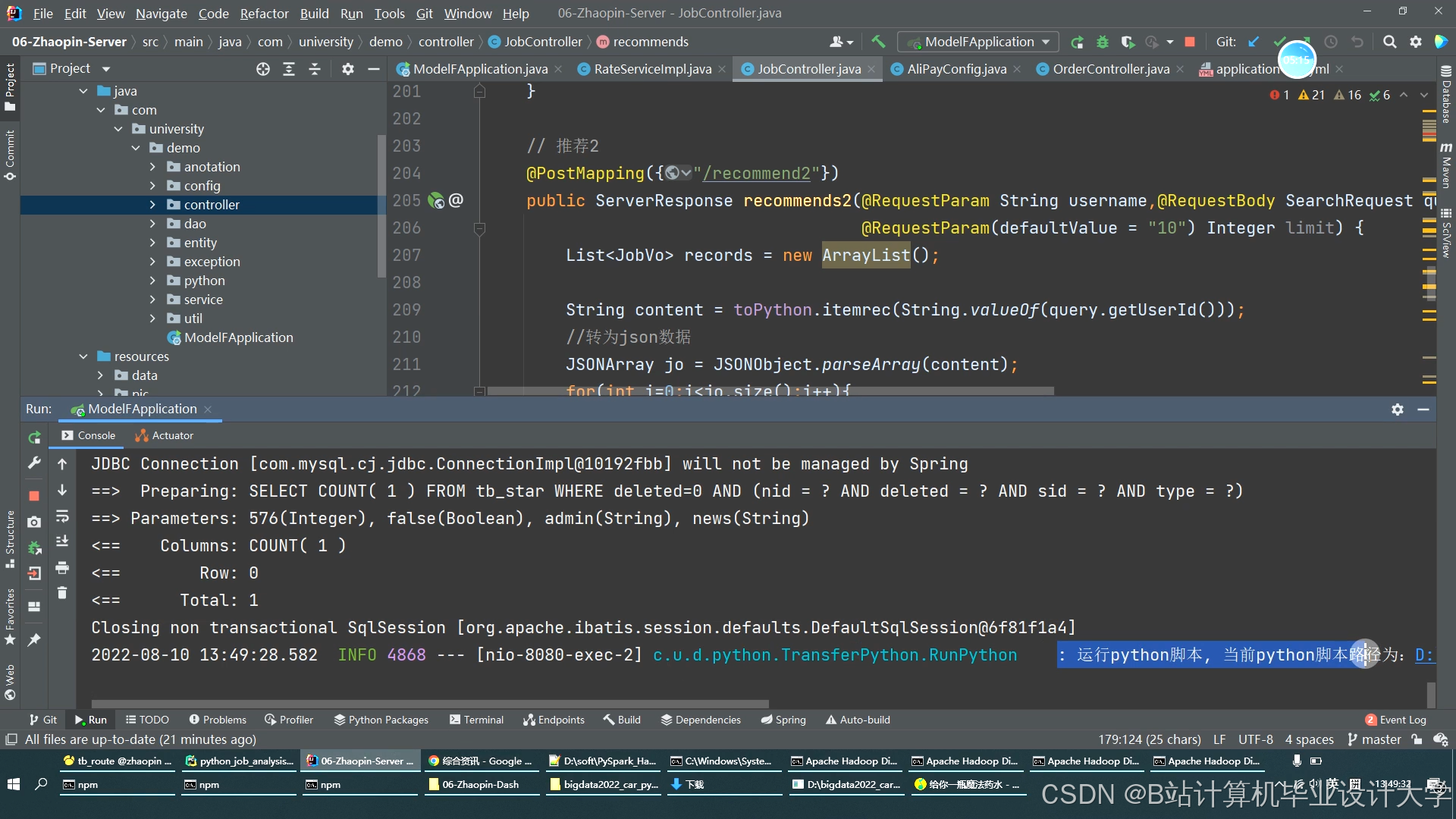

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

986

986

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?