目录

本篇文章记录用户访问session分析-算子调优之reduceByKey本地聚合介绍。

reduceByKey

val lines = sc.textFile("hdfs://") val words = lines.flatMap(_.split(" ")) val pairs = words.map((_, 1)) val counts = pairs.reduceByKey(_ + _) counts.collect()

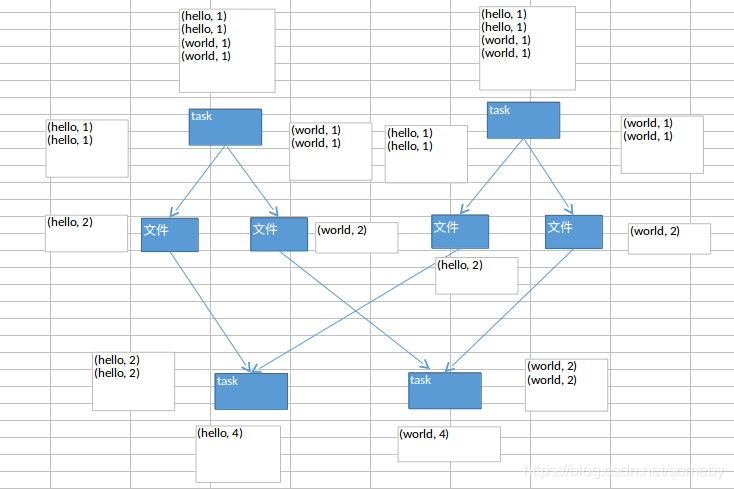

reduceByKey,相较于普通的shuffle操作(比如groupByKey),它的一个特点,就是说,会进行map端的本地聚合。

对map端给下个stage每个task创建的输出文件中,写数据之前,就会进行本地的combiner操作,也就是说对每一个key,对应的values,都会执行你的算子函数(_ + _)

用reduceByKey对性能的提升

1、在本地进行聚合以后,在map端的数据量就变少了,减少磁盘IO。而且可以减少磁盘空间的占用。

2、下一个stage,拉取数据的量,也就变少了。减少网络的数据传输的性能消耗。

3、在reduce端进行数据缓存的内存占用变少了。

4、reduce端,要进行聚合的数据量也变少了。

本文介绍使用ReduceByKey算子在Spark中的作用及其带来的性能提升。通过在Map端进行本地聚合,不仅减少了磁盘I/O操作和内存占用,还降低了网络传输负载及Reduce端的数据处理量。

本文介绍使用ReduceByKey算子在Spark中的作用及其带来的性能提升。通过在Map端进行本地聚合,不仅减少了磁盘I/O操作和内存占用,还降低了网络传输负载及Reduce端的数据处理量。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?