1.1检查是否已经安装MySQL

检查:rpm -qa | grep mysql 删除:sudo rpm -e --nodeps

mysql-libs-5.1.66-2.el6_3.x86_64

1.2安装的版本

一般情况下,企业使用MySQL的版本:5.7,和Java项目中使用MySQL是一致的

5.1和5.7区别: 服务的名称:<5.5:mysqld >=5.5:mysql

1.3通过Yum安装

sudo yum install -y mysql-server

1.4启动MySQL服务

sudo service mysqld start

1.5设置开机启动

sudo chkconfig mysqld on

1.6设置管理员密码

/usr/bin/mysqladmin -u root password ‘123456’

1.7登录MySQL

mysql -uroot -p123456

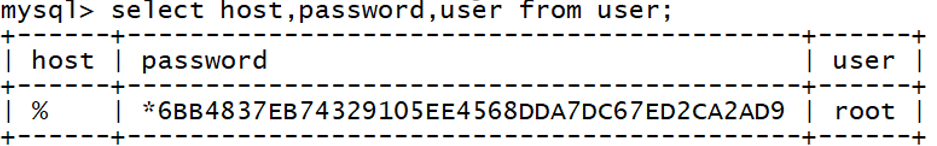

1.8修改权限

授权:

grant all privileges on . to ‘root’@’%’ identified by ‘123456’ with grant option

删除其他授权

刷新权限

flush privileges

1.9重启MySQL服务,建立远程连接

sudo service mysqld restart

2、准备工作

2.1确保Hadoop相关进程启动

NameNode、DataNode

ResourceManager、NodeManager

JobHistoryServer

2.2 MySql服务器启动

确保开启、开机启动

windows 上Navicat等工具可以连上

3、Hive功能介绍

hive是Apache的顶级项目,

http://hive.apache.org/

3.1 hive是干什么

将SQL语句转换成MapReduce程序,并且提交到Yarn上运行,读取HDFS上的数据进行处理。

SQL语句:和MySQL数据库中SQL语句非常非常类似。

3.2概念:SQL on Hadoop

建立在Hadoop之上提供SQL方式分析的框架

- 最早的框架就是 Hive

facebook开源

- impala

- presto

- sparkSQL/shark

-kylin

3.3要学好hive,需要什么

Hadoop基础:HDFS、MapReduce、Yarn

MySQL数据库

DML(数据操作语言)、DDL(数据定义语言)

hive软件版本的问题

其实使用的3大版本:

0.13.1:经典稳定的版本(2104)

1.2.1 :较新的一个版本

2.X:2017发布,

底层推荐使用Spark或者TeZ框架分析数据,而不是MapReduce

下载地址:http://apache.org/dist/hive

6、安装Hive

上传、解压、重命名

mv apache-hive-1.2.1-bin/ hive-1.2.1-bin/

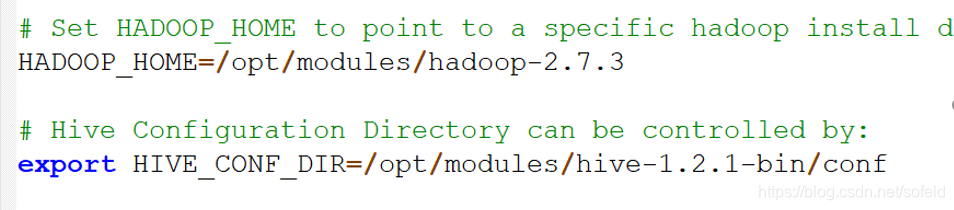

6.3修改配置

mv hive-env.sh.template hive-env.sh

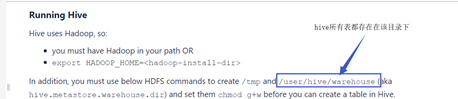

创建数据仓库

hive 的数据需要保存到HDFS,那么保存HDFS那个目录,是不是需要配置 不配置,因为它会去读默认路径,但是这些目录是空,我需要去创建

bin/hdfs dfs -mkdir -p /user/hive/warehouse

bin/hdfs dfs -mkdir -p /tmp

bin/hdfs dfs -chmod g+w /user/hive/warehouse

bin/hdfs dfs -chmod g+w /tmp

本文档详细介绍了Hive的安装步骤,包括检查MySQL、Yum安装、启动与配置MySQL服务,以及Hive的准备工作和功能介绍。重点强调了在Hadoop环境下,如何将SQL语句转换为MapReduce任务,同时提供了不同版本Hive的特点和安装注意事项。

本文档详细介绍了Hive的安装步骤,包括检查MySQL、Yum安装、启动与配置MySQL服务,以及Hive的准备工作和功能介绍。重点强调了在Hadoop环境下,如何将SQL语句转换为MapReduce任务,同时提供了不同版本Hive的特点和安装注意事项。

923

923

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?