导读

当一个人形机器人学会走路,它面临的第一个考验不是速度,而是“稳定”。

看似简单的迈步、转身、起跳,在机器世界里却暗藏着成千上万的物理陷阱——脚会“滑”、膝盖会“穿模”、身体甚至会漂浮在空气中。

过去,研究者尝试让机器人“模仿人类”来学习动作,但这件事并不容易。传统的动作捕捉(MoCap)数据昂贵又稀缺,而互联网视频虽多,却往往缺乏物理约束,生成的动作虚假又不稳定。

于是,来自 KAIST 的研究团队提出了一个新思路——他们构建了一个真正“脚踏实地”的动作模仿数据集,让机器人在学习人类运动时,也能遵守真实世界的物理法则。

这,就是 PHUMA:Physically-Grounded HUMAnoid Locomotion Dataset

▲图1|PHUMA视频速览

PHUMA 的诞生,像是一场“从虚拟到真实”的净化过程。

研究团队发现,直接用网络视频生成的人体动作数据(如 Humanoid-X)虽然规模庞大,但常常存在漂浮、穿透地面、脚打滑等物理失真问题——对机器人来说,这些动作根本无法执行。

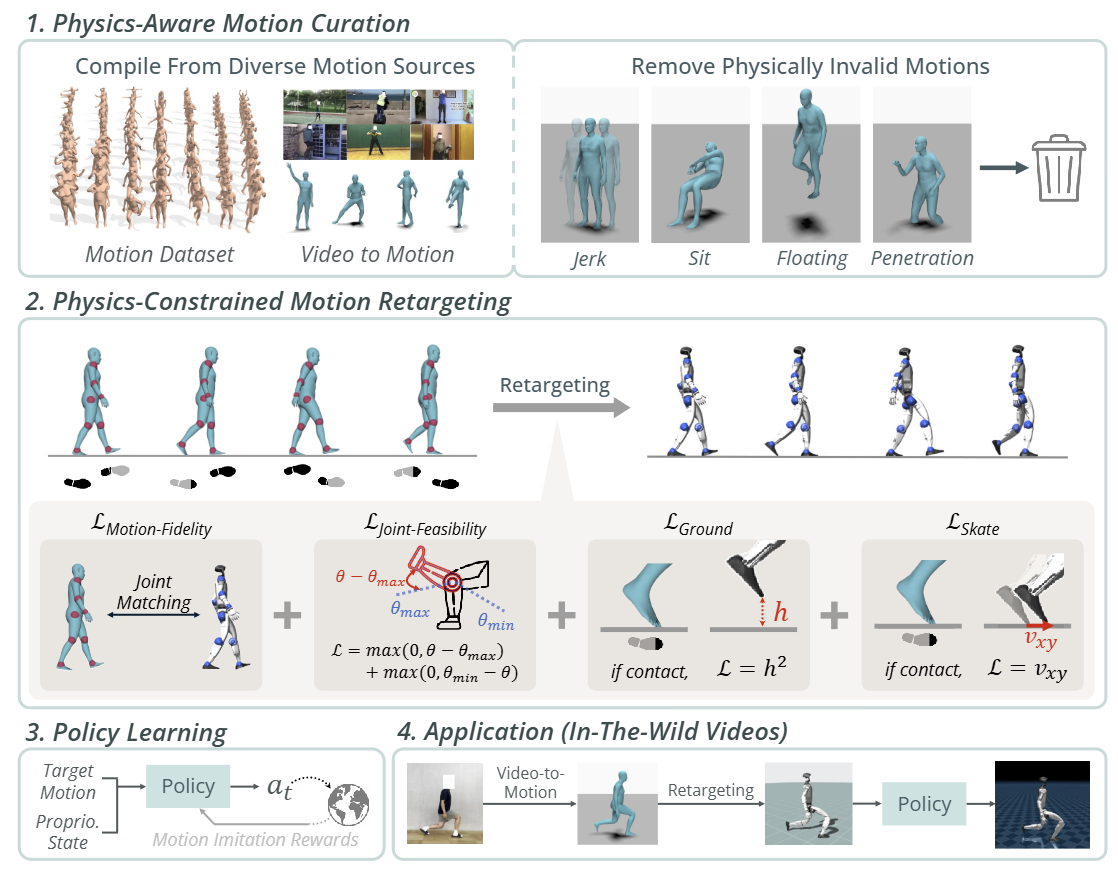

于是,他们设计了一条四阶段物理化流程:

1. Motion Curation(动作筛选)

对来自 Humanoid-X、AMASS 等源的数据进行物理可行性筛选,自动剔除约 70% 不合理的片段(例如坐在虚空中的动作)。

2. PhySINK(物理约束重定向)

这是整个系统的关键,团队在传统 SINK(形状自适应逆运动学)基础上加入三项物理损失:

● 关节可行性(防止超伸)

● 接地约束(防止漂浮/穿透)

● 防滑约束(消除脚滑)

让每一个动作都能符合机器人动力学边界。

3. Policy Learning(策略学习)

采用 MaskedMimic 框架进行强化学习,让机器人学会从这些物理可靠的动作中进行模仿与泛化。

4. Application(视频推理)

最后,他们将自录视频转为 SMPL 动作,再用 PhySINK 重定向,实现“看一段人类视频 → 机器人自然模仿”。

简而言之,PHUMA 的核心故事是:让海量视频数据真正“落地”。

▲图2|PHUMA 数据集的完整数据处理流程

物理约束重定向:让动作更“真实可走”

传统视频转动作模型忽略了重力、接地等因素,而 PhySINK 在优化目标中加入物理损失项:

● 关节可行性提升至 100%,

● 漂浮与穿透比例降至 <4%,

● 脚滑现象减少近 40%。

这意味着机器人模仿动作时,不再“凌空乱舞”,而是能稳稳落地

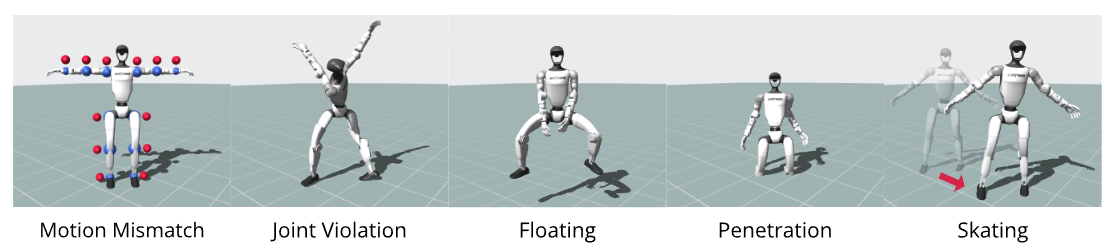

▲图3|动作重定向中的常见物理伪影:从左至右依次为:动作不匹配、关节越界、漂浮、穿透以及脚滑。这些现象说明传统重定向方法缺乏物理约束

通过物理约束之后,机器人的动作将变得更加符合物理规律,不会做出奇怪的反关节超人类运动↓

▲图4|PHUMA中符合物理约束的机器人动作示例(动作看着变扭,但实际上每个人都能把这个“变扭”的动作给做出来)

规模 × 质量并存的全新数据集

PHUMA 共收录 7.88M 帧、73 小时、7.6 万段 物理可靠的人体动作,

结合了 MoCap 与大规模视频来源,弥补了 AMASS(小而干净)与 Humanoid-X(大而混乱)之间的缺口,实现了多样性与物理可靠性的平衡。

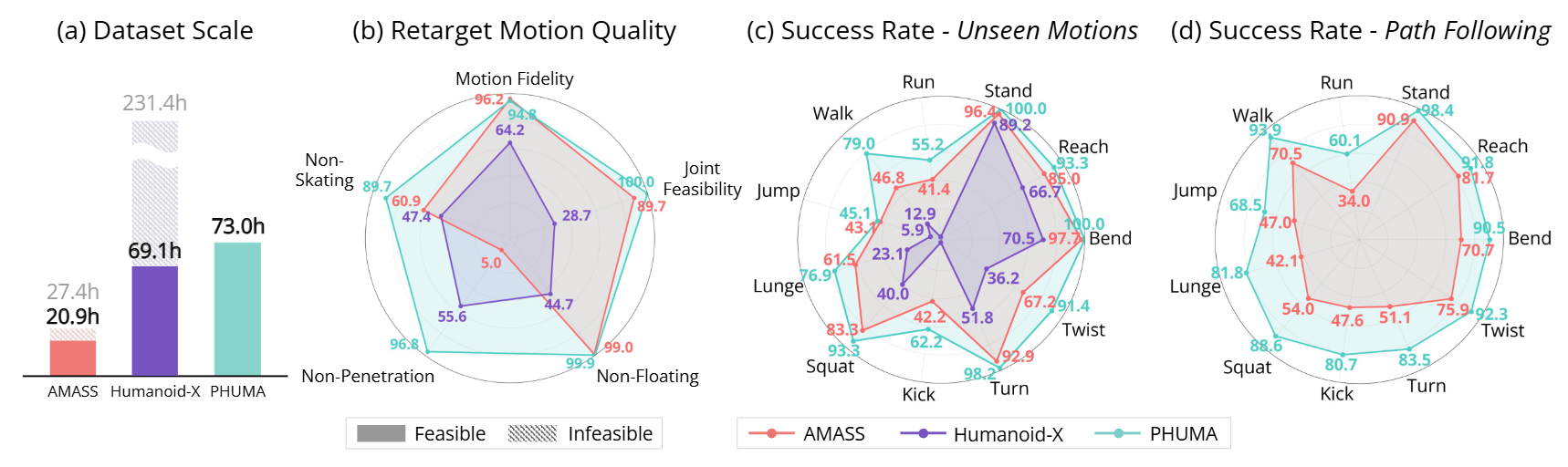

▲图5|数据集规模与性能概览:PHUMA 同时具备大规模与高物理可靠性,这种特性在模仿学习与路径跟随任务中转化为更高的成功率。(a) 各数据集中物理可行与不可行的动作比例;(b) 动作的物理可靠性,其中 AMASS 使用标准学习型逆运动学方法重定向;(c) 未见动作的模仿成功率;(d) 骨盆路径跟随任务的成功率

具身智能的直接收益:更会“学人类”

在 Unitree G1、H1-2 两款人形机器人上的测试显示:

● 模仿未知动作成功率提升 2.1 倍;

● 路径跟随任务(仅凭骨盆引导)成功率提升 1.4–2.1 倍;

● 尤其在“跳跃”“跑步”等高动态任务中表现最突出。

这说明——有了更“真实”的数据,机器人才能学会更“人类”的行为

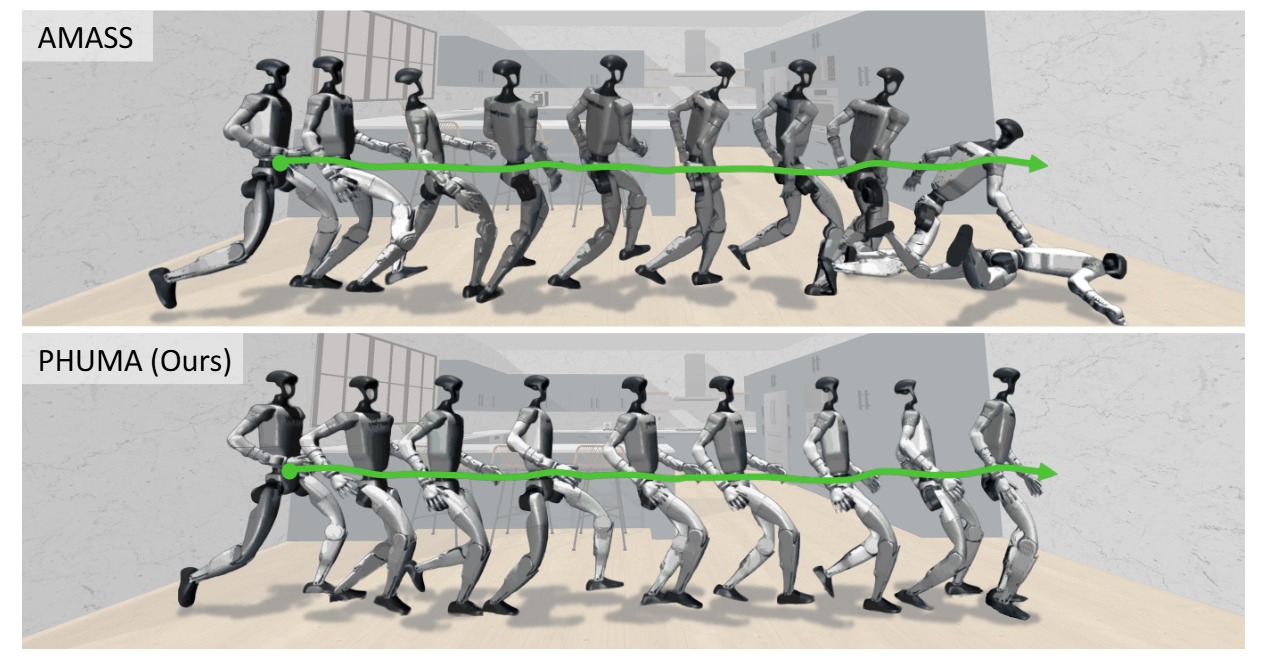

▲图6|跑步动作的路径跟随结果:展示了机器人在跑步任务中的运动轨迹。绿色曲线为目标骨盆路径。上排为 AMASS 训练的策略,常出现偏移或失衡;下排为 PHUMA 训练的策略,能更稳定地沿目标路径完成动作

研究团队在 IsaacGym 模拟器中对两类任务进行了验证:

● 动作模仿(Full-State Imitation):让机器人复现完整人体动作;

● 路径跟随(Pelvis Path Following):仅用骨盆轨迹引导机器人完成动态移动。

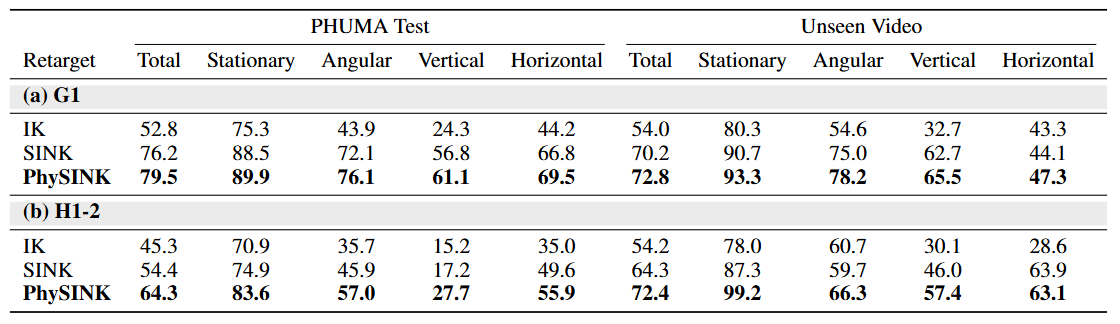

▲图7|不同重定向方法的模仿性能对比:对 AMASS 数据集分别采用 IK、SINK 与 PhySINK 三种重定向方式训练模仿策略,并在两类机器人(G1 与 H1-2)上评估。结果表明,PhySINK 在所有动作类型及测试集(PHUMA Test 与 Unseen Video)中均取得最高成功率

实验结果非常直观:

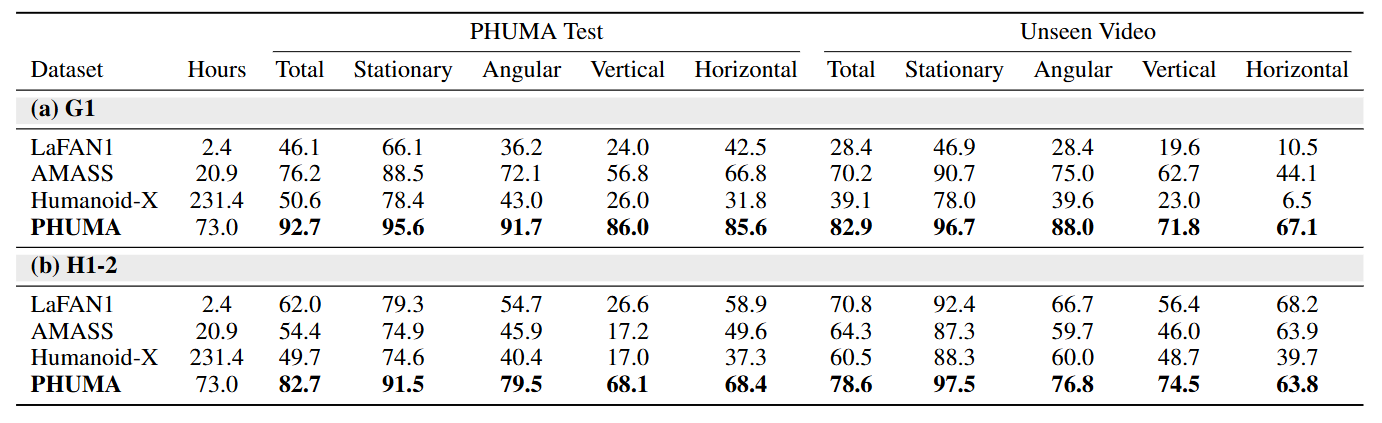

在 G1 上,PHUMA 训练的策略在所有动作类别(站立、转身、下蹲、奔跑)中平均成功率 92.7%,远高于 AMASS 的 76.2%;

● 在未见过的视频动作测试中,PHUMA 的泛化率仍保持 82.9%;

● 对比实验结果显示,PHUMA 让机器人的足迹几乎与目标路径重合,而 AMASS 模型常常“偏航”或摔倒。

▲图8|作者基于 LaFAN1、AMASS、Humanoid-X 与 PHUMA 四个数据集分别训练模仿策略,并在 G1 与 H1-2 上测试。结果显示,PHUMA 在所有动作类型和测试条件下均显著优于其他数据集,证明其兼具数据规模与物理可靠性

更重要的是,这些改进不是靠网络规模堆出来的,而是源于“物理一致性”的提升。

PHUMA 的价值不只是一份数据集,它更像是具身智能的“校准仪”——

它提醒我们,真正的智能不是让机器人模仿动作,而是让它理解并遵循世界的物理逻辑。

未来,团队计划将 PHUMA 推向真实场景,探索从仿真到现实(Sim-to-Real)的迁移,并结合视觉输入,让机器人“看视频就能学”。

当机器人不仅“看到人类怎么做”,还能“知道为什么这么做”——那也许,才是它真正开始“理解世界”的那一刻。

标题:PHUMA: Physically-Grounded Humanoid Locomotion Dataset

作者:Kyungmin Lee, Sibeen Kim, Minho Park, Hyunseung Kim, Dongyoon Hwang, Hojoon Lee, Jaegul Choo

链接:https://davian-robotics.github.io/PHUMA

1525

1525

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?