大数据学习三之 伪分布式集群安装部署

ip:168.192.59.200

hostname:bigdata-lmt02.hpsk.com

我的环境搭建是基于前两篇博客的基础之上的:

大数据学习一Linux基础配置

大数据学习二HADOOP框架安装部署

在搭建HADOOP环境之前先准备好hadoop-2.7.3.tar.gz安装包

Apache Software Foundation Distribution Directory

http://archive.apache.org/dist/

hadoop-2.7.3

http://archive.apache.org/dist/hadoop/common/hadoop-2.7.3/

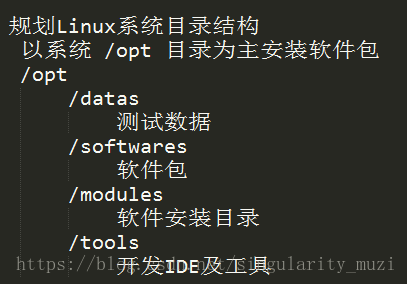

在上一篇博客中我们规划了目录结构

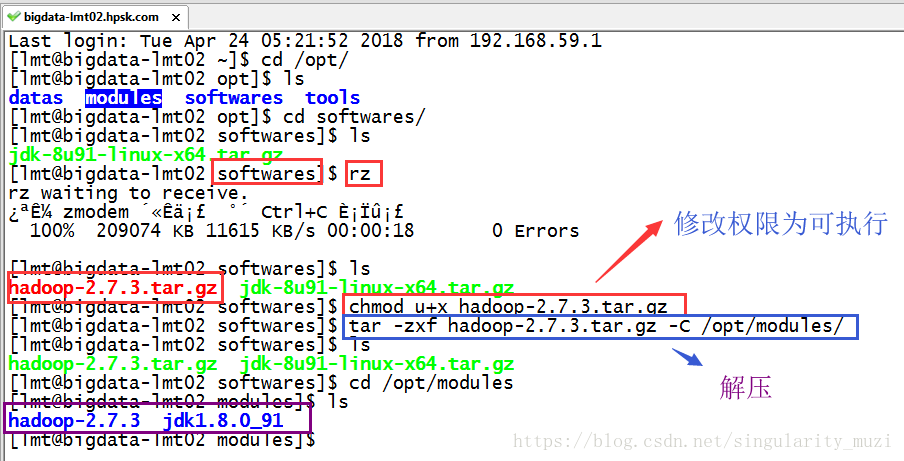

在这里我们将准备好的hadoop-2.7.3.tar.gz安装包上传到/opt/softwares/目录下:

上传后解压(使用rz上传文件的前提是安装了Linux系统自带上传下载软件$ sudo yum install -y lrzsz)

$ rz

$ chmod u+x hadoop-2.7.3.tar.gz

$ tar -zxf hadoop-2.7.3.tar.gz -C /opt/modules/

配置HADOOP

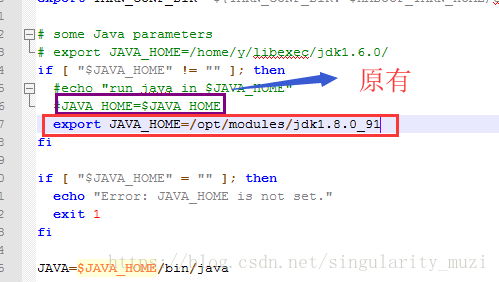

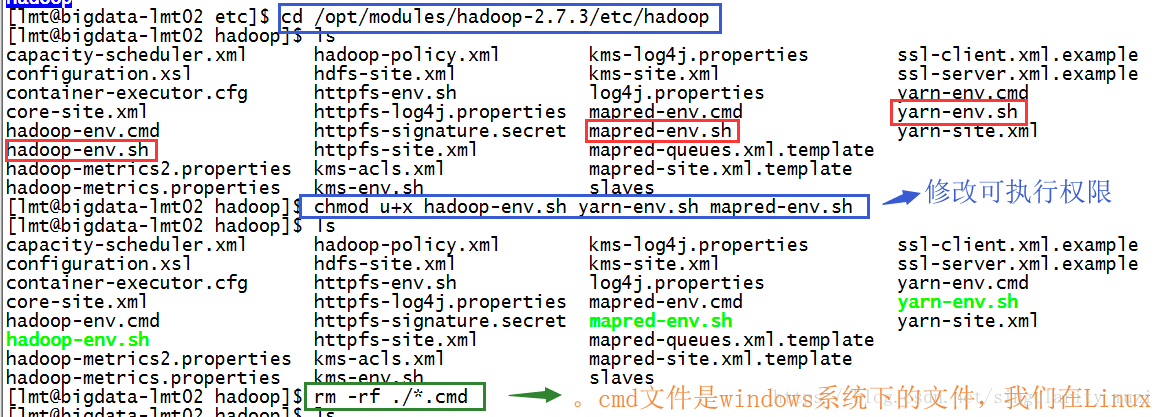

配置 *-env.sh 环境变量文件

hadoop-env.sh ; yarn-env.sh ; mapred-env.sh

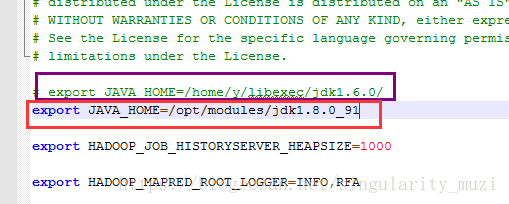

设置值:export JAVA_HOME=/opt/modules/jdk1.8.0_91

hadoop-env.sh

yarn-env.sh

mapred-env.sh

赋以执行权限: $ chmod u+x hadoop-env.sh yarn-env.sh mapred-env.sh

依据HADOOP三个模块来进行配置

- HDFS

存储数据

- YARN

管理资源

- MapReduce

分析数据

配置HDFS环境

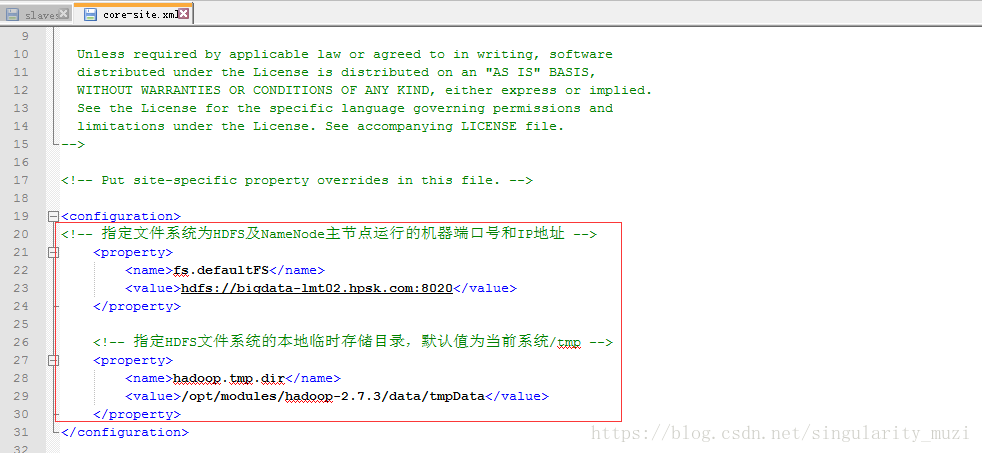

core-site.xml

<!-- 指定文件系统为HDFS及NameNode主节点运行的机器端口号和IP地址 -->

<property>

<name>fs.defaultFS</name>

<value>hdfs://bigdata-lmt02.hpsk.com:8020</value>

</property>

<!-- 指定HDFS文件系统的本地临时存储目录,默认值为当前系统/tmp -->

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/modules/hadoop-2.7.3/data/tmpData</value>

</property>

创建对应文件夹:

$ cd /opt/modules/hadoop-2.7.3

$ mkdir -p data/tmpData修改配置文件hdfs-site.xml

<!-- 由于伪分布式安装部署, 仅有一台机器,所有block副本数没有必要设置为3,设置为1即可 -->

<property>

<name>dfs.replication</name>

<value>1</value>

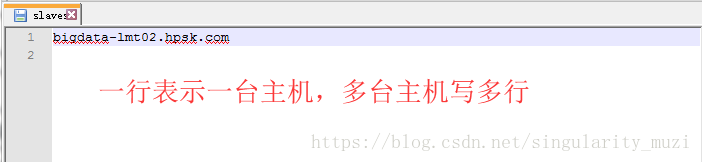

</property>配置slaves文件:指定DataNode运行在哪些机器上,此文件中一行表示一个主机名称,会在此主机上运行DataNode

启动HDFS服务

对于文件系统来说,第一次使用,要进行格式文件系统(注意:系统格式化只能进行一次,在之后的使用中就不能再次格式化了,否则会出现问题)

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1025

1025

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?