(tf2) D:\python\yolov109.25>pip list

WARNING: Ignoring invalid distribution -orch (e:\python\anaconda\envs\tf2\lib\site-packages)

Package Version

---------------------------- --------------------

absl-py 2.3.1

addict 2.4.0

aiofiles 23.2.1

altair 5.5.0

annotated-types 0.7.0

anyio 4.11.0

asttokens 3.0.0

astunparse 1.6.3

attrs 25.4.0

cachetools 5.5.2

certifi 2025.8.3

charset-normalizer 3.4.3

click 8.1.8

colorama 0.4.6

coloredlogs 15.0.1

contourpy 1.3.0

cycler 0.12.1

decorator 5.2.1

efficientnet_pytorch 0.7.1

einops 0.8.1

exceptiongroup 1.3.0

executing 2.2.1

fastapi 0.119.1

ffmpy 0.6.4

filelock 3.19.1

flatbuffers 25.2.10

fonttools 4.60.1

fsspec 2025.9.0

gast 0.4.0

google-auth 2.40.3

google-auth-oauthlib 0.4.6

google-pasta 0.2.0

gradio 4.31.5

gradio_client 0.16.4

grpcio 1.74.0

h11 0.16.0

h5py 3.14.0

httpcore 1.0.9

httpx 0.28.1

huggingface-hub 0.23.2

humanfriendly 10.0

idna 3.10

importlib_metadata 8.7.0

importlib_resources 6.5.2

intel-openmp 2021.4.0

ipython 8.18.1

jedi 0.19.2

Jinja2 3.1.6

jsonschema 4.25.1

jsonschema-specifications 2025.9.1

keras 2.10.0

Keras-Preprocessing 1.1.2

kiwisolver 1.4.7

libclang 18.1.1

Markdown 3.9

markdown-it-py 3.0.0

MarkupSafe 2.1.5

matplotlib 3.9.4

matplotlib-inline 0.2.1

mdurl 0.1.2

mkl 2021.4.0

mmcv 1.4.0

mmengine 0.10.7

mpmath 1.3.0

narwhals 2.9.0

networkx 3.2.1

numpy 1.24.3

oauthlib 3.3.1

onnx 1.14.0

onnxruntime 1.15.1

onnxruntime-gpu 1.18.0

onnxsim 0.4.36

opencv-python 4.7.0.72

opt_einsum 3.4.0

orjson 3.11.3

packaging 25.0

pandas 2.3.3

parso 0.8.5

pillow 10.4.0

pip 25.2

platformdirs 4.4.0

polars 1.34.0

polars-runtime-32 1.34.0

prompt_toolkit 3.0.52

protobuf 6.33.0

psutil 5.9.8

pure_eval 0.2.3

py-cpuinfo 9.0.0

pyasn1 0.6.1

pyasn1_modules 0.4.2

pycocotools 2.0.7

pydantic 2.12.3

pydantic_core 2.41.4

pydub 0.25.1

Pygments 2.19.2

pyparsing 3.2.5

pyreadline3 3.5.4

python-dateutil 2.9.0.post0

python-multipart 0.0.20

pytorch-wavelets 1.3.0

pytz 2025.2

PyWavelets 1.6.0

pywrap 0.1.0

PyYAML 6.0.1

referencing 0.36.2

regex 2025.10.23

requests 2.32.5

requests-oauthlib 2.0.0

rich 14.2.0

rpds-py 0.27.1

rsa 4.9.1

ruff 0.14.1

safetensors 0.4.3

scipy 1.13.0

seaborn 0.13.2

semantic-version 2.10.0

setuptools 78.1.1

shellingham 1.5.4

six 1.17.0

sniffio 1.3.1

stack-data 0.6.3

starlette 0.48.0

sympy 1.14.0

tbb 2021.11.0

tensorboard 2.10.1

tensorboard-data-server 0.6.1

tensorboard-plugin-wit 1.8.1

tensorflow-estimator 2.10.0

tensorflow-gpu 2.10.0

tensorflow-io-gcs-filesystem 0.31.0

termcolor 3.1.0

thop 0.1.1.post2209072238

timm 0.6.13

tomli 2.3.0

tomlkit 0.12.0

torch 2.4.0+cu118

torchaudio 2.4.0+cu118

torchvision 0.19.0+cu118

tqdm 4.67.1

traitlets 5.14.3

typer 0.20.0

typing_extensions 4.15.0

typing-inspection 0.4.2

tzdata 2025.2

ultralytics 8.3.2

ultralytics-thop 2.0.17

urllib3 2.5.0

uvicorn 0.38.0

wcwidth 0.2.14

websockets 11.0.3

Werkzeug 3.1.3

wheel 0.45.1

wrapt 1.17.3

xgboost 2.1.4

yapf 0.43.0

zipp 3.23.0

这些适配环境中有没有会导致E:\Python\anaconda\envs\tf2\python.exe D:\python\yolov109.25\train.py

E:\Python\anaconda\envs\tf2\lib\site-packages\mmengine\optim\optimizer\zero_optimizer.py:11: DeprecationWarning: `TorchScript` support for functional optimizers is deprecated and will be removed in a future PyTorch release. Consider using the `torch.compile` optimizer instead.

from torch.distributed.optim import \

Ultralytics YOLOv8.1.34 🚀 Python-3.9.23 torch-2.4.0+cu118 CUDA:0 (NVIDIA GeForce RTX 4050 Laptop GPU, 6140MiB)

engine\trainer: task=detect, mode=train, model=ultralytics/cfg/models/v10/yolov10l.yaml, data=datasets_extend/differ.yaml, epochs=1, time=None, patience=100000, batch=16, imgsz=320, save=True, save_period=-1, val_period=1, cache=False, device=None, workers=8, project=None, name=train26, exist_ok=False, pretrained=True, optimizer=auto, verbose=True, seed=0, deterministic=True, single_cls=False, nwdloss=True, iou_ratio=0.6, rect=False, cos_lr=False, close_mosaic=10, resume=False, amp=True, fraction=1.0, profile=False, freeze=None, multi_scale=False, overlap_mask=True, mask_ratio=4, dropout=0.0, val=True, split=val, save_json=False, save_hybrid=False, conf=None, iou=0.7, max_det=300, half=False, dnn=False, plots=True, source=None, vid_stride=1, stream_buffer=False, visualize=False, augment=False, agnostic_nms=False, classes=None, retina_masks=False, embed=None, show=False, save_frames=False, save_txt=False, save_conf=False, save_crop=False, show_labels=True, show_conf=True, show_boxes=True, line_width=None, format=torchscript, keras=False, optimize=False, int8=False, dynamic=False, simplify=False, opset=None, workspace=4, nms=False, lr0=0.01, lrf=0.01, momentum=0.937, weight_decay=0.0005, warmup_epochs=3.0, warmup_momentum=0.8, warmup_bias_lr=0.1, box=7.5, cls=0.5, dfl=1.5, pose=12.0, kobj=1.0, label_smoothing=0.0, nbs=64, hsv_h=0.015, hsv_s=0.7, hsv_v=0.4, degrees=0.0, translate=0.1, scale=0.5, shear=0.0, perspective=0.0, flipud=0.0, fliplr=0.5, bgr=0.0, mosaic=1.0, mixup=0.0, copy_paste=0.0, auto_augment=randaugment, erasing=0.4, crop_fraction=1.0, cfg=None, tracker=botsort.yaml, save_dir=D:\python\yolov109.25\runs\detect\train26

Overriding model.yaml nc=80 with nc=3

from n params module arguments

0 -1 1 1856 ultralytics.nn.modules.conv.Conv [3, 64, 3, 2]

1 -1 1 73984 ultralytics.nn.modules.conv.Conv [64, 128, 3, 2]

2 -1 3 279808 ultralytics.nn.modules.block.C2f [128, 128, 3, True]

3 -1 1 295424 ultralytics.nn.modules.conv.Conv [128, 256, 3, 2]

4 -1 6 2101248 ultralytics.nn.modules.block.C2f [256, 256, 6, True]

5 -1 1 137728 ultralytics.nn.modules.block.SCDown [256, 512, 3, 2]

6 -1 6 8396800 ultralytics.nn.modules.block.C2f [512, 512, 6, True]

7 -1 1 268800 ultralytics.nn.modules.block.SCDown [512, 512, 3, 2]

8 -1 3 1744384 ultralytics.nn.modules.block.C2fCIB [512, 512, 3, True]

9 -1 1 656896 ultralytics.nn.modules.block.SPPF [512, 512, 5]

10 -1 1 990976 ultralytics.nn.modules.block.PSA [512, 512]

11 -1 1 0 torch.nn.modules.upsampling.Upsample [None, 2, 'nearest']

12 [-1, 6] 1 0 ultralytics.nn.modules.conv.Concat [1]

13 -1 3 2006528 ultralytics.nn.modules.block.C2fCIB [1024, 512, 3, True]

14 -1 1 0 torch.nn.modules.upsampling.Upsample [None, 2, 'nearest']

15 [-1, 4] 1 0 ultralytics.nn.modules.conv.Concat [1]

16 -1 3 1247744 ultralytics.nn.modules.block.C2f [768, 256, 3]

17 -1 1 590336 ultralytics.nn.modules.conv.Conv [256, 256, 3, 2]

18 [-1, 13] 1 0 ultralytics.nn.modules.conv.Concat [1]

19 -1 3 1875456 ultralytics.nn.modules.block.C2fCIB [768, 512, 3, True]

20 -1 1 268800 ultralytics.nn.modules.block.SCDown [512, 512, 3, 2]

21 [-1, 10] 1 0 ultralytics.nn.modules.conv.Concat [1]

22 -1 3 2006528 ultralytics.nn.modules.block.C2fCIB [1024, 512, 3, True]

23 [16, 19, 22] 1 2826658 ultralytics.nn.modules.head.v10Detect [3, [256, 512, 512]]

YOLOv10l summary: 628 layers, 25769954 parameters, 25769938 gradients, 127.2 GFLOPs

Freezing layer 'model.23.dfl.conv.weight'

AMP: running Automatic Mixed Precision (AMP) checks with YOLOv8n...

D:\python\yolov109.25\ultralytics\nn\tasks.py:779: FutureWarning: You are using `torch.load` with `weights_only=False` (the current default value), which uses the default pickle module implicitly. It is possible to construct malicious pickle data which will execute arbitrary code during unpickling (See https://github.com/pytorch/pytorch/blob/main/SECURITY.md#untrusted-models for more details). In a future release, the default value for `weights_only` will be flipped to `True`. This limits the functions that could be executed during unpickling. Arbitrary objects will no longer be allowed to be loaded via this mode unless they are explicitly allowlisted by the user via `torch.serialization.add_safe_globals`. We recommend you start setting `weights_only=True` for any use case where you don't have full control of the loaded file. Please open an issue on GitHub for any issues related to this experimental feature.

ckpt = torch.load(file, map_location="cpu")

D:\python\yolov109.25\ultralytics\utils\checks.py:641: FutureWarning: `torch.cuda.amp.autocast(args...)` is deprecated. Please use `torch.amp.autocast('cuda', args...)` instead.

with torch.cuda.amp.autocast(True):

D:\python\yolov109.25\ultralytics\engine\trainer.py:276: FutureWarning: `torch.cuda.amp.GradScaler(args...)` is deprecated. Please use `torch.amp.GradScaler('cuda', args...)` instead.

self.scaler = torch.cuda.amp.GradScaler(enabled=self.amp)

AMP: checks passed ✅

train: Scanning D:\python\yolov109.25\datasets_extend\train\labels.cache... 495 images, 0 backgrounds, 0 corrupt: 100%|██████████| 495/495 [00:00<?, ?it/s]

E:\Python\anaconda\envs\tf2\lib\site-packages\mmengine\optim\optimizer\zero_optimizer.py:11: DeprecationWarning: `TorchScript` support for functional optimizers is deprecated and will be removed in a future PyTorch release. Consider using the `torch.compile` optimizer instead.

from torch.distributed.optim import \这些问题的出现

最新发布

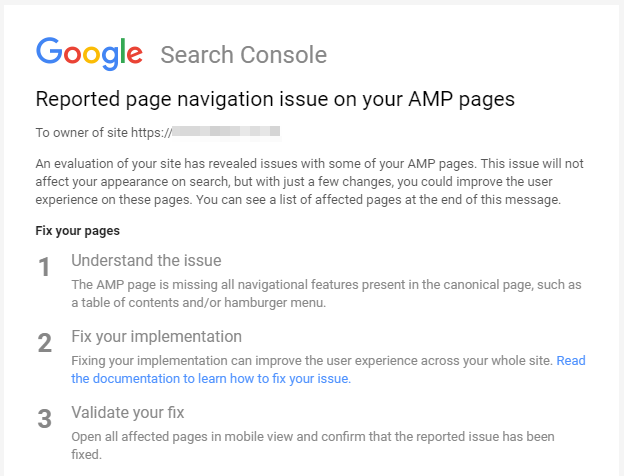

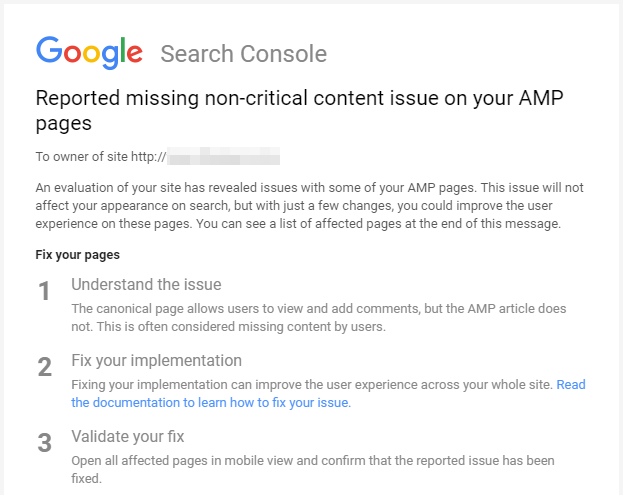

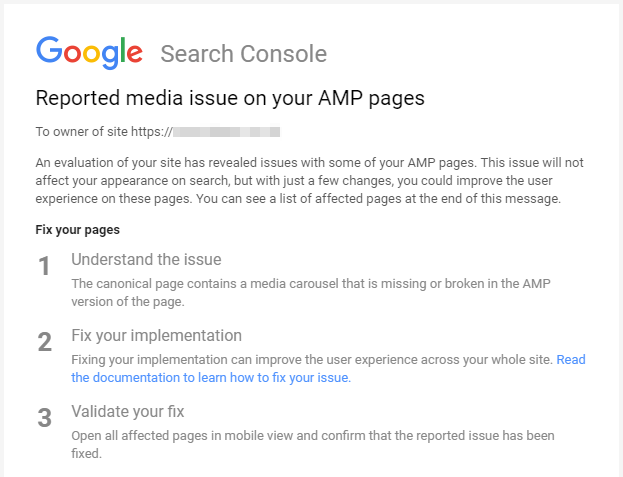

探讨了AMP作为Google推动的网页加速项目,如何在优化移动网页体验的同时,成为其控制网络标准和内容的手段。文章分析了Google对AMP版本与常规网页一致性的要求,及其对发布商的影响。

探讨了AMP作为Google推动的网页加速项目,如何在优化移动网页体验的同时,成为其控制网络标准和内容的手段。文章分析了Google对AMP版本与常规网页一致性的要求,及其对发布商的影响。

695

695

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?