基础准备

pve1 》ntp服务 pve1、pve2、pve3加入集群

安装ceph图解

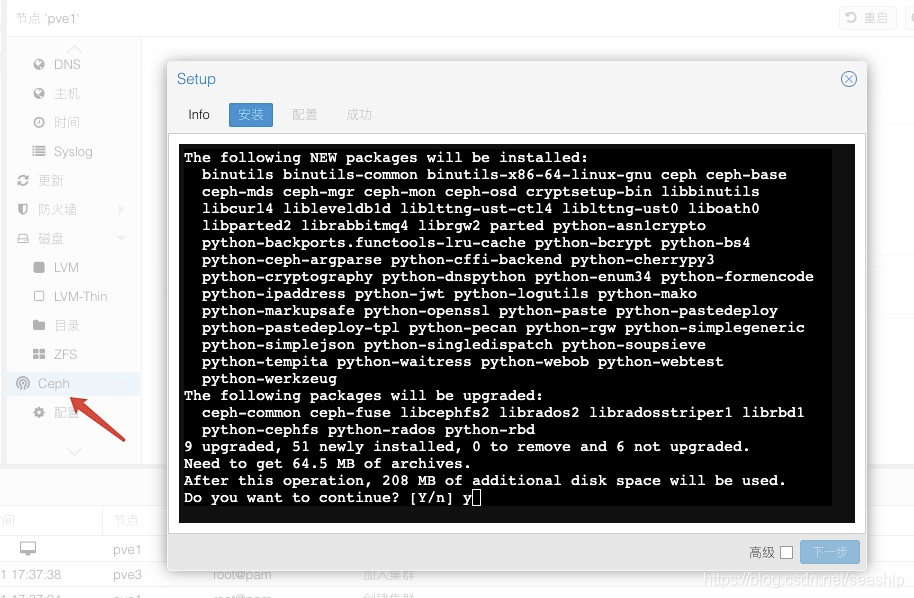

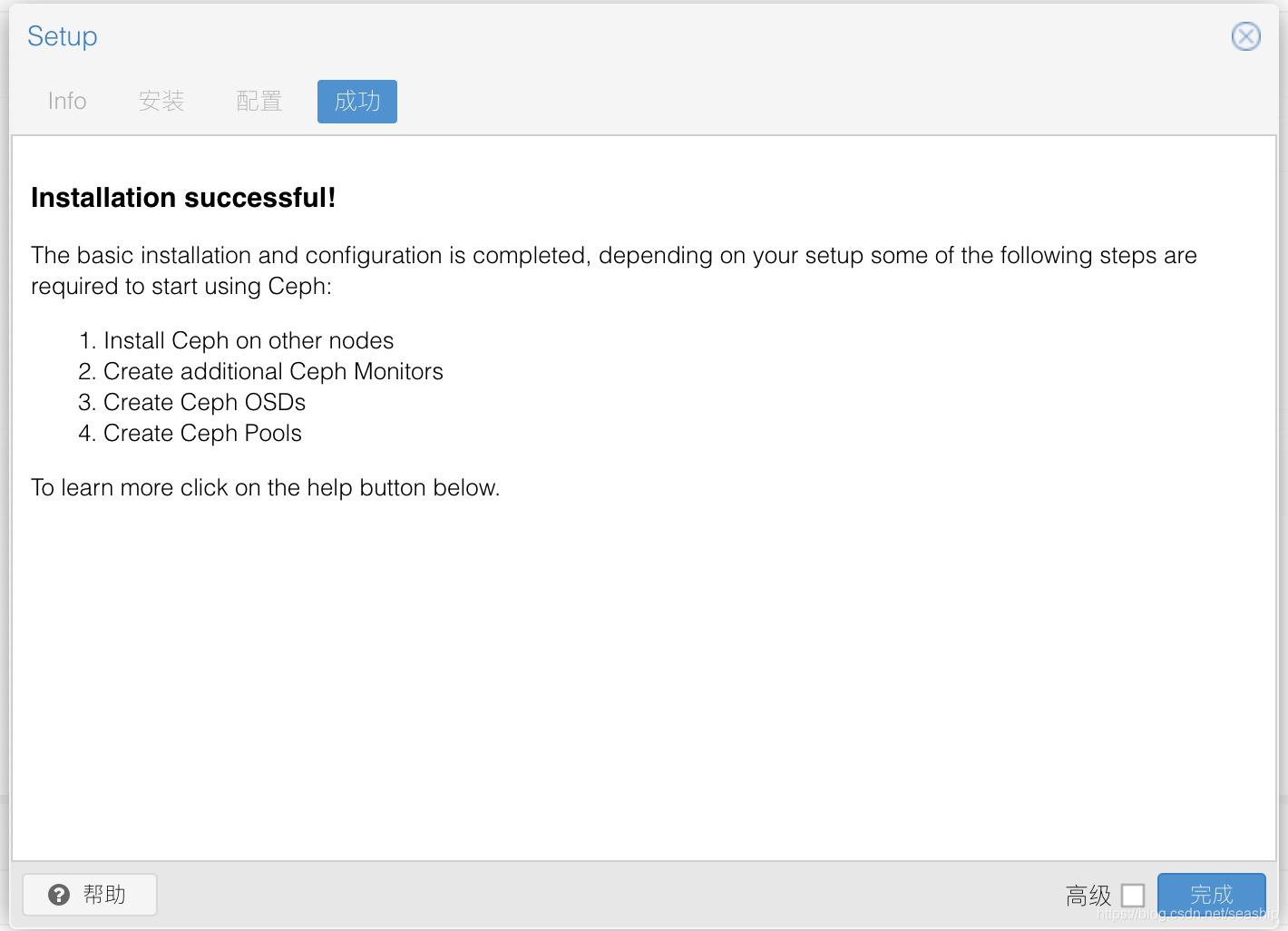

在线安装

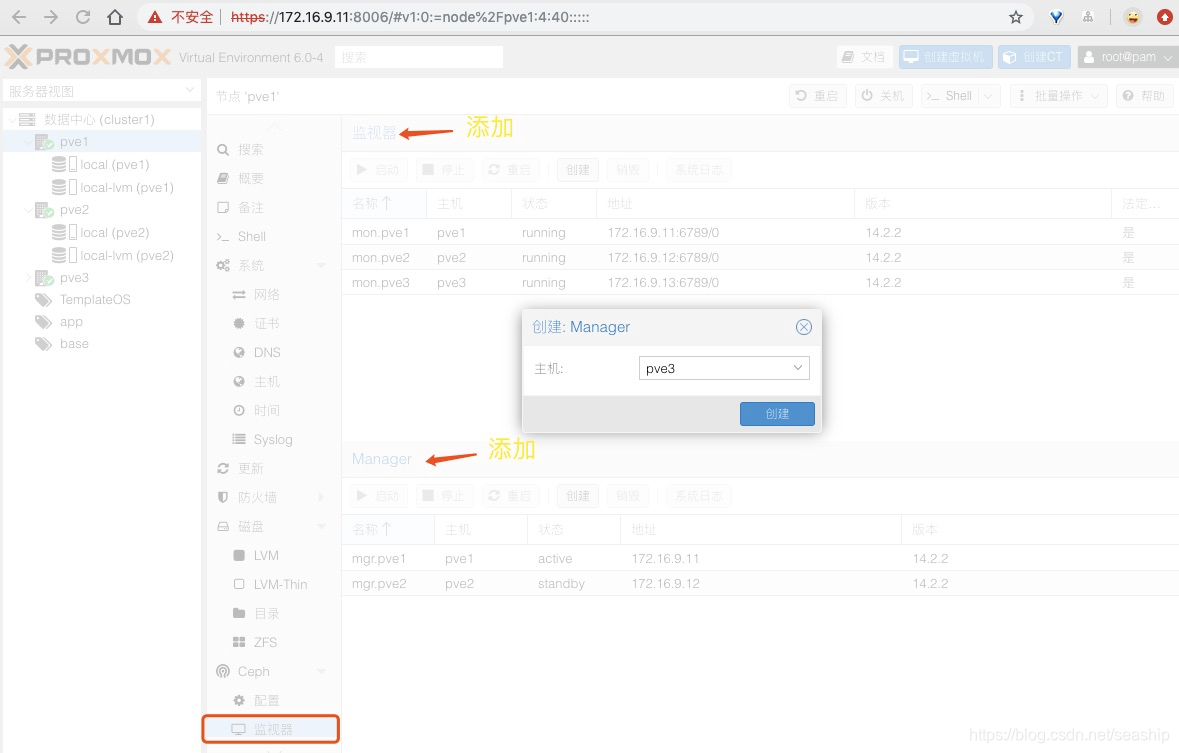

监视器和manger

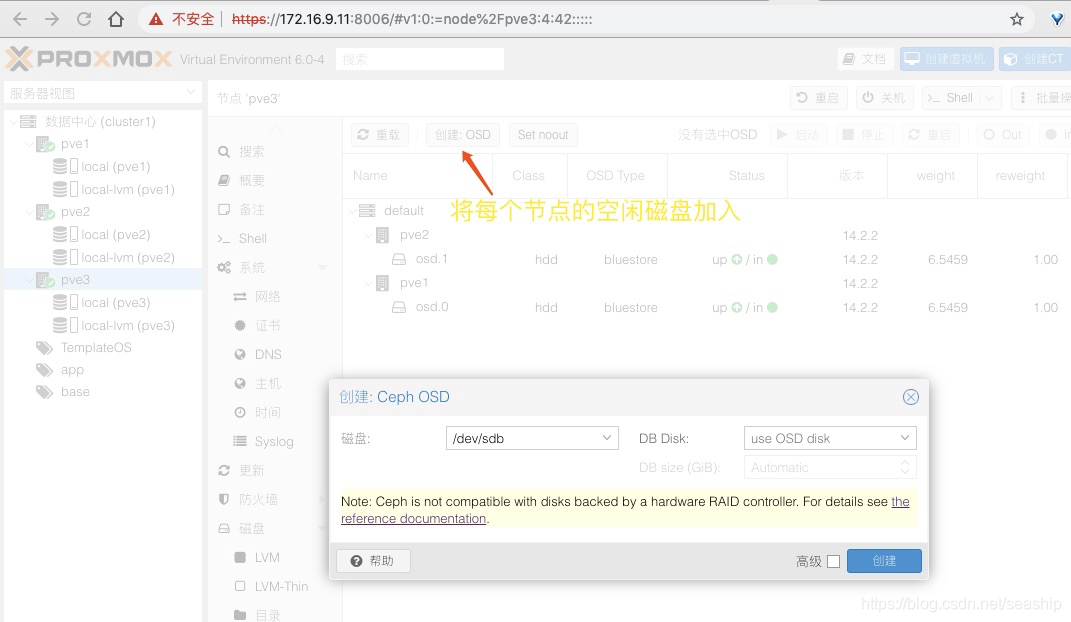

ODS

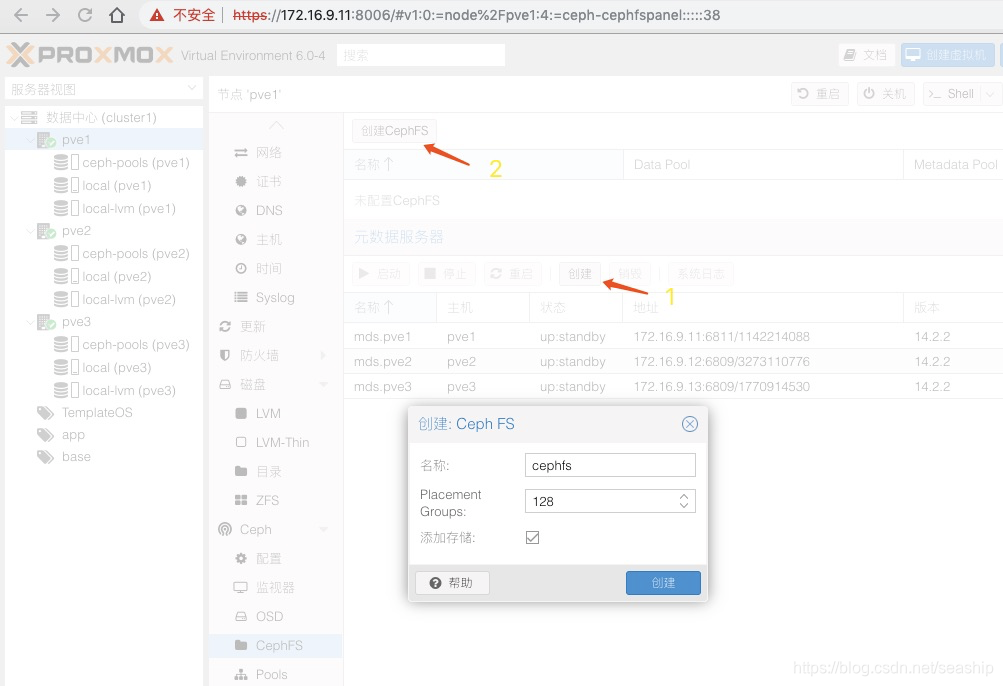

ceph文件系统

补充

ceph不建议使用raid盘,ods挂载独立盘!

pve1在线安装完成后把/var/cache/apt/archives/deb包传到其他服务器加快安装!

多磁盘批量手动添加osd

pveceph createosd /dev/sdd

pveceph createosd /dev/sde

pveceph createosd /dev/sdf

…

本文详细介绍了如何在Proxmox VE (PVE) 上安装和配置Ceph集群,包括NTP服务同步、在线安装流程、监视器与Manager设置、对象存储设备(ODS)挂载以及多磁盘批量添加OSD的方法,为构建高效稳定的数据存储解决方案提供实用指导。

本文详细介绍了如何在Proxmox VE (PVE) 上安装和配置Ceph集群,包括NTP服务同步、在线安装流程、监视器与Manager设置、对象存储设备(ODS)挂载以及多磁盘批量添加OSD的方法,为构建高效稳定的数据存储解决方案提供实用指导。

2301

2301

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?