在知乎看到一个很有意思的问题,搬运给大家,顺便记录一下

问题描述:

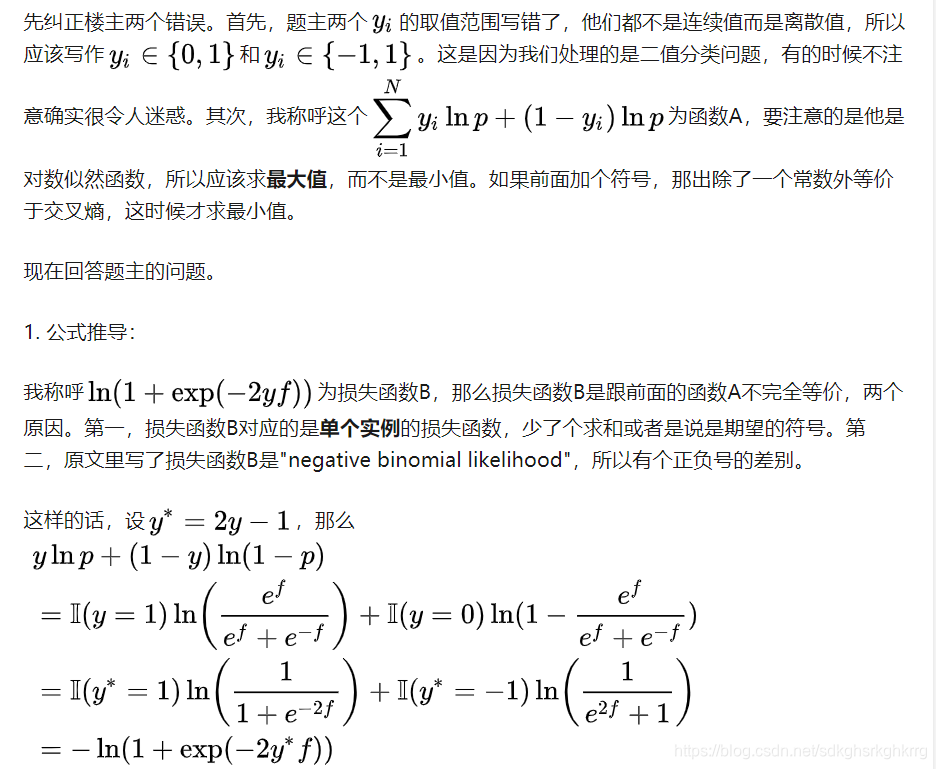

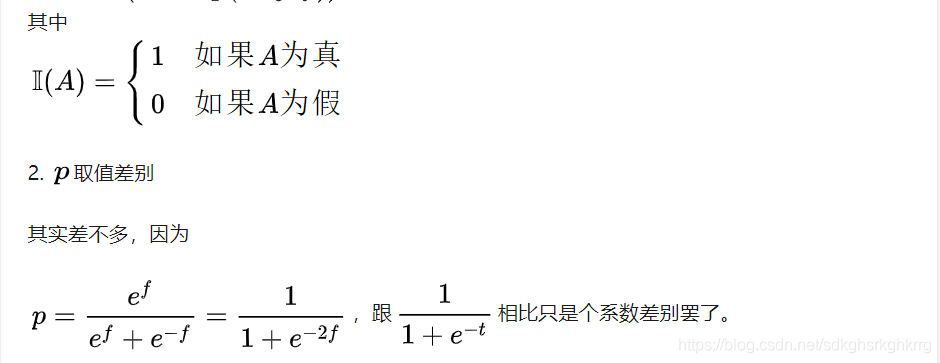

回答问题:

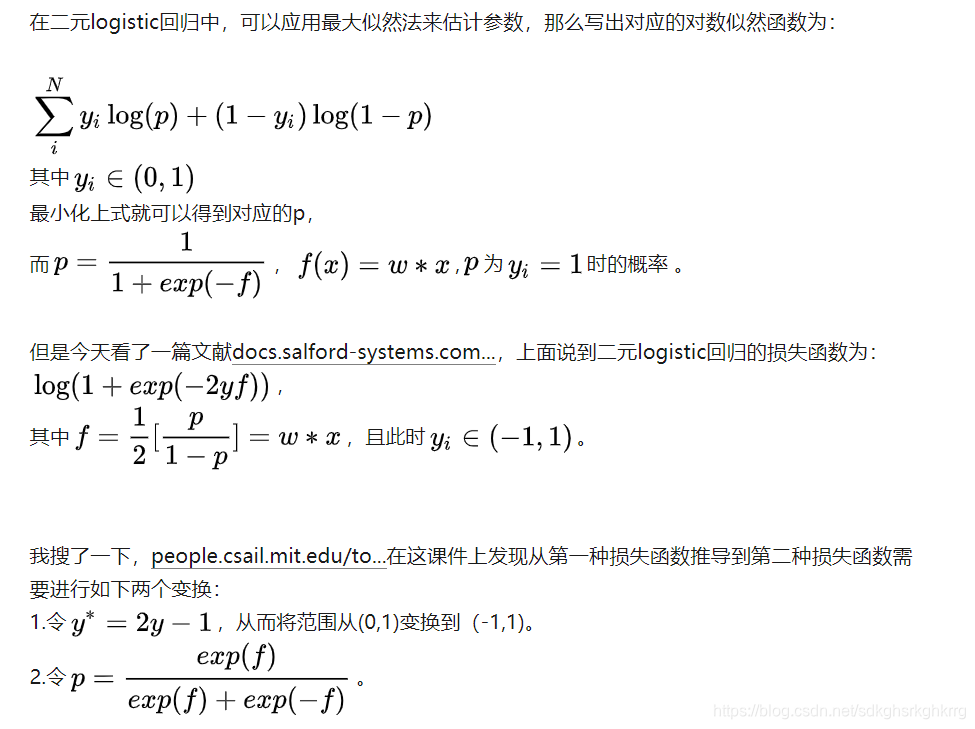

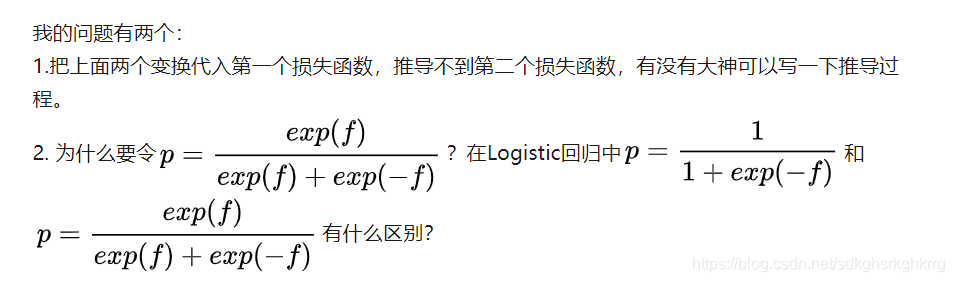

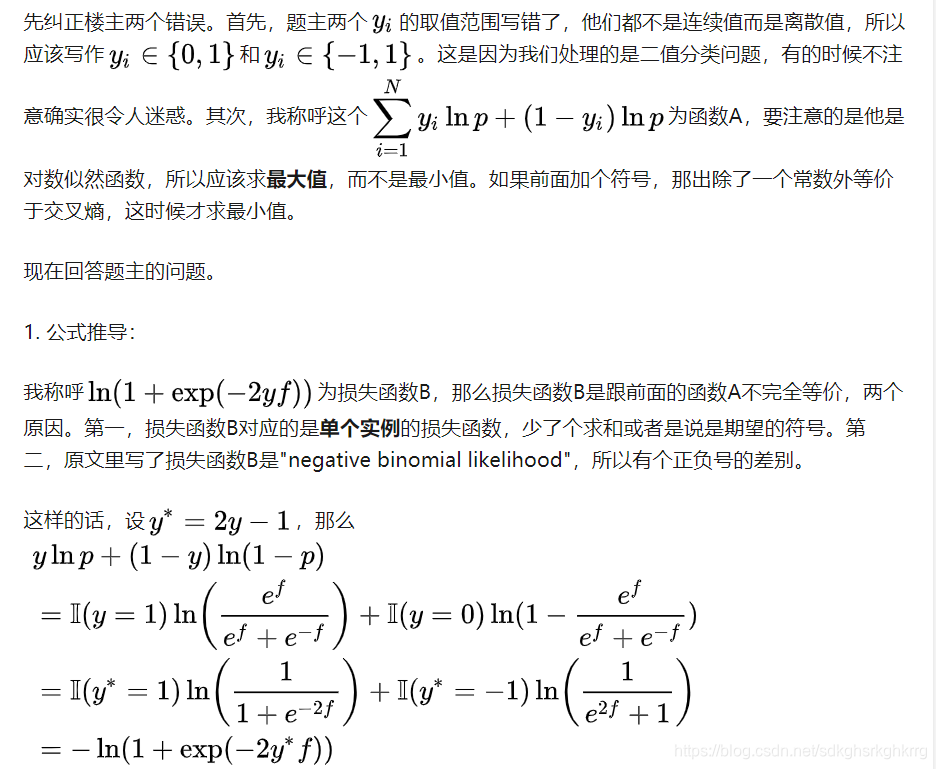

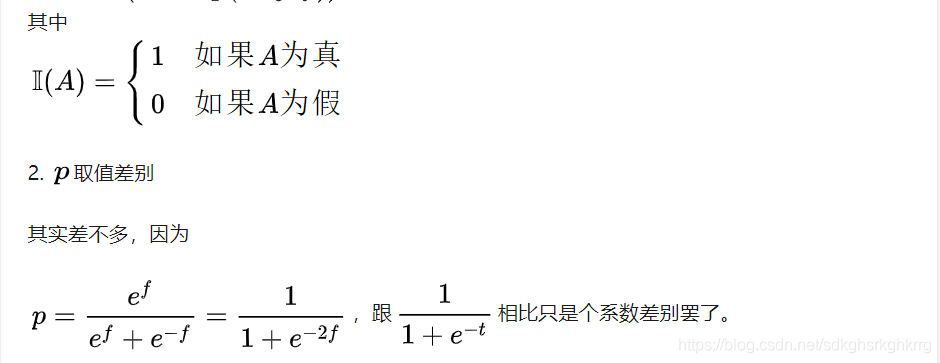

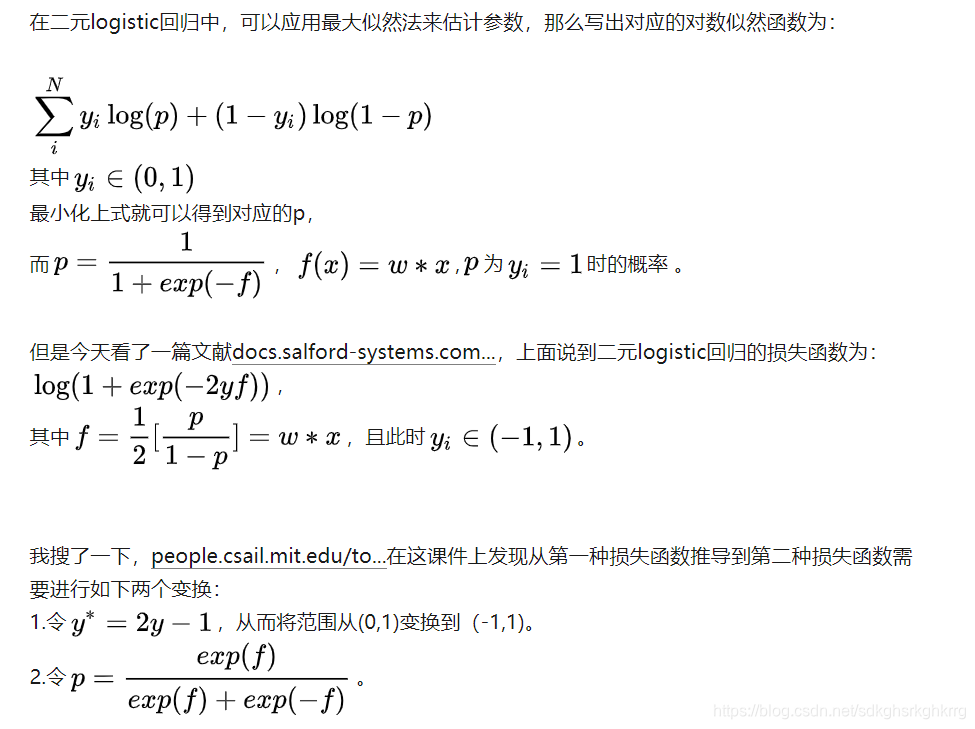

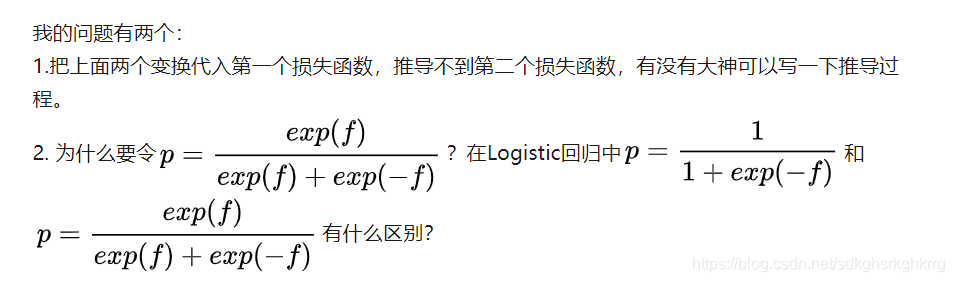

关于二元Logistics回归的损失函数的推导的问题

最新推荐文章于 2024-11-08 17:13:24 发布

作者从知乎搬运一个有意思的机器学习相关问题,并进行记录。虽未给出具体问题描述与回答内容,但围绕机器学习展开。

作者从知乎搬运一个有意思的机器学习相关问题,并进行记录。虽未给出具体问题描述与回答内容,但围绕机器学习展开。

作者从知乎搬运一个有意思的机器学习相关问题,并进行记录。虽未给出具体问题描述与回答内容,但围绕机器学习展开。

作者从知乎搬运一个有意思的机器学习相关问题,并进行记录。虽未给出具体问题描述与回答内容,但围绕机器学习展开。

在知乎看到一个很有意思的问题,搬运给大家,顺便记录一下

问题描述:

回答问题:

1047

1047

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?