浅谈SEO优化-站点优化(3)

一.前言

我们新建一个站点,搜索引擎肯定不知道吧。那我们不可能等对方来抓取,那不知道何时何月才能抓取到你的站点,我们要主动出击,去找搜索引擎,那怎么办呢?如何添加我们的网站?而每个搜索引擎都有一个站长平台,那是让我们添加自己网站的。这篇文章是教大家如何主动出击,和搜索引擎大教导。

二.搜索引擎

我们要做哪几个平台呢?国内2017年1月数据。我们主要围绕这5个搜索引擎,百度、360搜索、搜狗、google、必应。

| 搜索引擎 | 网址 |

|---|---|

| 百度 | http://zhanzhang.baidu.com/ |

| 360搜索 | http://zhanzhang.so.com/ |

| 搜狗 | http://zhanzhang.sogou.com |

| http://www.google.cn/webmasters/ | |

| 必应 | https://www.bing.com/webmaster |

如何提交站长

文件验证: 点击 “下载验证文件”,将文件放在项目的根目录下,然后点击完成验证。百度会搜索你的域名查看有没有哪个文件。

HTML标签验证: 把meta头,加载head头里面。点击完成验证。

CNAME验证: 打开后台,域名解析添加 下图域名。点击完成验证。

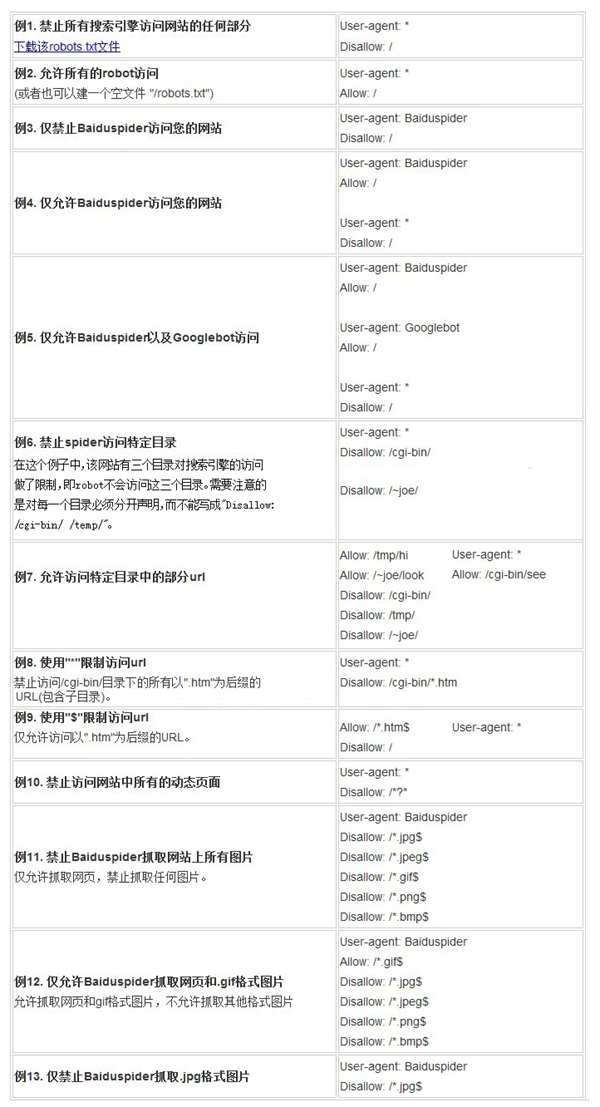

三.Robots

robots是站点与spider沟通的重要渠道,站点通过robots文件声明该网站中不想被搜索引擎收录的部分或者指定搜索引擎只收录特定的部分。请注意,仅当您的网站包含不希望被搜索引擎收录的内容时,才需要使用robots.txt文件。如果您希望搜索引擎收录网站上所有内容,请勿建立robots.txt文件。

robots文件

robots文件往往放置于根目录下,包含一条或更多的记录,这些记录通过空行分开(以CR,CR/NL, or NL作为结束符),每一条记录的格式如下所示:

robots生成工具:

站长工具:http://tool.chinaz.com/robots/

Robots生成器:http://robots.51240.com

nodejs自动化生产:https://www.npmjs.com/package/robots

四.sitemap

对于网站中希望搜索引擎抓取的网页url,站长可以将其制作成标准的Sitemap(站点地图)文件。

如何使用:

把sitemap.xml放到根目录,然后在站长工具,提交文件就可以了。

Sitemap例子:

"><!-- XML文件需以utf-8编码-->

<urlset>

<!--必填-->

<url>

<!--必填,定义某一个链接的入口,每一条数据必须要用<url>和</url>来标示 -->

<loc>http://www.xxxxxx.html/000000.html</loc>

<!--必填,URL长度限制在256字节内-->

<lastmod>2012-12-01</lastmod>

<!--更新时间标签,非必填,用来表示最后更新时间-->

<changefreq>daily</changefreq>

<!--更新频率标签,非必填,用来告知引擎页面的更新频率 -->

<priority>0.8</priority>

<!--优先权标签,优先权值0.0-1.0,用来告知引擎该条url的优先级-->

</url>

<url>

<loc>http://www.xxxxxx.html/000001.html</loc>

<lastmod>2012-12-01</lastmod>

<changefreq>daily</changefreq>

<priority>0.8</priority>

</url>

</urlset> sitemap生成工具:

webpack sitemap生成工具:https://www.npmjs.com/package/sitemap-webpack-plugin

小爬虫生成器:http://www.sitemap-xml.org

本文介绍如何通过各大搜索引擎的站长平台提交网站信息,包括文件验证、HTML标签验证及CNAME验证等方法,并探讨了robots文件和sitemap的使用技巧。

本文介绍如何通过各大搜索引擎的站长平台提交网站信息,包括文件验证、HTML标签验证及CNAME验证等方法,并探讨了robots文件和sitemap的使用技巧。

2702

2702

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?