基于利用单目图像的提议生成网络的3D物体检测

摘要

单目3D目标检测对于自动驾驶汽车和机器人技术而言是一项低成本但具有挑战性的任务。利用单目图像进行3D目标检测作为自动驾驶车辆的一个辅助模块,近年来受到越来越多的关注。目前,昂贵的激光雷达和立体相机在精确的3D目标检测方面表现占优,而基于单目图像的方法性能则明显较低。通过将基于单目的方法重构为单一内部网络,该性能差距得以缩小。我们利用2D与3D检测空间之间的相关性,使3D框能够借助在图像空间中生成的特征图。2D和3D候选框通过一个增强的提议生成网络提取,并用于实现精确的3D检测与定位。在KITTI数据集上的实验结果表明,与其他单目目标检测方法相比,提出的方法显著提高了3D物体检测的准确率。对于中等难度级别的轿车类别,前视图下的3D物体检测平均精度均值(mAP)提升至25%,鸟瞰图下提升至32%。

I. 引言

目标检测与识别在为自动驾驶汽车和机器人视觉设计高效、计算成本较低且实时的3D解决方案中起着至关重要的作用[1],[2]。现有的3D物体检测方法依赖于3D数据传感器,例如来自稀疏深度图的点云,这些传感器利用昂贵的激光传感器(激光雷达)、深度相机和立体相机[3]。这些传感器的缺点包括深度范围有限、立体相机的同步与校准问题,以及激光传感器尤其是用于检测小物体的高分辨率激光雷达的高昂成本。以往基于单目图像的方法采用几何约束、解耦变换和深度感知卷积来预测3D物体[4],[5],[6]。大多数基于单目或立体图像的3D物体检测方法对于实时性要求而言速度过慢,且整体准确率远低于使用3D数据传感器的其他方法。这促使我们改进现有最先进的方法中准确率低的问题,并减少复杂的处理步骤。

本文提出了一种单一的端到端深度学习模型,用于同时预测7元组3D边界框参数(物体的位置、高度、宽度、长度和方向角)以及物体的4元组2D(位置、高度和宽度)。2D目标检测可以提供足够的信息,通过单一的内部深度学习模型来提升并指导3D物体检测的性能。因此,3D物体检测在分类任务中同时利用了3D和2D空间。本文工作的贡献如下:

我们提出了一种3D区域提议网络(RPN),该网络利用3D和2D检测空间的几何约束,高效地预测3D物体。

- 预计算了十二个3D锚框,具有不同的尺度和长宽比。

- 我们使用判别学习技术来训练骨干网络。

- 与最先进的方法相比,提出的方法在KITTI数据集上表现出显著性能提升。

II. 相关前期工作

本文提出的工作与3D物体检测和单目3D目标检测相关。因此,我们将相关工作归纳为以下两类。

A. 3D目标检测

3D物体检测可以定义为从图像、视频序列或3D数据中在3D视图中查找或识别物体。当前先进的3D物体检测方法基于激光雷达点云和深度图等3D数据。这些方法要么仅使用激光雷达点云,要么同时结合激光雷达和相机图像。一些方法提出了两个子网络,一个用于3D目标提议生成,另一个用于利用激光雷达和相机图像进行多视图特征融合。许多方法利用立体视觉来估计3D深度信息。另一些方法使用立体图像通过立体RPN生成候选区域,以同时预测对应的左右图像中的物体,并采用像素级立体匹配来优化3D边界框。相比单目图像,立体图像提供了更丰富的信息,但立体相机的安装和计算要求高于单目相机,因此单目相机在实时场景中更具可行性。

B. 单目3D目标检测

单目3D目标检测是仅利用单张相机图像对物体周围的3D边界框进行预测与定位。尽管这是一个困难且病态的问题,但目前自动驾驶汽车领域的大多数最新研究工作仍基于单目图像。伪激光雷达(Pseudo‐LiDAR)[7]生成深度图,将其转换为点云,并将这些点输入基于激光雷达的目标检测方法中。Deep3DBox[4]通过2D目标检测提供的姿态估计和几何约束来估计3D边界框。在MonoDIS[5]中,特征金字塔网络被训练以解耦变换。在M3D‐RPN[6]中,深度感知卷积与区域提议网络结合使用。

与利用多网络的最先进方法相比,其中一些方法使用额外数据来训练2D和3D目标检测,我们的模型利用内部网络同时预测2D和3D边界框。该方法仅使用单个相机图像,在KITTI数据集上的3D物体检测准确率相比最先进的方法有所提升。

III. 提出的方法

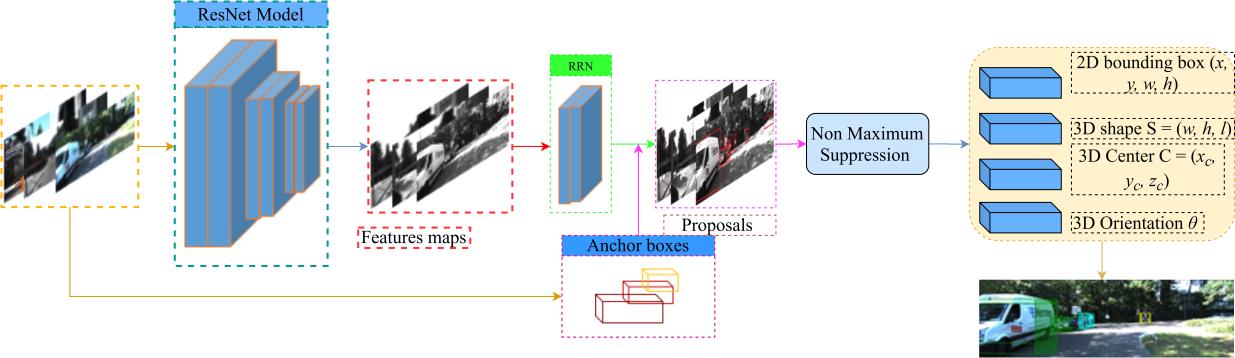

我们提出的方法的框图如图1所示。提出的网络从输入的单目RGB图像中提取特征图。这些特征图进一步由区域提议网络(RPN)处理,以预测2D和3D锚框的可能候选区域及其目标性得分。候选区域通过非极大值抑制(NMS)来抑制不必要的候选区域。我们提出的方法为图像中的每个类别生成一个2D边界框(2DB)和一个3D边界框(3DB)。

A. 3D目标检测

3D物体检测的任务是如何在图像中检测出所有需要考虑的物体,并为其绘制2D和3D边界框。一个有方向的3D边界框在数学上表示为3DB = (C, S, θ),其中C = (xC, yC, zC) 和S = (w, h, l) 分别表示3D边界框的中心(三维坐标值)和尺寸。θ是方位角,用于表示边界框的方向,如图2所示。该方位角表示物体相对于相机射线角度的相对运动方向,而转向和俯仰视为零,这与其他自动驾驶车辆相关问题中的处理方式一致。有方向的2D边界框在数学上表示为2DB = (x, y, w, h),其中x和y是边界框在二维平面上的像素值,w和h分别是2D边界框的宽度和高度。

该模型以单目图像作为输入,并为每个锚框输出所有感兴趣的对象。与Faster R-CNN类似,每个锚框都会估计其3D边界框。3D边界框参数包括中心值C=(xC , yC , zC) 、方向θ和形状S= (w,h,l)。模型输出2DB参数像素位置(x, y),尺寸(w, h)和标签类别(cls),该类别属于每个锚点a的对象类别。

是中心,(w, h, l) 是形状,θ是方向)

是中心,(w, h, l) 是形状,θ是方向)

B. 候选区域生成

候选区域通过利用Faster R-CNN中引入的区域提议网络(RPN)提取。RPN是一个小型卷积层,滑过骨干网络(如ResNet)的特征图。RPN预测与一组预定义的3D边界框(称为锚框)相匹配的候选区域。这些锚框根据训练数据的统计信息,以不同的长宽比和尺度进行定义。锚框使用2D和3D参数共同定义,3D和2D参数之间采用共享中心位置。使用已知的投影矩阵来估计z坐标值。由于我们利用单张RGB图像进行3D物体检测,3D坐标中心点通过投影变换投影到2D图像平面。我们采用多任务损失来进行背景或目标的检测。目标。提出了一种类别熵用于计算目标性损失。在计算3D边界框回归损失时忽略背景锚框。通过锚点与真实3D边界框之间的重叠度来计算目标性得分。为了减少不必要的候选区域,应用了非极大值抑制(NMS)。

C. 网络架构

所提出的方法包含一个骨干深度学习模型。所提出的骨干网络为ResNet‐101[8]。在实验不同具有深层的模型时,发现使用深层进行训练会对3D物体检测性能产生不利影响。我们移除了ResNet‐101模型中的第4层、全连接层和softmax层。模型的输出特征图尺寸保持为1024 × 1024像素。我们采用一种判别学习技术来训练模型。首先冻结预训练的ResNet‐101模型权重中的深层,并以较低学习率训练浅层。该技术背后的直觉是,浅层包含边缘和线条等粗粒度信息,因此无需大幅调整权重。与浅层相反,在若干轮次后,我们解冻深层并使用较大学习率继续训练模型。我们使用PyTorch框架实现模型。

D. 损失函数

我们的网络损失是一个由分类损失、2D边界框损失和3D边界框损失组成的多模型学习问题。对于分类损失函数,我们使用基于回归的逻辑损失函数,而对于2D边界框损失函数,则对变换后的边界框和标签边界框应用负逻辑损失。3D边界框通过变换后的边界框与标签边界框之间的平滑L1损失函数进行计算。整个网络损失函数由分类损失函数、2D边界框损失函数和3D边界框损失函数组成,并带有正则化权重(λ1, λ2)。

IV. 实验结果

在本节中,我们分别展示了相机前视图图像和鸟瞰图图像上的3D物体检测与定位的实验结果。所提出的方法与基于单目视觉的3D目标检测和定位方法进行了比较。该方法在KITTI数据集上进行评估,该数据集包含7480张训练图像集、7518张测试图像集以及在德国卡尔斯鲁厄采集的相机标定集[9]。模型采用随机梯度下降进行训练,初始学习率0.001,批量大小为1,并使用在ImageNet上预训练的ResNet权重进行初始化。我们对所提出的方法在单一类别(仅汽车)上进行了评估。该方法在NVIDIA GeForce 1080 Ti GPU上进行训练。

A. 3D目标检测评估

在KITTI验证集上的3D物体检测评估结果如表I所示。3D物体检测任务的平均精度(AP3D)通过估计的3D边界框与真实3D边界框之间的IoU计算得出。对于KITTI官方评估中汽车类别的3D物体检测,IoU阈值设为0.7。由于骨干模型的选择对单目3D目标检测至关重要,我们标出了所有基于单目的3D物体检测方法所使用的骨干模型。本文展示了采用ResNet‐101的结果,该模型提升了3D物体检测的有效性。通常,像ResNet‐101这样更强大的骨干网络能够生成更精确的2D候选框和特征图,从而提升3D物体检测与定位的性能。表I仅针对轿车类别展示了所提出的方法与先前方法的对比结果。表I表明,所提出的方法在轿车类别上显著优于与最先进的方法相比,提高了两个难度级别的3D物体检测准确率。提出的方法在简单、中等和困难级别上相较于PatchNet[7]分别达到了31.34%、25.96(↑3.96%)和20.72(↑1.12%)。

| 方法 | Backbone | IoU > 0.7 | ||

|---|---|---|---|---|

| 简单 | 中等 | Hard | ||

| Deep3DBox [4] | VGG‐16 | 5.8 | 4.1 | 3.8 |

| MonoDIS[5] | ResNet‐34 | 18.0 | 14.9 | 13.4 |

| M3D‐RPN [6] | DenseNet-121 | 20.4 | 16.4 | 13.3 |

| MonoPointNet[10] | PointNet | 32.2 | 21.0 | 17.2 |

| PatchNet[7] | ResNet‐18 | 35.1 | 22.0 | 19.6 |

| Ours | ResNet‐101 | 31.3 | 25.9 | 20.7 |

B. 定位评估

鸟瞰图(BEV)图像的目标检测展示了所提出方法的定位性能。BEV提供了从顶部视角观察到的对象位置。在3D坐标系中,BEV可通过x轴和z轴方向表示。前视图图像(FV)中的3D边界框被投影到地面平面上,并在地面平面上应用2D目标检测。BEV的平均精度(APBEV)通过预测边界框与真实边界框之间的IoU计算得出。BEV的IoU阈值根据KITTI官方网站提供的标准评估脚本设置为0.7。图3(a)展示了围绕对象的预测3D边界框,而图3(b)展示了BEV的检测性能。在图3(b)中,绿色边界框表示预测结果,棕色表示真实情况。与最先进的方法[7],[4],[5],[6],[10]相比,我们在所有难度级别(简单、中等和困难)的汽车类别上均取得了显著更高的结果。如表II所示,在图像的简单难度级别中,仅有MonoPointNet[10]和PatchNet[7]分别高出6.63%和7.28%准确率高于提出的方法。然而,在中等和困难难度级别上,我们的方法将准确率分别提高了32.77 (↑3.67%) 和23.56。

| 方法 | 骨干网络 | IoU > 0.7 | ||

|---|---|---|---|---|

| Easy | Mod | Hard | ||

| Deep3DBox[4] | VGG‐16 | 9.9 | 7.7 | 5.3 |

| MonoDIS[5] | VGG‐16 | 24.2 | 18.4 | 16.9 |

| M3D‐RPN[6] | DenseNet‐121 | 26.8 | 21.1 | 17.4 |

| MonoPointNet[10] | PointNet | 43.7 | 28.3 | 23.8 |

| PatchNet[7] | ResNet‐18 | 44.4 | 29.1 | 24.1 |

| Ours | ResNet‐101 | 37.1 | 32.7 | 23.5 |

3D物体检测的前视图。(b) 鸟瞰图可视化。棕色框表示真实边界框,绿色框表示在鸟瞰图中的预测边界框。)

3D物体检测的前视图。(b) 鸟瞰图可视化。棕色框表示真实边界框,绿色框表示在鸟瞰图中的预测边界框。)

表III展示了提出的方法在KITTI验证集上基于40个点插值的鸟瞰图和3D检测的平均精度。

| 方法 | IoU > 0.7 | ||

|---|---|---|---|

| Easy | Mod | Hard | |

| BEV | 32.9% | 27.6% | 20.6% |

| 3D | 26.9% | 22.7% | 16.3% |

表IV展示了提出的方法在不同骨干模型上的准确率和推理时间。

| 模型 | time (秒) | IoU > 0.7 | ||

|---|---|---|---|---|

| Easy | Mod | Hard | ||

| ResNet‐18 | 0.098 | 9.6 | 7.3 | 5.2 |

| ResNet‐50 | 0.115 | 19.3 | 15.4 | 13.7 |

| ResNet‐101 | 0.131 | 36.5 | 28.8 | 23.3 |

| ResNet‐101 (discriminative) | 0.131 | 37.1 | 32.7 | 23.5 |

C. 消融研究

在KITTI数据集的新评估代码[5]上对提出的方法进行了评估。表III展示了提出的方法的评估结果。在中等难度级别下,提出的方法在鸟瞰图和3D检测上的准确率分别为27.6%和22.7%。此外,使用不同的ResNet模型(如ResNet‐18、ResNet‐50和ResNet‐101)对提出的方法进行了评估。表IV展示了提出的方法在不同骨干模型上的准确率和检测时间。ResNet‐18和ResNet‐50的检测时间明显低于ResNet‐101,但在简单模型上的准确率有显著下降。此外,采用判别学习的ResNet‐101相比ResNet‐101、ResNet‐50和ResNet‐18分别实现了3.9%、17.3%和25.4%更高的平均精度均值(mAP)。

V. 结论

本文中,我们提出了一种仅利用单目图像进行2D、3D物体检测和定位的单一网络。与以往采用多个网络、不同数据源以及多阶段流程的研究相比,所提出的方法通过单一内部网络同时预测物体周围的2D和3D边界框。首先,将单目RGB图像作为输入传入模型,并通过强大的骨干深度学习模型提取特征图。这些特征图进一步由区域提议网络(RPN)处理,利用2D和3D锚框生成候选区域。此外,应用非极大值抑制以消除冗余的候选区域。在KITTI基准上的实验结果表明,与先前方法相比,所提出的方法在3D物体检测和定位方面的性能更为高效。具体而言,在定位和3D物体检测任务中,所提出的方法将轿车类别的平均精度分别提高了32%和25%。在未来的研究中,预计将针对最新的3D物体检测基准开展更广泛的实验。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?