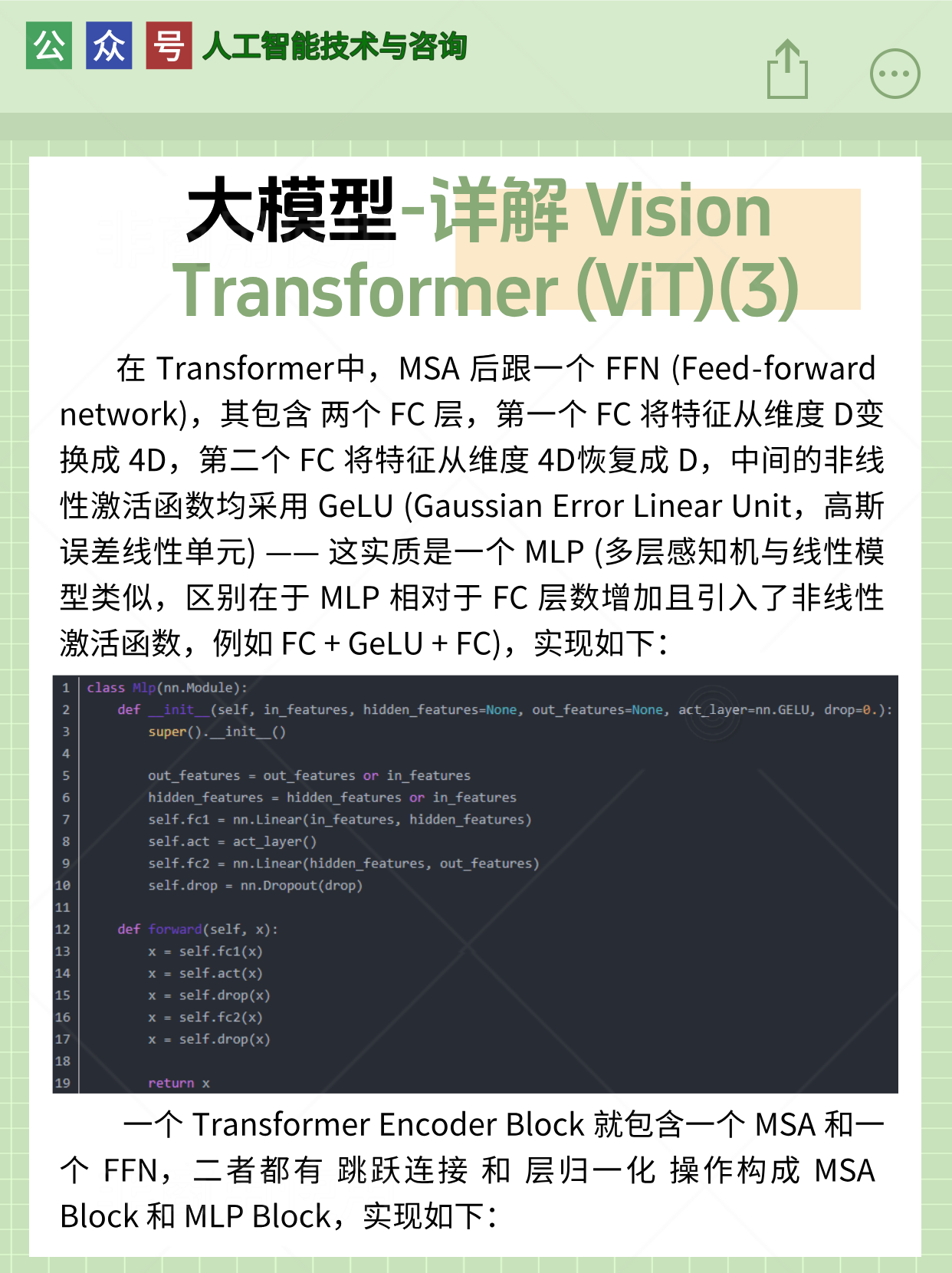

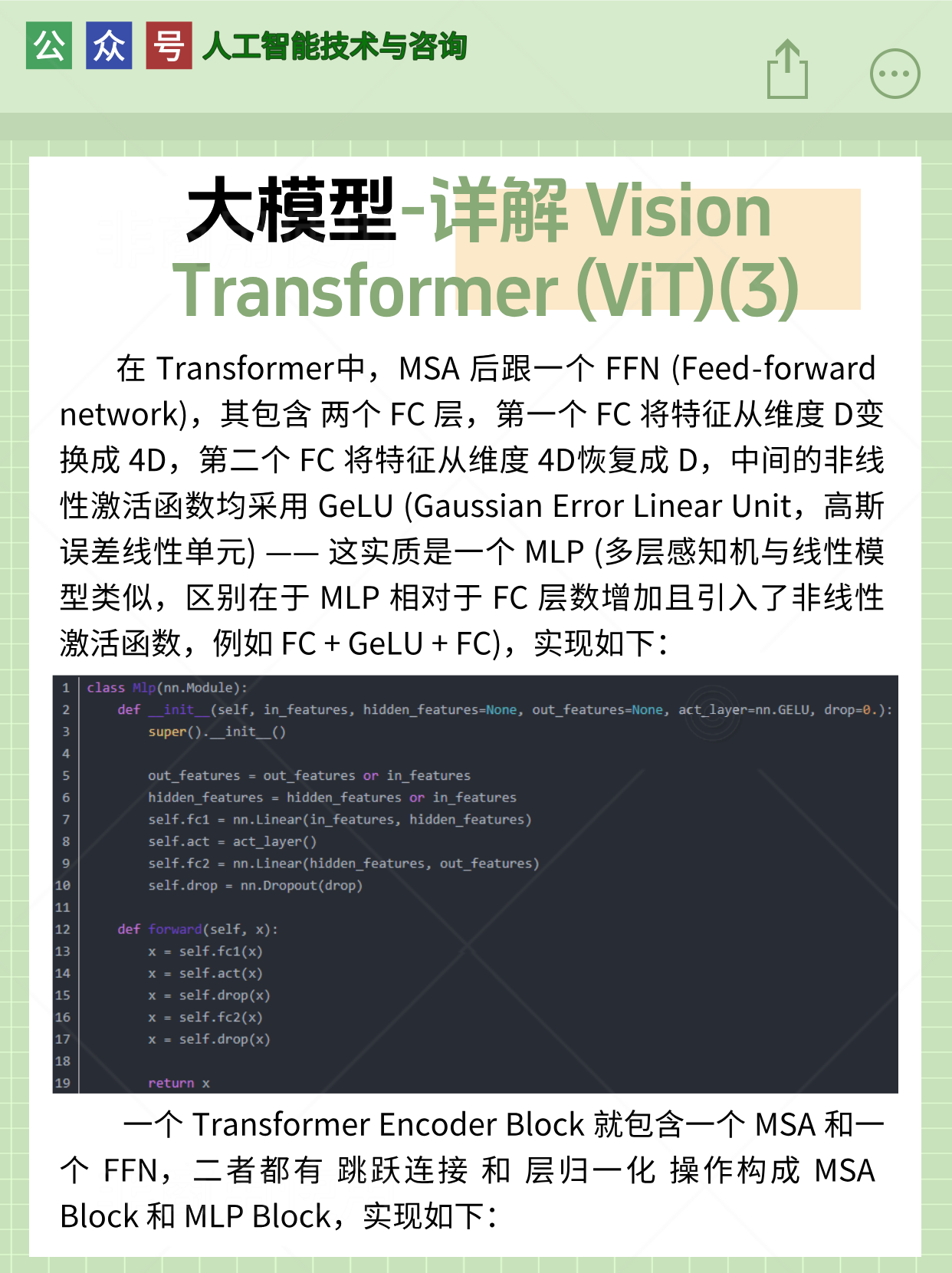

1.Transformer 编码器

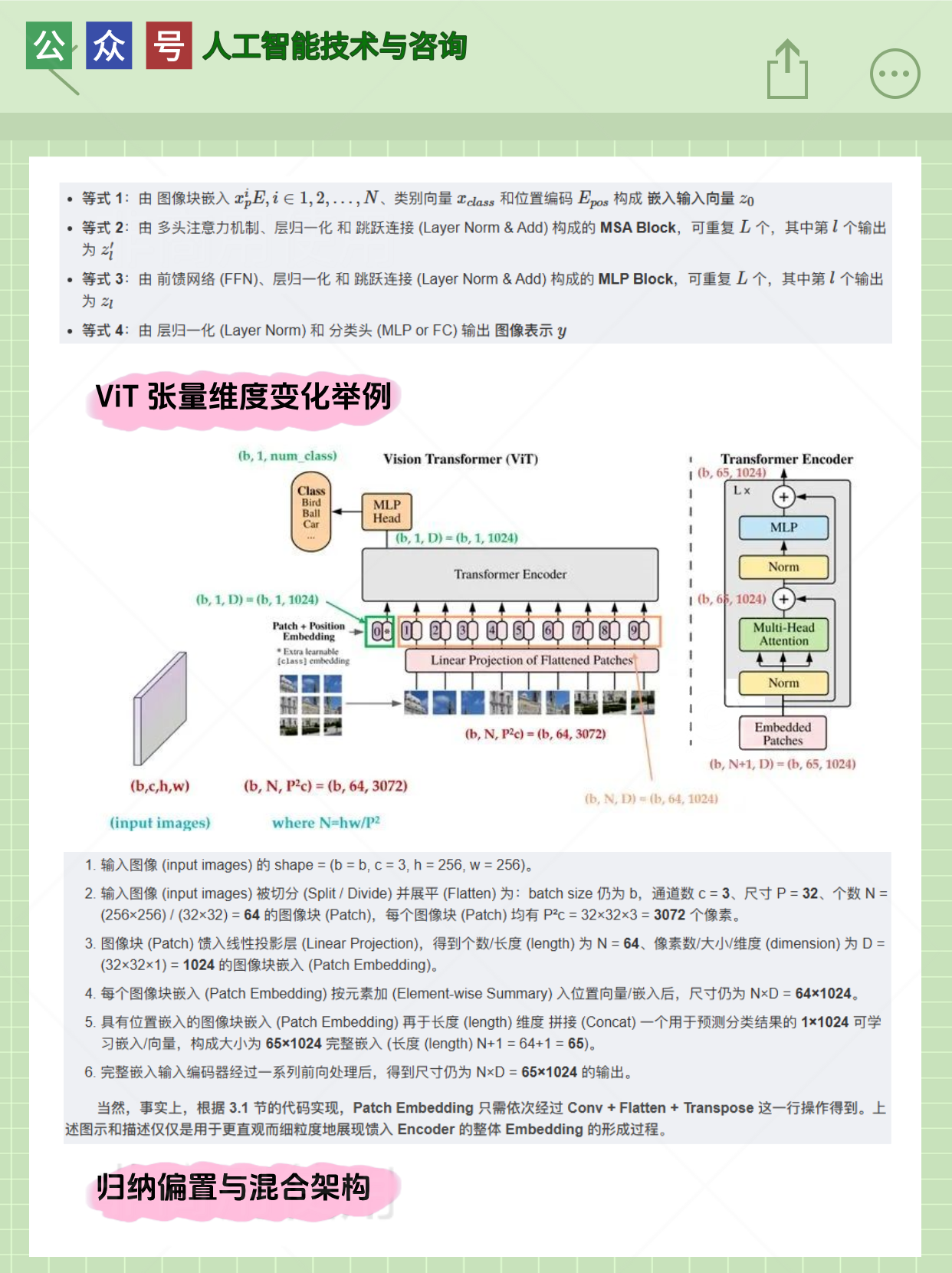

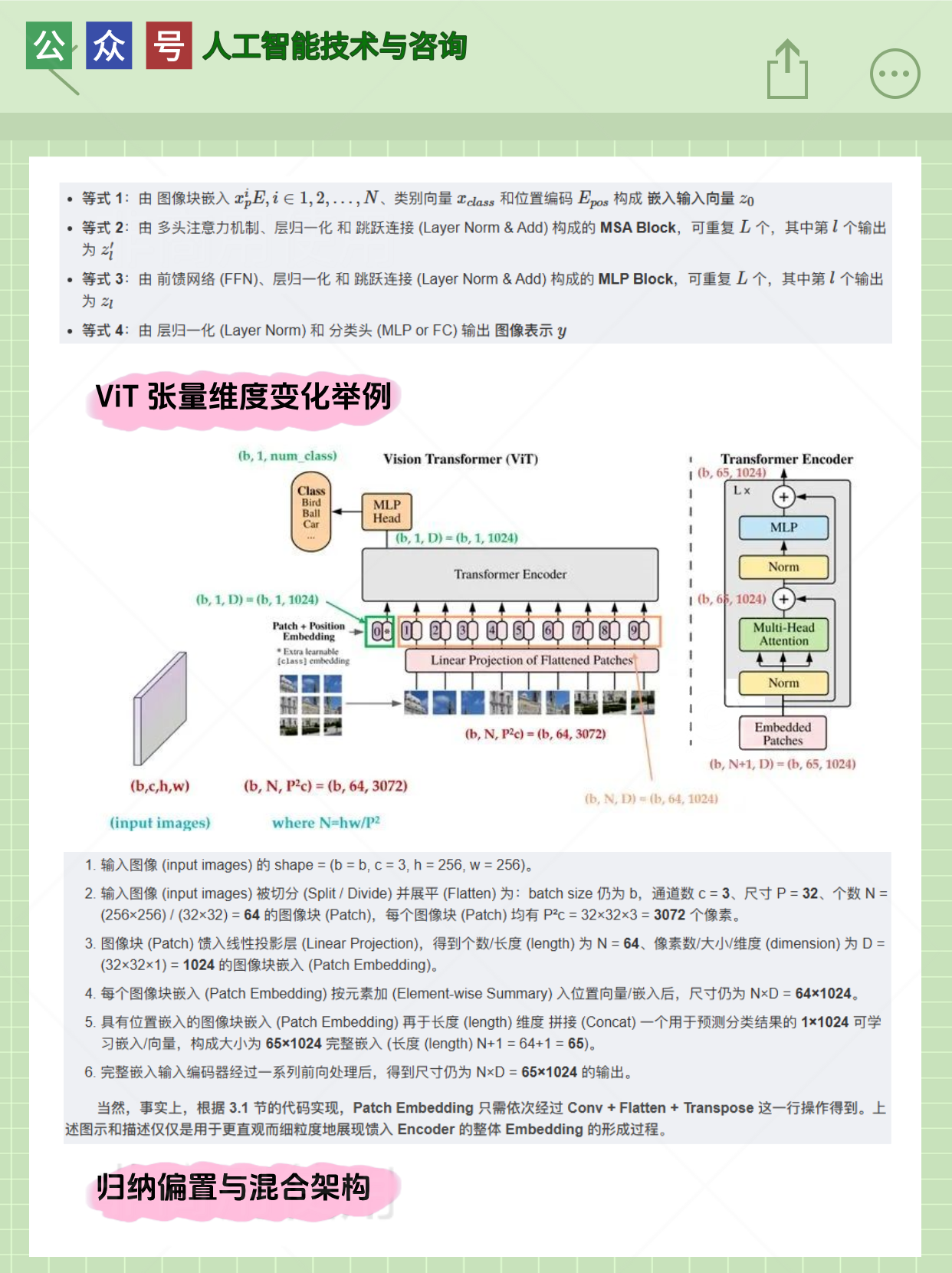

2.ViT 张量维度变化举例

3.归纳偏置与混合架构

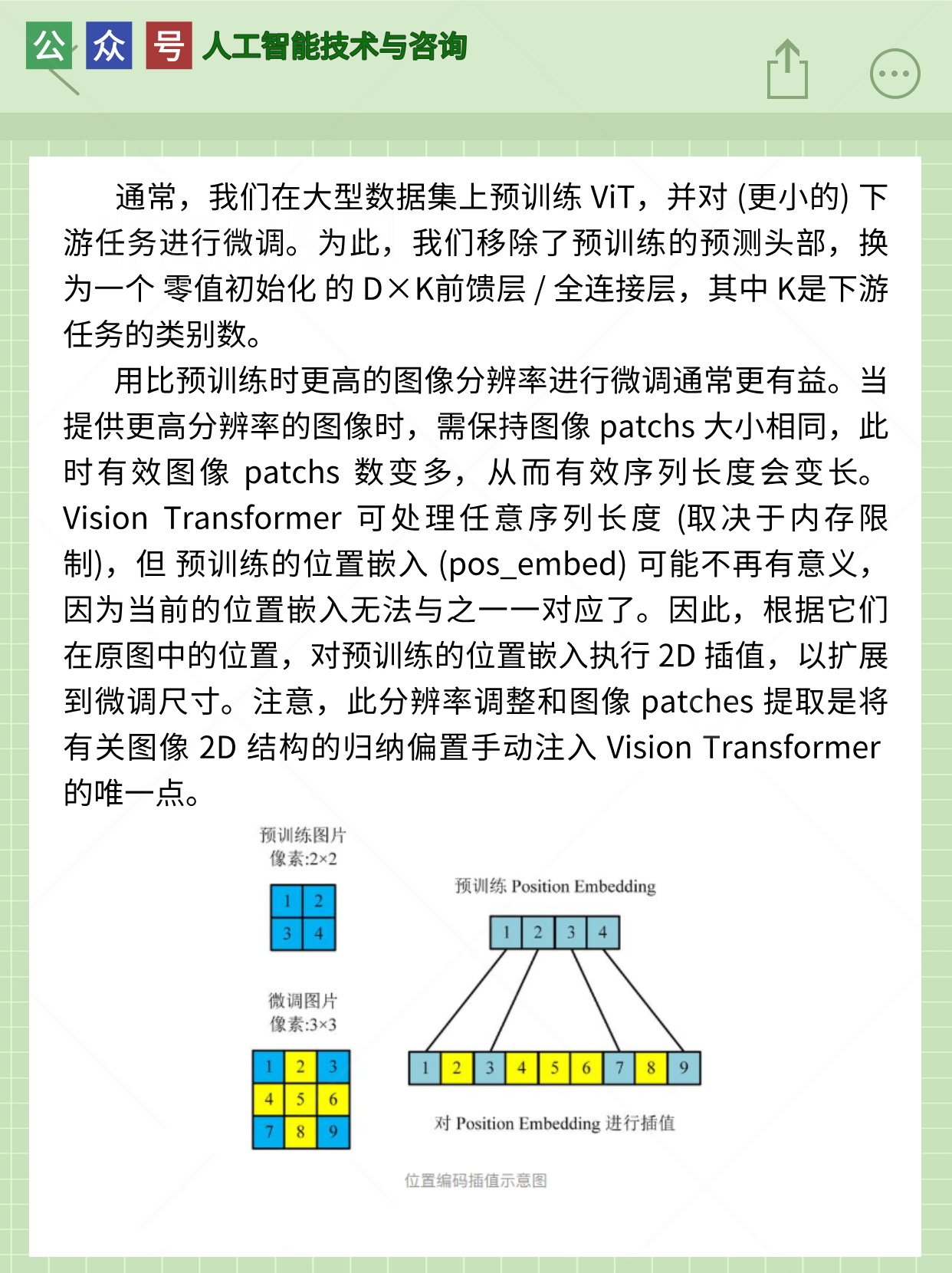

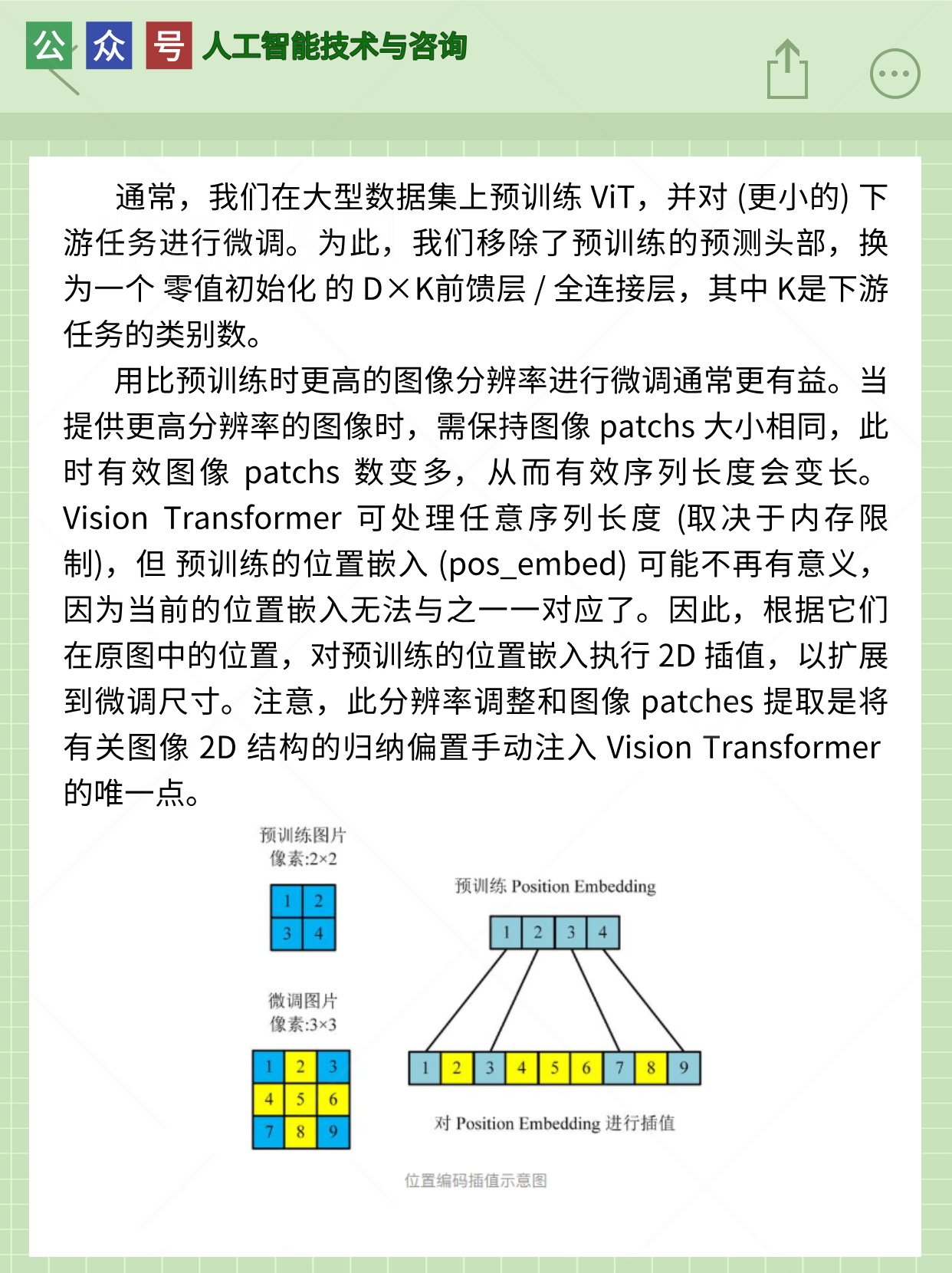

4.微调及更高分辨率

5.超参数

1.Transformer 编码器

2.ViT 张量维度变化举例

3.归纳偏置与混合架构

4.微调及更高分辨率

5.超参数

您可能感兴趣的与本文相关的镜像

TensorFlow-v2.9

TensorFlow 是由Google Brain 团队开发的开源机器学习框架,广泛应用于深度学习研究和生产环境。 它提供了一个灵活的平台,用于构建和训练各种机器学习模型

1178

1178

727

727

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?