本文是笔者另一篇blog的姐妹篇,另一篇的地址如下: https://blog.youkuaiyun.com/rav009/article/details/151403409?spm=1001.2014.3001.5501![]() https://blog.youkuaiyun.com/rav009/article/details/151403409?spm=1001.2014.3001.5501

https://blog.youkuaiyun.com/rav009/article/details/151403409?spm=1001.2014.3001.5501

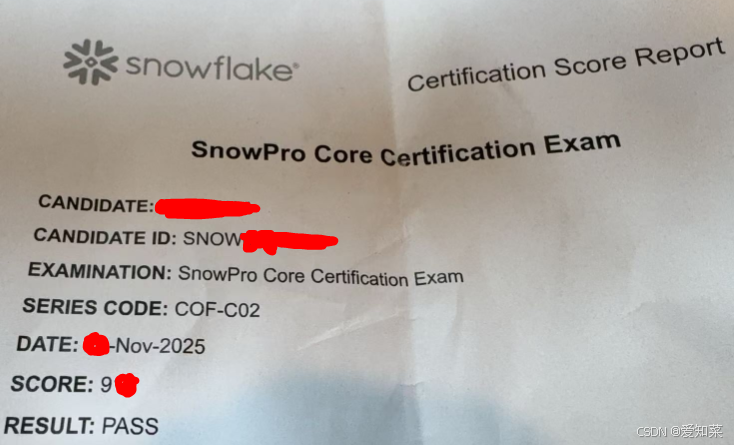

笔者在2025年11月底参加了SnowPro Core的考试,顺利通过,同时发现了一些新的考点,通过本文来记录,并共享给大家:

Snowflake Hybrid Tables

Snowflake Hybrid Tables are a new table type designed to unify transactional (OLTP) and analytical (OLAP) workloads in a single platform. They are part of Snowflake’s Unistore architecture, which aims to eliminate the traditional trade-off between fast transactions and deep analytics.

Snowflake 的 MFA

Snowflake 的 MFA 不支持邮件、电话或 SMS。目前官方支持的方式只有三类:Passkey(密钥)、TOTP 身份验证器应用(如 Google Authenticator)、以及 Duo Security

Snowflake 的 Resource Monitor

Snowflake 的 Resource Monitor 支持的重置周期(Frequency)包括:DAILY(每天)、WEEKLY(每周)、MONTHLY(每月)、YEARLY(每年)、NEVER(不重置)。

每月最常见。

DELETE

在 Snowflake 中,DELETE 操作属于 DML(数据操作语句),它需要 Virtual Warehouse 提供计算资源来执行,而不是仅靠 Cloud Services 层完成。

同名表时,临时表优先。

同名时,临时表优先于永久表。这是 Snowflake 的对象解析规则之一。

CHARACTER(n)

在 Snowsight 中,不管你定义的是 CHARACTER(n)、CHAR(n)、VARCHAR(n) 还是 STRING,UI 都会显示为 VARCHAR,只是长度限制会保留(比如 VARCHAR(25))。

REPEATABLE

要让 Snowflake 的 SAMPLE 可重复,必须在 TABLESAMPLE 后加上 REPEATABLE(seed)。这样在相同条件下,每次查询都会返回相同的样本。

Iceberg 表

Snowflake 的 Iceberg 表支持通过 Secure Data Sharing 功能进行共享。

移除列时微分区的行为

-

ALTER TABLE DROP COLUMN

-

当你移除一列时,Snowflake 并不会立即去重写或重新生成所有微分区的数据文件。

-

原因是 Snowflake 的存储是 不可变的微分区 (immutable micro-partitions),删除列只是对 元数据层 的修改。

-

-

实际效果

-

被删除的列在元数据中标记为不可见,不再出现在查询结果里。

-

微分区中的底层数据仍然存在,但对用户和查询不可见。

-

这也是为什么

DROP COLUMN操作不需要 Virtual Warehouse,只靠 Cloud Services 层就能完成。

-

-

不会触发全表重写

-

Snowflake 避免了昂贵的全表数据重写。

-

只有在涉及 DML(如

DELETE、UPDATE)时才需要重新生成新的微分区。 -

DDL(如

DROP COLUMN)只更新元数据,不会重写数据。

-

382

382

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?