传统轻量级视觉模型(如基于卷积或自注意力的网络)在 “感知” 和 “聚合” 过程中存在效率与效果的矛盾:

自注意力机制:通过全局特征交互实现感知,但会引入冗余注意力(如对无关背景的过度关注),且感知与聚合范围相同,扩大上下文需付出高计算成本。

传统卷积:依赖固定内核权重建模 token 间关系,缺乏对动态上下文的适应性,感知范围受限于小内核尺寸。

人类视觉系统的启发

人类视网膜的感光细胞(视杆细胞和视锥细胞)分工明确:

视杆细胞:分布于视网膜外围,负责大视野低分辨率感知(“See Large”),捕捉整体场景信息。

视锥细胞:集中于中央凹,负责小范围高分辨率聚合(“Focus Small”),提取精细细节。

这种 “大视野感知 + 小焦点聚合” 的机制使人类视觉系统能高效处理复杂视觉信息。

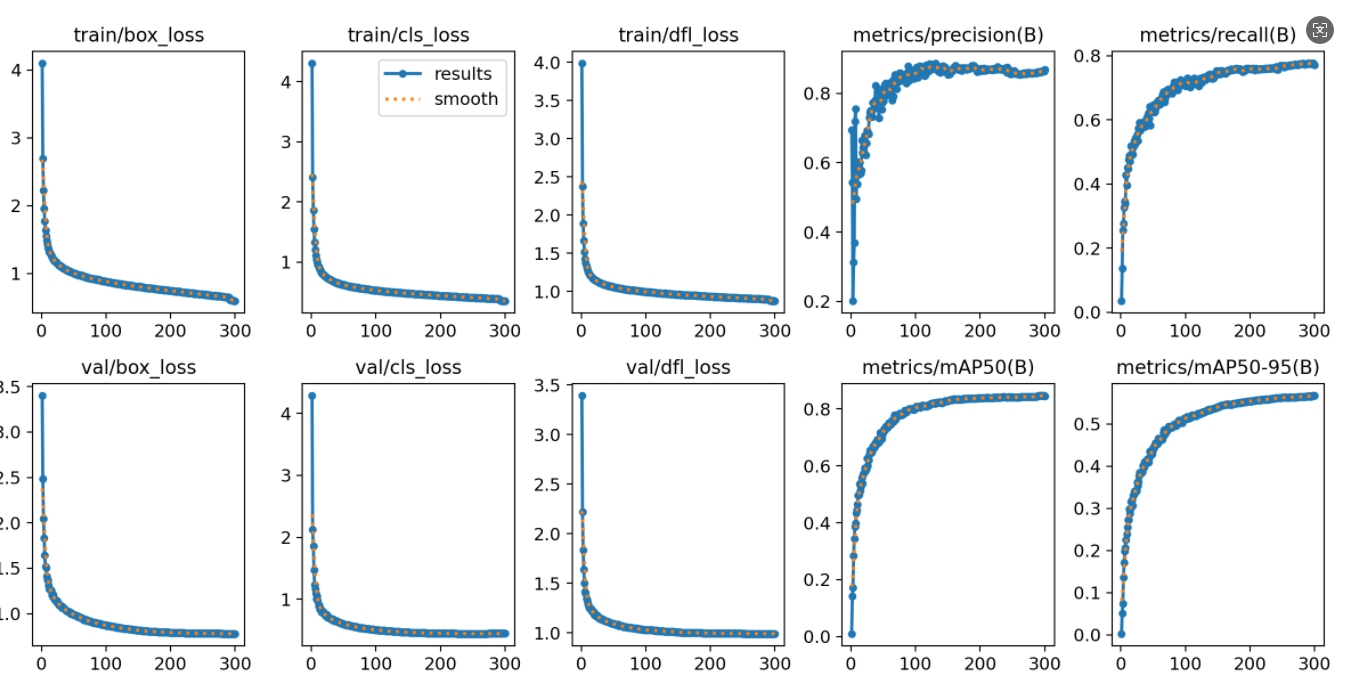

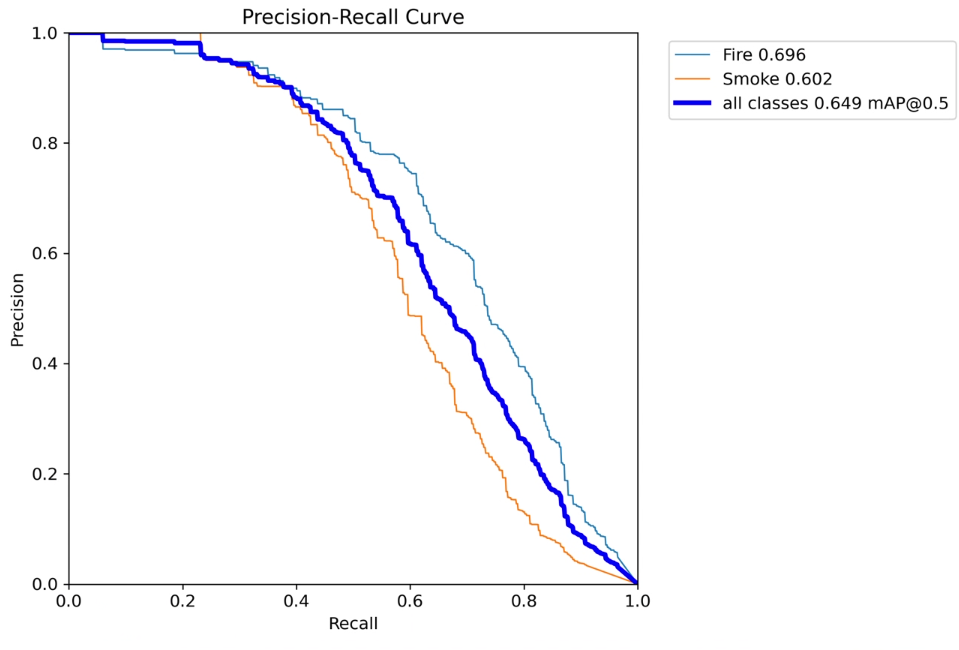

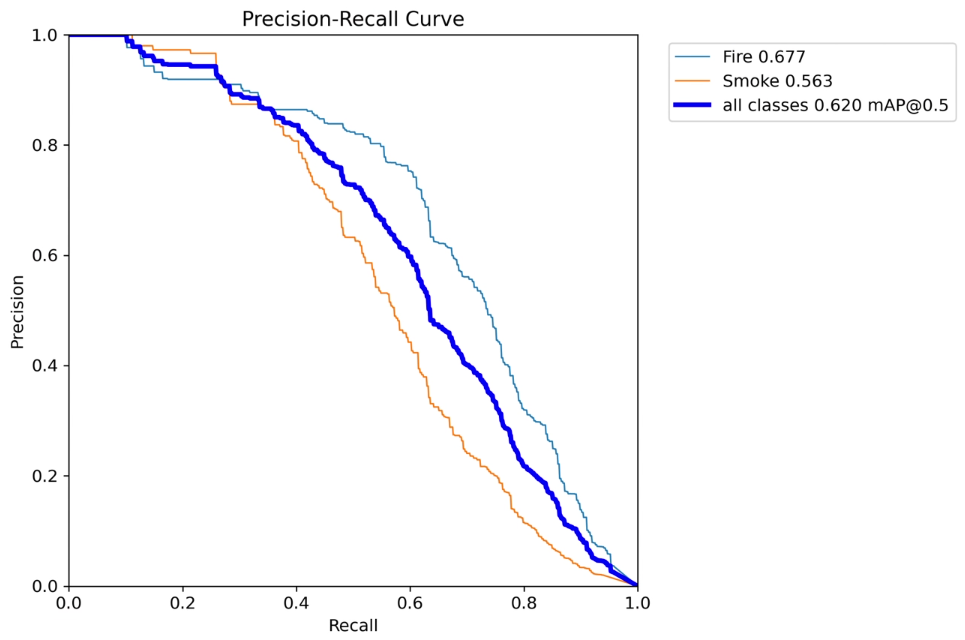

上面是原模型,下面是改进模型

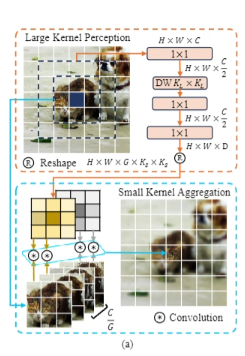

1. LS convolution介绍

LS convolution 的核心理论是异尺度上下文建模,即通过分离感知和聚合的范围与方式,实现高效的特征提取:

感知(Perception)与聚合(Aggregation)的解耦:感知阶段:采用大内核卷积(如 7×7)扩大感受野,捕捉全局上下文关系,类似人类外围视觉的大视野感知。聚合阶段:利用小内核动态卷积(如 3×3)在高相关区域进行自适应特征融合,类似中央凹的精细聚焦。

动态权重生成

大内核感知的输出用于生成小内核聚合的动态权重,使聚合过程能根据输入内容调整,增强模型对复杂场景的适应性。

计算效率优化

通过深度可分离卷积(Depth-wise Convolution)和分组机制(Group Mechanism)降低计算复杂度,确保轻量级设计。

2. YOLOv11与LS convolution的结合

LS 卷积与 YOLO11 结合时,大核分支可捕捉图像全局语义信息(如目标与场景关系),小核分支聚焦目标局部细节(如纹理、边缘),通过动态权重融合增强多尺度特征表达,提升复杂场景下小目标、重叠目标的检测精度;

3. LS convolution代码部分

视频讲解:

YOLOv8_improve/YOLOv11.md at master · tgf123/YOLOv8_improve · GitHub

YOLO11改进-Mamba篇 如何使用Manba发一篇三四区论文_哔哩哔哩_bilibili

YOLOv11模型改进讲解,教您如何修改YOLOv11_哔哩哔哩_bilibili

4. LS convolution引入到YOLOv11中

第一: 将下面的核心代码复制到D:\model\yolov11\ultralytics\change_model路径下,如下图所示。

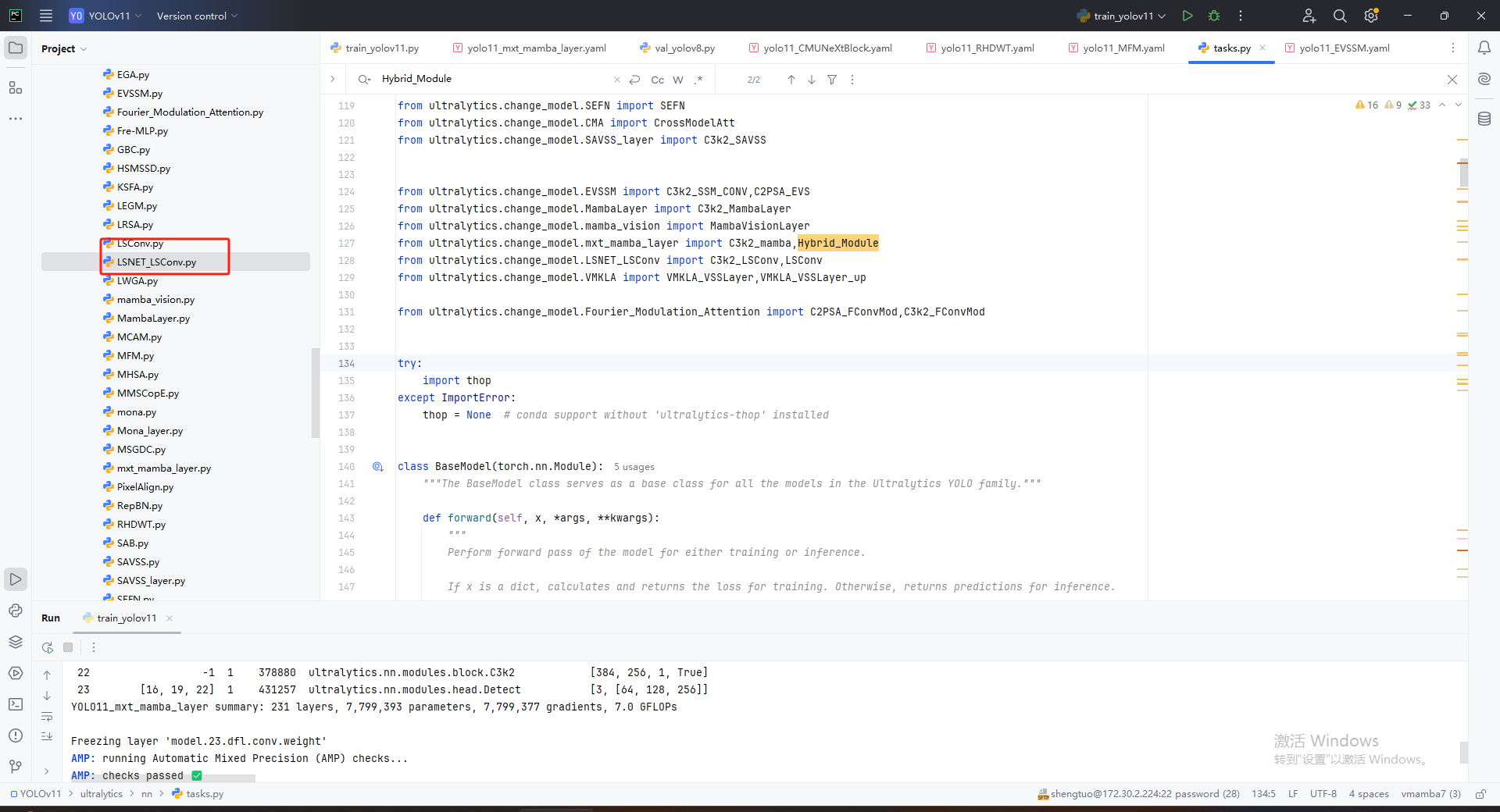

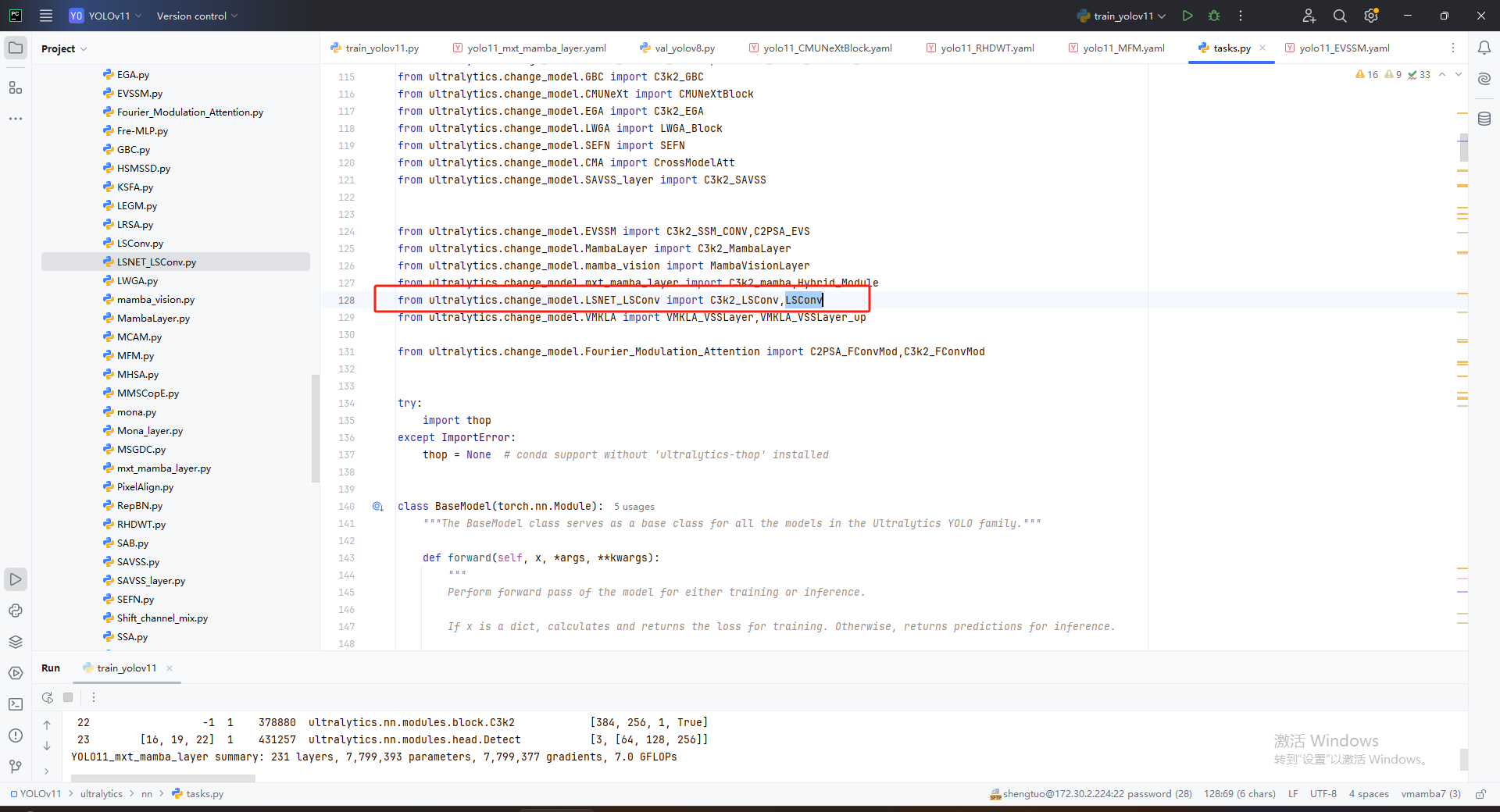

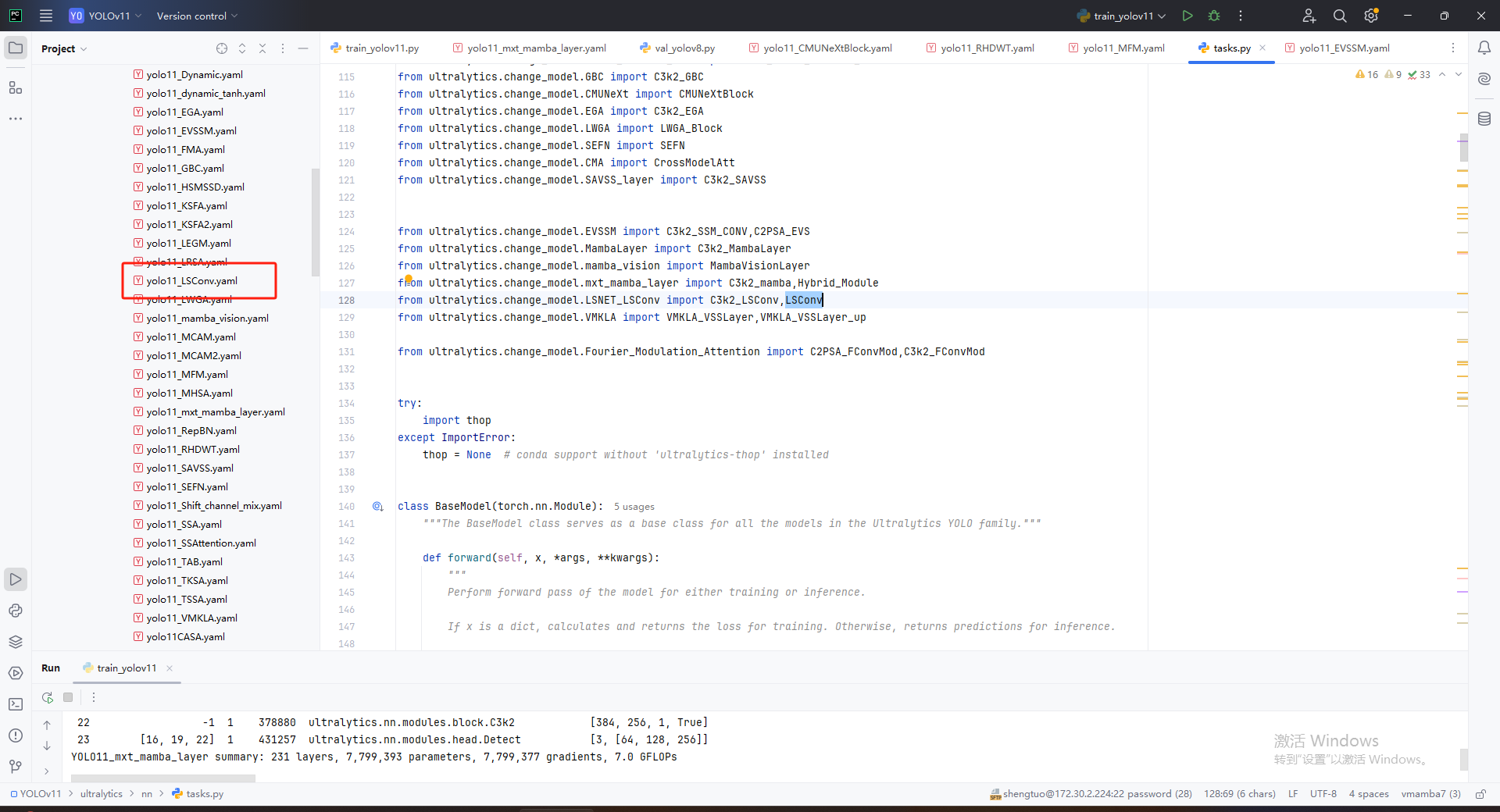

第二:在task.py中导入包

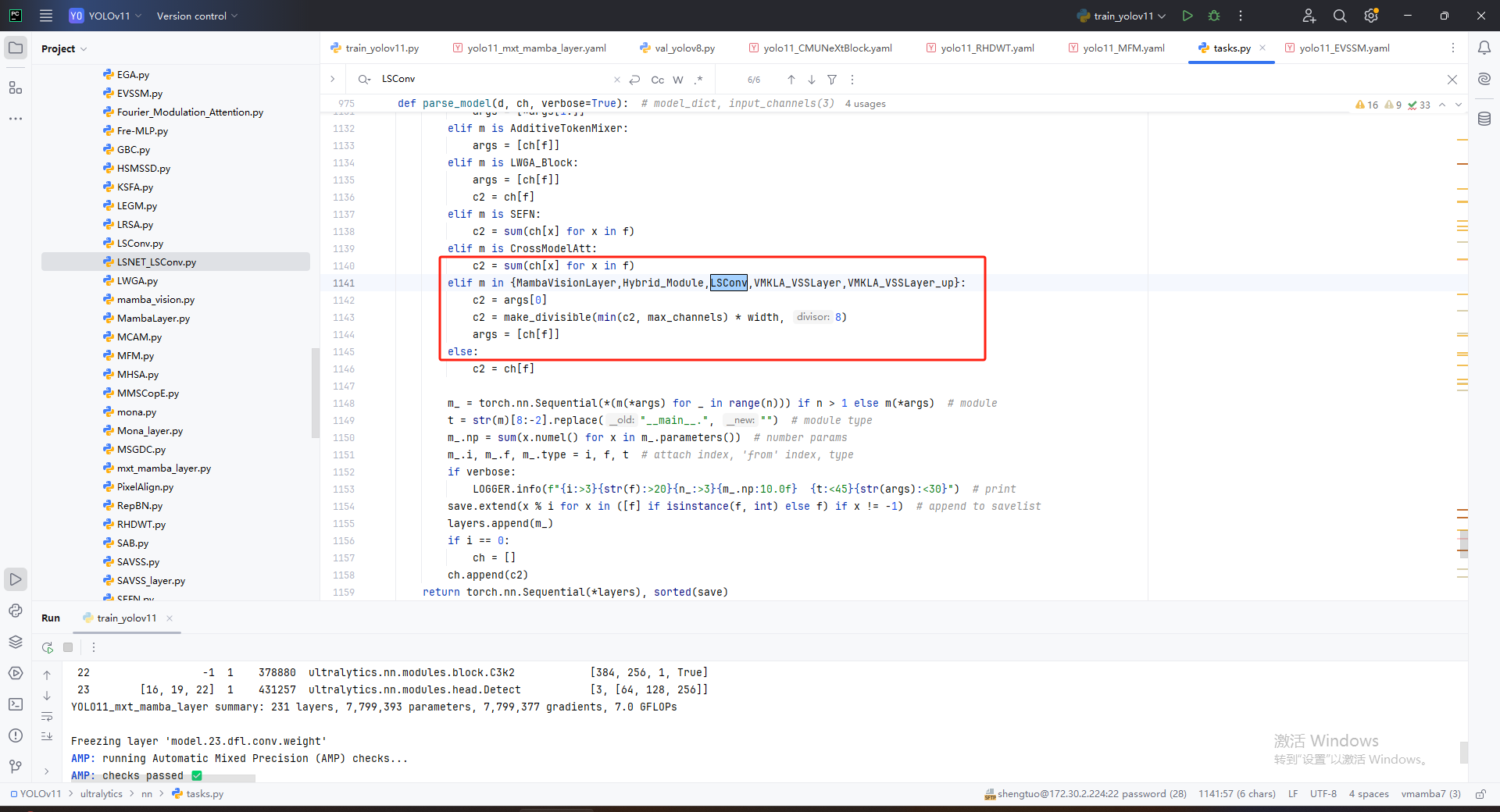

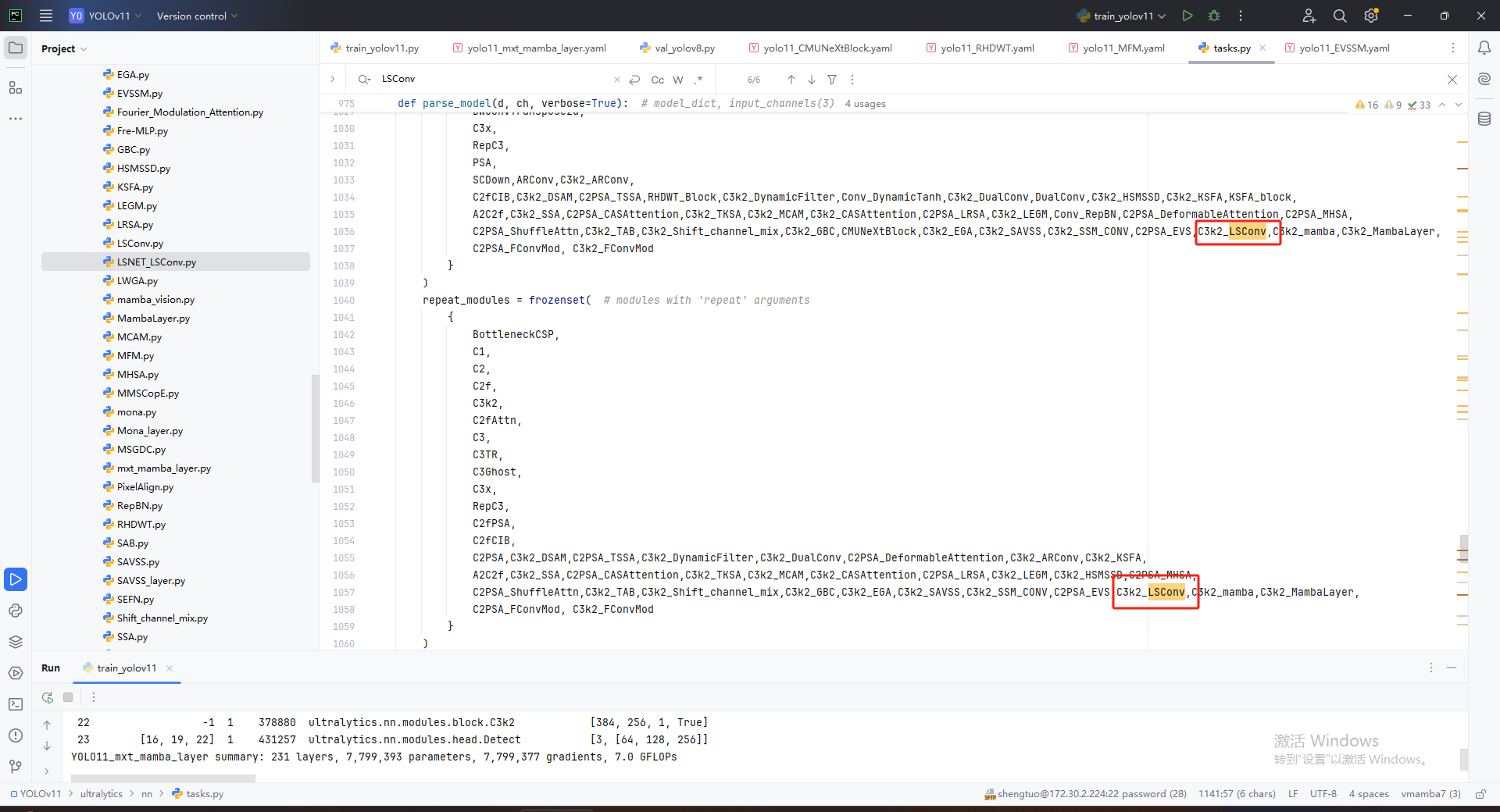

第三:在YOLOv11\ultralytics\nn\tasks.py中的模型配置部分下面代码

第四:将模型配置文件复制到YOLOV11.YAMY文件中

第五:运行成功

from sympy import false

from ultralytics.models import NAS, RTDETR, SAM, YOLO, FastSAM, YOLOWorld

if __name__=="__main__":

# 使用自己的YOLOv8.yamy文件搭建模型并加载预训练权重训练模型

model = YOLO(r"E:\Part_time_job_orders\YOLO\YOLOv11\ultralytics\cfg\models\11\yolo11_LSConv.yamy")\

.load(r'E:\Part_time_job_orders\YOLO\YOLOv11\yolo11n.pt') # build from YAML and transfer weights

results = model.train(data=r'E:\Part_time_job_orders\YOLO\YOLOv11\ultralytics\cfg\datasets\VOC_my.yaml',

epochs=300,

imgsz=640,

batch=64,

# cache = False,

# single_cls = False, # 是否是单类别检测

# workers = 0,

# resume=r'D:/model/yolov8/runs/detect/train/weights/last.pt',

amp = True

)

7203

7203

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?