目录

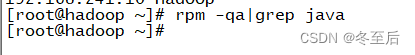

1.查看Linux是否安装了java jdk,如果查询有其他的java版本,则需要删除

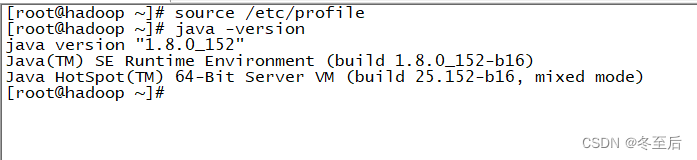

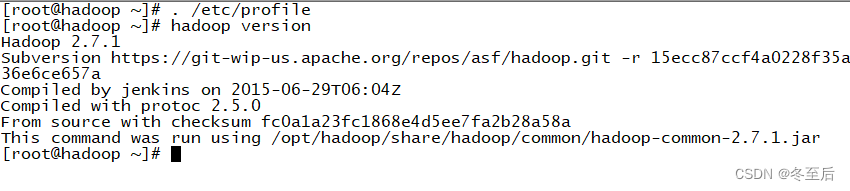

4.配置文件生效 source /etc/profile---也可以写成 . /etc/profile

4.启动集群:spark下sbin目录下:./start-all.sh编辑

6.查看spark是否安装成功 返回主目录下输入spark-submit --version

1.scala的配置文件,直接写在/etc/profile下

2.source /etc/profile使环境变量生效,接着scala -version查看是否安装成功,出现画线版本号即为成功(或者直接输入scala)编辑

以下是要准备的包:

1.java的包--jdk

![]()

2.hadoop的包

![]()

spark和scala是基于Hadoop环境部署安装的

3.scala包:

https://www.scala-lang.org/download/all.html

注意:这里spark与scala的包最好都统一版本,还有下以.tgz结尾的包

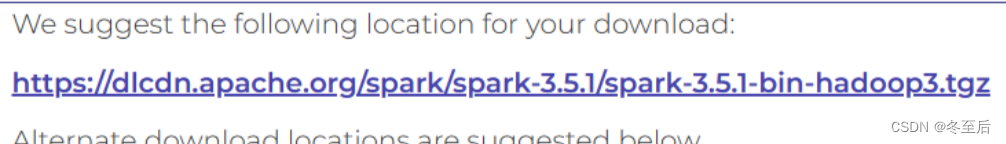

4.spark包:

Index of /spark/spark-3.5.1 (apache.org)

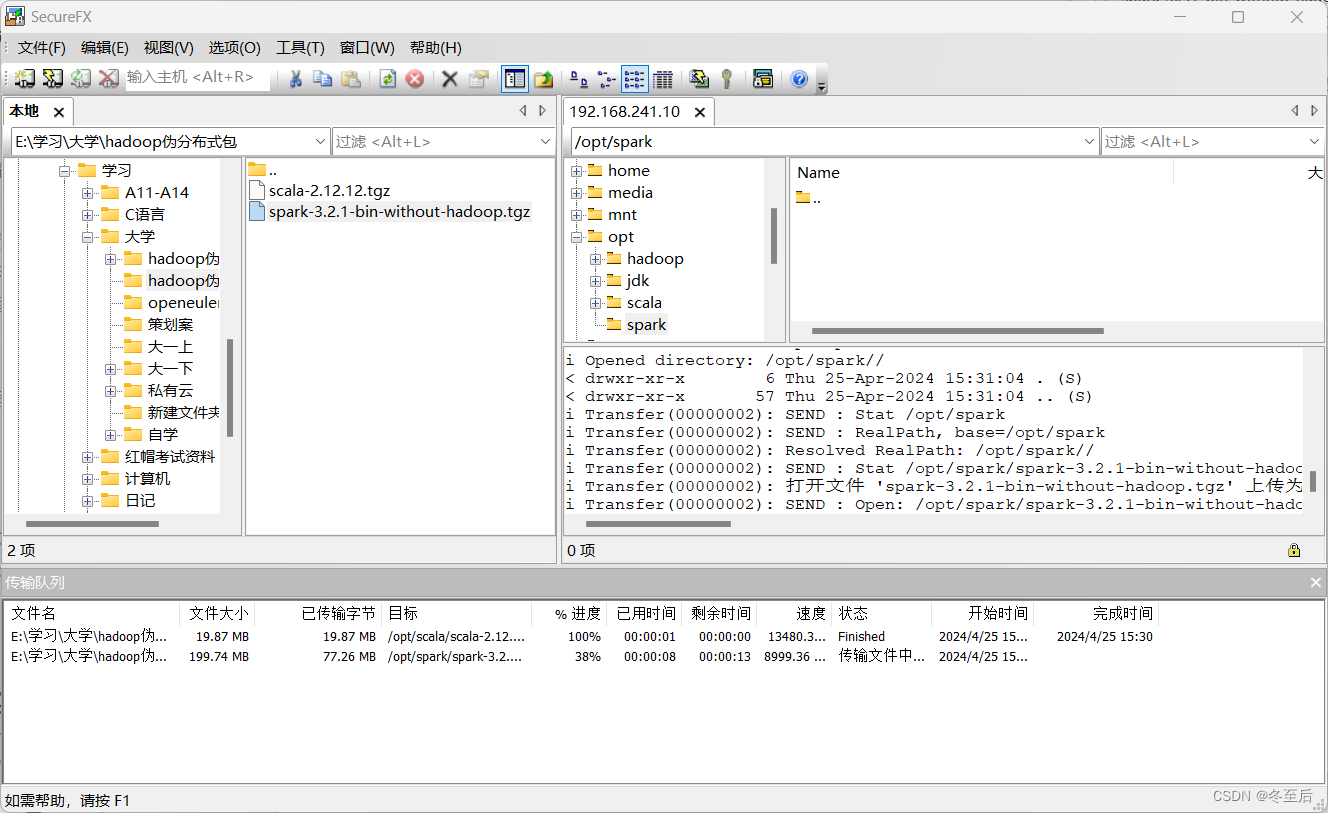

上传到linux上(记住位置)

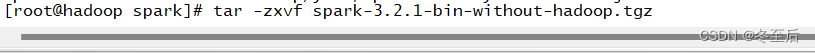

首先解压spark

之后在解压scala,与spark的解压同理

hadoop与java也是一样的解压方式

我的文件位置,以下的操作皆为我的文件位置来写

把以上的压缩包都准备好,接下来开始搭建hadoop+spark+scala伪分布式集群

基础环境

注意:在搭建Hadoop的时候需要关闭防火墙与安全上下文(这里默认以及配好ip)

1.修改主机名

hostnamectl set-hostname hadoop[修改的主机名]

bash //启动

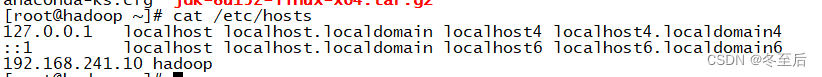

2.网络映射

vi /etc/hosts

java环境配置

1.查看Linux是否安装了java jdk,如果查询有其他的java版本,则需要删除

删除命令:rpm -e --nodeps [java名]

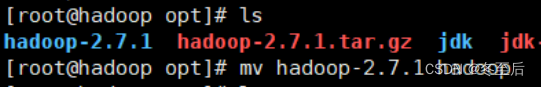

2.解压,压缩包与重命名

重命名: mv [原文件] [新文件]

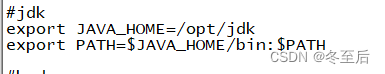

3.修改java环境变量

在最后三行写:vi /etc/profile

export JAVA_HOME=/opt/jdk

export PATH=$JAVA_HOME/bin:$PATH

4.配置文件生效 source /etc/profile---也可以写成 . /etc/profile

hadoop的环境配置

1.解压hadoop

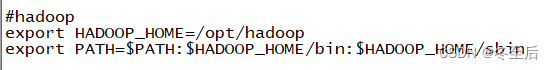

2.修改配置文件vi /etc/profile

在最后三行写!! 以下所有的配置文件都是在最后写

#hadoop

export HADOOP_HOME=/opt/hadoop

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

3.配置文件生效,查看hadoop的版本

hadoop集群伪分布式

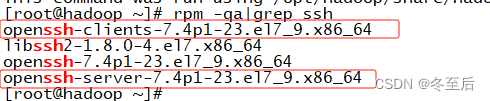

一、查看是否安装了ssh

主要的圈了起来:

如果没有的话需要安装:

yum install -y openssh-clients openssh-server

2.启动ssh服务

systemctl restart sshd

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1295

1295

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?