目录

一、安装es

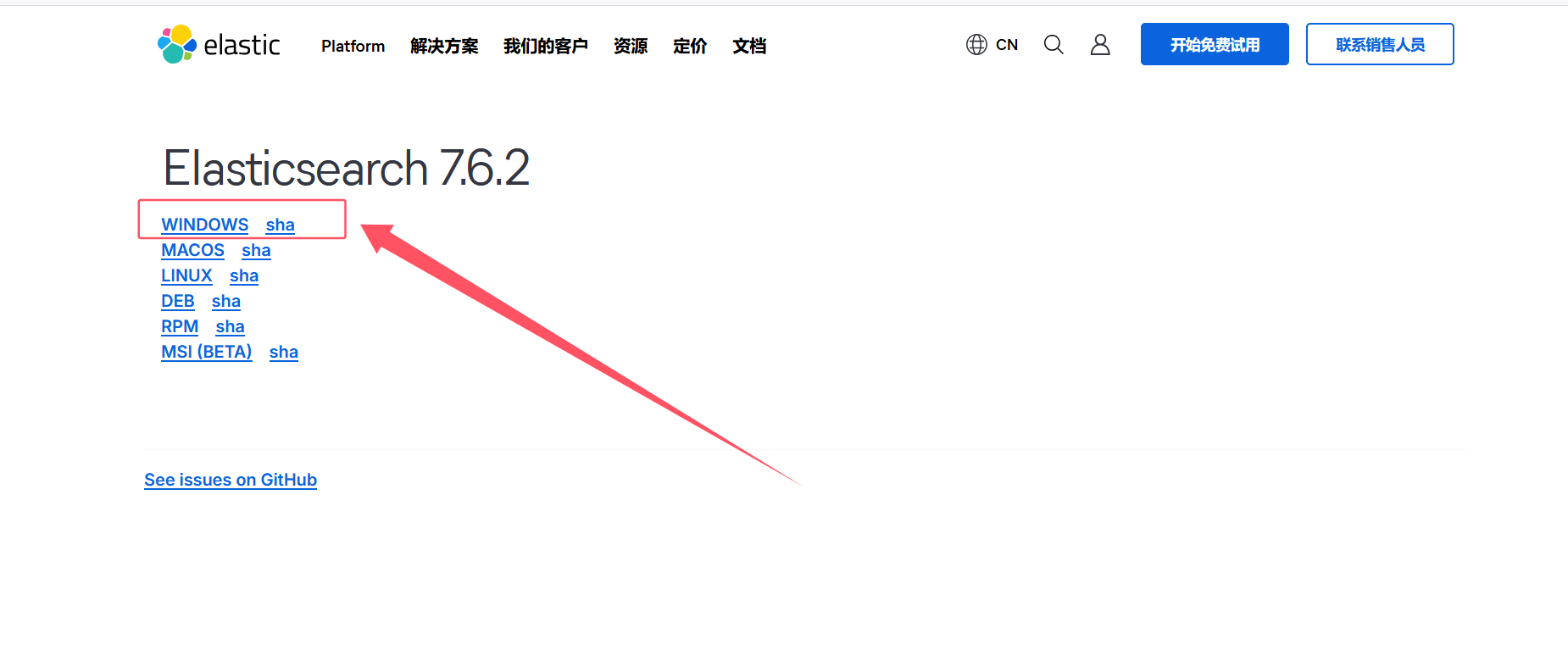

1.下载es

方式一:

链接:https://pan.baidu.com/s/1P3I6ksFPAcP4DMHbAwgMTQ

提取码:pe3u

方式二:

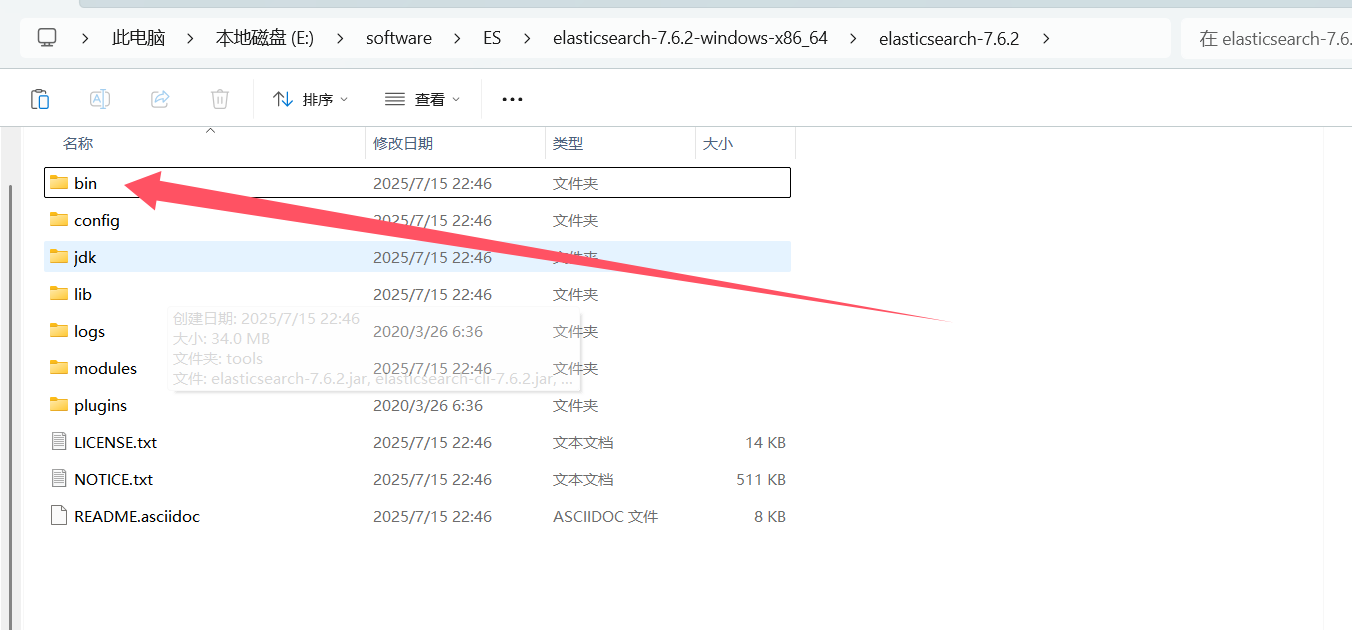

2.解压

3.进入bin目录

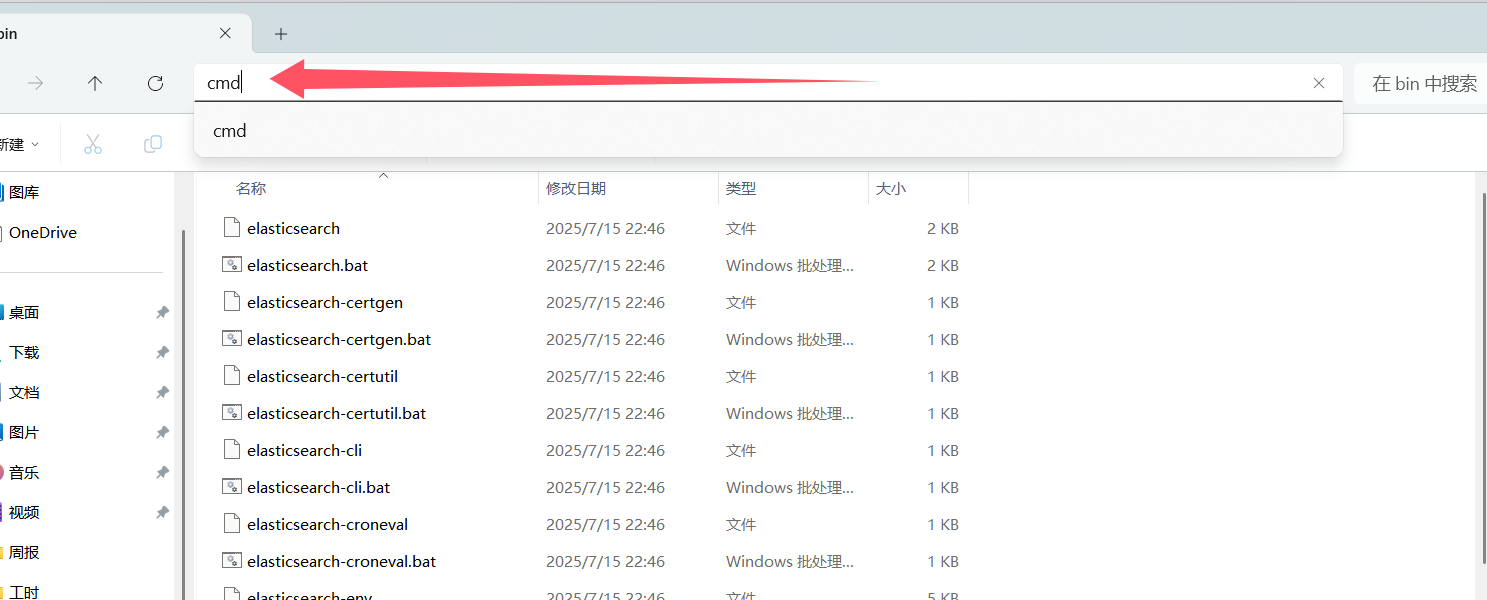

4.进入命令行

5.下载中文分词器

elasticsearch-plugin install https://github.com/medcl/elasticsearch-analysis-ik/releases/download/v7.6.2/elasticsearch-analysis-ik-7.6.2.zip

6.启动

执行bin目录下的elasticsearch.bat

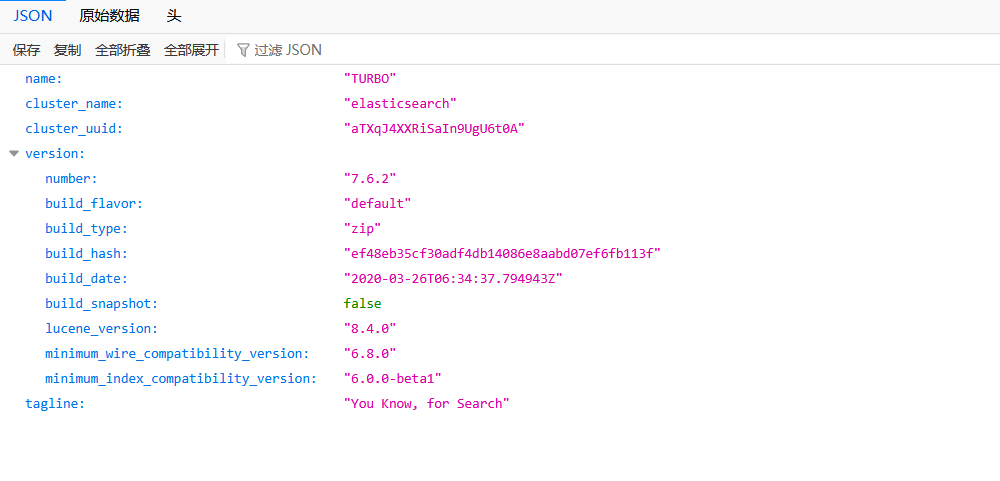

7.访问

http://localhost:9200/

二、安装kibana

1.下载kibana

链接:https://pan.baidu.com/s/1KHWnVMvoMOOwX7olodadXA

提取码:vnxz

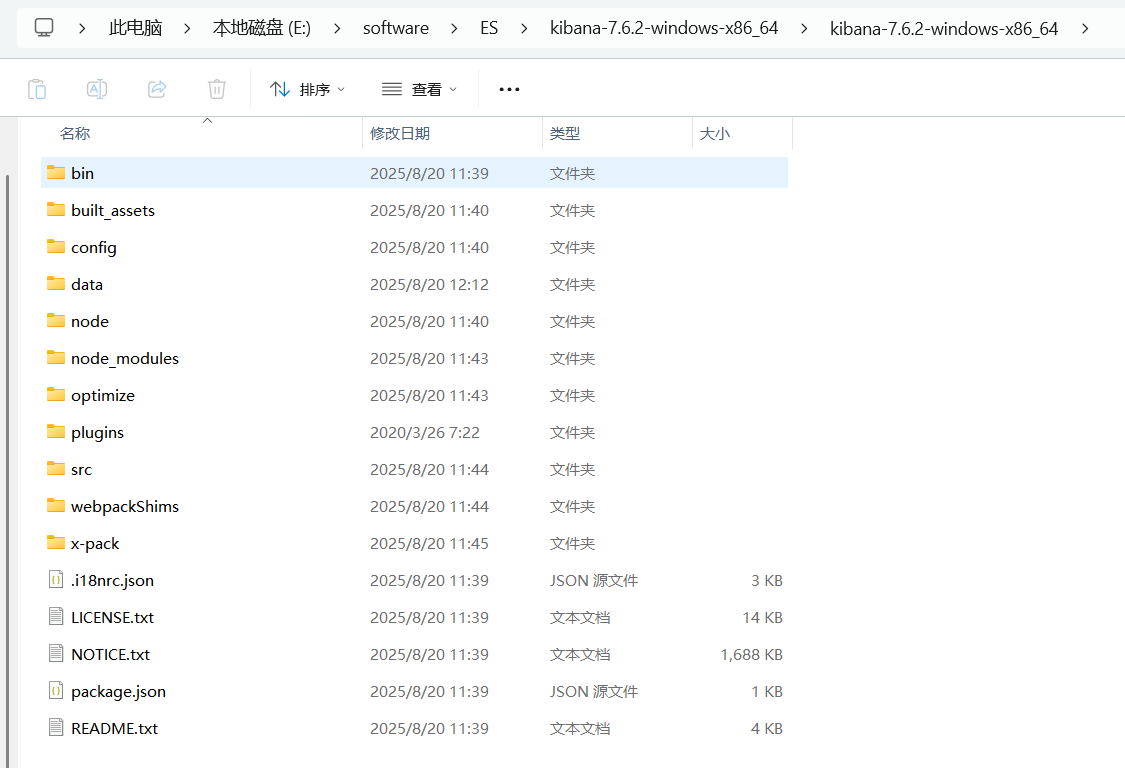

2.解压

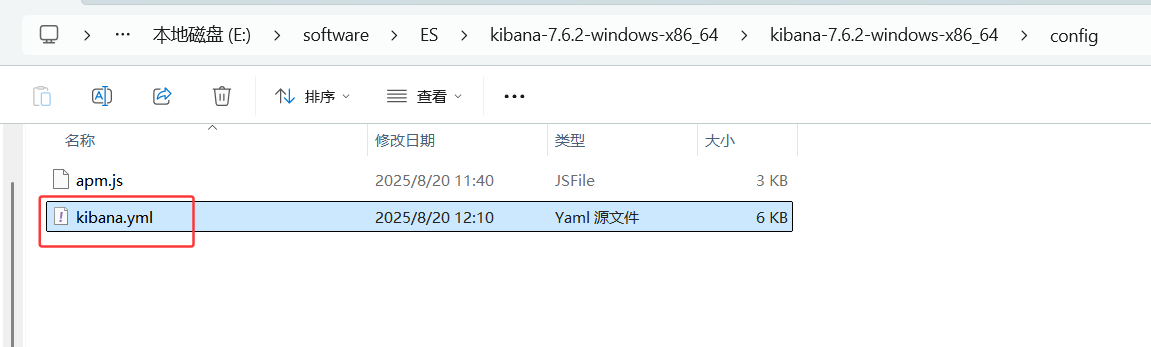

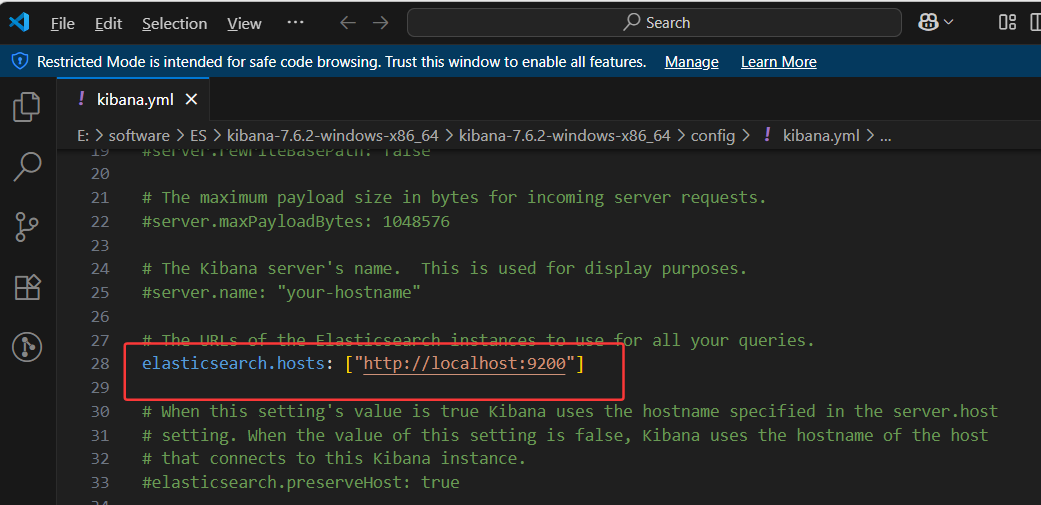

3.编辑kabana.yml配置文件

ES启动好后把这行注释放开

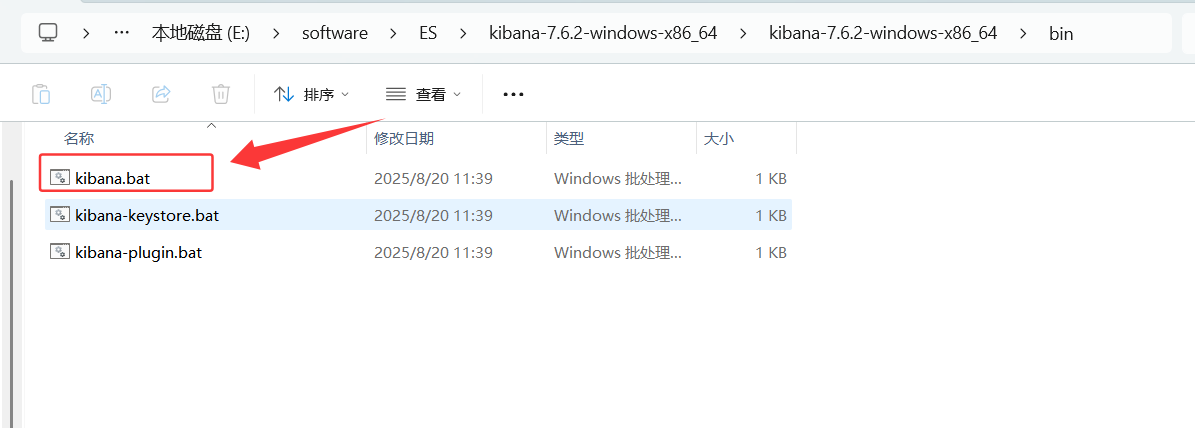

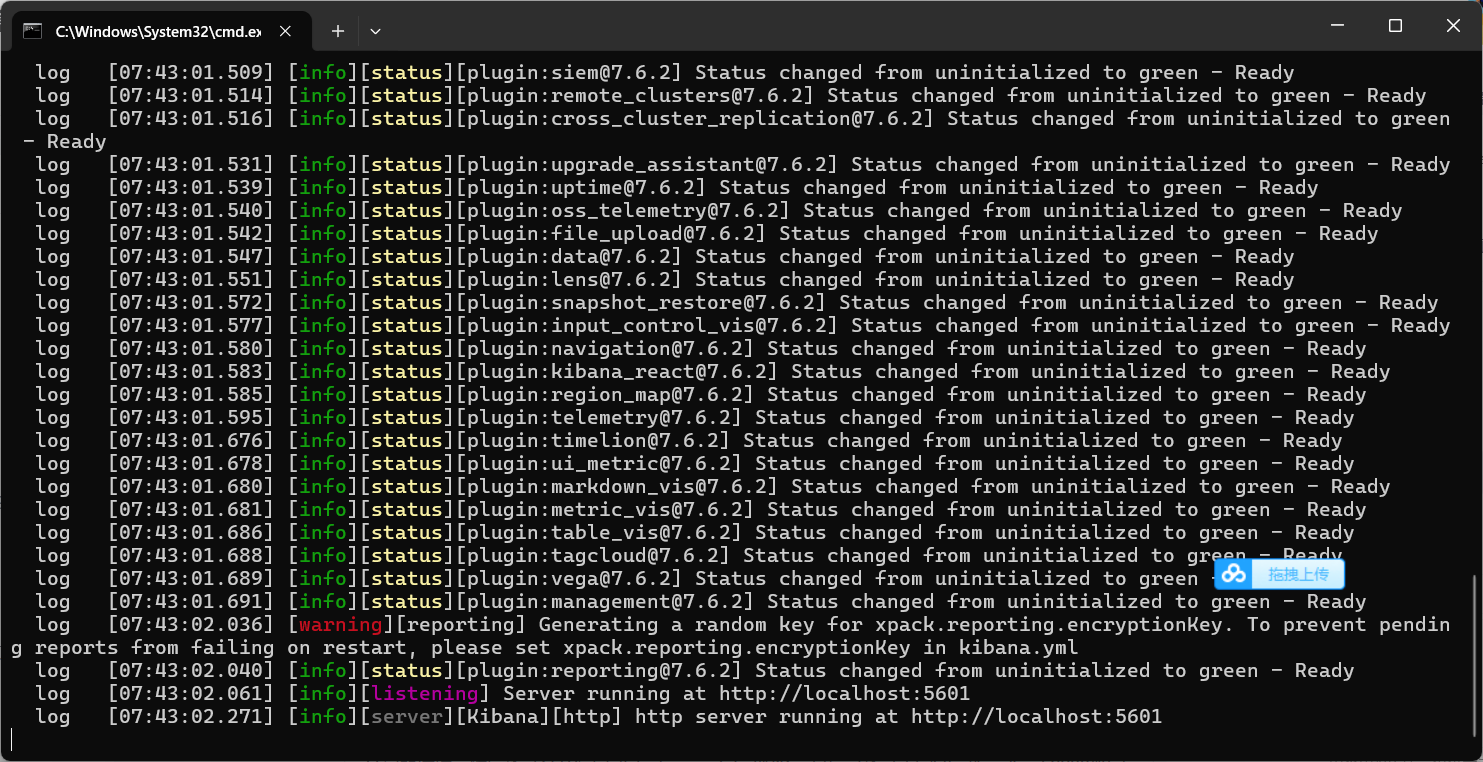

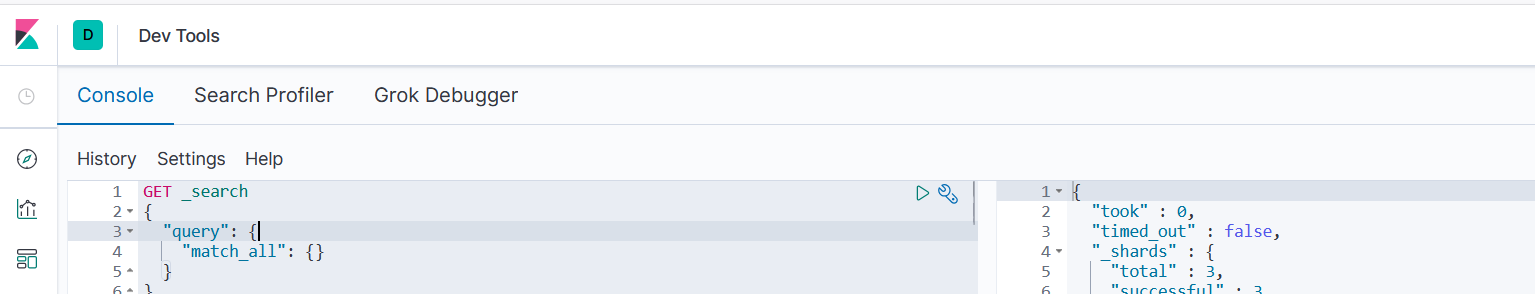

4.启动kibana

效果

访问浏览器 http://localhost:5601

安装完成,可以对ES进行操作了

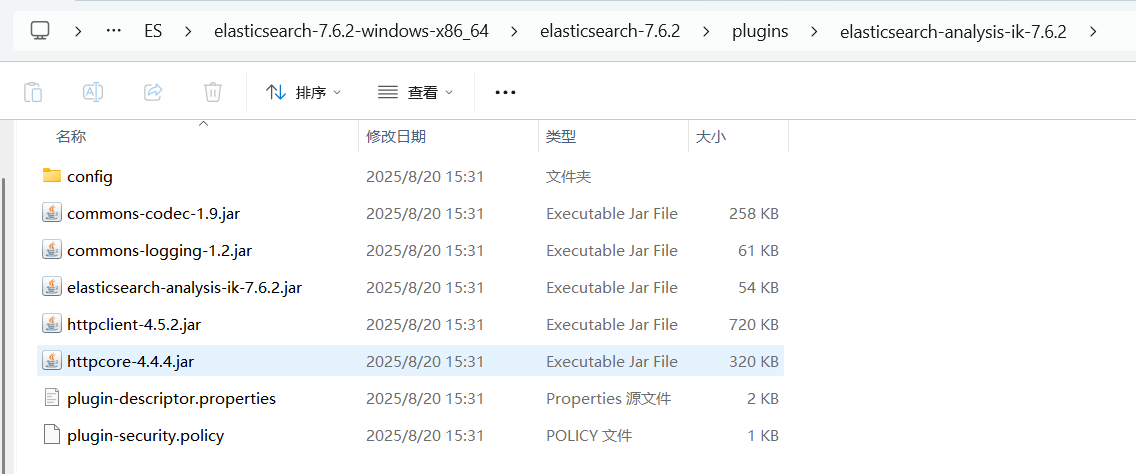

三、安装ik分词器

1.下载ik分词器

链接:https://pan.baidu.com/s/1hYBJtpUjZmfeZTgZ9cax2Q

提取码:6upk

2.解压到ES plugins文件夹下

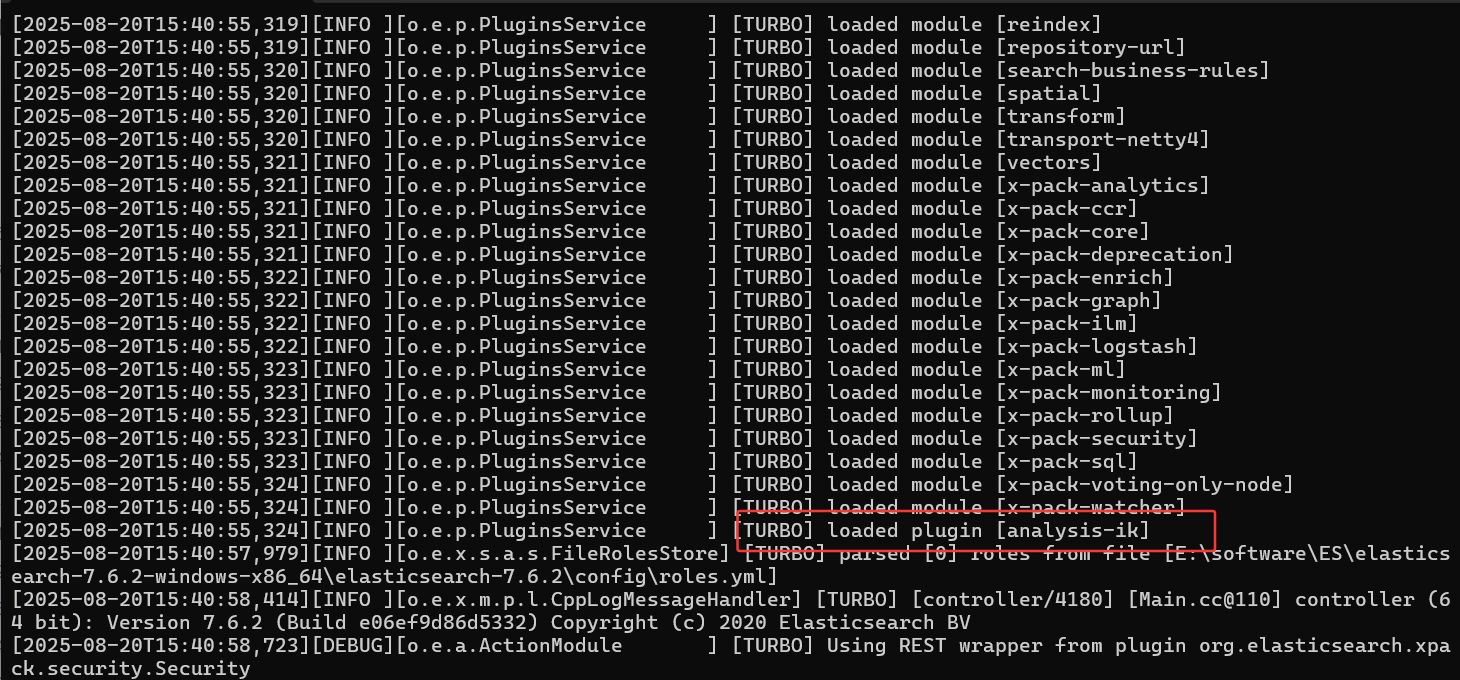

3.重启ES

4.使用Kibana进行测试验证

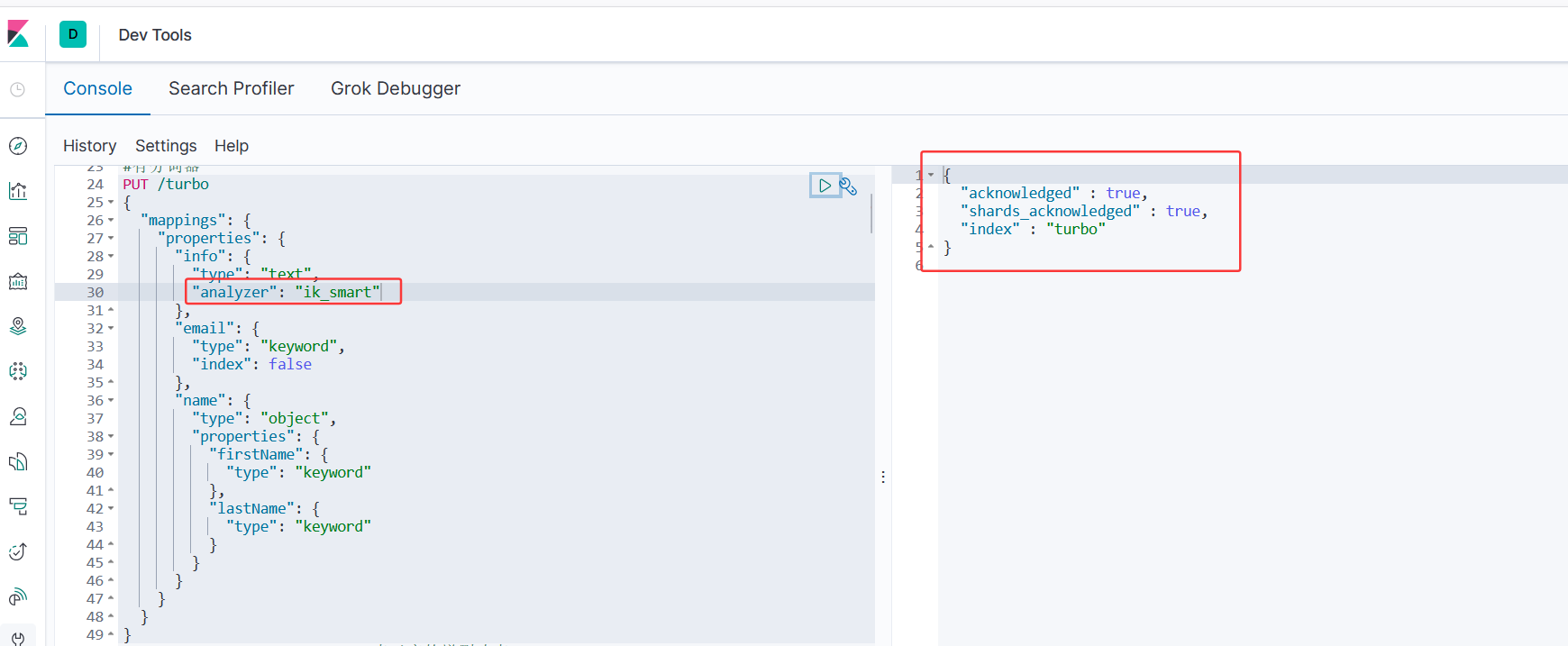

PUT /turbo

{

"mappings": {

"properties": {

"info": {

"type": "text",

"analyzer": "ik_smart"

},

"email": {

"type": "keyword",

"index": false

},

"name": {

"type": "object",

"properties": {

"firstName": {

"type": "keyword"

},

"lastName": {

"type": "keyword"

}

}

}

}

}

}

创建分词索引库成功

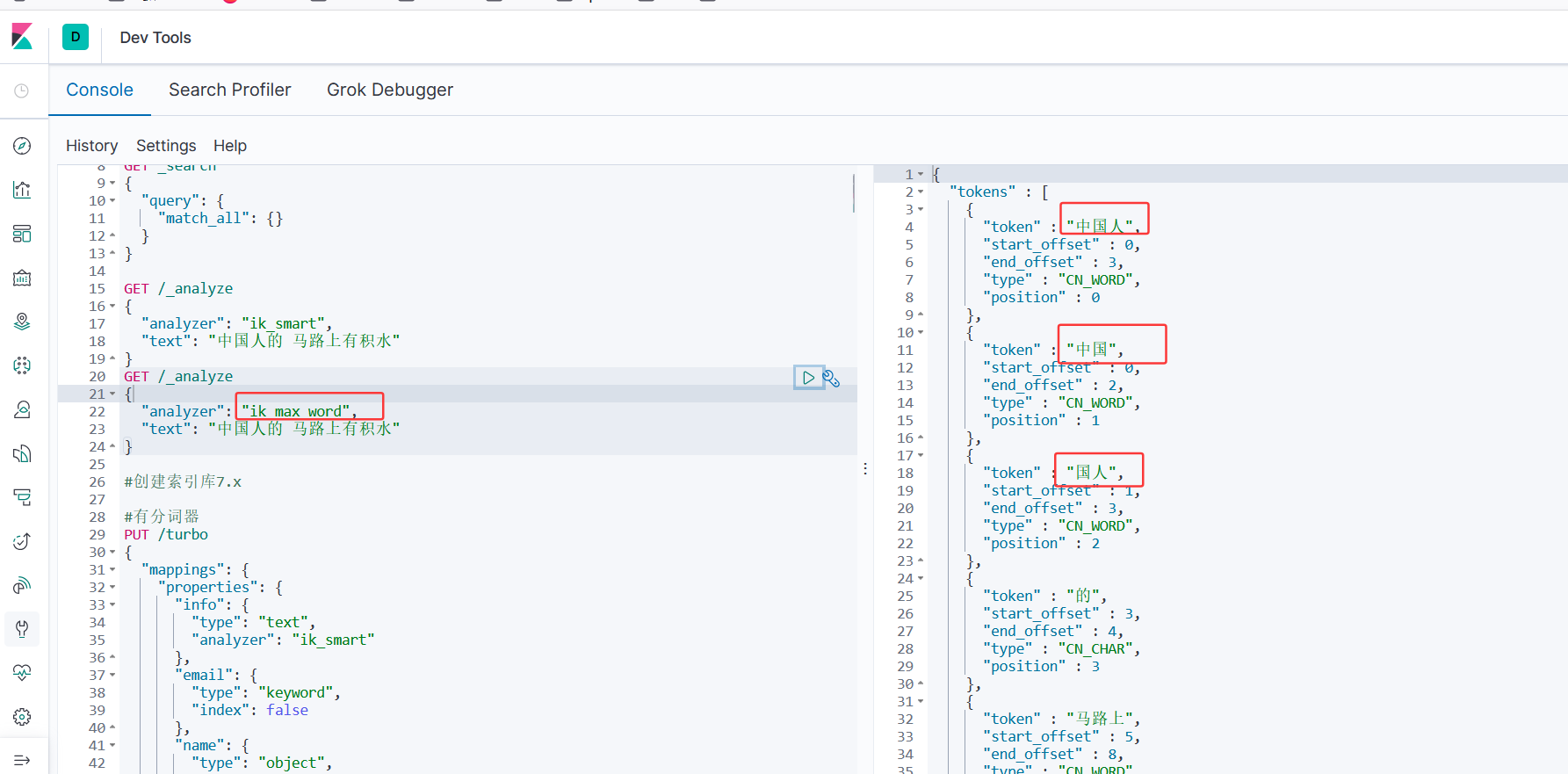

5.分词测试

GET /_analyze

{

"analyzer": "ik_smart",

"text": "中国人的 马路上有积水"

}

GET /_analyze

{

"analyzer": "ik_max_word",

"text": "中国人的 马路上有积水"

}

测试 ik_smart

ik最简分词器

ik_smart会将一句话拆分成几个词语

测试ik_max_word

ik_max_word最细粒度的划分词,它除了将当前词分出来,还将这个句子中可能组合的词语都列出来,穷尽词库的可能

2524

2524

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?