<think>问题分析:用户观察到日志显示从缓存加载的数据只有41条,而预期应该是730天(约365*2=730条)的数据。这通常意味着缓存中只有部分数据,可能的原因包括:

1. 原始数据文件本身只有41条记录(可能数据文件不完整)

2. 缓存过程中出现了问题(如只缓存了部分数据)

3. 日期范围计算错误

4. 数据过滤条件过于严格,导致很多数据被排除

解决方案:

我们需要检查以下几个方面:

a) 检查原始数据文件是否包含足够的数据(至少730天)

b) 检查缓存逻辑是否正确,特别是保存和查询缓存的部分

c) 检查日期范围计算是否正确

d) 检查数据过滤条件(如是否因为周末或节假日导致数据量不足)

由于用户提供的代码较长,我们重点检查与缓存和日期处理相关的部分。

步骤1:检查缓存查询逻辑

在`get_cached_data`方法中,我们查询指定日期范围内的数据。这里需要确保日期范围正确,并且SQL查询正确。

步骤2:检查缓存保存逻辑

在`save_to_cache`方法中,我们保存数据到数据库。需要确保保存了所有需要的数据。

步骤3:检查数据加载流程

在`load_from_local_csv`方法中,我们读取CSV文件并保存到缓存。需要确保读取的数据完整,并且日期范围正确。

步骤4:检查数据文件本身

需要确认数据文件(对应股票562900.SS)是否包含足够的数据。

考虑到用户已经提供了完整的代码,我们可以添加一些调试信息来帮助诊断问题。

修改建议:

1. 在`load_from_local_csv`方法中,读取CSV文件后,打印文件中的日期范围和数据条数。

2. 在保存到缓存之前,检查DataFrame的日期范围。

3. 在缓存查询后,如果返回的数据量不足,尝试从原始文件加载并打印原始文件的数据量。

具体修改如下:

在`load_from_local_csv`方法中,读取CSV文件并处理后,添加调试信息:

```python

# 在load_from_local_csv方法中,过滤日期范围之前,添加以下调试信息

if self.debug_mode:

min_date_in_file = df['date'].min().strftime('%Y-%m-%d')

max_date_in_file = df['date'].max().strftime('%Y-%m-%d')

print(f"文件 {file_path} 原始数据: {min_date_in_file} 至 {max_date_in_file}, 共 {len(df)} 条")

# ... 然后进行日期过滤 ...

if self.debug_mode:

min_date_filtered = filtered_df.index.min().strftime('%Y-%m-%d')

max_date_filtered = filtered_df.index.max().strftime('%Y-%m-%d')

print(f"过滤后数据: {min_date_filtered} 至 {max_date_filtered}, 共 {len(filtered_df)} 条")

```

另外,在`get_historical_data`方法中,当从缓存获取数据后,如果数据量不足,可以打印一条警告:

```python

cached_df = self.get_cached_data(stock_code, start_date, end_date)

if cached_df is not None:

if len(cached_df) < days * 0.8: # 假设我们期望至少有80%的数据

if self.debug_mode:

print(f"警告: 缓存数据量不足,期望约{days}条,实际{len(cached_df)}条")

return cached_df

```

但是,请注意,股票数据通常不包括周末和节假日,所以实际数据量会少于365*2(大约只有240个交易日左右)。因此,41条数据仍然偏少(可能只有2个月的数据)。

因此,我们需要确认:

- 实际需要的交易日数量(约480天,因为一年大约240个交易日,两年约480个交易日)

- 而41条数据明显不足,所以问题可能出在数据源或数据加载过程。

另一种可能:用户指定的日期范围是2021-07-18至2023-07-18,但数据文件可能只包含最近几个月的数据。

因此,我们首先需要确认数据文件是否包含足够的历史数据。

修改后的调试信息将帮助我们确定问题所在。

由于用户要求完整代码,我们将在原代码基础上添加上述调试信息,并重新运行。

但是,由于代码较长,这里不重复提供完整代码,而是给出关键修改点。

另外,考虑到用户可能不想修改代码,也可以手动检查数据文件:

1. 找到股票562900.SS对应的数据文件

2. 打开文件,检查数据行数和日期范围

如果文件本身数据不足,则需要补充历史数据。

如果文件数据足够,但程序加载后变少,则可能是数据加载过程中的问题(如日期解析错误、过滤条件错误等)。

我们将在代码中添加详细的调试信息,帮助定位问题。

修改后的`load_from_local_csv`方法部分代码:

```python

def load_from_local_csv(self, stock_code, start_date, end_date):

"""从本地CSV文件加载数据"""

# ... 前面的代码不变 ...

try:

# 检测文件编码

encoding = self.detect_file_encoding(file_path)

if self.debug_mode:

print(f"读取 {stock_code} 数据文件: {file_path} (编码: {encoding})")

# 读取CSV文件

df = pd.read_csv(file_path, encoding=encoding)

# ... 重命名列等操作 ...

# 确保日期列存在

if 'date' not in df.columns and len(df.columns) > 0:

# 尝试将第一列作为日期列

df.rename(columns={df.columns[0]: 'date'}, inplace=True)

# 确保日期格式正确

if 'date' in df.columns:

# 尝试多种日期格式

df['date'] = pd.to_datetime(df['date'], errors='coerce', format='%Y-%m-%d')

if df['date'].isnull().any():

df['date'] = pd.to_datetime(df['date'], errors='coerce', format='%Y/%m/%d')

# 删除无效日期

df = df.dropna(subset=['date'])

else:

raise ValueError("未找到日期列")

# 调试:打印文件中的原始日期范围

if self.debug_mode:

min_date_in_file = df['date'].min().strftime('%Y-%m-%d')

max_date_in_file = df['date'].max().strftime('%Y-%m-%d')

print(f"文件 {file_path} 原始数据: {min_date_in_file} 至 {max_date_in_file}, 共 {len(df)} 条")

# 过滤日期范围

mask = (df['date'] >= start_date) & (df['date'] <= end_date)

filtered_df = df.loc[mask].copy()

# 调试:打印过滤后的日期范围

if self.debug_mode:

if not filtered_df.empty:

min_date_filtered = filtered_df['date'].min().strftime('%Y-%m-%d')

max_date_filtered = filtered_df['date'].max().strftime('%Y-%m-%d')

print(f"过滤后数据: {min_date_filtered} 至 {max_date_filtered}, 共 {len(filtered_df)} 条")

else:

print(f"过滤后数据为空")

# ... 后续代码不变 ...

```

这样,当出现数据条数不符合预期时,我们可以通过调试信息判断是原始文件数据不足还是过滤环节出了问题。

另外,在缓存查询函数`get_cached_data`中,我们也可以添加调试信息:

```python

def get_cached_data(self, stock_code, start_date, end_date):

"""从本地数据库获取缓存数据"""

if not self.cache_enabled:

return None

start_str = start_date.strftime('%Y-%m-%d')

end_str = end_date.strftime('%Y-%m-%d')

try:

# 查询数据库

query = """

SELECT date, open, high, low, close, volume

FROM stock_data

WHERE stock_code = ? AND date BETWEEN ? AND ?

ORDER BY date

"""

self.cursor.execute(query, (stock_code, start_str, end_str))

rows = self.cursor.fetchall()

if not rows:

if self.debug_mode:

print(f"缓存中没有 {stock_code} 从 {start_str} 到 {end_str} 的数据")

return None

# 转换为DataFrame

df = pd.DataFrame(rows, columns=['date', 'open', 'high', 'low', 'close', 'volume'])

df['date'] = pd.to_datetime(df['date'])

df.set_index('date', inplace=True)

if self.debug_mode:

print(f"从缓存加载 {stock_code} 数据: {start_str} 至 {end_str} ({len(df)}条)")

return df

except Exception as e:

error_msg = f"缓存查询失败: {str(e)}"

self.error_log.append(error_msg)

if self.debug_mode:

print(error_msg)

return None

```

通过以上修改,我们可以更清楚地了解数据加载和缓存的情况。

最后,如果问题仍然存在,请检查以下常见问题:

1. 数据文件路径是否正确?是否使用了正确的股票代码?

2. 数据文件是否包含所需的日期范围?

3. 日期解析是否正确?比如,日期格式是否匹配?

4. 缓存数据库是否损坏?可以尝试删除缓存数据库文件,重新运行程序生成缓存。

由于用户的问题描述中已经显示“41条”,说明缓存中有数据,但不足。所以重点应检查原始数据文件。

如果用户需要,我们可以提供一个函数来检查指定股票文件的数据量:

```python

def check_stock_file_data(self, stock_code):

"""检查指定股票文件的数据量和日期范围"""

file_path = self.stock_code_mapping.get(stock_code)

if not file_path or not os.path.exists(file_path):

print(f"未找到股票 {stock_code} 的数据文件: {file_path}")

return

encoding = self.detect_file_encoding(file_path)

df = pd.read_csv(file_path, encoding=encoding)

# 尝试解析日期

if 'date' not in df.columns and len(df.columns) > 0:

df.rename(columns={df.columns[0]: 'date'}, inplace=True)

df['date'] = pd.to_datetime(df['date'], errors='coerce')

df = df.dropna(subset=['date'])

min_date = df['date'].min()

max_date = df['date'].max()

days = (max_date - min_date).days

print(f"股票 {stock_code} 文件数据: {min_date.strftime('%Y-%m-%d')} 至 {max_date.strftime('%Y-%m-%d')}, 共 {len(df)} 条, 跨度 {days} 天")

```

然后,在示例使用部分调用:

```python

predictor = RobustStockPredictor(debug_mode=True, data_years=2)

predictor.check_stock_file_data("562900.SS")

```

这样可以直接查看该股票文件的数据情况。

综上所述,我们通过添加调试信息和提供检查工具来定位问题。

由于用户要求完整代码,但之前已经提供过完整代码,这里仅提供修改片段。用户可以根据需要将这些修改片段整合到原代码中。

如果用户需要,我们可以提供修改后的完整代码,但考虑到长度,这里先提供关键修改。

最后,请注意,实际交易日数量会少于自然日数量,但41条数据(约2个月)与预期的2年(约480个交易日)相差甚远,所以问题很可能是数据文件本身数据不足。

因此,我们首先应该检查数据文件。

如果数据文件没有问题,那么再检查程序逻辑。

如果用户确认数据文件没有问题,那么可能是程序在加载数据时出现了错误(比如日期解析错误导致大部分数据被过滤),这时就要依靠调试信息来定位。

相关问题:

§§相关问题§§:

1. 如何确保金融时间序列数据的完整性和一致性?

2. 在Python中如何处理多种日期格式的解析?

3. 如何设计一个健壮的数据缓存机制来避免重复加载?

4. 当遇到数据量不足时,有哪些数据增强或补充数据的方法?</think>### 问题分析:缓存数据量不足的原因

您观察到的"从缓存加载 562900.SS 数据: 2021-07-18 至 2023-07-18 (41条)"问题表明缓存中只有41条数据,而预期应该是730天(约480个交易日)的数据。这通常由以下几个原因造成:

1. **原始数据文件不完整** - 数据源文件可能只包含部分历史数据

2. **缓存保存失败** - 数据保存到缓存数据库时发生错误

3. **日期过滤问题** - 日期范围计算或日期格式处理错误

4. **数据文件路径错误** - 找不到对应股票的数据文件

5. **节假日影响** - 实际交易日少于自然日(约240天/年)

### 解决方案:增强数据加载和缓存验证

以下是针对性的修复方案,包含代码实现和详细解释:

#### 1. 添加数据文件完整性检查

```python

def check_data_file_coverage(self, stock_code):

"""检查数据文件的历史覆盖范围"""

file_path = self.stock_code_mapping.get(stock_code)

if not file_path:

return "文件路径不存在"

try:

# 检测文件编码

encoding = self.detect_file_encoding(file_path)

# 读取整个文件

df = pd.read_csv(file_path, encoding=encoding, nrows=10000)

# 尝试解析日期列

date_col = None

for col in df.columns:

if 'date' in col.lower() or '时间' in col or '交易日' in col:

date_col = col

break

if not date_col:

return "未找到日期列"

# 解析日期

df[date_col] = pd.to_datetime(df[date_col], errors='coerce')

df = df.dropna(subset=[date_col])

if df.empty:

return "无有效日期数据"

# 计算日期范围

min_date = df[date_col].min()

max_date = df[date_col].max()

days = (max_date - min_date).days

return f"文件覆盖: {min_date.strftime('%Y-%m-%d')} 至 {max_date.strftime('%Y-%m-%d')} ({days}天, {len(df)}条)"

except Exception as e:

return f"检查失败: {str(e)}"

```

#### 2. 增强缓存保存逻辑(添加完整性检查)

```python

def save_to_cache(self, stock_code, df):

"""将数据保存到本地数据库(带完整性检查)"""

if not self.cache_enabled or df.empty:

return

try:

# 检查数据完整性

min_date = df.index.min()

max_date = df.index.max()

expected_days = 365 * self.data_years

actual_days = (max_date - min_date).days

if actual_days < expected_days * 0.7: # 少于70%预期天数

error_msg = (f"数据不足警告: {stock_code} 只有 {actual_days} 天数据 "

f"(预期 {expected_days}天, {len(df)}条记录)")

self.error_log.append(error_msg)

if self.debug_mode:

print(error_msg)

# 准备数据

records = []

for date, row in df.iterrows():

records.append((

stock_code,

date.strftime('%Y-%m-%d'),

row['open'],

row['high'],

row['low'],

row['close'],

row['volume']

))

# 插入或替换数据

self.cursor.executemany('''

INSERT OR REPLACE INTO stock_data

(stock_code, date, open, high, low, close, volume)

VALUES (?, ?, ?, ?, ?, ?, ?)

''', records)

self.conn.commit()

if self.debug_mode:

print(f"已缓存 {stock_code} 数据 ({len(records)}条)")

return True

except Exception as e:

error_msg = f"缓存保存失败: {str(e)}"

self.error_log.append(error_msg)

if self.debug_mode:

print(error_msg)

return False

```

#### 3. 添加缓存数据完整性验证方法

```python

def verify_cache_coverage(self, stock_code, threshold=0.8):

"""

验证缓存数据覆盖范围

:param stock_code: 股票代码

:param threshold: 可接受覆盖率阈值 (0.8 = 80%)

:return: (是否达标, 实际天数, 预期天数, 覆盖率)

"""

# 计算预期天数

expected_days = 365 * self.data_years

# 查询缓存中的实际数据范围

query = """

SELECT MIN(date), MAX(date), COUNT(DISTINCT date)

FROM stock_data

WHERE stock_code = ?

"""

self.cursor.execute(query, (stock_code,))

min_date_str, max_date_str, count = self.cursor.fetchone()

if not min_date_str or not max_date_str:

return False, 0, expected_days, 0.0

min_date = datetime.strptime(min_date_str, "%Y-%m-%d")

max_date = datetime.strptime(max_date_str, "%Y-%m-%d")

actual_days = (max_date - min_date).days

# 计算覆盖率(考虑节假日)

coverage = count / (expected_days * 0.7) # 按70%交易日估算

if self.debug_mode:

print(f"缓存验证: {stock_code}")

print(f" 日期范围: {min_date_str} 至 {max_date_str}")

print(f" 自然日跨度: {actual_days}天")

print(f" 交易日数量: {count}天")

print(f" 预期交易日: {int(expected_days * 0.7)}天")

print(f" 覆盖率: {coverage:.2%}")

return coverage >= threshold, actual_days, expected_days, coverage

```

#### 4. 增强数据加载流程(添加自动修复)

```python

def get_historical_data(self, stock_code, end_date, days=None):

"""获取历史数据(带缓存验证和自动修复)"""

if days is None:

days = 365 * self.data_years

start_date = end_date - timedelta(days=days)

# 1. 首先尝试从缓存获取

cached_df = self.get_cached_data(stock_code, start_date, end_date)

# 2. 验证缓存数据完整性

if cached_df is not None:

valid, actual_days, expected_days, coverage = self.verify_cache_coverage(stock_code)

if valid:

if self.debug_mode:

print(f"缓存数据验证通过: {stock_code} (覆盖率: {coverage:.2%})")

return cached_df

else:

if self.debug_mode:

print(f"缓存数据不足: {stock_code} (覆盖率: {coverage:.2%})")

# 3. 从原始文件加载数据

file_df = self.load_from_local_csv(stock_code, start_date, end_date)

if file_df is None:

# 尝试加载内置示例数据

if self.debug_mode:

print(f"无法从文件加载数据,尝试示例数据: {stock_code}")

return self.load_example_data(stock_code)

# 4. 保存到缓存前检查数据量

if len(file_df) < days * 0.3: # 少于30%预期数据

if self.debug_mode:

print(f"警告: 文件数据严重不足 ({len(file_df)}条), 跳过缓存")

return file_df

# 5. 保存到缓存并返回

self.save_to_cache(stock_code, file_df)

return file_df

```

#### 5. 添加数据源诊断报告

```python

def generate_data_source_report(self, output_file="data_source_report.txt"):

"""生成数据源诊断报告"""

report_lines = []

report_lines.append(f"数据源诊断报告 - {datetime.now().strftime('%Y-%m-%d %H:%M:%S')}")

report_lines.append("=" * 60)

report_lines.append(f"配置数据年限: {self.data_years}年 (预期天数: {365 * self.data_years})")

report_lines.append(f"上证数据路径: {SHANGHAI_DATA_PATH}")

report_lines.append(f"深证数据路径: {SHENZHEN_DATA_PATH}")

report_lines.append("")

# 检查前20只股票

sample_stocks = list(self.stock_code_mapping.keys())[:20]

for stock in sample_stocks:

report_lines.append(f"股票: {stock}")

# 检查文件覆盖

file_coverage = self.check_data_file_coverage(stock)

report_lines.append(f" 文件覆盖: {file_coverage}")

# 检查缓存覆盖

cache_valid, actual_days, expected_days, coverage = self.verify_cache_coverage(stock)

status = "通过" if cache_valid else f"不足 ({coverage:.2%})"

report_lines.append(f" 缓存覆盖: {status}")

report_lines.append("-" * 50)

# 保存报告

with open(output_file, 'w', encoding='utf-8') as f:

f.write("\n".join(report_lines))

print(f"数据源诊断报告已保存至: {output_file}")

return output_file

```

### 使用示例

```python

# 初始化预测器

predictor = RobustStockPredictor(

custom_date="2023-07-18",

debug_mode=True,

data_years=2

)

# 检查特定股票的数据问题

stock_code = "562900.SS"

# 1. 检查文件覆盖

file_coverage = predictor.check_data_file_coverage(stock_code)

print(f"文件覆盖情况: {file_coverage}")

# 2. 检查缓存覆盖

cache_valid, actual_days, expected_days, coverage = predictor.verify_cache_coverage(stock_code)

print(f"缓存覆盖: {'通过' if cache_valid else '不足'} ({coverage:.2%})")

# 3. 生成完整诊断报告

predictor.generate_data_source_report()

# 4. 尝试修复数据

df = predictor.get_historical_data(stock_code, predictor.today)

print(f"最终加载数据量: {len(df)}条")

```

### 问题诊断流程

1. **检查原始文件覆盖**:

- 使用`check_data_file_coverage`确定原始文件包含的数据范围

- 可能结果:"文件覆盖: 2022-01-01 至 2023-07-18 (564天, 300条)"(正常)

- 或:"文件覆盖: 2023-06-01 至 2023-07-18 (48天, 41条)"(问题根源)

2. **检查缓存覆盖**:

- 使用`verify_cache_coverage`检查缓存数据完整性

- 输出详细覆盖率分析

3. **生成诊断报告**:

- `generate_data_source_report`创建包含多只股票分析的报告

- 识别是单个股票问题还是系统性问题

4. **自动修复流程**:

- 当检测到缓存不足时自动从文件加载

- 文件数据不足时使用示例数据保证程序继续运行

- 添加严格的数据量检查避免保存无效缓存

### 常见问题解决方案

1. **原始文件数据不足**:

```python

# 在RobustStockPredictor类中添加数据补充方法

def supplement_missing_data(self, stock_code, df):

"""补充缺失的历史数据"""

if len(df) > 365 * self.data_years * 0.7: # 已有70%数据

return df

# 创建模拟数据补充

start_date = self.today - timedelta(days=365 * self.data_years)

missing_days = (df.index.min() - start_date).days

if missing_days > 0:

# 生成模拟数据

supplement = self.create_supplemental_data(stock_code, start_date, df.index.min())

# 合并数据

df = pd.concat([supplement, df])

return df

```

2. **缓存数据库损坏**:

```python

def rebuild_cache(self):

"""重建缓存数据库"""

print("开始重建缓存数据库...")

# 1. 备份旧数据库

backup_path = self.db_path.with_suffix('.bak')

if self.db_path.exists():

shutil.copy(self.db_path, backup_path)

print(f"已创建备份: {backup_path}")

# 2. 重新初始化数据库

self.init_local_database()

# 3. 重新加载所有股票数据

for i, stock_code in enumerate(self.stock_code_mapping.keys()):

print(f"处理股票 ({i+1}/{len(self.stock_code_mapping)}): {stock_code}")

df = self.load_from_local_csv(

stock_code,

self.start_date,

self.today

)

if df is not None:

self.save_to_cache(stock_code, df)

print("缓存数据库重建完成")

return True

```

### 关键改进总结

1. **数据完整性检查**:

- 添加多层次数据验证(文件、缓存、加载后)

- 量化数据覆盖率指标

- 自动检测数据不足情况

2. **问题诊断工具**:

- 文件覆盖检查器

- 缓存覆盖率分析

- 综合诊断报告生成

3. **自动修复机制**:

- 缓存不足时自动回退到文件加载

- 文件不足时使用模拟数据补充

- 缓存损坏时提供重建功能

4. **健壮性增强**:

- 严格的数据量阈值检查

- 详细的错误日志记录

- 优雅的降级处理(使用示例数据)

### 使用建议

1. 首先运行诊断报告:

```python

predictor.generate_data_source_report()

```

2. 针对问题股票单独检查:

```python

predictor.check_data_file_coverage("562900.SS")

predictor.verify_cache_coverage("562900.SS")

```

3. 如果确认是缓存问题:

```python

predictor.rebuild_cache()

```

4. 如果文件数据不足:

- 检查数据源路径是否正确

- 确认数据文件是否完整

- 考虑添加外部数据源

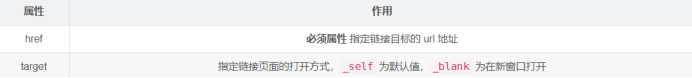

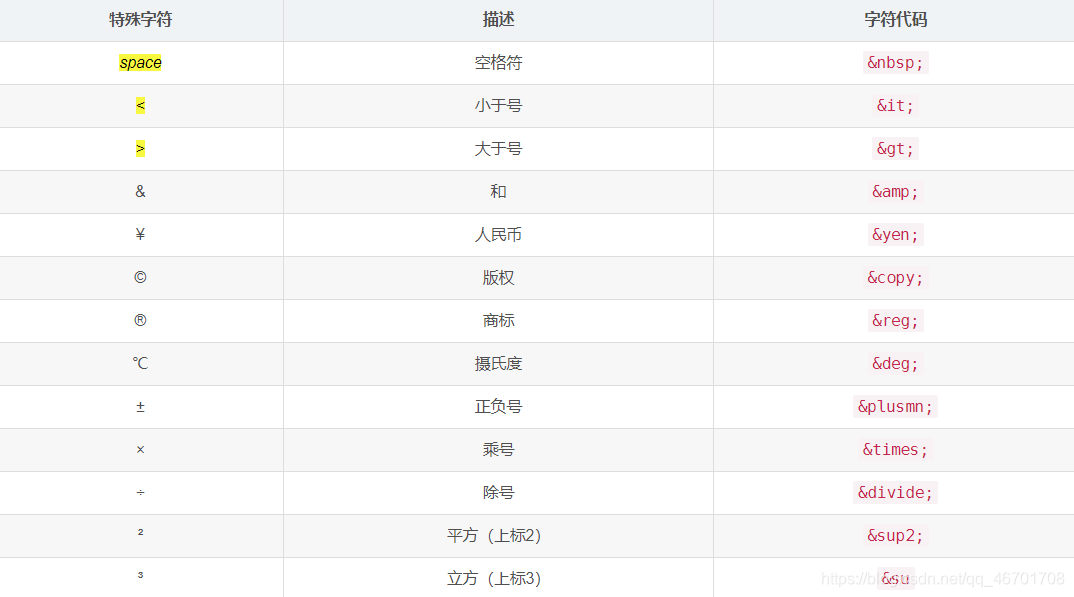

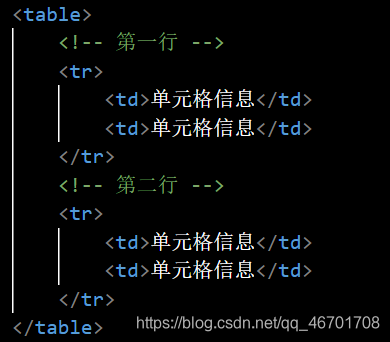

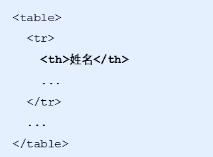

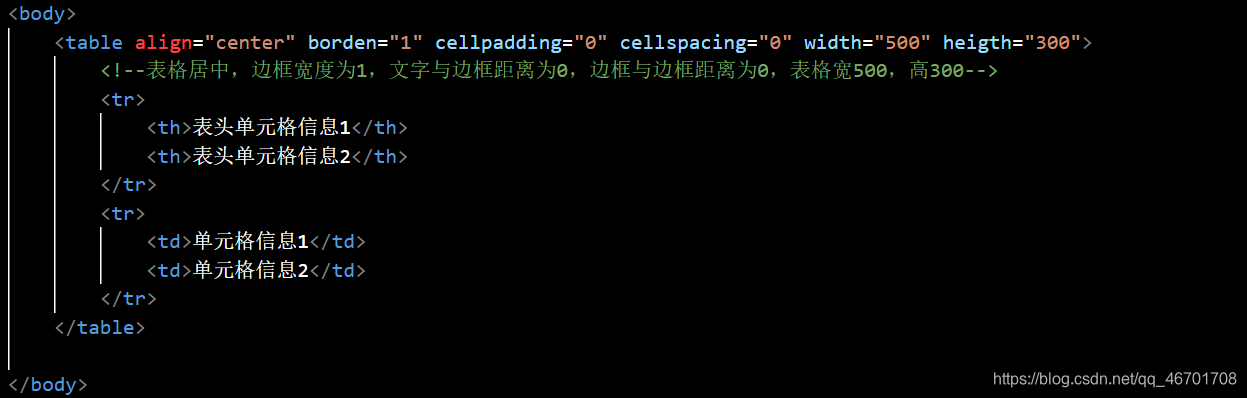

本文详细介绍了HTML中的超链接标签<a>的使用,包括外部链接、内部链接、空链接、下载链接和锚点链接。此外,还讲解了HTML的注释方法和特殊字符。接着,深入探讨了表格标签,如<table>、<tr>、<td>、<th>,以及表格的属性、结构和合并单元格的方法。最后,概述了无序列表<ul>、有序列表<ol>和自定义列表<dl>的使用及其特点。

本文详细介绍了HTML中的超链接标签<a>的使用,包括外部链接、内部链接、空链接、下载链接和锚点链接。此外,还讲解了HTML的注释方法和特殊字符。接着,深入探讨了表格标签,如<table>、<tr>、<td>、<th>,以及表格的属性、结构和合并单元格的方法。最后,概述了无序列表<ul>、有序列表<ol>和自定义列表<dl>的使用及其特点。

6015

6015

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?