Spark环境搭建

搭建所使用的环境和软件

- 服务器集群

我用的CentOS-7版本的3个虚拟机,主机名为hadoop01、hadoop02、hadoop03。CentOS 7+Hadoop-2.10.1的hadoop集群搭建. - scala-2.13.4.tgz安装包

- spark-2.4.7-bin-hadoop2.7.tgz安装包

网盘链接 link ----------------- 提取码:whs9

搭建集群

集群规划

-

1: 将scala与spark安装包上传到hadoop-01的 /opt/software 目录下(通过xftp)

-

2: 将scala与spark安装包解压到hadoop-01的 /opt/module 目录下

[root@hadoop-01 software]# tar -zxvf scala-2.13.4.tgz -C /opt/module/

[root@hadoop-01 software]# tar -zxvf spark-2.4.7-bin-hadoop2.7.tgz -C /opt/module/

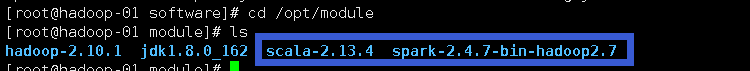

- 3: 查看是否成功

- 4: 配置scala环境变量

[root@hadoop-01 module]# vim /etc/profile

#配置内容

#SCALA_HOME

export SCALA_HOME=/opt/module/scala-2.13.4

export PATH=$P

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

575

575

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?