作为当今大数据处理领域的经典分布式平台,ApacheHadoop主要基于

Java语言实现,由三个核心子系统组成:HDFS、YARN、MapReduce,其

中,HDFS是一套分布式文件系统;YARN是资源管理系统,MapReduce是运行

在YARN上的应用,负责分布式处理管理。如果从操作系统的角度看,HDFS

相当于Linux的ext3/ext4文件系统,而Yarn相当于Linux的进程调度和内存分配

模块。(初学的我一脸懵逼QAQ)

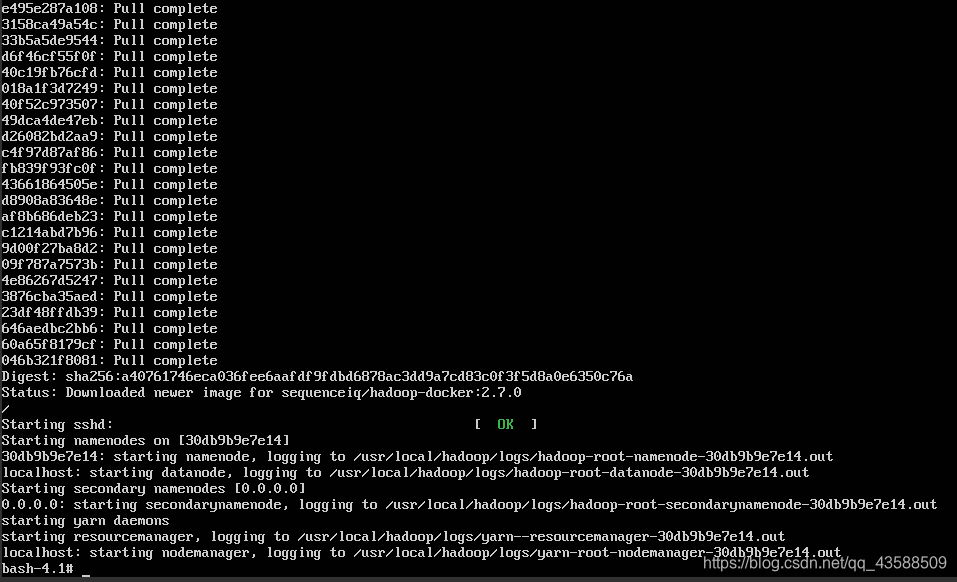

首先我们拉取一个官方镜像,并进入bash命令行

#docker run -it sequenceiq/hadoop-docker:2.7.0 /etc/bootstrap.sh -bash

在漫长的等待时间后,出现了这个

bash-4.1#

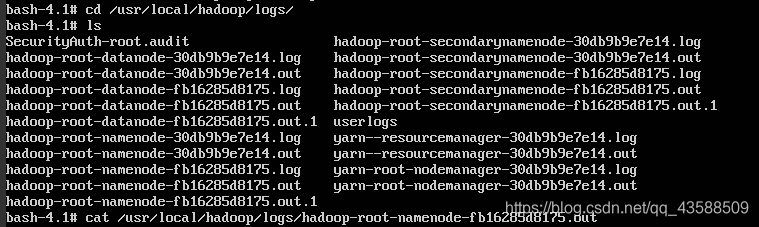

这时就可以进行各种操作了,我们可以试一下查看日志等操作

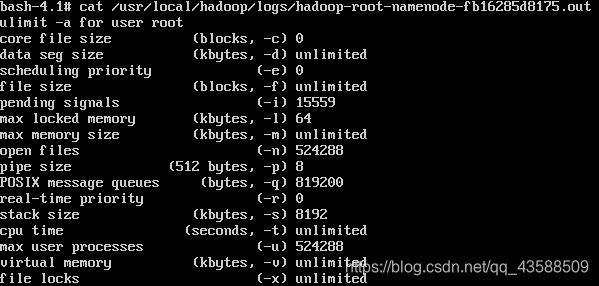

找到对应目录,查看对应信息后用cat即可,我的操作如下图

效果图如下

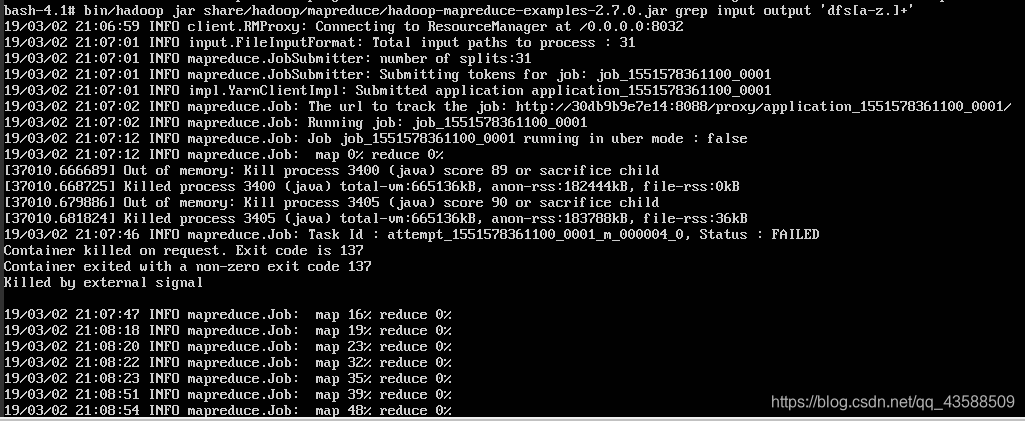

假设我们需要验证Hadoop是否安装成功,可以通过运行Hadoop内置的实例程序来进行测试,最后使用hdfs指令检查输出结果即可:

具体操作如下:

在bash命令行下进入Hadoop目录

bash-4.1# cd /usr/local/hadoop

运行内置实例程序

bash-4.1# bin/hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.0.jar

grep input output 'dfs[a-z.]+'

(又是漫长的等待QAQ)

效果图如下

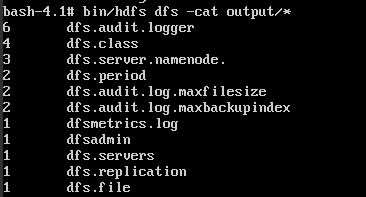

使用hdfs指令检查输出结果

bash-4.1# bin/hdfs dfs -cat output/*

本文详细介绍了如何使用Docker快速部署Hadoop环境,并通过运行内置实例程序验证Hadoop的安装与配置是否正确,包括HDFS、YARN和MapReduce等核心组件的操作与测试。

本文详细介绍了如何使用Docker快速部署Hadoop环境,并通过运行内置实例程序验证Hadoop的安装与配置是否正确,包括HDFS、YARN和MapReduce等核心组件的操作与测试。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?