EfficientDet : Scalable and Dfficient Object Detection阅读记录

这里写目录标题

3.BiFPN

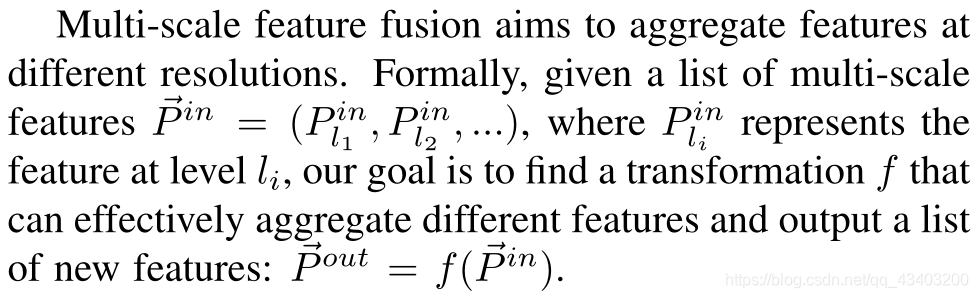

3.1Problem Formulation

作者首先介绍了什么时特征融合,通过某种融合方法,将特征提取网络提取到不同深度的特征相融合,最后输出新的特征。

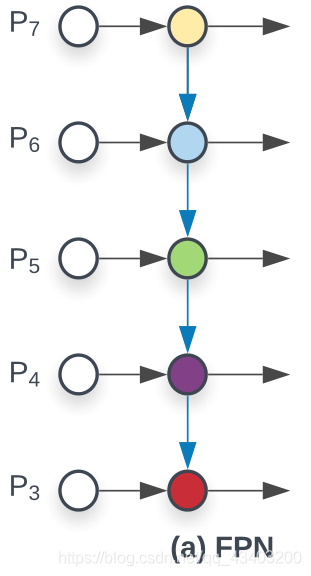

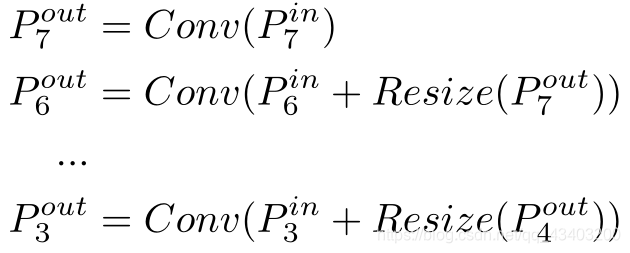

然后作者用传统的FPN为例,介绍FPN特征融合的过程。

对于特征提取网络来说,随着网络深度的增加,输出特征的分辨率会降低。例如:输入图片的分辨率为640x640,那么P3层输出特征的分辨率就是80x80(

640

/

2

3

=

80

640/2^3=80

640/23=80);P7层输出的特征的分辨率就是5x5(

640

/

2

7

=

5

640/2^7=5

640/27=5)

也就是说特征提取网络提取到的不同层的特征的尺寸是不同的。

传统同的FPN的融合方式可以表示为:

其中 P i o u t P_i^{out} Piout为图(a)中右侧箭头的输出特征; P i i n P_i^{in} Piin为左侧白色圆圈所表示的输入特征。Resize方法是为了特征分辨率匹配而做的上采样或下采样操作。Conv是特征融合操作。

3.2 Cross-Scale Connections

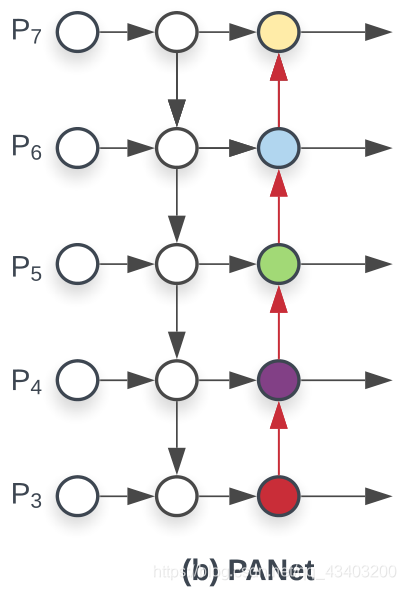

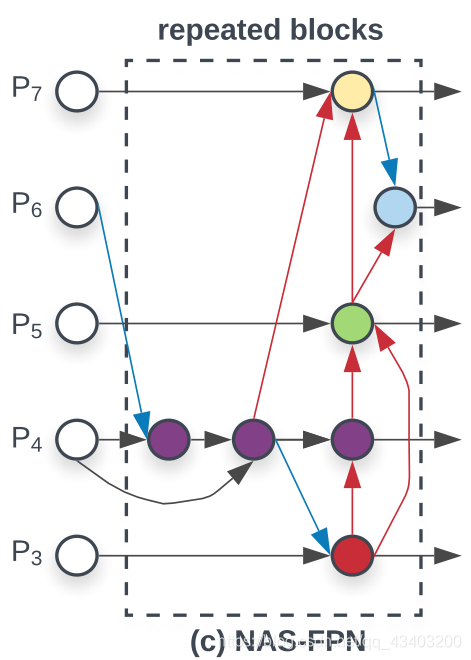

作者又介绍了两种特征融合的方式:PANet和NAS-FPN。

PANet考虑到FPN只有自顶向下的特征融合可能会导致特征融合不够充分,又增加了自底向上的连接。这样的操作会提升网络的特征融合能力,但是增加了更多的参数。

NAS-FPN是通过学习的方式建立节点的连接。这将需要更多的计算资源,而且训练输出的网络是不规则的。

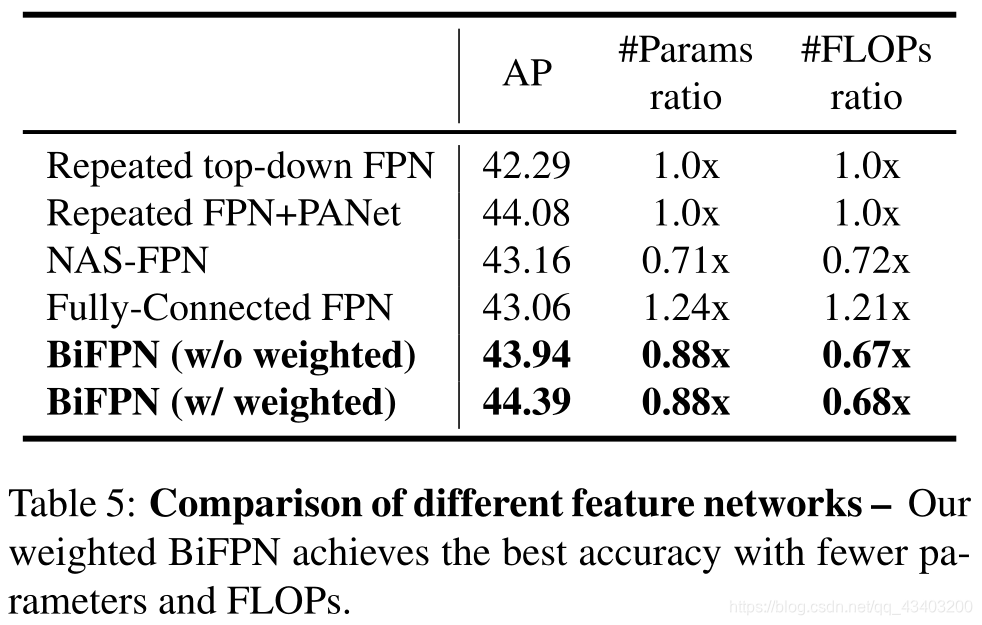

作者也做了实验,测试各个融合网络的性能。结果如下表:

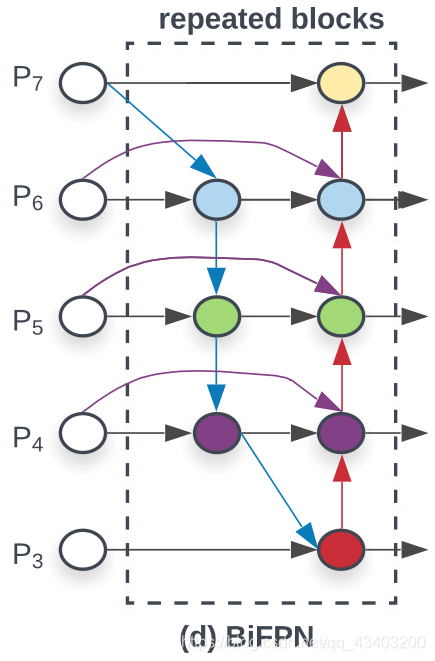

作者结合总结上述特征融合方法的优缺点,提出了双向特征金字塔网络(BiFPN)。网络结构如下:

该网络有下列几点改进:

- 删除了只有一条边连接的节点;

- 如果原始输入节点与输出节点处于同一层,就在它们之间增加一条额外的边,以便融合更多的特征;

- 处理每个双向(自顶向下和自下而上)路径作为一个特征网络层,并多次重复同一层,以实现更高级的特征融合。

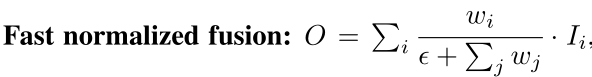

3.3 Weighted Feature Fusion

当融合不同分辨率的特征时,一个常见的方法是首先将它们调整为相同的分辨率,然后将它们相加。之前的所有方法都一视同仁地对待所有输入特征。然而,由于不同的输入特征在不同的分辨率,它们通常对输出特征的贡献是不平等的。所以给每一个输入添加权重是有必要的。作者对比了三种不同的添加权重的方法,发现快速标准化融合(Fast normalized fusion)的方法效果最好。

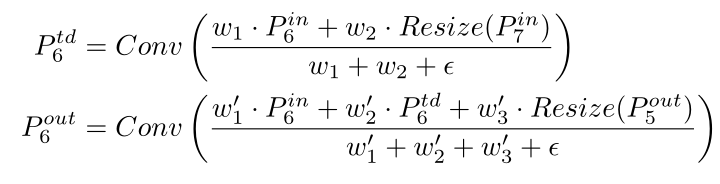

作者采用双向跨尺度连接与快速标准化融合加权计算相结合的方法实现最终的BiFPN。例如,我们可以使用如下方式计算第6层的输出:

其中

P

6

t

d

P_6^{td}

P6td是中间特征,

P

6

o

u

t

P_6^{out}

P6out是第6层的输出,

ω

i

\omega_i

ωi和

ω

i

′

\omega_i'

ωi′是各个输入所对应的权重。

4. EfficientDet

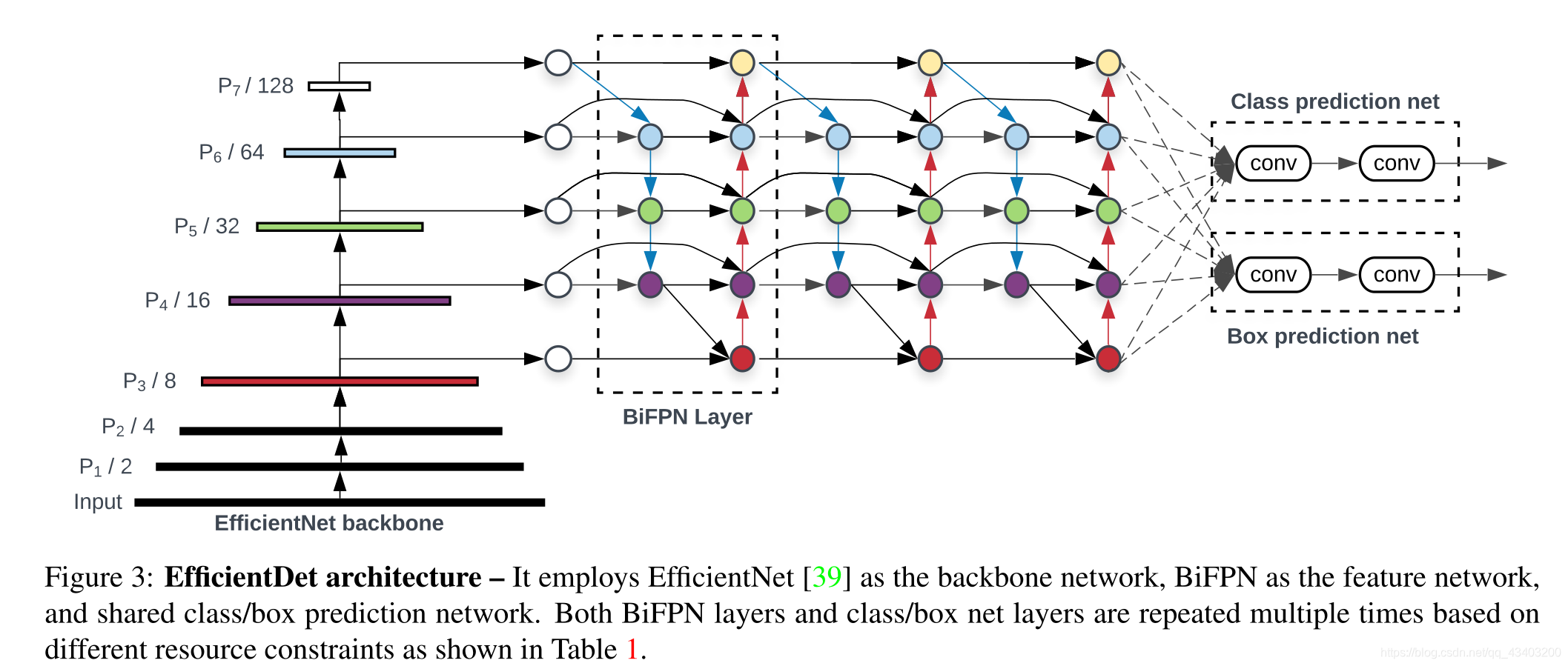

4.1 EfficientDet Architecture

上图是EfficientDet的整体结构,是一个单阶段的网络。该网络使用预训练的ImageNet作为主干网络,使用BiFPN作为特征融合网络,最后的预测网络对不同层的特征是权值共享的。

4.2 Compound Scaling

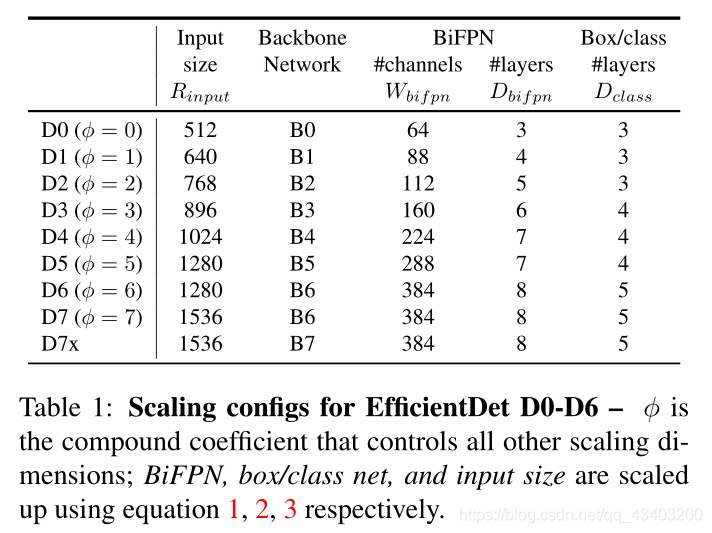

不同的设备有不同的计算资源,为了适应不同的设备,有必要设计一个模型系列。作者根据不同的Backbone network、BiFPN network、Box/class prediction network和Input image resolution将模型划分成7个不同的尺寸。

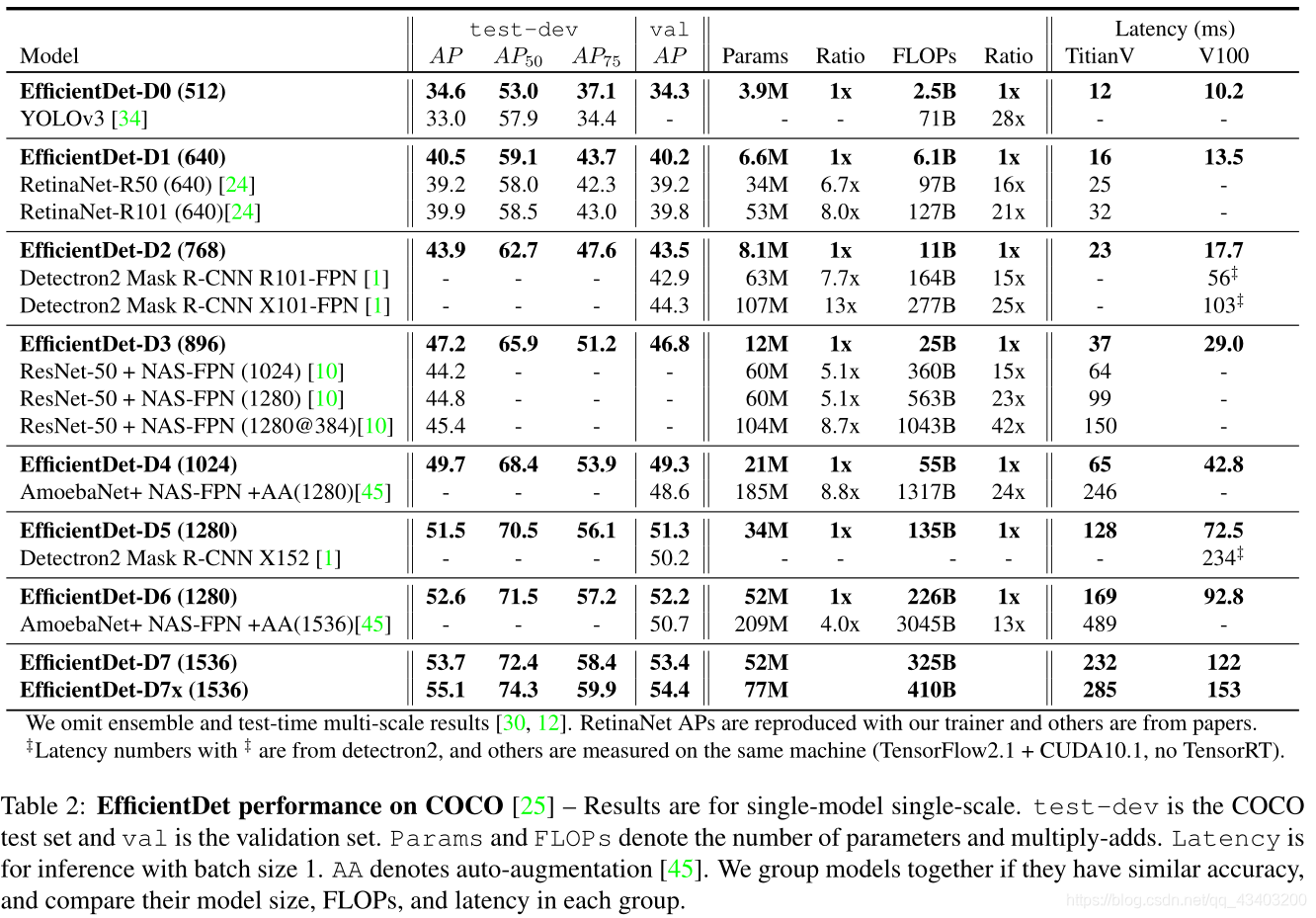

5. Experiments

本文详细介绍了EfficientDet的BiFPN结构,包括问题定义、跨尺度连接和加权特征融合。BiFPN通过双向连接和权重融合提升特征融合效果,同时减少了额外参数。EfficientDet架构结合了高效主干网络和BiFPN,实现了不同规模的模型以适应不同计算资源。实验表明,这种方法在性能和效率之间取得了平衡。

本文详细介绍了EfficientDet的BiFPN结构,包括问题定义、跨尺度连接和加权特征融合。BiFPN通过双向连接和权重融合提升特征融合效果,同时减少了额外参数。EfficientDet架构结合了高效主干网络和BiFPN,实现了不同规模的模型以适应不同计算资源。实验表明,这种方法在性能和效率之间取得了平衡。

331

331

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?