目录

数值稳定性

神经网络的梯度

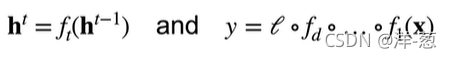

考虑如下有d层的神经网络

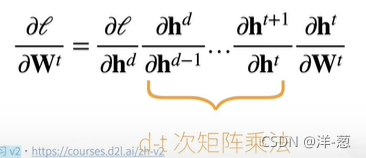

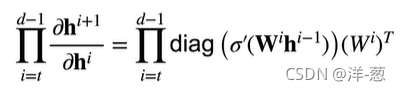

计算损失l关于参数Wt的梯度

数值稳定性的常见两个问题

梯度消失 和 梯度爆炸

例子: MLP

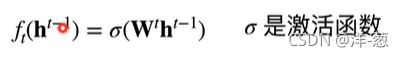

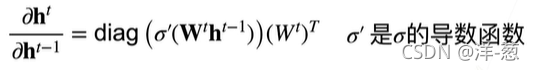

加入如下MLP(为了简单省略了偏移)

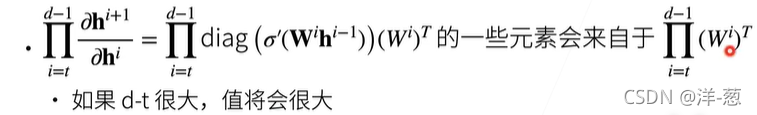

梯度爆炸

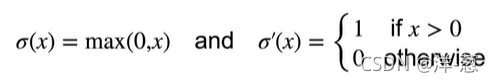

使用ReLU作为激活函数。

梯度爆炸的问题

- 值超出值域(infinity)

对于16位浮点数尤为严重(数值区间6e-5 - 6e4)。

- 对学习率敏感

如果学习率太大 -> 大参数值 -> 更大的梯度。

如果学习率太小 -> 训练无进展。

我们可能需要在训练过程不断调整学习率。

梯度消失

使用sigmoid作为激活函数

本文探讨了深度神经网络中常见的数值稳定性问题,包括梯度爆炸和梯度消失。通过实例分析MLP,解释了ReLU和sigmoid激活函数导致的这些问题,提出了通过权重初始化、归一化和选择合适的激活函数来提升训练稳定性的策略。

本文探讨了深度神经网络中常见的数值稳定性问题,包括梯度爆炸和梯度消失。通过实例分析MLP,解释了ReLU和sigmoid激活函数导致的这些问题,提出了通过权重初始化、归一化和选择合适的激活函数来提升训练稳定性的策略。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?