win10如何使用scrapyd部署爬虫

官方文档:http://scrapyd.readthedocs.io/en/stable/

scrapy爬虫写好后,一般需要用命令行运行。scrapyd部署能够在网页端查看正在执行的任务,也能新建爬虫任务,和终止爬虫任务。优点:在网页端管理爬虫,可以控制多个爬虫任务。

1.安装

pip install scrapydpip install scrapyd-client

2.基本使用

2.1 运行scrapyd

在scrapy.cfg中,取消#url = http://localhost:6800/前面的“#” 。

首先切换命令行路径到Scrapy项目的根目录下,

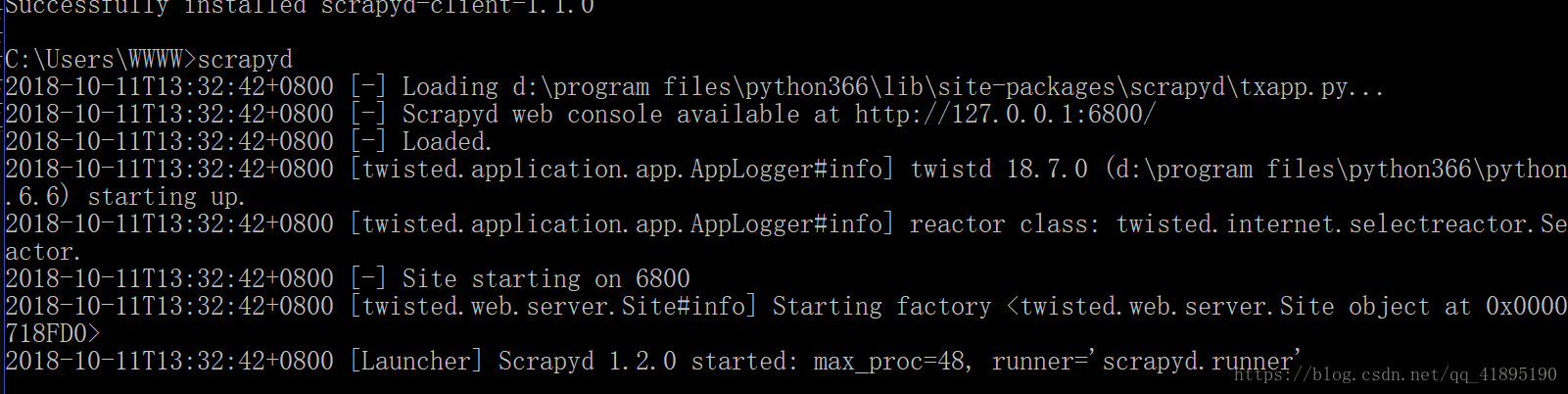

开启scrapyd服务,输入scrapyd,将scrapyd运行起来

然后新开一个终端切换路径至scrapy工程根目录,发布scrapyd项目,运行命令:scrapd-deploy -p projectName

验证是否发布成功:scrapyd-deploy -l

2.2 发布工程到scrapyd

上述命令已经开启服务,并创建了爬虫项目

2.3 创建爬虫任务

命令行输入

本文介绍了在Windows 10系统中如何使用scrapyd部署和管理Scrapy爬虫。内容包括scrapyd的安装、运行、发布项目、创建爬虫任务以及查看和管理爬虫任务的方法,详细解析了相关命令行操作。

本文介绍了在Windows 10系统中如何使用scrapyd部署和管理Scrapy爬虫。内容包括scrapyd的安装、运行、发布项目、创建爬虫任务以及查看和管理爬虫任务的方法,详细解析了相关命令行操作。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

674

674

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?