- 集群角色介绍

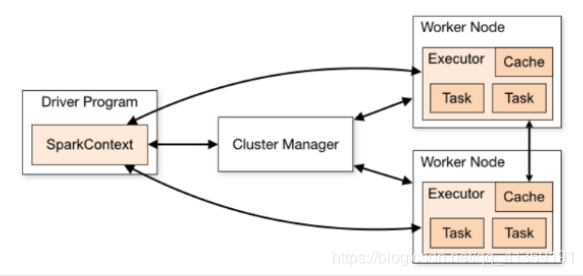

Spark是基于内存计算的大数据并行计算框架,实际中运行计算任务肯定是使用集群模式,那么我们先来学习Spark自带的standalone集群模式了解一下它的架构及运行机制。Standalone集群使用了分布式计算中的master-slave模型

master:集群中含有master进程的节点

slave:集群中的worker节点含有Executor进程

- Spark架构图

http://spark.apache.org/docs/latest/cluster-overview.html

- 集群规划

node01:master

node02:slave/worker

node03:slave/worker

- 下载Spark安装包

下载地址:http://spark.apache.org/downloads.html

- 上传安装包

本文详细介绍Spark集群的standalone模式部署步骤,包括环境搭建、配置修改、集群启动与测试,以及如何通过集群模式运行Spark程序进行大数据计算。

本文详细介绍Spark集群的standalone模式部署步骤,包括环境搭建、配置修改、集群启动与测试,以及如何通过集群模式运行Spark程序进行大数据计算。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

4323

4323

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?