之前的神经网络是全连接网络,需要把输入图片拉伸为一维向量,然后和W进行点乘,得到10个得分。

但是,把图像拉伸为一维向量会失去它的空间特征,而卷积神经网络能解决空间特征的问题。

在卷积层中,卷积核一般是f*f*c的形式,其中c是输入的深度。

进行卷积运算其实就是卷积核在输入上滑动时,求卷积核和输入的点积。

上面蓝色的卷积核能得到蓝色的激活图(activation map),再来一个绿色的卷积核就能得到绿色的激活图。

每一个卷积核获取一种特征,得到一张激活图。所以输出的深度和卷积核的个数相等。

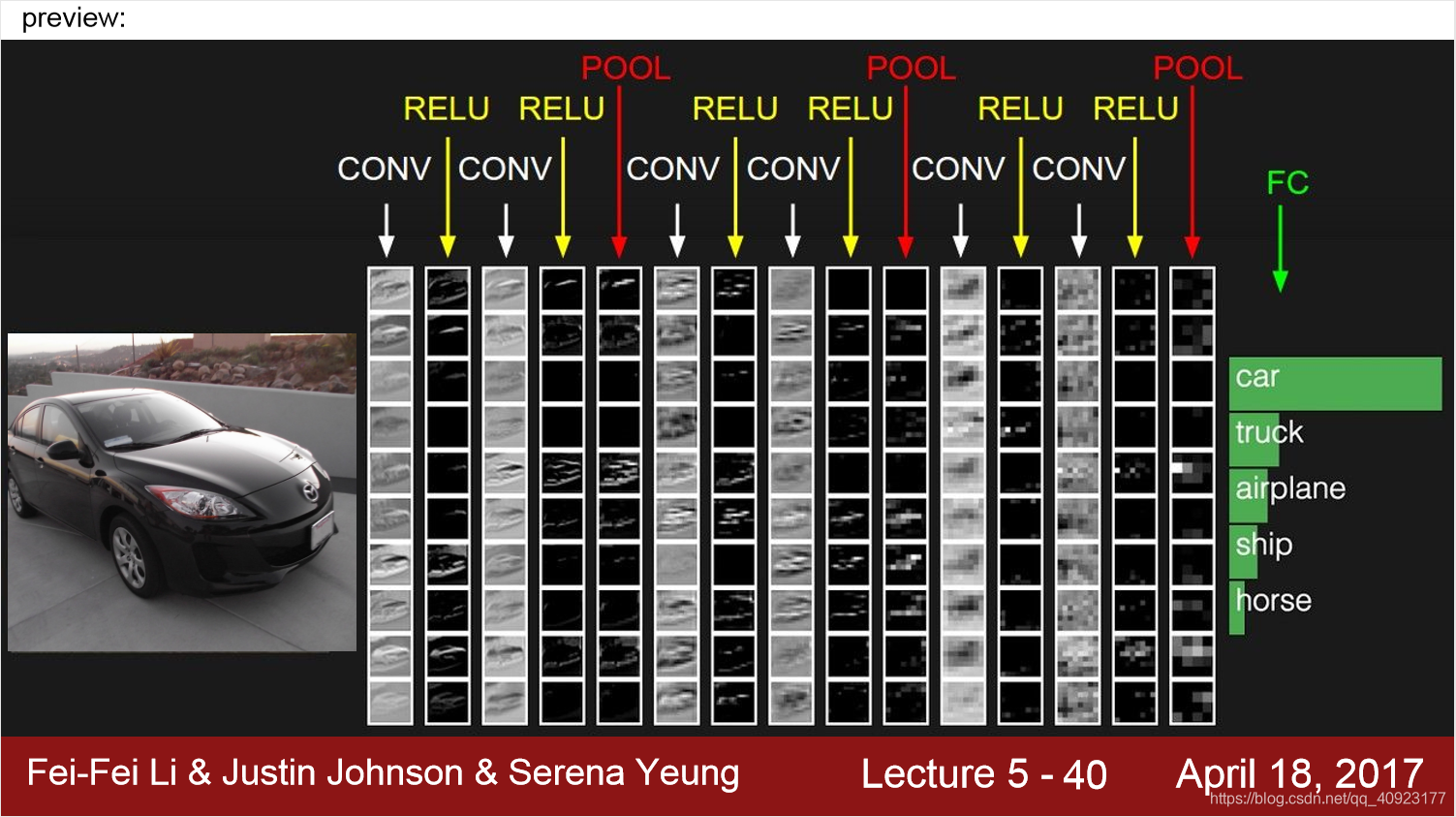

卷积网络就是一系列的卷积层,每个卷积层后面都有一个激活函数(比如这里的ReLu)。

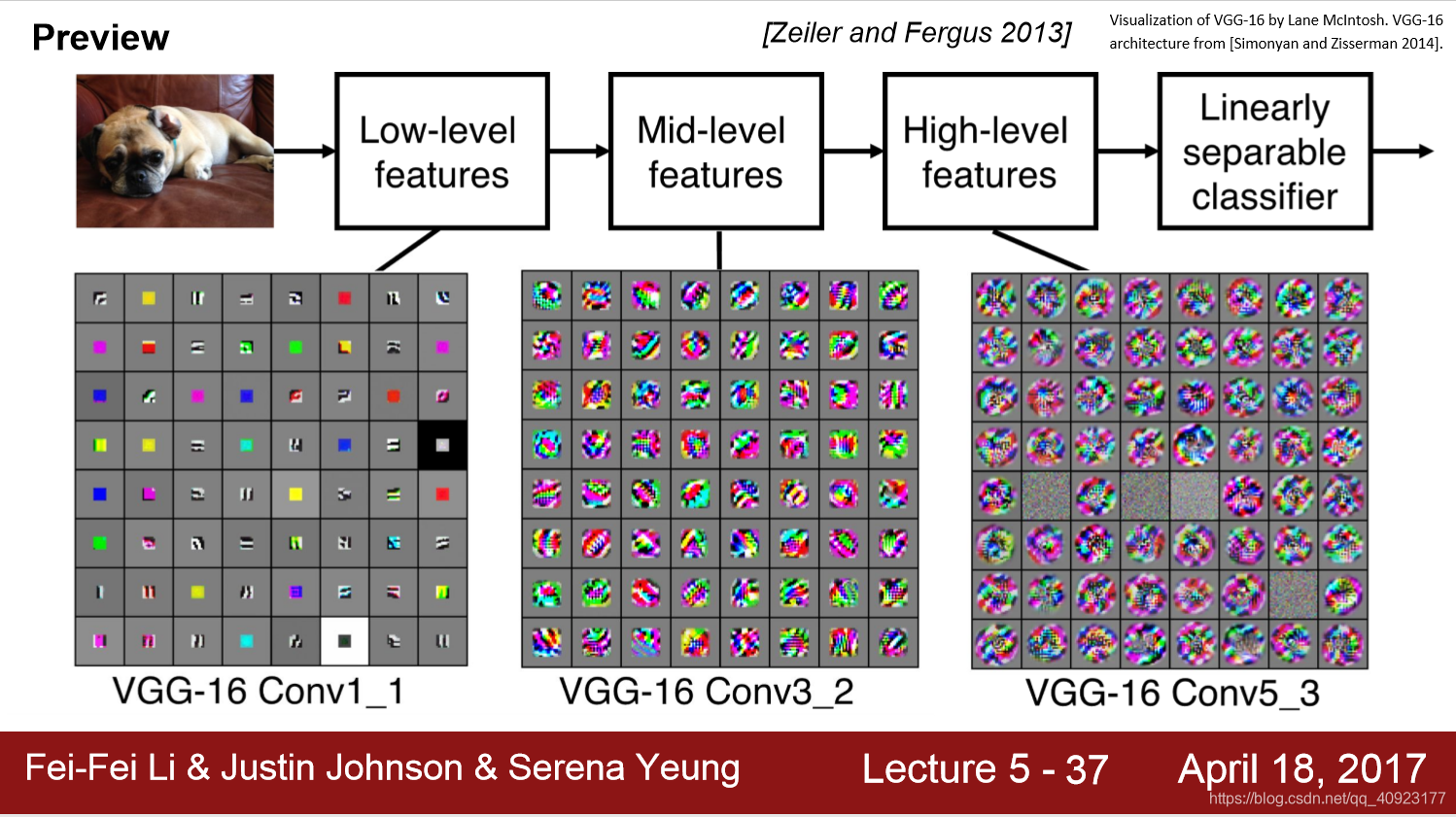

可以看到,较低层的卷积核代表一些低阶的图像特征,比如边缘;中间层则是低阶特征的组合,得到比较复杂的特征,比如边角和斑点;高层则得到更加复杂的特征。

所以卷积网络就是从简单特征开始,逐步学习复杂的特征,最后用复杂特征进行分类的过程。

这个网址展示一个卷积网络的各层特征。

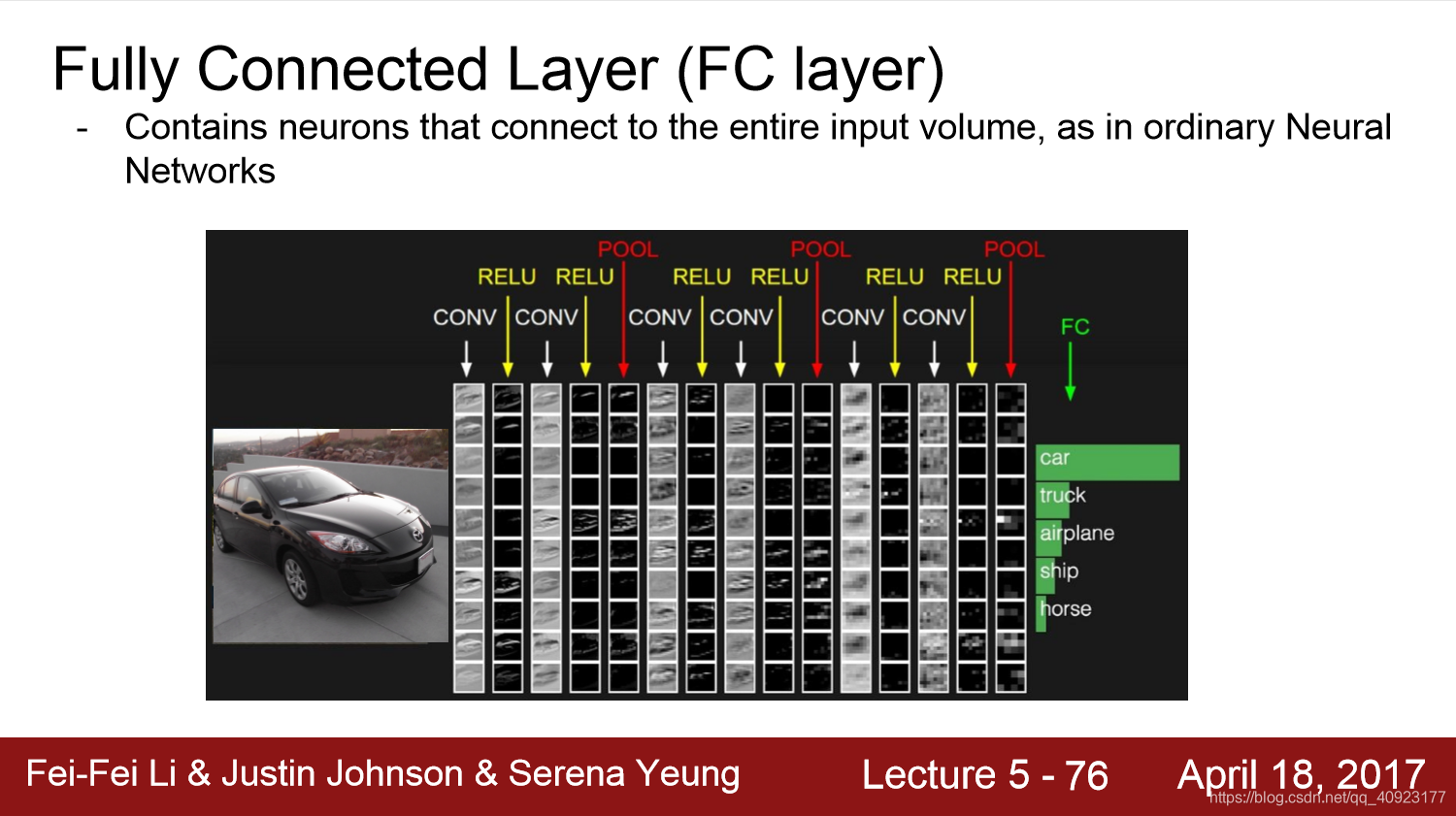

一个卷积神经网络的框架如下所示,每个卷积层(conv)后都有一个激活函数(RELU),多个卷积层+激活函数后会有一个池化层,再重复卷积层和激活函数。最后是一个全连接层(FC)。

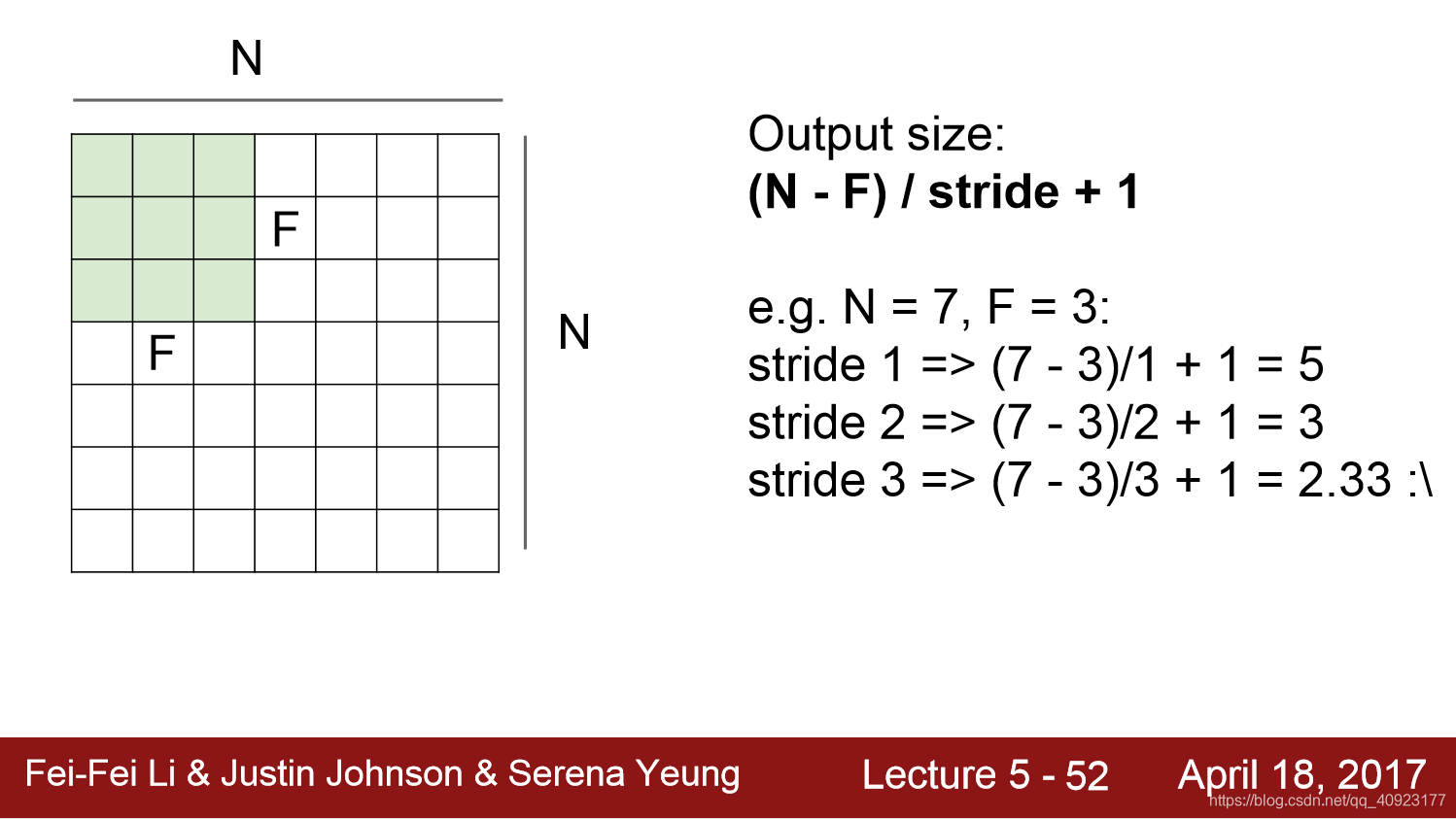

在进行卷积操作的时候,输出图像的大小的计算公式如下,其中N是输入图像的大小(不算深度),F是卷积核的大小(也不算深度),stride是步长,表示每次点乘卷积核后,卷积核滑动的像素个数。

一般来说,进行卷积操作都会使得输出图像的大小比输入时的小,想要维持输出图像的大小,一个常用的策略是在输入的边缘补零。

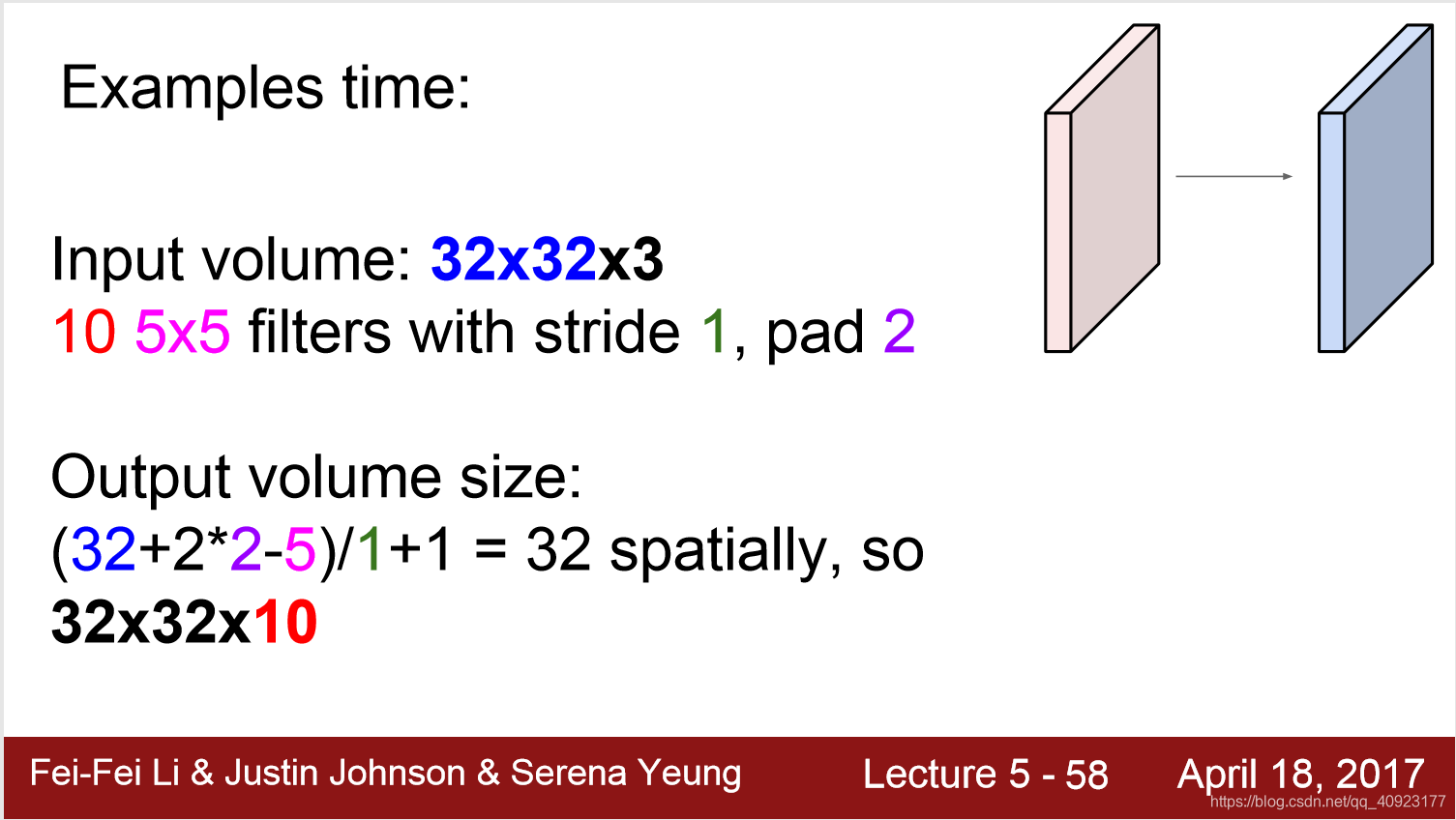

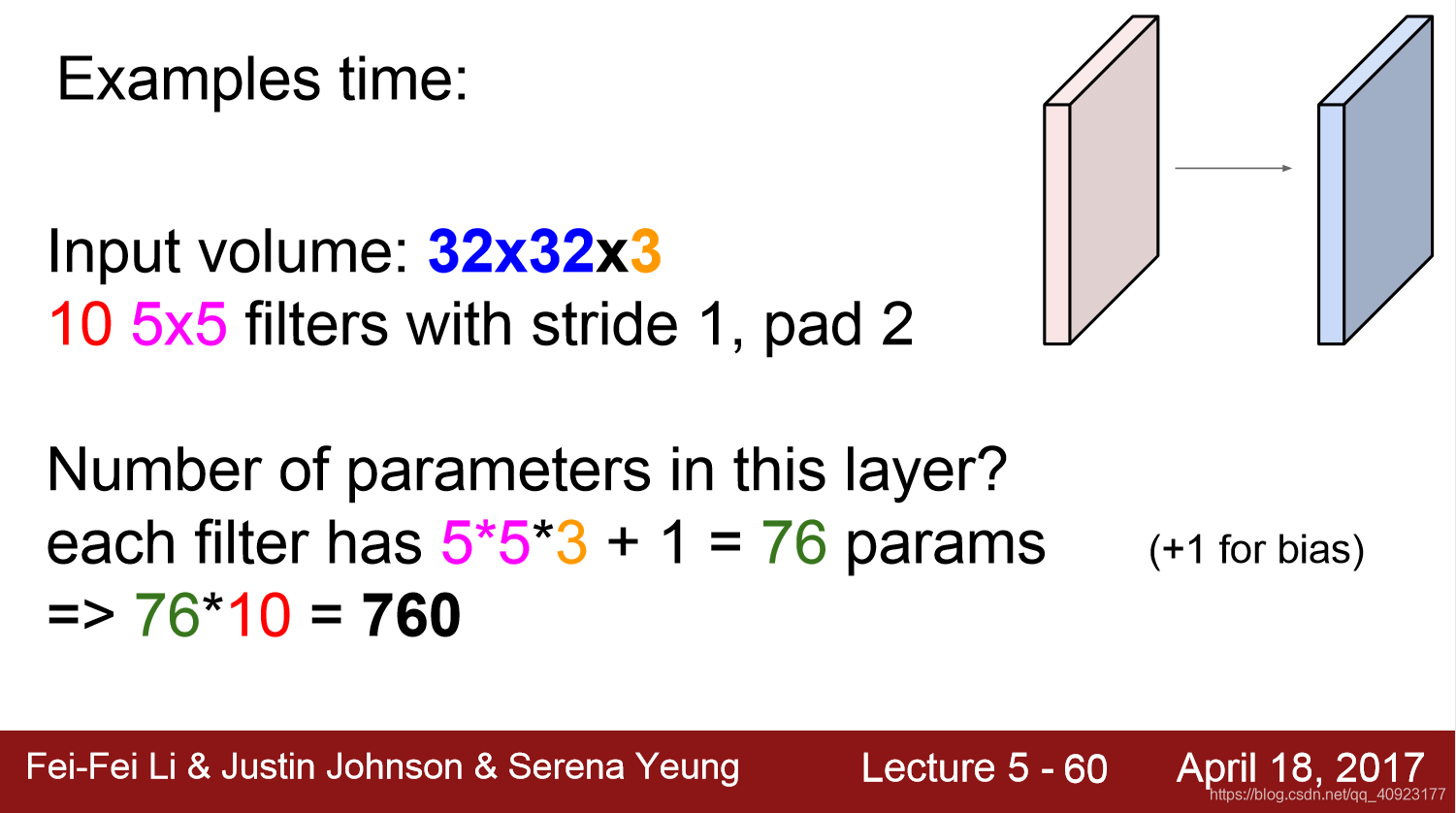

Q:如果一个输入是32*32*3,有10个5*5的卷积核,步长为1,在输入的上下左右各补两行零,那么输出图像的大小是多少?

A:根据上面的计算公式,补零后的N=32+2*2=36,F=5,所以(36-5)/1+1=32。又因为有10个卷积核,所以输出图像的深度为10。综上,输出的大小是32*32*10。

Q:输入的大小、卷积核的大小、步长和补零的个数都和上面的一样,那么这一层需要多少个参数呢?

A:每一个卷积核是5*5*3大小的,再加上一个偏置,所以,每个卷积核的参数为5*5*3+1=76个,总共有10个卷积核,所以总共的参数就是76*10=760个。

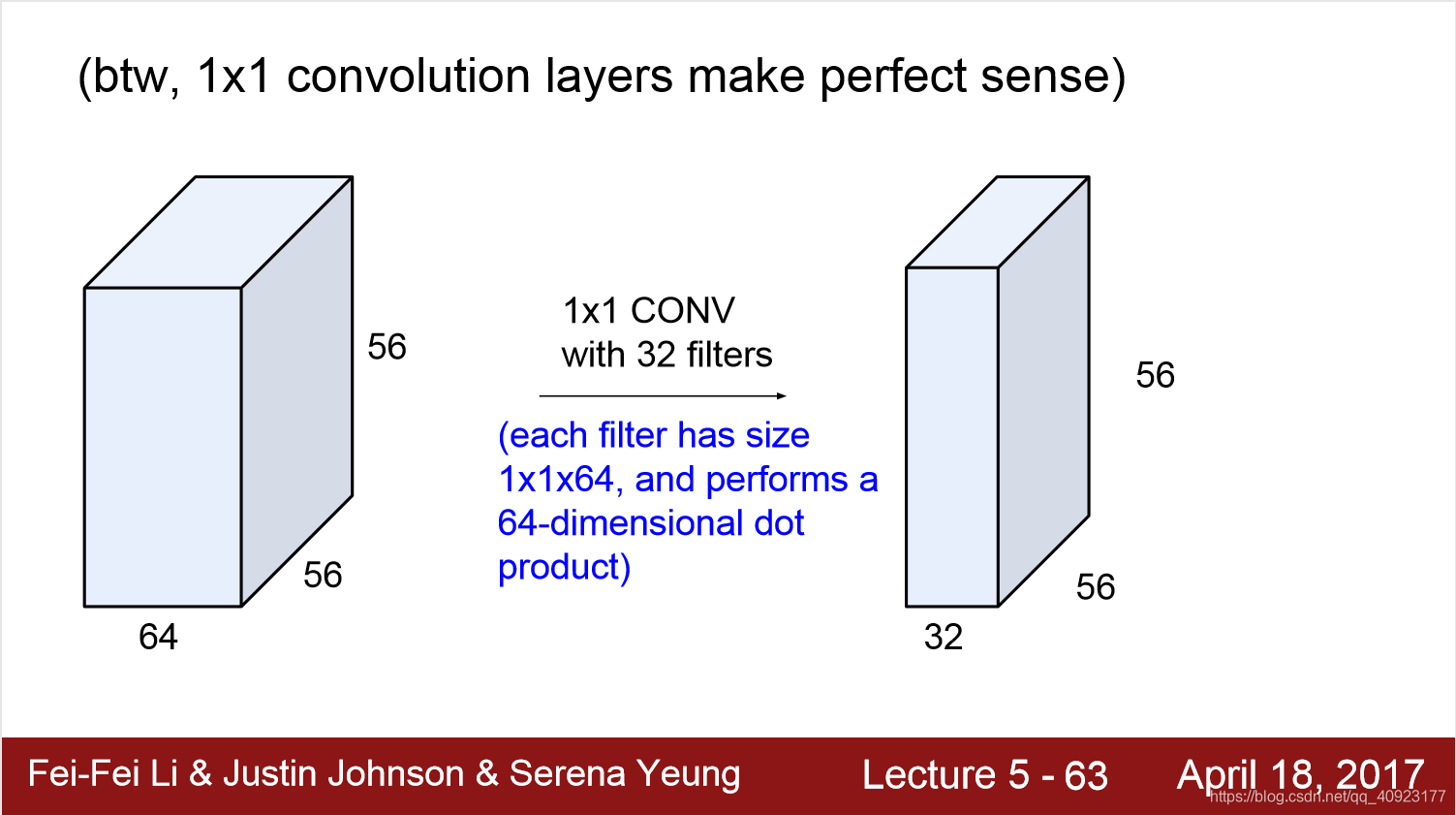

还可以考虑1*1大小的卷积核,它只考虑了各个特征的信息,没有考虑空间的信息。

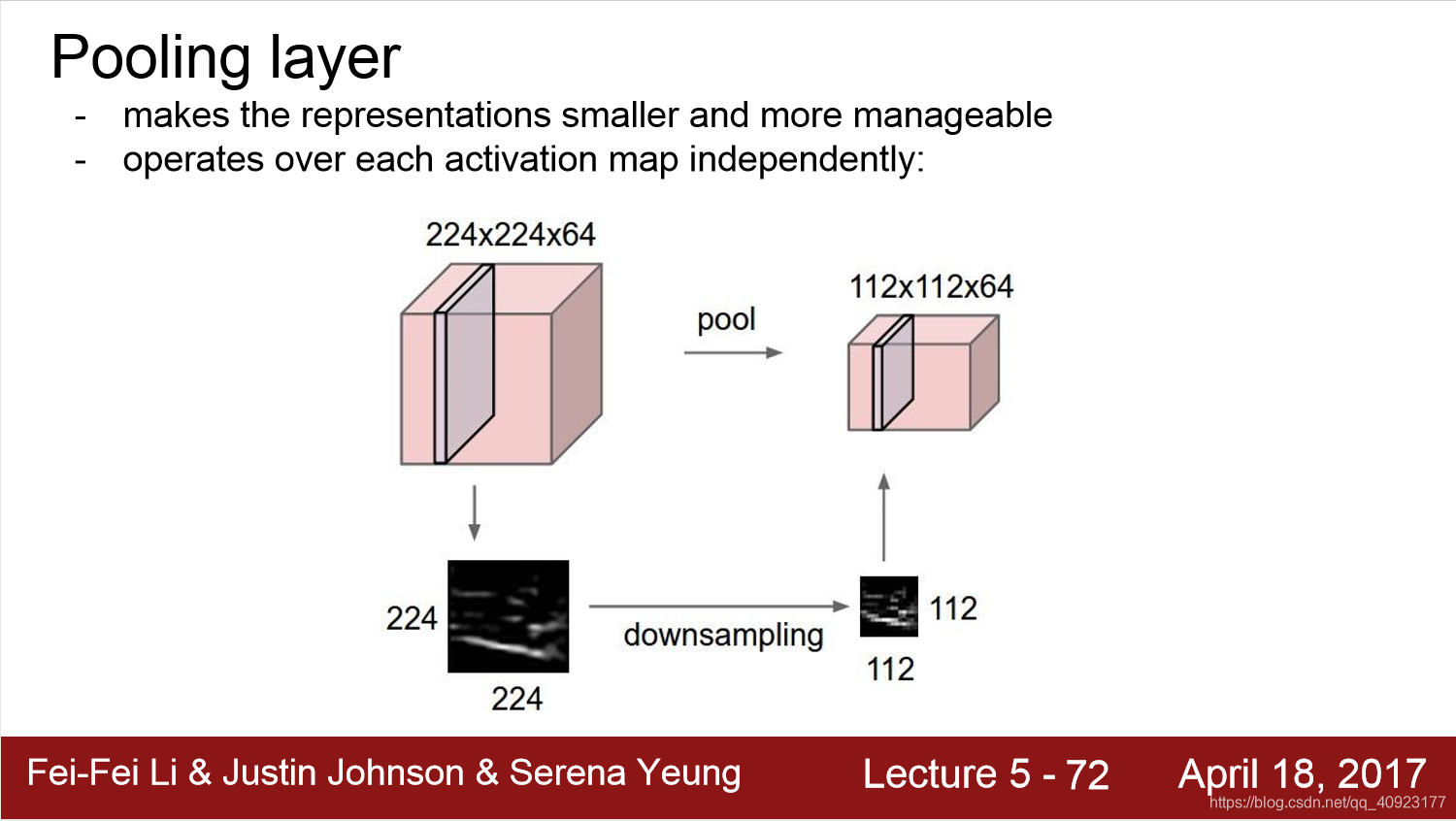

池化层相当于做下采样,它可以使输入的尺寸减少,保留比较有意义的信息。

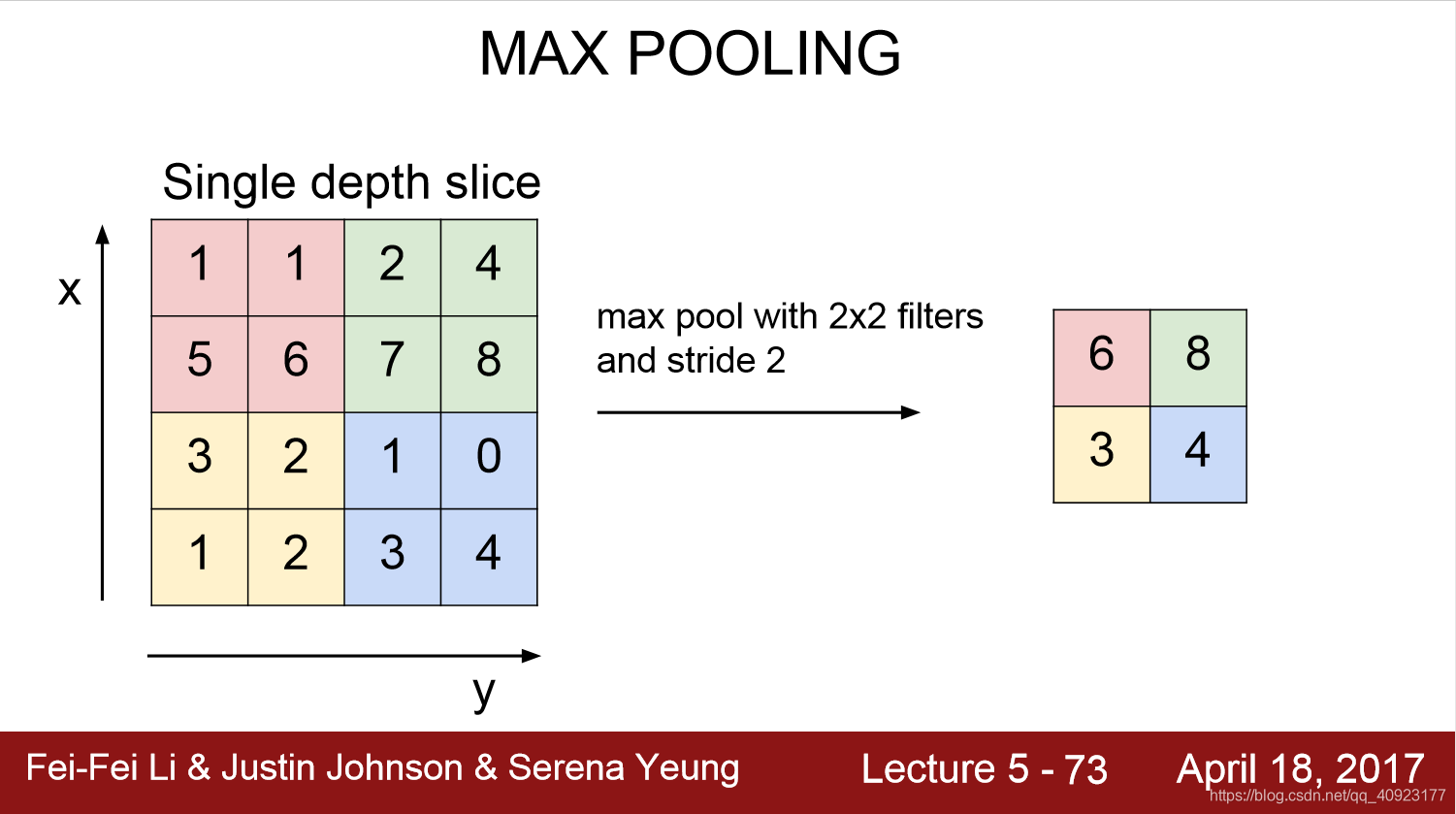

这是一个2*2核的最大池化的例子,保留每个2*2区域的最大值。

一般来说,池化层的步长都是和核的大小相同,也就是说,每次取最大值的区域是不重叠的。

经过多次卷积、激活、池化后,使用全连接层把所有特征都统一考虑,拿去做分类。

小结:

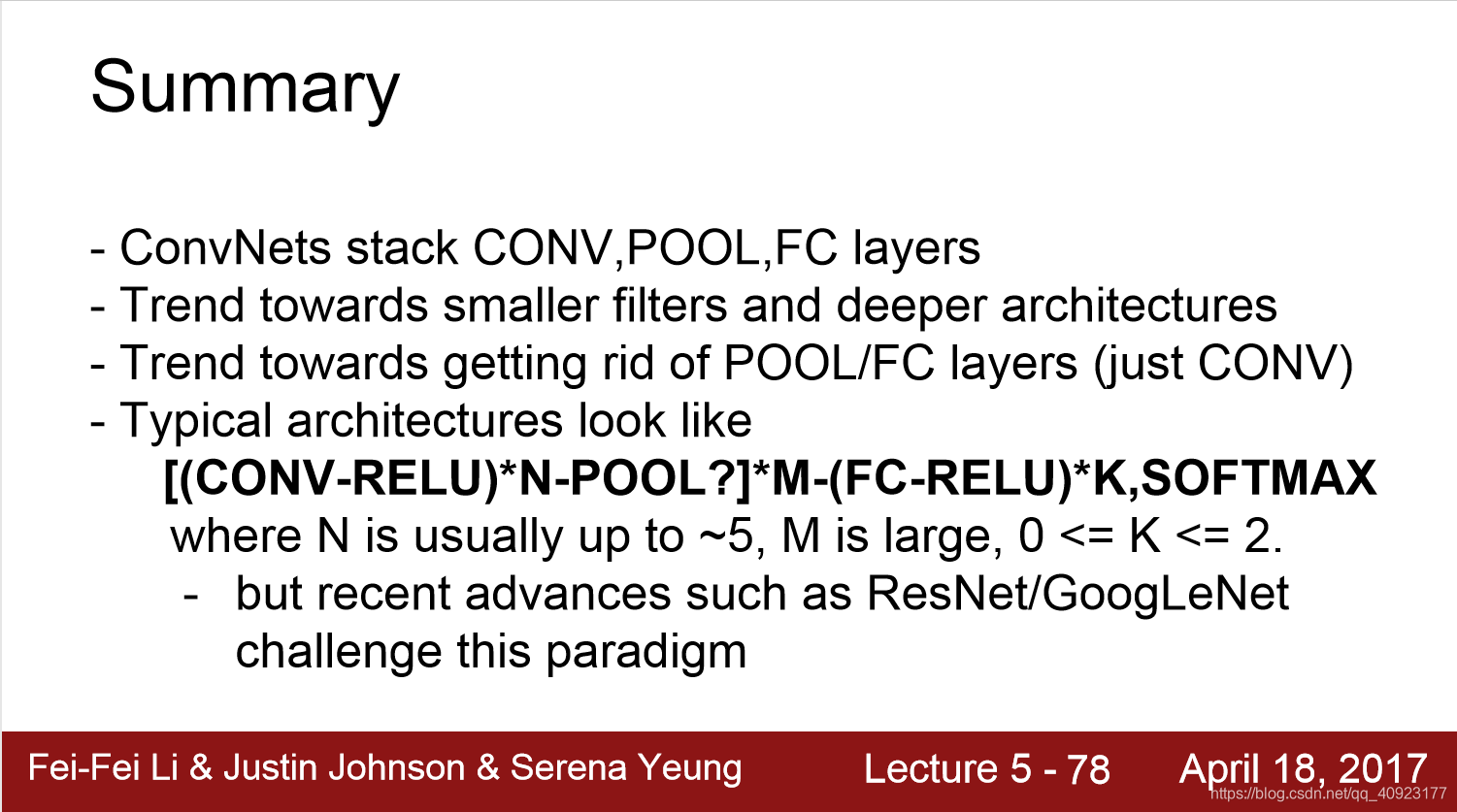

- 卷积网络由卷积层、池化层、全连接层堆叠起来

- 卷积网络是朝着更小的卷积核和更深的结构发展的

- 卷积网络是朝着全卷积网络发展的,也就是说没有池化层和全连接层,只有卷积层

- 比较典型的卷积网络结构是上图的样子,但是现在也有很多打破这种结构的卷积网络。

卷积神经网络(CNN)通过卷积层保留图像的空间特征,每个卷积核获取特定特征,形成激活图。网络从简单到复杂学习特征,用于分类。CNN框架包括卷积层、ReLU激活、池化层和全连接层。较低层捕获边缘等低阶特征,高层处理复杂特征。卷积层参数计算和池化层的作用也在介绍之中。

卷积神经网络(CNN)通过卷积层保留图像的空间特征,每个卷积核获取特定特征,形成激活图。网络从简单到复杂学习特征,用于分类。CNN框架包括卷积层、ReLU激活、池化层和全连接层。较低层捕获边缘等低阶特征,高层处理复杂特征。卷积层参数计算和池化层的作用也在介绍之中。

1068

1068

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?