在机器学习中,岭回归(Ridge Regression)是一种经典的线性回归改进方法,它通过引入正则化项来解决线性回归中可能出现的过拟合问题。

接下来,我们将详细推导岭回归的核心公式,帮助你深入理解其数学原理。

一、岭回归的基础原理

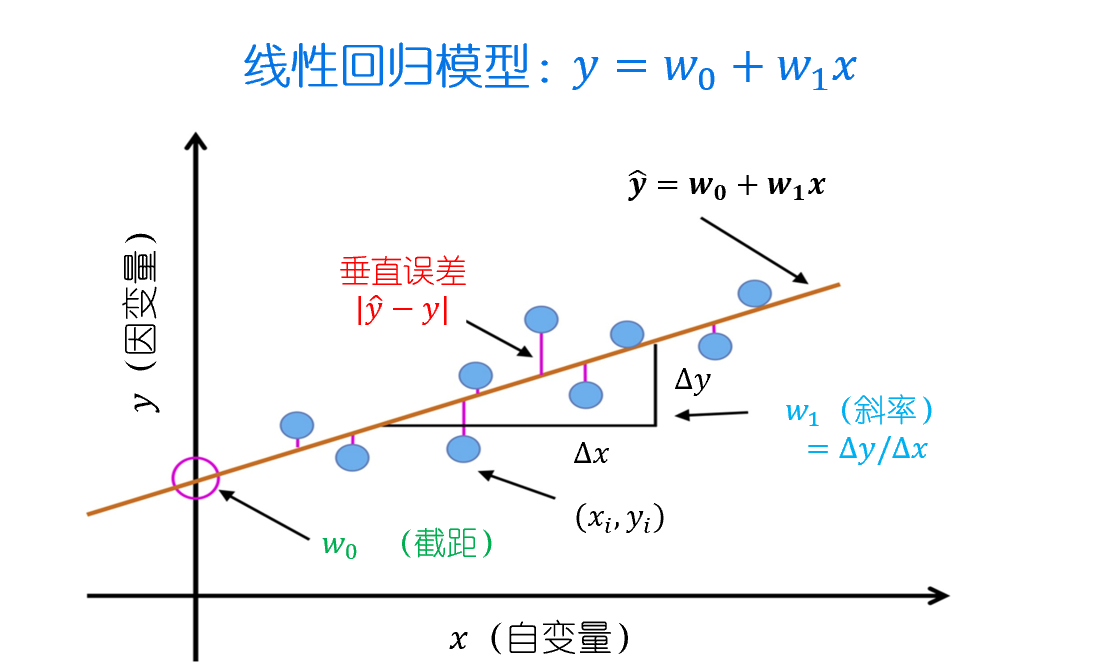

在推导“岭回归”数学公式之前,我们先回顾一下线性回归的基本概念。

线性回归的目标是找到一个权重向量 ω\omegaω,使得预测值 ωTxi\omega^T x_iωTxi 与真实值 yiy_iyi 之间的平方误差最小。

用数学公式表示就是:

J(ω)=∑i=1n(yi−ωTxi)2 J(\omega) = \sum_{i=1}^{n}(y_i - \omega^T x_i)^2 J(ω)=i=1∑n(yi−ωTxi)2

其中,yiy_iyi 是目标值,xix_ixi 是特征向量,ω\omegaω 是权重向量。

用矩阵形式表示,目标函数可以写成:

J(W)=(Y−XW)T(Y−XW) J(W) = (Y - XW)^T(Y - XW) J(W)=(Y−XW)T(Y−XW)

其中,YYY 是目标值向量,XXX 是特征矩阵,WWW 是特征矩阵。

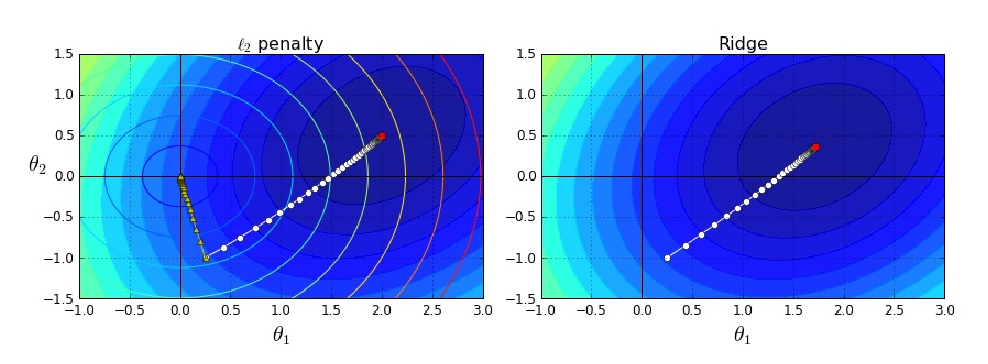

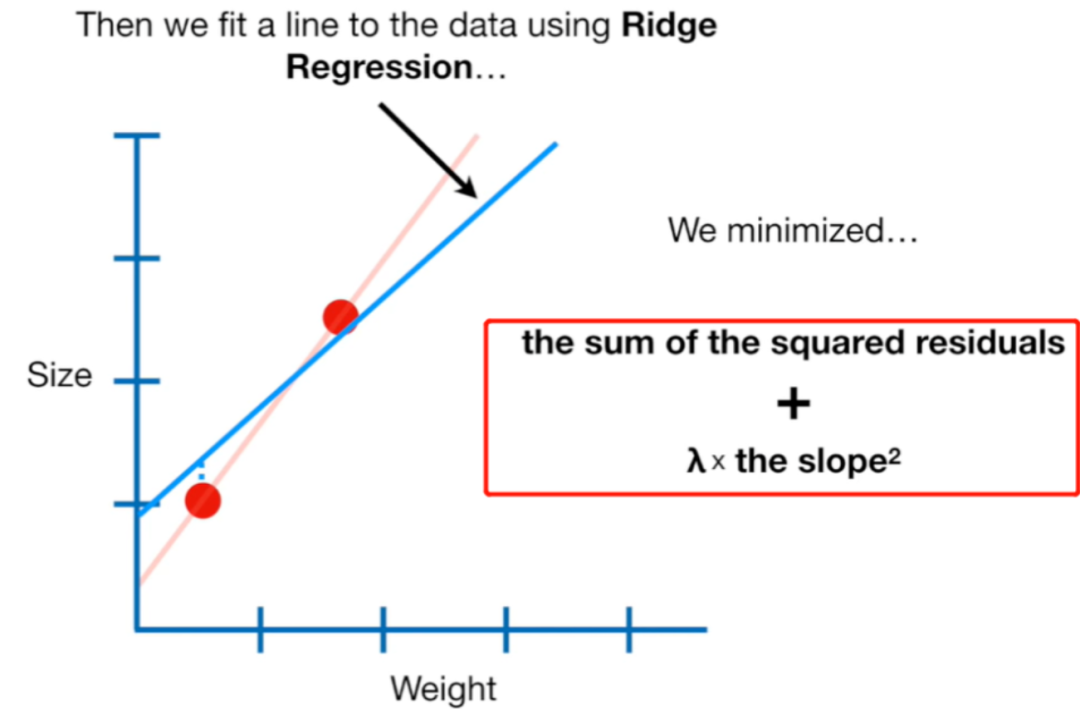

岭回归的核心思想是在最小二乘法的基础上引入一个正则化项,对模型的权重进行惩罚,使其不会过大,从而降低模型的复杂度。

岭回归的目标函数可以表示为:

J(ω)=∑i=1n(yi−ωTxi)2+λ∑j=1pωj2 J(\omega) = \sum_{i=1}^{n}(y_i -\omega^T x_i)^2 + \lambda \sum_{j=1}^{p}\omega_j^2 J(ω)=i=1∑n(yi−ωTx

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

3231

3231

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?