- 2023.12

- Dongchao Yang

- HKU & Microsoft & 浙大

abstract

- 一个LLM模型做11个音频任务

- token的类型:Phoneme,MIDI转成frame-f0,text【机器翻译模型提取的emb+T5】,Semantic Token【Hubert 9th layer-kmeans】

- 模型的缺点:同时有多种任务,数据的质量不能保证;可能会引入错误;

- 1B 的模型size

- 基于各种audio 数据,重新训练的codec,优化了判别器;基于自己的模型,8个码本 的效果更好;

method

- 多模态的特征先token化,最终的输出都是音频特征;

- global transformer + local transformer的结合体:

- 假设音频编码3个码本,global 先预测sum的结果,local 预测1/2/3级结果;3级结果sum之后,和之前的特征一起作为global 的condition;

- 码本越多,还原的音频质量越高;但是码本越长,AR建模越难,而且内存占用越高;这样的设计可以达到很好的trade off;

experiment

- 基于7个音频任务预训练,4个任务finetune;

- finetune之后的模型在预训练7个任务上,和基座模型没有太明显的差异;【finetune 也是一种数据增广的方式】

- finetune 过程,特定任务训练数据的重采样系数 α = 0.05;top-k=30,temperature=0.8。因为global 不直接预测结果,采样只在local transformer中发生。

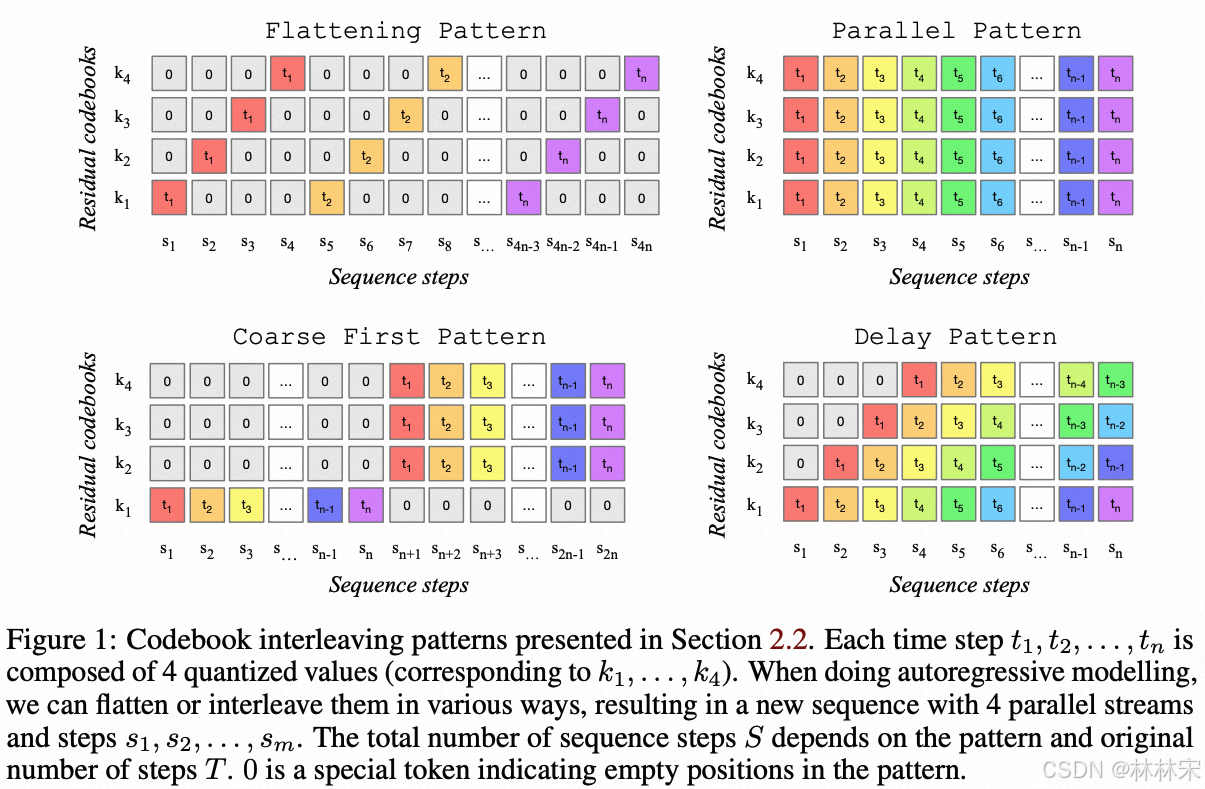

几种不同的AR预测方式对比

- parallel:多个码本一起单步推理;

- corse first:valle的结构,先自回归推第一级码本,然后并行依次推理剩下的多级码本;

- flattening:多级码本flattening,ar依次推理;

- delay pattern:和flatten 推理比较像,每次推4个码本,从s11,s21,…sn1,每次新增一个;然后推第二级码本;

- flatten 比parallel, coarse first, and delay prediction的生成质量都好; - global+local的方式,和flatten 达到相当级别的生成质量,同时时间复杂度大大降低,从

O

(

T

∗

N

)

2

O(T*N)^2

O(T∗N)2降低至

O

(

T

)

2

O(T)^2

O(T)2

- flatten 比parallel, coarse first, and delay prediction的生成质量都好; - global+local的方式,和flatten 达到相当级别的生成质量,同时时间复杂度大大降低,从

O

(

T

∗

N

)

2

O(T*N)^2

O(T∗N)2降低至

O

(

T

)

2

O(T)^2

O(T)2

数据集

46

46

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?