MaxCompute数据导入导出

MaxCompute提供多种数据导入导出方式,如下所示:

- 直接在客户端使用Tunnel命令。

- 通过MaxCompute Studio工具可视化方式实现本地数据文件导入导出,详情请参见导入导出数据。

- 通过Tunnel提供的SDK自行编写Java工具。

- 通过Flume及Fluentd插件方式导入。

- 通过DataWorks对数据导入和导出,详情请参见数据集成概述。

导出数据请参见Tunnel命令操作中Download的相关命令。

1.Tunnel命令导入数据

1.准备数据

假设您已准备本地文件wc_example.txt,本地存放路径为D:\odps\odps\bin,内容如下:

I LOVE CHINA!MY NAME IS MAGGIE.

I LIVE IN HANGZHOU!I LIKE PLAYING BASKETBALL!

2.创建MaxCompute表

您需要把上面的数据导入到MaxCompute的一张表中,所以需要创建MaxCompute表。

CREATE TABLE wc_in (word string);

3.执行tunnel命令

输入表创建成功后,可以在MaxCompute客户端输入Tunnel命令进行数据的导入,如下所示:

tunnel upload D:\odps\odps\bin\wc_example.txt wc_in;

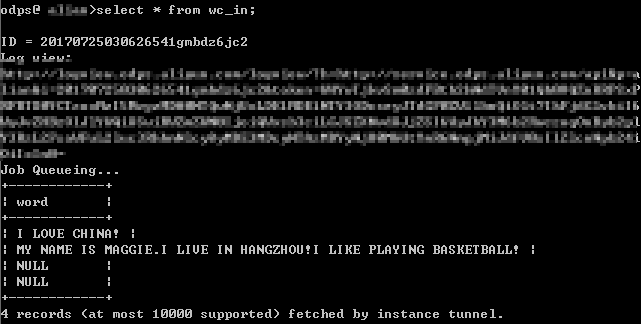

4.执行成功后,查看表wc_in的记录

说明

(1)有关Tunnel命令的更多详细介绍,例如如何将数据导入分区表等,请参见Tunnel操作。

(2)当表中含有多个列时,可以通过-fd参数指定列分隔符。

2.MaxCompute Studio导入数据

在使用MaxCompute Studio导入数据前,您需要先安装MaxCompute Studio,并配置项目空间链接。

1.准备数据

假设依然是该本地文件wc_example.txt,本地存放路径为D:\odps\odps\bin

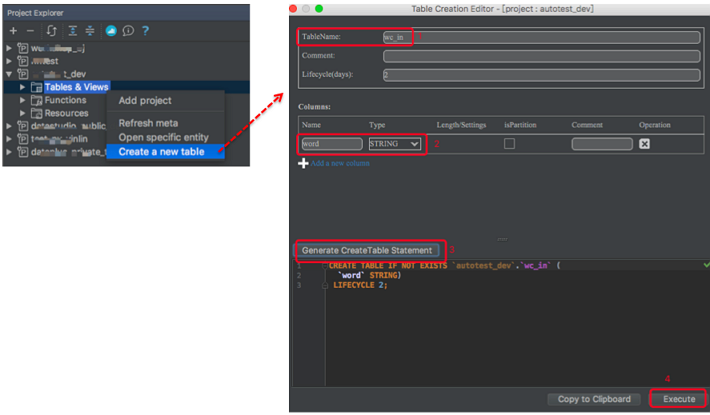

2.创建MaxCompute表

您需要把上面的数据导入到MaxCompute的一张表中,所以需要创建MaxCompute表。右键单击项目的 tables&views列表:

执行成功,则建表成功。

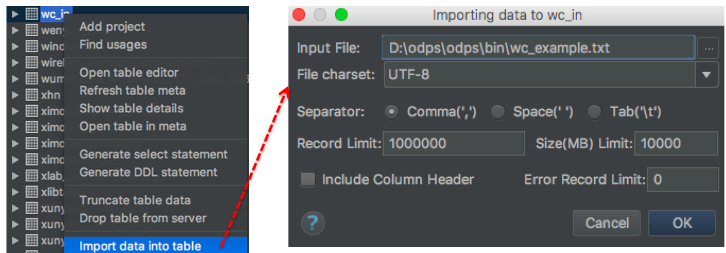

3上传数据文件

右键单击tables&views列表中新建的表wc_in

3.Tunnel SDK

具体略:主要通过java对Tunnel源文件进行修改以及配置pom.xml文件

4.其他导入方式

除了通过客户端及Tunnel Java SDK导入数据,阿里云数加数据集成、开源的Sqoop、Fluentd、Flume、LogStash 等工具都可以进行数据导入到MaxCompute,详情请参见数据上传下载-工具介绍。

详细介绍请见

https://help.aliyun.com/document_detail/27809.html?spm=a2c4g.11186623.6.578.14502185gwthBb

本文介绍了MaxCompute数据导入导出的方法,包括Tunnel命令、MaxComputeStudio工具、TunnelSDK等方式。此外还提到了Flume及Fluentd插件、DataWorks等其他工具的使用。

本文介绍了MaxCompute数据导入导出的方法,包括Tunnel命令、MaxComputeStudio工具、TunnelSDK等方式。此外还提到了Flume及Fluentd插件、DataWorks等其他工具的使用。

1074

1074

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?