🎯 写在前面

最近在用 Claude Code 做开发时,相信很多同学都遇到了镜像站频繁被封的问题。作为一名 AI-Java 开发者,我深知这种痛苦——正写着代码突然就连不上了!

今天给大家分享一个神器:Claude Code Router,它能让你的 Claude Code 请求路由到不同的模型,彻底解决镜像封锁问题。

✨ 核心功能一览

Claude Code Router 不只是简单的代理,它提供了完整的解决方案:

- 🔄 智能模型路由:根据任务类型自动选择最合适的模型

- 🌐 多提供商支持:支持 OpenRouter、DeepSeek、Ollama、Gemini、火山引擎、硅基流动等

- ⚡ 请求/响应转换:为不同提供商定制化适配

- 🎛️ 动态模型切换:在 Claude Code 中用

/model命令实时切换 - 🔧 GitHub Actions 集成:工作流程中也能触发 Claude Code 任务

- 🧩 插件系统:支持自定义转换器扩展

🚀 快速上手指南

第一步:环境准备

首先确保你已经安装了 Claude Code:

npm install -g @anthropic-ai/claude-code

然后安装我们的主角:

npm install -g @musistudio/claude-code-router

第二步:配置文件设置

这里有个小坑要注意!系统默认会在 ~/.claude-code-router/ 路径下寻找配置文件,但这个文件夹可能不存在。

解决方法:先手动创建这个文件夹,然后创建 config.json 文件。

配置文件详解

下面是一个完整的配置示例,记得把 api_key 替换成你自己的:

{

"LOG": true,

"CLAUDE_PATH": "",

"HOST": "127.0.0.1",

"PORT": 3456,

"APIKEY": "123",

"API_TIMEOUT_MS": "600000",

"PROXY_URL": "http://127.0.0.1:7890",

"Transformers": [],

"Providers": [

{

"name": "gemini",

"api_base_url": "https://generativelanguage.googleapis.com/v1beta/models/",

"api_key": "xxx-xx",

"models": [

"gemini-2.5-flash",

"gemini-2.5-pro"

],

"transformer": {

"use": ["gemini"]

}

},

{

"name": "volcengine",

"api_base_url": "https://ark.cn-beijing.volces.com/api/v3/chat/completions",

"api_key": "xxx",

"models": [

"kimi-k2-250711",

"doubao-seed-1-6-thinking-250715",

"doubao-seed-1-6-250615",

"doubao-seed-1-6-flash-250715",

"deepseek-r1-250528"

],

"transformer": {

"use": ["doubao"]

}

},

{

"name": "siliconflow",

"api_base_url": "https://api.siliconflow.cn/v1/chat/completions",

"api_key": "sk-xxx",

"models": [

"zai-org/GLM-4.5",

"zai-org/GLM-4.5-Air",

"Pro/moonshotai/Kimi-K2-Instruct",

"Qwen/Qwen3-Coder-30B-A3B-Instruct",

"Qwen/Qwen3-Coder-480B-A35B-Instruct"

],

"transformer": {

"use": [

[

"maxtoken",

{

"max_tokens": 65536

}

]

]

}

}

],

"Router": {

"default": "siliconflow,Pro/moonshotai/Kimi-K2-Instruct",

"background": "siliconflow,Qwen/Qwen3-Coder-30B-A3B-Instruct",

"think": "siliconflow,zai-org/GLM-4.5",

"longContext": "gemini,gemini-2.5-pro",

"longContextThreshold": 60000,

"webSearch": "gemini,gemini-2.5-flash"

}

}

💡 小贴士:如果你没有某个模型提供商的 API Key,直接删除对应的 JSON 块即可。

第三步:启动服务

配置完成后,用以下命令启动:

ccr code

重要提醒:每次修改配置文件后,记得重启服务:

ccr restart

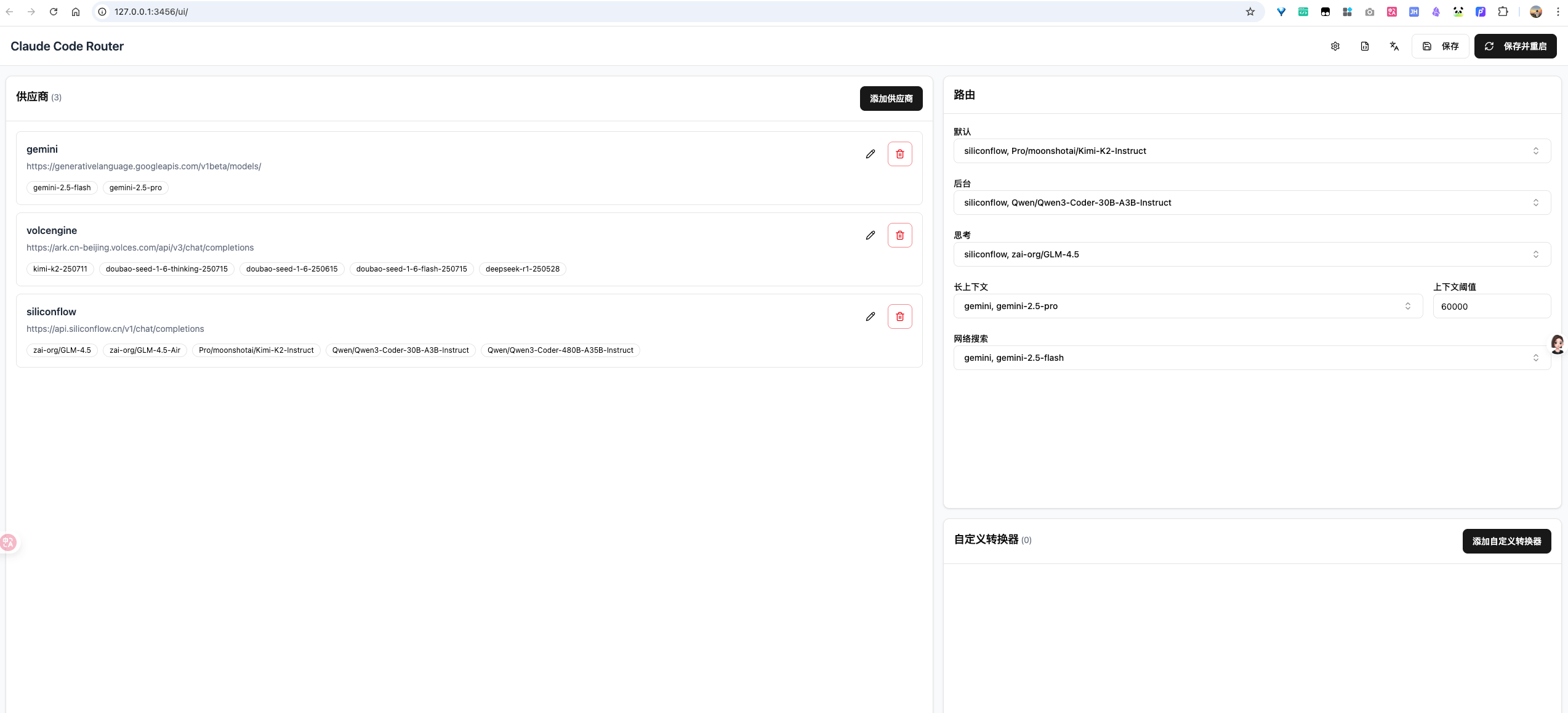

🎨 UI 管理界面(强烈推荐)

对于不喜欢手动编辑 JSON 的同学,Claude Code Router 提供了可视化管理界面:

ccr ui

这会打开一个基于 Web 的界面,让配置管理变得超级简单!

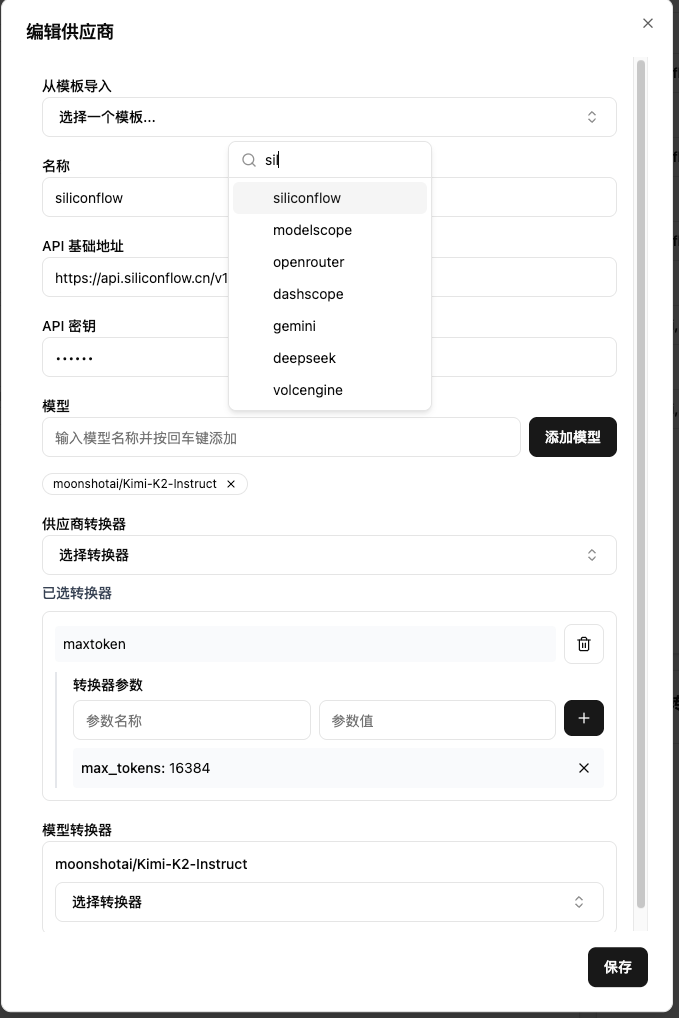

添加新的模型提供商

在 UI 界面中,点击【添加供应商】按钮:

选择你要使用的提供商,这里以硅基流动为例:

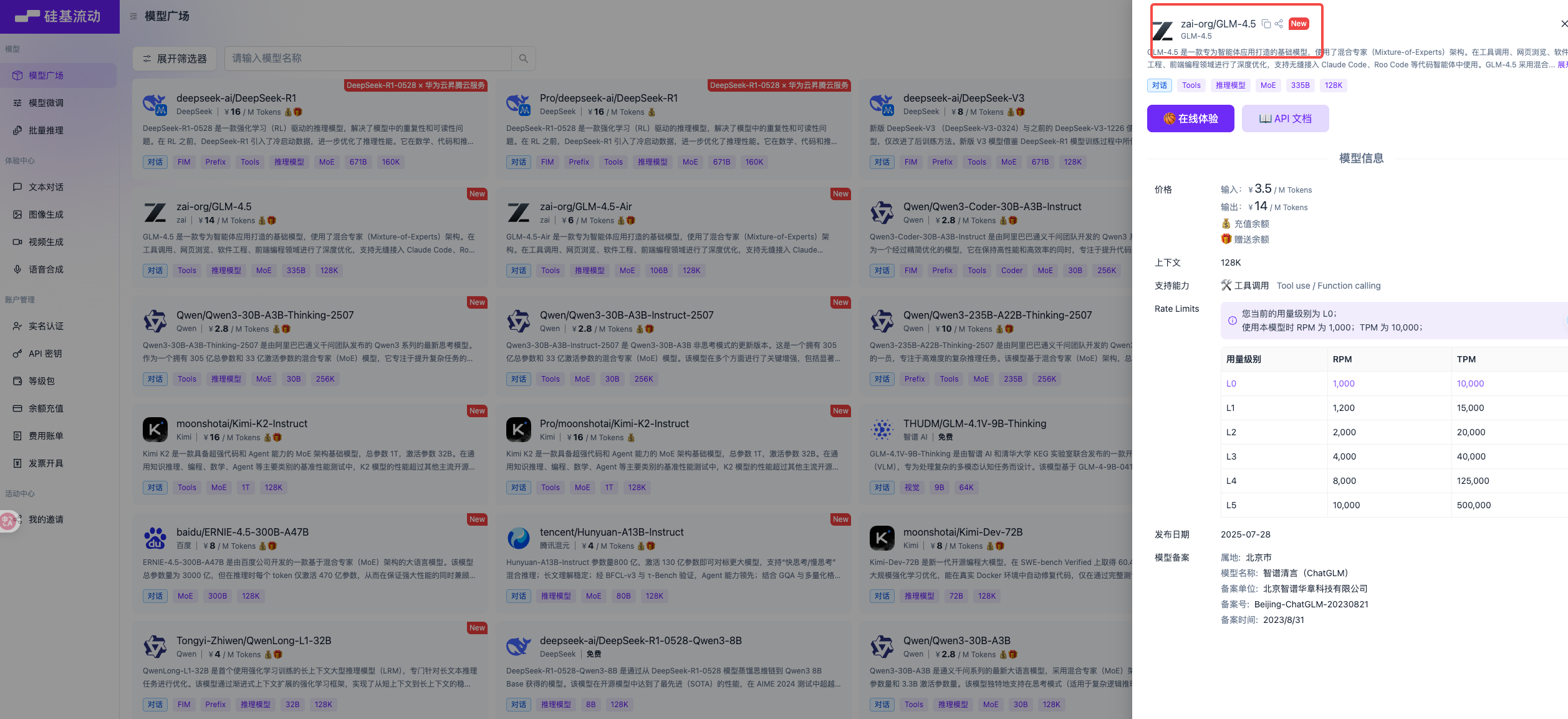

选择合适的模型

访问 硅基流动模型广场,选择你需要的模型。比如我选择 GLM-4.5,复制模型标识 zai-org/GLM-4.5:

填入相关信息后点击【保存】即可。

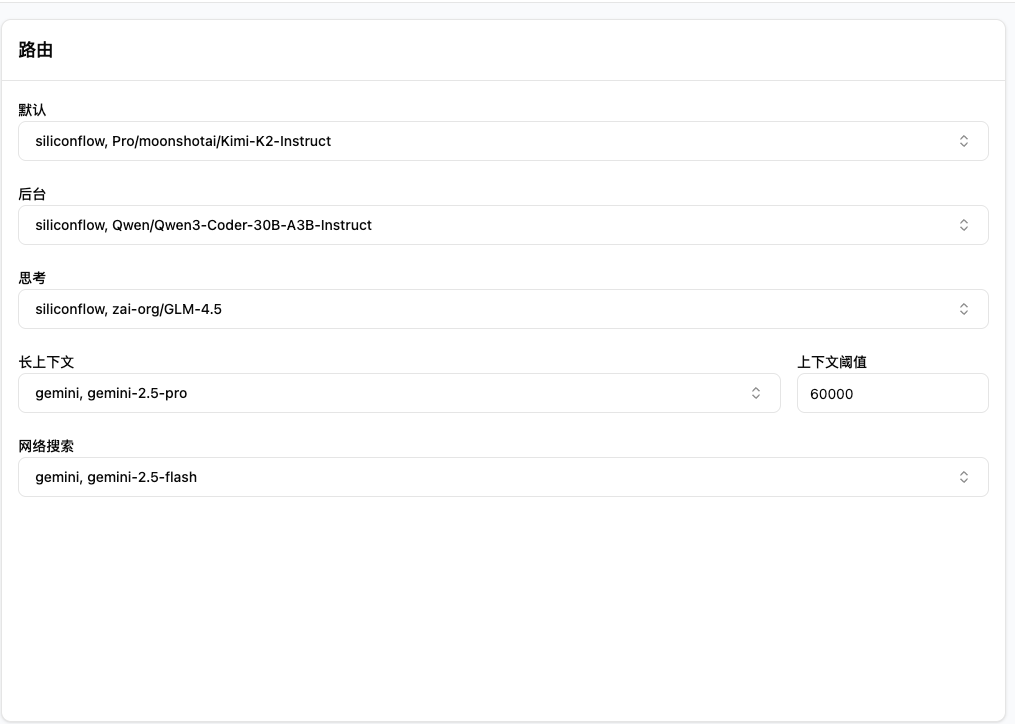

路由配置管理

在页面右侧,你可以管理不同场景下的模型路由:

路由类型说明

default:日常开发的默认模型,建议选择平衡性能和成本的模型background:后台任务专用,可以选择成本较低的模型think:推理密集型任务(如架构设计、复杂逻辑),需要强推理能力的模型longContext:处理长文档、大型代码库时使用longContextThreshold:触发长上下文模型的阈值(默认 60000 tokens)webSearch:网络搜索任务,需要模型本身支持联网功能

配置完成后,点击右上角的【保存并重启】:

你还可以导出配置文件,方便在其他机器上复用。

🎉 实战效果

配置完成后,你的 Claude Code 就能:

- 智能切换模型:根据任务复杂度自动选择最合适的模型

- 成本优化:简单任务用便宜模型,复杂任务用强力模型

- 稳定可靠:多个提供商备份,再也不怕镜像被封

- 性能提升:不同任务类型匹配最优模型

📚 写在最后

Claude Code Router 不仅解决了镜像封锁问题,更是为我们提供了一套完整的 AI 开发工具链管理方案。通过合理的路由配置,我们可以在保证开发效率的同时,有效控制成本。

项目地址:https://github.com/musistudio/claude-code-router

🔥 关注我,获取更多 AI 开发干货

我是 Channing,专注 AI-Java 开发,定期分享:

- 🤖 AI 前沿技术解析

- 💻 实用开发工具推荐

- 🛠️ 项目实战经验分享

- 📚 技术踩坑与解决方案

如果这篇文章对你有帮助,点赞 + 收藏 + 关注 三连支持一下!你的支持是我持续创作的动力 💪

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?