【AIGC】dify+ragflow+ollama构建个人知识库

环境配置参考:

【AIGC】Win10系统极速部署Docker+Ragflow+Dify

本文着重讲配置部分。

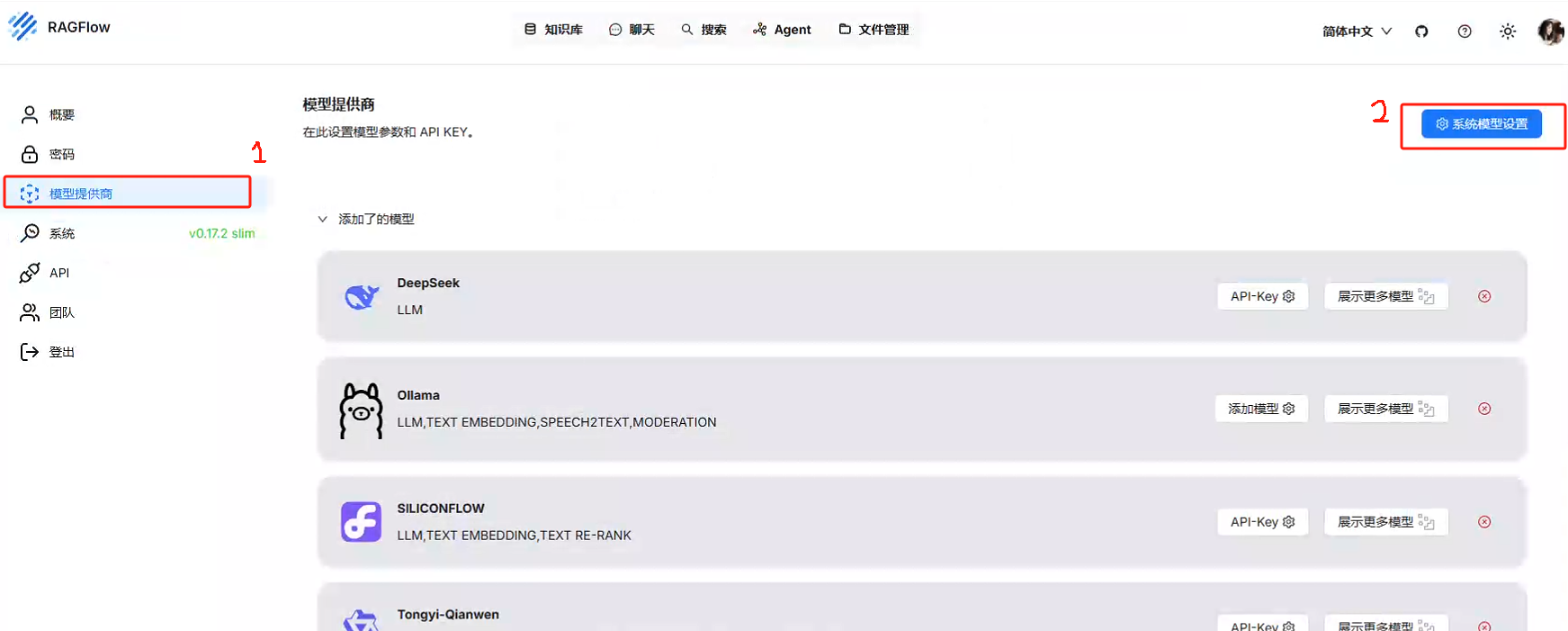

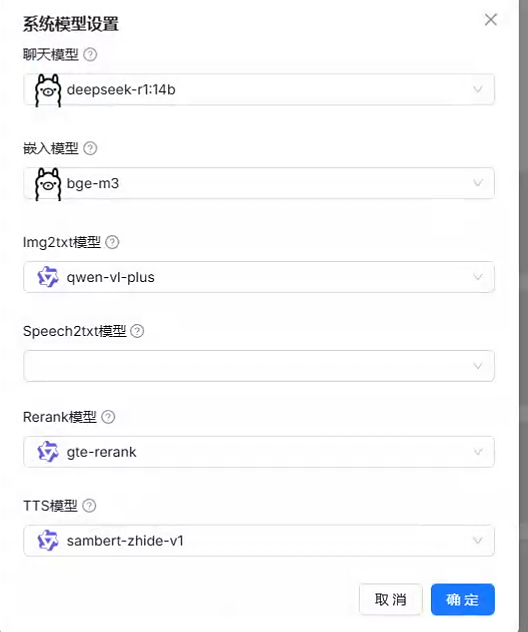

一、给ragflow配置大模型

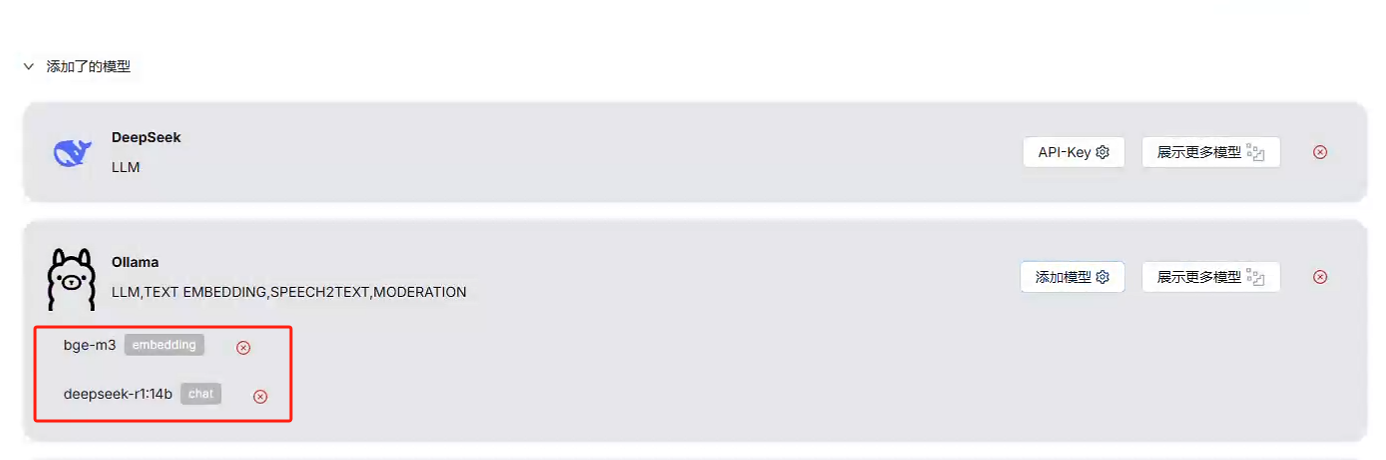

注意,slim版没有预装模型,full版有预装。缺少模型就在下面添加引用。

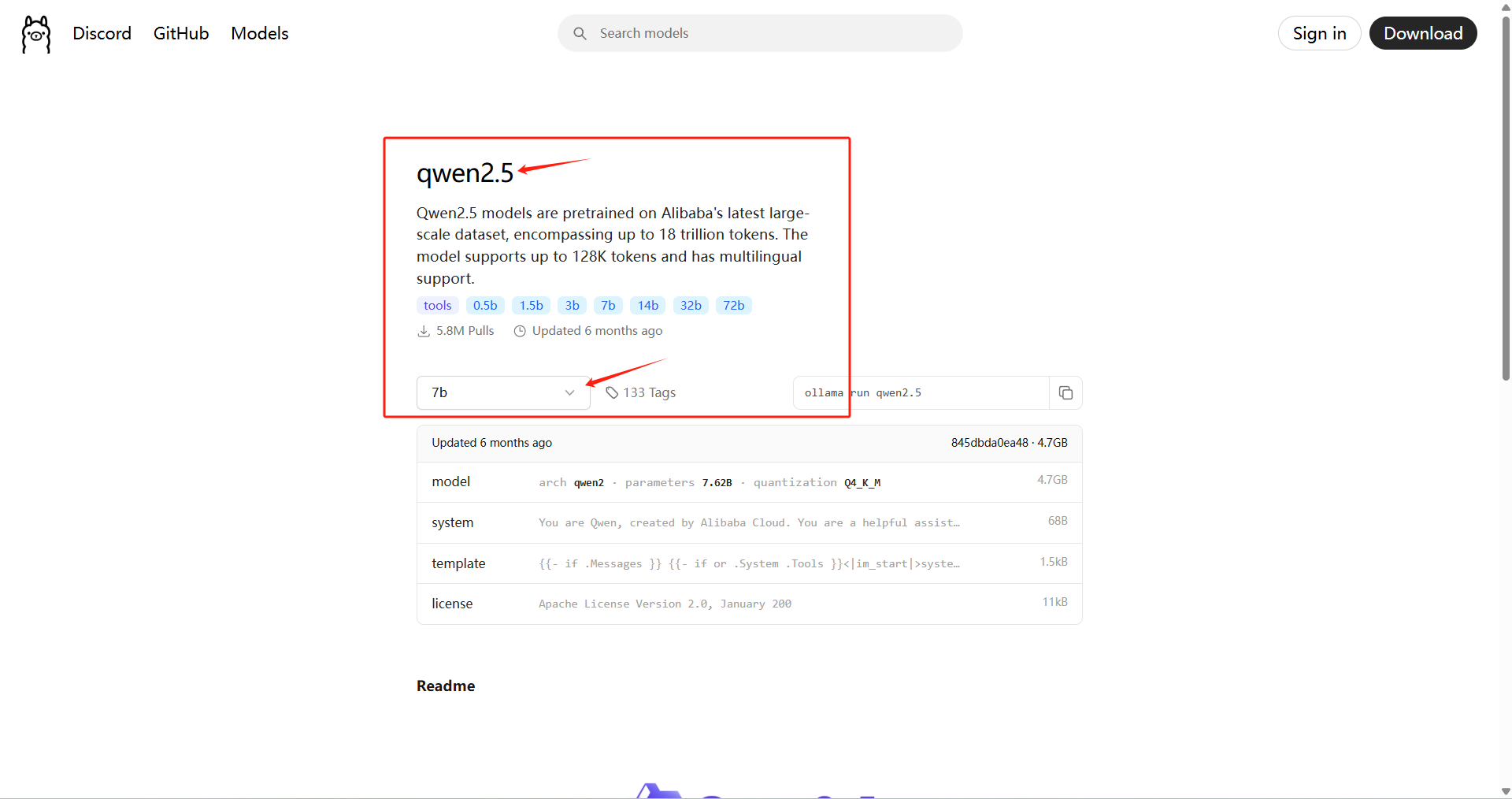

普通机器推荐安装以下两个模型:

具体安装的模型名称和版本,参考ollama官网提供的模型参数:

如果dify在docker里,ollama在docker外,则参考这个地址引用ollama模型:http://host.docker.internal:11434

二、数据入库

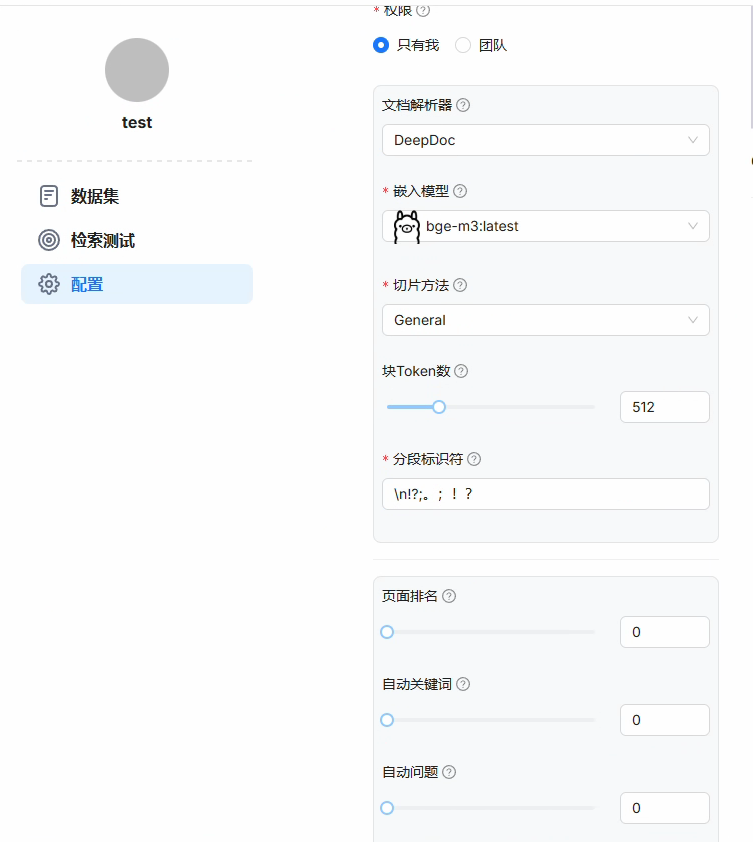

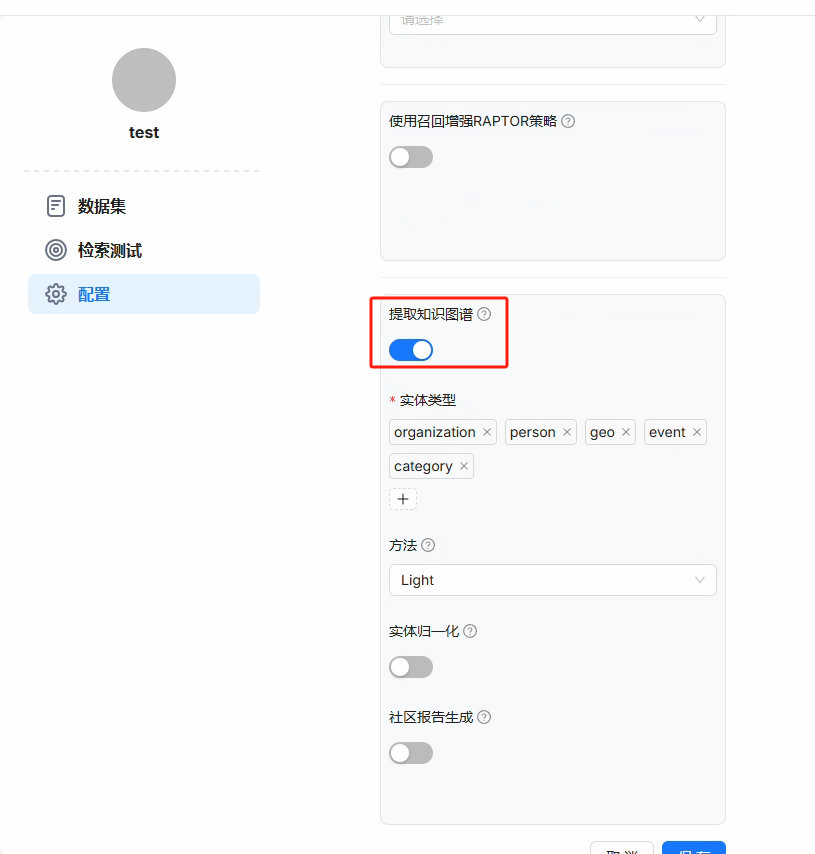

1.在ragflow中,进行知识入库配置

根据不同的文件类型,可以选择不同的模型和切片方法。

尽量开启知识图谱检索,会显著提升检索效果。

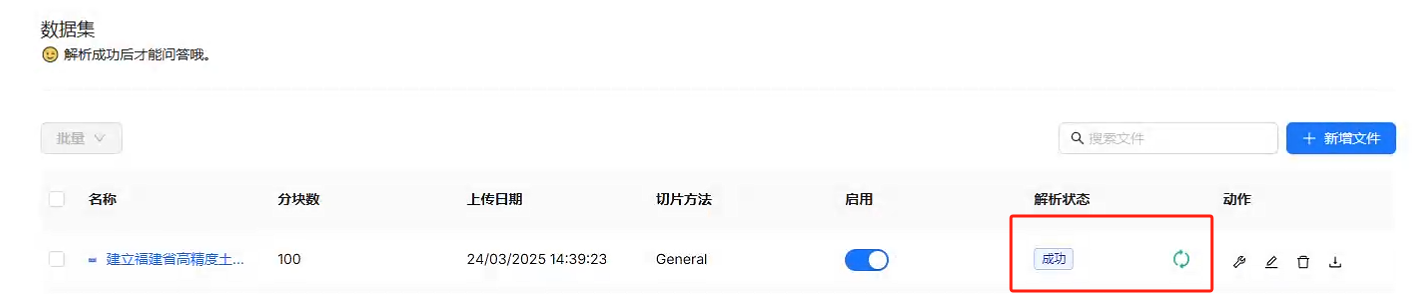

2.数据入库解析

导入数据,确保解析状态为成功,即可进行检索。

三、将ragflow关联到dify

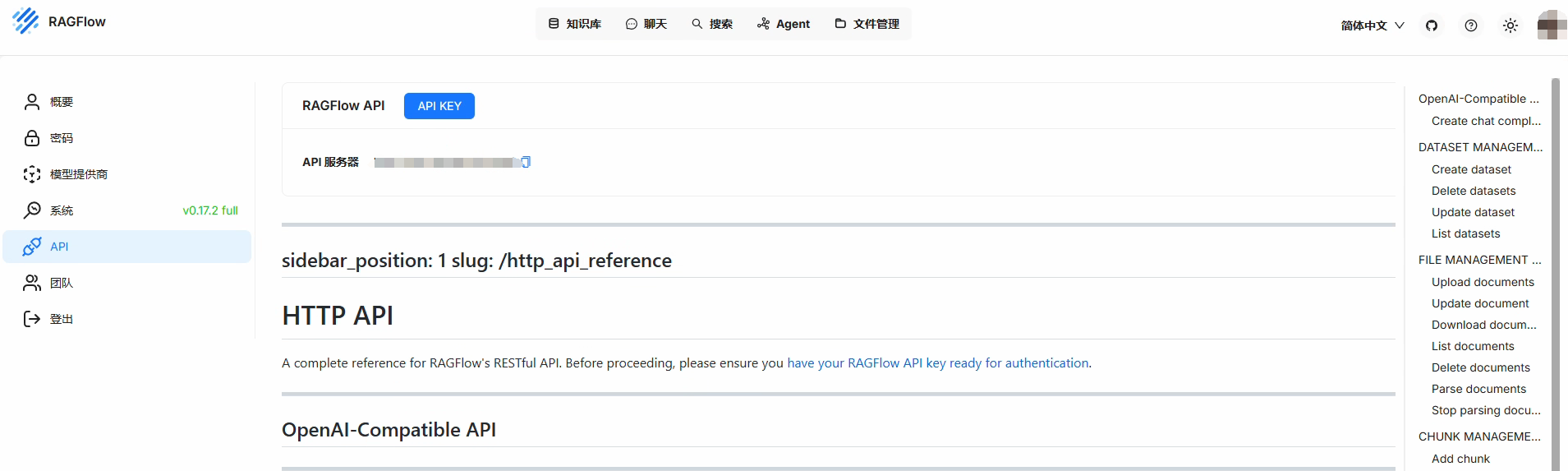

1.到ragflow中获取秘钥

点击创建新秘钥,并复制出来。

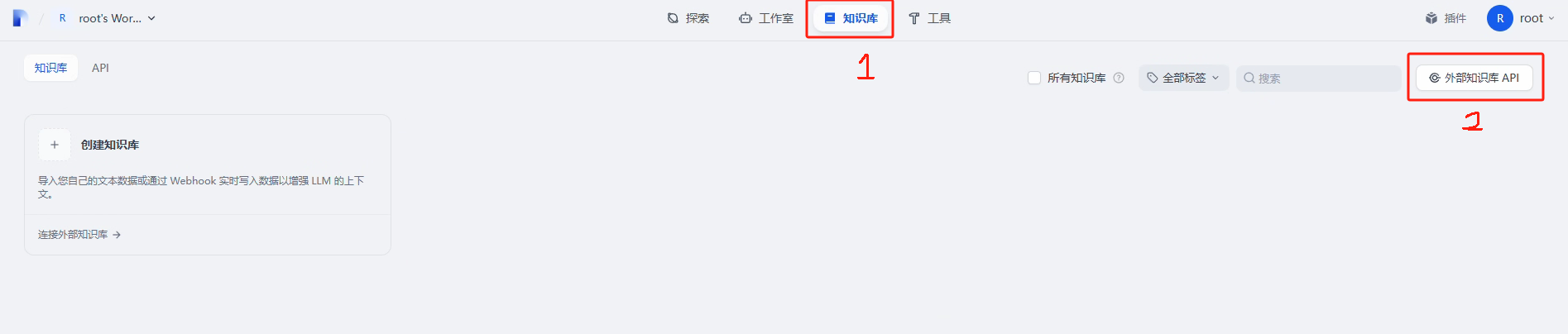

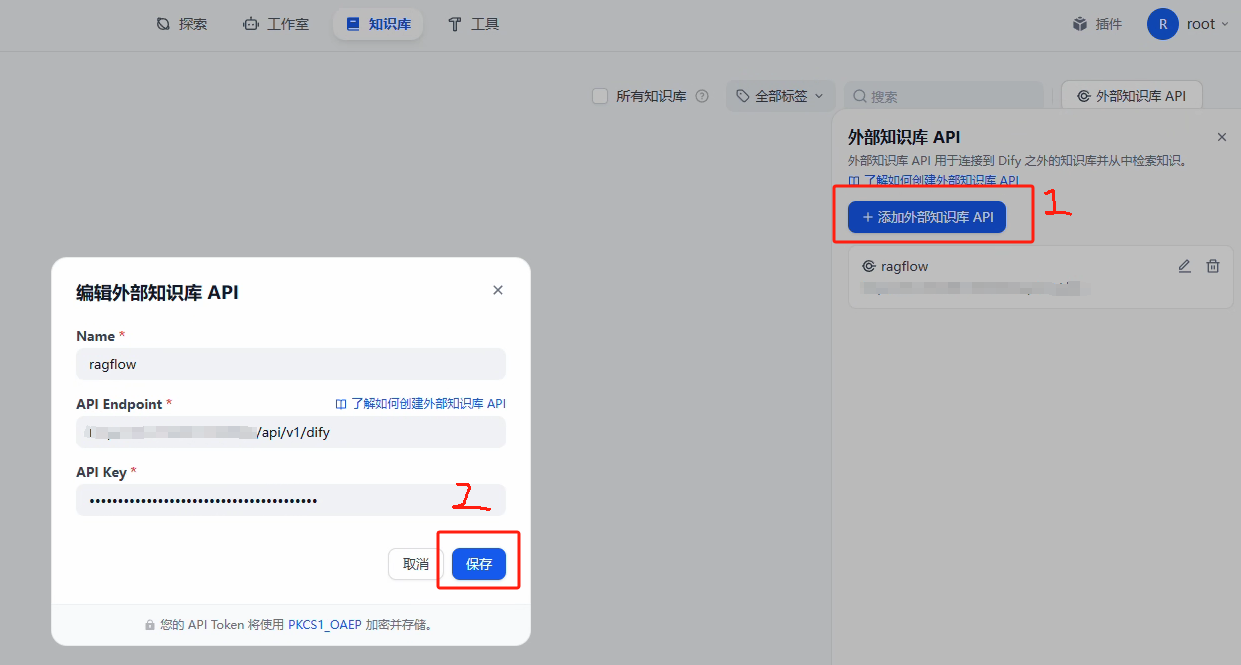

2.到dify中关联外部知识库api

将刚刚获取的秘钥输入进来

其中endpoint填写ragflow的访问地址+/api/v1/dify

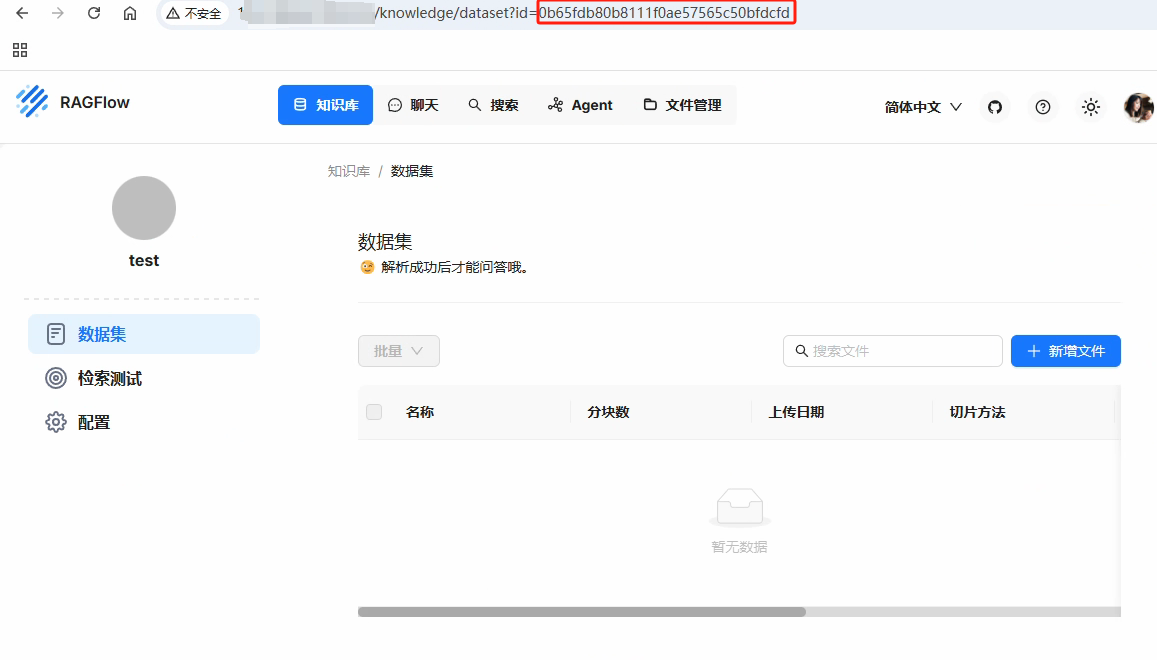

3.到ragflow中获取知识库id

4.在dify中链接外部知识库

填入刚刚获取的知识库id,并输入名称和描述。

四、在dify工作流中引用知识库

添加知识库引用。

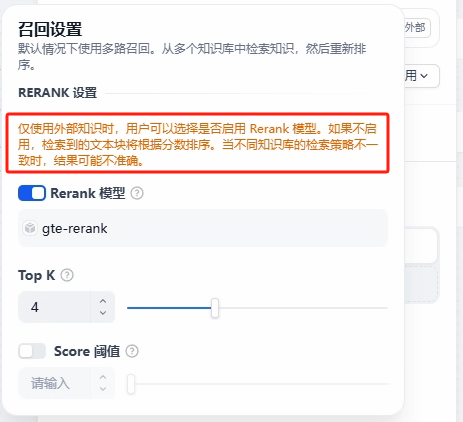

如果没有绑定rerank模型,导入知识库后需要关闭这个功能。

五、输出回答效果优化

1.提升大模型level

尽量选择更智能的LLM,并通过提示词严格限制不能杜撰虚构。

2.工作流的形式做分类处理

- 面向不同的文件和内容

- 区分简单检索和理解性工作

- 区分需要二次加工的数据(例如语音和图文)

- 区分不同的主题来检索不同的知识库,或组合检索。

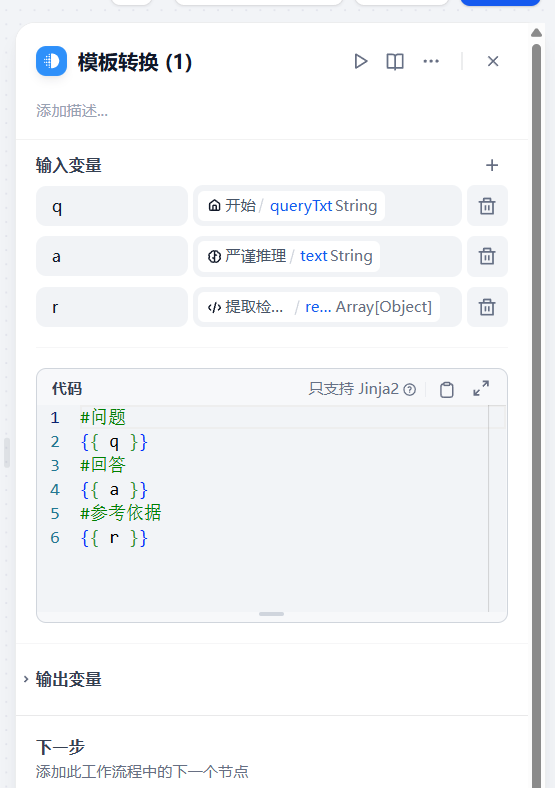

3.模板化输出

让大模型输出回答和引用内容,帮助用户确认回答的准确性。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?