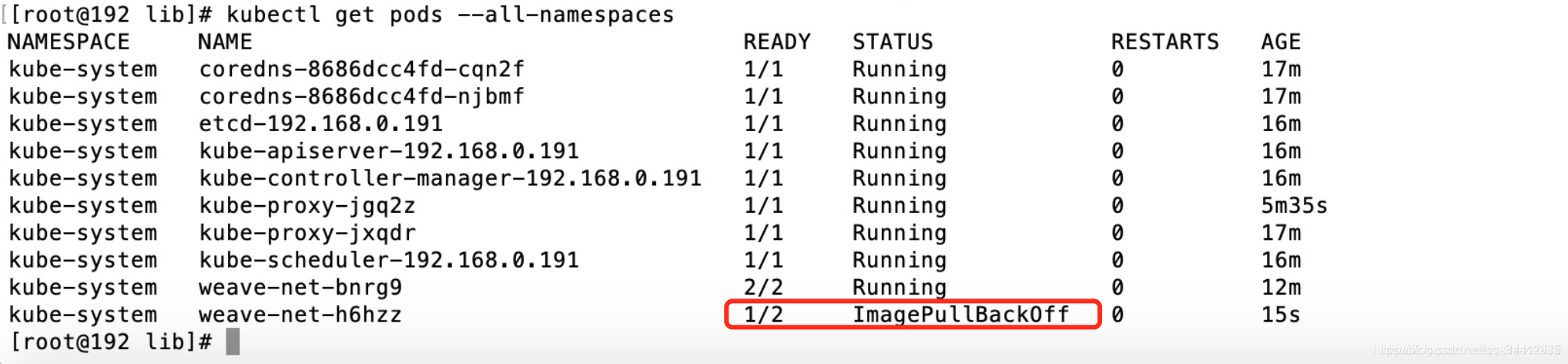

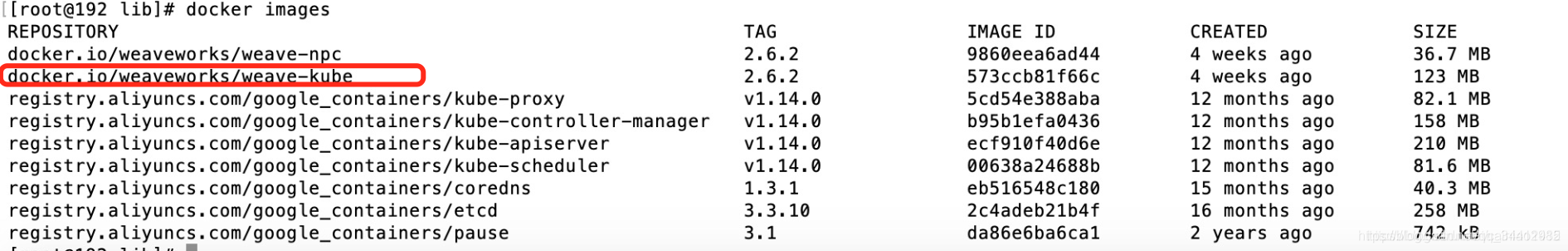

Pod一直处于ImagePullBackOff当中,但是docker images查看镜像又是存在的。

这时候需要关注你的Pod和镜像在不在一台服务器上。

使用 kubectl get pods -A -o wide 查看

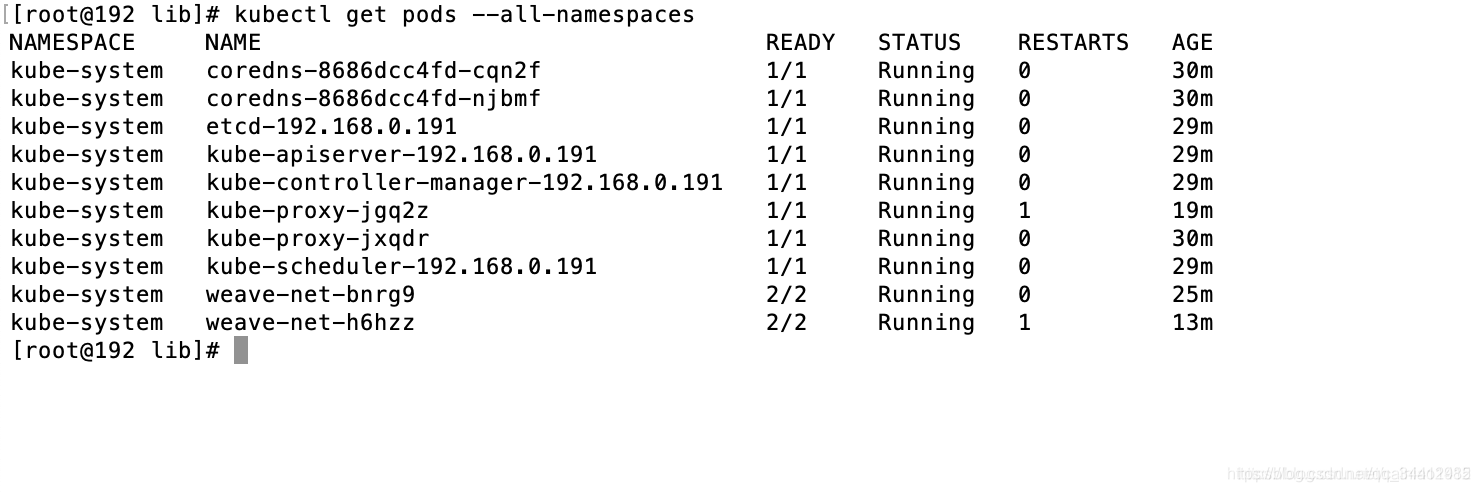

因为我190的机器上确实没有该镜像,所以一直是这个状态,在190上将对应的镜像下载下来即可搞定。

还有其它的原因,比如你的镜像确实就是没有下载下来,版本号不对啥的,参考下面这篇文章看看。

https://gardener.cloud/050-tutorials/content/howto/missing-registry-permission/

我遇到的问题是:k8s集群120,122,123共3台机器120机器重启,kube-flane的pod状态老是crashloopbackoff,查看日志是因为依赖kube-proxy的pod,因为kube-proxy时image pull back off,然后把122中这个镜像发到120机器上服务就正常了。

博客主要讲述了K8s中Pod处于ImagePullBackOff状态的问题。当docker images显示镜像存在时,要关注Pod和镜像是否在同一服务器,可通过kubectl get pods -A -o wide查看,若机器无镜像则需下载。还提及了镜像未下载、版本号不对等原因,并分享了k8s集群机器重启后相关Pod状态异常的解决办法。

博客主要讲述了K8s中Pod处于ImagePullBackOff状态的问题。当docker images显示镜像存在时,要关注Pod和镜像是否在同一服务器,可通过kubectl get pods -A -o wide查看,若机器无镜像则需下载。还提及了镜像未下载、版本号不对等原因,并分享了k8s集群机器重启后相关Pod状态异常的解决办法。

7104

7104

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?