1.AdaBoost算法原理

AdaBoost是代表性的提升算法。对于分类问题而言,在给定训练样本的条件下,找到一个弱分类器比找到一个强分类器要简单得多,提升算法就是从弱学习算法(弱分类器)出发,反复学习,得到一系列的弱分类器(基本分类器),然后组合这一系列的分类器,构成一个强分类器。大多数的提升方法都是改变训练数据的概率分布(训练数据的权值分布),针对不同的分布调用弱学习算法学习一系列分类器。提升算法需要回答的两个问题:(1)在每一轮训练中如何改变训练数据的权值或者概率分布(2)如何组合这一系列的弱分类器成为一个强分类器。在AdaBoost中,针对问题(1),AdaBoost提高前一轮学习被错误分类的样本的权重,降低前一轮学习被正确分类的样本权重,使被错误分类的样本由于权重的提高在下一次的训练中得到重视。针对问题(2),AdaBoost采用加权多数表决的方法,即加大分类错误率小的分类器的权重,使其在表决中起较大作用,减少分类错误率高的分类器的权重,使其在表决中起到较少的作用。

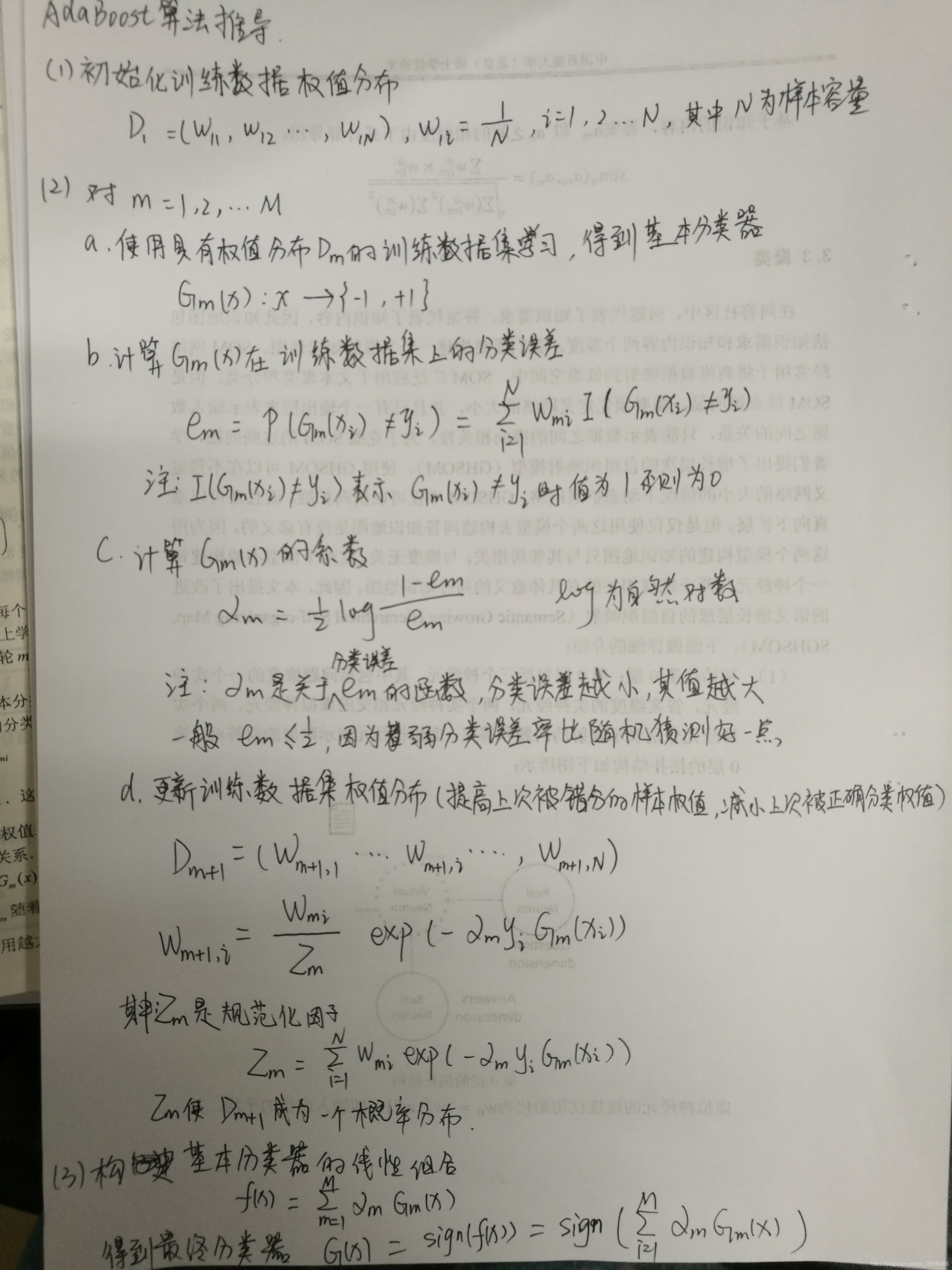

2.AdaBoost算法推导过程

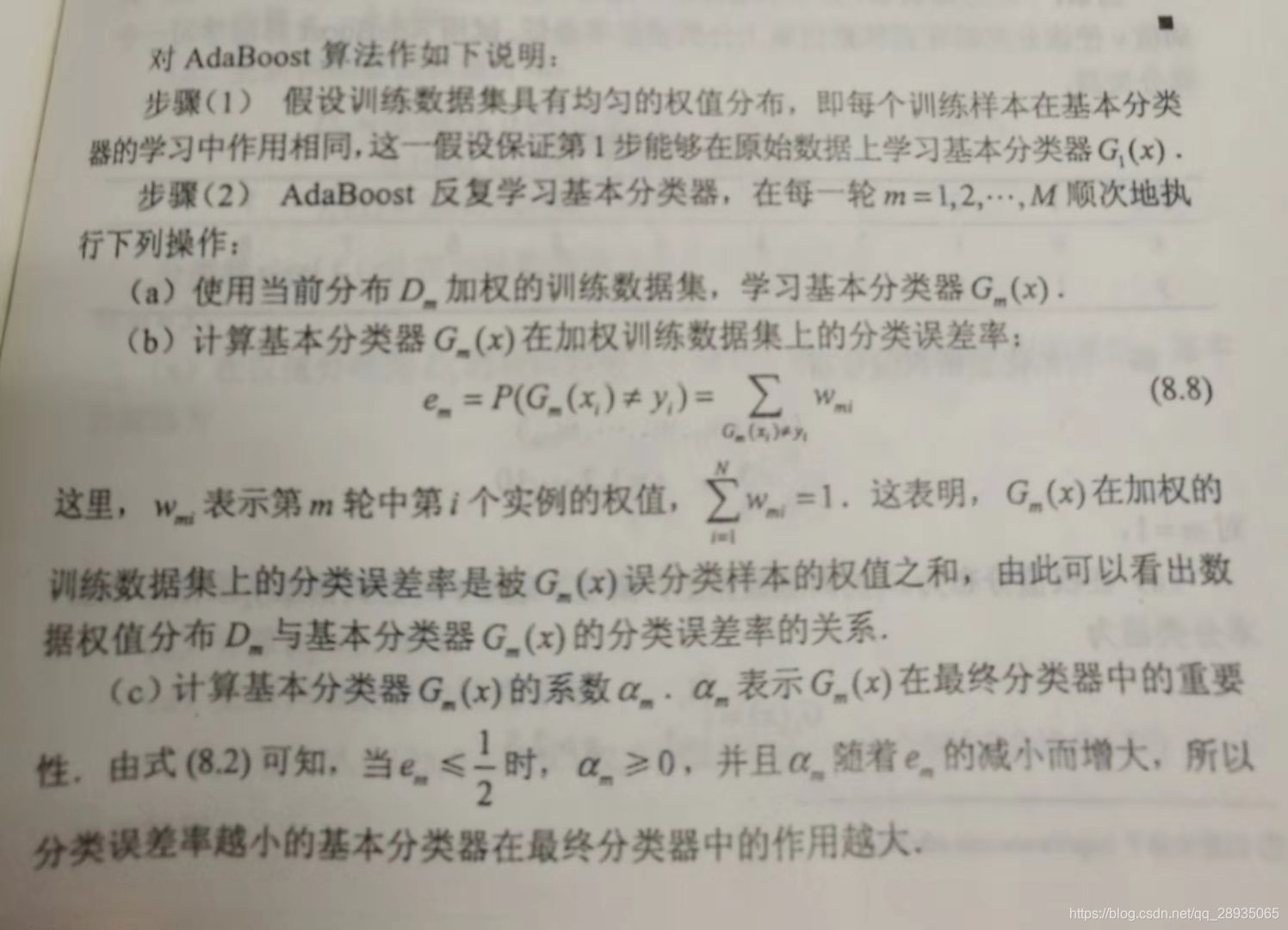

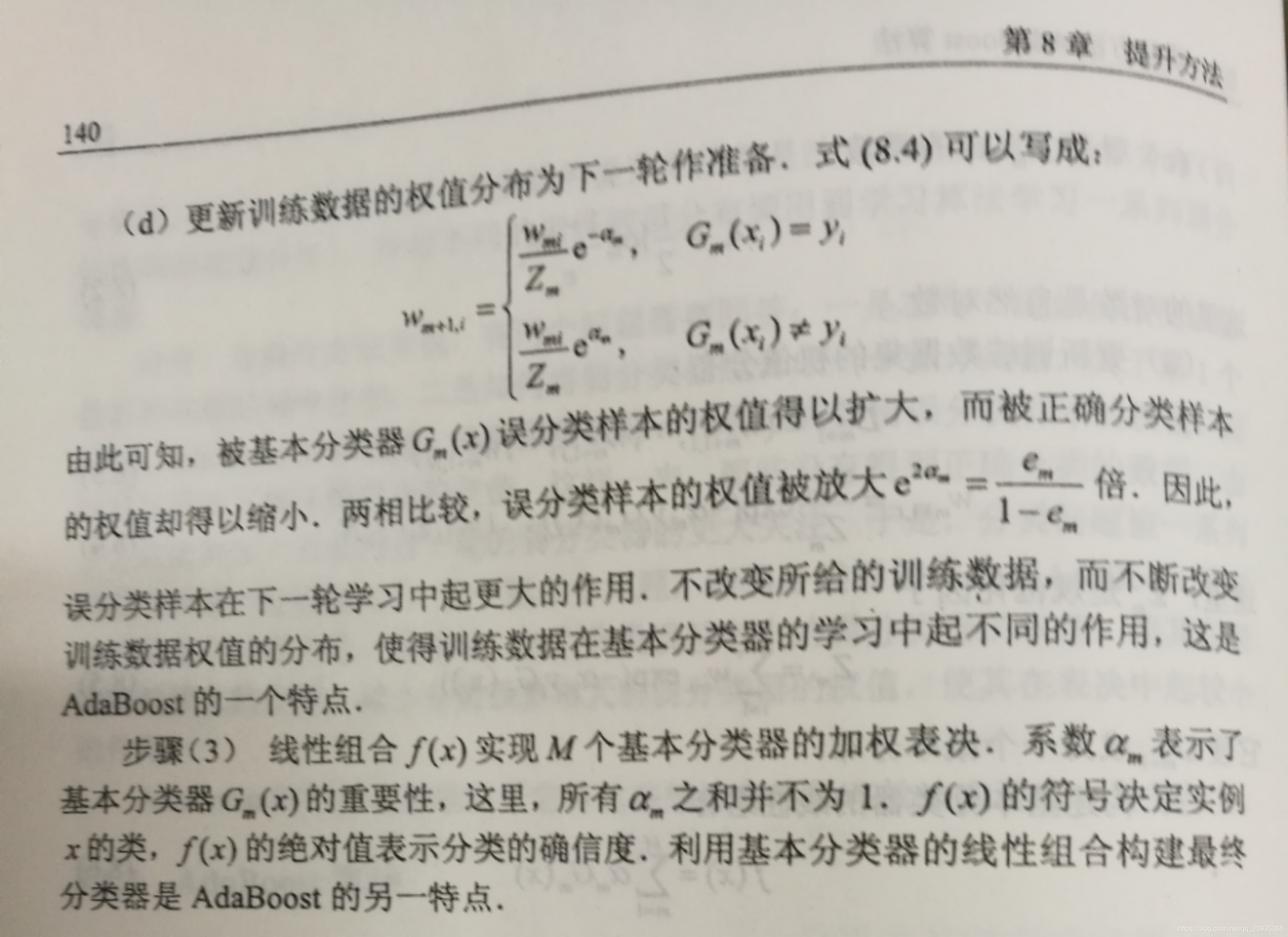

3.AdaBoost算法说明

参考文献

1.李航《统计学习方法》

1259

1259

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?