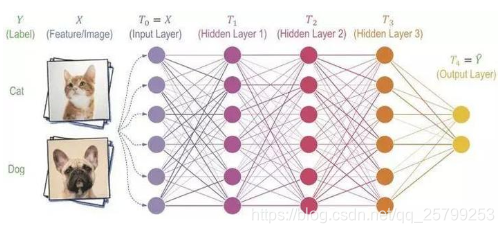

1.YJango的卷积神经网络——介绍(这个人的系列很好,循序渐进,但这里讲卷积运算的时候讲得很复杂,不便理解,可以看下面那个专门讲卷积运算的网址)

YJango的卷积神经网络:https://zhuanlan.zhihu.com/p/27642620

卷积滤波的作用:感知特征,获取激活图 (用老鼠图片的例子把卷积提取边缘的作用讲得非常好)

卷积运算详解:https://zhuanlan.zhihu.com/p/27642620

question1:

这里后面讲到的:不变性的满足是什么意思?

答:从不同角度拍摄的一个物体,物体本身没有变,但是拍出来的图像不一样,不变形指的是这个物体。

question2:

跳层连接??

question3:

1x1卷积核作用:降维和升维

question4:relu激活函数的作用:

https://blog.youkuaiyun.com/ViatorSun/article/details/82418578

https://blog.youkuaiyun.com/qq_34638161/article/details/81902989

反向传播没看懂,看得不是很明白,还是要看课程。

question5:

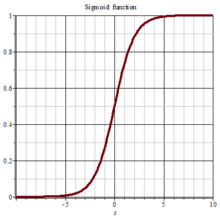

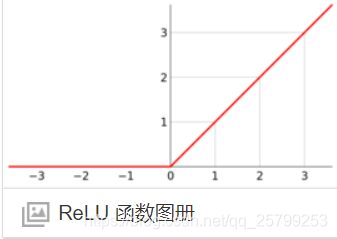

为什么深层神经网络用relu激活函数而不用sigmod激活函数?

答:sigmod函数与relu函数

sigmod的值域为[0,1],在浅层的神经网络中可以均衡各种信息特征,但在深层网络中,每个信息都被平均化了(均衡化了),数值都是0.8、0.7、0.6、0.3,都很小,更新权重得到的结果没有明显改善,就是在深层网络中不能突出有用信息。

而relu函数的x>0的部分是一个正比例函数,在深层神经网络中,某个神经元的输入越大,它的作用能更大地影响后面的神经元,

这样就能让某个特定突出的特征能在深度神经网络中不丢失。

question6:深度学习: 学习率 (learning rate)

https://blog.youkuaiyun.com/qq_41204464/article/details/83660728

question7:深度学习中Dropout层的作用:防止小数据集过拟合于是就隐藏部分隐层神经元

https://www.cnblogs.com/Lin-Yi/p/10407023.html

2.「七夕的礼物」: 一日搞懂卷积神经网络

https://zhuanlan.zhihu.com/p/28863709

卷积核和图像怎么运算的没讲清楚,参考网址:

https://www.zhihu.com/question/22298352

或者搜索:知乎 怎么通俗易懂地解释卷积,然后在这个网页中搜索平行矩阵,从那里开始看

池化也没讲清楚,看这里:https://blog.youkuaiyun.com/u010402786/article/details/51541465

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?