Image Processing and Computer Vision_Review:HPatches A benchmark and evaluation of handcrafted and learned local descriptors——2017.04

图像处理和计算机视觉–基础,经典以及最近发展_综述;翻译:手工和学习本地描述符的基准和评估;[2017.04 CVPR]

翻译

HPatches:手工和学习本地描述符的基准和评估

**作者:**Vassileios Balntas,Karel Lenc,Andrea Vedaldi

引用: Balntas V , Lenc K , Vedaldi A , et al. HPatches: A benchmark and evaluation of handcrafted and learned local descriptors[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, PP(99).

**摘要:**在本文中,我们提出了一个评估本地图像描述符的新基准。我们证明现有数据集和评估协议没有明确指出评估的所有方面,导致文献中报告的结果含糊不清和不一致。此外,由于最近通过从大注释数据集中学习它们而获得的局部描述符的改进,这些数据集几乎饱和。因此,我们引入了一个适用于训练和测试现代描述符的新的大型数据集,以及在匹配,检索和分类等几个任务中严格定义的评估协议。这允许在不同的应用场景中进行更真实且更可靠的比较。我们评估几个状态描述符的性能并分析它们的属性。我们表明,传统手工描述符的简单规范化可以在实际的基准评估中将其性能提升到基于深度学习的描述符的水平。

1.简介

局部特征描述符仍然是图像匹配和检索系统的重要组成部分,它是一个活跃的研究领域。随着可学习表示的成功以及越来越大的标记数据集的可用性,对局部描述符的研究已经复兴。端到端学习允许彻底优化可用基准的描述符,显着优于完全[20]或半手工制作的特征[21,32]。

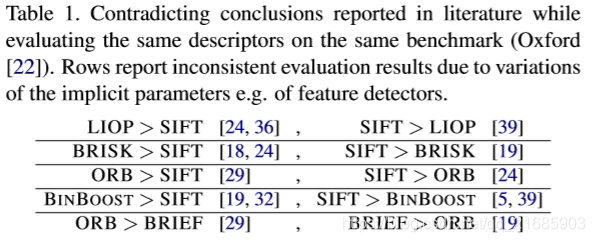

表1.在同一基准评估相同描述符的同时,文献中报告的结论存在矛盾(牛津[22])。由于隐含参数的变化,行报告不一致的评估结果,例如特征检测器。

然而令人惊讶的是,这些据称更好的描述符的采用在应用中受到限制,SIFT [20]仍然主导着这一领域。我们认为这是由于基于现有基准的报告绩效评估不一致[22,38]。这些数据集要么很小,要么缺乏多样性,以便很好地概括描述符的各种应用。描述符技术和应用要求的进展尚未与基准和评估协议的可比较发展相匹配。因此,尽管学习的描述符可能针对特定场景进行了高度优化,但尚不清楚它们是否在更一般的情况下运行良好,例如:在用于训练它们的特定数据集之外。事实上,如表1所示,仅根据已发表的实验比较描述符是困难和不确定的。

在本文中,我们为局部特征描述符引入了一个新颖的基准套件,它具有明显更大的定义,具有明确定义的协议和更好的泛化属性,可以取代现有的数据集。这得益于牛津匹配数据集[22]的成功,这是最广泛采用且仍然非常受欢迎的本地特征评估基准,尽管只有48个图像。这对于在深度学习和大规模数据集时代评估现代描述符是非常不利的。虽然存在一些较大的数据集,如第2节所述,但在数据和任务多样性,评估指标和实验重现性方面存在其他重要缺陷。我们通过在第3节中确定并满足此类基准的关键要求来解决这些缺点。

数据多样性被认为对于评估描述符的各种属性尤为重要。为此,我们在真实和变化的捕获条件下收集大量不同场景的多图像等级,如第4节所述。场景被选择为代表不同的用例并在不同的视点,照明或时间下捕获条件,包括在申请中遇到的具有挑战性的滋扰因素。图像用地面实况变换注释,允许识别评估由描述符建立的匹配质量所必需的唯一对应关系。

比较的再现性和公平性在基准测试中至关重要。通过消除检测器参数的影响来解决这个问题。因此,基准是基于提取的局部图像块而不是整个图像,这带来了重要的好处:i)它允许比较描述符模数检测器的选择,ii)它简化了过程并使实验可重复,并且重要的是, iii)它避免了各种偏见,例如测量区域的数量或大小或半局部几何约束使得基于图像的基准测试结果无法比拟(第2部分)。

任务多样性是现有评估基准中很少涉及的另一项要求。为此,我们在第5节中定义了三个互补的基准测试任务:补丁验证(补丁对的分类),图像匹配和补丁检索。这些代表了不同的用例,正如我们在实验中所示,探测器的排名取决于所考虑的任务。

虽然这项工作侧重于局部描述符,但建议的数据集包含groundtruth,包括成对几何变换,这将允许将来对特征检测器进行评估。我们相信这个基准将使社区能够获得最先进的本地特征匹配的新见解,因为它比这个领域中使用的任何现有数据集更加多样化并且显着更大。我们在第6节中评估了各种方法,包括简单基线,手工制作的描述符和最先进的学习描述符。实验结果表明描述符性能及其排名可能因不同的任务而有所不同,并且与文献中报道的结果不同。这进一步突出了为本地描述符引入大量,多样和可重复的评估基准的重要性。

实施评估协议的所有基准数据和代码均可公开获取1。1:https://github.com/hpatches

2.审查现有基准

在本节中,我们将回顾用于评估本地描述符的现有数据集和基准,并讨论它们的主要缺点。

###2.1. 基于图像的基准

在图像匹配基准中,描述符用于建立相同对象或场景的图像之间的对应关系。通过共变体检测器从每个图像提取的局部特征通过比较它们的描述符来匹配,通常与最近邻方法相比较。然后,评估推定的匹配与图像之间的已知几何变换的兼容性(通常是单应性),并且相对的相对数量被用作评估量度。

评估描述符和检测器的最广泛采用的基准是牛津匹配数据集[22]。它由8个场景的图像序列组成,每个场景包含6个图像,以及地面真实的单应性。虽然牛津数据集包含全部由相机捕获的图像,但生成匹配数据集[14]是通过使用合成变换生成图像而获得的,并且包含16个48个图像的序列。然而,转换的合成性质并不模拟通常在捕获过程中发生的所有噪声,因此使这些数据比牛津数据[4]更具挑战性。 DTU机器人数据集[1]包含3D对象的真实图像,使用机械臂在受控实验室条件下捕获,适用于某些应用场景,但数据的多样性有限。汉诺威数据集[11]研究高分辨率匹配,包含高达8百万像素的图像,具有高度准确的地面真实单应性。但是,它仅限于包含5个场景。 Edge Foci数据集[42]由观察条件变化很大的序列组成,使评估在某种程度上适用于极端情况;此外,非平面场景的基础并不唯一地识别对应关系,因为变换不能通过单应性很好地近似。同样,WxBs数据集[25]侧重于非常宽的基线匹配,随着时间的推移几何,光照和外观发生极大变化。

所有这些数据集都有一个重要的缺点,即在不同的描述符评估中留下变化的范围:没有预先定义的区域集来匹配。因此,结果很大程度上取决于探测器的选择(方法,实现和参数),使得描述符的比较非常困难和不可靠。这在表1中得到证实,即使使用相同的方案对相同的数据进行评估,不同的论文也会得出不同的结论。

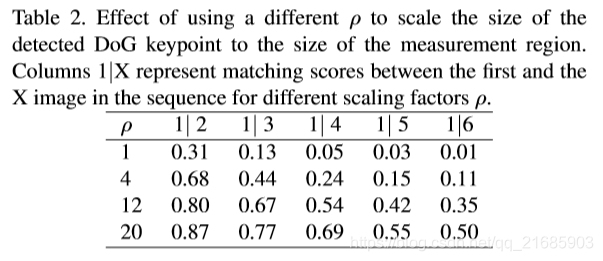

表2.使用不同的ρ将检测到的DoG关键点的大小缩放到测量区域的大小的效果。列1 | X表示序列中第一个和第X个图像之间的匹配分数,用于不同的缩放因子ρ。

定义要匹配的特征的中心位置也不足以约束问题。例如,这不会影响用于计算描述符的图像区域,通常称为测量区域。通常将测量区域设置为固定但任意设置的特征尺寸缩放,并且该参数通常不在报告中报告或变化。不幸的是,这对性能有重大影响[31]。表2显示了在办公室数据中测量区域的不同比例因子的匹配分数.2超过50%mAP的变化发生;实际上,由于这种场景的平面性,较大的测量区域导致改善的匹配结果。

使用DoG检测器和SIFT描述符在Oxford匹配数据集中的Leuven序列上计算2mAP。

为了控制测量区域的大小和其他重要参数,例如模糊量,用于计算描述符的标准化补丁的分辨率[34],或者使用半局部几何约束,我们认为描述符基准应该基于图像补丁而不是整个图像。因此,消除了所有这样的模糊,并且可以将描述符表示和评估为将补片x∈R(H×H×3)映射到D维特征向量的函数f(x)∈RD。接下来将讨论这种类型的基准。

###2.2. 基于补丁的基准测试

基于补丁的基准包括从图像中的兴趣点位置提取的补丁。然后将贴片标准化为相同的大小,并且用标签指示对或组,用标签指示对应的正或负对象。通常通过使用图像groundtruth来建立注释,例如图像之间的几何变换。在基于图像的评估的情况下,提取,标准化和标记补丁的过程留下变化的范围,并且其参数在评估之间不同。

第一个流行的基于补丁的数据集是PhotoTourism [38]。自推出以来,使用补丁进行基准测试(第5.3节)的许多好处变得明显。 PhotoTourism引入了一个简单而明确的评估协议,我们将其称为补丁验证:给定一对补丁,任务是预测它们是否匹配,这将匹配任务减少为二进制分类问题。该公式特别适用于基于学习的方法,包括CNN和度量学习,特别是由于该数据集中可用的大量补丁。 PhotoTourism的主要限制是其稀缺的数据多样性(只有三个场景:Liberty,Notre-Dame和Yosemite),任务多样性(只有补丁验证任务)和特征类型多样性(仅提取DoG特征)。 CVDS数据集[9]通过从五个MPEG-CDVS中提取补丁来解决数据多样性问题:图形,绘画,视频,建筑物和通用对象。尽管它具有显着的多样性,但实验表明,最先进的描述符在这些数据上获得了高性能分数[3]。 RomePatches数据集[26]考虑了一个反映图像检索场景的查询排名任务,但仅限于10K补丁,这使得它比PhotoTourism小一个数量级。

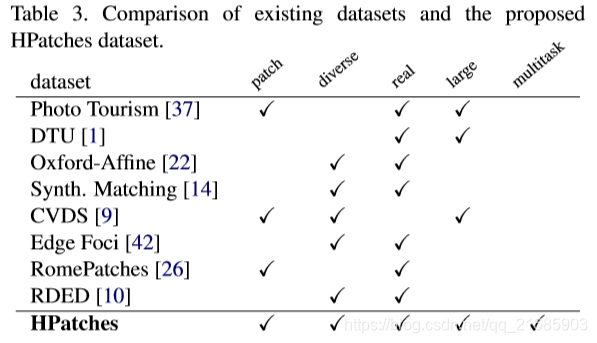

表3.现有数据集与建议的HPatches数据集的比较。

###2.3. Metrics

除了选择数据,补丁和任务外,评估指标的选择也很重要。对于分类,接收器操作特性(ROC)曲线经常被用作[12,13]作为比较的基础。然而,补丁匹配本质上是高度不平衡的,其中许多比正对应候选者更负面; ROC曲线对于不平衡数据的代表性较低,因此,ROC空间中的强大性能不一定推广到应用中的强大性能,例如最近邻匹配[30,39,5,33]。一些论文[38,32,33]报道了ROC曲线上的单个点(FPR95,即95%真阳性回忆率的假阳性率),这比不等的数据更适合于等误差率或者下面的面积。 ROC曲线;但是,这会减少整条曲线提供的信息。对于不平衡数据集,PrecisionRecall和平均平均精度(mAP)是更好的度量选择 - 例如,DBRIEF [33]在ROC空间中表现优异,但在牛津数据集中具有非常低(≈0.01)的mAP [19]。

3.Benchmark设计

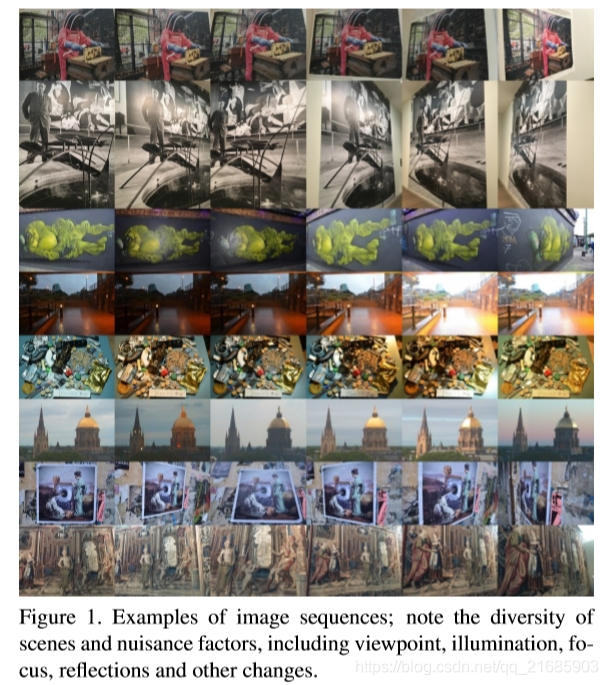

图1.图像序列示例;注意场景和滋扰因素的多样性,包括视点,光照,焦点,反射和其他变化。

我们通过确定以下要求来解决第2节中讨论的现有数据集的缺点:

•可重复,基于补丁:应在补丁上进行描述符评估,以消除检测器相关因素。这导致不同作品的标准化,并使结果直接可比。

•多样化:代表许多不同的场景和图像捕捉条件。

•真实:由于无法在图像变换中建模的烦扰因素,已发现实际数据比合成数据更具挑战性。

•大:允许准确和稳定的评估,以及为基于学习的描述符提供大量的培训集。

•多任务:代表几个用例,从匹配图像对到图像检索。这允许在相同数据内对描述符性能进行跨任务比较。

基于这些期望的属性,我们引入了一个新的大型图像序列数据集(第4节),用单应性标注。这用于生成基于补丁的基准测试套件,用于评估本地图像描述符(第5节)。表3根据上述属性将建议的数据集与现有基准进行了比较。

4.图像和补丁

从各种来源收集图像,包括现有数据集。我们通过相机捕获了51个序列,来自[16]的33个场景,来自[1]的12个场景,来自[10]的5个场景,来自[22]的4个场景,来自[35]的2个场景和来自[40]的1个场景。 ]。一些序列如图1所示。在57个场景中,主要的滋扰因素是光度变化,其余59个序列由于视点变化而显示出显着的几何变形。

序列包括参考图像和具有不同几何变化光度的5个目标图像。捕获序列使得图像之间的几何变换可以通过从参考图像到每个目标图像的单应性很好地近似。在[22]之后估计单应性。

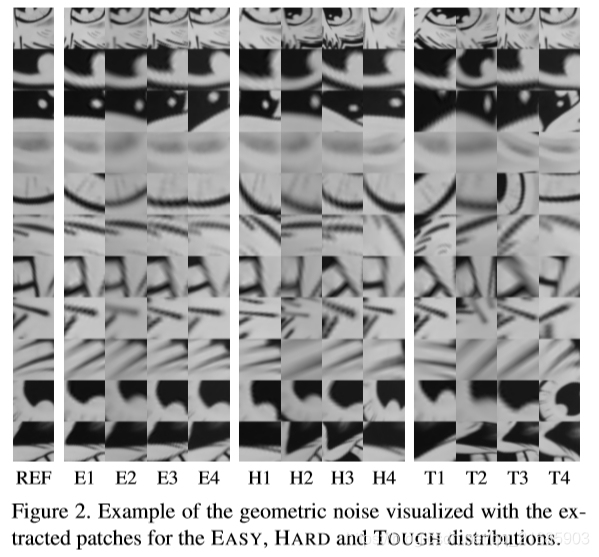

图2.使用EASY,HARD和TOUGH分布的提取贴片可视化的几何噪声示例。

使用以下协议提取补丁。使用几个尺度不变的兴趣点检测器,即DoG,Hessian-Hessian和Harris-Laplace来提取大于1.6px的尺度的特征3,这给出了稳定的点。基于它们的交叉结合(IoU)重叠(> 0.5)丢弃接近重复的区域,并且随机保留每个簇的一个区域。这可以保持重叠小于0.5 IoU的区域。然后随机选择每个图像大约1,300个区域。

![图3. Hessian和HessianAf fi探测器在[23]的视点序列上的平均重叠精度。线条颜色对数据集和线条样式进行编码。 EASY和HARD变体的所选重叠用虚线可视化。](https://i-blog.csdnimg.cn/blog_migrate/f8b7927a31daac151c44d323a80acb6b.jpeg)

图3. Hessian和HessianAf fi探测器在[23]的视点序列上的平均重叠精度。线条颜色对数据集和线条样式进行编码。 EASY和HARD变体的所选重叠用虚线可视化。

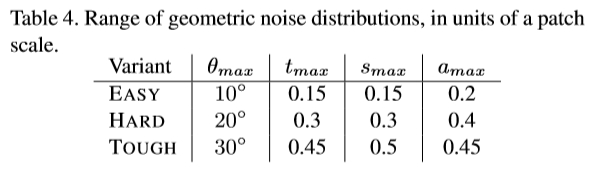

对于每个序列,在参考图像中检测斑块并使用groundtruth单应性投影在目标图像上。这避免了探测器的局限性,由于重要的视点或光照变化,探测器可能无法在每个目标图像中提供相应的区域。此外,它允许提取更多补丁,从而更好地评估这种情况下的描述符。丢弃未完全包含在所有目标图像中的区域。因此,一组相应的补丁包含序列中每个图像中的一个。实际上,当检测器提取不同图像中的相应区域时,它会产生一定量的噪声。为了模拟这种噪音,使用三种设置扰乱检测:EASY,HARD和TOUGH。这是通过将随机变换T:R2→R2应用于投影之前的区域而获得的。假设区域中心是坐标原点,则变换包括角度θ的旋转R(θ),s /√a和s√a的各向异性缩放,以及[m tx,m ty]的平移,因此平移成比例到检测范围m。从区间θ∈[-θmax,θmax],tx,ty∈[-tmax,tmax],log2(s)∈[-smax,smax],log2(a)∈[-amax]中均匀地采样变换参数。 amax],其每个设置的值在表4中给出。这些设置反映了牛津匹配基准上Hessian和Hessian-Af fi探测器的典型重叠精度。在那里,通过增加变换对每个序列中的图像进行分类,导致检测器噪声增加。图3显示EASY,HARD和TOUGH组对应于在这些序列的图像1-2,3-4和5-6中提取的区域。

表4。几何噪声分布的范围,以贴片尺度为单位。

检测到的区域按比例缩放5倍(参见第2节)。参考图像中的最小斑块尺寸是16×16px,因为仅考虑来自检测尺度大于1.6px的区域。在每个区域中,使用梯度方向的直方图来估计主导方位角[20]。通过使用双线性插值将检测到的自然区域归一化为圆并且提取65×65像素的正方形来对区域进行整形。提取的补丁的示例如图所示。 2,增加探测器噪声的效果清晰可见。

5.Benchmark任务

在本节中,我们定义了基准指标,任务及其评估协议:补丁验证,图像匹配和补丁检索。

这些任务旨在模仿本地描述符的典型用例。补丁验证(第5.2节)基于[38]并测量描述符分类是否从同一测量中提取两个补丁的能力。受[22]启发的图像匹配(第5.3节)测试描述符在两个图像中正确识别对应关系的程度。最后,补丁检索(第5.4节)测试描述符如何与aquery补丁匹配到从许多图像中提取的补丁池,包括许多干扰物。这是基于局部特征的图像索引的代理[27,26]。

5.1. 评估指标

我们首先确定了HPatches中使用的精度和召回评估指标。令y =(y1,…,yn)∈{-1,0,+ 1} n是针对补丁查询返回的补丁的排序列表的标签,分别指示否定,忽略和肯定匹配。然后在等级i处的精度和召回由4 Pi(y)= Pi k = 1 [yk] + / Pi k = 1 | yk |给出。和Ri(y)= P i k = 1 [yk] + / PN k = 1 [yk] +;平均精度(AP)由AP(y)= Pk给出:yk = + 1 Pk(y)/ PN k = 1 [yk] +。主要区别是w.r.t. PR的标准定义是可以忽略的条目,即yi = 0,将在5.4节中用于检索任务。在这种情况下,设K≥PNk= 1 [yk] +为正数的总数;召回计算为Ri(y; K)= Pi k = 1 [yk] + / K且AP为AP(y; K)= Pk:yk = + 1 Pk / K,其对应于截断的PR曲线)。

5.2 补丁验证

在补丁验证中,描述符用于分类两个补丁是否对应。基准从正面和负面贴片对的列表P =((xi,x0 i,yi),i = 1,…,N)开始,其中xi,x0i∈R65×65×1是贴片和yi =±1是他们的标签。数据集用于评估匹配方法A,给定任意两个补丁xi,x0 i,产生两个补丁对应的置信分数si∈R。该方法的质量被测量为排序补丁的平均精度,即AP(yπ1,…,yπN),其中π是按降序对分数进行分类的排列(即sπ1≥sπ2≥… .≥sπn)应用5.1节中的公式。

基准测试使用通过改变投影噪声提取的四组补丁对,如第4节中所述,即EASY,HARD或TOUGH,以及一组负对,它们可以从同一序列中的图像或不同序列中采样。然后将方法A的整体性能计算为六个补丁集的平均AP。总的来说,我们每组产生2×105个正对和1×106个负对。

注意,基准仅需要算法A计算的分数si;特别地,这统一了具有自定义相似性度量的描述符的评估,包括学习的相似性度量。该评估协议类似于[38]。然而,虽然在那里使用ROC [13],但是这里优选AP [30],因为数据集是高度不平衡的,绝大多数(106)的补丁对是负的。后者更能代表典型的匹配方案。

5.3. 图像匹配

在图像匹配中,描述符用于匹配从参考图像到目标图像的补丁。在该任务中,图像是N个补丁Lk =(xik,i = 1,…,N)的集合。考虑一对图像D =(L0,L1),其中L0是参考,L1是目标。因此,在匹配之后,xi0与xi1对应。

对D用于评估算法A,给定参考贴片xi0∈L0,确定最佳匹配贴片xσi1∈L1的索引σi∈{1,…,N},以及相应的置信分数si∈R。然后,基准将分配σi标记为yi = 2 [σi? = i] -1,并计算AP(yπ1,…,yπN; N),其中π是按降序对分数进行排序的排列(请注意,正结果的数量固定为N;请参阅第5.1节) 。

我们根据它们是否因视点或光照而变化来对序列进行分组,并且每个组都使用EASY,HARD和TOUGH补丁进行实例化。算法A的整体性能被计算为所有这些图像对和变体的平均AP。

注意,基准仅需要针对每个图像对D的索引σi和由算法A计算的分数si。通常,这些可以通过提取补丁描述符并与相似性度量进行比较来计算。

该评估协议旨在与[22]中的那个非常相似。一个值得注意的区别在于,由于补丁数据集的构造方式使得每个参考补丁在每个目标图像中都有相应的补丁,因此最大回忆率始终为100%。还要注意,与验证任务类似,基准测试评估由测试算法提供的描述符和相似性得分的组合性能。

5.4. 补丁检索

在补丁检索中,描述符用于在大量补丁中找到补丁对应关系,其中很大一部分是从混淆图像中提取的干扰物。考虑集合P =(x0,(xi,yi),i = 1,…,N),其包括从参考图像L0提取的查询补丁x0,以及来自图像Lk,k = 1的所有补丁。 …,K在相同的序列(匹配的图像),以及许多混杂的图像。

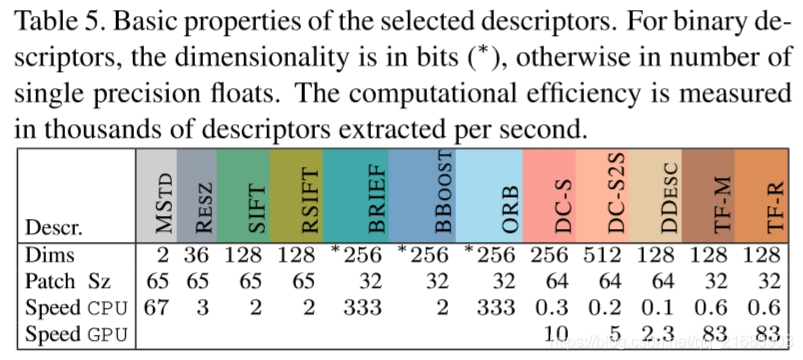

表5.所选描述符的基本属性。对于二进制描述符,维度以位(*)表示,否则以单精度浮点数表示。计算效率是以每秒提取的数千个描述符来衡量的。

在检索协议中,如果补丁xi对应于查询补丁x0,则补丁xi被给予正标签yi = +1,而对应于查询补丁x0则补偿为yi = -1。由于在相同序列的每个图像Lk中恰好存在一个对应的补丁,因此在D中确实存在K个正补丁。但是,与查询补丁x0不对应但至少属于匹配图像Lk的检索补丁xi被忽略(yi = 0)。这个想法是这样的补丁对于检索正确的图像没有害处,并且在图像中重复结构的情况下可能经常发生这种无害的错误。

集合P用于评估算法A,该算法A为每个补丁xi分配补丁得分si∈R,补丁与查询x0匹配。然后基准返回AP(yπ1,…,yπN; K),其中π是按降序对分数进行排序的排列。

基准提取1×104个集合P,每个集合对应于不同的查询补丁x0及其对应的5个补丁以及从所有序列中随机选择的2×104个干扰物。此外,有三种变体实例化为EASY,HARD和TOUGH。算法A的整体性能被计算为所有这些集合及其变体的平均AP。该基准测试的设计灵感来自经典图像检索系统,如[27,28,26],它使用补丁及其描述符作为图像索引中的条目。可以通过使用PhotoTourism数据集来执行类似的评估,该数据集包括~100K小组相应的补丁。不幸的是,由于这些小集不是最大的,所以不可能知道补丁没有正确的对应而没有基本事实,这使得评估有噪声。

6.实验结果

在本节中,我们使用新引入的基准来评估局部描述符,并讨论与文献相关的结果。

###6.1.描述子

我们评估以下描述符,总结在表5中。我们包括两个基线:MSTD,[μ,σ],它是贴片的平均μ和标准偏差σ,RESZ,通过将贴片的大小调整为6×6得到的矢量像素并通过减去μ并除以σ来对其进行归一化。对于基于SIFT的描述符,我们包括SIFT [20]及其变体RSIFT [2]。从二元描述符族我们测试Brief [8],基于随机强度比较,ORB [29],使用不相关的二进制测试,和BBOOST [32],其中使用增强选择二进制测试。最后,我们评估了几个最近的深度描述符,包括DeepCompare [41](DCS,DC-S2S)的暹罗变体,其中一个和两个流CNN架构用于一个或两个补丁作物,DeepDesc [30](DDESC),它利用了硬 - 负挖掘,以及TFeat描述符[4]的TFeat余量*(TFM)和比率*(TF-R),基于浅卷积网络,三元组学习约束和快速硬负挖掘。所有基于学习的描述符都接受了PhotoTourism数据的培训,这与我们的新基准不同。

在[2,7,17]中已经表明,描述符归一化通常会显着改善性能。因此,我们还通过应用ZCA白化包括所选描述符的后处理变体[6,p。 299-300]具有限幅特征值[15],然后是幂律归一化[2]和L2归一化。 ZCA投影是在数据集的子集上计算的(注意ZCA是无监督的)。针对每个描述符分别估计特征限幅的阈值,以最大化其在数据集的子集上的性能。规范化不用于普通基线和二进制描述符。

表5示出了维度,以像素为单位的测量区域的大小以及每个描述符的提取时间。 DeepCompare [41]变体的最高维度为256和512,否则其他实际值描述符除了MSTD和RESZ之外的128维。所有二进制描述符都是256位。就速度而言,二进制描述符BRIEF和ORB比最有效的基于CNN的特征(即TF)快4倍。其他描述符至少慢一个数量级。请注意,MSTD和RESZ是在Matlab中实现的,因此应谨慎解释它们的效率。

###6.2. 结果

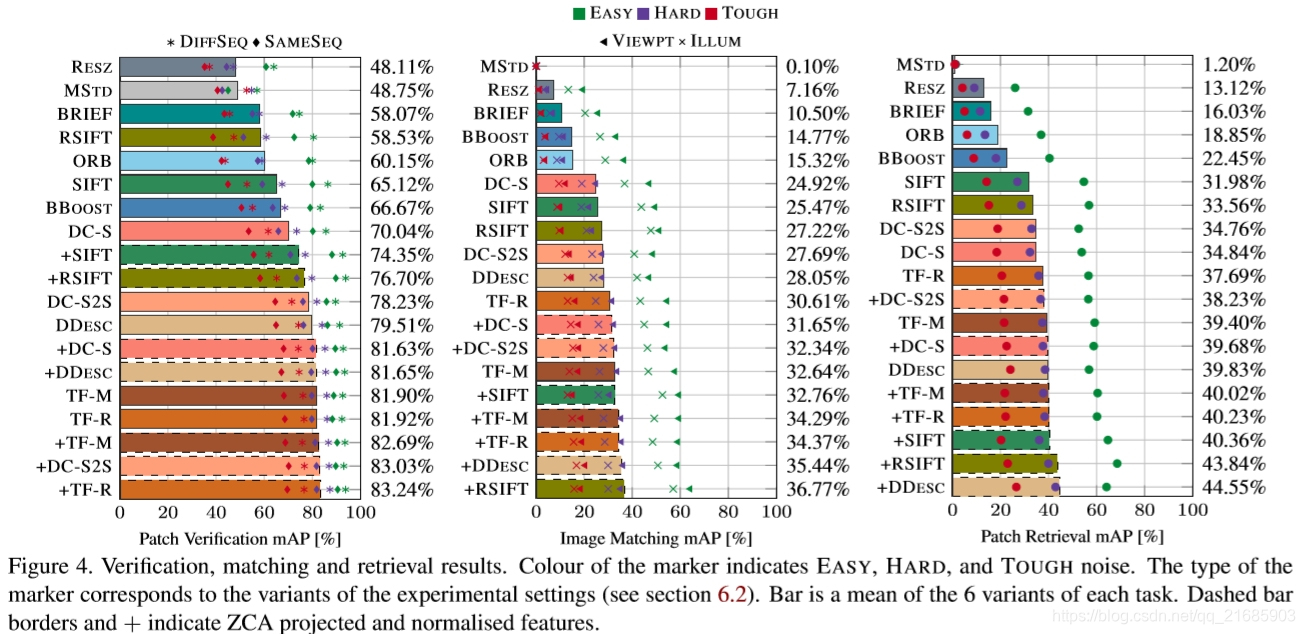

描述符在三个基准任务上进行评估:补丁验证,图像匹配和补丁检索,如第5节中所定义。在图5中的所有图中。如图4所示,标记的颜色表示几何噪声的量,即EASY,HARD和TOUGH,如第4节所述。每个任务的实验设置有两种变体,如下面的讨论中所述,以及类型标记的对应于实验设置。条形图是六种运行方式,由三种噪声变量组成,每种都有两个额外的设置。虚线条边框和+表示ZCA投影和标准化特征。

VERI科幻阳离子。 ZCA投影和标准化+ TF-R,+ DC-S2S紧跟其他TF-,+ DDESC和+ DC-S,后处理SIFT和二进制描述符的得分略低。后处理为DC-以及SIFT提供了显着的提升,但对基于TF的描述符的改进较小。期望CNN特征的良好性能,因为这些描述符与它们的距离度量一起被优化以在验证任务中表现良好。对来自相同序列SAMESEQ和来自不同序列DIFFSEQ的贴片形成的负对进行实验。来自SAMESEQ的那些被认为更具挑战性,因为图像的不同部分中的纹理通常是相似的。事实上,SAMESEQ的结果一直较低。这表明,不仅正数据中的噪声构成挑战,而且性能也可能根据负面示例的来源而变化。

**匹配。**描述符的排名随此任务而变化。尽管标准化+ DDESC仍然表现良好,但令人惊讶的是,+ RSIFT出现在其他描述符之前。 + TF还提供良好的匹配性能。总体mAP分数远低于验证任务,因为这里的正面与负面例子的比率明显较低,而所有负面例子都来自同一序列。与验证相比,SIFT和深度描述符之间的差距也很小。另一个有趣的观察结果是,具有光度变化(ILLUM)的序列的结果始终低于视点变化(VIEWPT)。这与牛津数据评估中观察到的不同[22]。与光度变化的稳健性相比,似乎在几何不变性方面取得了更多进展。拟议的HPatches数据集包括许多具有极端照明变化的序列。

**恢复。**检索场景中的最佳表现与匹配相同。特别是,SIFT变种紧随+ DDESC。与匹配相比,整体性能稍好一些,这可以通过源于匹配中的相同序列和检索中的不同序列的干扰物来再次解释。

**得心应手。**任务中有几个有趣的观察结果。首先,描述符的排名发生变化,这证明需要多个评估指标。其次,SIFT变体,特别是在进行归一化后,表现非常好。事实上,+ RSIFT是图像匹配和补丁检索中第二好的描述符。 MSTD在验证方面给出了很好的分数,但完全无法进行匹配和检索,因为两者都依赖于最近邻匹配。良好的验证性能显然不能很好地概括为其他任务,这更好地反映了描述符的实际应用。这进一步强调了使用多任务基准来补充PhotoTourism的培训和测试的必要性,这在大多数最近的论文中已经完成,并且类似于此处的验证任务。EASY和TOUGH几何失真以及照明变化的性能差异高达30%,这表明这两个领域仍有改进的余地。

图4.验证,匹配和检索结果。标记的颜色表示EASY,HARD和TOUGH噪音。标记的类型对应于实验设置的变体(参见第6.2节)。 Bar是每个任务的6个变体的平均值。虚线条边框和+表示ZCA投影和标准化特征。

尽管+ DDESC [30]接近每个类别中的最高分,但深度描述符和SIFT的性能在任务中变化,但是它是最慢的计算。在匹配和检索中,ZCA和规范化将SIFT的性能提升到最高水平。与一些深度描述符相比,SIFT对于高度几何噪声似乎不太稳健,对于EASY和TOUGH基准测试具有很大的扩展性。这在补丁验证任务中尤为明显,其中SIFT的表现优于TOUGH数据的大多数其他描述符。

对于图像匹配和补丁检索任务,二进制描述符的表现优于原始SIFT,这可能是由于其辨别能力和对几何噪声的更好的鲁棒性。二进制描述符仅适用于补丁验证任务。然而,二进制描述符具有其他优点,例如紧凑性和速度,因此它们仍然是精度不如速度重要的应用中的最佳选择。另外+ TF表现相对较好,特别是在考虑其效率时。

后处理归一化,特别是平方根,具有显着的效果。对于大多数描述符,标准化特征比原始特征执行得更好。

最后,与其他任务相比,补丁验证平均获得了更高的mAP分数。这主要可以从简单的MSTD描述符的相对良好的性能看出。这证实了补丁验证任务本身并不充分,其他任务在描述符评估中至关重要。

7.结论

随着深度学习的出现,新颖和更强大的本地描述符的发展已经大大加速。但是,正如我们在本文中所示,通常用于评估此类描述符的基准是不充分的,这使得比较不可靠。从长远来看,这可能会对进一步的研究产生不利影响。为了解决这个问题,我们引入了HPatches,一种用于本地描述符的新公共基准。新的基准测试是基于补丁的,消除了困扰现有基于图像的基准测试的许多模糊性,并有利于严格,可重复和大规模的实验。通过考虑许多不同的场景和视觉效果类型,以及接近描述符实际应用的三个基准任务,该基准还改进了其他数据集中存在的有限数据和任务多样性。

尽管我们的基准测试套件具有多任务复杂性,但使用评估很容易,因为我们提供了可以轻松使用的协议的开源实现。 HPatches可以取代PhotoTourism等数据集以及较旧但仍经常使用的牛津匹配数据集,解决它们的缺点,并为对本地描述符感兴趣的研究人员提供有价值的工具。

致谢Karel Lenc得到了ERC 677195-IDIU的支持,Vassileios Balntas得到了FACER2VM EPSRC EP / N007743 / 1的支持。我们要感谢Giorgos Tolias对描述符规范化的帮助。

参考文献

[1] H. Aanæs, A. L. Dahl, and K. S. Pedersen. Interesting interest points. IJCV, 97(1):18–35, 2012.

[2] R. Arandjelovi´c and A. Zisserman. Three things everyone should know to improve object retrieval. In Proc. CVPR, pages 2911–2918, 2012.

[3] V.Balntas.Efficientlearningoflocalimagedescriptors.PhD thesis, University of Surrey, 2016.

[4] V.Balntas,E.Riba,D.Ponsa,andK.Mikolajczyk. Learning local feature descriptors with triplets and shallow convolutional neural networks. Proc. BMVC, 2016.

[5] V. Balntas, L. Tang, and K. Mikolajczyk. BOLD - binary online learned descriptor for efficient image matching. In Proc. CVPR, 2015.

[6] C. M. Bishop. Neural networks for pattern recognition. Oxford university press, 1995.

[7] A. Bursuc, G. Tolias, and H. J´egou. Kernel local descriptors with implicit rotation matching. In ACM ICMR, pages 595– 598, 2015.

[8] M. Calonder, V. Lepetit, C. Strecha, and P. Fua. BRIEF: Binary robust independent elementary features. In Proc. ECCV, pages 778–792, 2010.

[9] V. Chandrasekhar, G. Takacs, D. M. Chen, S. S. Tsai, M. Makar, and B. Girod. Feature matching performance of compact descriptors for visual search. In Proc. Data Compression Conference, pages 3–12, 2014.

[10] K. Cordes, B. Rosenhahn, and J. Ostermann. Increasing the accuracy of feature evaluation benchmarks usingdifferential evolution. In Proc. SDE, pages 1–8, 2011.

[11] K.Cordes,B.Rosenhahn,andJ.Ostermann.High-resolution feature evaluation benchmark. In Proc. CAIP, pages 327– 334, 2013.

[12] J. Davis and M. Goadrich. The relationship between precision-recall and roc curves. In Proc. ICML, pages 233– 240, 2006.

[13] T. Fawcett. Roc graphs: Notes and practical considerations for researchers. 2004.

[14] P. Fischer, A. Dosovitskiy, and T. Brox. Descriptor matchingwithconvolutionalneuralnetworks: acomparisontosift. arXiv preprint arXiv:1405.5769, 2014.

[15] G. Hua, M. Brown, and S. Winder. Discriminant embedding forlocalimagedescriptors. InProc.ICCV,pages1–8,2007.

[16] N. Jacobs, N. Roman, and R. Pless. Consistent temporal variations in many outdoor scenes. In Proc. CVPR, pages 1–6, 2007.

[17] Y. Ke and R. Sukthankar. PCA-SIFT: A more distinctive representation for local image descriptors. In Proc. CVPR, volume 2, pages II–506, 2004.

[18] S.Leutenegger,M.Chli,andR.Y.Siegwart. BRISK:Binary robust invariant scalable keypoints. In Proc. ICCV, pages 2548–2555, 2011.

[19] G. Levi and T. Hassner. LATCH: learned arrangements of three patch codes. In Winter Conference on Applications of Computer Vision (WACV), 2016.

[20] D. G. Lowe. Object recognition from local scale-invariant features. In Proc. ICCV, volume 2, pages 1150–1157, 1999.

[21] K. Mikolajczyk and J. Matas. Improving descriptors for fast tree matching by optimal linear projection. In Proc. ICCV, 2007.

[22] K. Mikolajczyk and C. Schmid. A performance evaluation of local descriptors. IEEE PAMI, 27(10):1615–1630, 2005.

[23] K. Mikolajczyk, T. Tuytelaars, C. Schmid, A. Zisserman, J. Matas, F. Schaffalitzky, T. Kadir, and L. Van Gool. A comparison of affine region detectors. IJCV, 65(1-2):43–72, 2005.

[24] O.MiksikandK.Mikolajczyk. Evaluationoflocaldetectors and descriptors for fast feature matching. In Proc. ICPR, pages 2681–2684, 2012.

[25] D.Mishkin,J.Matas,M.Perdoch,andK.Lenc. Wxbs: Wide baselinestereogeneralizations. InProc.BMVC,pages12.1– 12.12, 2015.

[26] M. Paulin, M. Douze, Z. Harchaoui, J. Mairal, F. Perronin, and C. Schmid. Local convolutional features with unsupervised training for image retrieval. In Proc. ICCV, pages 91– 99, 2015.

[27] J. Philbin, O. Chum, M. Isard, J. Sivic, and A. Zisserman. Objectretrievalwithlargevocabulariesandfastspatial matching. In Proc. ICCV, pages 1–8, 2007.

[28] J. Philbin, O. Chum, M. Isard, J. Sivic, and A. Zisserman. Lost in quantization: Improving particular object retrieval in large scale image databases. In Proc. CVPR, pages 1–8, 2008.

[29] E. Rublee, V. Rabaud, K. Konolige, and G. Bradski. ORB: An efficient alternative to SIFT or SURF. In Proc. ICCV, pages 2564–2571, 2011.

[30] E. Simo-Serra, E. Trulls, L. Ferraz, I. Kokkinos, P. Fua, and F. Moreno-Noguer. Discriminative learning of deep convolutional feature point descriptors. Proc. ICCV, 2015.

[31] K. Simonyan, A. Vedaldi, and A. Zisserman. Learning local feature descriptors using convex optimisation. IEEE PAMI, 36(8):1573–1585, 2014.

[32] T. Trzcinski, M. Christoudias, and V. Lepetit. Learning image descriptors with boosting. IEEE PAMI, 37(3):597–610, 2015.

[33] T. Trzcinski and V. Lepetit. Efficient discriminative projections for compact binary descriptors. In Proc. ECCV, pages 228–242, 2012.

[34] A.VedaldiandB.Fulkerson. VLFeat: Anopenandportable library of computer vision algorithms. http://www.vlfeat. org/, 2008.

[35] V. Vonikakis, D. Chrysostomou, R. Kouskouridas, and A. Gasteratos. Improving the robustness in feature detection bylocalcontrastenhancement. InProc.IST,pages158–163, 2012.

[36] Z. Wang, B. Fan, and F. Wu. Local intensity order pattern for feature description. In Proc. ICCV.

[37] S. Winder and M. Brown. Learning local image descriptors. In Proc. CVPR, 2007.

[38] S.Winder,G.Hua,andM.Brown. Pickingthebestdaisy. In Proc. CVPR, 2009.

[39] T.-Y. Yang, Y.-Y. Lin, and Y.-Y. Chuang. Accumulated stability voting: A robust descriptor from descriptors of multiple scales. In Proc. CVPR, pages 327–335, 2016.

[40] G. Yu and J.-M. Morel. ASIFT: an algorithm for fully affine invariant comparison. Image Processing On Line, 1, 2011.

[41] S. Zagoruyko and N. Komodakis. Learning to compare image patches via convolutional neural networks. In Proc. CVPR, 2015.

[42] C. L. Zitnick and K. Ramnath. Edge foci interest points. In Proc. ICCV, pages 359–366, 2011.

介绍HPatches,一个评估图像描述符的新基准,旨在克服现有数据集的局限性,提供更广泛的场景和评估协议,以实现更可靠和可重复的性能比较。

介绍HPatches,一个评估图像描述符的新基准,旨在克服现有数据集的局限性,提供更广泛的场景和评估协议,以实现更可靠和可重复的性能比较。

442

442

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?