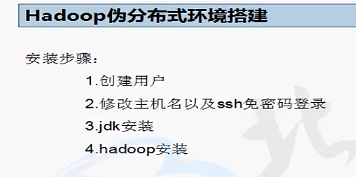

伪分布式环境搭建

1.hadoop简介 2.hadoop有三种搭建模式:单机模式(基本没用)、伪分布式模式、完全分布式模式

2.hadoop有三种搭建模式:单机模式(基本没用)、伪分布式模式、完全分布式模式

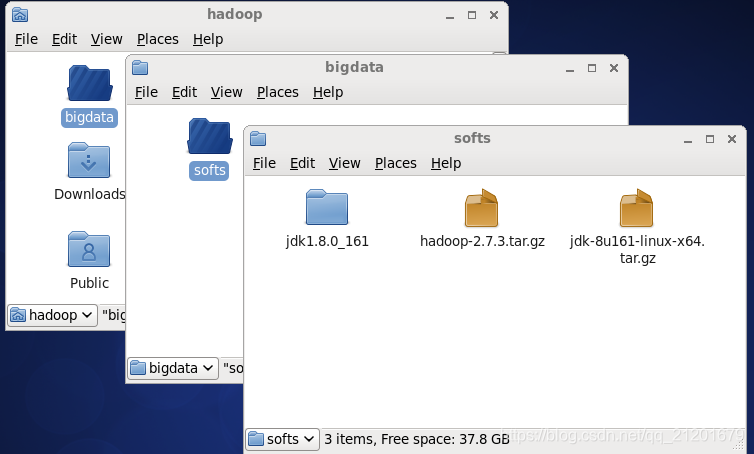

以伪分布式为主

3.搭建步骤:(由于搭建之前未曾想过要写博客,之后由于该过程较复杂为记录备忘,所以文中部分图片使用的是北风网教学视频中的截图,不太清晰,请见谅)

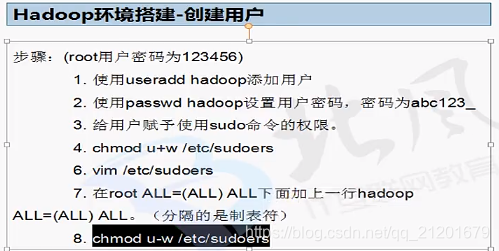

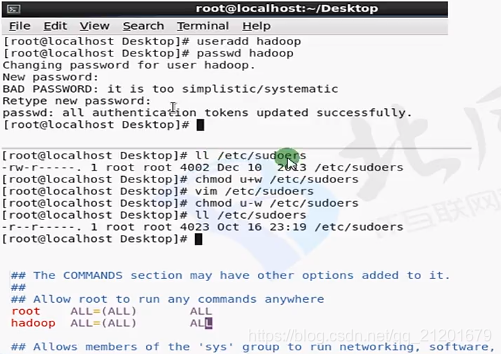

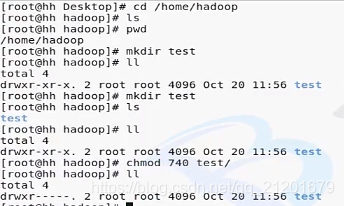

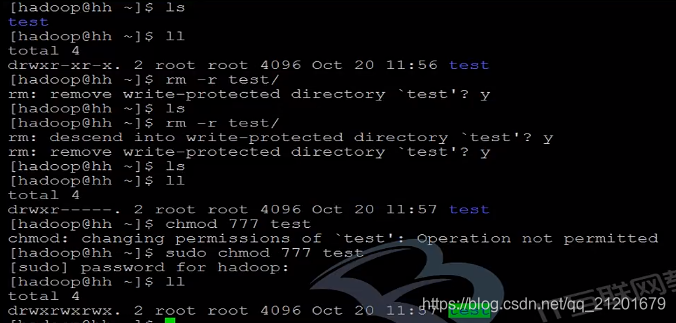

1)创建用户

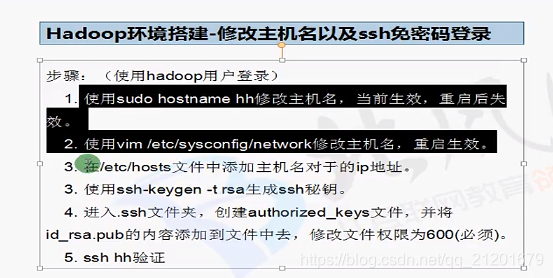

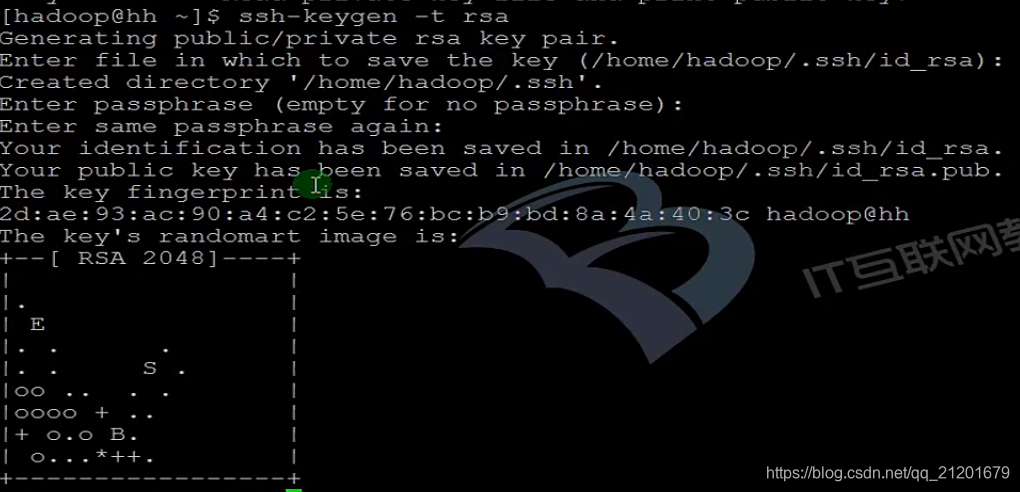

2)修改主机名及ssh免密码登录

2)修改主机名及ssh免密码登录

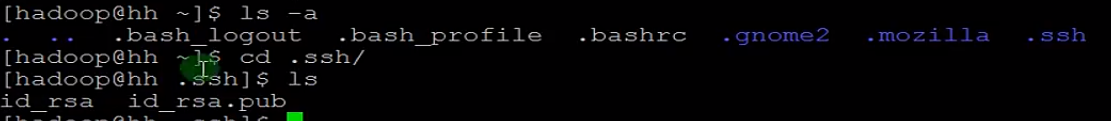

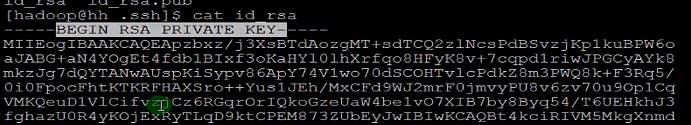

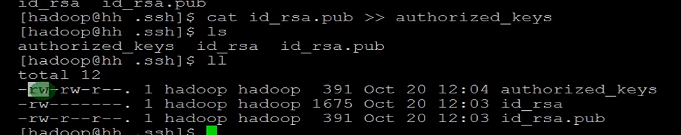

.ssh 密钥文件

.ssh 密钥文件

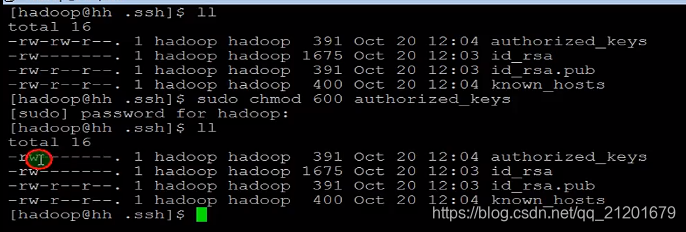

修改权限为600,否则会登录失败

修改权限为600,否则会登录失败 3)jdk安装

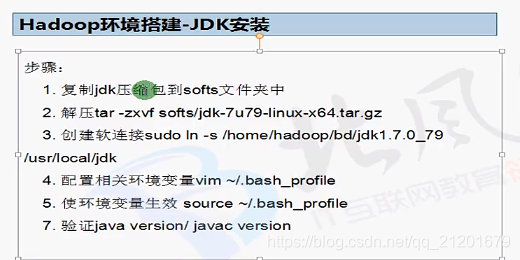

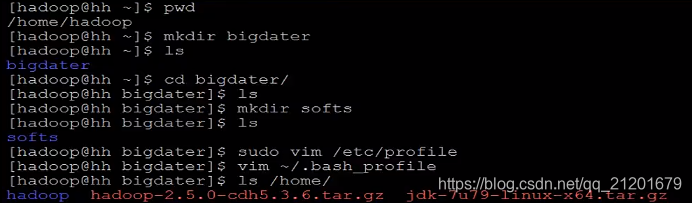

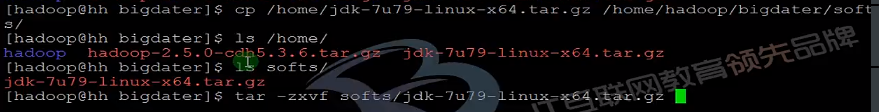

3)jdk安装

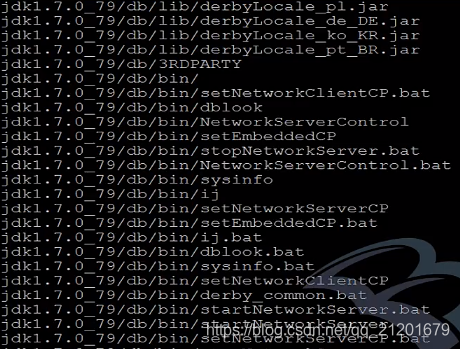

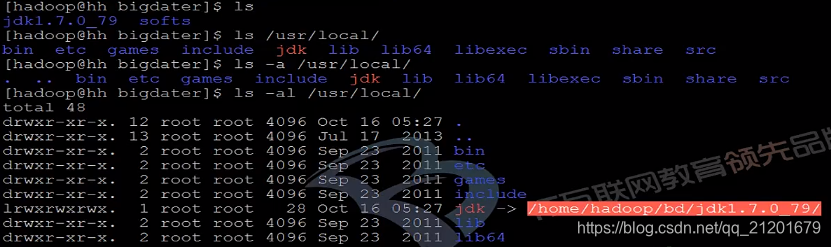

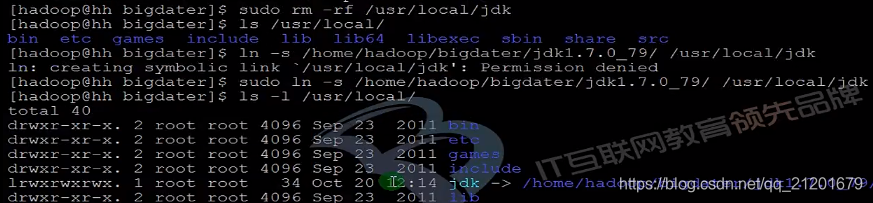

创建软连接

jdk创建成功

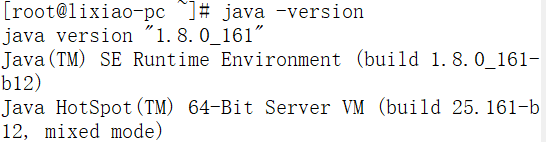

jdk创建成功 配置相关环境变量

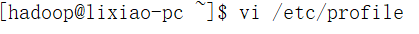

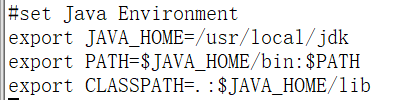

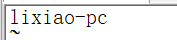

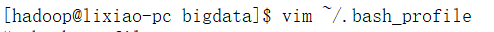

配置相关环境变量

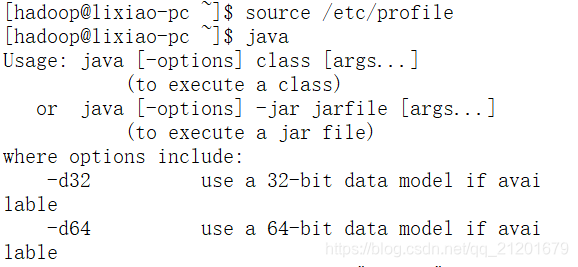

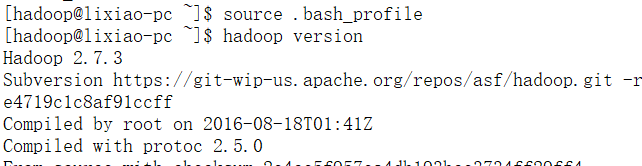

使环境变量生效 验证java是否安装成功

验证java是否安装成功

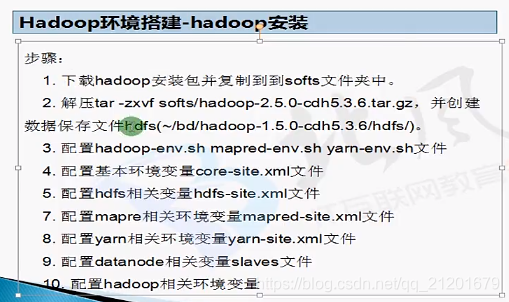

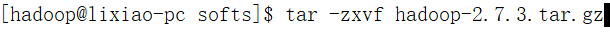

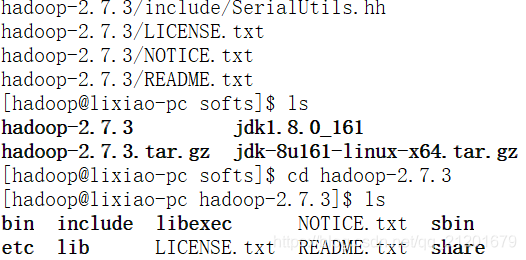

4)hadoop安装

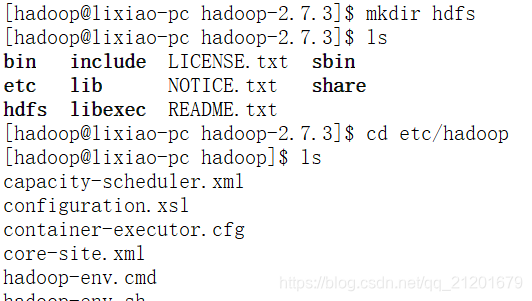

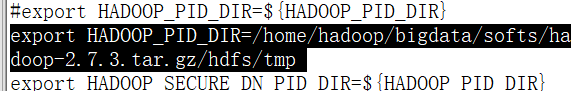

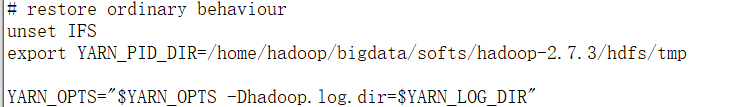

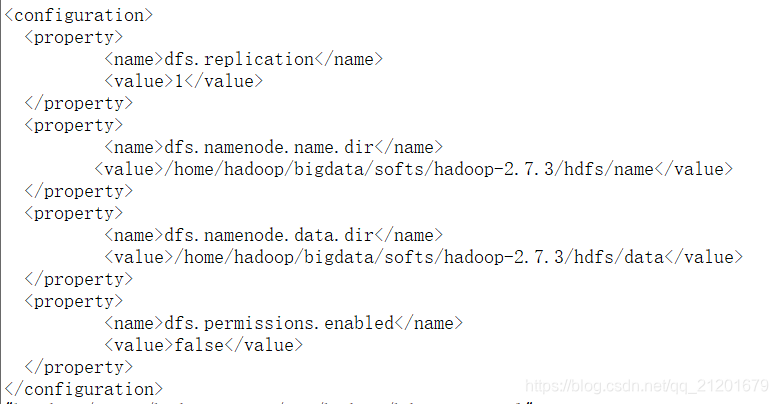

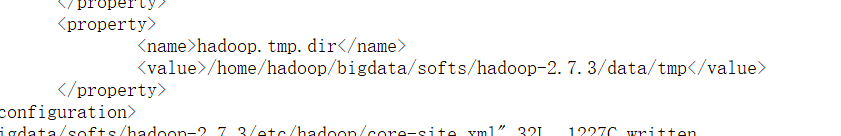

创建HDFS并修改环境变量

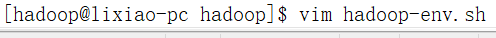

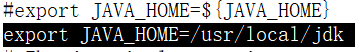

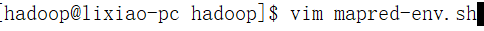

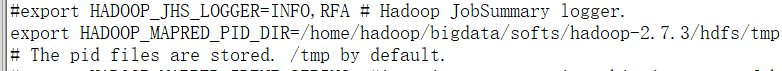

env配置启动信息

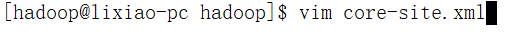

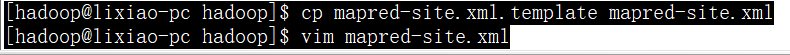

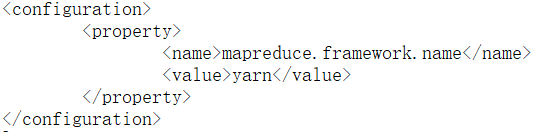

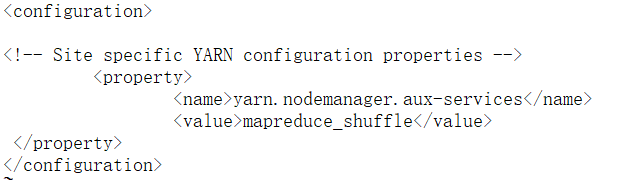

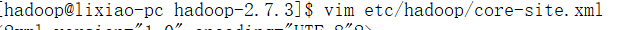

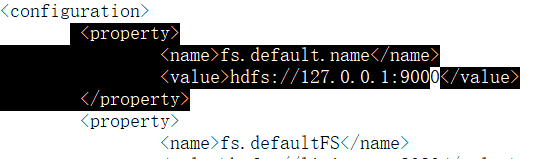

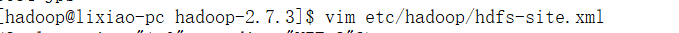

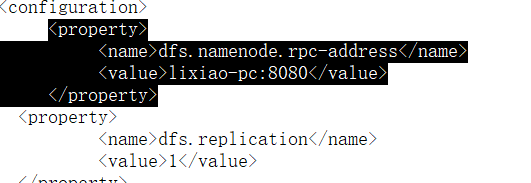

配置集群信息

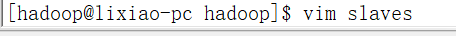

指定DataNode节点有哪些

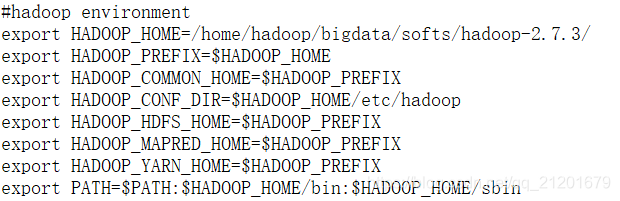

配置环境变量

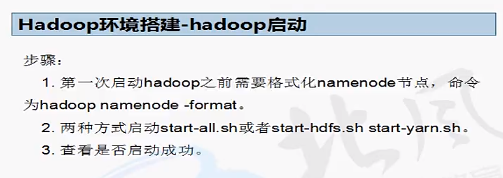

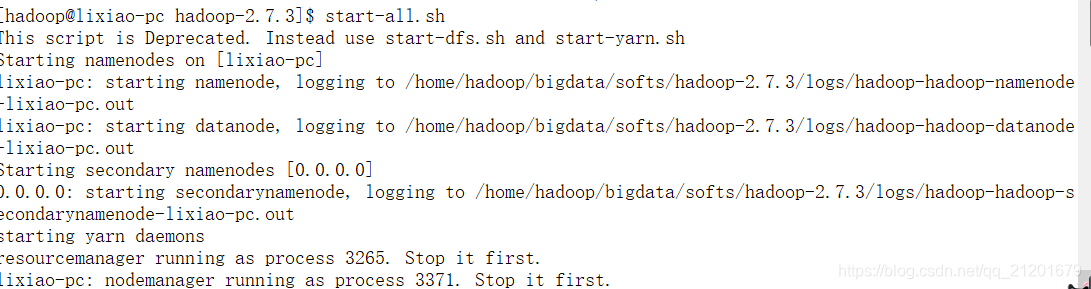

4.hadoop启动

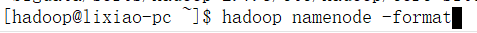

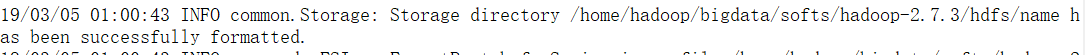

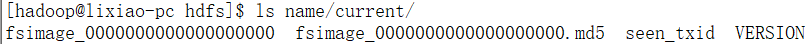

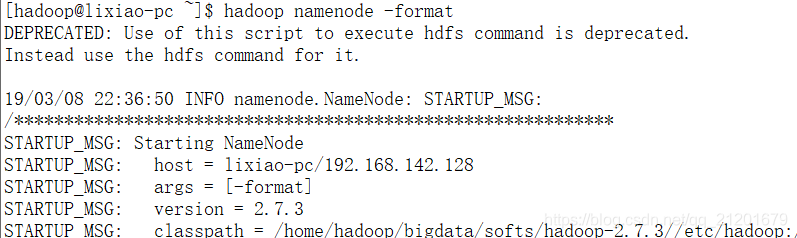

格式化namenode

该信息表示已经格式化成功了

该信息表示已经格式化成功了

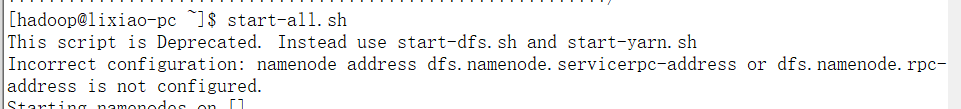

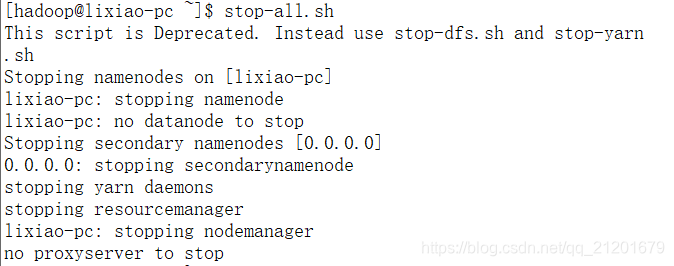

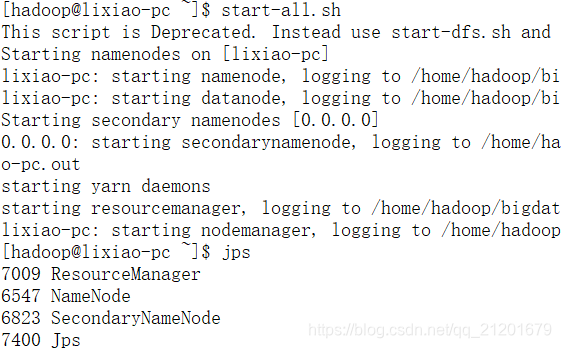

启动

报错,未显示namenode和datanode

解决方法:分别添加以下内容:

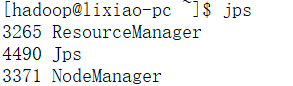

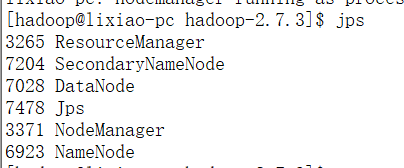

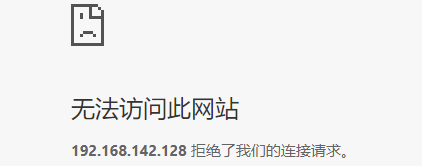

使用jps查看hadoop已正常启动,但是web界面一直拒绝连接

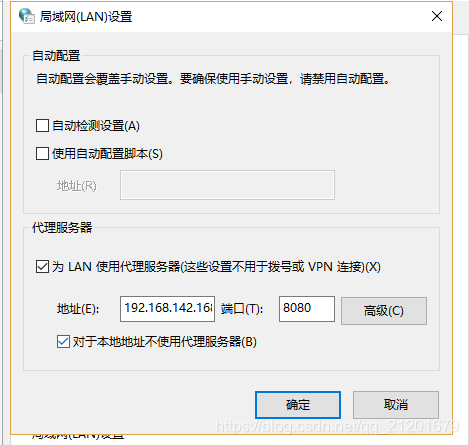

解决办法:控制面板-网络和internet-设置-Internet属性-连接-局域网设置

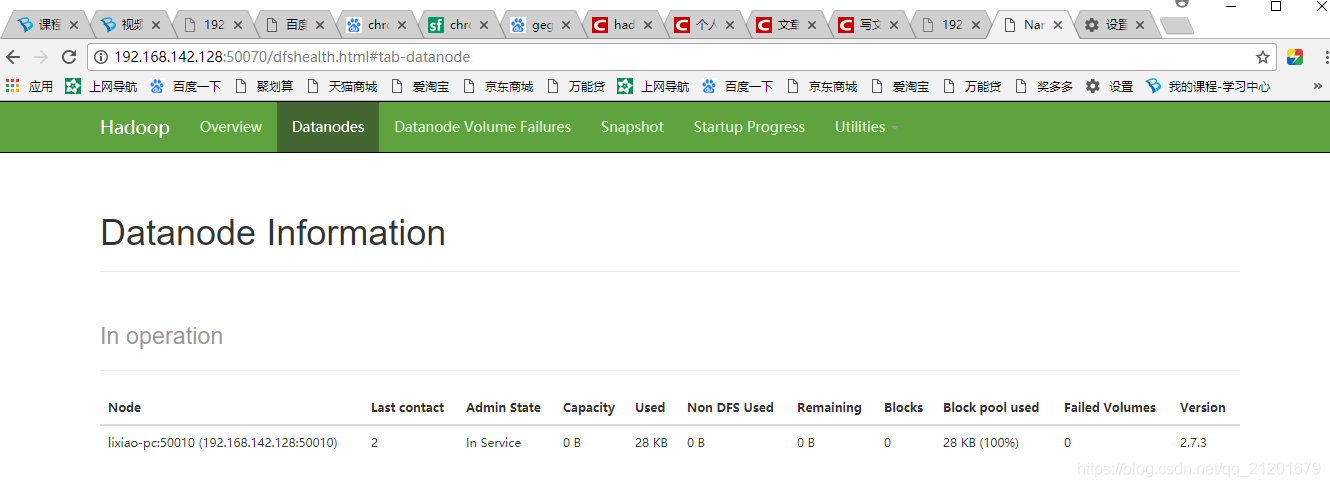

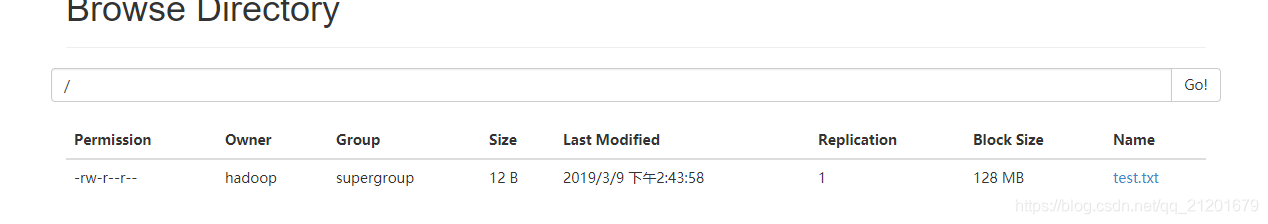

web界面即可正常启动

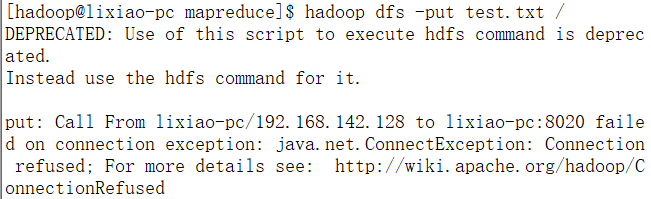

通过http://wiki.apache.org/hadoop/ConnectionRefused 网页的最后一句:

通过http://wiki.apache.org/hadoop/ConnectionRefused 网页的最后一句:

None of these are Hadoop problems, they are host, network and firewall configuration issues. As it is your cluster, only you can find out and track down the problem.

了解到,如果你的所有配置都是正确的,那么这个问题只能是host,network,firewall.

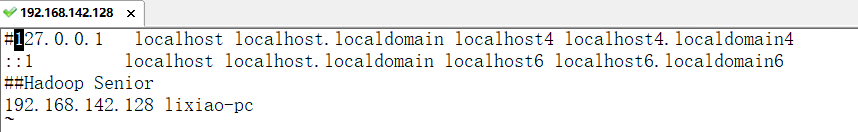

在帮助文档中,我看到有这么一句话:

Check that there isn’t an entry for your hostname mapped to 127.0.0.1 or 127.0.1.1 in /etc/hosts (Ubuntu is notorious for this)

于是我打开master中的hosts文件,查看是否有127.0.0.1

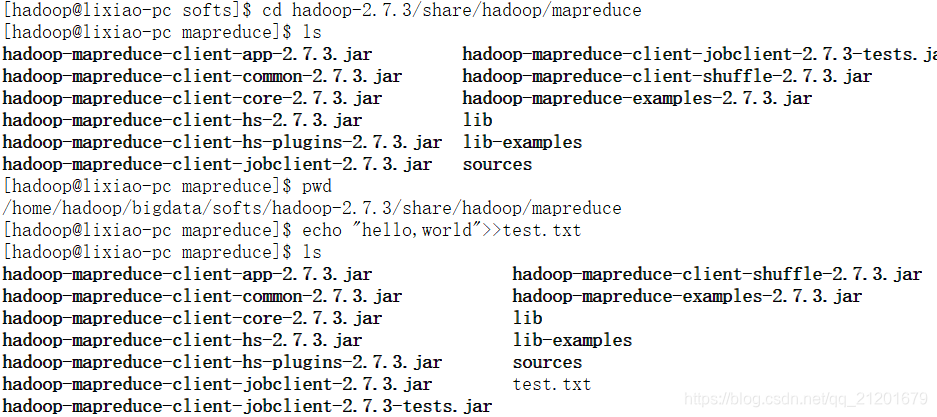

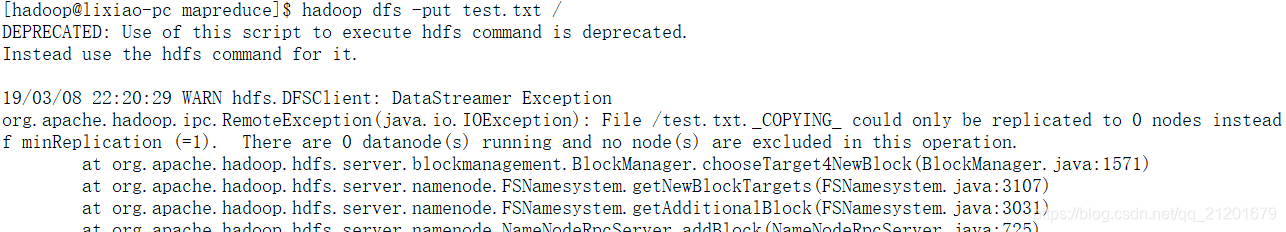

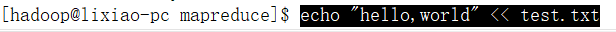

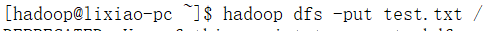

上传test.txt报错

错误原因应该是:

使用hadoop namenode -format格式化时格式化多次,造成那么spaceID不一致

重启集群即可解决

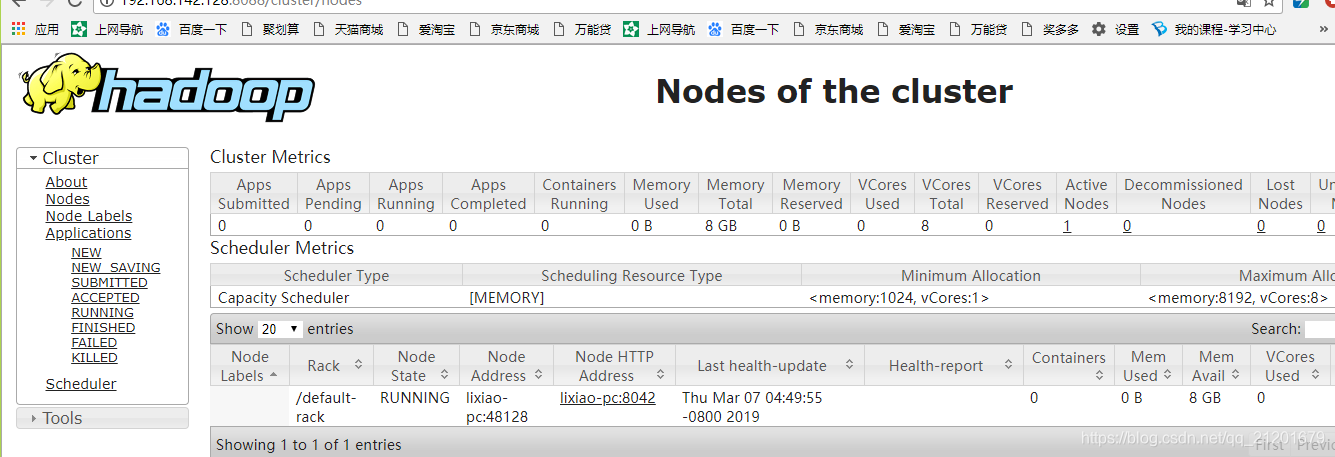

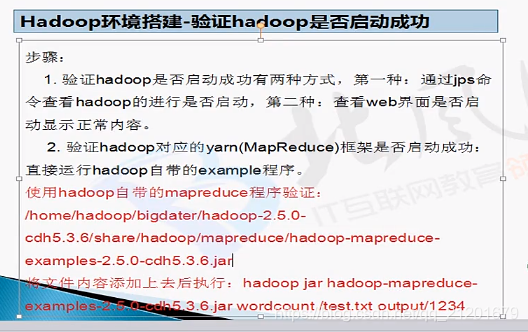

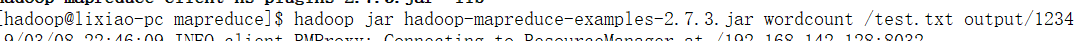

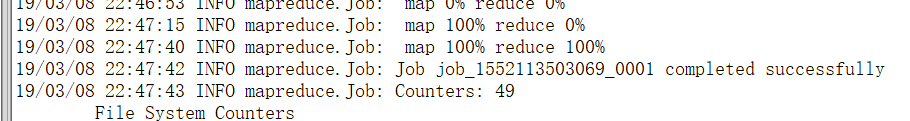

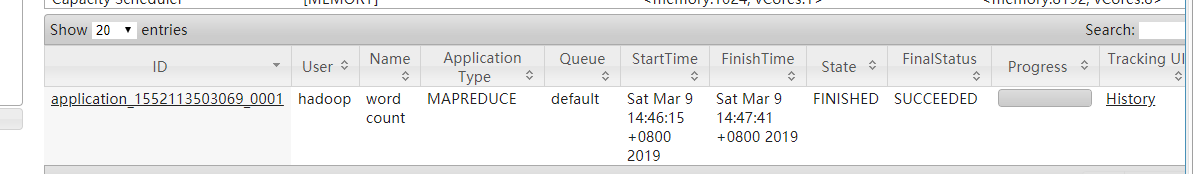

验证hadoop对应的yarn框架是否启动成功

本文详细介绍伪分布式Hadoop环境的搭建过程,包括用户创建、主机名修改、SSH免密码登录配置、JDK安装与环境变量设置、Hadoop安装与配置、集群启动及常见问题解决。针对web界面连接拒绝、hosts文件配置错误及多次格式化导致的问题提供解决方案。

本文详细介绍伪分布式Hadoop环境的搭建过程,包括用户创建、主机名修改、SSH免密码登录配置、JDK安装与环境变量设置、Hadoop安装与配置、集群启动及常见问题解决。针对web界面连接拒绝、hosts文件配置错误及多次格式化导致的问题提供解决方案。

712

712

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?