1. 需求说明

用Shell脚本和Flume采集Nginx日志信息,按日期分割上传到HDFS上,供后续清洗,分析使用。

2. 实现过程

2.1 Shell方式

分析:实现采集日志,需要在特定时间,如0点执行脚本将Nginx日志分离,重新生成新的日志,将过去的日志修改名字后上传到HDFS上。

#! /bin/bash

# Nginx 目录

NGINX_HOME=/usr/local/nginx

# 获取昨天的时间

YESTERDAY=`date -d"1 day ago" +"%Y%m%d"`

# Hadoop 目录

HADOOP_HOME=/opt/modules/cdh5.14.2/hadoop-2.6.0-cdh5.14.2

# 重命名

/bin/mv ${NGINX_HOME}/logs/access.log ${NGINX_HOME}/logs/access_${YESTERDAY}.log

# 回滚日志

${NGINX_HOME}/sbin/nginx -s reload

# 声明环境变量 执行用户

export HADOOP_USER_NAME=fanl

# 上传日志

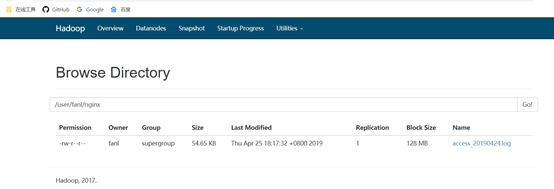

${HADOOP_HOME}/bin/hdfs dfs -put ${NGINX_HOME}/logs/access_${YESTERDAY}.log /user/fanl/nginx这里需要写个定时任务调度,使用crontab,这里就不再写了。直接执行验证。

2.2 Flume方式

通过一个Flume监控Nginx日志将信息发送到一个特定的端口,增加一个聚合Flume收

本文介绍了如何使用Shell脚本和Flume来采集Nginx的日志信息,并将其按日期分割上传到HDFS。在需求说明中,提到了Shell方式依赖定时任务调度,而Flume方式则通过配置两个代理实现实时监控和存储。通过这两种方法,可以为后续的数据清洗和分析提供日志数据。

本文介绍了如何使用Shell脚本和Flume来采集Nginx的日志信息,并将其按日期分割上传到HDFS。在需求说明中,提到了Shell方式依赖定时任务调度,而Flume方式则通过配置两个代理实现实时监控和存储。通过这两种方法,可以为后续的数据清洗和分析提供日志数据。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1644

1644

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?