本文详细介绍了检索增强生成(RAG)技术的四种主要架构:Naive RAG基础架构、Advanced RAG优化架构、Modular RAG模块化架构和Agentic RAG智能体架构。文章解析了每种架构的设计逻辑、核心模块及适用场景,并提供了基于需求目标、资源限制和数据特点的选择指南,帮助开发者构建高效精准的大语言模型知识检索与生成系统。

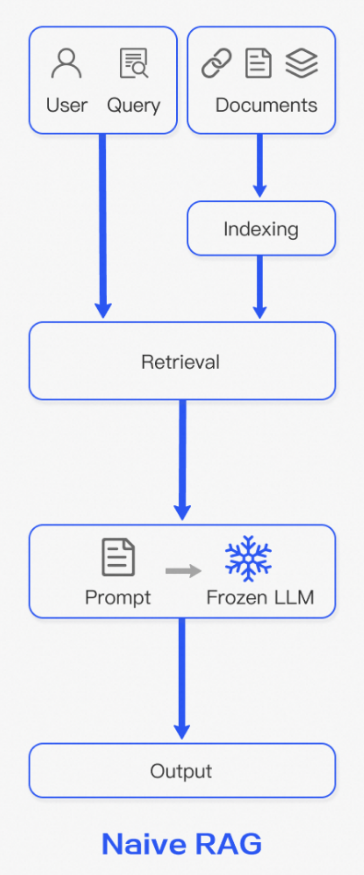

1、Naive RAG

Naive RAG是最底层的RAG架构,后续衍生出的一系列框架都基于此。其核心思想是通过将用户输入查询与知识库中的文档块(chunks)进行匹配,检索到相关内容后连同用户输入与提示词直接输入到大模型中总结并生成答案。

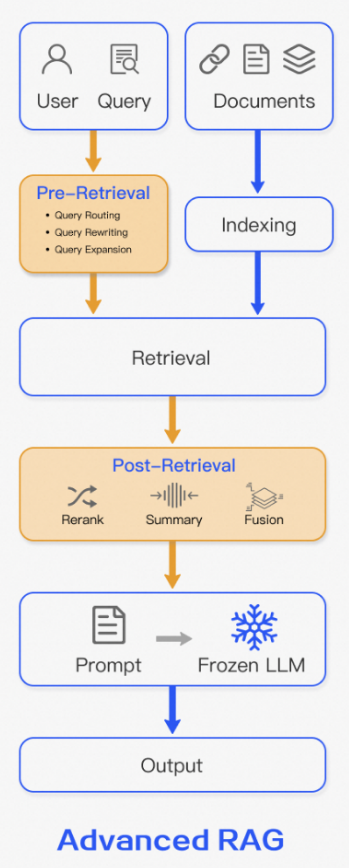

2、Advanced RAG

从Naive RAG到Adavanced RAG,主要在 检索前 和 检索后 两个阶段进行优化,

检索前优化

- chunk 分块策略选择:采用按行 / 句 / 段落、滑动窗口、语义等方式分块;分块粒度影响信息质量与计算成本 —— 块大易含噪声,块小则消耗更多计算资源。

- 元数据增强:可按作者、时间、类别等元数据过滤 chunk(如限定时间范围),也可人工添加段落摘要、假设性问题等元数据。

- 用户查询优化:通过改写(如 “国家专精特新“小巨人”企业如何去申请?” 改 “流程和材料有哪些?”)、分解(拆为条件、材料、办理地点)、扩展(补充国家专精特新“小巨人”企业/省级专精特新中小企业差异、审批周期)优化查询。

- HyDE 技术:让 LLM 先无外部知识生成查询答案,再用答案 + 原始查询检索,提升查询泛化性。

检索后优化

- Rerank 重排序:

- 分两阶段:①粗检索:从海量数据快速筛选候选文档;②精排序:用 rerank 模型(交叉编码器)联合编码查询与文档,输出相关性分数,精准评估提升结果质量。

- 优势:直接处理原始信息减损耗,可动态提取文档与查询相关部分,提高评估准确性。

- 上下文压缩:剪掉 chunk 无关内容,仅留与问题相关部分;通过 LLM 按场景用选择性保留、摘要压缩等方式实现。

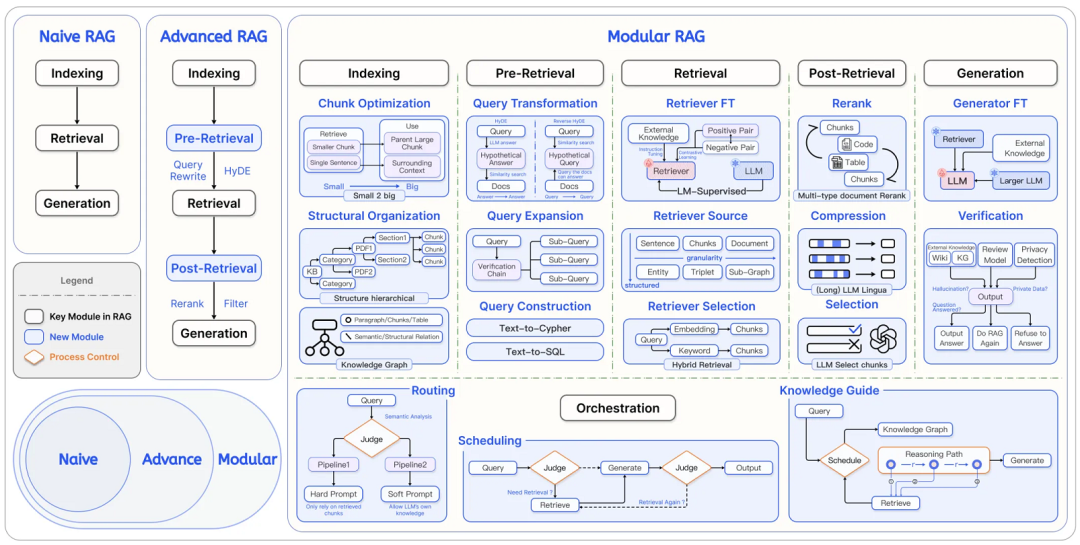

3、Modular RAG

Advanced RAG 通过两阶段检索(召回+重排序)显著提升了效果,但这种架构仍然是‘固定流水线’——所有查询都走同样的流程。实际的场景中,可能需要定制化的流程。为此,Modular RAG 架构应运而生,其采用模块化设计,将RAG流程分解为若干核心功能模块,涵盖从数据检索到生成优化的完整链路。具体而言,该架构包含七大类模块:

Indexing(索引)

负责将文档切割为可管理的 chunk 并存入向量数据库,核心挑战与解决思路如下:

核心挑战

- 内容表达不完整

- 块相似度搜索准确性不足

- 引用链模糊

解决思路

- 块优化:Small-to-Big 方法

- 检索阶段:用小块做高精度语义检索,精准定位问题核心

- 生成阶段:根据匹配的小块,关联其所属的大块,基于大块生成答案

- 结构化组织

(1)分层索引

以树状结构组织文档内容关系,节点存数据摘要以快速提取关键信息,构建方法包括:

- 基于段落、句子分割的结构

- 基于 html、latex 等内在格式的结构

- 基于语义识别分割的语义感知结构

(2) 知识图谱索引

用知识图谱建立概念与实体的关联,将碎片化信息结构化。

Pre-retrieval(预检索)

基础 RAG 中,用户查询与 chunk 的相似度匹配过度依赖原始查询,因查询措辞模糊、语言歧义(如 “uv” 难辨是包管理器还是紫外线指数)导致检索效果差,解决思路如下:

- 查询转换:

- HyDE:LLM 不依赖外部知识生成假设性回复,用该回复在向量库检索相似真实文档块;

- reverse HyDE:为每个文档块生成假设性问题并关联,将用户查询向量与问题向量匹配(适用于问题与答案差异大的场景,如查询 “如何让 git 提交记录更干净”,匹配含 “git rebase 整理提交历史” 的文档块)。

- 查询扩展:将用户查询视为 “意图种子”,拓展多角度子问题,结合原始查询与子问题在向量库检索,所有结果作为候选集。

- 查询构建:RAG 集成结构化数据时,将用户查询转为 Text2sql 或 Text2cypher,以访问不同数据源。

Retrieval(检索)

检索中,向量模型将查询与文本转化为潜在空间向量,以建立语义相似性,需关注三大关键点:①检索效率;②检索质量;③检索任务、数据与模型的一致性。

- 稀疏检索器

通过统计方法将查询和文档转化为稀疏向量(维度对应词表,权重由统计特征决定),核心是筛选少量高相关特征,典型方法:

- TF-IDF:结合词频(TF,词在文档中出现频率)与逆文档频率(IDF,总文档数 / 含该词文档数,区分词的重要性,如 “的”“是” IDF 低,领域专有名词 IDF 高),评估词对文档的重要性。

- BM25:基于概率的排序函数,在词频基础上加入文档长度等因素,假设查询词独立,累加单词与文档的相关得分,得到总相关性。

- 密集检索器

用预训练语言模型(如 BERT、GPT 系列)将文档和查询嵌入为密集向量(维度不对应具体词,而是语义)。

- Retriever FT

利用特定领域数据,对通用检索器进行 “二次训练”,使其学习领域语义关系,提升专业文档匹配精准度。

Post-Retrieval(后检索)

将检索文档块直接输入大模型非最佳选择,易出现三类问题:

- 中间遗忘效应:LLM 易记住文本开头与结尾,遗忘中间内容;

- 噪声干扰:检索返回的文档块可能含无效噪声信息;

- 上下文窗口限制:LLM 自身窗口大小,无法处理过量检索内容。

对应的解决思路:

- Rerank(重排序):对检索文档块重新排序,提升高相关文档优先级;

- 上下文压缩:针对文档块信息冗余问题,用微调小模型(如 GPT-2 Small)移除无关内容,转化为 LLM 易理解的形式;

- 选择性上下文:让 LLM 在生成最终答案前,评估并过滤检索内容中的不相关文档。

Generation(生成)

利用 LLM 结合用户查询及上下文生成答案时,需按任务需求选模型,核心考量两点:1)是否需微调;2)推理效率。

对应解决思路:

- 生成器微调:用特定任务数据集微调生成模型,使其能将检索知识转化为符合需求的自然语言输出;

- 验证环节:虽 RAG 可提升 LLM 输出可靠性,但仍可能出现幻觉,需通过验证模块过滤不符合要求的生成答案。

Orchestration(编排)

编排是 RAG 流程的控制模块,核心是依据用户查询动态智能选择、组合功能模块,以高效精准完成任务,区别于固定线性的 Naive RAG 与 Advanced RAG,关键在于自适应决策能力。

- 路由

RAG 系统按查询特性导向最优处理路径,适配多场景架构:

- 元数据路由:从查询提取关键词、实体或意图,匹配索引数据块的元数据(如日期、来源、章节),将查询路由至最相关子文档集或特定检索器(例:“2024 年财报” 查询,路由至标有 “2024”“财报” 的文档库);

- 语义路由:通过深层语义理解判断查询真实意图,选择最优处理模块(例:资讯 agent 接收 “林业最近有哪些政策”,先识别是否需调用工具,再决定直接回复或进一步处理)。

- 调度

负责 RAG 全流程执行,确保高效有序,关键节点精准判断:

- 知识引导调度(高级策略):借助知识图谱规划解题路径,流程为:先从知识图谱提取问题相关核心概念与关系,构建临时 “推理链 / 子图”(任务地图,明确关键信息节点);再按节点调度检索、生成模块,逐一获取并处理信息,最终汇总成答案。

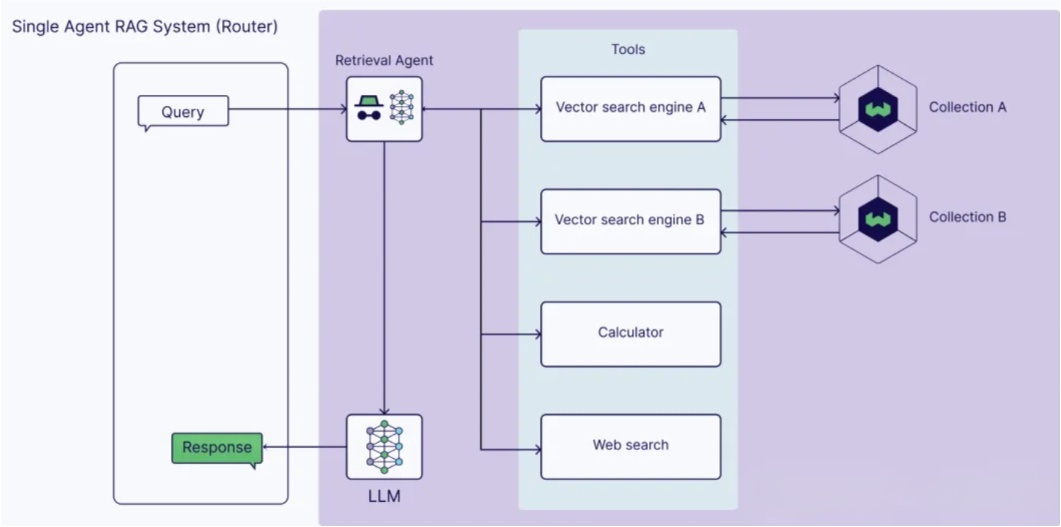

4、Agentic RAG

基础 RAG 流程依赖单一外部知识源,仅检索一次上下文,不验证检索质量、无推理能力。Agentic RAG 是引入 AI 智能体的 RAG 实现方式,通过智能体编排组件、执行更多动作以突破前者局限,当前更强调在检索模块的应用,复杂度可高可低:简单的单智能体架构(Single-Agent Agentic RAG)仅作路由器,复杂场景则组合为多智能体架构(Multi-Agent Agentic RAG)。

Single-Agent Agentic RAG

传统 RAG 是固定 “检索 - 生成” 流水线,而 Single-Agent Agentic RAG 引入智能体,可依问题类型动态选工具,更灵活强大。

-

接收查询:用户输入如 “国家最近有发布哪些优惠政策?”

-

检索代理路由:智能体分析意图,并实现 路由 分配,决定下一步该调用哪个工具。

如果查询是“工信部有发布哪些政策?”,它可能会判断信息在collection A中,路由到“Vector search engine A”;

如果查询是“科技部有发布哪些政策?”,它可能会判断信息在collection B中,路由到“Vector search engine B”;

-

工具执行:对应工具启动,向量搜索引擎在专属知识库(Collection A / B)检索相关攻略片段。

-

生成结果:工具返回信息与原查询整合后送 LLM,由 LLM 梳理总结成最终回答。

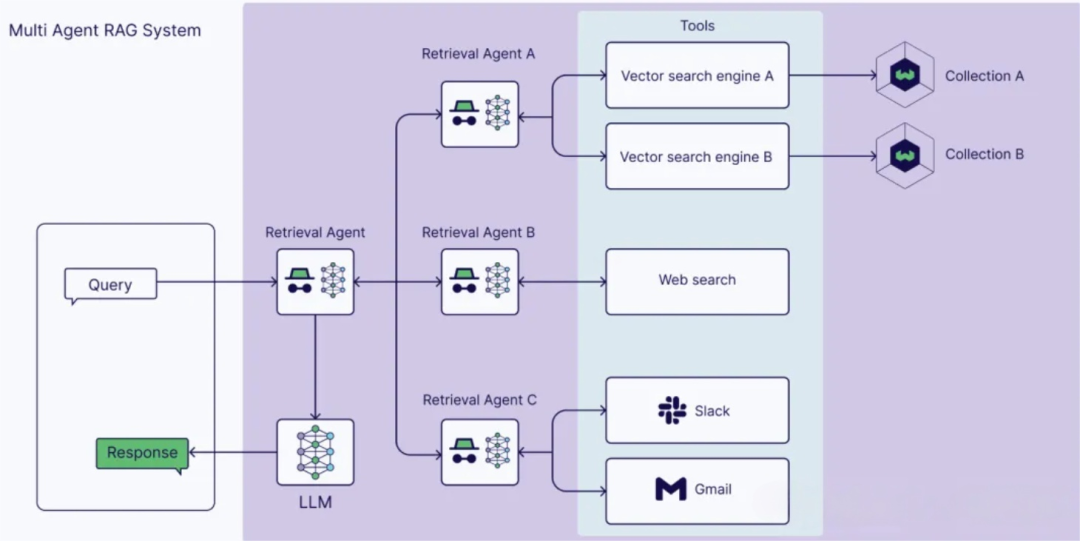

Multi-Agent Agentic RAG

单智能体系统存在局限,可通过多个专用智能体细化复杂工作流与不同查询类型。

以示例架构为例:核心检索 Agent 负责协调下级三个专用 Agent 获取信息 ——Agent A 从内部专有数据源检索,Agent B 专注网络搜索获取外部信息,Agent C 从个人账户提取数据。

此模式下,RAG 系统不再是简单 “检索器 + 生成器”,能模拟专家团队解决复杂问题。

5、选择决策指南

1. 优先选 Naive RAG 的情况

- 需求目标:仅需验证 RAG 可行性,或搭建简单问答原型;

- 资源限制:开发人力≤2 人,算力预算<1 万元 / 年,开发周期<1 个月;

- 数据特点:文档数量<1000 份,格式单一(仅文本),领域固定(无跨领域需求)。

2. 优先选 Advanced RAG 的情况

- 需求目标:需提升问答准确率,处理中等复杂度查询(如多条件筛选、数据对比);

- 资源限制:开发人力 2-3 人,算力预算 1-5 万元 / 年,开发周期 1-2 个月;

- 数据特点:文档数量 1000-10000 份,支持多源文本(如 PDF、Word),需处理歧义查询。

3. 优先选 Modular RAG 的情况

- 需求目标:搭建可长期迭代的大规模知识库,支持多部门定制化需求,需频繁升级功能;

- 资源限制:开发人力 4-6 人,算力预算 5-20 万元 / 年,开发周期 2-3 个月;

- 数据特点:文档数量>10000 份,多格式(文本 + 表格 + 图片),跨领域(如技术 + 市场 + 法务),需对接企业内部系统(如 CRM、OA)。

4. 优先选 Agentic RAG 的情况

- 需求目标:处理复杂决策型任务,需自主完成多步骤流程,需调用外部工具补充能力;

- 资源限制:开发人力 5-8 人(含算法工程师),算力预算 20-100 万元 / 年,开发周期 3-6 个月;

- 数据特点:需结合结构化数据(数据库)、实时数据(API 接口)与非结构化文档,任务需多轮交互(如 “先检索数据→再分析→最后生成报告”)。

如何从零学会大模型?小白&程序员都能跟上的入门到进阶指南

当AI开始重构各行各业,你或许听过“岗位会被取代”的焦虑,但更关键的真相是:技术迭代中,“效率差”才是竞争力的核心——新岗位的生产效率远高于被替代岗位,整个社会的机会其实在增加。

但对个人而言,只有一句话算数:

“先掌握大模型的人,永远比后掌握的人,多一次职业跃迁的机会。”

回顾计算机、互联网、移动互联网的浪潮,每一次技术革命的初期,率先拥抱新技术的人,都提前拿到了“职场快车道”的门票。我在一线科技企业深耕12年,见过太多这样的案例:3年前主动学大模型的同事,如今要么成为团队技术负责人,要么薪资翻了2-3倍。

深知大模型学习中,“没人带、没方向、缺资源”是最大的拦路虎,我们联合行业专家整理出这套 《AI大模型突围资料包》,不管你是零基础小白,还是想转型的程序员,都能靠它少走90%的弯路:

- ✅ 小白友好的「从零到一学习路径图」(避开晦涩理论,先学能用的技能)

- ✅ 程序员必备的「大模型调优实战手册」(附医疗/金融大厂真实项目案例)

- ✅ 百度/阿里专家闭门录播课(拆解一线企业如何落地大模型)

- ✅ 2025最新大模型行业报告(看清各行业机会,避免盲目跟风)

- ✅ 大厂大模型面试真题(含答案解析,针对性准备offer)

- ✅ 2025大模型岗位需求图谱(明确不同岗位需要掌握的技能点)

所有资料已整理成包,想领《AI大模型入门+进阶学习资源包》的朋友,直接扫下方二维码获取~

① 全套AI大模型应用开发视频教程:从“听懂”到“会用”

不用啃复杂公式,直接学能落地的技术——不管你是想做AI应用,还是调优模型,这套视频都能覆盖:

- 小白入门:提示工程(让AI精准输出你要的结果)、RAG检索增强(解决AI“失忆”问题)

- 程序员进阶:LangChain框架实战(快速搭建AI应用)、Agent智能体开发(让AI自主完成复杂任务)

- 工程落地:模型微调与部署(把模型用到实际业务中)、DeepSeek模型实战(热门开源模型实操)

每个技术点都配“案例+代码演示”,跟着做就能上手!

课程精彩瞬间

② 大模型系统化学习路线:避免“学了就忘、越学越乱”

很多人学大模型走弯路,不是因为不努力,而是方向错了——比如小白一上来就啃深度学习理论,程序员跳过基础直接学微调,最后都卡在“用不起来”。

我们整理的这份「学习路线图」,按“基础→进阶→实战”分3个阶段,每个阶段都明确:

- 该学什么(比如基础阶段先学“AI基础概念+工具使用”)

- 不用学什么(比如小白初期不用深入研究Transformer底层数学原理)

- 学多久、用什么资料(精准匹配学习时间,避免拖延)

跟着路线走,零基础3个月能入门,有基础1个月能上手做项目!

③ 大模型学习书籍&文档:打好理论基础,走得更稳

想长期在大模型领域发展,理论基础不能少——但不用盲目买一堆书,我们精选了「小白能看懂、程序员能查漏」的核心资料:

- 入门书籍:《大模型实战指南》《AI提示工程入门》(用通俗语言讲清核心概念)

- 进阶文档:大模型调优技术白皮书、LangChain官方中文教程(附重点标注,节省阅读时间)

- 权威资料:斯坦福CS224N大模型课程笔记(整理成中文,避免语言障碍)

所有资料都是电子版,手机、电脑随时看,还能直接搜索重点!

④ AI大模型最新行业报告:看清机会,再动手

学技术的核心是“用对地方”——2025年哪些行业需要大模型人才?哪些应用场景最有前景?这份报告帮你理清:

- 行业趋势:医疗(AI辅助诊断)、金融(智能风控)、教育(个性化学习)等10大行业的大模型落地案例

- 岗位需求:大模型开发工程师、AI产品经理、提示工程师的职责差异与技能要求

- 风险提示:哪些领域目前落地难度大,避免浪费时间

不管你是想转行,还是想在现有岗位加技能,这份报告都能帮你精准定位!

⑤ 大模型大厂面试真题:针对性准备,拿offer更稳

学会技术后,如何把技能“变现”成offer?这份真题帮你避开面试坑:

- 基础题:“大模型的上下文窗口是什么?”“RAG的核心原理是什么?”(附标准答案框架)

- 实操题:“如何优化大模型的推理速度?”“用LangChain搭建一个多轮对话系统的步骤?”(含代码示例)

- 场景题:“如果大模型输出错误信息,该怎么解决?”(教你从技术+业务角度回答)

覆盖百度、阿里、腾讯、字节等大厂的最新面试题,帮你提前准备,面试时不慌!

以上资料如何领取?

这份完整版的大模型 AI 学习资料已经上传优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

为什么现在必须学大模型?不是焦虑,是事实

最近英特尔、微软等企业宣布裁员,但大模型相关岗位却在疯狂扩招:

- 大厂招聘:百度、阿里的大模型开发岗,3-5年经验薪资能到50K×20薪,比传统开发岗高40%;

- 中小公司:甚至很多传统企业(比如制造业、医疗公司)都在招“会用大模型的人”,要求不高但薪资可观;

- 门槛变化:不出1年,“有大模型项目经验”会成为很多技术岗、产品岗的简历门槛,现在学就是抢占先机。

风口不会等任何人——与其担心“被淘汰”,不如主动学技术,把“焦虑”变成“竞争力”!

最后:全套资料再领一次,别错过这次机会

这份完整版的大模型 AI 学习资料已经上传优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

857

857

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?