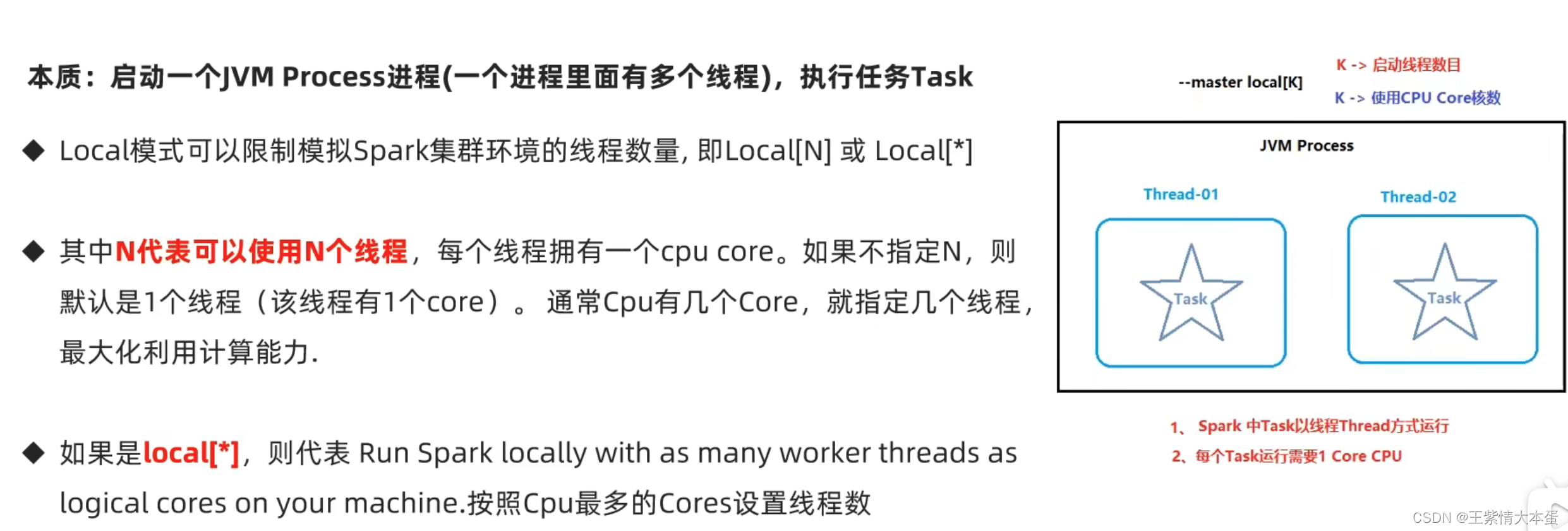

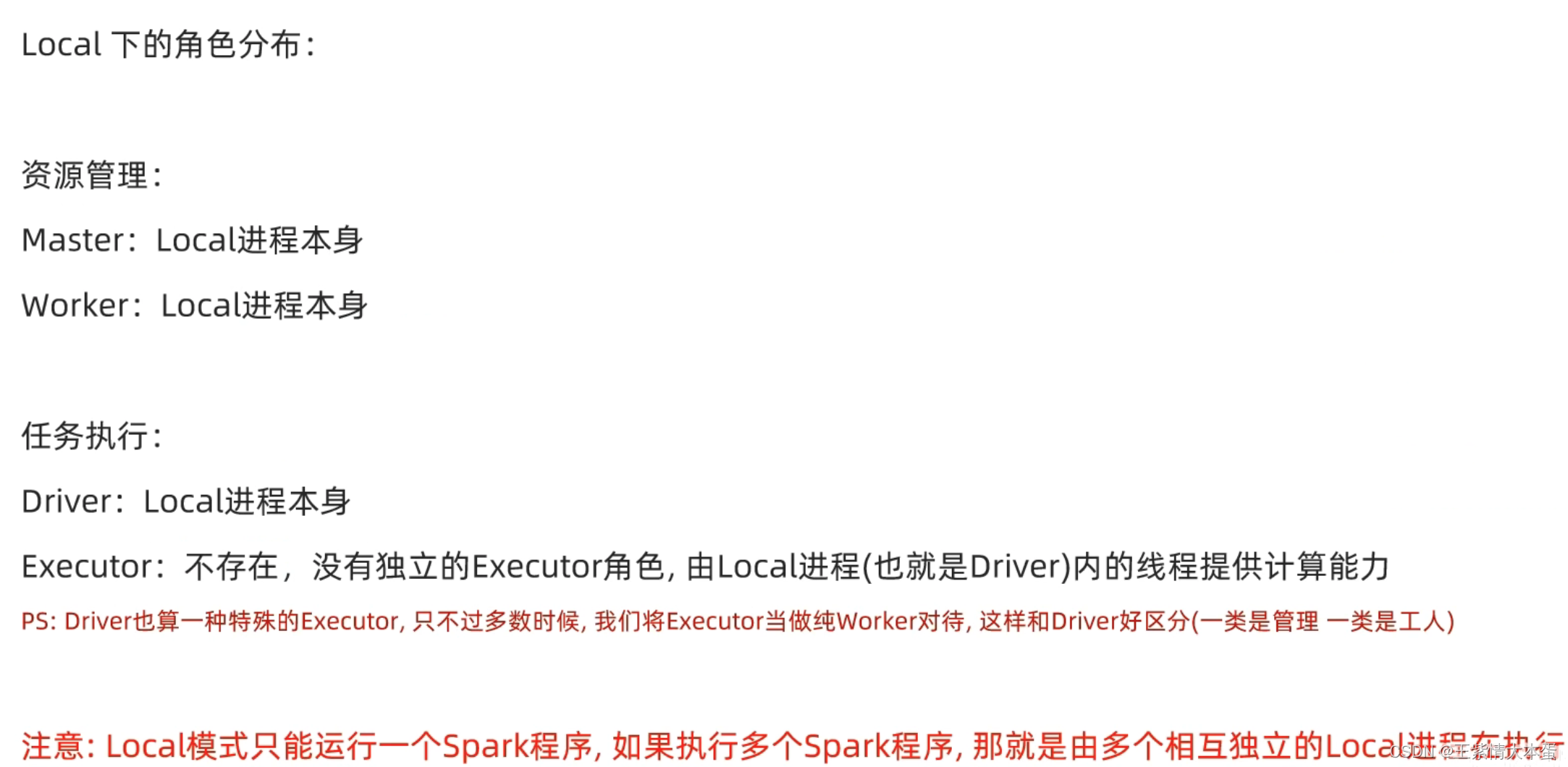

1.SPARK的local模式原理

local[4]的角色图,两个程序可以运行

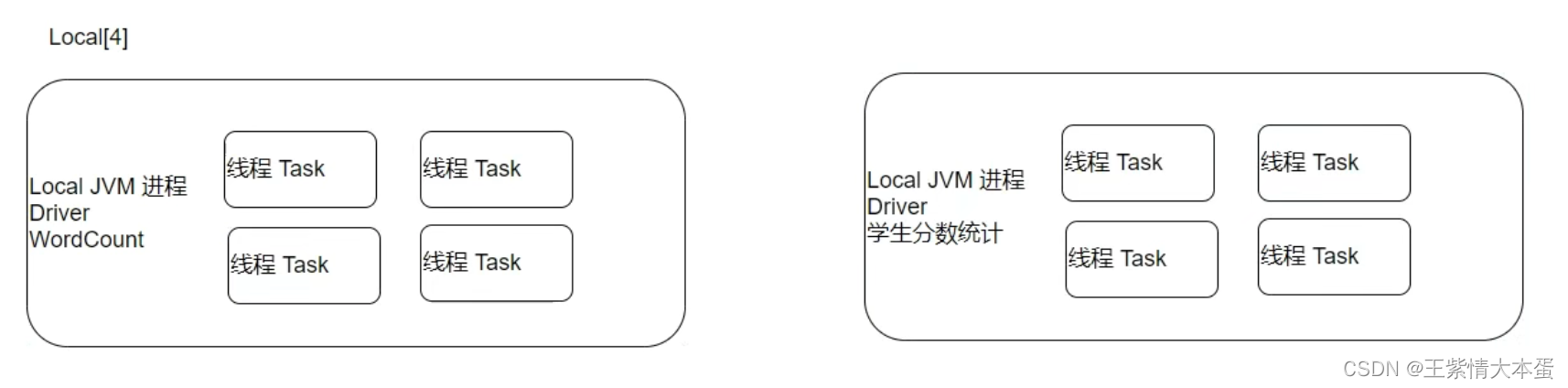

运行spark local[*]模式

也可以向spark中提交已经写好的python程序,spark- submit

local模式总结

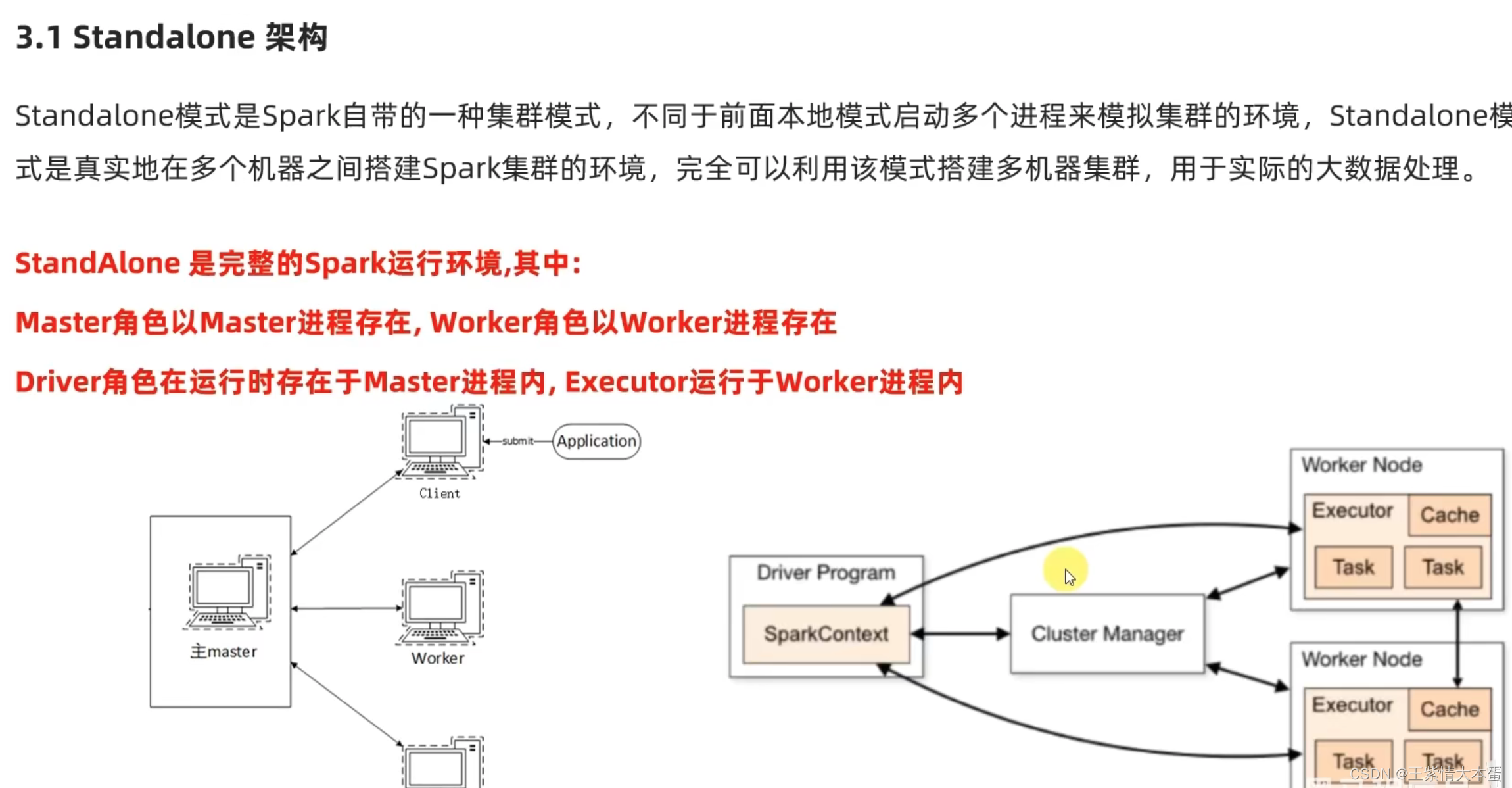

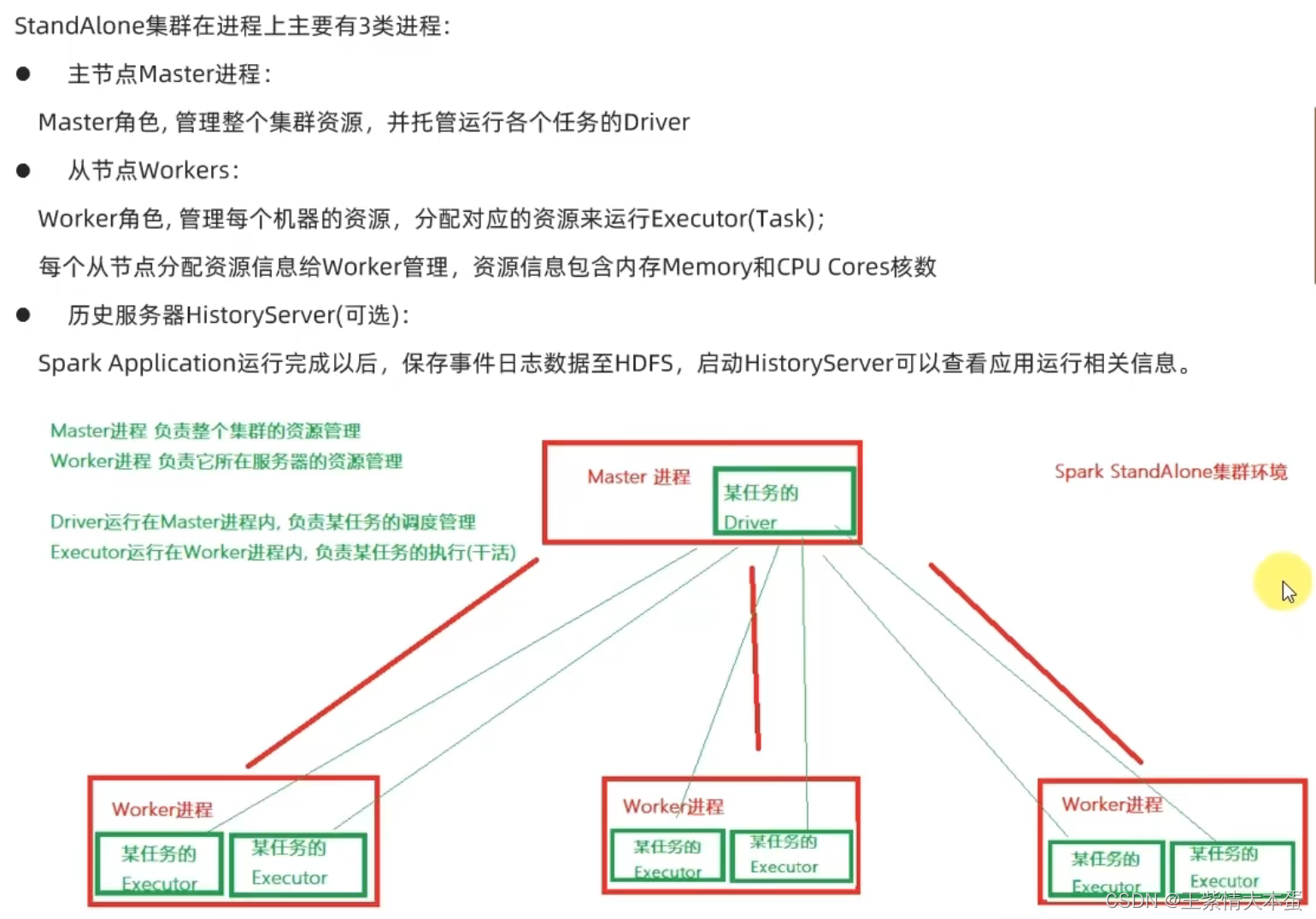

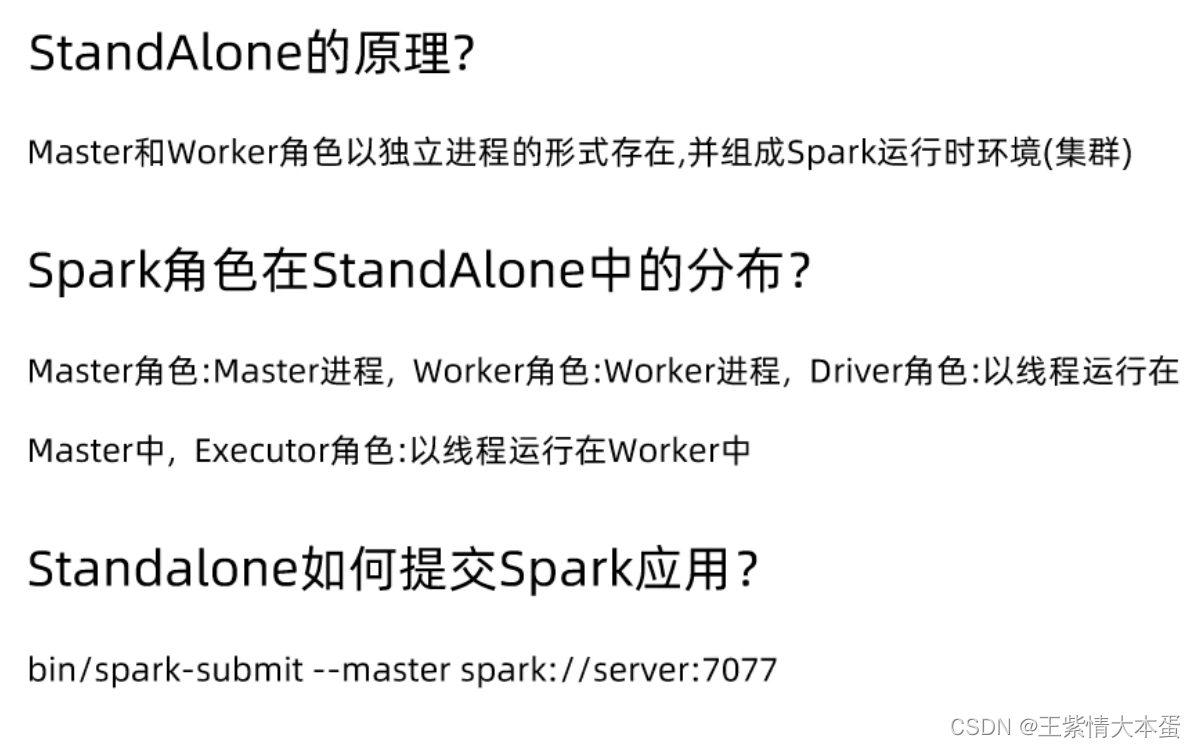

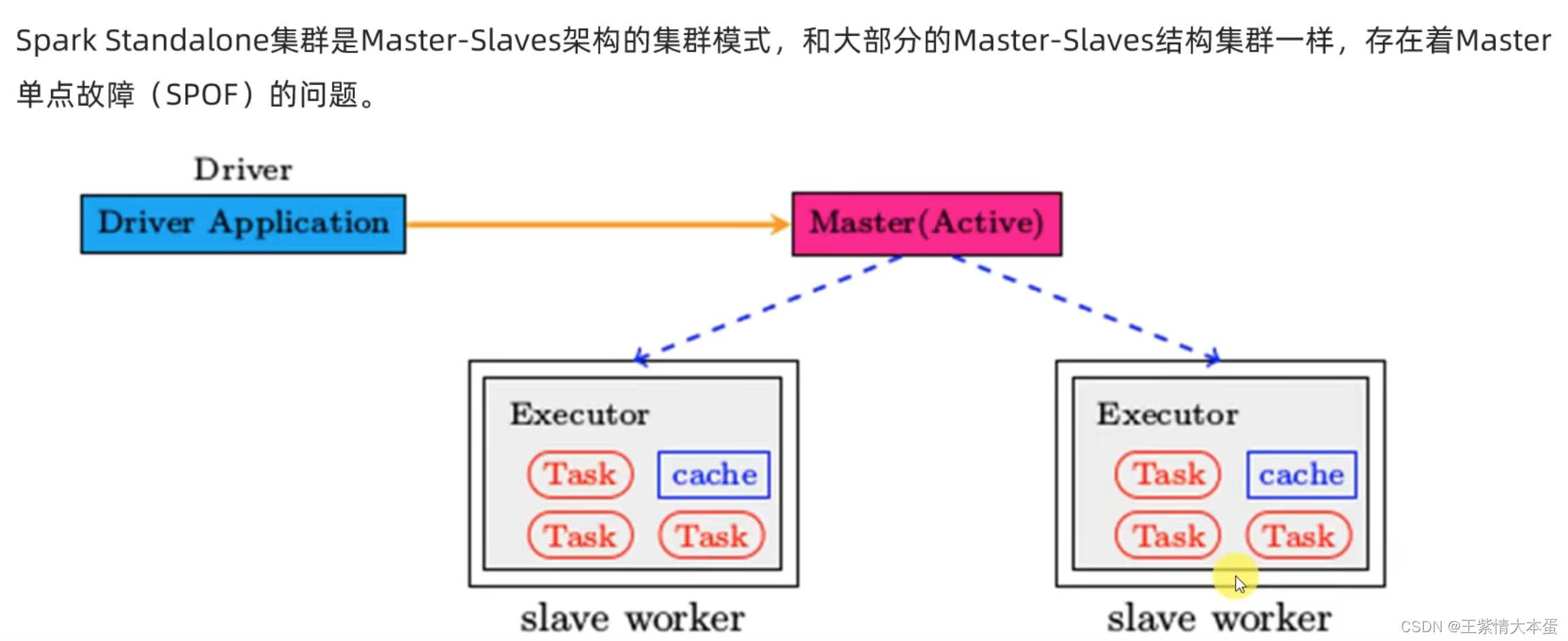

2.SPARK的standalone原理

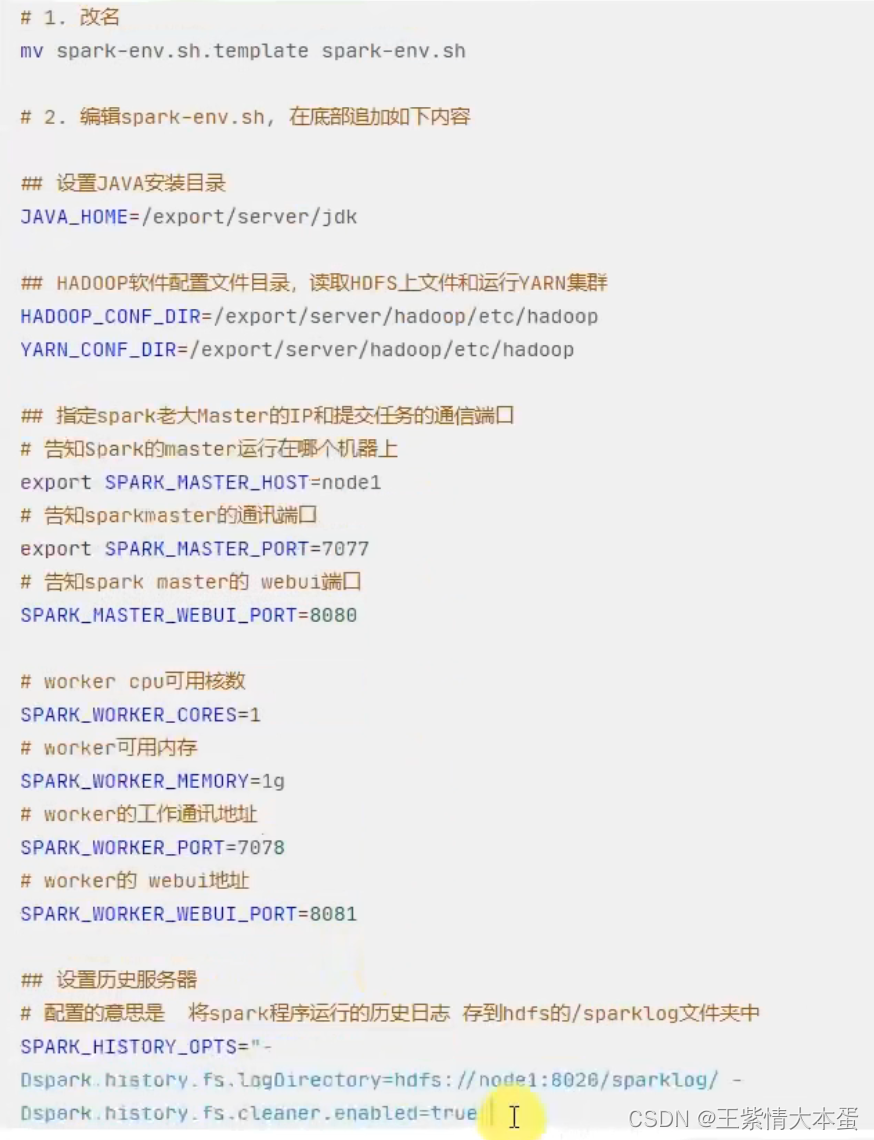

spark的standalone环境配置,主要是spark-env.sh,在worker文件里面指定workers,配置好之后要分发到其他节点上,3台服务器,一台是master和worker,另外两台均为worker。

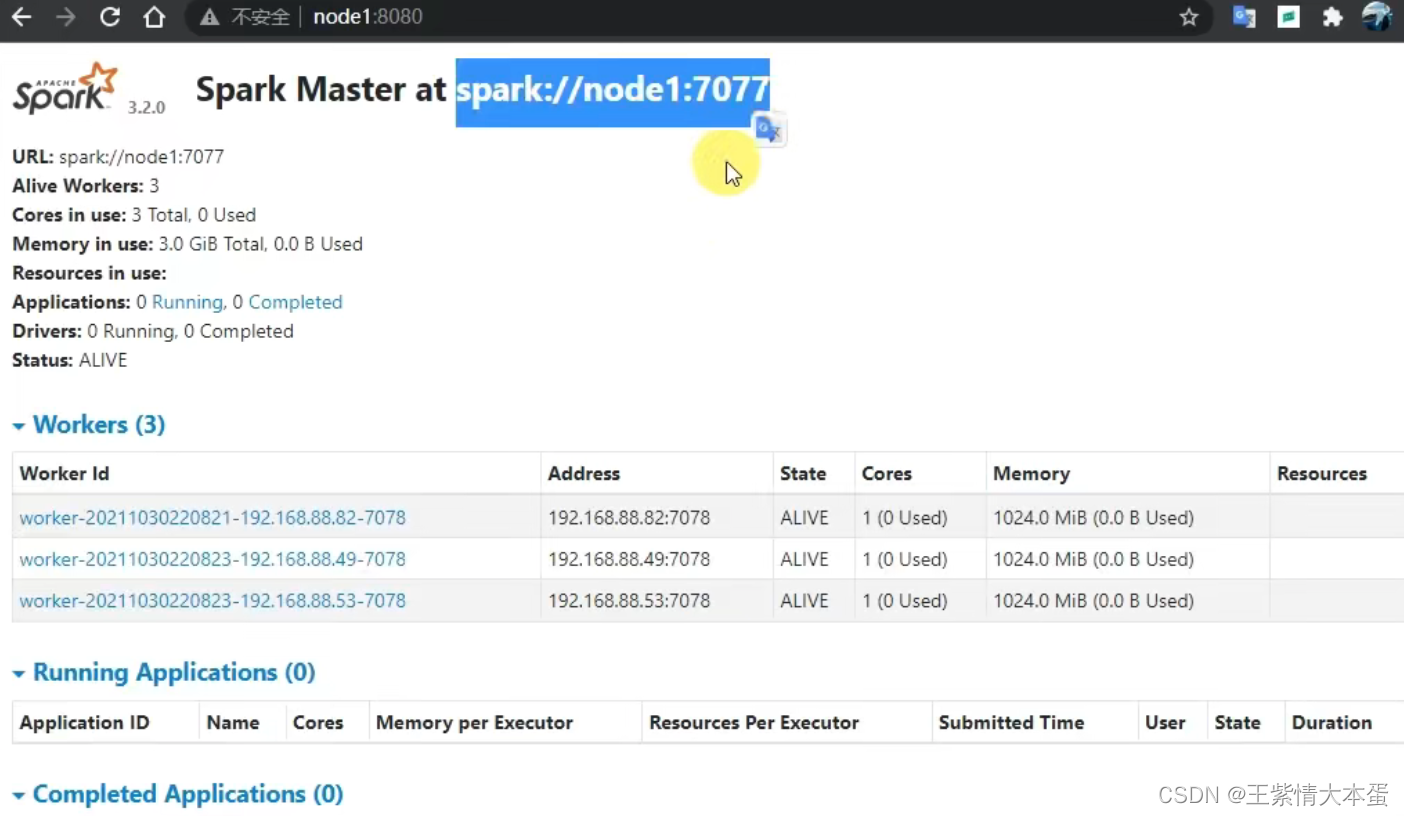

运行sbin/start-all.sh之后,会打开集群所有节点,这里可以查看网页的端口,node1:8080。

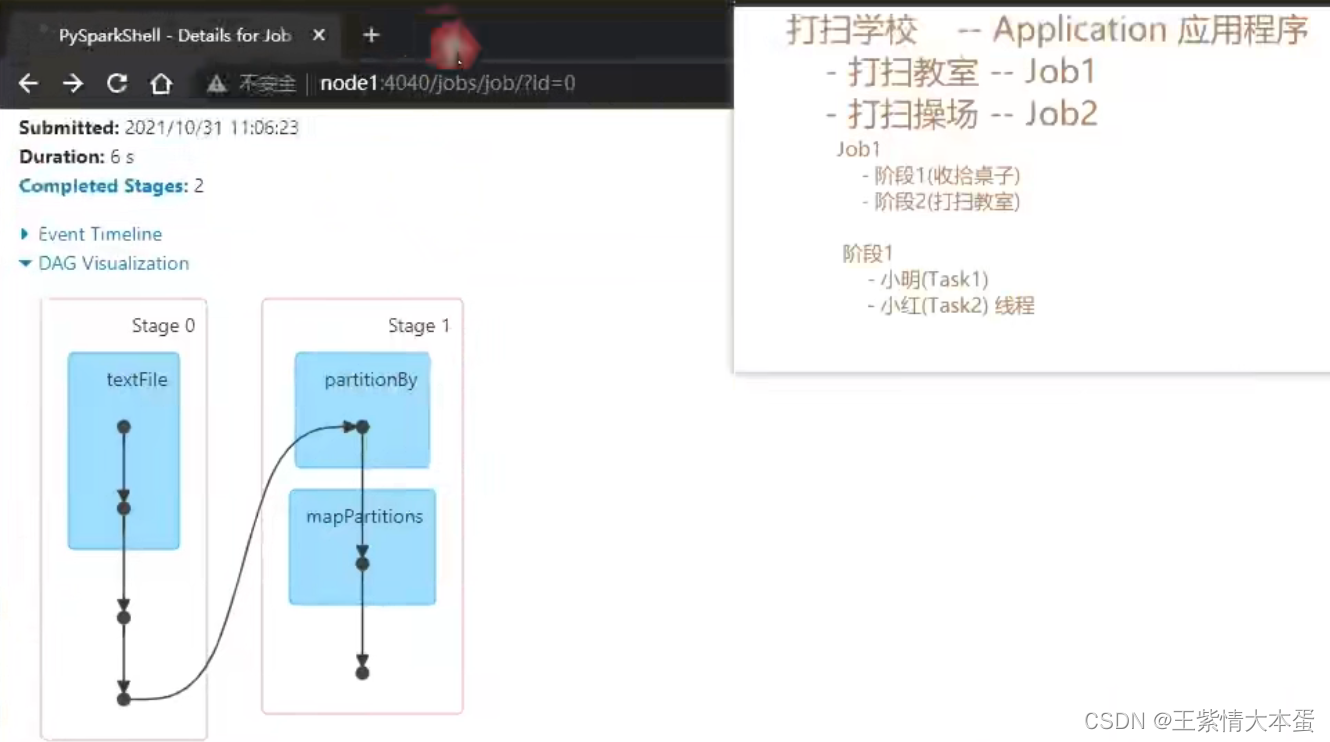

3.SPARK程序运行层次结构

一个spark程序的运行层次

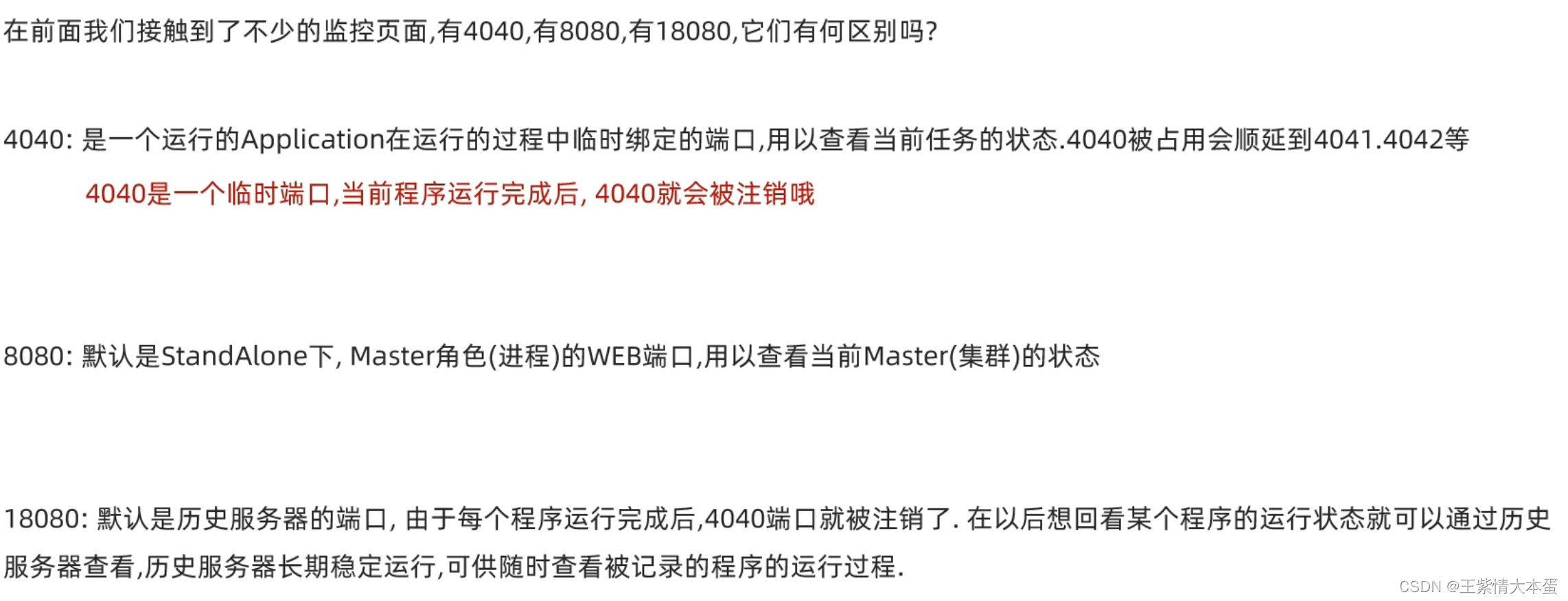

4040相当于application

小结

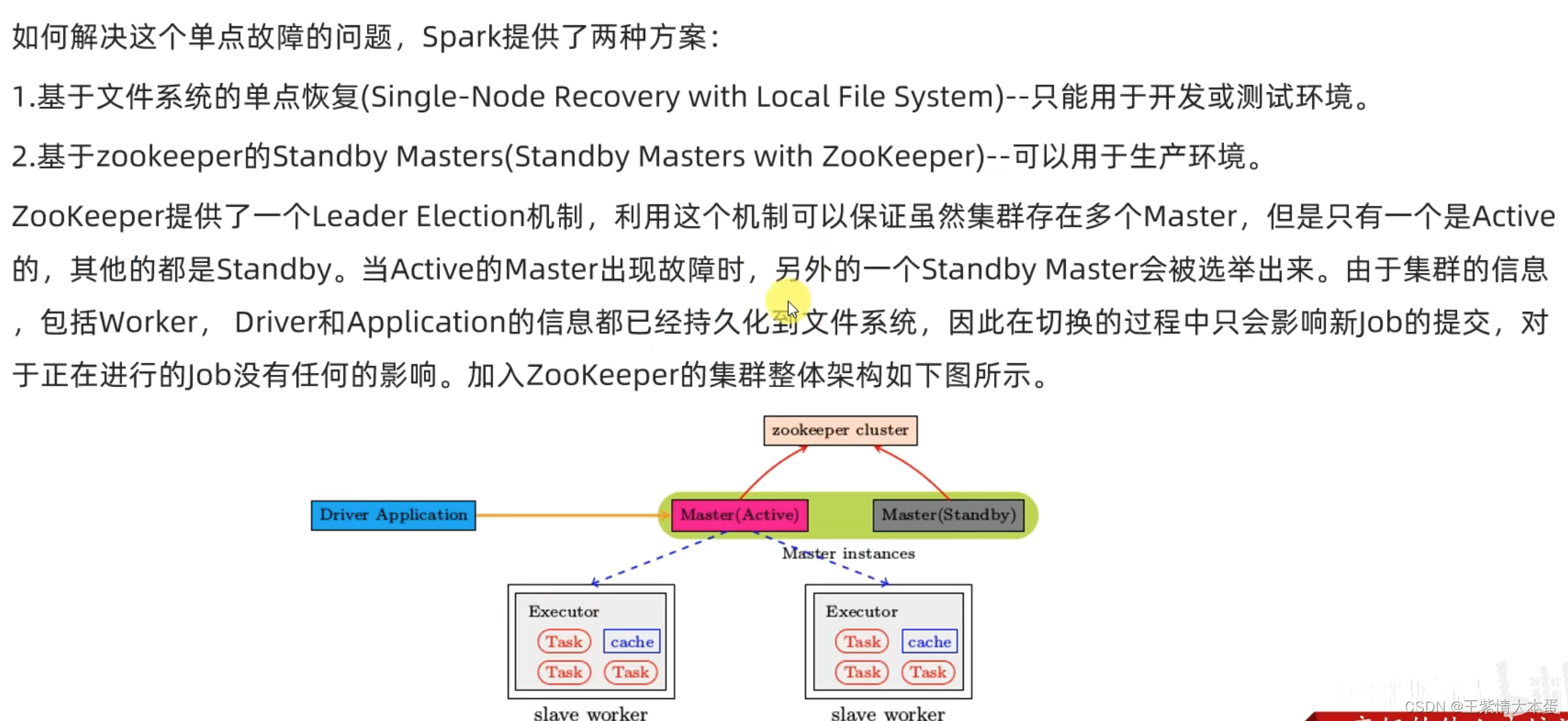

4.standalone的HA模式运行原理

High Availability(高可用)

配置中将master注释掉,并添加上HA模式,在第一个alive的master被kill之后,会第二个standby的master激活。

本文详细介绍了Spark的local模式和standalone模式的工作原理,包括如何在local模式下运行多个程序,以及如何配置standalone集群。同时,讨论了standalone模式的HA(高可用)设置,当主Master故障时,备用Master如何接管。此外,还概述了一个Spark程序的运行层次结构,以及4040端口对应的应用程序监控。

本文详细介绍了Spark的local模式和standalone模式的工作原理,包括如何在local模式下运行多个程序,以及如何配置standalone集群。同时,讨论了standalone模式的HA(高可用)设置,当主Master故障时,备用Master如何接管。此外,还概述了一个Spark程序的运行层次结构,以及4040端口对应的应用程序监控。

8129

8129

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?